一种面向延迟及能耗优化的数据中心数据部署算法

2016-07-18吴嘉佳樊玉琦

吴嘉佳,樊玉琦

(1.贵州师范大学 教育科学学院,贵州 贵阳 550001;2.合肥工业大学 计算机与信息学院,安徽 合肥 230009)

一种面向延迟及能耗优化的数据中心数据部署算法

吴嘉佳1,樊玉琦2

(1.贵州师范大学 教育科学学院,贵州 贵阳550001;2.合肥工业大学 计算机与信息学院,安徽 合肥230009)

摘要:大规模网络应用是通过分布在不同地理位置的数据中心为世界各地的用户提供服务,而以较小的延迟从数据中心获取数据和减少网络与数据中心产生的能耗是其中2个重要课题。文章通过综合考虑用户到数据中心的访问延迟、数据中心的能耗和网络传输能耗3个因素来解决节能数据中心的数据部署问题,提出了一种请求路由方法GLDD(green latency-aware data deployment),允许网络管理和应用者在部署数据时灵活地调节3个因素的影响。实验结果表明,GLDD能够有效地减少数据中心能耗,并能在数据中心能耗、网络传输能耗和网络传输延迟三者之间获得良好的平衡。

关键词:节能;延迟感知;服务器能耗;网络能耗;数据部署

0引言

随着互联网应用和服务的发展,云计算飞速发展起来。越来越多的数据和计算被迁移或托管到互联网数据中心,即云数据中心。云数据中心在许多方面比传统数据中心有优势,如增强数据的可靠性、减少终端用户的管理成本、降低设备的成本等[1]。然而,这些云计算也在消耗大量的能量,包括数据中心的能耗与数据传输所需的网络能耗。

目前,为大规模互联网应用提供服务的云数据中心消耗的电能占世界电能供应的1.3%,并且这一比例在2020年将达到8%[2]。Internet网络中传输和交换设备消耗的能量约占整个信息和通信技术行业能量消耗的14.8%,而2020年将上升到21.8%[3]。光电设备日益增长的规模和数量也加剧了网络中传输和交换设备的能量消耗[4-5]。

文献[6-7]最先提出绿色网络问题,随后减少网络中传输能耗问题引起了人们的注意。目前已有一些方法用来减少数据中心的能耗,主要包括以下几类:动态电压频率调整(DVFS)控制技术[8]、虚拟技术[9]和最小化服务器群能耗的方法[10]。动态电压频率调整控制技术是根据服务器的负载来调整其工作频率以减少数据中心的能耗。虚拟技术是通过将一台物理设备虚拟成可以供多个用户使用的多台设备的方法来提高硬件的使用率,从而减少数据中心的能耗。最小化服务器群能耗的方法是关闭服务器群中一些空闲的服务器来减少数据中心能耗。已有的减少网络传输能耗的研究主要针对以太网主机和网卡的能耗[11]、链路的数据速率[12]、交换功能[13]、WDM骨干网络[14]和新的网络架构[15]等方面。

延迟是云数据中心为用户提供服务的一个重要服务质量指标,降低用户访问云数据中心的访问延迟也是一个重要的研究课题。文献[16]分析了保证纳秒级延迟需求的应用。随着科学技术的进一步发展,更低延迟的数据中心网络越来越成为可能。这些技术包括升级已有的数据中心、应用下一代以太网交换芯片和使用更快的以太网卡。用户到数据中心的访问延迟包括用户到数据中心的传输延迟和数据中心处理用户请求的处理延迟。已有的对用户到数据中心访问延迟的研究大多集中在降低数据中心处理用户请求的延迟上[17],较少关注用户到数据中心传输过程的延迟,而文献[18]综合考虑了用户到数据中心的传输延迟和数据中心对用户请求的处理延迟。

本文综合考虑用户到数据中心的访问延迟、数据中心的能耗和网络传输能耗3个因素,设计了一种单数据中心拷贝的数据部署策略。

1问题定义

部署数据到云数据中心应考虑3个因素:① 用户访问云数据中心的访问延迟;② 云数据中心中的服务器能耗;③ 数据在网络传输过程中的能量消耗。数据部署涉及的3个实体如下:

(1)用户组。用户组是地理位置相近或者处于同一自制系统内的用户的集合。

(2)数据。数据是对用户请求的抽象物,如在线视频。

(3)数据中心。可以服务用户请求的服务器的集合。

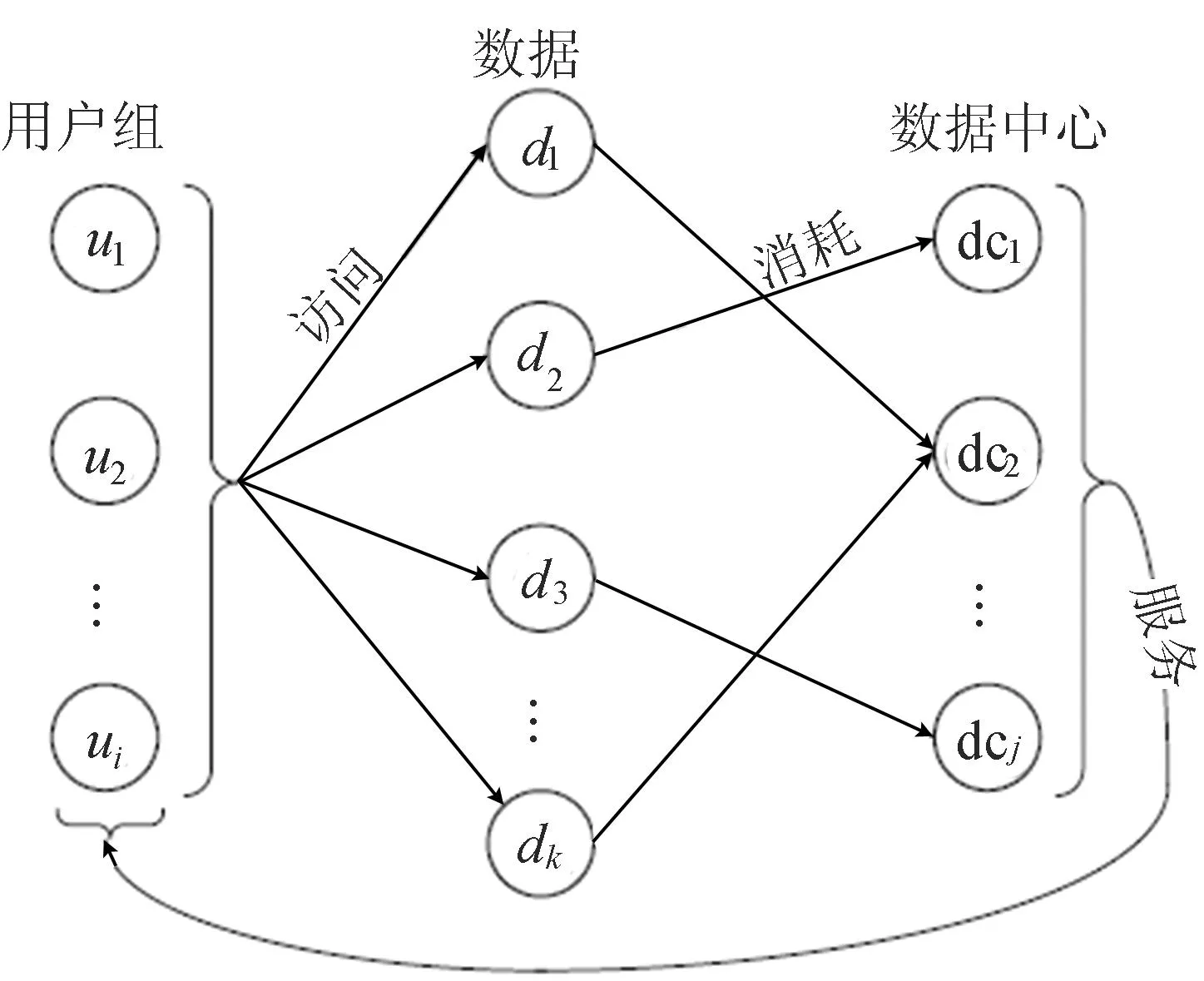

用户组、数据和数据中心3个实体间的关系如图1所示。

图1 用户组、数据和数据中心三者关系

用户组访问的数据部署在云数据中心的服务器上,而这些服务器可能分布在不同的数据中心,数据中心通过提供用户所需的数据请求为用户服务。假设每个数据仅部署在一个数据中心,且每个用户组访问每个数据的概率可以预先获得。

不仅服务器会消耗能量,冷却系统和数据中心的其他设备也会消耗能量。电源使用效率(power usage effectiveness,PUE)是衡量数据中心能源使用效率的一个重要指标,最高效数据中心的PUE约为1.07~1.20[19],行业平均水平约为2.00[20]。PUE的计算表达式为:

(1)

用户访问数据中心过程中经过的网络模型类似文献[21]中的模型。假设接入网络模型是一个无源光网络,其能量消耗在很大程度上独立于传输过程中的流量。

用户通过Internet访问云数据中心,每比特数据消耗能量的计算公式为:

(2)

其中,Pes、Pbg、Pg、Ppe、Pc和Pw分别为以太网交换机、宽带网关路由器、数据中心网关路由器、提供商边界路由器、核心路由器和WDM传输设备的功耗;Ces、Cbg、Cg、Cpe、Cc和Cw为相应设备每秒时间内的容量。系数6由电源冗余需求(系数2)、冷却和其他负载(系数1.5)、网络一般利用率为50%和最大消耗功率(系数2)决定。假设Internet网络中的PUE是1.5。以太网交换机的系数3表示城域网中以太网交换机和数据中心内部以太网交换机的总和。提供商边界路由器的系数2包括边缘网络的边缘路由器和数据中心的网关路由器。核心路由器的系数2表示考虑到核心路由器通常是为未来提供相当于当前需求的2倍的要求。系数hc(ui,dcj)表示数据在核心网络传输过程中经过的路由器的跳数。

当部署数据到数据中心上时,必须将数据部署到某个数据中心的某个服务器上。数据中心到用户的延迟越小越好。但是除了数据中心到用户组的延迟,还要考虑数据中心中的服务器能耗和数据在网络传输中的能耗。当部署数据到数据中心时,需要权衡用户访问数据的访问延迟、数据中心服务器能耗和数据在网络传输过程中的能量消耗。此问题的数学模型为:

(3)

(4)

(5)

(6)

(7)

(8)

(4)式表示数据部署会导致延迟和能量消耗;(5)式表示每个数据仅部署1份;(6)式表示对于每个数据的请求必然来自一个用户组;(7)式表示能耗应考虑PUE因素;(8)式表示一个服务器上部署的数据总大小不能超过此服务器的容量。

2启发式算法

针对上述问题,本文设计了启发式算法GLDD(green latency-aware data deployment)以解决多重约束条件限制下的数据部署问题,同时考虑延迟、数据中心服务器能耗和网络传输的能耗。GLDD算法按照数据大小非升序方法排序并处理数据。在处理每个数据时,GLDD算法搜索所有数据中心的所有服务器,并将数据部署在总消耗最小的服务器上。检查每个数据中心的每个服务器,获得将数据部署在足以容纳这个数据的服务器上的总消耗。将数据dk部署在数据中心dcj的服务器sm上的总消耗为:

cost(dk,dcj,sm)=undeploy-cost(dk,dcj,sm)=

(9)

总消耗包括延迟、数据中心服务器能耗和网络传输中的能耗。一般情况下,用户访问数据的延迟随着用户到该数据所在数据中心间距离的增加而增加。数据在网络传输过程中的能量消耗可用(2)式计算。

当部署一个数据到服务器上时,不同服务器的部署状态可能不同。如果某个服务器已经被部署了某些数据,则认为部署更多数据到这个服务器上不会给它带来额外的能耗。也就是说,如果某服务器已经被部署了某些数据,将其他数据部署在该服务器上的能量消耗可用(10)式计算,即

cost(dk,dcj,sm)=deploy-cost(dk,dcj,sm)=

(10)

否则,将数据部署在该服务器上的总能耗用(9)式计算。

GLDD算法如下。

输入:P(ui|dk)、L(ui,dcj)、EI(ui,dcj)、Es(sm,dcj)、S(dk)。

输出:记录数据部署情况的矩阵Rep(dcj,sm,dk)。

Sort by ascending(S(dk));

while S(dk)!=Nil do dk=FirstElement(S(dk));

for each dcjdo

for each smin each dcjdo

if C(sm,dcj)>s(dk);

con=cost(dk,dcj,sm);

end if;

end for;

end for;

min sm=FindMinValue(con);

C(min sm,dcj)=C(min sm,dcj)-s(dk);

rep(dcj,min sm,dk)=true;

end while;

return Rep(dcj,sm,dk)

3实验结果与分析

通过实验比较GLDD和FORTE算法[22],以此来评估GLDD算法的性能。FORTE试图平衡碳足迹、数据中心服务器能量消耗和数据访问延迟三者之间的关系,但没有考虑网络传输中的能耗问题。在FORTE算法中,一个数据可能会被部署在多个数据中心的服务器上,会被部署多份,但是GLDD算法将数据只部署在一个数据中心中。并且,GLDD算法试图获取数据访问延迟、数据中心服务器能耗和网络传输过程能耗三者之间的平衡。

本文以用户到数据中心间的地理距离近似代替用户访问数据中心的延迟。根据FORTE部署数据的策略,一个数据可能会被部署多份,如果数据足够大,那么它将被部署到数据中心。也就是说,数据的大小应该在最大的一些数据流内;FORTE定义了一个阈值用来表示数据是否足够大。为了保证每个数据都能被部署在某个数据中心,可将FORTE中的比例阈值设为0。

本文考虑4种情况:① 情形1(case1),只考虑目标函数中延迟子目标(即λ2=λ3=0);② 情形2(case2),只考虑目标函数中数据中心服务器能耗子目标(即λ1=λ3=0),忽略延迟和网络传输中能耗子目标;③ 情形3(case3),考虑延迟和数据中心服务器能耗(即λ3=0);④ 情形4(case4),考虑延迟、数据中心服务器能耗和网络传输过程中的能耗3个因素。

假定用户数是1 000,延迟/距离性能如图2所示。从图2可以看出,随着数据量的增加,用户到数据中心的平均距离也会增加;FORTE算法的延迟比GLDD小,因为FORTE算法将数据部署在多个数据中心中,使每个用户能从最近的拥有该数据的数据中心访问该数据。GLDD在case1下能够获取最好的距离性能,因为在case1下距离是影响数据部署决策的唯一因素。由于case2只考虑数据中心的服务器部分能耗,忽略了距离因素,因此产生了最大的访问距离。GLDD在case4下的距离比case3下的距离小,因为case4考虑了距离、数据中心服务器能耗和网络传输过程中能耗3个因素,而延迟和网络传输中的能耗都受到用户到数据中心距离的影响。

图2 延迟/距离性能

数据中心服务器能耗如图3所示。

图3 数据中心服务器能耗

由图3可知,数据中心的能耗随着数据量的增加而增加,因为需要更多的服务器来部署增加的数据。由于FORTE算法中,每个数据可能被部署在多个数据中心,而GLDD算法中每个数据仅被部署在一个数据中心,所以FORTE算法消耗的数据中心服务器能耗比GLDD的多。GLDD在case1和case2下的数据中心服务器能耗结果一样,因为此时数据中心的服务器状态不影响数据部署代价的计算。在4种情况中,GLDD在case2下数据中心的服务器能耗最小,因为此时数据中心的服务器能耗是数据部署过程中影响部署策略的唯一因素。在case1下,由于只考虑距离因素,数据会被部署到离用户比较近的数据中心,而较近的数据中心的PUE比较大或者会消耗更多的服务器能耗。对于数据中心服务器能耗,GLDD在case3下的性能比case4好,因为case3考虑了距离和数据中心服务器能耗2个因素,而case4需要考虑距离、数据中心服务器能耗和网络传输能耗3个因素。

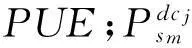

距离和数据中心能耗的代价和比较如图4所示。调整λ1和λ2的值使得(3)式中第1部分和第2部分处于同一数量级范围内,从而距离和数据中心能耗都能够合理地影响数据部署策略。λ1和λ2分别被设置为0.000 01 和0.004 00。GLDD在4种情况下的距离和数据中心能耗总代价比FORTE少。在FORTE算法中,数据可能会被部署多份,以消耗更多数据中心能耗来换取用户访问数据中心距离的减少。

图4 距离和数据中心能耗的代价和

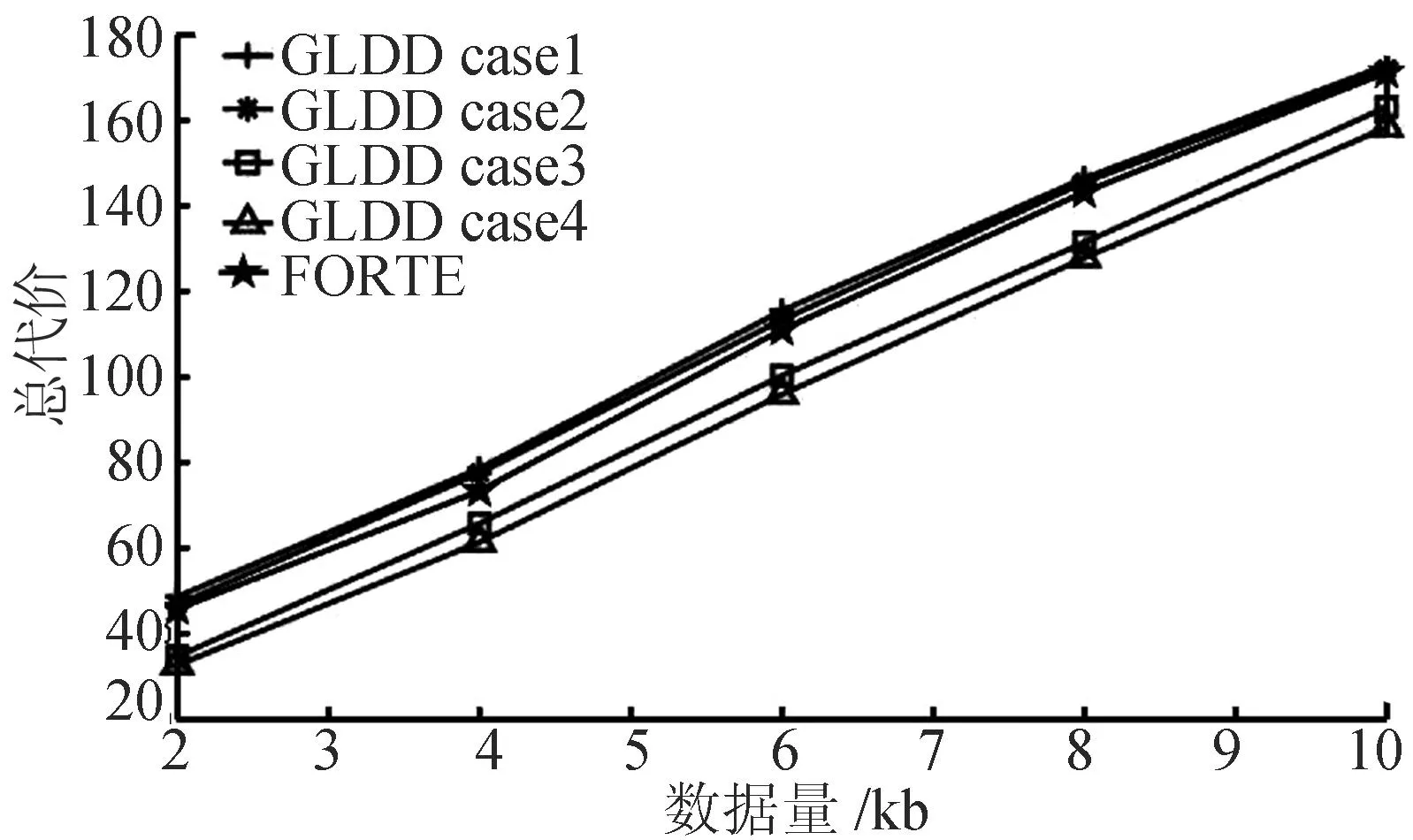

距离、数据中心能耗和网络传输能耗的总代价比较如图5所示。λ1、λ2和λ3分别被设置为0.000 01、0.004 00和 0.000 000 1。与图4结果类似,在case3和case4下,GLDD的总代价比FORTE少,但在case1和case2下,FORTE获得了更好的性能,因为GLDD只会考虑距离和数据中心能耗中的一个因素,并且数据仅会被部署一份,从而增加了用户访问数据的距离或网络传输能耗。

图5 距离、数据中心能耗和网络传输能耗的总代价

4结束语

大规模的网络应用使用分布在不同地理位置的数据中心为世界各地的用户提供服务。本文在解决节能数据中心的数据部署问题时,综合考虑了用户到数据中心的访问延迟、数据中心的能耗和网络传输能耗3个因素,提出了一种请求路由方法GLDD,允许网络管理和应用者在部署数据时可以灵活地调节上述3个因素的影响。实验结果表明,GLDD能够有效地减少数据中心能耗,并能在数据中心能耗、网络传输能耗和网络传输延迟三者之间获得良好的平衡。

[参考文献]

[1]罗军舟,金嘉晖,宋爱波. 云计算:体系架构与关键技术[J]. 通信学报,2011,32(7):3-21.

[2]Koomey J. Growth in data center electricity use 2005 to 2010[M].Analytical Press,2011.

[3]Pickavet M,Vereecken W,Demeyer S,et al. Worldwide energy needs for ICT: the rise of power-aware networking[C]//International Symposium on Advanced Networks and Telecommunication Systems. IEEE,2008:1-3.

[4]Van Heddeghem W,De Groote M,Vereecken W,et al. Energy-efficiency in telecommunications networks: link-by-link versus end-to-end grooming[C]// 14th Conference on Optical Network Design and Modeling.IEEE,2010:1-6.

[5]Aleksic S. Analysis of power consumption in future high-capacity network nodes[J]. Journal of Optical Communications and Networking,2009,1(3):245-258.

[6]Gupta M,Singh S. Greening of the Internet[J]. ACM Sigcomm,2003,33(4):19-26.

[7]Christensen K,Nordman B,Brown R. Power management in networked devices[J].Computer,2004,37(8):91 - 93.

[8]Sarood O,Miller P,Totoni E,et al. “Cool” load balancing for high performance computing data centers[J]. IEEE Transactions on Computers,2012,61(12):1752-1764.

[9]Nathuji R,Schwan K. VirtualPower: coordinated power management in virtualized enterprise systems[C]//ACM Symposium on Operating Systems Principles.ACM,2007:265-278.

[10]Berl A,Gelenbe E,Girolamo M D,et al. Energy-efficient cloud computing[J]. Computer Journal,2010,53(7):1045-1051.

[11]Gunaratne C,Christensen K,Nordman B. Managing energy consumption costs in desktop PCs and LAN switches with proxying,split TCP connections,and scaling of link speed[J]. International Journal of Network Management,2005,15(5):297-310.

[12]Gunaratne C,Christensen K,Nordman B,et al. Reducing the energy consumption of Ethernet with adaptive link rate (ALR)[J].IEEE Transactions on Computers,2007,57(4):448-461.

[13]Nedevschi S,Popa L,Iannaccone G,et al. Reducing network energy consumption via sleeping and rate-adaptation[C]//Proceedings of the 5th USENIX Symposium on Networked Systems Design and Implementation. USENIX Association,2008:323-336.

[14]Yetginer E,Rouskas G N.Power efficient traffic grooming in optical WDM networks[C]//Proc GLOBECOM 2009,2009:1838-1843.

[15]Chabarek J,Sommers J,Barford P,et al. Power awareness in network design and routing[C]//The 27th Conference on Computer Communications. IEEE,2008:457-465.

[16]Lee M,Goldberg S,Kompella R R,et al. Fine-grained latency and loss measurements in the presence of reordering[C]//Proceedings of the 2011 ACM SIGMETRICS International Conference on Measurement and Modeling of Computer Systems. ACM,2011: 329-340.

[17]Yao Y,Huang L,Sharma A,et al. Power cost reduction in distributed data centers: a two-time-scale approach for delay tolerant workloads[J].IEEE Transactions on Parallel and Distributed Systems ,2014,25(1):200-211.

[18]Ren K. Optimal load balancing and energy cost management for Internet data centers in deregulated electricity markets[J]. IEEE Transactions on Parallel and Distributed Systems,2014,25(10):2659-2669.

[19]Google Data Center.Google’s data center efficiency[EB/OL].[2015-05-30].http://www.google.com/about/datacenters/efficiency/internal/index.html.

[20]EPA.EPA report to congress on server and data center energy efficiency[R].U. S. Environmental Protection Agency,2007.

[21]Baliga J,Ayre R W A,Hinton K,et al. Green cloud computing: balancing energy in processing,storage,and transport[J]. Proceedings of the IEEE,2011,99(1):149-167.

[22]Gao P X,Curtis A R,Wong B,et al.It’s not easy being green[C]//Conference on Applications,Technologies,Architectures and Protocols for Computer Communication.ACM,2012:211-222.

(责任编辑胡亚敏)

A green latency-aware data deployment algorithm in data centers

WU Jia-jia1,FAN Yu-qi2

(1.School of Educational Science,Guizhou Normal University,Guiyang 550001,China;2.School of Computer and Information,Hefei University of Technology,Hefei 230009,China)

Abstract:Large-scale Internet applications provide service to end users by routing service requests to geographically distributed servers,which may be located at different data centers. Two concerns exist in service providing by data centers. One is that users require experiencing low latency while accessing data from the data centers. The other is to reduce the power consumed by network transport and servers in the data centers. In this paper,the problem of green data deployment in the data centers is studied by taking into account the three factors of latency,energy consumption of the data centers and energy consumption of the network transport. A request-routing scheme,that is,the green latency-aware data deployment(GLDD),is proposed to allow operators to tune the three factors above during data deployment. The simulation results show that the proposed algorithm GLDD is effective in terms of the reduction of data center power consumption,as well as the trade-off among the latency of data access,the power consumption of the network transport and the data centers.

Key words:energy saving;latency awareness;energy consumption in server;energy consumption in network;data deployment

收稿日期:2015-05-26;修回日期:2015-07-01

基金项目:贵州省科学技术基金资助项目(黔科合J字LKS[2012]40号)

作者简介:吴嘉佳(1980-),女,湖南辰溪人,贵州师范大学讲师; 樊玉琦(1976-),男,安徽合肥人,博士,合肥工业大学副教授,硕士生导师.

doi:10.3969/j.issn.1003-5060.2016.06.011

中图分类号:TP393

文献标识码:A

文章编号:1003-5060(2016)06-0772-06