兼顾特征级和决策级融合的场景分类

2016-05-14何刚霍宏方涛

何刚 霍宏 方涛

摘要:针对单一特征在场景分类中精度不高的问题,借鉴信息融合的思想,提出了一种兼顾特征级融合和决策级融合的分类方法。首先, 提取图像的尺度不变特征变换词包(SIFTBoW)、Gist、局部二值模式(LBP)、Laws纹理以及颜色直方图五种特征。然后, 将每种特征单独对场景进行分类得到的结果以DezertSmarandache理论(DSmT)推理的方式在决策级进行融合,获得决策级融合下的分类结果;同时, 将五种特征串行连接实现特征级融合并进行分类,得到特征级融合下的分类结果。最后, 将特征级和决策级的分类结果进行自适应的再次融合完成场景分类。在决策级融合中,为解决DSmT推理过程中基本信度赋值(BBA)构造困难的问题, 提出一种利用训练样本构造后验概率矩阵来完成基本信度赋值的方法。在21类遥感数据集上进行分类实验,当训练样本和测试样本各为50幅时,分类精度达到88.61%,较单一特征中的最高精度提升了12.27个百分点,同时也高于单独进行串行连接的特征级融合或DSmT推理的决策级融合的分类精度。

关键词:场景分类;特征级融合;决策级融合;DezertSmarandache理论推理;基本信度赋值;遥感影像

中图分类号:TP391.4 文献标志码:A

Abstract: Since the accuracy of single feature in scene classification is low, inspired by information fusion, a classification method combined featurelevel and decisionlevel fusion was proposed. Firstly, Scale Invariant Feature TransformBag of Words (SIFTBoW), Gist, Local Binary Patterns (LBP), Laws texture and color histogram features of image were extracted. Then, the classification results of every single feature were fused in the way of DezertSmarandache Theory (DSmT) to obtain the decisionlevel fusion result; at the same time, the five features were serially connected to generate a new feature, the new feature was used to classification to obtain the featurelevel fusion result. Finally, the featurelevel and decisionlevel fusion results were adaptively fused to finish classification. To solve the Basic Belief Assignment (BBA) problem of DSmT, a method based on posterior probability matrix was proposed. The accuracy of the proposed method on 21 classes of remote sensing images is 88.61% when training and testing samples are both 50, which is 12.27 percentage points higher than the highest accuracy of single feature. The accuracy of proposed method is also higher than that of the featurelevel fusion serial connection or DSmT reasoning decisionlevel fusion.

Key words:scene classification; featurelevel fusion; decisionlevel fusion; DezertSmarandache Theory (DSmT) reasoning; Basic Belief Assignment (BBA); remote sensing image

0 引言

场景分类的主要目的是研究如何使计算机把图像分类到特定的语义类别,往往需要建立从图像低层特征到高层语义之间的映射,是图像理解、视觉领域的一个近年来的研究热点[1-5]。目前用于场景分类的特征可分为两大类:一类是颜色、形状、纹理等低层特征[3-5],通过直接将这些低层特征映射到高层场景语义来进行分类;另一类是Gist、词包模型(Bag of Words,BoW)等中层语义特征[6-8],通过借助中层语义特征缩短低层特征到高层场景之间的语义鸿沟来进行分类。Olivia等[6]采用并改进了Gist特征,Gist特征将整幅场景作为对象进行描述,忽略场景中的物体等局部信息,易于计算,在室外场景分类中有较好的表现。Sivic等[7]提出视觉词包的概念,将文本分析中的BoW模型应用到场景的分类中,通过统计图像局部特征的分布信息来表达图像内容。但由于场景本身具有复杂性和多样性且还受到拍摄角度、光线等多种因素的影响[2],所以仅仅依靠上述单一特征对场景分类并不能达到实际应用中对分类精度的要求。

当人们发现难以通过单一特征信息来处理场景分类这一复杂问题时,一些学者开始采用信息融合的方法来进行场景分类研究[9-12]。信息融合按照其进行的层次可被分为数据级融合、特征级融合和决策级融合。在特征级融合方面,大多采用基于串行连接的融合方法,基于串行连接的特征级融合是指将各特征首尾相连融合成新特征。肖保良[11]将Gist特征和分层梯度方向直方图(Pyramid Histogram of Oriented Gradients, PHOG)特征相融合用于场景分类,分类精度相对于单一特征提升了2.5%。在决策级融合方面,基于多分类器组合的方法得到了广泛研究,刘帅等[12]将多个不同特征训练的支持向量机(Support Vector Machine, SVM)分类器结果进行融合并用于遥感图像分类,分类精度相比单分类器也有较大提升。但这些融合方法大多只在信息融合的某一个层次进行,不能充分利用不同层次融合之间的互补信息,并没有充分发掘信息融合的优势。

因此本文借鉴信息融合思想,针对单一特征信息在场景分类中精度不高的问题进行了新的探索,提出了一种兼顾特征级融合和决策级融合的场景分类方法,该方法在充分利用不同特征之间的互补信息的同时还能够对不同融合层次之间的互补信息加以利用。首先提取待分类图像的尺度不变特征变换词包(Scale Invariant Feature TransformBag of Words, SIFTBoW)特征[7]、Gist特征、局部二值模式(Local Binary Patterns, LBP)纹理特征[13-15]、Laws纹理特征[16]和颜色直方图特征[17],以提供多个角度的场景信息描述;然后将上述特征信息单独使用的分类结果以DezertSmarandache理论(DezertSmarandache Thoery, DSmT)推理的方式在决策级进行融合,得到决策级融合下的分类结果;同时将上述特征信息串行连接在特征级进行融合并分类,得到特征级融合下的分类结果;最后,将特征级和决策级的分类结果进行自适应的再融合完成场景分类。为解决DSmT推理中基本信度赋值(Basic Belief Assignment, BBA)构造困难的问题,本文首先利用训练样本构造后验概率矩阵,然后通过后验概率矩阵来完成基本信度赋值。

1 相关工作

1.1 场景特征提取

场景特征的提取对于后续的分类工作至关重要,本文主要提取SIFTBoW特征、Gist特征、LBP纹理特征、Laws纹理特征和颜色直方图五种特征来提供对场景的多个角度的描述信息。SIFTBoW特征选取具有尺度、旋转和光照不变性的SIFT描述子作为局部特征并统计整幅场景的局部特征分布信息来表达场景内容,从场景的局部构成角度对场景进行描述。Gist特征是一种生物启发特征,通过多尺度多方向的Gabor滤波器组对场景滤波来得到场景的整体轮廓信息,从全局角度对场景进行描述。LBP和Laws纹理分别采用统计和信号处理的方式,从纹理角度对场景进行描述。颜色直方图是一种被广泛使用的全局描述算子,计算简单且具有较高的鲁棒性,能够从色彩空间角度对场景进行描述。上述五种特征信息能够从局部、全局、纹理和色彩空间等多个角度来描述场景,在场景分类应用中得到了广泛的使用,但由于单一特征信息表达的场景具有片面性,仅使用其中任意一种特征来进行场景分类并不能取得令人满意的结果,所以需要通过信息融合的方式来综合这些不同角度的描述信息以完成场景分类工作。这些特征提取方法的具体内容详见参考文献,本文不再赘述。

1.2 信息融合

信息融合一般可划分为三个层次的融合:数据级融合、特征级融合和决策级融合。数据级融合将同一目标的不同信息来源的原始数据进行融合,常见于多谱段数据分析、多源图像复合等应用。特征级融合将来自同一对象的不同特征数据进行融合,常见的方法主要有串行连接(Serial Concatenate)、并行连接(Parallel Concatenate)、加权叠加和基于神经网络的方式[18],其中,研究最成熟的是基于串行连接的方式。决策级融合是对各分类器输出结果进行融合,常见方法有投票法、加权平均法和DempsterShafer理论(DempsterShafer Theory, DST)推理及其扩展等方法。本文为了利用不同融合层次之间的互补信息,在特征级和决策级分别选取了基于串行连接和基于DSmT[19-22]推理的融合方法,下面主要介绍DSmT融合理论。

1.2.1 DSmT融合理论

DSmT是对传统DST的扩展,主要用于处理不确定、高冲突和不精确的信息源融合问题。在模式识别领域,DSmT理论多用于对多个分类器输出进行决策级融合。DSmT理论跟DST理论最大的不同就是在辨识框架中加入了冲突信息。设Θ={θ1,θ2}为一个辨识框架,DST理论在幂集2Θ={θ1,θ2,θ1∪θ2}上进行基本信度赋值,DSmT则在超幂集DΘ={θ1,θ2,θ1∪θ2,θ1∩θ2}上进行基本信度赋值。由于在超幂集中有交运算的存在,这就使得辨识框架中保留了矛盾焦元。文献[20]中提出了多种比例冲突分配规则,用来解决融合过程中产生的矛盾焦元。本文选择其中的第5种比例冲突分配规则(Proportional Conflict Redistribution rules No.5,PCR5)来处理产生的矛盾焦元。

1.2.2 基本信度赋值

设有辨识框架Θ={θ1,θ2,…,θn}, DSmT模型的超幂集DΘ为由Θ中的所有元素及通过∪和∩运算产生的所有子集组成的集合[20],则基本信度赋值定义为从DΘ到[0,1]的一个映射,记作m(·):DΘ→[0,1],具体定义为:

m()=0且∑A∈DΘm(A)=1(1)

然而,在实际应用中基本信度赋值的构造往往是一大难点,通过距离函数或指数函数等方法能够进行信度赋值,但需要付出比较大的计算代价。

2 基于信息融合的场景分类框架

本文提出的基于信息融合的场景分类框架如图1所示,首先通过特征提取模块对一幅待分类的场景图像提取SIFTBoW特征、Gist特征、LBP纹理特征、Laws纹理特征和颜色直方图特征;然后在信息融合模块将提取的特征分别用于特征级融合子模块和决策级融合子模块,并将特征级融合子模块和决策级融合子模块的结果通过再融合子模块进行自适应的再融合;最后根据再融合子模块的结果来输出分类结果。现对其中一些具体内容和流程进行阐述。

2.1 DSmT融合模型

本文将DSmT融合方法用于决策级融合子模块和再融合子模块,仅对超幂集空间中的单子焦元进行信度赋值,即对于超幂集空间DΘ={θ1,θ2,θ1∪θ2,θ1∩θ2},只对θ1和θ2进行信度赋值,而θ1∪θ2和θ1∩θ2信度赋值为零。具体到本文的N个场景类别,有DΘN={θ1,θ2,…,θN},其中θ1,θ2,…,θN分别表示N个不同的场景类别。采用DSmT经典组合规则进行组合,并利用PCR5分配规则对融合过程中产生的矛盾焦元质量进行分配。

3 实验结果及分析

本文的实验在VS2010平台上进行,SVM分类器采用Libsvm软件包,采用径向基函数(Radial Basis Function, RBF),并通过网格搜索法(Grid Search)和五折交叉验证(5Cross Validation)进行参数优化,后续的分类实验均用SVM作为分类器。对SIFTBoW特征取600个单词;对Gist特征取4×4网格划分图像,每个图像块用4个尺度8个方向的Gabor滤波器处理得到512维特征向量;对LBP纹理特征采用均匀模式[14]得到59维特征向量;对Laws纹理特征采用14个模板来对图像进行卷积,并分别统计它们得到的均值、标准差、偏度、峰度4个特征量,得到共56维的特征向量;对颜色直方图特征在HLS(HueLightnessSaturation)空间将每个分量分别量化为8等分,得到512维特征向量。

3.1 实验数据

本文采用的数据集是由美国地质勘探局(United States Geological Survey,USGS)提供的21类遥感数据集,该数据集中图像均来自QuickBird传感器,包括农田、飞机、棒球场等共21类遥感场景,每类场景共有100幅图像,共2100幅图像,大小均为256×256。本文从每类场景中随机选取50幅作为训练集,余下50幅作为测试集进行实验,后续实验若无特别说明,都是采用该比例选取训练样本和测试样本。

3.2 SIFTBoW特征单词个数的设定

对SIFTBoW特征来说,词典中单词的个数是影响其分类性能的一个很大因素,过少的单词数无法提供足够的分类信息,过多的单词数不仅会带来计算复杂度的提升,且也无法保证能带来更高的精度。本文将SIFTBoW特征的单词设置为200、300、400、500、600、700、800、1000、1500,对实验数据进行10次重复实验,对其结果取平均值,各单词数的分类结果如图2所示。

从图2结果可知,随着单词个数的增多,分类精度曲线先是呈上升趋势,在600个单词时达到峰值,而后开始下降。这是因为过少的单词数会导致差异较大的图像块被分配到同一视觉词汇,降低模型的描述能力;而过多的单词数又会导致相似的图像块被分配到不同的视觉词汇,降低模型的泛化能力。所以本文后续用到的SIFTBoW特征都采用600个单词,因为此时模型在描述能力和泛化能力之间取得了平衡,拥有最优的分类精度。

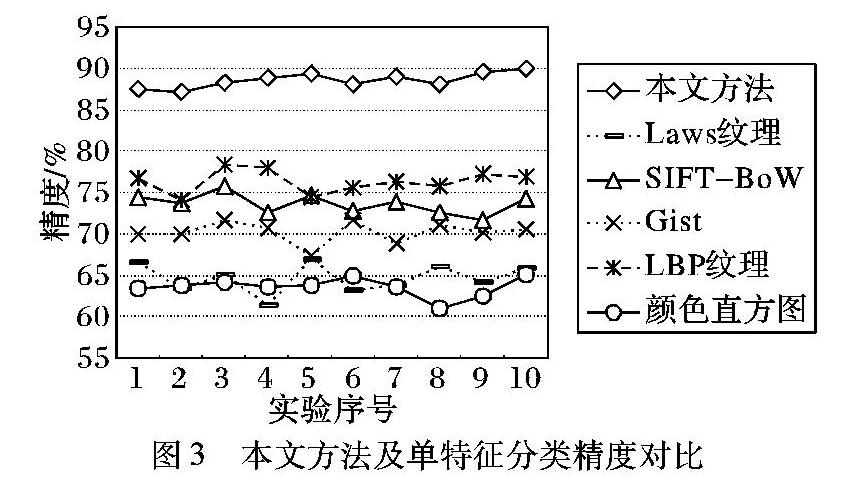

3.3 本文方法及单特征对比实验

利用本文方法(融合阈值T设为0.85)和5种单一特征在实验数据集上进行分类实验,共进行10次重复实验,分类精度如图3所示,其中单特征中分类精度最高的是LBP纹理特征,10次实验的平均精度为76.34%;最低的是颜色直方图特征,10次实验的平均精度是63.57%。其余的SIFTBoW、Gist和Laws纹理特征的平均分类精度分别为73.60%、70.17%和64.63%。而本文方法10次实验的平均精度达到88.61%,比单特征分类中的最高精度高12.27个百分点。

从图3可以看出,单一特征由于本身只能提供相对有限的场景描述信息,所以无法取得令人满意的分类结果。而本文的融合方法能够充分利用各特征之间的互补信息,获得足够的场景描述信息从而较为明显地提升分类精度。

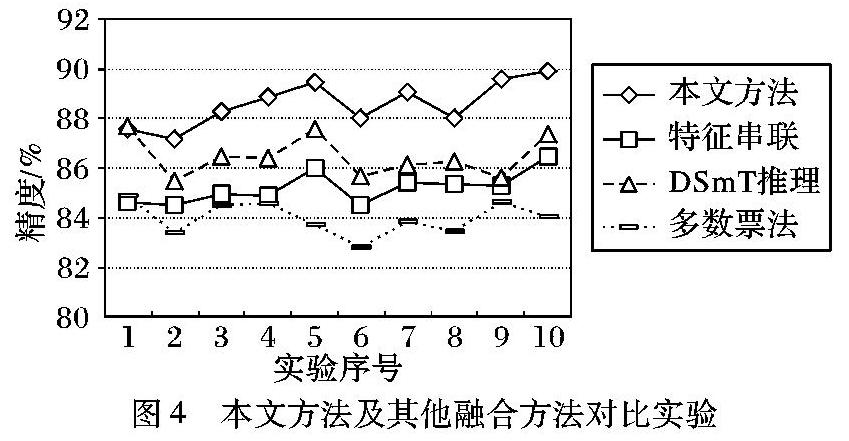

3.4 本文方法及其他融合方法对比实验

将本文方法与特征串联(相当于单独使用特征级融合子模块)、DSmT推理(相当于单独使用决策级融合子模块)、多数票法和完全一致法等融合方法作比较。多数票法根据5个分类器的类别输出进行投票,将得到票数最多的类别作为结果输出。完全一致法则要5个分类器的结果都一致时才输出结果,否则拒判。在实验数据集上进行10次重复实验。实验结果如图4所示。其中由于完全一致法平均精度(31.47%)与其他三种方法相差太多,为了清晰呈现实验结果,并未在图中给出。

由于多数票法和完全一致法只是对多个分类结果的简单统计,并没有考虑分类结果中的不确定性,所以分别只取得了84.00%和31.47%的平均分类精度。基于特征串联的融合方法和基于DSmT推理的融合方法分别在特征级和决策级进行融合分类,它们的平均分类精度分别为85.20%和86.48%。而本文提出的兼顾特征串联和DSmT推理的融合方法能够利用特征级融合和决策级融合之间的互补信息,进一步将平均分类精度提升到88.61%。

3.5 再融合子模块阈值T的讨论

在再融合子模块中的阈值T,用来自适应地判断是否对特征级融合结果VF和DSmT决策级融合结果VD进行再融合。当VF和VD中的最大元素xj(j=1,2,…,N)大于设定阈值T时,认为这一级作出的判断具有足够的可信度,取xj对应的类别作为最终分类结果C;若不大于阈值T,则表示特征级融合的结果和决策级融合的结果不足以作出判断,还需将它们再进行DSmT融合。对T取不同值的实验结果如表1所示,其中识别率表示根据阈值T不需对VF和VD进行DSmT融合就作出的判决数J0和总判决数J的比值,正确识别率表示J0中被正确分类的比例,总分类精度表示整个框架的分类精度。

从表1可以看出,随着T值的增大,总分类精度开始上升,当T值增大到一定范围后,总分类精度趋于稳定,不再上升。由于T值越大,判决条件越严苛,越多的判决结果需要对VF和VD进行DSmT融合后才能得到,计算量也越大。可以通过在不同的阈值T下进行分类实验来得到一个最优的阈值T0,使得阈值T0能够在保证分类精度的同时足够小,以减少计算量。本文在阈值T为0.85和1时处理单张图片的时间分别为19ms和22ms,可见设定合理的阈值能够在保证分类精度的同时提升分类速度。

4 结语

本文针对单一特征在场景分类应用中表达信息不全、分类精度不高的问题,提出了一种兼顾特征级融合和决策级融合的场景分类方法。该方法有效地结合了基于串行连接的特征级融合和基于DSmT推理的决策级融合方法,在充分利用不同特征之间的互补信息的同时还能够对不同融合层次之间的互补信息加以利用,提高了分类精度。在21类遥感数据集上采用每类50个训练样本和50个测试样本进行实验,分类精度达到88.61%,高于5种特征单独使用的分类精度,同时也比单独进行基于串行连接的特征级融合或基于DSmT推理的决策级融合更为有效。该方法通过设定合理的阈值能够在保证分类精度的同时,提高分类速度。如何对框架进行改进以便其更好地用于分类将是本文后续的研究问题,比如可以通过进一步在框架中增加特征选择等方法来对减少特征数据之间的冗余,以便提高基于该框架下的场景分类性能。

参考文献:

[1]CHERIVADAT A M. Unsupervised feature learning for aerial scene classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2014, 52(1): 439-451.

[2]李学龙,史建华,董永生, 等. 场景图像分类技术综述[J].中国科学:信息科学, 2015, 45(7): 827-848. (LI X L, SHI J H, DONG Y S, et al. A survey on scene image classification[J]. Scientia Sinica: Informations, 2015, 45(7): 827-848.)

[3]ZHOU L, ZHOU Z, HU D. Scene classification using multiresolution lowlevel feature combination[J]. Neurocomputing, 2013, 122: 284-297.

[4]KAPELA R, MCGUINNESS K, OCONNOR N E. Realtime field sports scene classification using colour and frequency space decompositions[J/OL].(2014-06-08)[2015-10-21].DOI 10.1007/s1155401404377.

[5]李锦锋,许勇. 基于LBP和小波纹理特征的室内室外场景分类算法[J]. 中国图象图形学报, 2010, 15(5):742-748.(LI J F, XU Y. Indooroutdoor scene classification algorithm based on the texture feature of LBP and wavelet[J]. Journal of Image and Graphics, 2010, 15(5):742-748.)

[6]OLIVA A, TORRALBA A. Modeling the shape of the scene: a holistic representation of the spatial envelope[J]. International Journal of Computer Vision, 2001, 42(3): 145-175.

[7]SIVIC J, ZISSERMAN A. Video Google: a text retrieval approach to object matching in videos[C]// Proceedings of the 9th IEEE International Conference on Computer Vision. Washington, DC: IEEE Computer Society, 2003:1470-1478.

[8]BOLOYINOU A, PRATIKAKIS I, PERANTONIS S. Bag of spatiovisual words for context inference in scene classification[J]. Pattern Recognition, 2013, 46(3): 1039-1053.

[9]SHAO W, YANGW, XIA G S, et al. A hierarchical scheme of multiple feature fusion for highresolution satellite scene categorization[C]// Proceedings of the 9th International Conference on Computer Vision Systems. Berlin: SpringerVerlag, 2013: 324-333.

[10]YU J, TAO D, RUI Y, et al. Pairwise constraints based multiview features fusion for scene classification[J]. Pattern Recognition, 2013, 46(2): 483-496.

[11]肖保良. 基于Gist特征与PHOG特征融合的多类场景分类[J]. 中北大学学报(自然科学版), 2014, 35(6):690-694.(XIAO B L. Multiclass scene classification based on fusion of Gist feature and PHOG feature[J]. Journal of North University of China (Natural Science Edition), 2014, 35(6):690-694.)

[12]刘帅,李士近,冯钧. 多特征融合的遥感图像分类[J]. 数据采集与处理, 2014, 29(1):108-115.(LIU S, LI S J, FENG J. Remote sensing image classification based on adaptive fusion of multiple features[J]. Journal of Data Acquisition and Processing, 2014, 29(1):108-115.)

[13]OJALA T, PIETIKAINEN M, HARWOOD D. A comparative study of texture measures with classification based on feature distributions[J]. Pattern Recognition, 1996, 29(1): 51-59.

[14]OJALA T, PIETIKAINEN M, MAENPAA T. Multiresolution grayscale and rotation invariant texture classification with local binary patterns[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7): 971-987.

[15]ZHAO G, AHONEN T, MATAS J, et al. Rotationinvariant image and video description with local binary pattern features[J].IEEE Transactions on Image Processing, 2012, 21(4): 1465-1477.

[16]SETIAWAN A S, WESLEY J, PURNAMA Y. Mammogram classification using Laws texture energy measure and neural networks[J]. Procedia Computer Science, 2015, 59: 92-97.

[17]KHAN R, HANBURY A, STOTTINGER J, et al. Multiple color space channel fusion for skin detection[J]. Multimedia Tools and Applications, 2014, 72(2): 1709-1730.

[18]李强. 手部特征识别及特征级融合算法研究[D]. 北京: 北京交通大学,2006:2-15.(LI Q. Research on handmetric recognition and feature level fusion method[D]. Beijing: Beijing Jiaotong University, 2006:2-15.)

[19]DEZERT J. Foundations for a new theory of plausible and paradoxical reasoning[J]. Information & Security, 2002, 9(1):13-57.

[20]SMARANDACHE F, DEZERT J. Advances and Applications of DSmT for Information Fusion[M]. Rehoboth: American Research Press, 2006:36-50.

[21]DEZERT J, LIU Z, MERCIER G. Edge detection in color images based on DSmT[C]// Proceedings of the 14th IEEE International Conference on Information Fusion. Piscataway, NJ: IEEE, 2011: 1-8.

[22]TCHAMOVA A, DEZERT J. Intelligent alarm classification based on DSmT[C]// Proceedings of the 6th IEEE International Conference on Intelligent Systems.