基于局部稀疏的目标跟踪方法

2015-12-20王元全

曾 旭,王元全

(天津理工大学 计算机与通信工程学院,天津300384)

0 引 言

视觉跟踪的主要难点是解决在跟踪过程中出现的一些问题,例如,光照变化、外观改变、以及部分或全部遮挡。在当前的追踪技术中,产生模型和区别模型是两种主要的方法。产生模型是学习一种模型来表示目标物体,然后用它来搜索具有最小重构误差的图像区域。在IVT 方法[1]中提出在线模型来应对外观变化,以此来改善了通过离线学习进行追踪导致的目标丢失问题。最近,稀疏表示[2]被用于实现跟踪,它对于部分遮挡、光照变化和位姿改变有很好的效果。然而,这些产生算法并没有考虑背景信息,而这个因素有可能提高追踪的准确性。

区别模型把追踪当作一个分类器来构建,它目的在于从背景中区分出目标。Grabner等[3]提出一个在线半监督boosting算法来减缓漂移问题;Collins等[4]已经证明一个在线方式的选择性区别特征能提高追踪效果;Kalal等[5]提出P-N 学习算法利用潜在的正负样本结构来进行物体追踪。

本文提出了基于局部稀疏表示的目标跟踪方法,将产生模型和区别模型结合起来进行目标物体的跟踪,其中本文通过对目标区域局部图像块进行稀疏编码来表示目标,这种基于局部特征的跟踪器能够很好的应对目标的外观变化,同时,将遮挡情况进行了分类处理:对于物体中遮挡的部分和其余剩下的部分,跟踪器会采用不同的处理方法。通过逻辑回归分类器进行分类,很好地区分出目标和背景,从而实现准确的跟踪。

1 用局部稀疏编码来表示目标物体

1.1 局部稀疏表示

在本文方法中,通过局部稀疏表示建模目标的观测模型,即对局部图像块稀疏编码表示目标。第一帧初始化目标物体,在目标区域内用有重叠的滑动窗提取局部图像块,矢量化后得到目标集T =[t1,t2,…,tn1]∈Rd×n1,d代表图像块的大小,n1是图像块的数目。同样,在目标区域附近用滑动窗采样图像块,矢量化后得到背景集Tb=[tb1,tb2,…,tbn2]∈Rd×n2,为了便于表示,令n1+n2=n,则我们的字典构造由如下所示

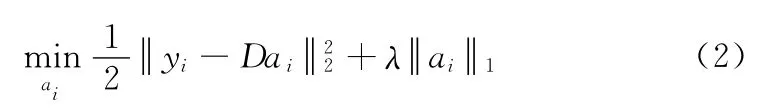

通过字典D,即可对目标区域的图像块进行编码表示,Y =[y1,y2,…,yN]∈Rd×N表示从目标区域提取的矢量化后的图像块,那么,与y1相对应的稀疏编码ai∈Rn×1,可由下式计算得到

式 (2)实际上就是Lasso回归,可以通LARS有效地解决。

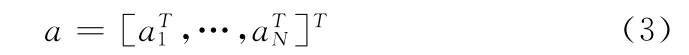

最后,连接所有的稀疏编码表示目标的观测型

1.2 遮挡的处理方法

遮挡问题作为目标追踪过程中一个不可避免的因素,我们通过对目标的观测模型进行表示的时候,修改相应的稀疏系数,从而达到具有遮挡的图像块被排除的效果,进而这个干扰问题得到了处理。假设属于目标的图像块的重构误差很小,那么就可通过设定阈值的方法对遮挡进行判断。如果所检测到的图像块的重构误差比较大,则认定其为遮挡了的图像块,从而设置与之相对应的图像块的权重为0;相反,当检测到的图像块其重构误差比较小的时候,认定其没有被遮挡,因此设置相应的系数为1,最终通过这些图像块的信息对目标的观测模型进行表示。

在本章中,候选目标的遮挡情况用向量表示,第i个元素表示第i 个图像块的遮挡情况。

方法如下

式中:εi= yi-Dαi是图像块yi的重构误差,ε0是预先定义完的阈值,可以用来判定图像块遮挡情况。如图1所示,向量i 包含N 个元素,对应于N 个图像块,每个元素取值的大小由相对应图像块的重构误差决定,如果图像块具有较大重构误差,判定为被遮挡,设置对应的稀疏为0。因此,加权的稀疏系数为

式中:⊙——点乘。

2 分类器的构建

图1 候选图像遮挡情况

近几十年来,目标跟踪问题被看作为分类问题,成为了新的研究方向,目标就是要把背景和目标分开。该种方法通过找到一个决策边界进行目标和背景的分离,因此,对于背景混乱的情况,该种方法可以很好地解决。另外,对于具有复杂运动的物体可由在线监测进行解决,通过不断的更新决策边界情况,很好地适应目标物体的变化。最近,有很多通过boosting算法来学习分类器[6]的鉴别追踪算法,本文中不同,我们使用逻辑回归分类器[7]来分类。

2.1 逻辑回归简介

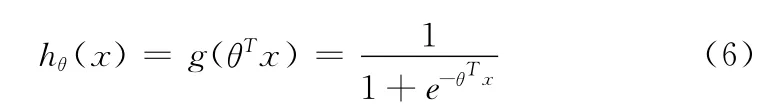

逻辑回归模型可以认为是一种logistic方程归一化后的广义的线性回归模型,通过特征学习进行分类。逻辑回归模型的数学表达式

式中:x——n维特征向量,函数g为logistic函数。

逻辑回归的损失函数

注意,式 (7)括号中的公式正是对逻辑回归进行最大似然估计中的最大似然函数,对于最大似然函数求最大值,从而得到参数θ的估计值,所以,这里求一个合适的参数,需要最小化损失函数即:minθJ(θ)。

2.2 逻辑回归分类器

本文中使用逻辑回归分类器能够很好的区分出目标物体和背景,首先进行分类器的初始化,即通过在第一帧提取正负样本来初始化分类器,这里,假定在第1帧中给定的目标物体的位置L1=(x1,y1),那么在附近小于半径γ的范围内提取正样本,其位置Lpos满足 Lpos-L1<γ。同样,负样本的选取满足环形区域γ< Lneg-L1<η,γ和η 为采样半径,即与选定目标物体中心有一定距离的一个环形区域内。

本文中我们设定yi∈{+1,-1},计算得到每个图像块的稀 疏编码形 成 训 练 数 据 为{zi,yi}Mi=1,其 中zi∈Rn,M 为训练样本的数目。

通过最小化下面损失函数来学习分类器

式中:w——分类器参数,λ控制正则项的长度,由于yi∈{+1,-1}根据式 (7)可得

对于任一候选z,其分类器的分数计算如下

一旦分类器被初始化,分类器的分数能够被用于相似性度量进行跟踪。具有最大分类器分数的样本即maxh(z),表明更加有可能属于前景目标级,所以,一般具有最大分类器分数的样本被看作当前帧的追踪结果。

3 跟踪框架

根据上述的局部稀疏表示和线性分类器两部分,提出一个基于贝叶斯推理框架下的追踪方法,即将目标跟踪问题当成是贝叶斯推理问题。

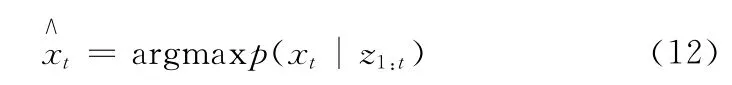

给定物体的观测值z1:t={z1,…,zt}后,可以通过最大后验概率估算目标状态变量xt,即

后验概率p(xt|z1:t)由贝叶斯理论推理得到

式中:h(·)为式 (11)定义的分类器。

4 实验分析

4.1 定性评价

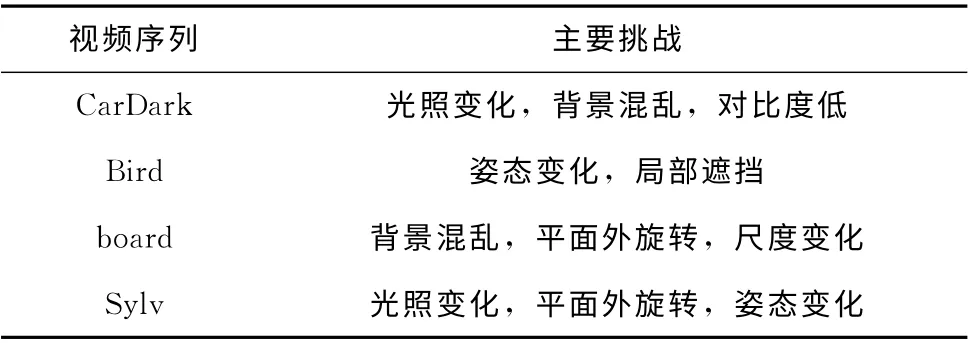

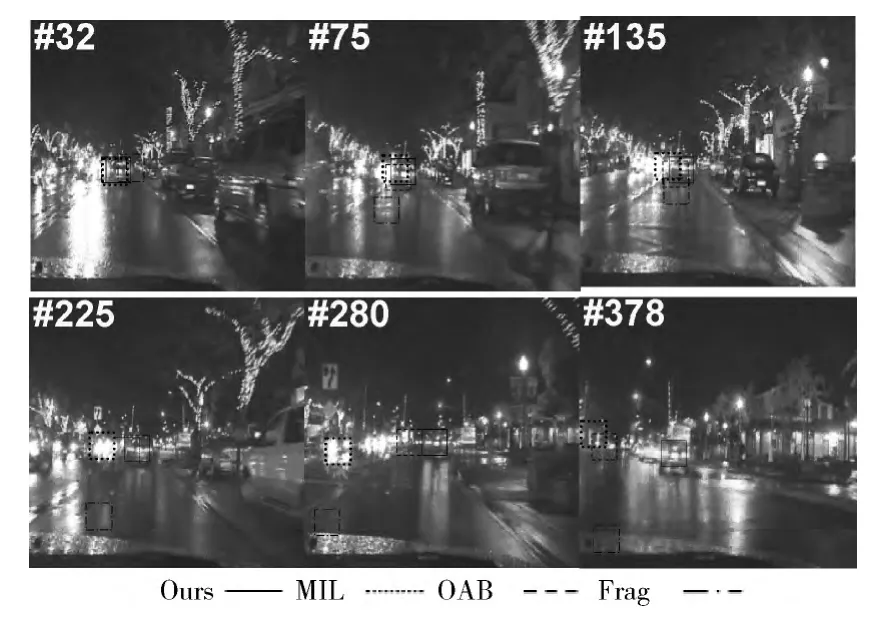

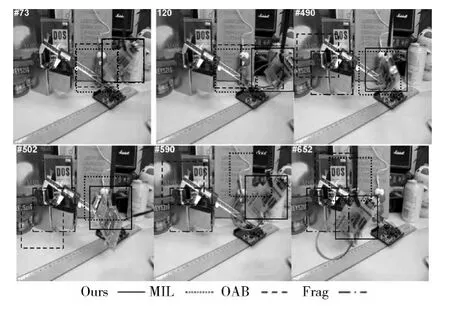

为了验证本节提出的算法的跟踪性能,我们选取5组测试视频作为实验视频,这5个视频图像序列包含的挑战性情形如:包括光照变化,背景混乱,姿态变化,遮挡,平面内外旋转,尺度变化等等。表1总结了本文使视频序列包含的跟踪挑战。实验中对本章方法、MIL (multiple instance learning)[8]和 OAB (online AdaBoost)[9]、Frag Tracker[10]4种方法进行了比较,其中短划线矩形框表示OAB算法的跟踪结果,长划线-点矩形框表示Frag算法的跟踪结果,点点矩形框表示MIL 算法的跟踪结果,实线矩形框表示本章的跟踪结果,分析结果如下。

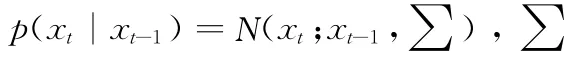

表1 用于实验测试的视频序列

图2中是CarDark视频序列,它的特点是光照的剧烈变化,汽车在这种环境下行驶,就容易造成目标和背景对比度很低的问题,这种较低的对比度和剧烈的光照变化都使得准确跟踪目标很有挑战性。从图2中可以看出,汽车在行驶的道路上一直存在着较大的光照变化,在#32Frag跟踪器有一些漂移,当对面迎来的汽车灯光照在目标汽车上 (如#75、#135 和#225),这种剧烈的光照变化使得Frag跟踪器漂移到路面背景上,目标丢失,MIL 跟踪器则逐渐发生漂移从#75有少量漂移到#225丢失目标跟踪到其它车辆上,而OAB跟踪器只是有些漂移,还能跟踪到目标汽车。#280 汽车改变方向逐渐到路边 (如#280 和#378),并且汽车正上方的路灯不断闪烁,我们看到Frag跟踪器依然丢失目标,MIL 跟踪器也逐渐远离目标,而OAB跟踪器由于汽车改变方向和路灯闪烁而丢失了目标。本文的方法在整个汽车行驶过程中跟踪的都很好,充分展示了该方法的准确性和鲁棒性。

图2 CarDark视频序列

图3中是对Bird 视频序列进行追踪的部分结果。图中小鸟悠闲的走来走去,经历了走路和转身等的姿态变化,旁边还有几只小黄鸟干扰着目标,这种姿态变化和局部遮挡给准确追踪目标增加了难度。图3中从#22开始Frag跟踪器就发生了漂移,到最后也没有准确跟踪上。而MIL 和OAB追踪器在小鸟转身前只是有少量的漂移,在#58小鸟转过身后由于外观发生了较大的变化同时旁边还有干扰产生局部遮挡,MIL和OAB追踪器漂移量逐渐增大,到#89时OAB追踪器完全丢失了目标。而从结果中可知我们的方法全程都可以实现较好的跟踪,这种基于局部特征的跟踪器能很好的应对目标外观变化。

图3 Bird视频序列

从图4中可以看出,Board视频对于准确追踪目标很有挑战性,因为视频序列中的目标经历了背景凌乱、面外旋转以及尺度变化。从#73和#120可以看出Frag 跟踪器只有在外观没有剧烈变化的情况下才能够跟踪准确,当目标加快速度移动和旋转时 (从#490 和#502 可以看出),Frag跟踪器不能完成跟踪任务。而OAB 和MIL 跟踪器在一开始目标经过背景凌乱的情况下就不能准确跟踪目标,当目标发生旋转时,MIL 跟踪器能够跟上目标 (#490 和#502),但是到后来还是发生了漂移,到最后丢失了目标(#652)。从图4中我们可知OAB 跟踪器一直都没能准确跟踪到目标。本文的方法能够比较好的进行跟踪,因为在线构造的字典既包含了目标信息又包含了背景信息,具有一定的区别性,逻辑回归分类器的使用也能很好的出目标和背景。从图6中也可看出我们的方法跟踪误差最小。

图4 Board视频序列

图5是Sylv视频序列的部分跟踪结果,该视频中玩偶在房间内做出各种变化姿态旋转角度,同时还在不同的光照条件下来回移动,因此Sylv视频的挑战在于对不同光照条件下长时间的移动且过程中伴随着各种姿态角度的变化。从图5中可以看出,4种跟踪方法几乎都能准确跟踪 (如#130),随着玩偶不停地长时间的移动变化姿态,MIL 跟踪器开始出现了漂移现象,一直到#462 都跟踪的不是很准确;Frag跟踪器在前面300帧表现很好,但是经历了长时间的来回移动后出现跟踪失效 (如#386);OAB 跟踪器的跟踪效果比MIL跟踪的好,从图中#386出现明显漂移现象,最后#462 的视角变化时也没有准确跟踪到玩偶。而我们的方法在整段视频中无论是光照下长时间来回移动还是平面外旋转的变化下都能准确跟踪到目标。

图5 Sylv视频序列

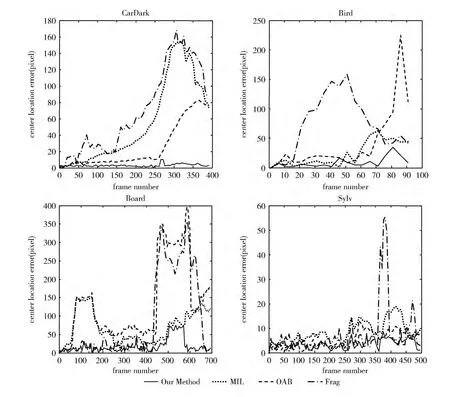

4.2 定量评价

为了客观准确的评估本文方法和其它3 种跟踪方法,本文使用目前广泛流行的跟踪结果与真值间的中心点位置误差作为衡量准则。其计算公式如下

式 (15)是xg和yg分别代表人工标定的目标真实值的x 方向和y 方向的坐标值:xt和yt分别代表不同方法的跟踪结果在两个坐标轴上的值。

如图6所示中心位置误差的曲线图,这里横纵坐标分别表示的是序列帧号和中心位置误差像素个数,结果表明本文方法在4种具有不同跟踪挑战的视频中都有比较好的表现,相对于另外3种跟踪方法有一定的优势。

5 结束语

本文通过局部稀疏表示目标物体,使得这种基于局部特征的跟踪器能够很好的应对目标的外观变化,同时文中对遮挡做了处理,使得跟踪器对遮挡部分和未遮挡部分采用不同的处理方式,即通过修改稀疏系数剔除被遮挡的图像块,最后通过逻辑回归分类器进行分类,很好地区分出目标和背景。文本方法很好地解决了由于位姿或遮挡等局部细节变化而造成的跟踪失败问题。实验结果表明,我们的跟踪方法与其它主流跟踪方法相比具有更好的性能。

图6 4种视频图像的跟踪误差曲线

[1]Ross D,Lim J,Lin R,et al.Incremental learning for robust visual tracking [J].International Journal of Computer Vision,2008,77 (1-3):125-141.

[2]Mei X,Ling H.Robust visual tracking using l1 minimization[C]//International Conference on Computer Vision,2009:1436-1443.

[3]Grabner H,Leistner C,Bischof H.Semi-supervised on-line boosting for robust tracking [C]//European Conference on Computer Vision,2008:234-247.

[4]Kwon J,Lee KM.Visual tracking decomposition [C]//IEEE Conference on Computer Vision and Pattern Recognition,2010:1269-1276.

[5]Kalal Z,Matas J,Mikolajczyk K.P-N learning:Bootstrapping binary classifiers by structural constraints [C]//IEEE Conference on Computer Vision and Pattern Recognition,2010:49-56.

[6]Avidan S.Ensemble tracking [J].IEEE Transactions on PAMI,2007,29 (2):261-271.

[7]Ng A,Jordan M.On discriminative vs.generative classifier:A comparison of logistic regression and naive Bayes [C]//Neural Information Processing Systems,2002:841-848.

[8]Babenko B,Yang M,Belongie S.Robust object tracking with online multiple instance learning [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33 (8):1619-1632.

[9]Grabner H,Leistner C,Bischof H.Semi-supervised on-line boosting for robust tracking [C]//European Conference on Computer Vision,2008:234-247.

[10]Adam A,Rivlin E,Shimshoni J.Robust fragments-based tracking using the integral histogram [C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition,2006:798-805.