一种基于历史背景的混合高斯背景建模算法

2015-11-30肖进胜刘婷婷张亚琪彭红鄢煜尘

肖进胜 刘婷婷 张亚琪 彭红 鄢煜尘

摘要:针对背景场景重复显现问题,提出了一种基于历史背景的混合高斯模型(History Background-based GMM,HBGMM)。相较于传统的混合高斯模型,该模型对历史背景模型进行标记,并通过判决匹配次数快速调整历史背景模型的学习率。同时对模型权重低于阈值下限历史模型和非历史模型进行区别处理,用该方法更新模型权重从而降低误检率,使历史模型尽量避免误删除。实验结果表明,本文提出的基于历史背景的混合高斯背景模型能够实现记忆背景的功能,从而更快地适应场景的变化,减少前景误判。

关键词:视频处理;背景建模;混合高斯模型;历史背景

中图分类号:TN919 文献标识码:A

背景减除是自动视频对象分析的一项关键技术,他在智能视频监控等领域中有着非常广泛的应用。对视频场景进行背景建模,将存储好的背景模型和新观察到的图片进行背景减除来提取运动目标是较为常用的方法\[1\]。原理虽然简单,但是真实世界中像素在时域和空域中的复杂变化,使得背景建模变得很困难。比如阴影检测、亮度的缓慢或剧烈改变等都是现在背景建模的难点\[2-3\]。近年来,国内外学者提出了许多建立背景模型的方法,包括针对含有纹理的动态场景,采用一种新的模糊色彩直方图特征来减弱运动背景造成的色彩改变\[4\];为每一个像素点建立一个由4层前馈神经网络组成的背景模型\[5\];结合颜色、梯度、不同特征来构建背景模型,采用支持向量机来进行背景分类\[6-7\]等。

湖南大学学报(自然科学版)2015年

第10期肖进胜等:一种基于历史背景的混合高斯背景建模算法

高斯模型是近年发展起来并得到广泛应用的一种技术。Stauffer等\[2\]提出利用混合高斯模型来建立背景模型,在每帧中对各个像素点建立由多个高斯分布组成的背景模型。自此以后,该方法以其能较为鲁棒地描述多峰分布的背景而被广泛应用,但其仍然具有处理速度较慢、无法应对突变背景等缺点\[8\]。此后的研究者对混合高斯背景建模方法做了各种改进。Zivkovic Z\[9\]针对自适应高斯混合模型的个数和参数问题进行了改进,利用最大似然估计进行高斯模型个数的选择。文献\[10\]考虑到全局抖动造成的运动目标检测不准确的问题,提出基于分区灰度投影稳像的高斯背景建模算法。文献\[11\]针对亮度场景的变化,建立亮和暗不同的模型进行亮度场景变化的检测和估计。文献\[12\]为了解决场景中存在的突变,提出基于记忆的混合高斯模型(Memory-based GMM, MGMM)的前景检测算法,取得了很好的检测效果,但是该算法中每个像素都要经过瞬时记忆、短时记忆和长时记忆3个空间的传输和处理,影响了算法效率和实用性。上述方法对混合高斯模型的修改多数集中在提高模型的处理效率与收敛速度方面。当现有的混合高斯建模算法应用到实际场景中时,若背景场景重复性出现时,如被重复性的遮挡与显露,受模型学习速度的影响,重新显露出的背景场景的变化不能被立即学入背景模型中,依然会被检测为前景,从而产生大量误判。

本文针对视频中背景经常重复性地被遮挡与显现的场景(如智能视频监控场景中),提出了一种基于历史背景的混合高斯模型(History Background-based GMM, HBGMM)。经过模型学习,基于历史背景的混合高斯模型对重复出现过的背景具有记忆功能;当重复性背景再次出现时,能及时判决出背景与前景,从而使被误判成为前景的背景快速消融至背景中。

1混合高斯模型原理分析

经典的混合高斯模型\[2\]对视频图像中的每一个像素点定义K个状态,其值一般取3~5。若每个像素点的像素值用Xt表示,则对应的概率密度函数可用K个高斯函数来表示:

f(Xt=x)=∑Ki=1ωi,tη(Xt,μi,t,Σi,t)。 (1)

式中:η(Xt,μi,t,Σi,t)为t时刻的第i个高斯模型;ωi,t为时刻t第i个高斯模型的权重,且有K个权重的和为1。 这里假定视频各帧图像中各点的像素值在R,G,B3个颜色通道\[13\]是相互独立的,并且具有相同的方差,σi,t为标准差,那么协方差矩阵可以取值为:

Σi,t=σi,t2I。 (2)

其中I为单位阵。所有K个高斯模型首先按照ωi,t由大到小排序,然后从首端选取B个高斯模型作为背景模型。其中B满足:

B=argminb(∑bi=1ωi,t>Thershold)。 (3)

式中:Thershold为预先给定的权重阈值,是用于选择模型个数的阈值,一般取值为0。7~0。9。对于新的一帧图片,若当前图片中点的像素值与其中某个高斯模型的均值和标准差满足:

Xt+1-μi,t<δσi,t。 (4)

则认为该像素值与高斯模型匹配(通常δ设为2~4)。高斯分布的参数采用在线K均值近似算法进行更新\[9\],对于第1个匹配上的高斯模型,更新其所有参数,而对于其他K-1个高斯模型,仅更新权重,权重更新公式为:

ωi,t+1=(1-α)ωi,t+αOi,t+1。 (5)

对于首次匹配的模型,Oi,t+1取1,对于其他模型,Oi,t+1取0。ωi,t和ωi,t+1分别为更新前和更新后的权重。均值与方差更新的公式为:

μi,t+1=(1-α)μi,t+αXt+1; (6)

σ2i,t+1=(1-α)σ2i,t+α(Xt+1-μi,t+1)T×

(Xt+1-μi,t+1)。 (7)

式中:μi,t和μi,t+1分别为更新前后的均值;σ2i,t和σ2i,t+1分别为更新前后的方差;α为学习率,取值为0。002~0。005。如果当前像素点无法与所有模型匹配,就用一个新的均值为Xt+1、高方差和低权重的高斯分布取代尾端的高斯分布。

传统高斯模型应用于复杂的现实环境中时计算复杂,其计算量与所用的高斯模型的个数成正比,而且模型参数难以调整\[14\]。同时在有重复性的背景场景出现时,背景点则会因为像素值的突然变化,而被误检为前景点,造成误判。一个理想的背景减除系统应具有一定的自适应能力,其背景模型应可以根据场景的变化自适应地保持与更新背景模型。

2基于历史背景的混合高斯模型

针对经典混合高斯模型的问题,如果在使用混合高斯模型对背景进行建模实现背景减除的过程中,对曾经判断成为背景的模型进行标记,标记其为历史模型。在之后的更新与匹配过程中,对历史模型记录其匹配次数,在一个周期内,若匹配次数超过用户设定门限,则在下次匹配成功之后,额外为该模型增加T倍的α,通过模型的权重降序排列,使其迅速增长至模型队列前端,落入背景模型的背景权重范围内,从而被判决为背景而不是前景。就能够在一定程度上解决前面提到的问题。

本算法对经典的高斯模型改进有以下2点:

1)对历史背景进行标记,以P帧为周期,记录该周期内历史背景的匹配次数,若匹配次数超过用户设定门限N,则在下次匹配成功之后,额外为该模型增加T倍的α。权重更新公式(5)更改为如下所示。

ωi,t+1=(1-α)ωi,t+αOi,t+1+αci,t+1。 (8)

式中:α,ωi,t和ωi,t+1与式(5)含义相同。对于满足历史背景更新条件的模型,ci,t+1取值为T,对于其他模型,ci,t+1取0。这里历史背景更新条件是指:若当前模型被匹配上,且该模型权重处于前景范围,在周期P内匹配次数超过N次。P与N若取值过小,会对图像中的噪声较为敏感;若取值过大,建模算法又无法及时适应视频图像中前景对象与背景的变化,因此,本文中取P为10,N为5。符合该条件的模型,会在原始权重更新的基础上,再加上Tα的新权重。实验表明,当T≥3时,前景过快消融,而当T<2时,对重复背景的处理效果不明显,因此将T设为2。

2)当模型权重小于某一门限时,对于历史模型和非历史模型进行区别处理。非历史模型将会被删除;而历史模型仅将其权重置为0,并不删除。

算法的具体描述如下:

步骤1第1帧时初始化记忆空间,用当前帧的图像像素(Ri,Gi,Bi)创建每像素点的第1个高斯模型,将其权重赋为1,并分配初始方差。

步骤2对每一帧新的图像,将每个像素点的K个模型按权值从大到小排序。根据式(3)从首端选取B个高斯分布作为候选背景模型,Thershold为用户自定义的阈值。

步骤3将新的采样值Xt+1(R,G,B)依次与原有K个高斯模型进行匹配,若δ=3时,式(5)成立,则认为该点匹配当前模型,若匹配上的模型落在步骤2中的B个模型内,则判断该像素点为背景,同时将当前模型标记为历史模型,否则,该像素点为前景点。找到匹配模型后不再寻找其他匹配模型,执行步骤4;若当前点未匹配上任何模型,转步骤5。

步骤4如果找到匹配模型,按照式(8),(5),(6),(7)更新匹配模型的权重、均值和方差,若该模型为历史模型,则记忆其匹配次数。在固定周期内(如10帧),匹配次数超过N次,则权重额外增加T倍的α。其他未匹配模型只更新权重,同时对所有模型按权重进行降序排列。 在模型的权重更新完成后,若该模型的权重小于某给定值αCT,当其未被标记为历史模型时,删除当前模型;否则,只将当前模型权重置为0,不删除该模型。

步骤5如果当前点未匹配上任何模型,按照式(8)更新所有模型的权重。在模型个数未达到用户设定上限时,生成一个新的模型加入模型队列;否则,用这个新模型取代权重最小的模型。同样,最后对所有模型按权重进行降序排列并归一化。

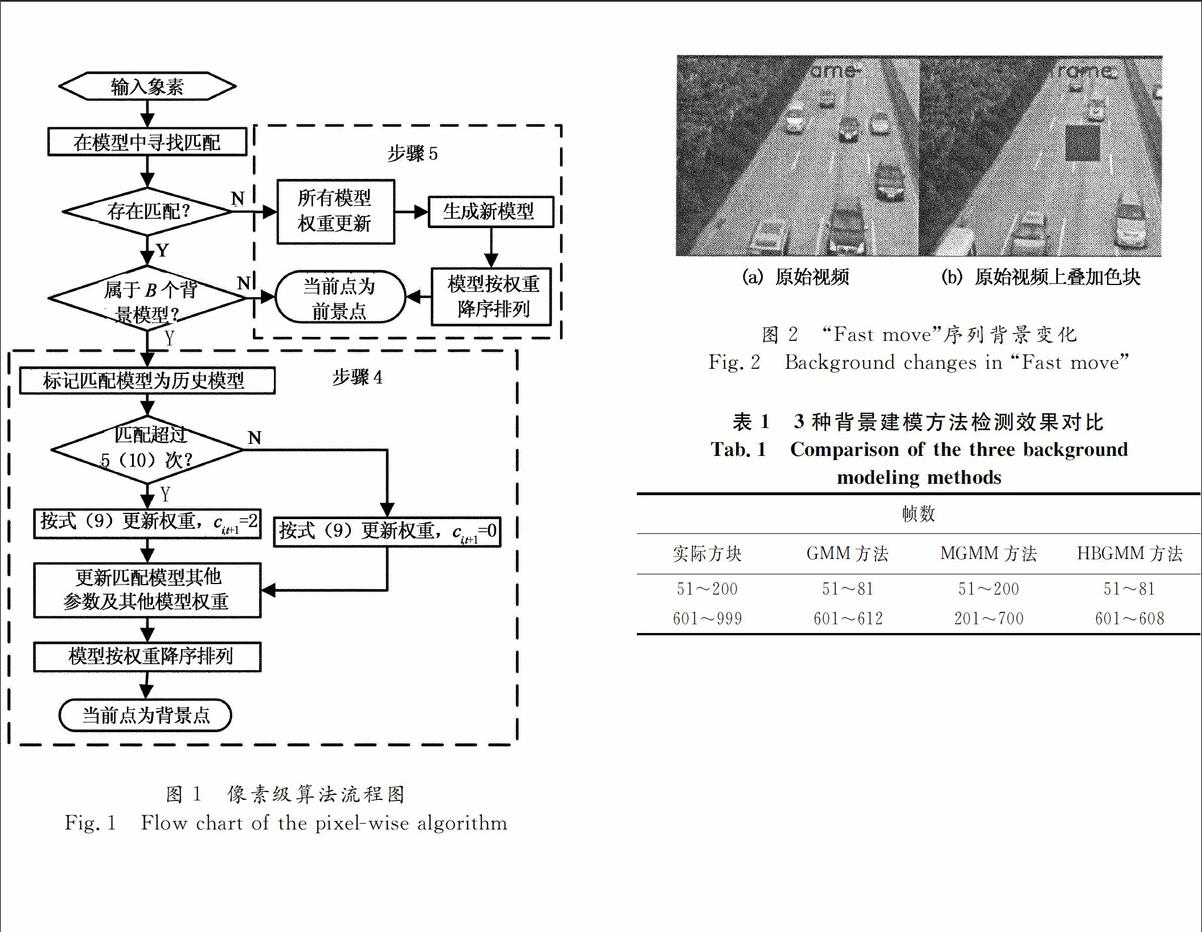

根据上面的模型分析,基于历史背景的混合高斯背景建模算法流程如图1所示。

在传统混合高斯模型更新过程中,引入曾经是背景模型的标记,并根据这一标记,对历史背景模型进行不同的更新处理,则有可能实现记忆背景的作用,在背景重复出现时,避免将其误检为前景。

3实验结果及讨论

为验证本文所提历史模型算法的有效性,在2。4 GHz酷睿i3双核处理器上,VS2005编程环境下,用序列进行了测试,并与传统GMM方法\[2\]以及文献\[12\]的MGMM方法进行了对比。为保证方法比较的有效性,3种方法基本参数取值相同,分别为Thershold=0。75,ω =α,其中GMM和本文算法K

=5,σ=20;MGMM算法中K=4,N=1,σ=25。

学习率计算方法为:

α=1/(2frame),frame<500;0。002,frame≥500。 (9)

式中:frame为帧数。

图1像素级算法流程图

Fig。1Flow chart of the pixelwise algorithm

为了更好地测试重复性背景问题,在序列“fast move”中叠加一个每隔400帧出现的色块,用该色块来模拟重复出现的运动目标,初始50帧用于模型学习,不叠加色块。色块消失后,由原位置被误检为前景的部分消失所需的帧数来定量判决不同背景建模算法处理重复背景的能力。

图2(a)显示了用于测试的视频原始图像,图2(b)为原始视频叠加色块的效果。图3从左到右依次给出序列分别为608,612原始帧,采用经典GMM方法、文献\[12\]的MGMM方法以及本文提出的HBGMM方法的前景检测结果。 表1为3种方法在测试帧中重复出现的色块检测为前景的帧数。

由表1可见,有色方块在视频的51~200帧与601~999帧出现,当其第2次在600帧出现时,由于之前出现过,该像素值曾被学习入背景模型中,此时重新出现的色块应该快速地被吸收入背景,而不应被检测为前景目标。但传统的混合高斯模型经过了12帧才将其吸收成背景,而本文所用方法仅用了8帧。由图3可知,本文算法的检测结果被误检为前景的目标更少,消失速度更快。由此可见,在重复性背景出现时,本文方法能够更快地将其吸引消融成背景,而不会长时间内仍被检测为前景。

图2“Fast move”序列背景变化

Fig。2Background changes in “Fast move”

表13种背景建模方法检测效果对比

Tab。1Comparison of the three background

modeling methods

帧数

实际方块

GMM方法

MGMM

方法

HBGMM方法

51~200

51~81

51~200

51~81

601~999

601~612

201~700

601~608

为了更精确地测试建模算法的效果,本文选用了两段带有真实前景(Ground truth)的视频序列,并采用F1得分来评估检测出的前景与真实前景的相似程度。F1得分的计算方法为:

F1=2prp+r,p=tt+f,r=tt+n。 (10)

式中:F1为得分值;t,f,n分别为正确检测、错误检测和未检测出的前景点个数。检测出的前景点是否正确,可以通过与Ground truth对比得知。F1得分的最高分为1,最低分为0,分值越高表明检测出的前景越准确,建模效果越好\[12\]。

“Office”序列中,当人物离开站立位置,其身后的墙壁再次显露出来,根据Ground truth,此时该处墙壁应被检测为背景。因此,对此时视频序列的前景检测结果计算F1得分。图4分别给出了第2 002(上图)和第2 006帧(下图)的前景检测结果。

图3“Fast move”序列前景检测结果

Fig。3 The segmentation results of “Fast move”

图4“Office”序列前景检测结果

Fig。4 The segmentation results of “Office”

由图4可见,本文提出的HBGMM建模算法比GMM算法和MGMM算法能够更快地将重复出现的墙壁吸收为背景。3种建模算法检测结果的F1得分如表2所示。由表2可知,HBGMM算法的F1得分均高于GMM算法与MGMM算法,可见,当重复背景出现时,HBGMM算法检测出的前景更为准确。

表2对“Office”序列3种方法检测结果的得分对比

Tab。2Comparison of score for “Office” sequence

with three methods

帧号

F1

GMM方法

MGMM

方法

HBGMM方法

2 002

0。546 9

0。421 8

0。566 4

2 006

0。525 9

0。415 0

0。548 6

为了进一步测试HBGMM算法的效果,本文选用了另一段室内监控视频“Sofa”,当人物将原本置于沙发上的行李移走时,原被行李遮盖后显露的沙发应被检测为背景。图5显示了在该场景中的两帧画面(第2 471,2 486帧)及相应建模算法的检测结果。表3为该3帧前景检测结果的F1得分。

表3对“Sofa”序列3种方法检测结果的得分对比

Tab。3Comparison of score for “Sofa” sequence

with three methods

帧号

F1

GMM方法

MGMM

方法

HBGMM方法

2 471

0。737 1

0。527 3

0。746 7

2 486

0。782 6

0。658 5

0。784 1

由表3可知,相较于GMM和MGMM建模算法,HBGMM算法的F1得分最高。同时,由图5可知,HBGMM算法在处理重复背景问题时,能够更快地将误检为前景(见重新显露出的沙发部分)的像素点吸收为背景。

图5“Sofa”序列前景检测结果

Fig。5The segmentation results of “Sofa”

4结论

本文在传统混合高斯模型更新过程中,引入曾经是背景模型的标记,并根据这一标记,对历史背景模型进行不同的更新处理。同时,与传统的GMM方法及MGMM方法进行重复性背景的对比实验。结果显示,本文所提出的方法实现了记忆重复背景的功能,从而更快地适应场景的变化,减少前景误判,适用于存在重复性运动场景的建模。

参考文献

[1]BRUTZER S,HOFERLIN B,HEIDEMANN G。Evaluation of background subtraction techniques for video surveillance \[C\]//IEEE Conference on Computer Vision and Pattern Recognition。Providence, RI,2011:1937-1944。

\[2\]STAUFFER C,GRIMSON W E L。Adaptive background mixture models for realtime tracking\[C\]//IEEE Conference on Computer Vision and Pattern Recognition。 Fort Collins,1999。

\[3\]WU Chuan,WANG Yuanyuan, KARIMI H R。 A robust aerial image registration method using Gaussian mixture models\[J\]。 Neurocomputing, 2014,144: 546-552。

\[4\]WONJUN Kim, CHANGICK Kim。 Background subtraction for dynamic texture scenes using fuzzy color histograms\[J\]。 IEEE Signal Processing Letters, 2012, 19(3): 127-130。

\[5\]王志明, 张丽, 包宏。 基于混合结构神经网络的自适应背景模型 \[J\]。 电子学报, 2011,39(5): 1053-1058。

WANG Zhiming, ZHANG Li, BAO Hong。 Adaptive background model based on hybrid structure neural network \[J\]。 Acta Electronica Sinica, 2011,39(5): 1053-1058。(In Chinese)

\[6\]HAN B, DAVIS L S。 Densitybased multifeature background subtraction with support vector machine \[J\]。 IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(5): 1017-1023。

\[7\]YAO J,ODOBEZ J M。 Fast human detection from video using covariance features\[C\]//The Eighth International Workshop on Visual Surveillance。Marseille,2008。

\[8\]LIN Hornghorng, CHUANG Jenhui, LIU Tyngluh。 Regularized background adaptation: A novel learning rate control scheme for gaussian mixture modeling\[J\]。 IEEE Transactions on Image Processing, 2011, 20(3): 822-836。

\[9\]ZIVKOVIC Z。 Improved adaptive Gaussian mixture model for background subtraction\[C\]//IEEE International Conference on Pattern Recognition。 IEEE,2004:28-31。

\[10\]肖进胜,单姗姗,易本顺, 等。基于区分灰度投影稳像的运动目标检测算法\[J\]。湖南大学学报:自然科学版,2013, 40(6):96-102。

XIAO Jinsheng, SHAN Shanshan,YI Benshun, et al。 Moving targets detection based on subzone gray projection video stabilization\[J\]。Journal of Hunan University:Natural Sciences, 2013,40(6):96-102。(In Chinese)

\[11\]CHENG Fanchieh,HUANG Shihchia,RUAN Shanqjang。 Illuminationsensitive background modeling approach for accurate moving object detection\[J\]。 IEEE Transactions on Broadcasting, 2011, 57(4):794-801。

\[12\]齐玉娟, 王延江, 李永平。 基于记忆的混合高斯背景建模\[J\]。自动化学报, 2010, 36(11): 1520-1526。

QI Yujuan,WANG Yanjiang, LI Yongping。 Memory based Gaussian mixture background modeling\[J\]。 Acta Automatica Sinica, 2010, 36(11): 1520-1526。 (In Chinese)

\[13\]XIAO Jinsheng, LI Wenhao, LIU Guoxiong,et al。Hierarchical tone mapping based on image color appearance model\[J\]。IET Computer Vision, 2014, 8(4): 358-364。

\[14\]LEE D S。 Effective Gaussian mixture learning for video background subtraction\[J\]。IEEE Transactions on Pattern Analysis and Machine Intelligence, 2005, 27(5): 827-832。