基于ARM和DSP空中运动目标实时跟踪系统研究

2015-10-10熊显名李小勇

王 永,熊显名,李小勇

(1.桂林电子科技大学 电子工程与自动化学院,广西 桂林 541004;2.广西交通科学研究院 研发部,广西 南宁 530007)

基于ARM和DSP空中运动目标实时跟踪系统研究

王 永1,熊显名1,李小勇2

(1.桂林电子科技大学 电子工程与自动化学院,广西 桂林 541004;2.广西交通科学研究院 研发部,广西 南宁 530007)

对空中目标物体实时跟踪目前主要采用雷达探测的方法,但时常会受到电磁场与电磁波的干扰,降低了探测的准确性,为解决此类问题,提出了一种基于空中视觉实时跟踪系统的解决方案。该方案适用于小范围空中动态物体的跟踪,包括动态目标的差值提取,二值图像的滤波和模板图像的实时更新,以及动态目标的特征提取、云台控制。为提高系统的准确检测性,提出了一种基于改进的动态模板匹配与帧间差分相结合的空中目标检测方法。该方法有效地解决了电磁场干扰、环境变化使动态目标无法捕捉的问题,根据实验表明,该系统能够很好地检测到空中动态物体,具有很好的鲁棒性、实时性和清晰度。

空中视觉;云台控制;动态模板匹配;帧间差分;目标检测

目前,对空中目标动态物体的实时跟踪主要采用雷达探测方法。本系统不同于常规的雷达监测系统,空中视频跟踪系统具有高精度、隐蔽性、直观性、抗电子干扰等优点,使其在军事上得到广泛应用。在对空中飞行目标如飞机和导弹的捕获、跟踪、打击过程中,离不开具备高精度、高速度的图像处理技术的探测跟踪设备。

对空中动态目标的跟踪可实时获取目标的动态信息,目标在空中的相对位置和动态目标的相对面积以及目标的方位角等信息。对空中目标跟踪的根本核心是对动态目标的提取[1-3],根据提取的动态目标来确定目标的位置信息,求取目标物体与中心点的偏差值,作为云台控制器的输入参数控制云台的转动将动态物体处于视场的中心位置。对运动目标跟踪的研究主要分为人工神经网络和图像处理的方法,由于人工神经网络过于复杂,所以常用图像处理的方法来对动态目标进行跟踪,现有的比较流行的方法有光流法、背景差分法、帧间差分法、模板匹配法,但光流法[4]三维物理结构信息量大,算法复杂,耗时太长,背景差分法和帧间差分法结构简单,程序计算量小,能够快速得到目标物体的轮廓,但背景差分法[5]受光线强度,背景变化的影响比较大,由静止到运动会出现“鬼影”现象。帧间差分法[6]不需要建模速度非常快,能够克服光线的影响,但是检测阈值需要人工设定。动态模板匹配法[7]虽然能够准确得到动态目标物体,但需要提前设置模板,为了快速得到精确的动态物体在空中的位置,克服光线对物体的影响,本系统将帧间差分法与动态模板匹配法有机地结合起来,实现它们各自的优点,以实现精确捕捉。

1 系统的设计与实现

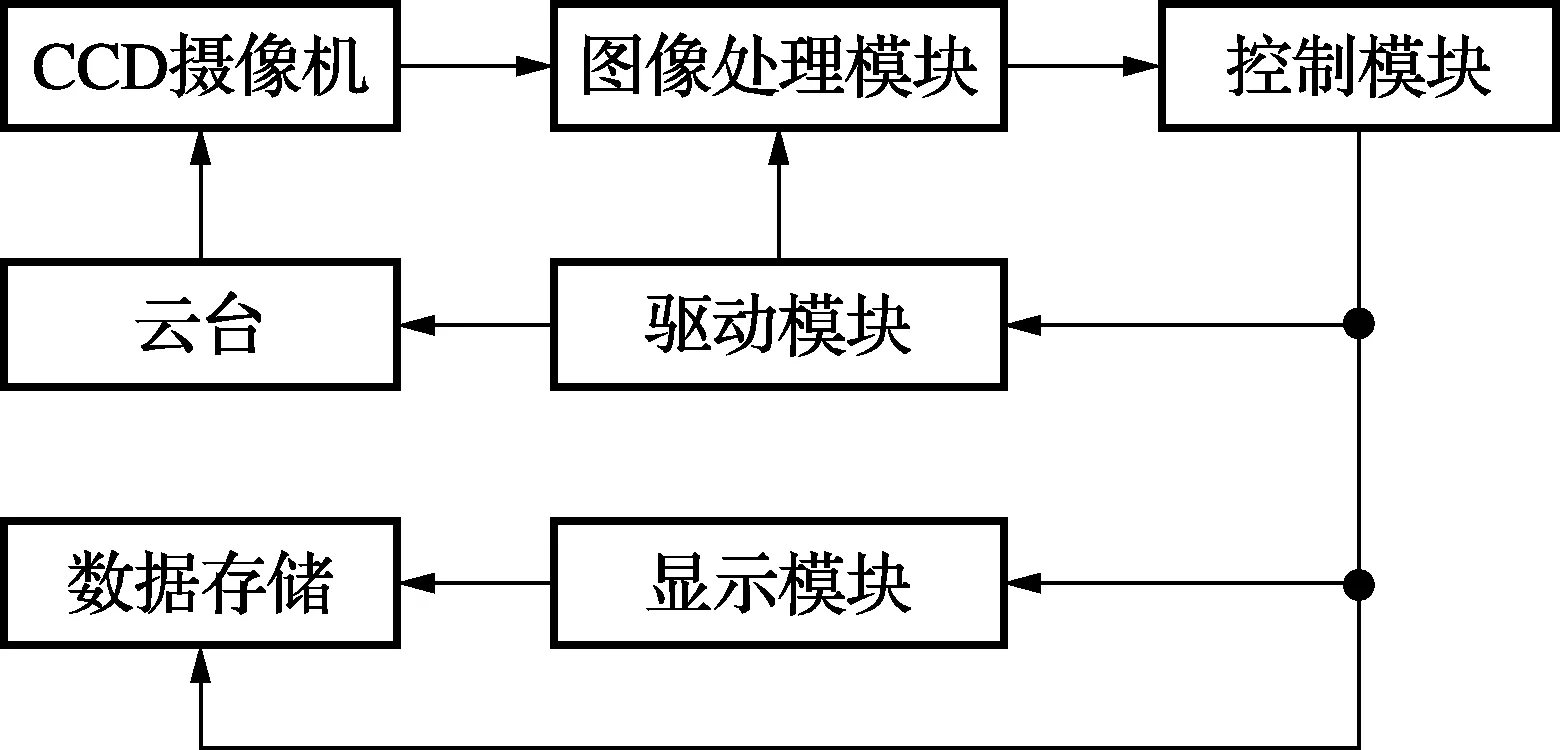

系统由CCD摄像机、图像处理模块(DM642)、控制模块(STM32)、驱动模块、云台以及显示模块组成。系统整体结构框图如图1所示。硬件实物如图2所示。

图1 系统整体结构框图

图2 系统硬件实物图(照片)

系统将CCD采集到的视频序列经过DSP(DM642视频处理专用芯片具有极高的处理速度)[8-9]处理得到动态目标,完成目标检测与识别,将目标在视场的二值图像通过高速网络实时传输给ARM(STM32具有网络传输及显示、控制能力强的特点)[10],计算出目标在视场中形心坐标与视场中心坐标的偏差,输出给控制云台,以使目标始终保持在视场中心附近,同时将图像信息通过显示模块进行显示并进行存储,本系统将DSP与ARM相结合,发挥它们各自的优点,使系统整体处理速度更快,更加稳定,达到实时性。

具体程序实现分为两部分,由DSP实现目标物体的动态检测、识别与图像的传输,另一部分由ARM实现,主要是对接收到的只含有目标物体的图像进行分析,提取特征值,控制云台与显示存储功能。

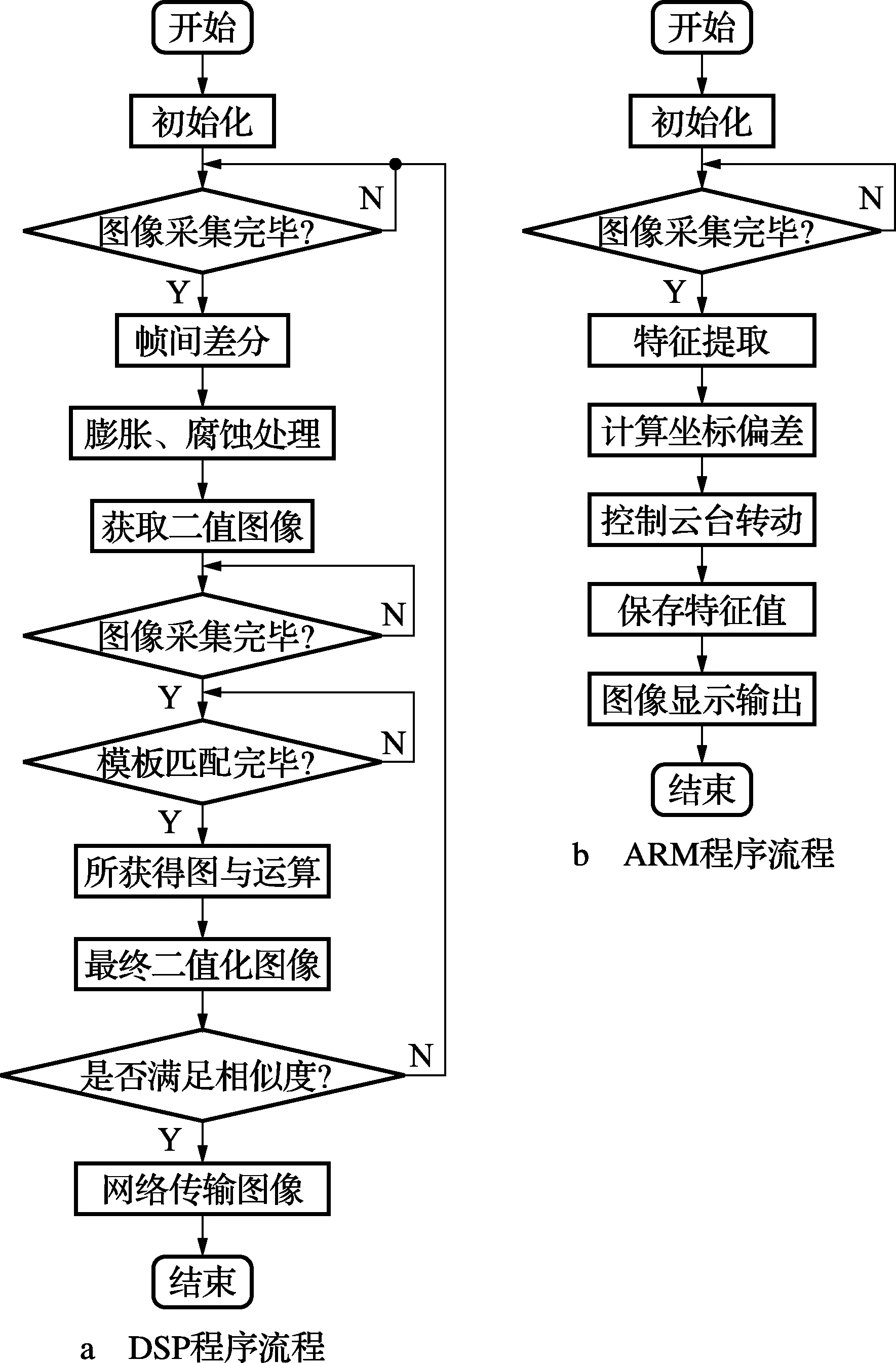

系统的程序流程图如图3所示。实现步骤如下:

1)首先系统进行初始化,系统将采集到的图像帧与帧做差,根据最大类帧间方差求得阈值,从而得到二值图像。

2)将得到的二值图像进行滤波与开运算,去除噪声带来的亮点,经过腐蚀和锐化算法,得到清晰的动态物体的轮廓。

3)计算出形心位置,以形心为中心选取合适的矩形区域作为下一帧模板匹配算法模板,而后续的目标检测均采用模板匹配法,从而得到运动目标物体。再根据阈值得到二值图像与帧间差分法相与开运算,得到清晰的二值图像,判断与之前的相似度,如果太小重新采集,这样避免帧间错位现象。

4)根据二值图像运算得到形心与视场中心的距离,计算匹配区域,同时通过云台控制算法,控制云台的仰俯、旋转,使得动态物体的形心在视场的中心附近。

图3 程序流程图

2 目标检测与跟踪的实现

2.1 目标检测的实现

首先采用最大类间方差阈值分割法[11],通过初始的阈值将图像分割,然后计算出最佳的分割阈值T。用帧间差分法初步的找到动态目标物体,在检测范围内出现动态物体时,帧与帧之间有很大的区别,做差后得到亮度差的绝对值,然后判断是否大于阈值来分析动态物体的轮廓,第k帧图像与k+1帧图像变化表示如下

(1)

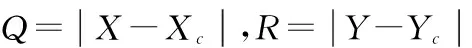

式中:T为二值化图像的阈值,为“1”的部分是前后两帧灰度值变化的部分,“0”的部分为两帧图像不变化的部分,根据阈值的不同得到的二值图像不同,本系统采用了最大类间方差获得阈值T,将获得的B(i,j)作为模板图像,模板图像根据帧间差分不断地进行更新,解决了模板更新实时性的问题,避免了目标姿态变化而带来匹配失败的问题,如图4~图5所示。

图4 二值图像

图5 更新的二值图

所得到的图像B(i,j),即匹配目标所在的图像灰度,图像大小为M×N,根据模板匹配算法,将模板图像在需要匹配图像中移动,求取当前图像像素点与模板的绝对值[12]

(2)

(3)

这样能够大大减少匹配的运算量[13],使检测更加精准,避免了不必要的运算,根据匹配结果得到的图像F(i,j)与B(i,j)相与再开运算,得到精确的运动目标,避免了当前帧不匹配的问题,表达式如下

DG(i,j)=F(i,j)&B(i,j)

(4)

(5)

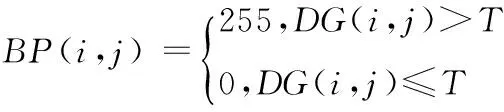

得到的二值图像BP(i,j)如图6~图7所示。

图6 第245帧原图及转化的二值图像

图7 第263帧原图及转化的二值图像

2.2 云台跟踪算法的实现

根据求得的动态目标物体的二值图像,很容易确定形心做视场中的位置,由上可知为(Xc,Yc)视场中心点位置为(P,O),可得到形心坐标与视场中心位置的偏差值,即Δx=Xc-O,Δy=Yc,假设本系统的云台转速和仰俯速度固定,设为k,v,则可得到

(6)

式中:tx和ty分别为云台上下、左右移动Δx,Δy像素间距所用的时间。笔者将采集到的当前视场建立坐标系,由于视场是变动的,所以偏差是根据每帧图像进行实时更新的。计算当前位置的图像形心坐标与视场中心位置的偏差。根据偏差来计算移动的时间作为云台的启停信号。使形心始终向视场中心靠近。经过反复试验可知,能够很好地实现跟踪,试验结果如图8~图9所示。

图8 云台移动前帧图

图9 云台移动后帧图

3 实验结果分析

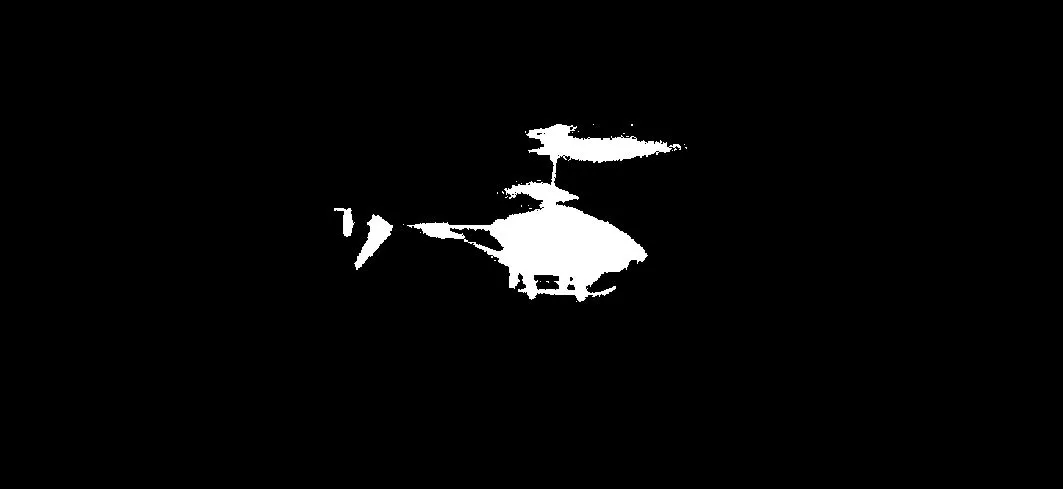

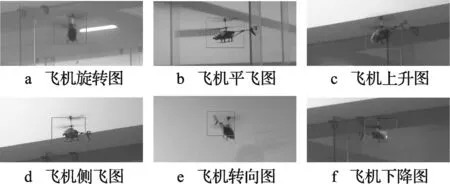

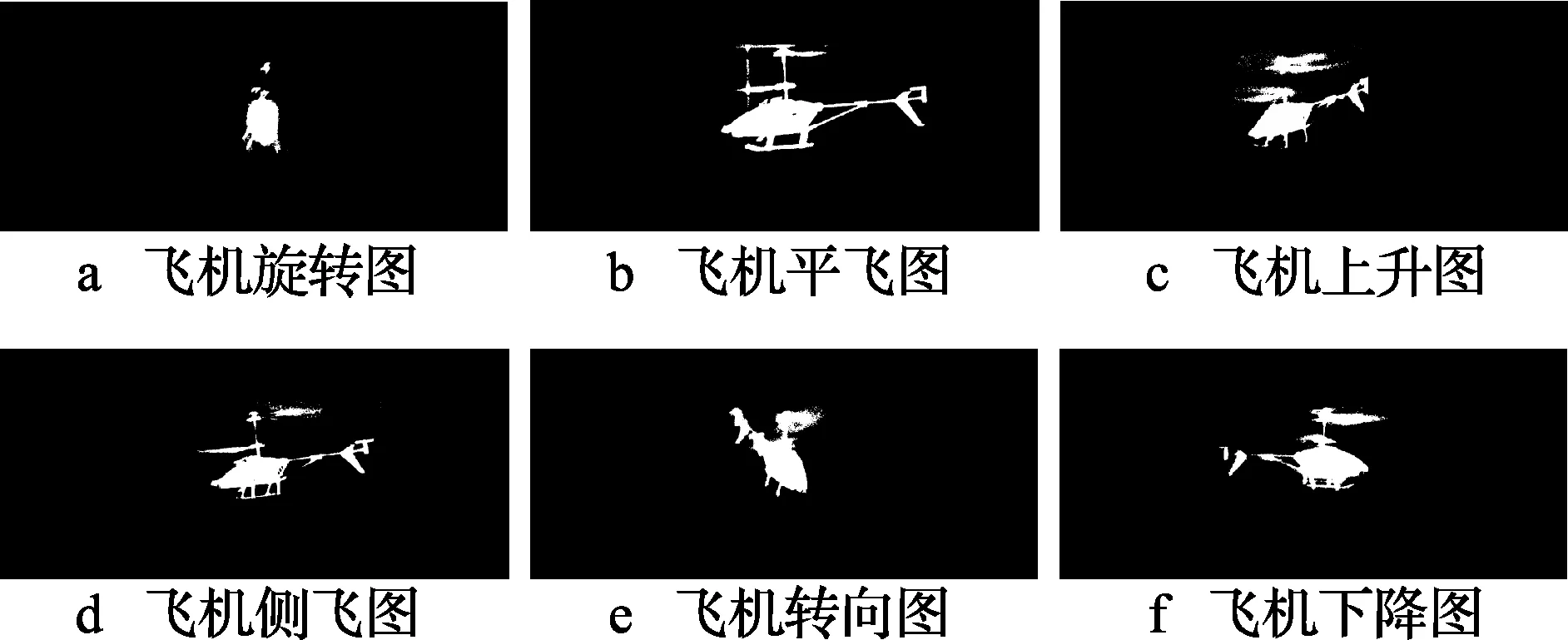

本实验使用遥控飞机来模拟空中物体,系统对遥控飞机进行捕捉,图10为强电磁场干扰时捕捉最终屏幕显示图所对应的二值图像如图11所示。

图10 强电磁场干扰时捕捉最终屏幕显示图

图11 图10所对应的二值图像

根据图11a~11f可知,系统能够很好地跟踪捕捉遥控飞机,颜色变化浅的地方,稍微有点偏差,但是偏差很小,查看二值化图像可知,系统能够精确检测到动态目标,动态模板更新比较精确,动态目标轮廓比较清晰,使后续图像处理,特征值的提取更加精确,在存在强电磁场的情况下并没有影响系统对空中目标的扑捉,很好地解决了雷达扑捉动态物体受强电磁场干扰的问题。

4 总结

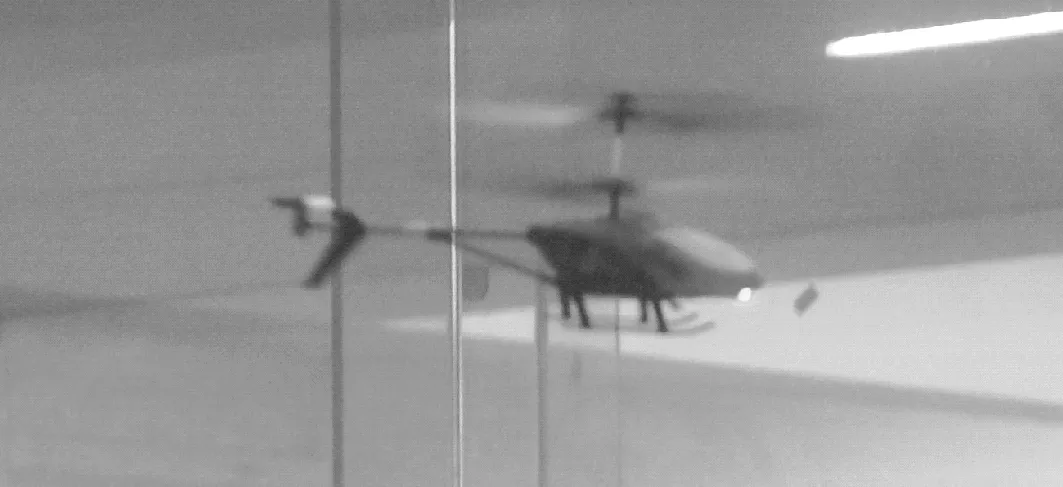

本系统采用DM642与STM3为核心的系统硬件平台,能够满足系统的实时性与稳定性的要求。采用帧间差分图像预处理,通过中值滤波消除噪声对图像的影响,为后续的模板匹配、特征提取、移动云台做准备。利用帧间差分获得的图像对模板进行实时更新,提高了模板的匹配度,防止了目标姿态改变而带来的匹配错误,提高了对目标检测的准确性。根据反复试验可知,系统能够很好地捕捉并跟踪动态目标物体,而且能够抵抗干扰,如图12所示。

图12 跟踪捕捉结果图

[1] 刘宏鼎,秦世引.基于图像特征的运动目标识别与伺服跟踪[J].仪器仪表学报,2008,29(3):644-648.

[2] 杜宇人,周爱军.一种基于视频图像的运动车辆跟踪方法[J].电子测量与仪器学报,2009,23(3):45-48.

[3] 杨耿,和卫星.运动目标图像识别与跟踪系统的研究[J].计算机测量与控制.2005,13(3):267-269.

[4] 施家栋,王建中,王红茹. 基于流光的人体运动实时检测方法[J].北京理工大学学报报,2008,28(9):794-797.

[5] 吴凌霄,林晨,徐福海等.基于背景差分的车辆计数方法的研究[J].自动化技术与应用,2011(30):72-75.

[6] 冯尧文. 基于帧间差分的运动目标稳健检测方法[D]. 哈尔滨:哈尔滨工业大学,2011.

[7] 逯新华,史忠科.基于动态模板匹配的空中运动目标检测与跟踪控制[J].电子测量与仪器学报,2010,24(10):935-941.

[8] 许永辉,杨京礼,林连雷. TMS320DM642 DSP原理与应用实践[M].北京:电子工业出版社,2012.

[9] 韦金辰,李刚,王臣业,等. 零点起步 TMS320C6000系列DSP原理与应用系统设计[M]. 北京:机械工业出版社,2012.

[10] 廖义奎. Cortex-M3之STM32嵌入式系统[M].北京:中国电力出版社,2012.

[11] 李敏,罗红艳,郑小林,等. 一种改进的最大类间方差图像分割法[J].南京理工大学学报,2012,36(2):22-27.

[12] 刘正君,李琦,王骐. 基于特征选择算法的相干激光雷达目标识别[J].中国激光,2013,40(8):1-9.

[13] 王妍,王向军.低对比度条件下的快速相关匹配算法[J].红外与激光工程,2006,35(10):89-92.

王 永(1986— ),硕士生,主研测试计量技术及仪器,为本文通讯作者;

熊显名(1964— ),硕士生导师,研究员,主研光电检测;

李小勇(1987— ),硕士生,主研图像处理及嵌入式。

责任编辑:闫雯雯

首款全系统多核导航定位芯片面世

近日,“北斗星通”发布了全球首款全系统多核高精度导航定位系统级芯片“NebulasII”。该芯片率先在高精度领域采用55 nm低功耗工艺和完全自主知识产权技术,具有全系统、抗干扰、高输出率等特性,可实现高精度全球卫星导航系统(GNSS)测量仪器小型化。它集小面积、抗干扰、多频点等优点,能够涵盖北斗、GPS等四大导航系统的12个频点,可对抗数十个单音干扰,支持毫米级测量精度。

Research on Aerial Object Dynamic Capture System Based on DSP and ARM

WANG Yong1,XIONG Xianming1,LI Xiaoyong2

(1.SchoolofElectricalEngineeringandAutomation,GuilinUniversityofElectronicTechnology,GuangxiGuilin541004,China;2.DevelopmentDepartmentofGuangxiTransportationResearchInstitute,Nanning530007,China)

At present, the mainly method of real-time tracking to air targets is radar detection. But usually,this method will be affected by interference of electromagnetic field and electromagnetic. So the accuracy of the detection will be decrease. To solve such problems, a solution is put forward which based on air visual real-time tracking .The scheme is suitable for small range of air dynamic object tracking, including the extraction of dynamic target’s difference, the filtering of binary image, the real-time updates of template image, the feature extraction of dynamic target, and the cloud platform control. For increasing accuracy of the system’s detectability, an air target detection’s method is proposed what combine matching dynamic template which based on the improved one and difference between frames. This method will solve the electromagnetic interference effectively and the problem of dynamic target can’t be captured because of circumstances change. The experiment results show that the system can detect air dynamic object very well, and it possess good robustness, realtime performance and sharpness.

air visual; cloud platform control; matching dynamic template; difference between frames; air target detection

【本文献信息】王永,熊显名,李小勇.基于ARM和DSP空中运动目标实时跟踪系统研究[J].电视技术,2015,39(11).

广西研究生教育创新计划项目(2011105950804M30);广西自然科学基金项目(2013GXNSFDA019002;2014GXNSFGA118003);广西科学研究与技术开发项目(桂科合1346010-5);桂林市科学研究与技术开发项目(20130122-1);广西教育厅重点项目(ZD2014057)

TN911.7

A

10.16280/j.videoe.2015.11.016

2014-10-18