基于经验学习的空间机器人精细抓捕方法*

2015-06-09孙富春刘春芳

孙富春,刘春芳

(清华大学计算机科学与技术系,北京 100084)

基于经验学习的空间机器人精细抓捕方法*

孙富春,刘春芳

(清华大学计算机科学与技术系,北京 100084)

机器人在空间环境下完成对复杂形状物体的精细操作,要求其具有较强的自主操作规划能力.从学习人类经验出发,模仿人类经验生成来建立经验数据库,提出有效的物体分类方法,在物体类别基础上,识别同类物体的可抓取区域,并提出“单拇指”姿态规划方法,将对物体的操作经验泛化到同类物体的操作规划中.试验证明了算法的有效性.

精细操作;空间机器人;人类经验;抓取规划;物体分类.

0 引 言

空间机器人自主完成各种精细灵巧操作仍然是一个具有挑战性的难题.复杂形状物体的表达、灵巧手多自由度的逆运动学计算是两大主要难题.人类能够灵巧的操作各种各样的物体,其主要原因之一是人类能够从操作具体物体的过程中,总结归纳经验,并将经验应用于对新物体的操作.本文通过学习人类经验以及模拟经验生成的规律,实现基于经验学习的机器人精细操作.

美国NASA研制的Robonaut机器人可以通过遥操作完成抓取工具等任务.操作者利用数据手套、跟踪器等的运动映射到Robonaut来指其完成操作.这种方法依赖于人的操作,并没有真正把人的经验转化成机器人的知识[1-7].本文将学习人类操作经验的生成规律,并将人类经验转化为机器人的经验.

从经验中学习在认知构架中已被公认是一种重要的认知能力,利用经验将有助于机器人在类似环境下重复相同或相似的任务,实现更多的自主任务规划.在Galindo的研究成果中,基于记忆的推理是通过从记忆中检索类似的问题并进行一定的调整来实现.因此,学习对经验的归纳,机器人可以学习并找到解决一类问题的方法.经验获取的重要来源之一是对视觉传感信息的分析.通过功能、属性等对物体进行分类,概念化对一类物体的描述,而非具体单个物体,使经验操作能够泛化到对同类别物体的操作中[8-10].

依据上述生成规律,本文首先利用形状描述子对物体进行分类;在获取物体类别标签后,机器人能够迅速找到相应的操作经验,并进行有效地调整,实现对同类别物体的精细操作.

1 抓取数据库建立

1.1 任意物体形状表达

采用Kinect RGB-D摄像机可以直接得到物体表面的三维点云序列. 三维点云能够在三维空间上表达物体的方向、位置、尺寸与形状信息,可以为物体识别与灵巧手姿态规划提供有效信息. 三维描述子通过三维点云中的点与其邻域点之间的相对位置与方向关系来描述物体的形状与姿态等信息,如3D Zernike, spin images, 3D Shape Context, FPFH, PFHRGB, SHOT,USC 等等.文献[11-13] 对比了13种三维描述子在物体分类识别与算法执行效率方面的能力.结果显示:SHOT(signature of histograms of orienTations)描述子在物体分类识别与执行效率方面综合较优,所以本文采用SHOT描述子在三维空间中表达物体的形状信息.SHOT三维描述子2012年由文献[14]中提出,具有良好的形状匹配能力,不受物体旋转影响,抗噪声能力强,尺寸归一化后,能够不受物体尺寸大小变化的影响.本文对SHOT描述子进行有效改进,在丰富其表达能力的同时,对其进行有效降维,减少物体识别过程中的时间消耗.

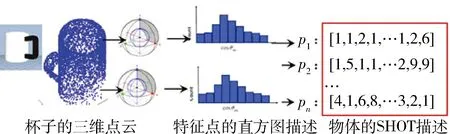

计算落入栅格内点云与该特征点之间的夹角余弦,并将该夹角余弦值分为11类,由落入不同夹角余弦类中点的数量形成直方图.因此,该特征点可以用球体栅格内夹角余弦直方图的组合来表达.

图1 SHOT 3维形状描述子Fig.1 SHOT 3D shape descriptor

SHOT描述子采用特征值分解方法在物体三维点云中每个特征点处建立一个局部坐标系.以每个特征点为圆心,利用特征点处局部坐标系建立3D球体,并沿径向、纬向以及半径方向将球体分成空间栅格.物体上局部点云落入不同的空间栅格内.

本文对SHOT三维描述子进行如下改进:(1)SHOT描述子在构建过程中,球体半径设为0.5d.d是物体点云内最大距离.球体半径的增大,使得SHOT描述子在表达特征点相对于整个物体的位置以及表达在局部邻域内物体表面变化等方面的能力增强.(2)将SHOT描述子的维度由352维扩展到594维,包括径向6维,纬向3维,半径方向3维,并将夹角余弦值分为11类,以增强算法的描述能力.(3)除SHOT特征之外,每个特征点处的局部坐标系(9维LR特征)也被用于描述物体的位姿特征.由此,每个特征点由603维的向量来表示.由2 000×603的数据矩阵来描述其形状与位姿(2 000个特征点,594维的SHOT描述,9维的LR描述).

设M为2 000×603维的物体描述矩阵.对于物体分类与存储而言,M矩阵数据量巨大.本文提出有效的M矩阵降维方法.

SHOT特征:用sj={si,j|i=1,2,…,594}表示SHOT特征,sj={si,j|i=1,2,…,2 000}.沿点方向提取以下特征,

范围特征:R(sj)=max(sj)-min(sj)

标准偏差特征:

最大特征值特征:STS.

同时,算法中也可以加入颜色信息.基于以上对任意物体的形状特征表达,利用极限学习机(ELM)对物体进行分类,以识别物体的类别.

2 可抓取区域的学习与泛化

本小节利用SHOT描述子对点云中点的描述进行可抓取区域及抓取点的学习.此外,由于许多日常生活物体都设计有专门的抓取手柄,识别这些可抓取部位对完成任务非常重要.在离线数据库的建立过程中,对于每一类物体,用SHOT描述子表示三维点云中每一个点,并由人在物体三维点云中标出可抓取部位,设0标签为不可抓取部位,1标签为可抓取部位.这样, 可以直接学习到人的经验.由于机器学习机SVM能够用于小数据量的知识学习,比较适合可抓取部位的学习.

在实际场景中,单视角仅能获取物体的局部点云信息.因此,本文的可抓取点识别也是在真实的局部点云上(直接从Kinect获取得到)学习获取.

3 抓取姿态的经验库

对于三指灵巧手Barretthand,抓取姿态变量包括手腕位置Pw∈R3,手腕方向θw∈R3以及手指关节角度θf=[θ1θ2θ3θ4]T,其中θ1,θ2,θ3为每指的关节角度,θ4为手指1与手指2的分开角度.设抓取函数G用于评估抓取姿态

G=f(θf,Pw,θw)

(1)

抓取函数通过三个接触点评估抓取姿态的情况,包括稳定性、接触点构成的三角形是否容易达到稳定状态以及机械手尺寸等[15-20].

f(θf,Pw,θw)是机械手抓取某个具体物体的姿态参数,直接存储在数据库中,不适合大数据量的情况,也无法表示该类抓取的共性特征.由此,本文在机械手姿态经验库中, 存储以下姿态规划经验值:抓取点识别分类器、手掌接近物体的方向向量以及手掌位置识别分类器.抓取点附着在物体上,可以用上述的SHOT形状描述子分类识别.手掌位置识别分类器,由与接近方向垂直的平面上手掌位置相对于物体位置的参数训练得到.该思路源于对同类物体抓取时,抓取相对方位不变,而接近物体的距离值随物体的尺寸变化而变化.

4 基于经验库的抓取姿态规划

在实时操作环境中,当遇到新物体时,首先判断物体的类别,由类别标签将物体导引到相应的操作经验.因此,当已知物体的类别时,可以获知物体的可抓取点、接近方向与手掌相对位置信息.

机械手类型多种多样(三指、五指、9自由度、20自由度等),很少能有跟人手完全一样的类型.然而,几乎所有的机械手都包含跟人类大拇指作用相近的机械手指(与其它手指方向相对).因此,学习人类大拇指姿态的经验, 研究基于单手指的实时姿态规划方法,有利于将经验应用于不同类型的机械手上.对文献[21]中方法进行改进,利用已建立的经验库,提出如下机械手姿态规划方法.这里,将机械手与大拇指相对应的手指称为单手指.

设ur=[Tr,pr]∈R6为单手指相对于物体坐标系O的方向和位置,pr∈R3是接触点的位置,可以从经验库中获取.Tγ=(Tα,Tβ,Tγ)∈R3是三个旋转角,其中Tα、Tβ与接近方向和方位经验相关,唯有Tγ(手指的弯曲程度)随物体变化而变化.由此,ur=ur(Tγ),uγ被简化为只有单一变量Tγ的函数.

图2 单手指坐标系Fig.2 Coordinate system of the single finger

通过单手指的逆运动学以及手腕的约束,最终Barrett手将抓取姿态规划的自由度由10个减为3个.

G=f(θ32,Tγ,θ4)

(2)

设i-1Ti为坐标系i与i-1之间的齐次转换矩阵.单手指的运动学可以表示为

OTT=OTwwT11T22T33TT

(3)

因此,

OTw=OTT(wT11T22T33TT)-1

(4)

OTw表示手腕与物体坐标系间的齐次转换矩阵.利用经验库中相应的单手指抓取点经验与抓取姿态与方位经验,可以求取抓取新物体时的手腕位置与姿态.

5 实验验证

5.1 物体分类效果测试

利用II-A改进的描述方法对物体进行分类,训练与测试数据集包括完全点云数据集PSB(princeton shape benchmark)与局部点云集Large RGBD.后者直接从Kinect传感器中获取局部点云,包括51个类别物体.从中选取10个在形状上不同的物体类别(球、咖啡杯、食物袋、食物盒、酱盒、盘子、胶水、订书器、老虎钳及水瓶等),每类物体包括6个从3个角度拍摄的不同物体, 其中4个用于训练,2个用于测试.采取三种学习方法对物体的特征描述进行分类,ELM(极限学习机)、多维的KNN方法与(RandFst)随机森林法.PSB点云集的颜色信息被忽略,所以不考虑PSB点云的ELM(color)分类.表1是分类准确率对比结果.真实局部点云集L-RGBD在ELM(color)分类器下的效果最好,达到97.2%.个别物体形状(食物盒与酱盒等)差别不大,导致个别分类失败.

表1 分类结果

5.2 可抓取区域的识别

利用SHOT 3D描述子描述点云中每个特征点,用于区分可抓取区域与不可抓取区域.图3展示了复杂形状物体可抓取部位的训练与测试.横排左三个是训练数据,右三个是测试数据.红色点云为可抓取区域,蓝色点云为不可抓取区域.点云集来自于PSB.由识别结果可以看出SHOT 3D形状描述子的效果非常好.尽管物体形状复杂多样(如图3中手枪、椅子、眼镜、杯子等),所提方法仍能比较好的在同类别测试物体中识别可抓取区域.同样,从Large RGBD数据集中获取的真实局部点云集(杯子),设可行的稳定抓取点标签为1,不可行的为0,实现分类识别可行抓取点(如图4所示).图4为杯子的训练样例,用于获取单手指的稳定抓取点识别器.黄色是可抓取区域,中间红色点是可抓取点,蓝色为不可抓取区域.相应的图5展示了用图4中4个杯子样例训练获得的抓取点识别器的测试结果.图5中杯子是直接从Kinect 拍摄的单视角点云.红色点是识别出的可行抓取点.虽然测试杯子尺寸变化比较大,但是仍然能比较好的识别出可行抓取点.以上显示了所提算法的优点:(1)训练数据集样例小,不需要非常多的训练数据量;(2)抓取点泛化能力强.这与SHOT 3D形状描述子有重要关系.

5.3 可抓取区域的识别

当已知物体类别时,可以获知操作物体的相关经验信息. 利用操作经验与单手指的抓取规划方法,可以求得对于新物体的抓取姿态规划结果.图6是对新物体的姿态规划结果.(a)是规划的抓取手势;(b)中绿点是规划出的抓取点,黑色点是手腕位置,红色箭头是手腕的接近方向;(c)是(b)的俯视图.

图3 可抓取部位的学习Fig.3 Learning the graspable component

图4 数据库中杯子的学习训练样例Fig.4 The training samples of a mug

图5 抓取点识别Fig.5 Identification of the graspable point

表2是手姿态规划结果.Mug 1-4分别代表上述的4个杯子.Tγ是单手指相对于物体坐标系的弯曲程度.θ32是单手指的关节角度.手指1和手指2的分开角度忽略.抓取规划评价函数显示,这四次规划抓取均为稳定抓取.

图6 姿态规划结果Fig.6 Posture planning results

MugTγ/radθ32/rad10.7921.22020.7511.18930.6781.13440.6281.097

图7是用7自由度机械臂和三指BarrettHand抓取杯子的实验.分三个阶段,“准备抓取”、“抓取物体”与“拿起物体”.

图7 抓取杯子实验结果Fig.7 The experiment of grasping a mug

4 结 论

本文提出有效的基于经验知识库的精细操作方法.首先对SHOT 3D描述子进行有效改进,并利用ELM对物体进行分类识别,识别准确率达到97%以上.然后,在物体类别的导引下,获取抓取姿态规划信息,包括物体可行抓取区域、抓取点、机械手接近方向与方位信息.最后,利用经验知识,实现实时抓取姿态规划.所提姿态规划方法可以实现对复杂形状物体的抓取规划,并且所建数据库依赖数据样本少,易于建库.

[1] LI M, BEKIROGLU Y, KRAGIC D, et al. Learning of grasp adaptation through experience and tactile sensing[C]//IEEE/RSJ international conference on Intelligent Robots and Systems. Washington D.C.:IEEE, 2014:3339-3346.

[2] EL-KHOURY S, SAHBANI A. A new strategy combining empirical and analytical approaches for grasping unknown 3d objects[J]. Robotics and Autonomous Systems, 2010, 58(5), 497-507.

[3] DANG H, ALLEN P K. Grasp adjustment on novel objects using tactile experience from similar local geometry[C]//IEEE/RSJ international conference on Intelligent Robots and Systems. Washington D.C.:IEEE, 2013: 4007-4012.

[4] BOHG J, MORALES A, ASFOUR T, et al. Data-driven grasp synthesis-a survey [J]. IEEE Transaction Robot, 2014, 30(2), 289-309.

[5] HUANG B, EL-KHOURY S, LI M, et al. Learning a real time grasping strategy[C]//IEEE international conference on Robotics and Automation. Washington D.C.:IEEE, 2013: 593-600.

[6] MADRY M, SONG D, KRAGIC D. From object categories to grasp transfer using probabilistic reasoning[C]//IEEE international conference on Robotics and Automation. Washington D.C.:IEEE, 2012: 1716-1723.

[7] NIKANDROVA E, KYRKI V. Category-based task specific grasping[J]. Robotics and Autonomous Systems, 2015, 70: 25-35.

[8] HILLENBRAND U, ROA M. Transferring functional grasps through contact warping and local replanning[C]//IEEE/RSJ international conference on Intelligent Robots and Systems. Washington D.C.:IEEE, 2012: 2963-2970.

[9] GRANA C, DAVOLIO M, CUCCHIARA R. Similarity-based retrieval with MPEG-7 3d descriptors: performance evaluation on the Princeton shape benchmark[J]. Digital Libraries: Research and Development, First international DELOS Conference, 2007: 308-317.

[10] AMOR H, KROEMER O, HILLENBRAND U, et al. Generalization of human grasping for multi-fingered robot hands[C]//IEEE/RSJ Int. Conf. on Intelligent Robots and Systems. Washington D.C.:IEEE, 2012: 2043-2050.

[11] ALDOMA A, MARTON Z C, TOMBARI F, et al. Point cloud library: three-dimensional object recognition and 6dof pose estimation [J]. IEEE Robot. Automat. Mag., 2012, 19(3): 80-91.

[12] ALEXANDRE L A. 3D descriptors for object and category recognition: a comparative evaluation[C]//IEEE/RSJ international conference on Intelligent Robots and Systems. Washington D.C.:IEEE, 2012: 1-6.

[13] ALEXANDRE L A. Set distance functions for 3d object recognition[C]//Pattern Recognition, Image Analysis, Computer Vision, and Applications-18thIberoamerican Congress, 2013: 57-64.

[14] TOMBARI F, SALTI S, Di Stefano L. Unique signatures of histograms for local surface description[C]//Computer Vision-11thEuropean international conference on Computer Vision. Greece: Heraklion crete, 2010.

[15] GOLDFEDER C, CIOCARLIE M, DANG H, et al. The Columbia grasp database[C]. IEEE international conference on Robotics and Automation. Washington D.C.:IEEE, 2009.

[16] BOHG J, JOHNSON-ROBERSON M, LÉON B, et al. “Mind the gap-robotic grasping under incomplete observation[C]//IEEE international conference on Robotics and Automation. Washington D.C.:IEEE, 2011: 686-693.

[17] KROEMER O, AMOR H. B, EWERTON M, et al. Point cloud completion using extrusions[C]//IEEE-RAS International Conference on Humanoid Robots. Washington D.C.:IEEE, 2012: 680-685.

[18] LENZ I, LEE H, SAXENA A. Deep learning for detecting robotic grasps[J]. The International Journal of Robotics Research, 2015, 34(4): 705-724.

[19] LIU C, LI W, SUN F, et al. Grasp planning by human experience on a variety of objects with complex geometry[C]//IEEE/RSJ international Conference on Intelligent Robots and Systems.Washington D.C.:IEEE, 2015.

[20] DETRY R, PIATER J. Unsupervised learning of predictive parts for cross-object grasp transfer[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. Washington D.C.:IEEE, 2014:.1720-1727.

[21] LIN Y, SUN Y. Robot grasp planning based on demonstrated grasp strategies[J]. The International Journal of Robotics Research, 2014: 1-17.

Space Robot Precise Manipulation Based on Experience Learning

SUN Fuchun, LIU Chunfang

(1.Dept.ComputerScienceandTechnology,TsinghuaUniversity,Beijing100084,China)

It is a challenging problem for space robots autonomously to accomplish precise manipulation on objects with complex geometry. In this paper, an effective method for object classification and graspable components identification is firstly proposed by imitating the generation of human experience. Then, a “single” finger grasp planning method is developed which is able to generalize the grasp to the objects in the same category. Experiments verify the effectiveness of the proposed methods.

precise manipulation; space robot; human experience; grasp planning; object classification

*国家自然科学基金资助项目(61210013,61327809).

2015-09-01

V448

A

1674-1579(2015)05-0001-05

10.3969/j.issn.1674-1579.2015.05.001

孙富春(1964—),男,教授,研究方向为智能机器人精细操作与遥操作、机器人多模态信息编码与融合等;刘春芳(1985—),女,博士研究生,研究方向为机器视觉、灵巧手操作规划、冗余机械臂运动规划.