基于改进PCNN的压缩感知域图像融合

2015-03-23田中佳

刘 斌,田中佳

(燕山大学电气工程学院,河北秦皇岛066004)

1 引言

传统的图像融合算法对源图像直接处理,需要较大存储空间,这对于图像传感器规模扩大和实时性要求提高是一个巨大的挑战。具有低采样率、低能耗、低计算复杂度的压缩感知理论(Compressive sensing,CS)[1]为图像融合的研究提出了新思路。CS图像融合,不需要获得源图像的全部像素信息,仅需在CS域对图像的压缩观测值进行融合计算,得到融合观测值进行重构即可得到融合图像。

选取待融合图像之中绝对值较大的观测值进行融合的算法[2]取得了一定的成功。融合策略简单,但是背景较复杂图像融合结果存在大量图像细节丢失,并伴有明显的条纹出现。文献[3]提出一种傅里叶稀疏基的星型采样模式,融合策略使用手动调节加权参数取得较好的效果,但是权值手动调节操作繁琐。Luo等人提出基于信息熵加权观测值融合[4],根据不同观测值所占信息比例作为权值对信息重新分配的融合方法较好,但对观测值中图像结构信息挖掘不充分影响融合效果。基于CS的图像融合算法得到的观测数据不能百分之百地获得源图像的全部像素信息,现有融合策略得到的融合结果出现图像信息结构改变或细节丢失,需要研究一种基于CS图像融合尽可能保留完整图像结构信息和细节算法。

脉冲耦合神经网络(Pulse Coupled Neural Network,PCNN)作为一种模拟动物视觉神经的新型神经网络,是应用于图像领域的一种全局算法,对图像信息的处理原理更符合人类视觉神经系统的生理学基础,保留更多的细节信息[5],提高目标识别率[6-9]。为了充分利用CS理论和PCNN网络的技术优点,提高融合效率的同时获得纹理细节更加丰富的图像,本文提出了一种压缩感知域基于改进PCNN的图像融合算法(简称CS-PCNN算法)。首先对源图像进行压缩采样得到对应的压缩观测值,根据其物理意义建立改进PCNN模型,即利用压缩观测值的物理意义对PCNN中连接系数、加权矩阵和特征参数进行自适应设定,并作为改进PCNN神经元输入获取点火映射图作为融合算子对观测值进行融合,重构后得到融合结果。实验证明本算法克服现有CS图像融合中图像细节丢失的缺陷,优于现有CS图像融合算法。

2 基于CS的图像融合

在CS理论中,如果一个长度为N的一维信号x可以在一组稀疏基ψ下稀疏表示,则此信号可以采用一个满足有限等距性准则(Restricted isometry property,简称RIP)的测量矩阵Φ对信号进行投影观测[10],即:

式中,Φ ∈ RM×N,M ≤ N,y ∈ RM×1

其中,矩阵Φ满足约束等距性。根据等距性进行如下推导,取T=N,c取信号的稀疏表示x=ψTf时,有:

基于CS的图像融合的核心思想是在CS域对观测值进行融合,对融合得到的观测值进行重构,已达到减小计算量的目的。重构算法是从M维随机测量值y中重构出长度为N(NM)的稀疏信号x的过程。

3 脉冲耦合神经网络

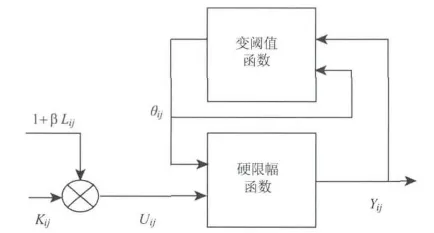

PCNN网络是由若干个神经元互相连接所构成的反馈型网络。每个神经元由三部分组成:接收部分、调制部分和脉冲产生部分。在原始神经元网络中,存在大量非线性和漏电容积分处理操作,在图像处理实际过程中,通常使用图1所示的简化模型。

图1 PCNN神经元的简化模型Fig.1 Simplied PCNN model

该模型的离散数学迭代方程如下:

内部活动项的连接系数为β,神经元强制激发的外部激励为Iij,反馈输入域中放大系数和衰减时间常数分别为VF和αL,动态门限的放大系数和衰减时间常数分别为VE和αE,权值矩阵Mijkl和Wijkl为别为反馈输入域和耦合连接域的连接矩阵。传统PCNN算法中,放大系数、衰减时间系数、连接系数矩阵、连接系数需要根据具体应用环境手动确定,进行多次实验才能得到最佳结果,获取理想信息特征值。

4 压缩感知域的改进PCNN图像融合

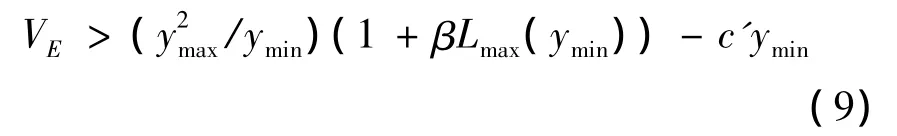

本文的算法基本结构流程如图2所示,CSPCNN算法具体实现流程如下:

胆结石在临床是比较常见的疾病,该病的形成原因比较复杂,导致患者的身体以及心理产生不适感。人性化护理模式秉承着“以人为本”的理念在临床中的运用越来越多[1],采用人性化护理可以全方位的对患者的身体以及心理状态进行改善。本研究将深入探讨人性化护理对于胆结石患者术前焦虑的改善效果,现报道如下。

图2 CS-PCNN结构流程图Fig.2 CS-PCNN structure flowchart

1)压缩采样:设置采样点数k,对输入图像源图像I1,I2进行向量化,使用随机置乱分块哈达玛矩阵对向量进行观测采样,获取观测值y1,y2;

2)融合:利用获得的观测值y1,y2对CS-PCNN网络进行参数自适应设定,同时输入改进PCNN获取对应观测值的点火映射图并进行整合,获得融合观测数据yD;

3)重构图像:使用离散小波变换进行硬阈值收缩进行重构得到融合后图像。

针对PCNN进行参数自适应设定如下:

1)连接系数。图像的标准偏差(SD)反应图像灰度相对于灰度均值的偏离程度,标准偏差越大,说明图像亮度变化大,所包含的信息量越多,目视效果越好。其定义为:

利用图像标准偏差可以判定图像所含信息量大小。PCNN网络中连接系数β表示神经元之间的相互耦合强度,与该处神经元所保留的特征信息有一定的关系。在文献[11]中,利用图像标准偏差作为加权平均融合算子取得了较好的效果。选择标准差作为PCNN中相应神经元的连接强度。为了保证融合图像之间关联性,对应源图像输入PCNN连接系数设定为:

2)加权矩阵。传统PCNN算法中通常计算相邻四个方向神经元的加权值,考虑输入压缩观测值并非简单地灰度值输入,每个观测值都包含了图像结构信息,为了保证在PCNN网络中尽可能捕获观测值中的图像信息,计算相邻8个方向的加权系数。

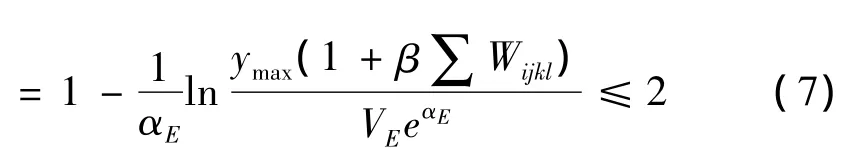

3)阈值放大系数VE。在传统PCNN网络中,阈值放大系数VE对神经元的点火周期起着重要调节作用。为了保证CS-PCNN算法的计算效率,需要提高PCNN网络点火效率。除了自适应调节参数外,应使PCNN网络输入中归一化后第2次就点火。根据神经元离散公式推导,可得神经元第n次循环点火[12]:

初始神经元设定值为0,故第一次点火并不计算在实际点火次数内,为了保证PCNN网络高效点火即理论值满足n=2:

解得:

在VE满足式(8)的条件下能够保证CS-PCNN网络以最高效率进行点火。为了确保在改进PCNN网络中对观测值中蕴含的图像信息的尽可能完整的提取,作为CS-PCNN网络的神经元输入,每一个压缩观测值最少进行一次捕获(即进行点火操作,非第一次)。根据离散公式推导如下[13]:

其中,c=(1-e-2αF)/(1-e-αF)。

综上所述,保证改进PCNN进行高效点火同时最大限度提取图像信息,阈值放大系数需同时满足式(8)和式(9)。取:

其中,β根据对应图像选择式(5)。

基于改进PCNN的融合步骤如下:

1)对源图像I1,I2获得压缩采样后观测值 y1,y2。令y1作为第一个PCNN1和第二个PCNN2中各神经元的反馈输入;

2)计算 y1,y2的SD,根据公式(7)获得 PCNN1和PCNN2连接系数;并根据获得的连接系数根据公式(13)获得阈值放大系数VE;同时设定PCNN1和PCNN2的加权矩阵;

3)设PCNNi的输出为di,得到观测值 y1,y2的点火映射图d1,d2;

4)采用如下规则选取融合系数:

5 实验结果及分析

为了验证算法的有效性,选用同源传感器图像(clock图像)融合和非同源传感器图像(ship图像)进行融合试验。与现有CS图像融合算法中常用的绝对值最大融合算法(简称MAX法)和Luo的基于熵加权平均融合算法(简称E-WEIGH法)在融合后图像质量进行对比。在MAX法中采用的融合规则是选取待融合图像中绝对值较大的观测值作为融合观测值进行融合。在E-WEIGH法中,根据待融合图像观测值所占信息比例作为加权算子对观测值进行融合。采样率50%。实验平台为matlab2012a,仿真计算机主频为2.40GHz,内存2GB。

同源传感器clock图像以及各种融合算法的融合结果如图3所示。图3(a)、图3(b)为待融合的左聚焦和右聚焦clock图像。图3(c)~(e)分别是clock图像采用MAX法、E-WEGH法和CS-PCNN法得到的融合图像。从视觉效果上看,CS-PCNN法较好地保留了图像整体结构信息,细节突出。相比之下,MAX法融合图像存在明显失真和虚假轮廓,在边缘位置上出现失真并有条纹出现。E-WEIGH法细节信息有所改善,但图像清晰度没有CS-PCNN法高。相对前两种方法,CS-PCNN法所得的融合图像边缘更为清晰。

图3 clock图像融合结果Fig.3 The fusion result of the clock image

图4为不同波段传感器获取的ship图像以及各融合算法的融合结果。图4(a)是红外图像,只能看见海面上船的基本轮廓,但能清晰显示倒影部分;同一场景的图4(b)可见光图像中,海面船只很清晰,由于光线较暗对倒影部分不能很清晰辨认。图4(c)~(e)分别是 ship图像采用 MAX法、EWEGH法和CS-PCNN法得到的融合图像。融合效果中,CS-PCNN法保留了海面船只的同时显示出倒影,较好地整合源图像中的信息。相比之下,MAX法和E-WEIGH法存在明显失真。在MAX法得到的融合图像中出现黑白夹杂的类似噪声的“干扰”,但这并不是噪声,而是由于源图像亮度差异较大,源图像的观测值包含的图像信息差异较大,MAX法融合策略获得融合观测值为两幅图像观测值信息交杂的结果,在重构图像的过程中分别按对应源图像信息恢复像素点,以至于出现“噪声”现象。相对前两种方法,CS-PCNN法所得的融合图像能够更好的捕获并整合更多图像信息。

除了主观评价,采用结构相似性、图像相关系数、互信息、峰值信噪比客观评价指标进行比较。图5给出了三种算法在不同采样率下,clock和ship图像客观评价指标的对比曲线。

图4 ship图像融合结果Fig.4 The fusion result of the ship image

图5 几种方法不同采样率下的图像客观评价指标对比Fig.5 Evalutions constrast under different sampling rate of several method

结构相似性是衡量图像结构相似性的指标,图像相关系数反应图像之间的相关性,互信息是计算源图像中有多少信息包含到了融合图像,峰值信噪比反应图像质量的客观评价质量。四者越大,说明融合效果越好。从图5可以看出CS-PCNN算法得到的重构图像客观评价指标高于MAX和EWEIGH算法。

6 结束语

根据CS理论和PCNN的特点,提出一种基于压缩观测值的改进PCNN图像融合算法,该方法最大的特点是充分利用压缩观测值的物理意义改进PCNN模型,并对观测值采用改进PCNN进行图像融合。通过同源传感器和不同波段传感器图像进行仿真实验表明,本文方法融合结果优于其他CS融合算法,包含更多图像整体结构信息,改善现有CS融合算法融合结果细节丢失的问题。

[1] Donoho D.Compressed sensing[J].IEEE Transactions on Information Theory,2006,52(4):1289-1306.

[2] Wan T,Canagarajah N,Achim A.Compressive Image Fusion[C].Proceedings of the International Conference of Image Processing,2008:1308-1311.

[3] HE Guodong,SHI Jianping,FENG Youhong,et al.Fusion alogtithm for infrared and visible image based on compressive sensing[J].Laser & Infrared,2014,44(5):582-584.(in Chinese)何国栋,石建平,冯友宏,等.基于压缩感知的红外与可见光图像融合算法[J].激光与红外,2014,44(5):582-584.

[4] Luo X,Zhang J,J Y,et al.Image fusion in compressive sensing[C].IEEE International Conference on Image Processing,2009:2205-2208.

[5] Eckhorn R,Reiboeck H J,Arndt M,et al.Feature linking via synchronization among distributed assemblies:simulation of results from cat visual cortex[J].Neural Computation.1990,2(3):293-307.

[6] Broussard R,Reitboeck H J,Arndt.Physiologically motivated image fusion for object detection using a pulse coupled neural network[J].IEEE Transactions on Neural Networks,1999,10(3):554-563.

[7] YANG Yanchun,DANG Jianwu,WANG Yangping.A medical image fusion methed based on lifting wavelet transform and adaptive PCNN[J].Journal of Computer-Aided Design & Computer Graphics,2012,24(4):494-499.(in Chinese)杨艳春,党建武,王阳萍.基于提升小波变换与自适应PCNN的医学图像融合方法[J].计算机辅助设计与图形学学报,2012,24(4):494-499.

[8] ZHAO Jingchao,QU Shiru.Infrared and color visible image fusion algorithm based on Curvelet transform and adaptive PCNN[J].Journal of Northwestern Polytechnical University,2011,29(6):849-853.(in Chinese)赵景朝,曲世茹.基于Curvelet变换与自适应PCNN的红外与可见光图像融合[J].西北工业大学学报,2011,29(6):849-853.

[9] LI Xin’e,REN Jianyue,L Zengming,et al.Fusion method of multispectral and panchromatic images based on improved PCNN and region energy in NSCT domain[J].Infrared and Laser Engineering,2013,42(11):3096-3102.(in Chinese)李新娥,任建岳,吕增明,等.NSCT域内基于改进PCNN和区域能量的多光谱和全色图像融合方法[J].红外与激光工程,2013,42(11):3096-3102.

[10] Candes E,Tao T.Robust uncertainty principles:exact signal reconstruction from highly incomplete information[J].IEEE Transactions on Information Theory,2006,52(2):489-509.

[11] LI Xin,QIN Shiyin.A new image fusion method based on compressive sensing principl[J].Chinese High Technology Letters,2012,22(1):35-41.(in Chinese)李新,秦世引.基于压缩感知的图像融合的新方法[J].高技术通讯,2012,22(1):35-41.

[12] DENG Xiangyu,MA Yide.PCNN model automatic parameters determination and its modified model[J].Acta Electronica Sinica,2012,40(5):955-964.(in Chinese)邓翔宇,马义德.PCNN参数自适应设定及其模型的改进[J].电子学报,2012,40(5):955-964.

[13] MA Yide,LI Lian,ZHAN Kun,et al.Pulse coupled neural network and digital image processing[M].Beijing:Science Press,2008:11-17(in Chinese)马义德,李廉,绽琨,等.脉冲耦合神经网络与数字图像处理[M].北京:科学出版社,2008:11-17.

[14] Lu Gan,Do T,Tran D.Fast Compressive Imaging Using Scrambled Block Hadamard Ensemble[C].Proceedings of European Signal Processing Conf,2008.