鲁棒的快速车道偏移警告

2014-02-21张百睿钟清华薛秀婷

张百睿, 钟清华, 薛秀婷

华南师范大学物理与电信工程学院,广州510006

由于驾驶员疲劳过度和疏忽致使车辆偏离车道而造成重大交通事故的比例逐年增长,车道偏移警告系统一直是智能交通的研究热点[1-2],它能在驾驶员无意识下造成车道偏离时发出警告.

车道偏移报警系统中最主要的一部分是车道线检测方法,但车道中的环境较复杂,系统容易受到路况差异、环境亮度和城市路面交通标记等复杂场景影响,引起车道线检测失误[3-6].如果采用二值化分方法进行图像的阈值分割[7-9],就不能有效解决夜间的阈值分割问题.基于不同的道路图像模型,采用模板匹配、神经网络和Hough变换等技术可较好地实现对车道线的识别[10-16],但重组过程计算量巨大.在车道线检测方法中,大多采用传统的Sobel算子和Canny算子来实现边沿检验[12-13].但经边沿检测后,不仅是车道线边沿信息,而且车道标识、车辆、行人等其他无用的轮廓线也同时增强了,这就使车道线的信息淹没在无用信息当中,无法准确而快速地提取车道线.基于Hough变换的车道线提取算法也是使用较为广泛的车道识别方法之一,其最大优点是鲁棒性强,但存在计算量和存储空间需求大,运算速度缓慢的不足.综上所述,目前的车道线检测方法准确度低,运算量大或占用内存空间大,导致车道偏移报警系统在进行车道偏移警示时具有准确度低、响应速度慢等缺点.因此,目前的算法大多采用高性能的处理器进行实现,在没有浮点计算、缺乏除法器、难以存储负数和片上资源较少的嵌入式处理器中不易实现,从而使该系统造价一直居高不下,影响普及应用,无法让广大的驾驶员享受安全便利智能的驾驶环境.

针对上述问题,本文基于单目视觉识别应用,提出一种鲁棒的快速车道线偏移警告方法.它通过一系列的数字图像处理从道路图像中提取车道线信息,利用一种5~15车道线匹配方法代替传统的边沿检测,有效去除原图像中的大量干扰信息,在提高识别效果的同时大大降低了运算量.最后采用限定霍夫变换的区间和数据量、缩小霍夫变换投票空间的压缩型霍夫变换对匹配结果进行车道线提取.与传统的霍夫变换相比,它减小了内存使用量.实验证明该算法对实时车道线的识别非常有效,并成功移植到现场可编程门阵列(field programmable gate array,FPGA)上,满足了全天候车道偏移警告的需求.

1 图像预处理

为了突出车道线所在位置,减少图像信息量,提高算法的高效性,需对包含车道线信息的图像进行预处理,其中包括基于区域统计的二值化处理和5~15的车道线匹配处理.

1.1 基于区域统计方式的二值化处理

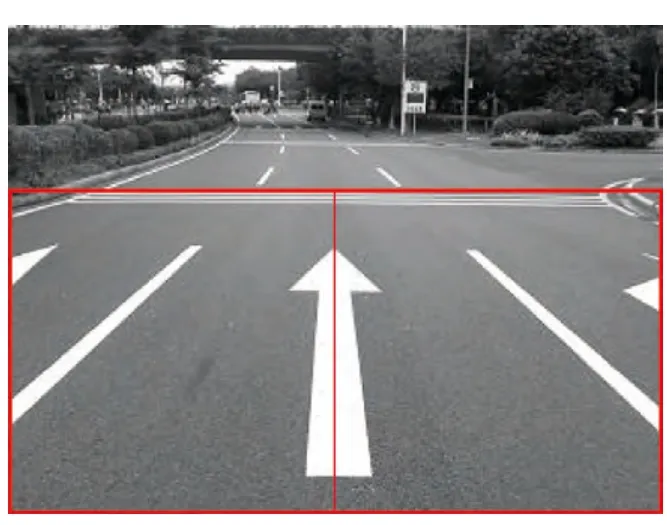

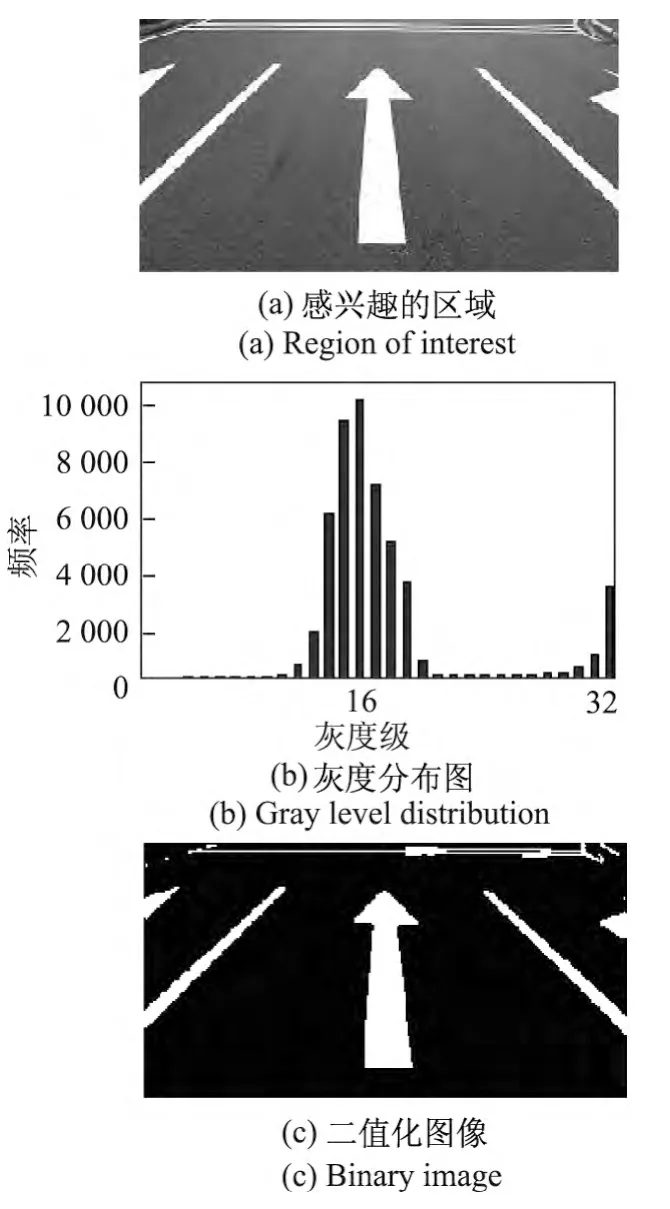

从安装在车辆前方的摄像头获得的道路信息图像中,根据车道占据画面的实际位置,选取左右两个160×160的矩形作为感兴趣区域(ROI),见图1.

图1 感兴趣区域(ROI)Figure 1 Region of interest

对感兴趣区域进行式(1)所示的中值滤波运算,去除图像获取和传输过程中所含有的噪声

式中,Sf(x,y)为点f(x,y)附近的一个3×3的小区域.

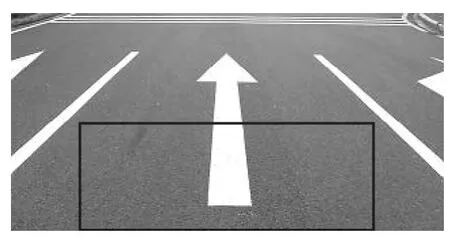

由于车道上的亮度环境比较复杂,必须使用动态的阈值分割方式.考虑到夜间车灯的照射范围和需要减少区域统计灰度分布时的运算量,选取车道图像中的中下部,即如图2所示的近景区域进行灰度分布统计.本文把灰度划分的区间由原来的256个调整为32个,消除了灰度分布曲线的毛刺对后期处理的影响,不仅可使分布曲线光滑,还能减少所占存储空间,得到较好的二值图像.

图2 近景区域划分Figure 2 Partition of close-range

1.2 5~15车道线匹配处理

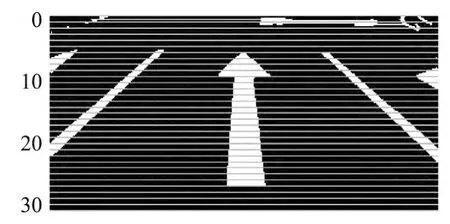

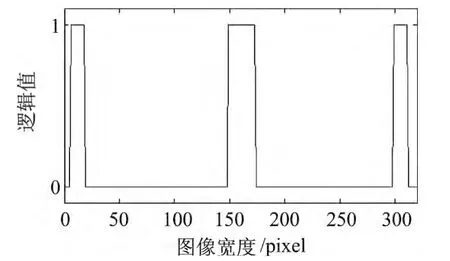

由于车道线具有连续性和非突变性的特点,本文从该二值图像中开始进行以行间距为5像素的横向检测(如图3所示),得到的每行数据相当于一组布尔量序列.根据采集图像中车道线的宽度规格设定最小(5像素)和最大(15像素)两个阈值作为车道线的宽度匹配阈值,然后对布尔量序列进行分析,寻找是否存在连续且符合两个阈值范围的白点子集,并记录下其中点的坐标di(x,y).

图3 横向检测Figure 3 Horizontal detection

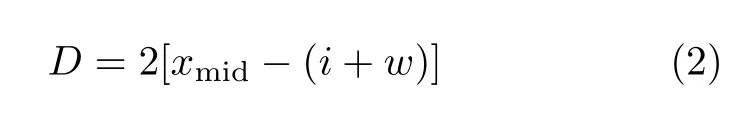

为进一步减少计算量,提高算法效率,并从消除路面标志影响的角度出发,在左边平面匹配出车道线后,根据道路的宽度规格,跳过一定距离D的像素点再进行匹配,距离D如式(2)所示

式中,xmid为布尔量序列中点的位置,在本文中该变量取160;i为上述白点子集的起始位置;w为连续的白点数目.

2 压缩型霍夫变换算法提取车道线

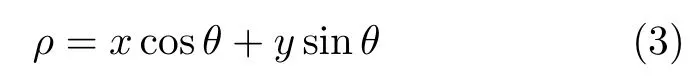

Hough变换通常对二值图像进行直线检测,其原理如下:在直角坐标系下的一点D(x,y)对应于变换空间中的一条曲线ρ=r(θ),而直角坐标系下的一条直线y=ax+b对应于变换空间的一点P(ρ,θ).反之,在直角坐标系中属于一条直线的共线点,在变换空间中相交于一点,由该点P(ρ,θ)的参数可以换算出直线的参数.坐标空间的变换关系为

通过计算变换空间中投票统计后各曲线相交于同一点的次数,即可确定对应的直角坐标系下的直线段分布情况.变换空间中次数越大的点,所对应的直线段越长.在车道线提取的过程中,车道线一般是所在平面中最长的线段,即为变换空间中次数最多的点.求得变换空间中符合该情况的点,就可以计算出车道线参数.

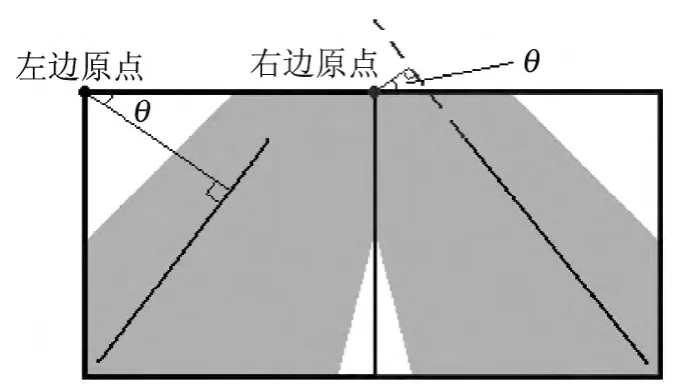

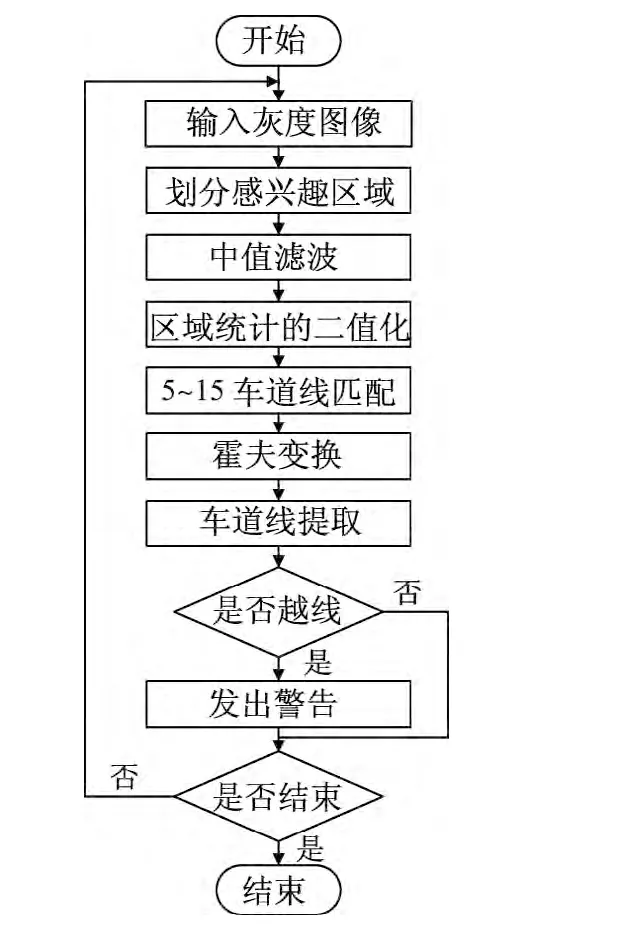

Hough变换最明显的优点是鲁棒性强,但所需的计算量和存储空间均很大.本文采用一种压缩型Hough变换对车道线匹配结果进行车道线提取.经过匹配处理后的图像首先分为如图4所示的左右两个感兴趣矩阵区域,图像原点分别在左右感兴趣矩阵的左上角.与传统的车道识别方法不同,本文忽略正常行使时的车道线,仅从车道将要偏移时开始进行车道线识别,进一步压缩了计算量.

研究发现,可能存在车道偏移情况下的车道线所在范围如图4中灰色部分所示,此时使用Hough变换提取车道线的θ取值范围左边为10°~41°,右边为-41°~-10°,代入式(3)得到对应的ρ取值范围左边为[0,224],右边为[-104,156].在量化过程中选取θ的步长为1°,ρ的步长为4.以上取值可减少运算量,避免道路上无关信息的干扰,也可满足车道线提取的要求.

图4 感兴趣矩阵霍夫变换Figure 4 Hough transform of ROI

为了适应片上资源缺乏的处理器,将算法所需要的正余弦计算结果预先计算完成,并以整数形式存储.运算时采用查表的方式读取,大大减少运算过程中的计算时间.

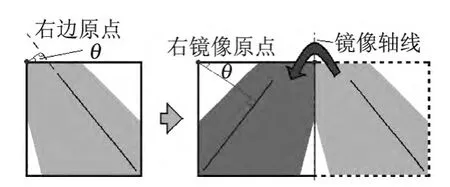

又由于右感兴趣矩阵与左感兴趣矩阵的计算取值范围较为相似,将右感兴趣矩阵以中线为对称轴进行水平镜像处理,如图5所示.即可使用左感兴趣矩阵的运算单元来处理右方区域,并且避免了负数的产生.

图5 右感兴趣矩阵镜像处理Figure 5 Mirror processing of right ROI

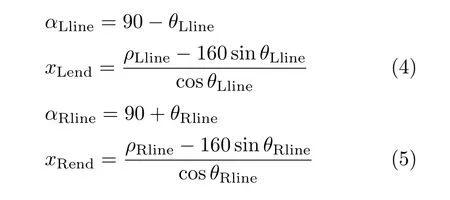

Hough变换后可得到两个感兴趣矩阵的变换区间.提取共线点数目大于8的值作为最长线段进行车道线越线判决,并根据式(4)和(5)分别计算出左线或右线与底边的夹角和交点

最后根据实际情况决定当前的图像是否存在越线现象,本文设定的左越线和右越线判决依据分别为式(6)和(7)

由于车道线具有非突变性的特点,本文设定连续2帧都出现越线现象时才输出越线警告,此法能保证越线判据的正确性.

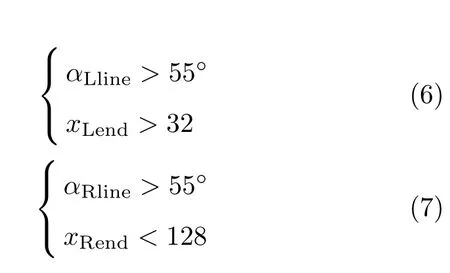

3 实验结果与分析

为了测试算法效果,本文采用实际道路照片和视频进行车道线偏移警告算法的验证.首先对道路上拍摄的静态照片和随车安装在前挡风玻璃拍摄所得的视频处理为320×240像素的jpg和avi文件,再利用本算法进行处理.计算环境为Q9400 CPU、2GB内存的计算机,采用MATLAB进行编程,算法整体流程图如图6所示.

图6 算法整体流程图Figur e 6 Lane departure detection algorithm

3.1 基于区域统计的二值化处理结果

对于划分为如图7(a)所示感兴趣的区域,使用32个等长灰度区间对其中的近景区域进行灰度直方图的统计,如图7(b)所示.利用其统计结果再采用迭代法对原图像进行二值化处理,得到如图7(c)所示的二值图像.

图7 图像预处理Figure 7 Image preprocessing

3.2 基于5~15的车道线匹配处理效果

以图3中第20次横向检测结果的布尔量序列为例,其结果可以表示为一个一维波形图像(如图8所示),其左、右车道线的连续白点数量均为13,路面中间箭头标志的连续白点数量为25.利用上述车道线匹配算法,根据车道线的宽度阈值,可以容易地匹配出车道线,得到其中点的所在位置.

图8 第20次横向检测结果Figure 8 Result of the 20th horizontal detection

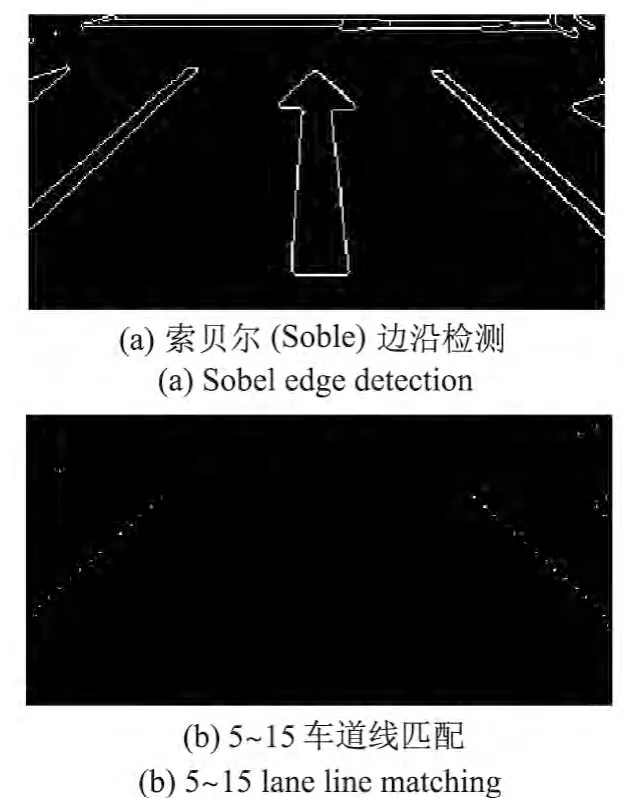

相比于传统使用边沿检测对二值化图像进行处理的车道线图像增强方法,本匹配算法更有效地排除了车道上的大量无关信息,增强了算法的鲁棒性,如图9所示.

图9 与边沿检测对比Figure 9 Compared with edge detection

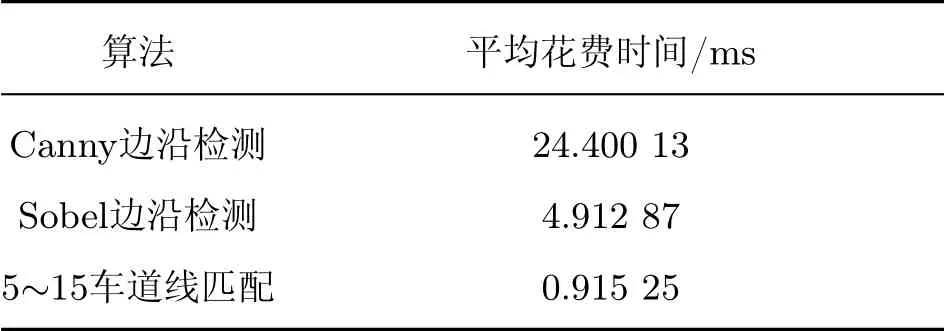

采取行间距为5像素的横向检测,相当于仅对感兴趣区域中20%的信息进行处理,经过在MATLAB上多次实验表明(见表1),本匹配算法有效地提高了计算速度.

3.3 车道线提取算法结果

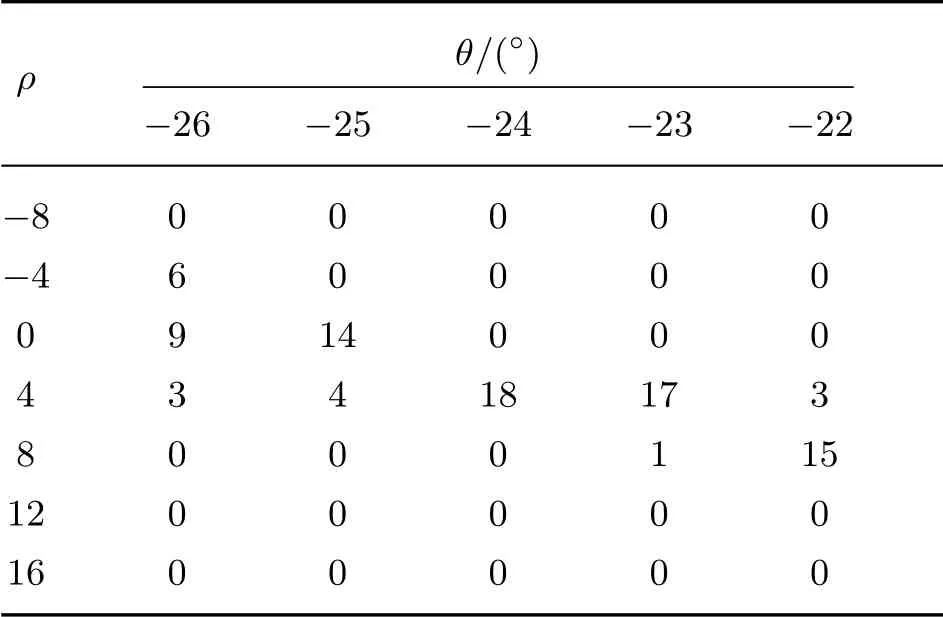

表2所示为其中一次Hough变换后,右车道线变换域的最大值,可得右车道线的各项参数分别如下:极坐标系数为ρRline=4,θRline=-24°,与底边夹角为αRline=66°,与底边交点为xRend=75.6.根据右线的判决依据可知此处出现了右车道线的越线情况.

表1 算法运行时间比较Table 1 Algorithm speed comparison

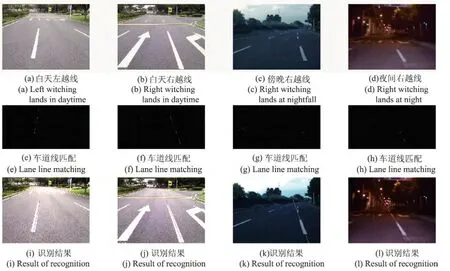

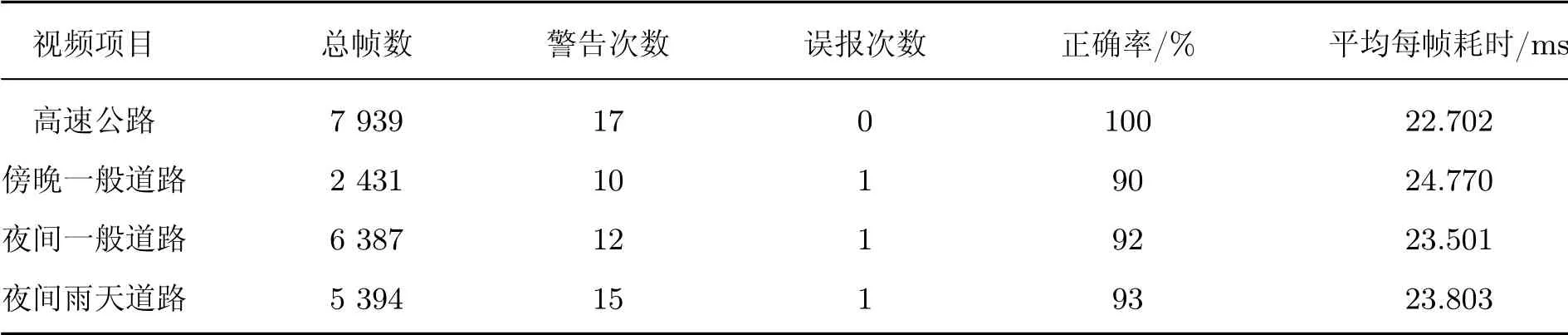

3.4 算法整体测试结果

不同道路环境越线情况下的识别结果如图10所示.对于不同的道路环境,本算法不但能准确地识别出车辆越线的情况,而且解决了路面标识、夜间灯光等影响对车道线识别所产生的影响.在上述计算环境下,处理单张静态图片花费时间约为19ms,处理视频数据每帧耗时约为24ms,详细结果统计如表3所示,完全满足实时性的要求.

表2 右车道线霍夫变换域最大值Table 2 Hough transform f ields of maximum values of the right lane lines

图10 不同道路环境下的识别结果Figure 10 Recognition results of different road environments

表3 视频处理结果统计Table 3 Results of the video processing statistics

对于特殊的路面环境所产生的干扰问题,如前车阻挡、路面标示、斑马线、文字、井盖、夜间灯光影响或道路的指示线有破损等情况,由于采用了第2节中所提及的连续2帧判断方法,并在车速大于50km/h时才开始运行警告,本算法能够排除干扰,准确地进行识别,其识别结果见图11.

图11 特殊路面环境识别结果Figure 11 Recognition results of special road environments

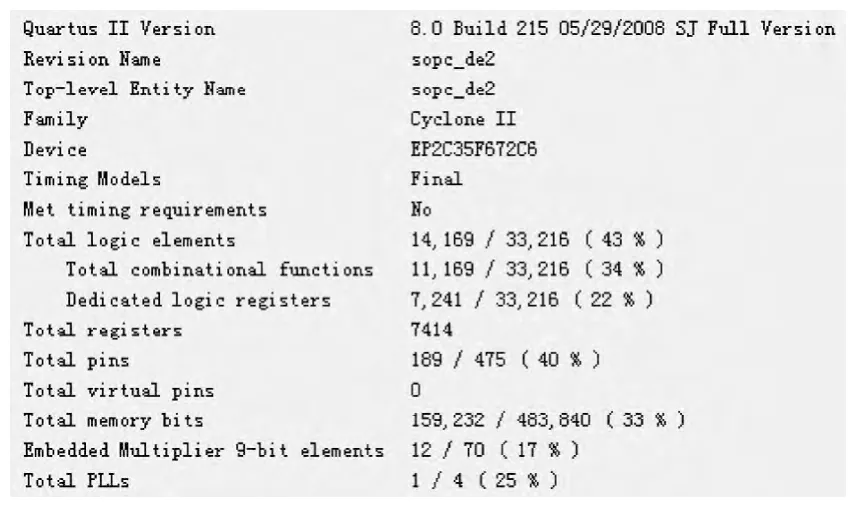

3.5 算法移植

本文的算法已成功移植到Altera公司CycloneⅡ系列的FPGA(型号为EP2C35F672C6)上.系统通过ADV7181视频采集芯片对模拟信号输出的摄像头进行信号采集,利用FPGA进行信号处理,若出现越线现象则发出警告.为满足实时性的需求,其中图像处理算法采用硬核固件实现,并在FPGA上建立SOPC系统,采用电路硬核和NIOSⅡ软核协同处理的方式,对处理速度要求不高的控制功能用NIOSⅡ软核来完成,以满足系统灵活性需求.整个系统所占用硬件资源的情况如图12所示.由图可见整个处理算法只占用14169个逻辑单元(logic elements,LE),对比现有系统[17],需要的硬件的资源更少,效率更高.

4 结语

图12 系统占用资源情况Figure 12 Resource consumption of the system

本文针对基于视觉感知的识别方式,提出一种鲁棒的车道线偏移警告快速算法.根据道路图像,通过数字图像和视觉技术的处理,提取车道线的信息,利用一种简便的5~15车道线匹配方法代替传统的边沿检测算法,有效去除原图像中的大量干扰信息,提高了识别效果,大大降低了运算量.再采用压缩型Hough变换方法针对匹配结果进行车道线提取.与传统的Hough变换相比,该方法减小了内存使用量.实验证明该算法对车道线的识别非常有效,不仅在速度上符合实时性的要求,而且适合在FPGA等片上资源较缺乏的处理器上运行.

[1]MCCALL J C,TRIVEDI M M.Video-based lane estimation and tracking for driver assistance:survey,system,and evaluation[J].IEEE Transaction on Intelligent Transportation Systems,2006,7(1):20-37.

[2]ASSIDIQ A A,KHALIFA O O,ISLAM M R.Real time lane detection for autonomous vehicles[C]//International Conference Computer and Communication Engineering.Kuala Lumpur: IEEE Press,2008:82-88.

[3]LEEJ W.A machine vision system for lane-departure detection[J].Computer Vision and Image Understanding,2002,86(1):52-78.

[4]CLANTONJ M,BEVLY D M,HODEL A S.A low-cost solution for an integrated multisensor lane departure warning system[J].IEEE Transactions on Intelligent Transportation Systems,2009,10(1):47-59.

[5]CUALAIN D O,GLAVIN M E,JONES E.Multiplecamera lane departure warning system for the automotive environment[J].IET Intelligent Transport Systems,2012,6(3):223-234.

[6]KANGD J,JUNGM H.Road lane segmentation using dynamic programming for active safety vehicles[J].Pattern Recognition Letters,2003,l6(1):3177-3185.

[7]HE Y,WANG H,ZHANG B.Color-based road detection in urban traffic scenes[J].IEEE Transactions on Intelligent Transportation Systems,2004,5(4):309-318.

[8]D'CRUZ C,ZOU J J.Lane detection for driver assistance and intelligent vehicle applications[C]//International Symposium on Communications and Information Technologies.Sydney:IEEE Press,2007:1291-1296.

[9]BENMANSOUR N,LABAYRADE R,AUBERT D.Stereovision-based 3D lane detection system: a model driven approach[C]//11th International IEEE Conference on Intelligent Transportation Systems.Beijing:IEEE Press,2008:182-188.

[10]ZHOU Y,XU R,HU X F.A robust lane detection and tracking method based on computer vision[J].Measurement Science and Technology,2006,17(4):736-745.

[11]BERTOZZI M,BOMBINI L,BROGGI A.GOLD:a framework for developing intelligent-vehicle vision applications[J].IEEE Transaction on Intelligent Systems,2008,23(1):69-71.

[12]CHEN S Y,HSIEH J W.Edge-based lane change detection and its application to suspicious driving behavior analysis[C]//International Conference Intelligent Information Hiding and Multimedia Signal Processing.Kaohsiung:IEEE Press,2007:415-418.

[13]SHEN Huan,LI Shunming,BO Fangchao.Intelligent vehicles oriented lane detection approach under bad roadscene[C]//IEEE Ninth International Conference on Computer and Information Technology.Xiamen.IEEE Press,2009:177-182.

[14]WU C F,LIN C J,LEE C Y.Applying a functionalneurofuzzy network to real-time lane detection and front-vehicle distance measurement[J].IEEE Transactions on Systems,Man,and Cybernetics—PART C:Applications and Reviews,2012,42(4):577-589.

[15]LEE J W,YI U K.A lane-departure identif ication based on LBPE,Hough transform,and linear regression[J].Computer Vision and Image Understanding,2005,99(3):359-383.

[16]FARRDI B,WANIELIK G.Hough transformation based approach for road border detection in infrared image[C]//Proceeding of IEEE Intelligent Vehicles Symposium.Parma:IEEE Press,2004:549-554.