一种基于RGB颜色空间和随机矩形区域的显著性检测方法

2013-10-13姚志均王金武

杨 波,姚志均,王金武

(船舶重工集团公司723所,扬州225001)

0 引 言

计算机视觉领域对视觉注意的研究正如火如荼,因为人们发现视觉注意有助于解决各种视觉自动化任务,如目标检测[1]、图像分割[2]、图像压缩[3]、目标识别[4]等等。鉴于此,学术界已提出了多种视觉注意计算模型。

视觉注意计算模型最基本的输出结果是输入图像的显著图,该显著图中的值表示每个像素的显著性。这些模型不但能够让计算机视觉系统受人类认知的启发而生成显著图,而且能够大量减少计算负担,因为它们忽略了不关心的区域[5]。

从心理学角度来看,视觉注意可以分为2类:目标驱动的视觉注意和刺激驱动的视觉注意。前者是由先前的期望指导的,也称自顶向下的视觉注意;后者是由独特的特征、突然的视觉袭击等引起的,也称自底向上的视觉注意。自底向上视觉注意的基本范式是它会引导注意力转向显著区域和目标[6]。文献[5]~[7]的研究结果表明自底向上的显著图能够提高前面提到的多种计算机视觉任务的性能。

一个理想的自底向上的显著模型应该能从视觉心理学上说明其工作原理,而不仅仅是通过图像统计得到。因此,它必须没有先验知识,不用推理,不用训练权重或可调参数,应该简单且便于编程实现,应该具有较小的计算复杂度以能够实时处理。文献[8]的研究结果表明视网膜上的感受野在处理视觉刺激时是随机处理的,包括位置和尺度空间上。受此启发,Vikram等人[9]提出了一种基于随机矩形区域采样的显著性检测方法:首先,将图像从RGB颜色空间转换到CIE 1976 L*a*b*颜色空间;然后在图像中随机采样一个矩形区域(区域的位置和大小都随机),计算该区域内每个像素与该区域的特征平均值之间的距离;最后融合所有的矩形区域和特征得到最终的显著图。该方法的计算很简单,且只有一个可调参数,即随机矩形区域的采样数量,容易编程实现。

然而,由于L*a*b*颜色空间的3个通道取值范围不同,L*的取值范围为[0 100],而a*、b*为[-128 127]。另外,图像的亮度变化往往比较大,而色度变化不大,这样很有可能导致基于这3个通道得到的显著性值不在同一个数量级,从而不能很好地体现出各个通道的作用。此外,该方法需要将原始图像从RGB颜色空间转换到XYZ颜色空间,再转换到L*a*b*颜色空间,故增加了计算时间,不利于实时性处理。考虑到R、G、B这3个通道的取值范围一样,变化快慢相当,故本文提出了一种基于RGB颜色空间的随机矩形区域显著性检测方法,实验结果表明本文方法大幅减少了计算时间,同时显著性检测效果也好于文献[9]。

1 本文提出的显著性检测方法

设输入图像I为一副r×c×3的彩色图像,其中r为图像的行数,c为图像的列数。

首先对输入图像做高斯平滑处理,以消除噪声等的影响,从而得到新的图像Ig。

接着,随机产生n个矩形区域,第i个矩形区域的左上角和右下角坐标分别记作(x1i,y1i)和(x2i,y2i)。

第3步,计算每种特征所对应的显著性值。以R通道为例,对于第i个矩形区域,计算该区域内R的均值,则该区域内每个像素的显著性值为该像素的特征值与均值之差的平方,然后结合这n个矩形区域可以得到R通道的显著图SR。同理可以得到G、B通道的显著图SG、SB,3个显著图的大小都为r×c。

第4步,特征融合。本文采用线性组合的方式将SR、SG、SB融合得到最终的显著图S,大小也为r×c。

第5步,后处理,包括中值滤波和归一化操作。选择中值滤波的原因是它在剔除噪声的同时能保留边缘信息,而归一化操作的目的是为了显示图像。

具体的算法流程如图1所示。

图1 本文方法的流程图

2 实验结果与分析

本节通过实验仿真来阐明提出本文方法的缘由,并验证本文方法的有效性与性能。

第1个实验是以一个小尺寸的图像块作为目标,通过查看L*、a*、b*3个通道的值及R、G、B3个通道的值来阐明提出本文方法的缘由。取图2中的方框(大小为11×10)为要分析的目标图像块,R、G、B3个通道的值如图3(a)、(b)、(c)所示,然后本文用Matlab内置的srgb2lab程序将图像从RGB颜色空间转换到L*a*b*颜色空间,L*、a*、b*3个通道的值分别如图3(d)、(e)、(f)所示。

图2 方框为要分析的目标图像块

注意,用srgb2lab程序得到的L*、a*、b*的值已归一化到[0 255]。为了衡量每个颜色通道中像素值的变化情况,本文用二阶统计量来表示它们的变化大小。经统计,R、G、B 和L*、a*、b*6个通道的方差大小分别为65.242 4、57.071 2、48.770 3和44.321 6、2.095 2、0.483 4。

图3 目标图像的6个颜色通道所对应的像素值

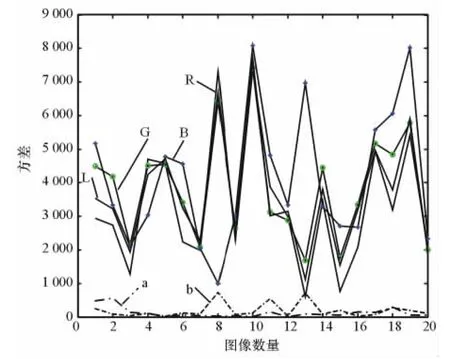

为了更客观地说明这2种颜色空间中各颜色通道的变化情况,本文从文献[2]的数据库随机取了20幅图像,然后统计6个颜色通道的像素值在整幅图像中的变化情况,结果如图4所示。图3和图4充分说明,RGB颜色空间各通道中像素值的变化大小比较一致,而L*a*b*颜色空间中亮度特征的变化远大于色度特征的变化,故当将L*、a*、b*3个通道所对应的显著性值直接相加的话,色度特征a*和b*的显著性往往容易被亮度特征L*所抑制,故本文采用RGB颜色空间作为图像特征。

图4 6个颜色通道的方差统计

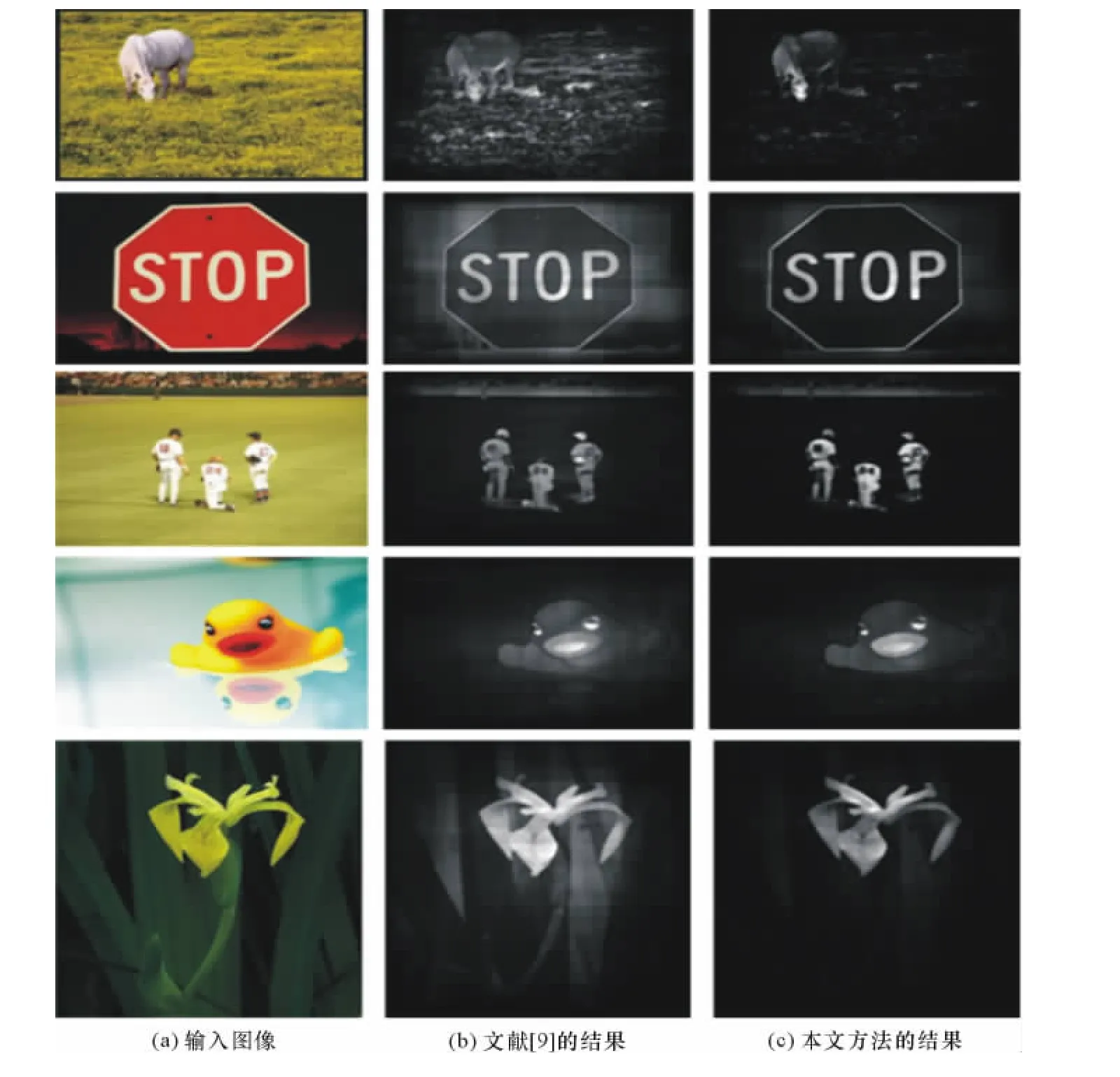

第2个实验是比较本文方法与文献[9]提出方法的显著性检测效果。实验的数据来自文献[2]提供的数据库,随机选了5幅图像。实验中高斯低通滤波器设置为Matlab默认的参数(大小为3×3,标准方差为0.5),中值滤波器的大小设置5×5,随机矩形区域采样数量n为100,实验结果如图5所示。

图5(b)和(c)分别是文献[9]和本文方法得到的显著图,像素的亮度越亮,显著性值越大,表明该像素越显著。

从图5可以看出,(c)中的目标比(b)中的目标更清晰,干扰更少,也即表明用本文方法得到的显著图优于文献[9]得到的显著图,这是因为本文方法充分利用了各颜色通道的信息,而文献[9]的方法由于亮度特征L*的变化远大于色度特征a*、b*的变化,从而抑制了色度特征提供的有用信息。

图5 2种显著性检测方法的结果比较

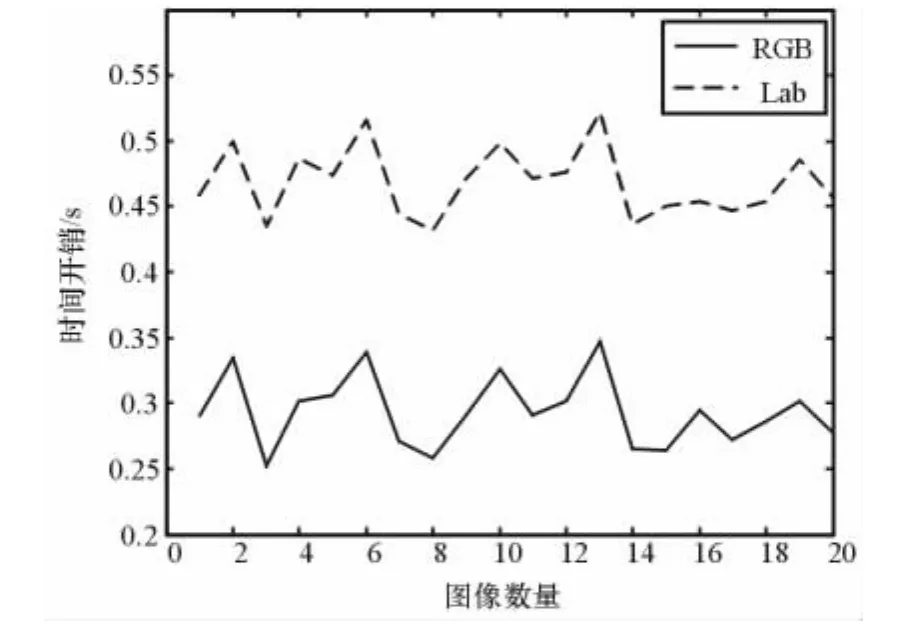

第3个实验是比较本文基于RGB颜色空间的方法与基于L*a*b*颜色空间的方法[9]的计算时间开销。实验用的硬件平台为Pentium(R)Dual-Core CPU,2.60GHz,2G内存的PC,2种方法都是在Matlab软件平台上运行,参数设置与实验2一样。

本文从文献[2]的数据库中选择了20幅400×300的图像作为测试图像,2种方法耗费的计算时间如图5所示,实线为本文方法的时间开销,虚线为文献[9]的时间开销。文献[9]的平均计算时间为0.468 5s,而本文方法的平均计算时间为0.293 2s,减少了40%左右,实时性更好。

图6 2种方法的计算时间比较

3 结束语

本文提出了一种基于RGB颜色空间的显著性检测方法,由于无需进行颜色空间的转换,从而相比于文献[9]的显著性检测方法更节省计算时间。同时,RGB颜色空间中的R、G、B三通道中像素亮度的波动比较一致,故在特征融合时更能充分利用各个特征的信息,从而取得了更好的显著性检测效果。

[1]Moosmann F,Larlus D,Jurie F.Learning saliency maps for object categorization[A].Proceedings of ECCV International Workshop on The Representation and Use of Prior Knowledge in Vision[C].Graz:Springer,2006.

[2]Achanta R,Estrada F,Wils P,et al.Salient region detection and segmentation[A].Proceedings of The International Conference on Computer Vision Systems[C].Santorini:Springer,2008:66-75.

[3]Guo C,Zhang L.A novel multiresolution spatiotemporal saliency detection model and its applications in image and video compression[J].IEEE Transactions on Image Processing,2010,19(1):185-198.

[4]Kanan C,Cottrell G W.Robust classification of objects,faces,and flowers using natural image statistics[A].Proceedings of The IEEE Conference on Computer Vision and Pattern Recognition[C].San Francisco:IEEE,2010:2472-2479.

[5]Rothenstein A L,Tsotsos J K.Attention links sensing to recognition[J].Image and Vision Computing,2008,26(1):114-126.

[6]Elazary L,Itti L.A Bayesian model for efficient visual search and recognition[J].Vision Research,2010,50(14):1338-1352.

[7]Harel J,Koch C,Perona P.Graph-based visual saliency[A].Advances in Neural Information Processing Systems[C].Vancouver:MIT Press,2007:545-552.

[8]Colby C L,Goldberg M E.Space and attention in parietal cortex[J].Annual Review of Neuroscience,1999,22(1):319-349.

[9]Vikram T N,Tscherepanow M,Wrede B.A saliency map based on sampling an image into random rectangular regions of interest[J].Pattern Recognition,2012,45(9):3114-3124.