自适应近邻的局部线性嵌入算法

2012-06-23张兴福黄少滨

张兴福,黄少滨

(1.哈尔滨工程大学计算机科学与技术学院,黑龙江哈尔滨150001;2.黑龙江省农垦经济研究所,黑龙江哈尔滨150090)

随着多媒体技术的广泛应用,分析图像及音、视频文件的算法也越来越受到科研工作者的关注.图像等数据往往维数过高,因此出现众多对高维数据进行降维处理算法,优秀的降维算法既可以去掉冗余特征,又能够保留主要特征,这样既提高后续算法的性能,还降低了算法的复杂度.

降维算法分为线性降维及非线性降维,经典的线性降维算法有主分量分析(PCA)、线性判别分析(LDA)、独立分量分析(ICA)等.线性降维算法通过对训练样本的学习得到映射矩阵,再通过线性运算将高维空间的数据映射至低维空间,算法计算复杂度低,适合实时应用,但对非线性分布数据的降维效果不佳,故需要采用对非线性分布数据的降维效果良好的非线性降维算法,如流形学习.

2000年Science杂志在同一期上连续发表了3篇流形学习方面的文章[1-3],奠定了流形学习的研究基础.相对于PCA等线性降维算法,流形学习算法能够更好地发现非线性分布数据的本质结构,而且H.Sebastian Seung等[1]又提出人类的感知是基于流形的,众多国内学者也对流形学习进行了深入研究[4-11].流形学习分为全局算法与局部算法,等距映射(ISOMAP)[2]是经典的全局算法,该算法将多维分析(MDS)推广到非线性降维领域,能够更好地保持数据的整体结构,但计算复杂度较高;局部线性嵌入(LLE)[3]与拉普拉斯映射(LM)[12]算法则是经典的局部算法,LLE算法将PCA算法推广到非线性降维领域,LM算法则利用热核方程计算加权边,然后与数据样本组成拉普拉斯图后进行数据降维,LLE与LM算法均只保留局部关系,这样虽然数据整体分布会有些“变形”,但计算复杂度大大降低,适合实时性要求高的系统.

目前流形学习的局部降维算法普遍存在3方面问题:1)近邻选取问题,局部算法均需要应用K近邻法或ε近邻法[12]确定任意样本的近邻,并没有根据样本自身特征考虑某一样本是否适合作为另一个样本的近邻,同时k或ε值的确定也没有给出具体方案;2)相似性度量问题,局部算法往往应用欧氏距离计算样本间相似度,欧氏距离假定高维数据的各个分量间是完全无关的,而对诸如图像等高维数据,作为分量的各个位置的像素值并不是完全无关的,因此某些具体应用中欧氏度量不一定是最恰当的相似性度量;3)新样本降维问题,一些局部算法没有提供新样本的降维方法,这使其很难应用于动态系统.

针对LLE算法存在的第1个问题,Dick de Ridder等[13]提出监督的 LLE 算法(SLLE),Shiqing Zhang等[14]提出增强的监督 LLE 算法(ESLLE),2种算法在近邻选择步骤时都充分考虑样本的类标签信息,使得样本的近邻大部分是同类,少部分是异类,这样在重构时既能尽量保持数据分布属性,还使得算法有较好的泛化能力.Hong Chang等[15]提出鲁棒的LLE算法,通过运用系数主分量分析算法评估每个样本噪声的概率,然后在运用LLE算法时,只选择是噪声概率较小的样本作为近邻.Shuzhi Sam Ge等[16]提出邻域线性嵌入算法(NLE),认为如果2个样本过于相似,则其中一个可以由另外一个表示,即过于相似的2个样本有类似的属性,选择近邻时只选择过于相似的2个样本之一作为某个样本的近邻.A.Hadid等[17]提出多流形局部线性嵌入算法,指出如果数据采样不好会造成当前很多LLE相关算法性能都会急剧下降,因此提出另外一种鲁棒LLE算法;将训练样本组成连通分支,如果存在多个连通分支,则认为较小的连通分支是由噪声点组成,因此只在较大的连通分支上应用LLE算法.LLE算法存在的第2个问题,很多学者也给出了改进方案,针对于图像降维应用问题,Liwei Wang等[18]提出图像相似度计算的方法(IMED)[18],Lijing Zhang 等[19]将其用于LLE算法中2个数据样本相似性度量.ChangYin Zhou等[20]还提出了基于凸轮分布的 近邻算法(camNN),Yaozhang Pan 等[21]将其用于 LLE算法中2个数据样本相似性度量.针对LLE算法存在的第3个问题,出现了新样本的线性及非线性降维方法[22-24].

标准LLE算法在应用K近邻法时还存在如下问题:1)缺乏有效确定K值的方法,试凑法需要大量的时间;2)对K值过于敏感,从仿真实验效果看,不同的取值往往会造成完全不同的降维效果;3)固定K值不合理,由于数据样本未必是均匀分布,故每个样本周围近邻分布情况不同,针对不同的分布却选择相同的K值显然并不合理.针对上述问题,众多学者提出自适应LLE算法,自动确定每个样本的近邻数[16,25-30],但这些算法在自动确定K值时,往往引入新参数,而对于新参数的确定没有给出具体方法.

本文提出基于自适应近邻的局部线性嵌入算法(ANLLE),根据样本数据分布情况不同,自动为每个样本分配不同数目的近邻,解决了标准LLE算法的近邻选取问题,且不需引入其他参数.

1 局部降维

1.1 标准局部线性嵌入算法(LLE)

假设一幅图像由m行n列像素组成,D=m×n表示原始图像向量空间的维数,d表示降维后子空间的维数,K表示使用K近邻算法时每个样本选取的近邻个数,X1、X2、…、XN表示D维空间的N个样本,Y1,Y2,…,YN表示 d 维空间的 N 个样本,Yi为Xi在d维空间的表示,一般d≪D.

Sam T.Roweis等开创性的提出了标准LLE算法,核心思想是在高维空间的局部邻域关系降维后在低维空间得到保持,即保证数据的局部结构,算法分为如下 3 步[3,31]:

1)计算样本间的欧氏距离,距离越小说明两者相似度越高,依此原则确定每个样本 Xi(i=1,2,…,N)的 K 个由近到远的近邻 Xi1,Xi2,…,XiK;

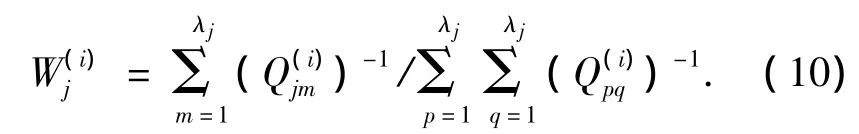

2)对任意Xi,用其近邻的线性组合重构Xi,系数W(i)j表示在重构时Xi的第j个近邻所占的权重,为使重构误差最小,设置代价函数为

3)保证系数W(i)j不变,在d维子空间用各个样本的近邻重构其本身,即求Y=[Y1Y2… YN],使得重构误差最小,设置代价函数为

记W为N×N的稀疏矩阵,Wij为矩阵W的第i行第j列对应的元素,如果Yj是Yi的近邻,则Wij=,否则 Wij=0,设 M=(I-W)T(I-W),I为单位阵,限制.设矩阵M按升序排列的最小的d个非零特征值所对应的特征向量为 q1,q2,…,qd,则最终求得

1.2 标准拉普拉斯映射(LM)算法及自动确定近邻的LM算法

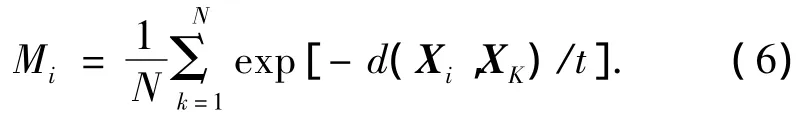

Mikhail Belkin等[12]于2001年提出拉普拉斯映射算法(LM),其理论基础是图谱理论,使用K近邻法确定任意样本的近邻,用热核方程确定拉普拉斯图中边的权值,即任意样本Xi与其第j(j≤K)个近邻Xij作为顶点的边的系数为

LM算法的目标是使任意Xi的近邻在降维后仍然尽可能靠近Xi,即在低维空间所有点与其近邻的距离和最小,因此有代价函数:

式中:Yi为Xi在低维空间的表示,维数为d;Yij为Xi的第j个近邻在低维空间的表示,其中是为了体现局部特征,而使得越靠近Xi的近邻点所占权重越大;L=D-W称为拉普拉斯算子,其中W为N×N的稀疏矩阵,Wij为矩阵W的第i行第j列对应的元素,如果Yj是Yi的近邻,则,否则Wij=0,D 为对角阵

文献[12]算法证明了拉普拉斯映射中求L的特征向量近似等同于标准LLE算法中求M的特征向量.

Bo Yang等[32]提出自动选择近邻 LM算法,算法根据每个样本周围数据分布情况确定该样本的近邻数,优点在于解决了标准算法确定近邻数的难题,而且不同样本选用不同近邻数,显然比采用固定近邻数的算法更合理.算法核心在于为每个样本确定一个近邻数阈值,即利用式(4)作为2个样本间的相似性度量,则任意样本Xi与所有样本的平均相似度为

2 自适应近邻局部线性嵌入算法理论

同标准LM算法一样,LLE算法同样需要确定近邻数,因此从 Bo Yang的论文[32]得到启示,寻找一种适合LLE算法的相似性度量,然后确定合理阈值即可为每个样本自动寻找合适的近邻.

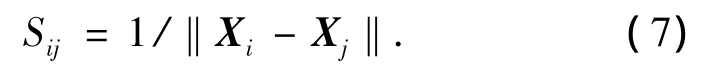

分析自动选择近邻的LM算法的相似性度量函数可知:1)函数以样本间欧氏距离为自变量,且必须是单调递减,单调性保证2个样本距离不同则相似性一定不同,递减则表示样本距离越大相似度越小,具有现实意义;2)随着自变量无限增大,函数极限为零,保证距离过大的2个样本相似度基本为零,这样如果用相似度均值作为阈值,则可保证阈值更多地取决于样本附近的数据.基于以上规则,针对LLE算法提出将图像欧氏距离的倒数作为相似性度量,以欧氏距离倒数的均值作为近邻选择的阈值.选取此阈值,当任意样本Xi周围数据比较密集时,阈值会相对靠近Xi,则在距离Xi较近处即可取到足够近邻;而当Xi周围数据比较稀疏时,阈值则会相对远离Xi,以便能够取到足够的近邻.基于此种想法提出自适应近邻局部线性嵌入(ANLLE)算法.

2.1 算法描述

2.1.1 样本近邻确定

设存在 N 个数据样本 X1,X2,…,XN,其中 Xi∈RD,(i=1,2,…,N),计算任意 2 个样本 Xi与 Xj相似度为

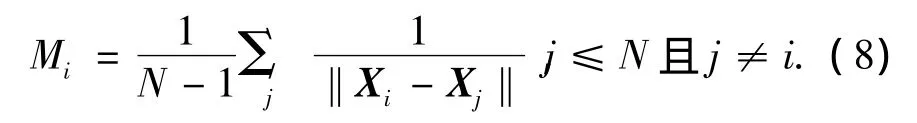

式中:分母表示两样本数据的2范数,则Xi与所有其他样本的平均相似度为

式中:Mi即可作为近邻选择的阈值,即任意Xj与Xi的相似度如果大于Mi,则Xj是Xi的近邻,否则不是.式(7)是双曲线在第一象限的部分,即靠近Xi的数据点Sij值较大,远离Xi的数据点Sij值迅速减小,因此式(8)中Mi值将较偏向Xi,这样可保证近邻数不会很大,在一定程度上避免近邻数过大导致的回路问题.

可采用二分法确定每个样本近邻数,具体描述如下:

1)对于任意Xi,将其他所有样本按与Xi欧氏距离升序排序,赋初值 λmin=1,λmax=N-1,转入2);

2)设置 λ =(λmin+ λmax)/2,如果满足 Si■λ+1」≤Mi≤Si■λ」(■λ」表示对 λ 下取整)则转入 4),否则转入3);

3)计算Xi与X■λ」的相似度,如果相似度大于Mi,则设置λmin=■λ」,否则设置 λmax=■λ」,转入2);

4)确定λi=■λ」为Xi的近邻数,算法结束.

2.1.2 训练样本降维

每一个样本的近邻确定完毕后,可据此对训练样本降维,过程可参照标准LLE算法,但有几点需要说明:

1)求解系数的代价函数为

注意与式(2)比较,式(9)的求和公式中用λi代替K,即针对每一个Xi值,用于重构的近邻数是不同的;

2)求解M=(I-W)T(I-W)的特征向量时,M中的矩阵W与标准LLE算法中M中的矩阵W有很大不同,标准算法中W的每一列都有且仅有K个非零元素,但本算法中W的每一列非零元素不同,即W的第i列有且仅有λi个非零元素.最终求得

2.1.3 待测样本分类

首先确定待测样本重构近邻数,然后再对待测样本降维,最后在低维空间使用最近邻法将待测样本分类,具体描述如下.

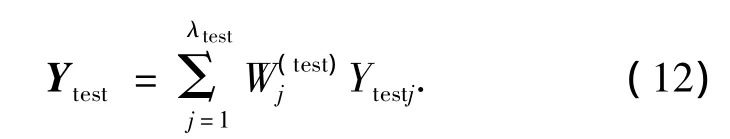

对任意待测样本Xtest,其与训练样本中任意样本 Xi的相似度为 Stesti=1/‖Xtest-Xi‖,Xtest与所有训练样本的平均相似度为

以 Mtest为阈值,用二分法确定 Xtest的近邻数λtest,进而确定 Xtest的近邻,用式(2)计算出重构系数,设Xtest的近邻在d维空间对应向量为 Ytest1、Ytest2、…、Ytestλtest,则 Xtest1在 d 空间的表示为

最后利用最近邻法,在低维空间寻找距Ytest最近点,其所属分类即是Ytest所属分类.注意,测试样本的降维过程依赖于样本分布局部线性的假设,这也是LLE算法的基础,因此假设是合理的,详细描述可参考文献[22].

2.2 ANLLE算法理论分析

ANLLE算法关键在于采用欧氏距离的倒数作为相似性度量,并据此利用式(8)计算每个样本的近邻数,下面比较此相似性度量对于直接使用欧氏距离作为相似性度量的优势.

不妨假设样本均匀分布并均匀取值,假设共有n+1个样本,样本X与其余n个样本的相似度分别为:1、1/2、1/3、1/4、…、1/n,根据式(8)计算平均相似度为

可知,当n趋于无穷大时有

式中:c=0.577 215 664 9为欧拉常数,则有

因此,用式(8)计算出来的近邻数是有界的,不会随着训练样本的增加而不断增大,可以有效避免近邻数太大出现的回路问题;而如果用欧氏距离作为相似性度量,则随着样本的增加,近邻数不断增大,不可避免的会造成回路问题.

3 仿真实验及结果分析

将标准LLE算法、NLE算法及ANLLE算法分别应用于ORL人脸数据库及USPS手写数字数据库,并对3种算法的性能进行比较分析.注意,实验过程中将 NLE算法的调节参数 γ设置为1,即lnγ=0,则NLE也变为完全自适应算法,这样易于与ANLLE算法进行性能比较.

3.1 ORL人脸数据库上的实验及性能分析

ORL人脸数据库由40个人的脸部图像组成,每个人提供10幅不同图像,每幅图像为112×92像素,包括在不同时间、光照、人脸表情(睁、闭眼,微笑、不笑)、面部细节(是否戴眼镜)取得的图片,背景相同,前视图有轻微倾斜,图1为其中一人的全部图像.

将图像分为10组,每组40幅图像,由40个不同人的脸部图像组成,采用留一法进行测试,即每次选取1组作为测试样本,其余9组作为训练样本,直到所有样本均已当选且仅当选过一次测试样本.

图1 ORL数据库示例Fig.1 Samples on ORL

对标准LLE算法子空间维数d分别设置为30、40、50及60,在每个子空间近邻数d分别设置为5、10、20、30、40、50 及 60 进行实验,对于 NLE 及 ANLLE算法,由于无需手动设置近邻数K,所以只需分别设置子空间维数d进行实验即可.实验结果如图2及3所示.

图2 LLE算法在ORL库上的识别率Fig.2 Recognition rate of LLE algorithm on ORL

图2中描述了不同子空间中选择不同近邻数时,LLE算法在ORL人脸数据库上的识别率.从图2中可以看出,在K=60且d=30及K=60且d=60时取得最低识别率84.25%,在K=5且d=60时取得最高识别率93.25%.在各个子空间中不同的K值使得识别率也不同,但从图中以看出在不同子空间中均是在K=5时取得最高识别率,因此采用K=5时LLE算法的识别率与NLE算法及ANLLE算法识别率进行比较,比较结果如图3所示.

图3 3种算法在ORL库上的识别率比较Fig.3 The comparison of recognition rates of the three algorithms on ORL

从图3中可以看出标准LLE算法当K=5时在30、40、50、60 维子空间的识别率分别为 88.5%、90%、91.25%、93.25%,NLE 算法在相应子空间的识别率为 91%、91.75%、92.25%、92.5%,ANLLE算法在相应子空间的识别率分别为95.5%、96.5%、95.25%、95.5%.由此可以得出,在各个不同子空间ANLLE算法识别率均优于标准LLE算法及NLE算法.

3.2 USPS手写数字数据库上的实验及性能分析

USPS手写数字数据库由0~9数字图像组成,每个数字有1 100个不同手写图像,每幅图像像素为16×16,图4为其中部分图像.

图4 USPS数据库示例Fig.4 Samples on USPS

从0~9中每个数字选择100幅图像,共计1 000幅作为训练样本,然后从剩余图像中每个数字选择200幅图像,共计2 000幅图像作为测试样本进行实验.

对标准LLE算法子空间维数d分别设置为30、40、50及60,在每个子空间近邻数K从5~60中每隔5取一次值进行实验,对于ANLLE算法及NLE算法,同样只需分别设置子空间维数d为30、40、50及60进行实验即可.实验结果如图5及6所示.

图5 LLE算法在USPS库上的识别率Fig.5 Recognition rate of LLE algorithm on USPS

图5中描述了不同子空间中选择不同近邻数时LLE算法在USPS手写数字数据库上的识别率.可以看出,并没有出现类似ORL库中不同子空间均在一个K值取得最好识别率现象,当子空间维数为30时,在K=25处取得最高识别率75.9%;维数为40时,在K=20处取得最高识别率77.25%;维数为50时,K=30处取得最高识别率77.15%;维数为60时,K=30处取得最高识别率77.5%.选取LLE算法在各个子空间最高的识别率与ANLLE算法及NLE算法进行比较,结果如图6所示.

图6 3种算法在USPS库上的识别率比较Fig.6 The comparison of recognition rates on USPS

从图6中可以看出,ANLLE算法及NLE算法在不同维数识别率均优于标准LLE算法,在30、40维子空间,ANLLE算法识别率高于NLE算法,而40、50维子空间NLE算法识别率高于ANLLE算法,但对比实验在ANLLE算法30维子空间处取得最高识别率 86.95%,大于 NLE的 83.15% 及 LLE的77.5%.

从与标准LLE算法的对比实验可以看出,ANLLE算法不但简化了手工确定K值的步骤,而且取得更好的识别率.从与NLE算法的对比实验分析,ANLLE算法计算近邻过程所需时间更短,而识别率却更高.因此综上所述,ANLLE算法相对于其他算法的优点主要有:1)正确识别率高;2)自动确定每个样本所需近邻;3)训练时间较短.

4 结论

提出ANLLE算法,相比较标准LLE算法有以下2个优点:

1)自动确定每个样本的近邻数,效率高于标准LLE算法中常用的试凑法确定近邻;

2)根据样本周围数据分布情况确定其近邻数,这比无论分布情况如何一律采用相同近邻数的标准LLE算法更合理,在ORL及USPS库上的实验证明,ANLLE算法识别率明显高于标准LLE算法.

除LLE算法外,局部切空间映射(LTSA)及汉森映射(HLLE)等算法均是较优秀的局部流形学习方法,同样可以考虑将自动选择近邻的方法应用于这些算法,这将作为后续研究内容.

[1]SEUNG H S,LEE D D.The manifold ways of perception[J].Science,2000,290(5500):2268-2269.

[2]TENENBAUM J B,DESILVA V,LANGFORD J C.A global geometric framework for nonlinear dimensionality reduction[J].Science,2000,290(5500):2319-2323.

[3]ROWEIS S T,SAUL L K.Nonlinear dimensionality reduction by locally linear embedding[J].Science,2000,290(5500):2323-2326.

[4]徐蓉,姜峰,姚鸿勋.流形学习概述[J].智能系统学报,2006,1(1):44-51.XU Rong,JIANG Feng,YAO Hongxun.Overview of manifold learning[J].CAAI Transactions on Intelligent Systems,2006,1(1):44-51.

[5]尹峻松,肖健,周宗潭,等.非线性流形学习方法的分析与应用[J].自然科学进展,2007,17(8):1015-1025.YIN Junsong,XIAO Jian,ZHOU Zongtan,et al.Analysis and application of nonlinear manifold learning method[J].Progress in Natural Science,2007,17(8):1015-1025.

[6]何力,张军平,周志华.基于放大因子和延伸方向研究流形学习算法[J].计算机学报,2005,28(12):2000-2009.HE Li, ZHANG Junping, ZHOU Zhihua. Investigating manifold learning algorithms based on magnification factors and principal spread directions[J].Chinese Journal of Computers,2005,28(12):2000-2009.

[7]赵连伟,罗四维,赵艳敞,等.高维数据流形的低维嵌入及嵌入维数研究[J].软件学报,2005,16(8):1423-1430.ZHAO Lianwei,LUO Siwei,ZHAO Yanchang,et al.Study on the low-dimensional embedding and the embedding dimensionality of manifold of high-dimensional data[J].Journal of Software,2005,16(8):1423-1430.

[8]詹德川,周志华.基于集成的流形学习可视化[J].计算机研究与发展,2005,42(9):1533-1537.ZHANG Dechuan,ZHOU Zhihua.Ensemble-based manifold learning for visualization[J].Journal of Computer Research and Development,2005,42(9):1533-1537.

[9]孟德宇,徐宗本,戴明伟.一种新的有监督流形学习方法[J].计算机研究与发展,2007,44(12):2072-2077.MENG Deyu,XU Zongben,DAI Mingwei.A new supervised manifold learning method[J].Journal of Computer Research and Development,2007,44(12):2072-2077.

[10]马瑞,王家廞,宋亦旭.基于局部线性嵌入(LLE)非线性降维的多流形学习[J].清华大学学报:自然科学版,2008,48(14):583-586.MA Rui,WANG Jiaxin,SONG Yixue.Multi-manifold learning using locally linear embedding(LLE)nonlinear dimensionality reduction[J].J Tsinghua Univ:Sci&Tech,2008,48(14):583-586.

[11]冯海亮,李见为,王旭初,等.基于非线性子流形的人脸识别[J].重庆大学学报,2008,31(3):303-306.FENG Hailiang,LI Jianwei,WANG Xuchu,et al.Face recognition based on nonlinear manifold learning[J].Journal of Chongqing University,2008,31(3):303-306.

[12]MIKHAIL B ,PARTHA N.Laplacian eigenmaps for dimension reduction and data representation[J].Neural Computation,2001,15(6):1373-1396.

[13]RIDDER D D,KOUROPTEVA O,OKUN O,et al.Supervised locally linear embedding[R].Stuttgart:Lecture Notes in Computer Science,2003.

[14]ZHANAG Shiqing.Enhanced supervised locally linear embedding[J].Pattern Recognition Letters,2009,30(13):1208-1218.

[15]CHANG Hong,YEUNG D Y.Robust locally linear embedding[J]. PatternRecognition, 2006,39(6):1053-1065.

[16]SAM G S,FENG G,PAN Y Z,et al.Neighborhood linear embedding for intrinsic structure discovery[J].Machine Vision and Applications,2008,21(3):391-401.

[17]ABDENOUR H,MATTI P.Efficient locally linear embeddings of imperfect manifolds[C]//Proceedings of the Third International Conference on Machine Learning and Data Mining in Pattern Recognition.Leipzig,Germany,2003:188-201.

[18]WANG Liwei,ZHANG Yan,FENG Jufu.On the Euclidean distance of images[J].IEEE Transactions on Pattern A-nalysis and Machine Intelligence,2005,27(8):1334-1339.

[19]ZHANG Lijing,WANG Ning.Locally linear embedding based on image Euclidean distance[C]//2007 IEEE International Conference on Automation and Logistics.Jinan,China,2007:1914-1918.

[20]ZHOU Changyin,CHEN Yanqiu.Improving nearest neighbor classification with cam weighted distance[J].Pattern Recognition,2006,39(4):635-645.

[21]PAN Yaozhang,GE S S,MAMUN A A.Weighted locally linear embedding for dimension reduction[J].Pattern Recognition,2009,42(5):798-811.

[22]DICK D R,ROBERT P W.Locally linear embedding for classification.PH-2002-01[R].Delft:Delft University of Technology,2002.

[23]OLGA K,OLEG O,PIETIKAINEN M.Incremental locally linear embedding[J].Pattern Recognition,2005,38(10):1764-1767.

[24]HE Xiaofei,CAI Deng,YAN Shuicheng,et al.Neighborhood preserving embedding[C]//Tenth IEEE International Conference on Computer Vision.Beijing,China,2005:1208-1213.

[25]文贵华,江丽君,文军.基于邻域优化的局部线性嵌入[J].系统仿真学报,2007,19(13):3119-3122.WEN Guihua,JIANG Lijun,WEN Jun.Locally linear embedding based on optimization of neighborhood[J].Journal of System Simulation,2007,19(13):3119-3122.

[26]李博,杨丹,雷明,等.基于近邻消息传递的自适应局部线性嵌入[J].光电子·激光,2010,21(5):772-778.LI Bo,YANG Dan,LEI Ming,et al.Adaptive locally linear embedding based on affinity propagation[J].Journal of Optoelectronics·Laser,2010,21(5):772-778.

[27]文贵华,江丽君,文军.邻域参数动态变化的局部线性嵌入[J].软件学报,2008,19(7):1666-1673.WEN Guihua,JIANG Lijun,WEN Jun.Dynamically determining neighborhood parameter for locally linear embedding[J].Journal of Software,2008,19(7):1666-1673.

[28]喻军,秦如新,邓乃扬.基于自适应最近邻的局部线性嵌入算法[J].控制工程,2006,13(5):469-470.YU Jun,QIN Ruxin,DENG Naiyang.Locally linear embedding algorithm based on adaptive nearest neighbor[J].Control Engineering of China,2006,13(5):469-470.

[29]惠康华,肖柏华,王春恒.基于自适应近邻参数的局部线性嵌入[J].模式识别与人工智能,2010,23(6):842-846.HUI Kanghua,XIAO Baihu,WANG Chunheng.Self-regulation of neighbourhood parameter for loally linear embedding[J].Pattern Recognition and Artificial Intelligence,2010,23(6):842-846.

[30]张育林,庄健,王娜,等.一种自适应局部线性嵌入与谱聚类融合的故障诊断方法[J].西安交通大学学报,2010,44(1):77-82.ZHANG Yulin,ZHUANG Jian,WANG Na,et al.Fusion of adaptive local linear embedding and spectral clustering algorithm with application to fault diagnosis[J].Journal of Xi'an Jiaotong University,2010,44(1):77-82.

[31]SAUL L K,ROWEIS S T.Think globally,fit locally:unsupervised learning of low dimensional manifolds[J].Journal ofMachineLearningResearch, 2004,4(2):119-155.

[32]YANG B,CHEN S C.Sample-dependent graph construction with application to dimensionality reduction[J].Neurocomputing,2010,74(1):301-314.