仿人面部表情机器人 SHFR-1样机

2011-10-20柯显信唐文彬陈玉亮杨晓晨

柯显信, 唐文彬, 陈玉亮, 杨晓晨

(上海大学机电工程与自动化学院,上海 200072)

仿人面部表情机器人 SHFR-1样机

柯显信, 唐文彬, 陈玉亮, 杨晓晨

(上海大学机电工程与自动化学院,上海 200072)

通过对人类实现不同面部表情时脸部肌肉运动情况的分析,设计仿人面部表情机器人的运动机构和控制系统.在仿真环境下,对所设计的虚拟样机进行运动分析,以所得到的数据为依据,研制仿人面部表情机器人样机SHFR-1.在 SHFR-1机器人上进行面部表情演示实验,结果表明,该样机可以较好地实现高兴、悲伤、惊讶、害怕、愤怒和厌恶等 6种人类基本表情.

仿人面部表情机器人;面部表情;样机

上海大学从 2007年开始进行仿人面部表情机器人的技术研究,并在 UGNX 4.0仿真环境中进行了虚拟样机的设计[8].本研究在此基础上研制了仿人面部表情机器人 SHFR-1的样机.在表情实验中,这台机器人能较好地实现高兴、悲伤、惊讶、害怕、愤怒和厌恶等 6种基本表情.与国内外同类机器人相比,本研究所设计的机器人具有内部结构简单、空间利用率大、易于控制、重量较轻且成本低廉等特点.

1 机器人机构设计

1.1 设计要求

根据面部表情编码系统 (facial action coding system,FACS)理论,人类面部共有 44个运动单元(action units,AU),其中 14个控制基本表情的 AU组可以产生近 55 000种不同的表情,但基本可以分为 6种表情:高兴、悲伤、惊讶、害怕、愤怒和厌恶[9].通过对这 6种表情进行运动分析,可得到眉毛、眼睑、眼睛和下颌这 4个主要产生表情的运动模块.这4个运动模块总共包含了 11个自由度,通过这些自由度的组合,可获得上述 6种基本表情.

1.2 运动机构设计

为了更加简便地实现这 6种基本表情,本研究对 4个主要的运动模块所具有的 11个自由度进行简化设计.眉毛模块具有 4个自由度,在不影响机器人运动效果的前提下将其简化至 1个自由度,让眉毛由舵机直接驱动并绕旋转中心转动.由于眼睑对于人类面部表情有重要作用,将眼睑运动简化为与眼睛水平同轴转动的 1个自由度.眼睛是最为重要的面部器官,本研究将双眼考虑为同步同方向运动,使得眼睛机构能以 2个自由度实现所需的运动要求.采用 1个曲柄滑块机构实现眼球的垂直方向运动,以 1个导轨滑块机构实现眼球的左右转动.下颌模块与眉毛模块一样由 4个自由度简化至 1个自由度,以双摇杆机构带动下颌上下转动,实现机器人嘴部的开闭.最终通过对自由度的优化,达到了用 7个自由度实现 6种基本面部表情动作的自由度简化目标.

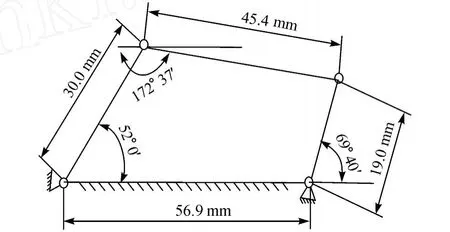

本研究采用矢量环解法[10]进行机构的位移解析计算.以眼球水平转动为例,眼球左右水平转动具有 2个自由度,将双眼左右水平转动考虑为同步同方向运动,则整个眼球左右水平转动机构只有 1个自由度.绕水平方向的转动采用双摇杆机构,如图 1所示.位置矢量环如图 2所示.

图 1 眼球水平转动机构Fig.1 M echan ism for the hor izon tal m otion of eyeball

图 2 眼球水平转动机构位置矢量环Fig.2 Position vector loop of the m echan ism for the hor izontalmotion of eyeball

定义机构位置为绕机构产生一个矢量环,该矢量环是自封闭的,使得绕环矢量总和为零.已知的矢量长度即为构件的长度,即

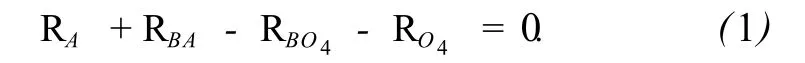

接着,对每个位置矢量代入复数表示符号,将式 (1)转变为

式 (2)中有 4个未知数,即构件的 4个角度.构件 1的角度值为固定值,θ2为独立变量,由舵机控制.采用欧拉恒等式对θ3和θ4两个未知量进行求解,得到所求未知量的解为

随后,建立速度矢量图 (见图 3),通过矢量方程求得眼球水平运动速度与舵机角度位移的关系为

在Matlab中建立数学模型,计算结果如图 4所示,可见眼部水平转动速度随舵机角度位移的变大而变大.

图 3 眼球水平转动机构速度矢量图Fig.3 Velocity vector of themechan ism for the hor izontal motion of eyeball

图 4 眼球水平速度变化图Fig.4 Eyeball hor izontal velocity var iation

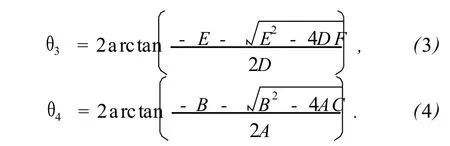

1.3 机器人机械结构设计

整个机器人样机采用了大量的通用标准件,其中连杆组件采用了关节轴承,不仅结构简单,长度可调节,而且可避免空间上的转动误差.眼睛上下转动和下颌转动都直接选择了带座轴承,4个运动模块在空间上布置合理,尺寸比例与人类接近.机器人后半部留有大量空间,预留空间将达到整体空间的50%,同时嘴部上方也留下了方形空间.图 5所示为在UGNX 4.0中建立的 SHFR-1机器人虚拟样机.

图 5 在 UGNX 4.0中建立的 SHFR-1机器人虚拟样机Fig.5 Vir tual prototype of SHFR-1in UGNX 4.0

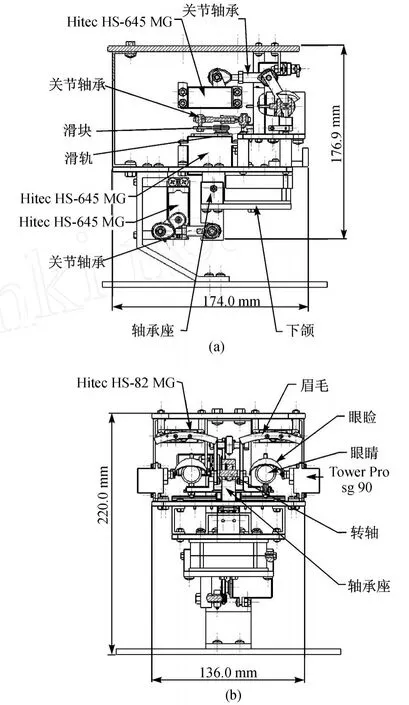

2 机器人控制系统设计

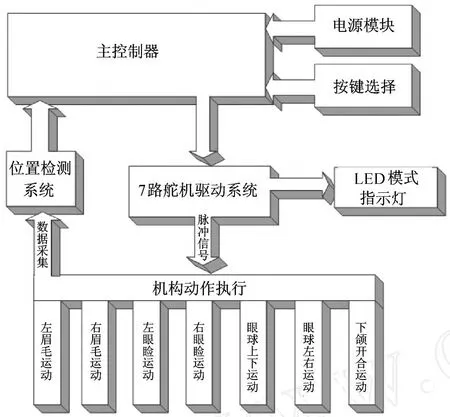

仿人面部表情机器人由机构本体、控制系统、舵机驱动系统和传感检测系统等组成.控制系统对机器人发出表情指令,通过舵机系统驱动机器人的各个机构运动,再由传感检测系统检测实际运动情况并修正,实现所需的面部表情.图 6所示为机器人控制系统框图.

2.1 控制系统硬件结构设计

为了使机器人易于控制和降低成本,本研究的机器人控制系统采用以单片机为控制核心的控制系统硬件结构.样机使用 AT89S52单片机,该单片机是一种低功耗、高性能且系统内带 8 kB可编程 Flash存储器的 8位 CMOS微处理器,灵活性较高,只需花费有限资源就可产生多个嵌入式控制的高性能微处理器.

图 6 SHFR-1机器人控制系统框图Fig.6 Con trol system of SHFR-1

机器人使用舵机作为驱动电机.舵机使用易于控制的脉冲宽度调制(pulsewidthmodulation,PWM)信号作为控制信号,适用于需要角度不断变化并可以保持的机构,而且由于内置多级减速,从而能以较小的体积产生较大的扭矩.

机器人采用 7路舵机联动控制,实现了机器人的 6种基本面部表情.多路舵机的控制方法可以采用单片机分时控制,单片机串行地从一个 I/O端输出多个舵机的控制信号,并装载整个机器人的步态数组.使用这种方法对单片机的速度要求不高,普通的 8051单片机使用 8 MHz频率的晶振就足以满足速度要求,并且编程也比较容易.控制系统采用分时控制方式实现 7路 PWM输出,控制舵机驱动机器人连续实现几种基本表情.

2.2 控制系统软件结构设计

机器人的控制系统软件设计采用了整体结构化的设计方法,编制了功能实现函数,利用函数参数传递的方法,实现系统功能.这样的设计方法简化了软件调试,并为将来的系统功能拓展提供了便利.软件调试工具采用 KeiluVision3集成开发环境,程序设计语言采用 C语言[11].本样机所涉及的控制系统主要包括主程序模块、命令输入模块、系统运行模块、模式选择模块、脉冲发送及控制模块等功能模块.

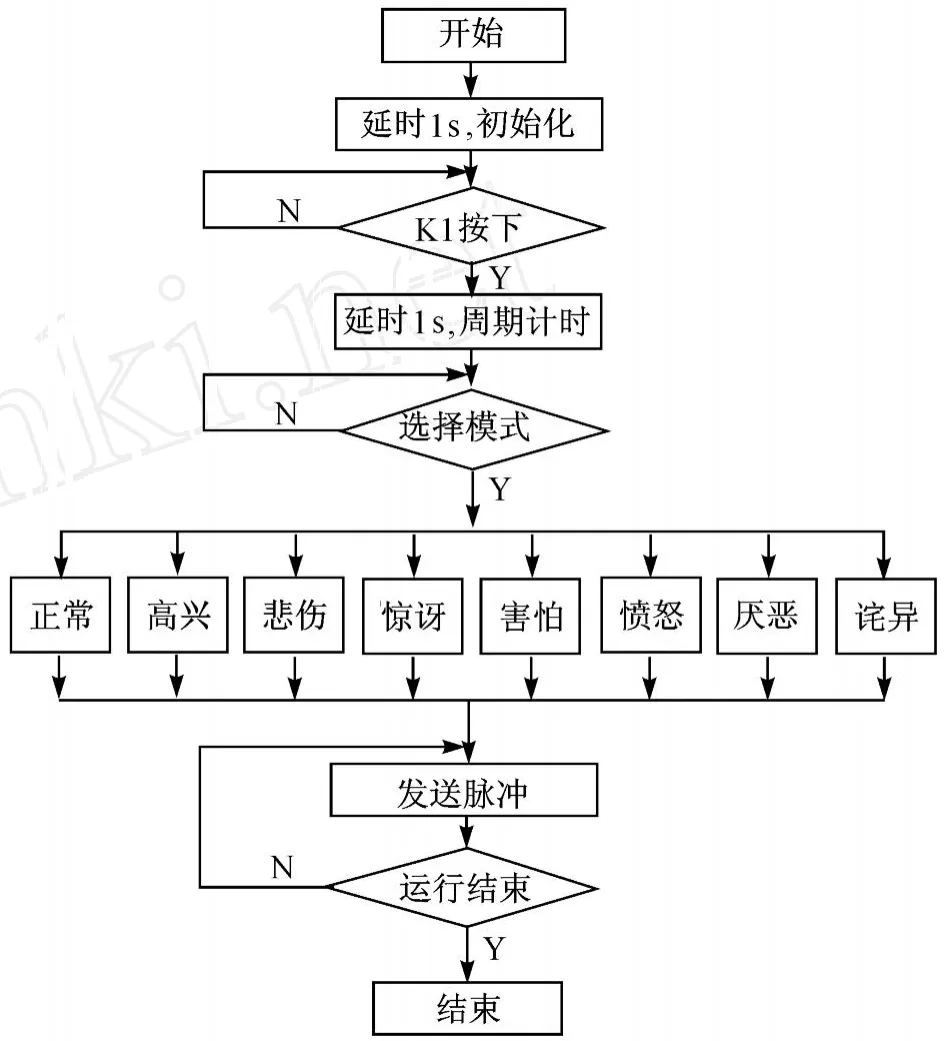

图 7为系统主程序流程图.当控制器开始运行后,延时 1 s等待系统运行命令;程序启动,系统开始运行,程序初始化,7路 PWM脉冲 20 ms周期开始计时;再延时 1 s,等待选择模式.根据不同的模式,用脉冲控制程序进行运算并通过脉冲输出程序开始输出脉冲,舵机接收脉冲信号驱动各运动执行机构,使得机器人开始执行动作.若接收到系统停止命令,则机器人在动作复位后,关闭系统.

图 7 系统主程序流程图Fig.7 Flow char t of ma in program

3 机器人样机研制

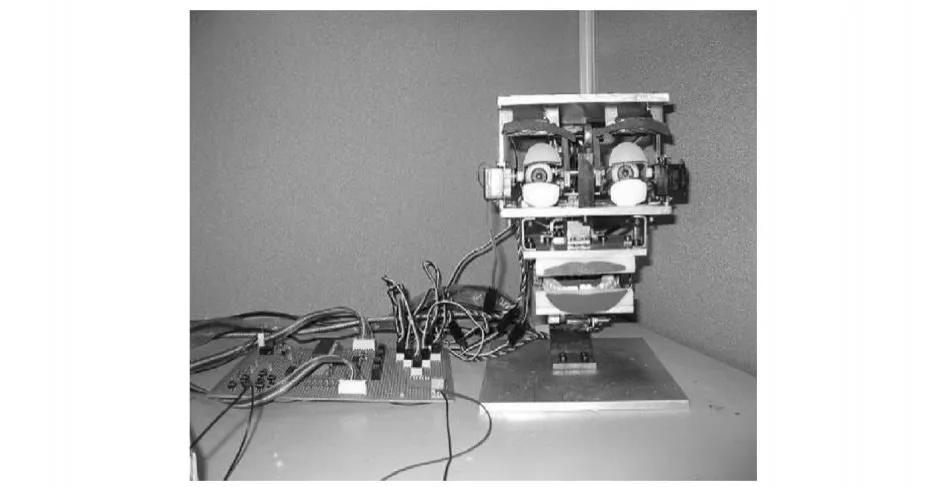

本研究研制的仿人面部表情机器人 SHFR-1样机,由机器人机械本体及控制系统组成.图 8所示为机器人样机机械本体和单片机控制系统.控制板由2个电源分别给单片机模块和舵机驱动模块供电.样机中眉毛、眼睑、眼睛机构只占用样机的 1/4空间,下颌机构只占用不到 1/4的空间.样机预留了眼部与下颌间、下颌后半部、机器人后半部大量空间,达到了预期结构设计要求.

图 8 机器人 SHFR-1样机Fig.8 Prototype of SHFR-1 robot

4 仿人表情实验

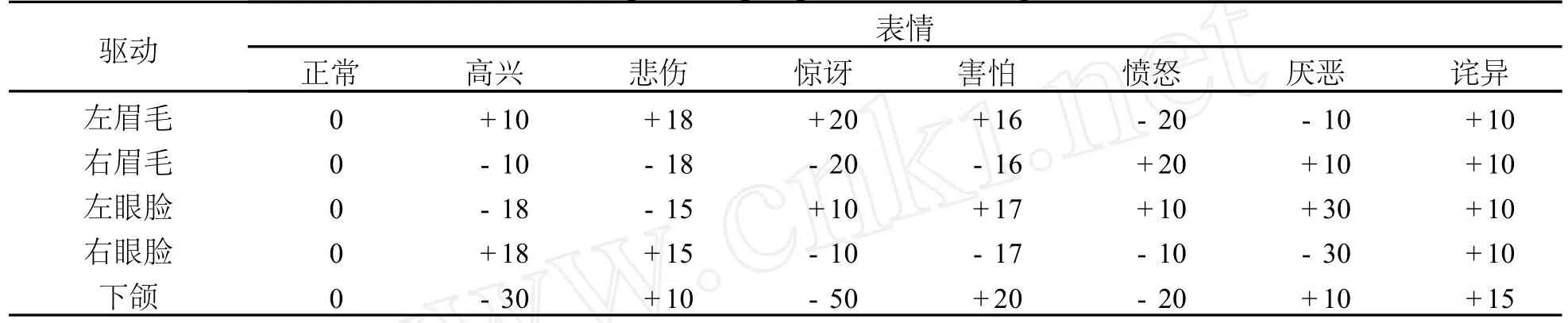

仿人面部表情机器人样机实验系统由面部表情机器人本体、控制板、电源、舵机和控制系统软件组成.采用 FACS理论对人类不同面部表情进行分析,获得了实现各表情时的运动数据.根据这些实验数据,首先在 UGNX 4.0仿真环境下进行仿真实现,并对数据及运动部件运动状况进行校核,得到机构运动数据 (见表1).

表1 运动仿真模块下不同表情的铰链驱动角度表Table 1 Hinge dr iving angle of d ifferent expressions (°)

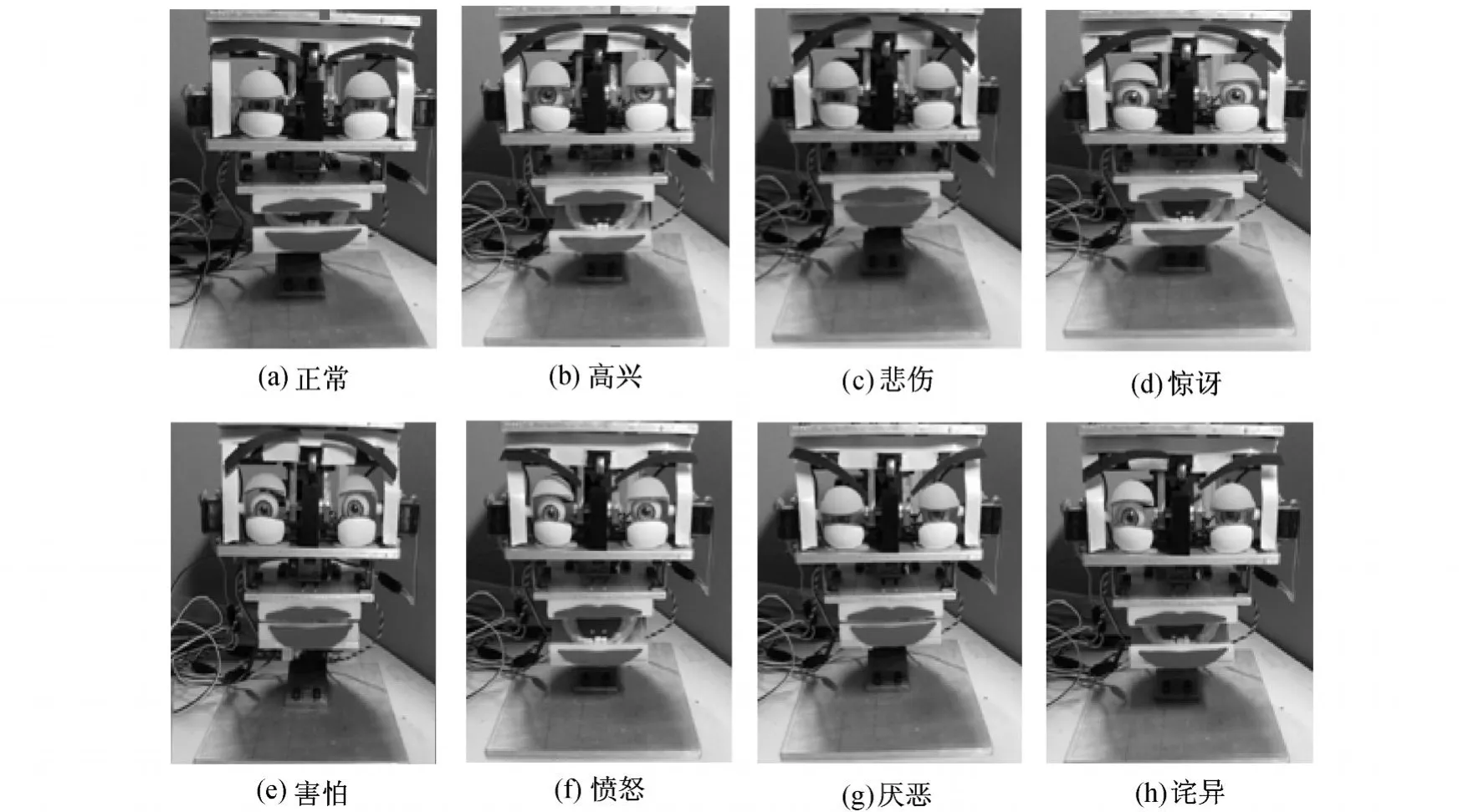

随后在机器人样机上进行表情实验 (见图 9).首先实验单个运动机构的动作,并在此基础上对各机构运动进行联动,得到了高兴、悲伤、惊讶、害怕、愤怒和厌恶 6种基本面部表情.在此基础上又实验了一个个性表情“诧异”(见图 9(h)),表明本机器人可以在实现 6种基本面部表情的基础上实现更为丰富的面部表情.在实验中,机器人各动作运动平稳,实现了控制系统速度微分功能.机构完成各目标动作与表情的时间都在 1s以内,虽然比人体肌肉的运动速度稍慢,但能够成功表达这几种表情.

图 9 各种表情实验Fig.9 Expression exper iments

5 结 束 语

本研究以舵机作为驱动器,采用独特的结构设计,以连杆组件作为执行机构构成了机器人的 4个主要运动模块,并以单片机 AT89S52为控制系统的核心,研制了仿人面部表情机器人 SHFR-1样机.通过实验验证,本样机基本达到了预期目标,能较好地实现 6种基本面部表情及 1个个性表情.机器人样机不仅结构简单、控制简便、空间利用合理,并且成本低廉,但在表情拟人化、细腻化及机器人的响应速度方面需要作进一步的研究.本研究特地为面部AU控制机构和传感器预留了大量空间,并可装配上仿人表皮材料.下一步研究重点在于使机器人样机能表现出更丰富逼真的表情,并加装如视觉模块等系统,使得样机可以更好地与人进行情感交流.

[1] HASHIMOTO T,HTIRAMATSU S,TSUJI T,et al.Development of the face robot SAYA for rich facial exp ressions[C]∥ SICE-ICASE International Joint Conference.2006:5423-5428.

[2] BERNS K.Control of facial expressions of the humanoid robot head ROMAN[C]∥Proceedings of the 2006 IEEE/RSJ International Conference on Intelligent Robots and Systems.2006:3119-3124.

[3] BREAZEAL C,EDSINGER A,FITZPATRICK P,et al.Active vision for sociable robots[J].IEEE Transactions on Systems,Man,and Cybernetic,2001,31(5):443-453.

[4] BREAZEAL C.Robot in society:friend or aliance[C]∥Proceedings of the 1999 Autonomous Agents Workshop on Emotion-Based Agent Architectures.1999:18-26.

[5] WU W G,MEN Q M,WANG Y.Development of the humanoid head portrait robot system with flexible face and expression[C]∥Proceedings of the 2004 IEEE International Conference on Robotics and Biomimetics.2004:757-762.

[6] 鹿麒,吴伟国,孟庆梅.具有视觉及面部表情的仿人头像机器人系统设计与研制 [J].机械设计,2007,24(7):20-24.

[7] 吴伟国,宋策,孟庆梅.仿人头像机器人“H&Frobot-Ⅲ”语音及口形系统研制与实验[J].机械设计,2008,25(1):15-19.

[8] 柏垠,柯显信,唐文彬.基于舵机驱动的一种仿人面部表情机器人的结构设计 [J].机电一体化,2009,9(8):55-58.

[9] EKMAN P,ROSENBERG E L.What the face reveals:basic and applied studiesof spontaneous exp ression using the facial action coding system(FACS)[M].2nd ed.New York:Oxford University Press,2005.

[10] 陈力周,韩建友,李威,等.机械设计:机械和机构综合分析[M].北京:机械工业出版社,2002:155-252.

[11] 尹勇,李宇.uVision2单片机应用程序开发指南[M].北京:科学出版社,2004.

Prototype of Humanoid Facial Robot SHFR-1

KE Xian-xin, TANGWen-bin, CHEN Yu-liang, YANGXiao-chen

(School of Mechatronics Engineering and Automation,ShanghaiUniversity,Shanghai200072,China)

By analyzing the facial expression and motion of facial muscles,the mechanism and control systemsof a facial robot are designed.Themechanism and motion of the corresponding virtual prototype are analyzed.A facial robot SHFR-1 is developed based on the results of the analysis.Experimental resultsof facial expressions show that SHFR-1 can exp ress six basic expressions:happiness,sadness,surprise,fear,anger and disgust.

facial robot;facial expression;prototype

TP 242.6

A

1007-2861(2011)01-0079-06

10.3969/j.issn.1007-2861.2011.01.013

2009-07-07

上海市教委基金资助项目(17023);上海大学重点学科建设快速反应基金资助项目(Y0102-1-KS09)

柯显信 (1973~),男,讲师,博士,研究方向为仿人机器人、机器人情感和人机交互.E-mail:xxke@shu.edu.cn

(编辑:刘志强)

20世纪以来,随着经济和科技的高速发展,机器人已逐渐走出工厂进入人类生活,其中以能与人类实现交互的仿人机器人最为引人注目.欧美及日韩等国开展仿人面部表情机器人的研究工作较早.日本作为机器人大国,在高仿真度的仿人机器人研究领域处于领先地位,如小林弘研制出了世界上第一个能够上课的仿人机器人“佐屋”.“佐屋”是在小林弘等[1]所研制的仿人机器人“SAYA”的基础上开发出来的.2007年,韩国制造技术研究所 (KITECH)展出的“夏娃”系列机器人,具有极高的仿真度、丰富的面部表情和灵活的行动力.由 Berns等[2]所研制的表情机器人“ROMAN”不仅具有复杂的头部机构,可以在传感系统的辅助下在不同的环境中实现不同的面部表情,而且在外形上酷似真人.Breazeal等[3-4]研发了可以和人类进行视觉交流的机器人“Kismet”,该机器人拥有与人类类似的面部表情特征,可以根据人的动作和表情表达出自己的喜怒哀乐,还能做出与人类接近的手势,甚至是耸肩、扭屁股之类的情感动作.

在国内,仿人面部表情机器人的研究还处于起步阶段.由邹人倜制造的硅橡胶高仿真机器人,需要79道制作工序,材料使用了真人胡须、头发等,颈部等关节运用转动机构实现人机交互,被美国《时代》周刊评为“2006年最佳发明”.吴伟国等[5]在 2004年研制出了仿人面部表情机器人“H&Frobo-Ⅰ”,并制作了面部表皮,加入了心理模型系统.2007年,吴伟国等[6]在“H&Frobo-Ⅰ”的基础上,研发了带有基于神经网络方法的人类面部基本表情的视觉识别系统机器人“H&Frobo-Ⅱ”,并于 2008年又为其加入了口形系统[7].