基于FTV的改进深度估计算法✴

2011-06-28陈玉峰牛庆高王静赵贵喜

陈玉峰,牛庆高,王静,赵贵喜

(1.解放军93163部队航空理论教研室,哈尔滨150001;2.齐鲁师范学院生物科学与技术系,济南250013)

基于FTV的改进深度估计算法✴

陈玉峰1,牛庆高1,王静2,赵贵喜1

(1.解放军93163部队航空理论教研室,哈尔滨150001;2.齐鲁师范学院生物科学与技术系,济南250013)

深度估计是任意视点电视(Free View Television,FTV)系统的关键技术。为提高深度边缘的深度估计准确度,并解决视频序列中不同帧间同一深度物体深度估计值不一致问题,提出一种在深度图的时间一致性保持算法,以前一帧的深度图与当前视图的运动信息为约束条件估计当前帧的深度,使得相邻帧的深度图在时间上保持一致。

任意视点电视;深度/视差估计;深度图时间一致性;平均亮度-梯度匹配

1 引言

2002年MPEG会议中提出了任意视点电视(Free View Television,FTV)[1]系统,它能够提供一种全新的、生动的、真实的、交互式[2]的三维视听系统,该系统可广泛应用于广播通信、娱乐、教育、医疗、视频监控等领域。FTV的一项关键技术就是如何获得准确的深度信息。目前,深度信息的获取方法有两种,一种采用深度摄像机直接获得深度信息,深度摄像机采集速度比较慢,深度数据与视频数据的采集需要同步调整,并且深度摄像机对室外场景的采集效果不够理想;另一种通过立体匹配从不同空间位置采集得到的立体图像对中计算场景深度信息,它根据相邻两摄像机拍摄的左右两视图寻找场景中同一点在这两个视图中对应的投射位置,该方法适用于室内外各种类型场景,成本较低,易实现。其中基于graph cuts的深度估计算法[4],引入了亚像素、四分之一像素的搜索机制[5]。为了估计视点间遮挡区域的深度,采用左中右3个视点位置的视图估计中间视点的深度图。但是深度估计的准确度尤其是深度边缘的准确度仍然需要进一步提高[6]。因此本文基于FTV-AHG采用的graph cuts的深度估计算法提出一种保持深度边缘深度估计准确度并保持深度图时间一致性的深度估计算法。

2 深度边缘与时间一致性保持方法

2.1 Graph cuts算法介绍

Graph cuts[4]是一种全局匹配算法,即它并不是逐个像素地计算深度,而是将整个视图的深度估计过程模型化为求解能量目标函数全局最小值的问题,继而同时估计出视图中所有像素的深度。首先依据某种测度函数构造式(1)所示的能量函数,然后采用图论中的最大流-最小割(max flow-min cut)[3,7]算法能量目标函数的最小值,从而为每个像素节点分配最优或接近最优的视差。

式中,I(x,y)表示当前视图(x,y)位置处像素p的亮度值,Iref(x-d,y)表示在视差为d时参考视图中的匹配像素的亮度值,disp(x,y)与disp(xN,yN)分别表示本次迭代中(x,y)位置处像素p的视差与其上下左右邻近像素的视差,w、h分别表示图像的宽度与高度。Edata与Esmooth分别表示在预选视差下对应像素间实际匹配程度(以绝对亮度差作为测度函数)以及相邻像素深度值(视差)之间的一致程度。

2.2 深度图时间一致性保持

以往的深度估计算法只关注深度图在空间上的准确度,然而FTV系统需要多个视点的视图在一段时间内的所有图像的深度信息。理论上,不同帧间同一深度物体的深度估计值应该是相同的,但由于深度估计算法对光照条件随时间的变化不够稳健,使得该物体的深度估计结果随时间的变化而变化,进而导致合成的虚拟视图的主客观质量随时间有明显的波动。为保持深度图在时间上的一致性,在估计当前视图当前帧的深度时,显然要考虑其前一帧的深度图,从而抑制深度图随时间的变化。但是对于运动物体而言,其真实深度在不同时刻有可能是变化的,尤其是运动遮挡与运动暴露区域,其在不同时刻的真实深度势必变化,如图1所示,图中圈注区域为运动遮挡区域,该区域在相邻帧的真实深度势必是变化的,因此在保持深度图时间一致性的同时需要考虑时间上相邻帧的运动信息。

图1 运动遮挡区域Fig.1 Areamasked bymotion

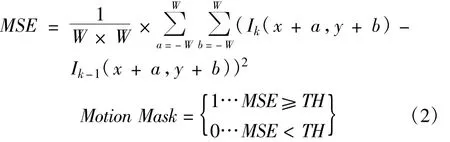

本文提出基于运动信息的深度图时间一致性保持算法(Motion Based Temporal Consistency Preserving,MBTCP)。首先采用式(2)进行运动检测,计算以当前像素为中心的区域(窗口)以及前一帧对应区域的均方差准则(MSE)。若MSE大于门限TH,就将当前像素判断为运动像素,并标记为“1”,否则判断为静止像素并标记为“0”,进而得到当前视图当前帧相对前一帧的运动掩膜(Motion Mask)。

式中,W表示以当前像素为中心的窗口的大小,Ik(x+a,y+b)表示该窗口内各个像素的亮度值,Ik-1(x+a,y+b)表示前一帧中对应区域内各个像素的亮度值。

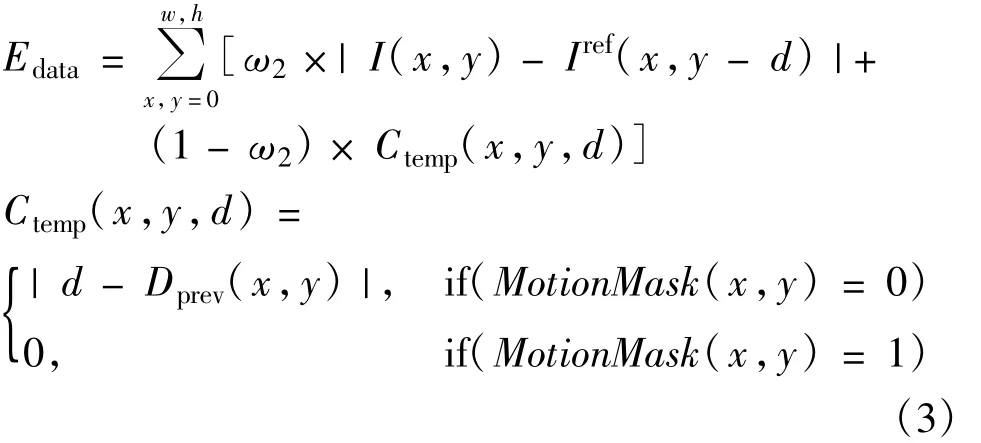

计算测度函数Edata时,对静止区域的像素(运动掩膜中标记为“0”的像素)增加惩罚因子Ctemp(x,y,d),用来抑制相邻两帧深度值的变化,如式(3)所示:

式中,Dprev(x,y)表示当前像素(x,y)在前一帧对应位置处的深度值;ω2为加权因子表示前一帧的深度值对当前帧深度值的影响,ω2越大,前一帧的深度值对当前帧深度值的影响越小。对于静止像素,ω2通常选为0.5。

3 实验

本文算法目的在于保持深度边缘的深度估计准确度并保持深度图的时间一致性,因此这里将深度边缘保持算法与时间一致性保持算法结合,采用式(4)作为测度函数Edata:

式中,ALGME与Ctemp(x,y,d)分别表示平均亮度-梯度匹配误差与时间惩罚因子,式(1)作为graph cuts的能量目标函数进行深度估计,并将估计的深度图与目前FTV-AHG提供的深度估计参考软件估计的深度图进行比较。为了便于说明,将本文算法称为ALGME-MBTCP,将FTV-AHG采用的graph cuts算法称为FTV-DE2.2。

为了比较深度图的准确度,分别采用ALGMEMBTCP与FTV-DE2.2估计FTV-AHG提供的标准测试序列的深度图,并采用该深度图合成虚拟视点的视图,比较虚拟视图的主客观质量,进而比较深度图的准确度。

图2为FTV-DE2.2与ALGME-MBTCP估计所得时间上相邻四帧的深度图,图2(a)、(b)、(c)、(d)分别为采用FTV-DE2.2s估计的第3视点第6、7、8、9帧的深度图,图2(e)、(f)、(g)、(h)分别为采用ALGME-MBTCP估计的第3视点第6、7、8、9帧的深度图。从图中可以看出图2(a)、(b)、(c)、(d)中深度图随时间变化很大,但是在图2(e)、(f)、(g)、(h)中深度图随时间变化很小。

图2 深度图时间一致性结果比较Fig.2 Comparison of the time consistency of the depth chart

图3 比较了采用两种算法估计的深度图合成的虚拟视图的主观质量。图3(a)、(b)与(c)、(d)分别为采用FTV-DE2.2与ALGME-MBTCP估计的深度图合成的第4视点虚拟视图的第6、第7两帧。从图3可以看出相比FTV-DE2.2,采用ALGMEMBTCP估计的深度图合成的虚拟视图的主观质量随时间的变化很小。

为了说明在保持时间一致性时运动信息的作用,将运动掩膜全部标记为“1”,即不考虑运动信息,然后进行深度估计。图4为在考虑运动信息与不考虑运动信息的情况下估计所得的深度图。从图4可以看出,在考虑运动信息的情况下,运动遮挡区域的深度更加准确。图5为分别采用图4(a)、(b)与(c)、(d)合成的虚拟视图。从图5可以看出,考虑到运动信息时,合成的虚拟视图在运动遮挡区域的主观质量更高。

图3 虚拟视图主观质量随时间的波动Fig.3 Fluctuations over time of the subjective quality of virtual view

图4 运动遮挡区域深度比较Fig.4 Depth comparison of sports blocked area

图5 合成虚拟视图比较Fig.5 Comparison of synthesized virtual view

对多个测试序列的实验结果表明,较FTV-DE2.2算法,采用ALGME-MBTCP算法估计的深度图合成的虚拟视图的客观质量PSNR更高,平均高出0.21 dB。

4 结论

针对FTV系统的需求,本文提出了基于graph cuts的深度边缘与时间一致性的保持算法。提出了一种新的测度函数,采用平均亮度-梯度联合匹配代替单像素亮度匹配,保持深度边缘的准确度;提出了基于运动信息的时间一致性保持算法,在考虑相邻两帧的运动信息的情况下,采用前一帧的深度值约束当前帧的深度值,抑制深度图随时间的变化。实验结果表明,本文的算法对深度边缘的准确度有很大提高,同时也有效地保持了深度图在时间上的一致性。

[1]Tanimoto M,Fujii T.FTV—free viewpoint television[R]. MPEG-M8595.Kaernten:Klagenfurt,2002.

[2]Smolic A,Yamashita R.Reporton Statusof3DAV Exploration[R]//ISO/IEC JTC1/SC29/WG11 N5416.Awaji,Japan:[s.n],2002.

[3]MPEG.Preliminary FTVModeland Requirements[EB/OL].(2007-07-07)[2008-06-15]http://wg11.sc29.org/mpeg/docs/81/causanne/wgll/wq168.zip..

[4]Boykov Y,Veksler O,Zabih R.Fast approximate energy minimization via graph cuts[J].IEEETransactions on Pattern Analysis and Machine Intelligence,2001,23(11):1222-1239.

[5]ISO/IEC JTC1/SC29/WG11 M15584,Experimental Results on Depth Estimation and View Synthesiswith sub-pixel precision[S].

[6]ISO/IEC JTC1/SC29/WG1 M15648,EE results on Leavinglaptop[S].

[7]ISO/IECJTC1/SC29/WG11 M15594,Enhancement of Temporal Consistency forMulti-view Depth Map Estimation[S].

An Im proved Depth Estimation Algorithm Based on FTV

CHEN Yu-feng1,NIYQing-gao1,WANG Jing2,ZHAO Gui-xi1

(1.Aviation Theory Teaching and Research Section,Unit93163 of PLA,Harbin 150001,China;2.Department of Biological Science and Technology,Qilu Normal University,Jinan 250013,China)

Depth estimation is one of the key technologies of FTV(Free View Television)system.To increase depth accuracy,a depth estimation method which can preserve temporal consistency is proposed.For current view,depth values of the previous frame and motion information between current frame and its previous frame are used as constraint conditions to estimate depthmap of current frame,thus preserving temporal consistency of depth maps in the two successive frames.Experiment results show thatnotonly accuracy of depth edges in depth maps is increased,but also temporal consistency of depthmaps is preserved well.

free view television;depth/disparity estimation;temporal consistency of depth map;average luminance-gradientmatching

the Ph.D.degree in 2008.He is now an associate professor.His research interests include image processing and aviation communication.

1001-893X(2011)09-0055-04

2011-03-03;

2011-06-30

TN941.4

A

10.3969/j.issn.1001-893x.2011.09.011

陈玉峰(1969—),男,黑龙江哈尔滨人,2008年获工学博士学位,现为副教授,主要研究方向为图像处理和航空通信。

Email:harbincyf@163.com

CHEN Yu-feng was born in Harbin,Heilongjiang Province,in 1969.He