遥感图像融合技术在潮间带地形提取中的应用

2011-01-31余连生李智勇文贡坚

余连生,李智勇,文贡坚,杜 春

国防科学技术大学电子科学与工程学院,湖南长沙410073

1 引 言

对于有潮海域,以海岸线和零米等深线为界,海岸线以上称为潮上带,零米等深线以下至30 m等深线处称为潮下带,两者之间,即海岸线与零米等深线之间的地带就称为潮间带。潮间带地区是海洋环境监测、近海养殖业、风电场建设的重点区域,同时也是军事研究的重要地带,因此,对潮间带地形的全面掌握具有重大的民用价值和军事意义。由于大部分潮间带地区无法直接测量或测量难度较大,因此潮间带的地形资料非常缺乏,海图上大部分潮间带的地形资料甚至是空白的[1]。目前潮间带地形的提取,主要是通过选取不同时期大量的不同潮位的卫星遥感图像来提取潮间带的遥感淹水线,结合数值模式进一步推算[1-2]。这种方法不但需要有大量不同时期的卫星影像支持,而且由于海平面容易受诸如潮汐、大气压变化、温室效应以及大气海洋的相互作用而变化[3],海岸线也受水蚀等因素影响而不断变化,因此可能会带来较大的偏差。同时推算的结果只是潮间带的高程和大概轮廓,并不能真实显示潮间带的具体地形地物特征。

综合利用不同平台遥感卫星对有潮海域同一潮汐周期不同时相的成像图像,能更好地获取到潮间带、海岸线等地形特征。其中,SAR可以全天时、全天候地观测目标,便于在光学传感器无法成像的时间段获取到潮间带的地貌特征,同时还可以从图像中反映出不同地形地物的差别和地势的高低。而全色遥感图像具有较高的空间分辨率,可以获取到海岸线附近地物目标的清晰轮廓信息,便于识别判读,与SAR图像之间可以实现较好的信息互补。

目前,SAR与全色图像的融合算法主要都是基于小波变换域方法进行。文献[4]提出的融合方法基于二维离散小波的Mallat算法,融合效果与加权融合方法的效果相当。文献[5]提出用átrous小波分解算法,添加全色图像的细节特征到SAR图像中去,但完全忽略了全色图像的低频信息。文献[6—7]分别利用脊波变换(ridgelet)和曲波变换(curvelet)实现了SAR图像与全色图像的融合,采取低频高频都取大的融合规则,在保持全色图像信息的同时,添加了SAR图像中的重要目标信息(特别亮的点或区域),但是这会遮盖一些比较暗的边缘、纹理等信息。

针对上述算法存在的不足,本文将平移不变离散小波变换(shift-invariant discrete wavelet transform,SIDWT)算法和新的融合规则应用于同一潮汐周期不同时相的海岸带地区SAR与全色遥感图像融合,得到了既能突出潮间带形状,又能突出海岸线特征的更高质量的图像,便于目视解译及后续处理,取得了较好的结果。

2 平移不变离散小波变换

针对本文的实际应用来说,由于待融合的SAR和光学图像等光谱差异较大,而且图像中地形差异明显,图像校正、配准难度较大,因此采取的融合方法是否具有平移不变性对融合结果影响较大[8],容易在融合结果中引入虚假信息,如振铃和混叠效应。

为了克服Mallat算法不具有平移不变性的不足,对图像进行小波变换时,需要将其分解为平移不变的小波表示,最直接的方法是计算输入图像在所有可能位移上的小波变换,如àtrous小波变换,但是其计算复杂度很高,而且并不必要[9]。文献[10]提出了一种过完备的小波分解方法——离散小波框架(discrete wavelet frame,DWF),来解决这一问题。基于此方法,文献[11]提出了平移不变离散小波变换(SIDWT)算法。

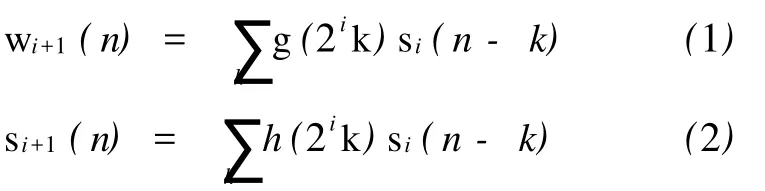

针对一维信号的情况,文献[11]中SIDWT的每一步运算都将输入信号分离为小波序列wi(n)和尺度序列si(n)

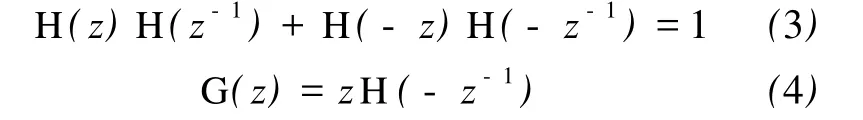

式中,si(n)作为下一层分解的输入信号,s0(n)= f(n),f(n)为输入信号。第 i层的低通滤波器h(2ik)和高通滤波器g(2ik)是通过在滤波器原型h(k)和 g(k)的序列间插入适量的0值得到的。其中,h(k)和 g(k)满足

式中,H(z),G(z)分别是 h(k),g(k)的 z变换。通过上述变换,构成了SIDWT的分解。对比标准的离散小波变换,由于舍弃了下采样,SIDWT算法导致了大量的冗余小波表示。因此,利用SIDWT算法对源图像进行 n层分解可得到一幅逼近图像(低频部分)和3n幅代表不同分辨率下细节信息的细节图像(高频部分),且每幅图像的尺寸大小均和源图像一样。

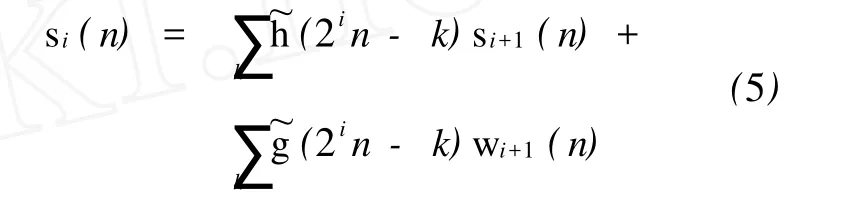

SIDWT的反变换(inverse SIDWT)是将上面得到的具有平移不变性的小波序列和尺度序列分别与相应的重建滤波器~h(2ik)和~g(2ik)进行卷积

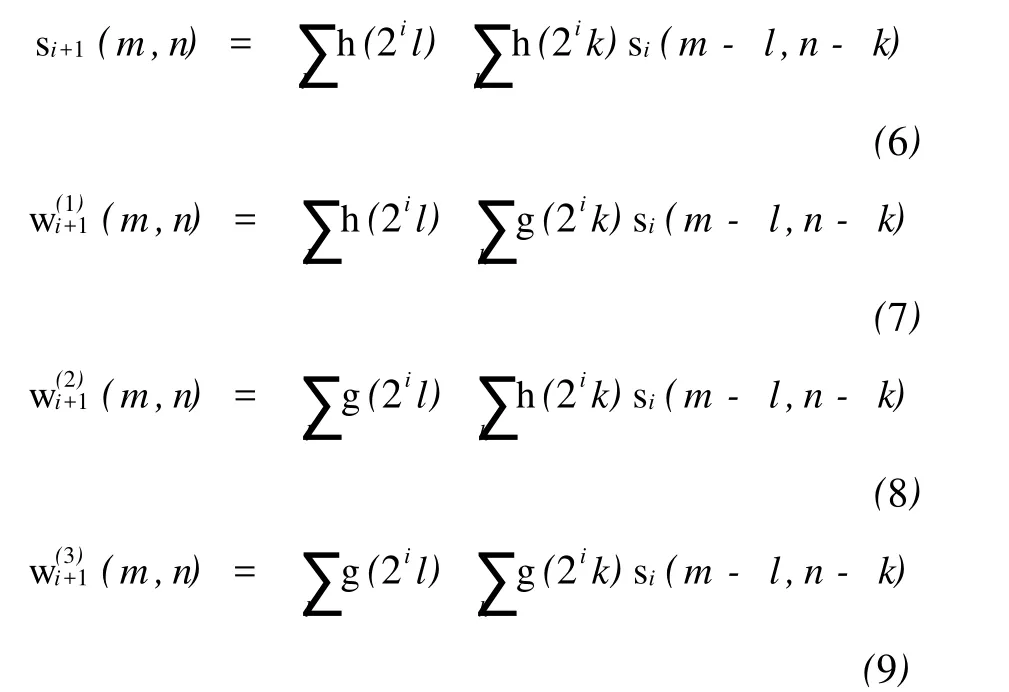

通过SIDWT的反变换,从而实现输入信号f(n)的重建。对于二维图像信号,其分解过程是上述一维信号流程分别在图像的行与列上所进行的处理过程

式中,s0(m,n)=f(m,n),f(m,n)为输入信号。描述二维图像每一层分解后的水平高频分量、垂直高频分量、对角高频分量,各自对应相应三个方向的小波序列。

综上所述,利用SIDWT算法进行融合的过程与利用离散小波变换相同:输入图像被分解成具有平移不变性的小波表示,然后通过一定融合规则得到融合后的小波表示,最后通过SIDWT的反变换得到最终融合图像。

本文将平移不变离散小波变换算法用于SAR与全色图像的融合,相应的小波基选择haar小波。这主要是因为haar小波计算简单,而且它是一切具有紧支集的规范正交小波基中唯一具有对称性(或反对称性)的[12],具有平移不变性。

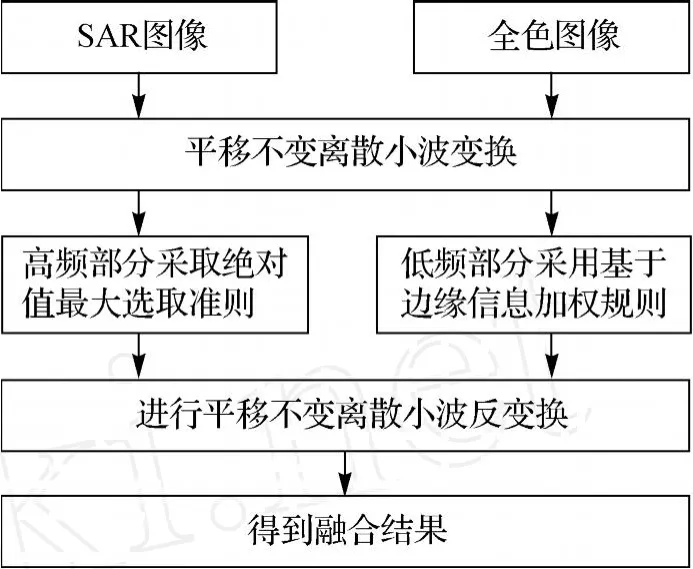

3 一种新的融合规则

相对全色图像来说,SAR图像的整体图像亮度较低,但对比度也较好。针对实际应用,本文的融合目的是既保留SAR与光学图像的边缘、轮廓、纹理等信息,又能在融合图像中添加SAR图像和光学图像所特有的地物特征描述,从而能够更好地确定潮间带特征,以便于后续的图像处理。

图像经过SIDWT分解后,得到的低频逼近图像包含了图像的基本轮廓、形状等大部分信息,高频部分则包含图像的边缘细节信息。结合融合目的,本文主要针对低频部分进行处理。在参考现有的相关算法[13-15]基础上,本文提出一种基于边缘信息的加权融合规则,具体实现如下:

首先,使用ROA算子对SAR图像进行边缘提取,用Canny算子对全色图像进行边缘提取,分别得到SAR与全色图像的边缘图像。然后,在下列四种可能存在的情况下进行逐像素点的比较:

(1)该像素点只是SAR图像的边缘点;

(2)该像素点只是全色图像PAN的边缘点;

(3)该像素点同时是两图像的边缘点;

(4)该像素点都不是两图像的边缘点。

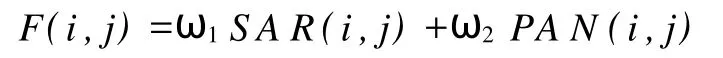

针对不同的情况,对SAR与全色图像经过SIDWT分解后的低频部分进行逐像素值的加权。设融合图像的低频图像像素值为

式中,(i,j)为图像中对应位置的像素值坐标;ω1, ω2分别为SAR与全色图像中的权值,满足ω1+ ω2=1。

依据实际应用,为了更好地突出边缘细节信息,并保持较好的图像对比度,基于如下原则选择权值:

对于情况1,为更好地添加SAR图像的特征信息,则SAR图像所占的比例较大,选择ω1= 0.75,ω2=0.25;

对于情况2,相应地,全色图像所占的比例较大,选择ω1=0.25,ω2=0.75;

对于情况3,则两者所占的比例相同,选择ω1=0.5,ω2=0.5;

对于情况4,由于一幅图像中非边缘点个数占绝大部分,为了能更好地保持SAR图像的特征,取ω1=0.75,ω2=0.25。

由于图像的边缘细节信息表现为SIDWT分解后高频部分中的绝对值较大的系数,因此,对于高频部分,采用基于绝对值最大准则进行融合。

得到新的低频部分和高频部分后,再通过平移不变离散小波反变换,最终得到融合结果。算法流程如图1所示。

图1 算法流程图Fig.1 Flow chart of the proposed method

4 试验结果及分析

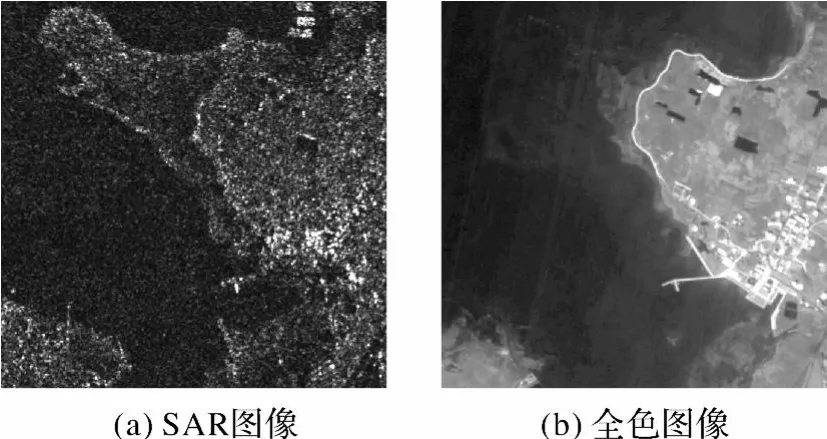

本文试验数据采用配准好的2007年10月18日拍摄的某岛屿的SAR和全色遥感图像,如图2所示。结合两幅图像的成像时间和该地区当天的气象资料可知,SAR图像中呈现的是晚上退潮后的情景,而全色图像则是反映了港口上午涨潮时刻情形。从图中可以明显看出该地区在不同时刻的地形差异。

图2 原始SAR与全色图像Fig.2 Original SAR and panchromatic images

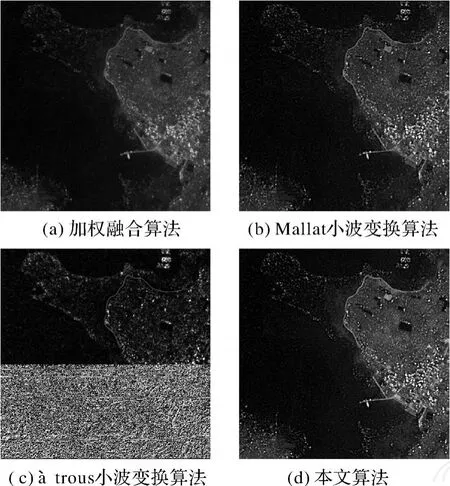

图3给出了基于不同方法的融合结果。作为对比,图3(a)是像素等比加权融合算法得到的融合结果,图3(b)为利用Mallat小波变换方法(小波基为Bior2.2小波)及本文融合规则得到的融合结果,图3(c)为利用àtrous小波变换方法[4]得到的融合结果,图3(d)为利用本文算法得到的融合结果。本试验中,后三种算法中的小波变换分解层数都是三层。

图3 融合结果图Fig.3 Fusion results

可以看出,各种算法都体现了潮间带和近岸地区的地形地貌,但是本文算法结果亮度较高,对比度也较好,潮间带、潮上带分界明显,目视解译可以很好地区分两者,同时还较好地实现了SAR图像与全色图像的地物信息互补,可以为绘制地图提供图像支持。其中,由于àtrous小波变换算法完全忽略了全色图像的低频信息,导致融合结果中光学特征丢失严重。

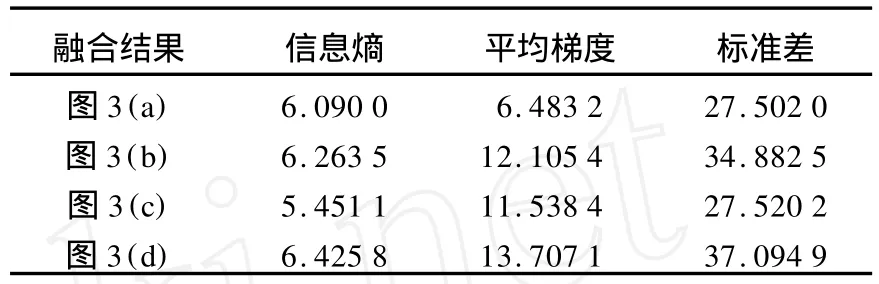

为了更客观地评价融合效果,本文采用信息熵、平均梯度、标准差等指标对融合图像进行评价。信息熵是衡量图像信息丰富程度的重要指标,信息熵越大,说明信息量增加得越多;平均梯度反映了图像中的微小细节反差和纹理变化等结构特征,同时也反映了图像的清晰度,其值越大,表示图像的清晰度越好;标准差反映了图像灰度值相对于平均值的离散状况,标准差越大,图像灰度级分布越分散,反差越大。

表1给出了不同融合算法的客观指标评价结果。可以看出,本文算法得到的图像熵值最大,清晰度也最高,标准差也最大,这与目视评价一致。综合所有评价指标,说明本文算法的效果最好。

5 结 论

为了消除潮汐和天气等因素的不良影响,更好地探测港口近岸地区及潮间带地区的地形地物等全面状况,本文利用同一天不同时相获取的同一地区的SAR与全色图像,基于两者之间较强的互补性,采用平移不变离散小波变换(SIDWT)算法和新的融合规则实现图像融合。从融合结果看,潮间带地形和近岸地区的地貌等较好地得到了综合、增强,在后续的目视解译中,更容易区分不同地形的特征,可以为绘制海图和电子海图提供支持,具有一定的应用意义。

表1 不同算法的客观指标评价结果Tab.1 Quantitative indices values of fusion results

[1] ZHAN G Wenjing,ZHU Shouxian,HUAN G Weigen. Application ofSatellite Remote Sensing Data to Storm Surge Flooding Calculation[J].Journal of PLA University of Science and Technology:Natural Science Edition,2009, 10(5):501-506.(张文静,朱首贤,黄韦艮.卫星遥感资料在湛江港风暴潮漫滩计算中的应用[J].解放军理工大学学报:自然科学版,2009,10(5):501-506.)

[2] ZHU Shouxian,HUANG Weigen,DING Pingxing,et al. Application of Satellite Remote Sensing Data to the Calculation ofTopography and Flooding at Littoral Zone[J]. Journal of East China Normal University:Natural Science, 2007(4):1-8.(朱首贤,黄韦艮,丁平兴,等.卫星遥感资料在潮间带地形和漫滩计算中的应用[J].华东师范大学学报:自然科学版,2007(4):1-8.)

[3] ZHAN Jingang,WANG Yong,XU Houze,et al.The Wavelet Analysis of Sea Level Change in China Sea during 1992~2006[J].Acta Geodaetica et Cartographica Sinica, 2008,37(4):438-443.(詹金刚,王勇,许厚泽,等.我国近海1992~2006年海平面变化的小波分析[J].测绘学报,2008,37(4):438-443.)

[4] SONG Jianshe,ZHENG Yongan,LIU Yingchun.Image Fusion Algorithm of SAR and Optical Images Based on Wavelet Transform[J].Application Reasearch of Computers, 2004,21(10):110-113.(宋建社,郑永安,刘迎春.基于小波变换的SAR与可见光图像融合算法[J].计算机应用研究,2004,21(10):110-113.)

[5] CHIBANI Y.Selective Synthetic Aperture Radar and Panchromatic Image Fusion by Using theàtrous Wavelet Decomposition[J].EURASIP Journal on Applied Signal Processing,2005,14:2207-2214.

[6] LI Huihui,GUO Lei,LI Guoxin.Is Ridgelet Transform Better than Wavelet Transform in SAR and Optical Image Fusion?[J].Journalof Northwestern Polytechnical University,2006,24(4):418-422.(李晖晖,郭雷,李国新.基于脊波变换的SAR与可见光图像融合研究[J].西北工业大学学报,2006,24(4):418-422.)

[7] L I Huihui,GUO Lei,L IU Hang.Research on Image Fusion Based on the Second Generation Curvelet Transform [J].Acta Optica Sinica,2006,26(5):657-662.(李晖晖,郭雷,刘航.基于二代Curvelet变换的图像融合研究[J].光学学报,2006,26(5):657-662.)

[8] L IU Kun,GU O L ei,L I H uihui,et al.Image Fusion Algorithm Using Stationary Wavelet Transform[J]. Computer Engineering and Applications,2007,43(12):59-61.(刘坤,郭雷,李晖晖,等.一种基于静态小波变换的图像融合算法[J].计算机工程与应用,2007,43(12):59-61.)

[9] BEYKIN G.On the Representation of Operators in Bases of Compactly Supported Wavelets[J].SIAM Journal on Numerical Analysis,1992,29(6):1716-1740.

[10] UNSER M.Texture Classification and Segmentation Using Wavelet Frames[J].IEEE Transactions on Image Processing,1995,4(11):1549-1560.

[11] ROCKINGER O.Image Sequence Fusion Using a Shiftinvariant WaveletTransform[C]∥Proceedings of the IEEE InternationalConference on Image Processing. Santa Barbara,CA:IEEE,1997:288-291.

[12] DAUBECHIES I.Ten Lecture on Wavelets[M]. Philadelphia:Capital City Press,1992.

[13] L I H uihui.Study on M ultisensor Images Fusion Algorithm[D]. Xi’an:Northwestern Polytechnical University,2006.(李晖晖.多传感器图像融合算法研究[D].西安:西北工业大学,2006.)

[14] WU Zhiguo,WAN G Yanjie.Image Fusion Algorithm Using Curvelet Transform Based on the Edge Detection [J].Optical Technique,2009,35(5):682-686.(武治国,王延杰.一种基于边缘的曲波变换图像融合方法[J].光学技术,2009,35(5):682-686.)

[15] ZHOU Liya,QIN Zhiyuan.Research on Enhancing Edge Feature Image Fusion Method[J].Journal of Geomatics Science and Technology,2008,25(6):448-450.(周丽雅,秦志远.突出边缘特征的图像融合方法研究[J].测绘科学技术学报,2008,25(6):448-450).