机器学习中的负迁移探讨

2010-10-09吴伊萍

吴伊萍

(泉州师范学院 数学与计算机科学学院,福建 泉州 362000)

机器学习中的负迁移探讨

吴伊萍

(泉州师范学院 数学与计算机科学学院,福建 泉州 362000)

传统的机器学习侧重于研究单一任务,假设训练数据和测试数据服从同样的概率分布,然而实际中这一条件往往无法满足,且对于不同任务的研究较少,这些就需要迁移学习.它可以从现有的任务中学习知识和技能用于将来的任务.然而使用迁移学习则要承担负迁移的风险.本文介绍在增强学习、多任务学习和归纳学习中避免负迁移的方法.

迁移学习;避免负迁移;任务相关;综述

1 引言

汉语拼音的学习有助于学习英语发音;英语的学习有助于学习法语;练短跑有助于提高三级跳成绩等.人们很早就懂得运用已掌握的知识和技能学习新任务.不同人的学习能力不同,随着知识的积累,一般成人的学习能力比小孩高.而提高机器的学习能力则要使机器学习的能力不断提高,继承和发展过去已掌握的知识和技能,实现增量学习.但正如Porter和Duncan[1]的研究发现在A到B之间迁移有效,但A到BR之间就有害,及“一朝被蛇咬,十年怕井绳”.这些都表明负迁移的存在及其危害.

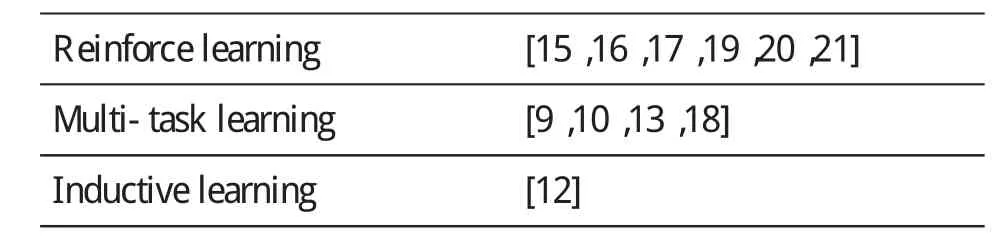

目前迁移学习在机器学习的一些领域,如神经网络、层次贝叶斯、增强学习、多任务学习和归纳学习的研究已经取得了一定的进展.为了促进迁移学习在其他机器学习上的推广,预防负迁移,这篇文章我们讨论负迁移及其预防机制.主要讨论其在增强学习、多任务学习和归纳学习上的避免方法.

2 概要

2.1 迁移学习和负迁移研究现状

迁移学习来源于认知科学[25],人们利用已掌握的经验知识学习新事物,它包括行为迁移和知识迁移.在机器学习领域,不同时期由于不同的研究对象人们提出了不同名称的迁移学习.1995年,NIPS-95工作室提出“学会学习(learning to learn)”[23];Caruana“多任务学习 (Multi-task learning)”[18];Raina“自学习(self-taught leaning)”[24]等.有些人提出了一些迁移学习研究的统一框架,如戴文渊——特征迁移[4]等.目前从事迁移学习的研究机构有香港科技大学计算机科学与工程系,美国威斯康星大学(University of Wisconsin,USA)机器学习实验室,加利福尼亚伯克利分校和麻省理工学院等.在近几年的顶级国际会议上,如ICML,ECML/ PKDD,KDD,IJCAI等和迁移学习相关的文章有不少,可参见香港科大的网页[3].随着认知心理学等相关学科的发展,在未来的一段时间里,迁移学习将成为机器学习和人工智能研究领域的主要方向.

负迁移是迁移学习过程中不可回避的问题.如会开小汽车后学习开大卡车就比较容易,但会骑自行车就要学开大卡车就很困难.虽然都是车,由于大卡车和小汽车的结构、发动和驾驶原理相似,但和自行车相差甚远.同样学习系统在一个新的场景中,如果套用原有场景的方法一味蛮干则会降低学习质量.

2.2 相关概念定义

迁移学习的概念目前没有严格统一的定义,按照NIPS2005对迁移学习的定义进行描述.“Transfer Learning emphasizes the transfer ofknowledge across domains,tasks,and distributions that are similar but not the same.”迁移学习强调的是在相似但不同的领域、任务和分布之间知识的迁移.

源任务指机器已掌握的相对于新任务不同的数据集.

目标任务指机器要学习的新任务的数据集.

负迁移,在机器学习领域还没有给出严格的定义.在此,我们定义为:旧的知识或经验阻碍或干扰新任务的学习.

3 避免负迁移的途径

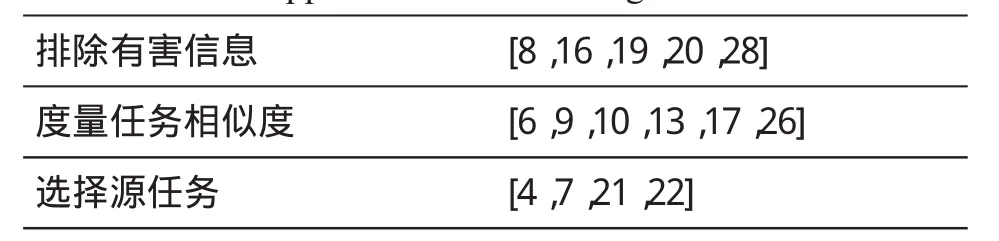

迁移学习的三个要素是:What to transfer;How to transfer;When to transfer,即迁移什么,怎样迁移和什么时候迁移.人们从纵多的经验知识中选择适合于新任务的知识,要能在合适的时间用合适的方法迁移挑选的旧知识于新知识中.迁移的内容从认知科学的角度包括知识和行为;迁移的方法Robins[25]指“analogy,skill transfer and metaphor”——类推,行为迁移和比喻.这对于人来说尚且不易,更不要说是机器.在机器进行迁移学习的过程中,如果候选任务选择不当或迁移的内容不当或迁移时机不当都会造成负迁移.在避免负迁移的研究中仍有许多问题值得探讨,在此按照以下三方面讨论:(1)排除有害信息(2)度量任务相似度(3)选择源任务.

Table1:Approaches to avoid negative transfer

Table2:Different settings of negative transfer

3.1 排除有害信息

排除有害信息是避免负迁移的重要方法之一.对于相似度极高的源目标任务,学习系统可能忽略目标任务的特定属性,进行简单的模仿,由此降低系统的性能.在增强学习中,存在多系统或多任务交互的情况,代理迁移先前学习的知识如策略或Q值时,可能采用原有单一系统的方法,这样就会造成负迁移.在交互任务中,学习系统要能够排除来自于自身环境或外来任务的干扰或有害的信息,才能进行有效地迁移学习.

对于相似度极高的两个任务,迁移学习有时会阻碍学习系统的性能,Rosenstein和Marx[8]给出了使用目标任务中的少量数据来检测和避免负迁移的方法.他们提出层次朴素贝叶斯方法,在假设两个任务具有相同的超验分布,未知的均值和小方差,计算小样本的后验概率.朴素贝叶斯和分层体制结合,用来检测和避免负迁移,简洁有效地判断是否进行迁移.不足在于,他们为适应Dirichlet分布为所有用户设置一个共享参数,但Dirichlet分布不适用于任意的双峰分布,该模型无法处理多于一个任务的聚类.Roy和Kaelbling[28]提出Dirichlet过程混合模型,解决了这一问题.

在大规模顺序决策问题上,增强学习的解决方法之一是关系强化学习.学习系统通过代理与环境中的其它系统交互.但对于复杂的场景代理要选择一个最优策略也是很困难的.Croonenborghs等人[16]试图在关系强化学习中学习关系抉择(relational options)进行归纳迁移.他们构造一个扩展的抉择框架用于分层关系抽取(hierarchical relational abstractions)来学习相似但不同的域.他们按照行为的形式迁移知识,将这些行为表示成关系抉择,并设定初始和结束条件及策略.显然,用Q函数(Q-function)代替最优策略表示上容易多,只要确定“状态——动作”序列求出Q值(Q-value),构造决策树就能确定下一步的动作.

Torrey等[19,20]提出征求建议来决定迁移源任务中的知识到目标任务中的方法.通过征求建议,迁移了共同知识,摒弃了不合理知识对目标任务的干扰.文中涉及的系统使用归纳逻辑程序涉及来分析源任务中的技能,根据迁移规则来决定采取什么行为.

3.2 度量任务相似度

任务或域的相似性度量是一个很难的问题,辨别新旧任务或域之间的相似点和相似程度,以确定是否进行迁移及迁移什么.针对不同的域和任务,人们提出了各种尝试,经过十几年的研究,任务相似度的度量有了一定的进展.Silver等人[26],1996年,提出了基于相似度度量地使用动态学习比率的任务知识的并行迁移.

Thrun和O’Sullivan等[13]为我们介绍了任务聚类的算法,帮助我们识别内在相关的任务.它有助于在多任务学习时,规避不相关任务带来的风险和潜在的误导,增强学习系统的鲁棒性.在同一个聚类中,如果从任务N迁移的知识越有助于改善学习系统学习任务M,则说明这两个任务越相关.任务聚类算法共三步:(1)对于每一组任务N和M:计算从任务M迁移的知识对任务N的性能增益;(2)在每个任务聚类中最大化性能增益,将所有任务安排在一个更小的聚类中;(3)如果一个新任务来临,决定最相似的聚类.从该类的某任务中选择性地迁移知识.对于每个新遇到的新任务,通过任务聚类算法,找到其所在聚类,根据该聚类的特征学习新任务,有效地实现知识和技能的迁移.[10]Bakker等人也在贝叶斯的多任务学习上进行任务聚类和控制来避免负迁移.

多任务学习是同时学习相关的任务,迁移学习是先学习一个相似但不同的源任务再将源任务中的知识迁移到目标任务.Ben-David和Schuler[9]在多任务学习中研究具有共同特征的相关任务集,并提出了针对相关任务的数据生成框模型及误差界限.根据数据生成模型,学习者可以计算任务属性值.如果任务P和T之间对于任意属性Tri有P(Tri)=T(F(Tri)),则称任务P和T满足函数F相似,则这两个任务称为相关任务.这为任务相关又提供了一种改进的度量方法.不足之处在于,要找到函数F不易.

Carroll和Seppi[17],2005年在增强学习任务库中,根据迁移方法的不同提出了任务相似性的度量的指标,包括时间、策略覆盖、Q值和奖赏结构分别用dT,dP,dQ,和dR表示.

Mahmud和Ray[6]从贝叶斯的角度来逼近计算任务相似度.他们使用条件Kolmogorov复杂性的假设,巧妙地解决了任务相似度地度量.条件的Kolmogorov复杂性的输入变量是h’,输出变量是h,其概率分布式K(h|h’),用来衡量输入对输出的积极信息.对于目标任务,它的先验概率来自于源任务的学习,因此计算每个候选项的概率P(·|h’)=2-K(·|h’),从而决定目标任务要从源任务重迁移适当的信息量.该方法的特点是一先验概率的计算容易;二能达到预先的目的——合理的迁移先验知识比不迁移先验知识的好.

3.3 选择源任务

迁移的知识各种各样,如增强学习中的值函数或启发式信息或关系.学习系统在遇到新任务时,存在某个迁移的知识点上有多个候选任务同时可以进行迁移.如果学习系统没有筛选候选任务,可能因此造成负迁移.

当面对多任务时,增强学习中代理做出正确的抉择很困难.Talvitie等人[21]使用直接的方法——基于Markov过程理论的随机动态系统的最优决策过程(Markov Decision Process,MDP)来迁移.首先,对于每个候选项,在目标任务上在固定的时间内运行MDP并按照它们的性能排序;其次,从前一次的排序结果中选出最优策略继续执行;比较第i次与第i+1次的最优策略,如果第i+1次比第i次来得差,则结束.对于问题规模大的情况,该方法尽管费时,但简单实用.此外,MDP具备完善的理论和评估指标.

在计算机和数学领域,图是构建实体关系的工具.Kuhlmann和Stone[22]、Dai等人[4]和Eaton等人[7]在迁移学习的研究上叶提出构造图来表示任务和规则.他们都提出基于来实现学习的迁移,但实现上却有所不同.Kuhlmann和Stone[22]是寻求同构空间中的匹配,描述的是规则图.节点代表一条规则中的逻辑语句、相关语句、常量和变量.顺序边连接的时连续的变量,为约束添加边描述其前后因.通过计算目标任务和旧任务的规则图是否同构,寻找同构的旧任务进行值函数迁移.

Dai等人[4]提出针对迁移学习的统一框架,描述的是任务图.实例、特征和标签作为节点,边连接目标任务和辅助数据.通过学习任务图的频谱可以获取其所有节点的特征空间表示.作者还提出了“特征聚类:用于迁移学习的统一框架”算法,用于进行目标聚类任务.特征迁移框架可以有效地解决跨域学习、跨分类学习、自学习三类典型的迁移学习问题.

Eaton等人[7]对候选任务间的迁移关系建模,通过在一个图中嵌入已学的源模型集合用于迁移性的度量.迁移到一个新的问题,通过把这个问题映射成一个图.在这个图上学习一个函数,自动确定转移到新任务的参数.该方法类似于归纳迁移,沿着流形获取任务间的迁关系.它直接对候选源任务间的关系建模,可以确保从多个候选任务中自动选择相关信息迁移,避免人工选择源任务带来的负迁移.

4 结束语

迁移学习是机器学习和人工智能领域的重要研究方向,负迁移是迁移学习过程中必须面对的问题.迁移学习在增强学习、多任务学习、贝叶斯学习和归纳学习的研究已开展一段时间,这篇文章从三个方面介绍了它们避免负迁移的途径——排除有害信息、度量任务相似度和选择源任务.希望通过对负迁移避免方法的探讨,有助于机器学习领域其他学习的迁移.此外,任务或域映射是与负迁移密切相关的问题,映射技术的提高有助于避免负迁移,是今后研究的一个方向.

〔1〕LW Porter,CP Duncan Negative Transfer in VerbalLearning [J].JournalofExperimental Psychology,1953.

〔2〕Sinno J.Pan,Qiang Yang.A Survey on Transfer Learning[C].IEEE Transactions on Knowledge and Data Engineering,2009,Vol.99,No.1.

〔3〕http://www.cse.ust.hk/~sinnopan/conferenceTL. htm.

〔4〕Wenyuan Dai,Gui-Rong Xue,Qiang Yang,Yong Yu,EigenTransfer:A Uni?ed Framework for Transfer Learning[C].Proceedings of the 26th International Conference on Machine Learning, 2009.

〔5〕Z.Marx, M.T.Rosenstein, L.P.Kaelbling,and T.G.Dietterich.Transfer learning with an ensemble of background tasks[C].In NIPS Workshop on Transfer Learning,2005.

〔6〕M.M.H.Mahmud and S.R.Ray.Transfer learning using kolmogorov complexity:Basic theory and empirical evaluations[C].Proceedings of Cambridge,MA:MIT Press,2008.985–992.

〔7〕E.Eaton,M.desJardins,and T.Lane.Modeling transfer relationships between learning tasks for improved inductive transfer[C].In Machine Learning and Knowledge Discovery in Databases,European Conference,2008.

〔8〕M.T.Rosenstein,Z.Marx,and L.P.Kaelbling.To transfer or not to transfer[C].In a NIPS-05Workshop on Inductive Transfer:10Years Later,December 2005.

〔9〕S.Ben-David and R.Schuller.Exploiting task relatedness for multiple task learning[C].In Proceedings of the Sixteenth Annual Conference on Learning Theory.San Francisco: Morgan Kaufmann,2003.825–830.

〔10〕B.Bakker and T.Heskes.Task clustering and gating for Bayesian multitask learning [J]. Journal of Machine Learning Reserch,vol.4. pp.83-99,2003.

〔11〕A.Argyriou,A.Maurer,and M.Ponti.An algorithm for transfer learning in a heterogeneous environment[C].Proceedings of Machine Learning and Knowledge Discovery in Databases,European Conference[C].ECML/PKDD,2008,ser. Lecture Notes in Computer Science.Antwerp, Belgium:springer,September 2008,pp.71–85.

〔12〕Jonathan Baxter.A model of inductive bias learning [J].Journal of Artificial Intelligence Research,12:149–198,2000.

〔13〕Sebastian Thrun,Joseph O’Sullivan.Clustering Learning Tasks and The Selective Cross-Task Transfer of Knowledge[M].1995.In S.Thrun and L.Y.Pratt (eds),editors,Learning To Learn, chapter 10.Kluwer Academic Publisher,1998.

〔14〕L.Torrey and J.Shavlik.Transfer Learning [M].In E.Soria,J.Martin,R.Magdalena, M.Martinez and A.Serrano,editors,Handbook of Research on Machine Learning Applications,IGI Global 2009.PP242-261.

〔15〕Matthew E.Taylor,PeterStone.Transfer Learning in Reinforcement Learning Domains: A Survey[J].Journal of Machine Learning Research,10(2009).PP.1633-1685.

〔16〕T.Croonenborghs,K.Driessens,andM.Bruynooghe. Learning relational skills for inductive transfer in relational reinforcement learning[C].In International Conference on Inductive Logic Programming,2007.

〔17〕C.Carroll and K.Seppi.Task similarity measuresfortransferin reinforcementlearning task libraries[C].In IEEE International Joint Conference on Neural Net-works,2005.

〔18〕R.Caruana.Multi-task learning[J].Machine Learning.1997,28(1):141-75.

〔19〕L.Torrey,T.Walker,J.Shavlik,and R.Maclin [C].Using Advice to Transfer Knowledge Acquired in One Reinforcement Learning Task to Another.Proceedings of the 16th European Conference on Machine Learning,2005.

〔20〕L.Torrey,J.Shavlik,T.Walker,and R.Maclin. Relational Skill Transfer via Advice Taking[C]. ICML Workshop on StructuralKnowledge Transfer for Machine Learning,2006.

〔21〕E.Talvitie and S.Singh.An expertsalgorithm for transfer learning[C].In International Joint Conference on Artificial Intelligence,2007.

〔22〕G.Kuhlmann and P.Stone.Graph-based domain mapping for transfer learning in general games[C].In European Conference on Machine Learning,2007.

〔23〕http://www-2.cs.cmu.edu/Groups/NIPS/NIPS95/

〔24〕Rajat Raina,Alexis Battle,Honglak Lee,Benjamin Packer and Andrew Y.Ng.Self-taught Learning:TransferLearning from Unlabeled Data[C].ICML2007.

〔25〕Anthony Robins.Transfer in Cognition [J]. Connection Scinece,Vol.8,No.2,1996.

〔26〕Daniel L.Silver,Robert E.Mercer.The Parallel Transfer of Task Knowledge Using Dynamic Learning Rates Based on a measure of Relatedness [J].Connection Science,Vol.8, No.2,1996.

〔27〕http://multitask.cs.berkeley.edu/.

〔28〕Daniel M.Roy and Leslie P.Kaelbling.Efficient Bayesian Task-Level Transfer Learning[C].Proceedings of the Twentieth International Joint Conference on Artificial Intelligence,2007.

TP274.1

A

1673-260X(2010)08-0039-04