基于人工智能的交互式数字人情感识别与响应技术研究

2024-11-01康旭

摘要:随着交互式数字人的迅速发展,情感识别技术得到了广泛应用,数字人在此项技术的支持下通过语音、面部表情和文本分析等方式来理解人类的情感状态;情感响应技术则让数字人能够通过语音生成、视觉反馈或动作做出适当反应。基于此,对情感响应系统的评估方法进行分析,通过应用测试,展示这些技术的实际效果,并提出未来研究方向等内容。

关键词:人工智能 交互式数字人 情感识别 响应技术

中图分类号:TP18

Research on Interactive Digital Human Emotion Recognition and Emotional Reaction Technology Based on Artificial Intelligence

KANG Xu

Tianjin Branch, CNOOC Information Technology and Services Co., Ltd., Tianjin City, 300452 China

Abstract: With the rapid development of interactive digital humans, emotion recognition technology has been widely applied. With the support of this technology, digital humans understand human emotional states through speech, facial expressions, and text analysis; Emotional response technology enables digital humans to respond appropriately through speech generation, visual feedback, or actions. Based on this, analyze the evaluation methods of emotional response systems, demonstrate the actual effects of these technologies through application testing, and propose future research directions.

Key Words: Artificial intelligence; Interactive digital human; Emotion Recognition; Reaction technology

在人工智能领域,交互式数字人情感识别与响应技术已成为一个快速发展的研究领域,它涵盖了机器学习、自然语言处理、计算机视觉和信号处理等多个学科的交叉应用。此类技术的核心目标是赋予数字人模仿人类情感交互能力,进而提升其应用效果,使之在如客户服务、教育、健康护理和娱乐等多个领域中发挥更大的作用。情感识别技术通过解析用户的语音、面部表情、文本输入等多模态数据来推断用户的情绪状态,而情感响应技术则依据这些推断结果生成相应的语音、文本或视觉反馈,以实现与用户之间的自然、有效交互。交互式数字人技术的发展意义重大,不仅因为它可以提高服务的个性化和满意度,也因为它在处理和响应人类情绪方面展示了巨大潜力。

1 交互式数字人情感识别与响应技术概述

在当前人工智能领域的研究中,交互式数字人情感识别与响应技术日益显得至关重要,它涵盖了机器学习、自然语言处理、计算机视觉及信号处理等多个技术的交叉应用,旨在赋予数字人类似于人类的情感理解和表达能力,以提升其交互效果和用户体验[1]。情感识别技术,作为交互式数字人的核心组成部分,主要依赖于模式识别和深度学习算法来分析用户的语音、面部表情以及文本输入,从而推断出用户的情绪状态。

2 交互式数字人情感识别技术

2.1面部表情分析

面部表情分析在交互式数字人情感识别技术中占据核心地位,它通过高精度的图像处理和机器学习技术解读人类表情中的微妙变化,从而推断出用户的情绪状态。该技术的实现基于面部动作编码系统(Facial Action Coding System ,FACS),该系统能详细地描述面部肌肉所产生的每一个动作,这些动作被编码为特定的动作单元(Action Unit,AUs),每个动作单元对应一组特定的肌肉运动。通过分析这些动作单元的激活状态,可以推断出表情所表达的基本情感,如快乐、悲伤、惊讶等[2]。

2.2语音情感识别技术

语音情感识别技术是交互式数字人情感识别领域的一个重要分支,依赖于声学特征提取、语音信号处理和机器学习模型来分析和识别人类语音中的情绪内容。这一技术的核心在于提取语音的基本和高级特征,如基频(fundamental frequency,F0)、能量、音色和语速,以及它们在语音中的动态变化[3]。采用特征提取技术如梅尔频率倒谱系数(Mer frequency inverted spectrum coefficient,MFCC)、线性预测编码( linear predictive coding ,LPC)、倒谱提升等从处理好的信号中提取有效的声学特征,如图1所示。这些特征不仅反映了语音的物理属性,还蕴含了说话人的情绪状态信息。在特征提取之后,采用各种机器学习算法,如支持向量机( Support Vector Machine SVM)、随机森林、深度神经网络(deep neural network ,DNNs)和长短期记忆网络(Long Short-Term Memory,LSTMs)等进行情绪分类。这些算法通过训练已标记的情感语音数据库,学习不同情绪状态下的声学特征模式。

3 交互式数字人情感响应技术

3.1音频响应技术

音频响应技术在交互式数字人情感响应系统中扮演了至关重要的角色,它涉及通过生成的音频来传达相应的情绪反馈,从而增强交互式数字人与用户之间的情感联结。这一技术的核心是利用语音合成(Text-to-Speech, TTS)系统,将文本信息转换为语音输出,同时注入适当的情绪色彩,以模仿人类在特定情感状态下的语音特征[4]。音频响应技术不仅仅是复制人类语音的声音特性,更重要的是能够在语调、节奏、音量和语速等方面精确地调制情感表达,这需要对语音信号进行细致的情感调控。

3.2视觉响应生成

视觉响应生成技术在交互式数字人情感响应系统中占据着重要位置,其目标是创建视觉输出,如面部表情和身体语言,这些输出能够在视觉上表达复杂的情感状态,以增强与用户的情感共鸣和交互的真实性。这一技术涵盖了从基础的图像处理到高级的计算机图形和动画生成,依赖于一系列先进的算法和模型,包括但不限于三维建模、动作捕捉技术、面部动画参数化以及实时渲染技术。

3.3情感响应系统的评估

评估交互式数字人情感响应系统的效能与准确性是确保其实用性的关键步骤,本研究采用基于机器学习的实时情感状态监测算法(Real-time Emotion Monitoring, REM)来实现这一目的。该算法核心在于持续更新情感状态的评估,以提供即时的响应调整。该算法的实施步骤如下所示,每一步均涉及具体的数学公式,用于定义和优化情感识别与响应生成的过程。

REM算法基于用户的语音、面部表情及文本输入数据集进行操作,其中每个输入都与一个情感标签相关联。算法的目标是学习一个映射函数,该函数能够预测未见数据的情感状态。该过程可以通过以下优化问题来形式化。

式(1)中:为损失函数,用于量化预测情感标签和真实情感标签之间的差异;为训练样本的数量。

为了实现实时监测,REM算法更新其模x6NhW3nV3rrbeNqdAtOZuQ==型参数通过一个迭代过程,通常使用梯度下降法。在每个时间步,参数更新可以表示为:

式(2)中:为学习率;为损失函数相对于模型参数的梯度,表示为函数对参数的敏感度。

在系统评估阶段,关键性能指标如准确率、召回率和F1分数被计算以评估情感识别的准确性。这些指标的计算如下:

式(3)中,、、和分别代表真正例、真负例、假正例和假负例的数量。这些公式在REM算法中的应用是多方面的:优化问题确立了学习任务的框架,参数更新公式指导了模型在接收新数据时如何调整,以保持其性能和适应性。

4 应用测试

为了确保交互式数字人情感识别与响应系统的评估具有高度的准确性和实用性,本研究采用了一组精心挑选的数据集。这些数据集是实测数据,由专业演员在控制的实验室环境下收集,以确保情感表达的广泛性和多样性。演员们被要求表达不同的情感状态,包括快乐、悲伤、愤怒、惊讶和中性,以覆盖人类情感的主要类别[5]。此外,数据收集过程中使用了高质量的录音和录像设备来捕捉声音和面部表情,以及相关的文本标注。

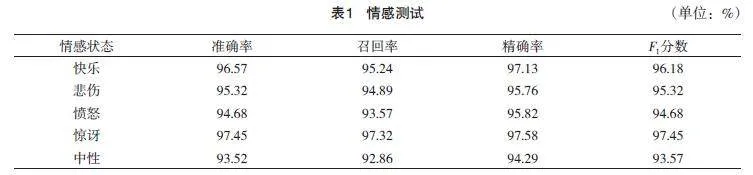

本研究中的数据集共包含10 000个样本,这些样本均匀分布在5种主要情感状态之间。为了评估情感识别与响应技术的效果,数据集被分为训练集和测试集。其中:80%(即8 000个样本)用于训练机器学习模型,以学习不同情感状态下的数据特征和模式;剩余20%(即2 000个样本)则用作测试集,以验证模型的性能和准确性。在本研究中,情感响应系统的评估采用了系统化的测试方法。数据的使用过程中,整个测试系统进行了3次完整的迭代,以确保评估结果的稳定性和可靠性。每次迭代都包括对全部2 000个测试样本的处理,而未对这些样本进行进一步的分组。这是因为目标在于评估模型在处理多样化情感状态下的整体性能,而非在特定子集上的表现,确保测试结果具有广泛的代表性和适用性,具体测试如表1所示。

从表1结果中可以观察到,模型在识别各种情感状态方面表现出高度的准确性和效率,尤其是在处理“惊讶”状态时,准确率和F1分数均达到了最高值,表明模型对表达惊讶的情感特征识别尤为敏感和精确。相较之下,对“中性”情感的处理略显不足,这可能是由于中性情感的表达较为含蓄和不明显,导致识别难度增加。这些结果整体表明:REM算法在多样化情感状态的识别上具备高效的实时处理能力,能够为用户提供准确反映情感状态的交互体验。

5 结语

为有效实现这些应用,必须对交互式数字人的情感识别与响应机制进行深入研究。这包括了解情感的心理和生理机制,开发能够准确捕捉和解析这些情感表达的算法,以及设计能够实时、自然地响应这些情感的系统。其中,情感识别算法需要处理和分析大量的实时数据,识别出用户的情绪状态,而情感响应算法则需要根据这些状态生成适当的反馈。这一过程不仅要求高效的数据处理能力,还需要对人类情感的深刻理解和精准的模拟能力。

研究交互式数字人的情感识别与响应技术,不仅有助于提升技术本身的成熟度和应用广度,还可以为理解人类情感和认知过程提供新的视角。通过这些技术的发展,可以极大地提高机器的人机交互质量,使其更加智能化和人性化,最终实现与人类用户之间更有效、更富有同理心的互动。

参考文献

[1] 邓欢.面向深度神经网络模型安全性测试的对抗补丁生成技术[D].北京:军事科学院,2023.

[2] 萧萍.具身,想象与共情:人工智能音乐生成与传播的技术现象学研究[J].现代传播:中国传媒大学学报,2022,44(9):155-161.

[3] 范永超,韩佳南.基于人工智能的语音识别系统设计与研究[J].数字通信世界,2022(5):55-57.

[4] 齐燕.基于人工智能算法的图像识别与生成研究[J].电子元器件与信息技术,2019, 3(11):45=47.

[5] 杨毯毯.基于HMM与改进的神经网络语音识别[D].青岛:山东科技大学,2019.