基于对抗分解卷积网络的自发微表情种类判别

2024-09-26吴俊

摘 要:针对自发微表情成分提取困难与分类识别率低的问题,提出对抗分解卷积网络,通过网络间的相互博弈与合作,实现自发微表情成分的提取与分类。将中性人脸作为判别网络的真实样本,自发微表情作为分解网络的输入样本,根据网络间的对抗得到只含有自发微表情成分的输出图像,通过网络迁移实现对自发微表情成分的迁移学习与分类。自发微表情跨库实验结果表明,分类准确率得到提升,具有克服不同数据库中人种、肤色差异的效果。

关键词:自发微表情;分类;分解;对抗生成网络

中图分类号:TP391.4 文献标识码:A 文章编号:2096-4706(2024)14-0026-05

Discrimination of Spontaneous Micro-expression Types Based on

Adversarial Decomposition Convolutional Network

WU Jun

(Fuzhou Vocational Technical College, Fuzhou 344000, China)

Abstract: Aiming at the problems of the difficulty in extracting spontaneous micro-expression components and the low classification recognition accuracy, the adversarial decomposition convolutional network is proposed to realize the extraction and classification of spontaneous micro-expression components through game and cooperation between networks. The images of neutral face are used as the real samples of the discriminant network, and images of spontaneous micro-expression are used as inputting samples of the decomposition network. According to the adversary between networks, output images containing only spontaneous micro-expression components can be obtained. Then, transfer learning and classification of spontaneous micro-expression components are realized through the transfer network. The cross database experimental results of spontaneous micro-expression show that the classification accuracy is improved and it has the effect of overcoming the differences of race and skin color in different databases.

Keywords: spontaneous micro-expression; classification; decomposition; Generative Adversarial Networks

DOI:10.19850/j.cnki.2096-4706.2024.14.006

0 引 言

自发微表情[1]是发生持续时间短、变化幅度弱的非自愿面部表情,标准的自发微表情发生时间为1 / 25秒 ~1 / 5秒。因此认知自发微表情是一个具有挑战性的课题,在国家安防等领域有巨大的应用潜力。

AU(Action Unit)单元[2]通过面部肌肉单元划分面部表情,不同数据库中不同种类的自发微表情都可以通过AU单元统一。根据AU单元进行划分,可以跨库[3]整合自发微表情样本,增加样本数量。

现在已有不同的研究算法针对自发微表情进行种类判别,而且都有着不错的认知性能。然而,对于自发微表情的认知存在样本数量少、类别数据不均衡等问题,并且跨库的自发微表情认知更具有挑战性。

1 相关算法

1.1 对抗生成网络

GAN(Generative Adversarial Network)[4]是经典的对抗生成网络,通过网络模型间的相互博弈生成足以以假乱真的图像。DCGAN(Deep Convolution GAN)[5]在生成模型上应用类反卷积的网络模型,在判别模型上应用卷积的网络模型,使其在图像生成上有着较为不错的效果,稳定了GAN的训练。

Yang等人[6]提出通过对抗生成网络将普通表情分解为表情成分和人脸成分的方法,对表情认知取得了不错效果。因此,本文基于DCGAN的结构,构建用于分解自发微表情的网络,使其可以将自发微表情分解为表情成分和人脸成分,从而实现表情成分的认知。

1.2 卷积神经网络

卷积神经网络在图像的特征提取、分类方面都表现出优良的性能。因此,在最新的研究中,卷积神经网络被广泛地用于自发微表情的定位与分类。Mayya等人[7]用TIM插值法将不同帧数的自发微表情片段插值为统一帧数,并用深度卷积神经网络对其提取脸部特征,从而实现视频中自发微表情3分类(消极、积极和惊讶)的种类判别。Khor等人[8]提出丰富信息的长时递归卷积网络(Enriched Long-term Recurrent Convolutional Network, ELRCN)用于自发微表情分类,该网络基于VGG16卷积神经网络进行迁移学习。

Inception-ResNet-V2 [9]是由谷歌提出的基于ImageNet大型图像数据库的分类网络,对于图像分类具有显著的效果。自发微表情样本数量少,难以训练较为优化的用于分类的卷积神经网络,因此本文基于该网络进行迁移学习,对提取的自发微表情成分的图像用Inception-ResNet-V2网络进行微调并完成分类。

2 方法概述

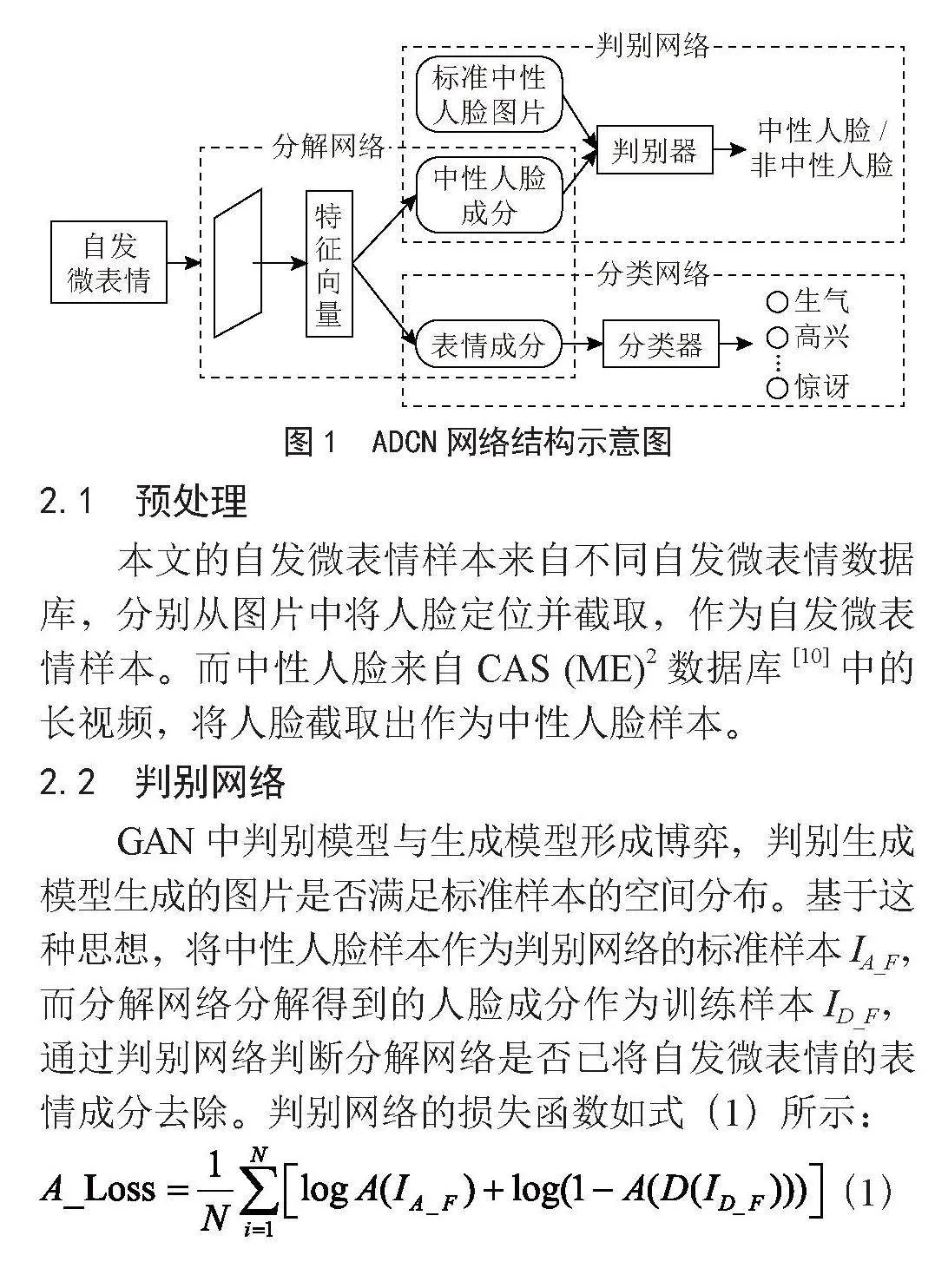

本文提出对抗分解卷积网络(Adversarial Decompose Convolutional Network, ADCN)分离自发微表情中表情成分与人脸成分,从而实现自发微表情种类判别。ADCN网络分为三个部分,分别为判别网络、分解网络与分类网络,图1描述了网络的具体构成方式。接下来,对预处理方法、网络结构与损失函数进行更加详尽的描述。

2.1 预处理

本文的自发微表情样本来自不同自发微表情数据库,分别从图片中将人脸定位并截取,作为自发微表情样本。而中性人脸来自CAS (ME)2数据库[10]中的长视频,将人脸截取出作为中性人脸样本。

2.2 判别网络

GAN中判别模型与生成模型形成博弈,判别生成模型生成的图片是否满足标准样本的空间分布。基于这种思想,将中性人脸样本作为判别网络的标准样本IA_F,而分解网络分解得到的人脸成分作为训练样本ID_F,通过判别网络判断分解网络是否已将自发微表情的表情成分去除。判别网络的损失函数如式(1)所示:

(1)

其中,N表示每批次的样本数量,A表示判别网络,D表示分解网络。同时,表1中列出了判别网络的网络结构。

2.3 分解网络

分解网络实现将自发微表情分解为中性人脸成分和自发微表情成分。如图1所示,分解网络可视为两个网络的组合,两个网络同时共享中间特征以完成相应图片的生成。分解网络的网络结构类似于判别网络,这里不再详述其网络结构。

分解网络的上半部分完成人脸成分的生成,与判别网络构成一个对抗生成网络,其损失函数如式(2)所示:

(2)

分解网络的下半部分实现自发微表情成分的生成,因没有纯表情样本提供该部分网络单独训练,因此联合输入的自发微表情样本与分解得到的中性人脸成分,通过各成分的互相叠加比较计算损失值,从而训练该部分网络。损失值函数计算如式(3)所示:

(3)

其中,IOri表示自发微表情样本,ID_E表示分解得到的自发微表情成分。

2.4 分类网络

分类网络实现分解网络生成的自发微表情成分5分类的种类判别,是基于Inception-ResNet-V2网络的迁移网络。因自发微表情样本少,难以训练较为优化的分类网络,因此采用迁移网络,通过优化局部参数训练分类网络。分类网络的交叉熵损失函数如式(4)所示:

(4)

其中,FL表示分类网络生成的标签,TL表示自发微表情的真实标签。

2.5 网络训练

为强化分解网络生成自发微表情成分的部分网络,将该部分网络的损失值与分类网络的损失值加权计算,使分类网络的损失值能影响分解网络生成的自发微表情成分。损失值加权计算方法如式(5)所示。

(5)

其中,α ∈ [0,1],表示平衡两种损失的参数, 用于训练分解网络生成自发微表情成分的部分网络。

3 实验及结果分析

3.1 数据库

CASMEII [11]数据库包括255段自发微表情片段,受试者为35个亚洲人。表情类别的确定由受试者和专家共同确定,包括生气、高兴等7类。

CAS (ME)2数据库是CASMEII数据库的扩展版本,其中包括自发微表情片段与自发宏表情片段共357段,受试者为22个亚洲人,分为生气、恐惧、厌恶等10种类别。

SAMM [12]数据库是最新的自发微表情数据库,其中包括自发微表情片段159段,受试者为32人,13个种族。该数据库根据AU单元,将所有的自发微表情片段分成生气、高兴等8种类别。

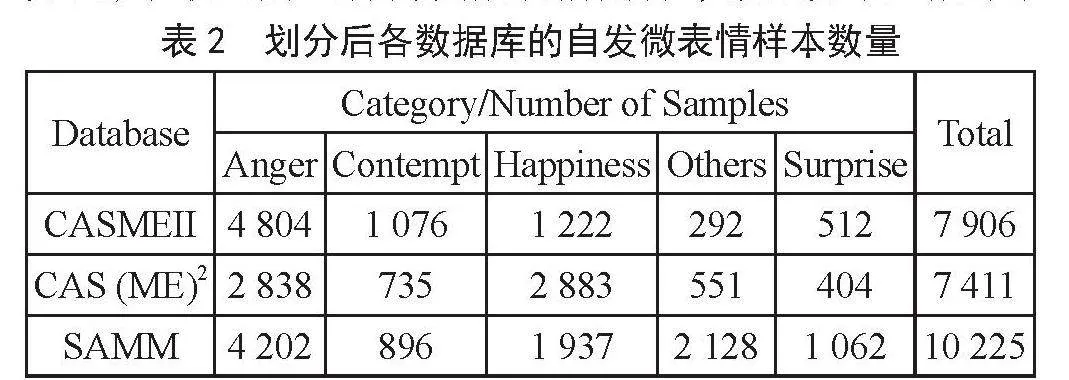

为统一不同自发微表情数据库的类别,根据文献[3],将CAS (ME)2数据库根据SAMM数据库中不同表情的AU单元重新进行表情种类的划分。为避免划分错误,舍弃不对应于SAMM数据库AU单元的自发微表情片段,最终得到244段自发微表情片段。同时,由于厌恶、害怕、伤心这三类自发微表情片段数量过少,只进行生气、蔑视、高兴、其他、惊讶五类自发微表情的判别(CASMEII数据库划分规则也是如此)。最终的五种自发微表情的样本数量如表2所示。

3.2 实验细节

ADCN网络训练分为三个阶段。1)因输入分解网络的图片为自发微表情样本,而输入判别网络的图片为CAS (ME)2数据库的中性人脸样本,分解网络生成人脸成分的部分网络在大约50周期时会趋于收敛(损失值不发生改变),此时结束第一阶段的训练。2)在训练的第二阶段,根据第3节中的损失函数对整个网络进行训练,但减少判别网络的参数更新次数,直至网络收敛(实验中设置α值为0.7)。3)在第三阶段,单独对分类网络训练,因在Inception-ResNet-V2网络上进行迁移学习,所以学习率一般设置为1×10-4,直至网络损失趋于稳定。

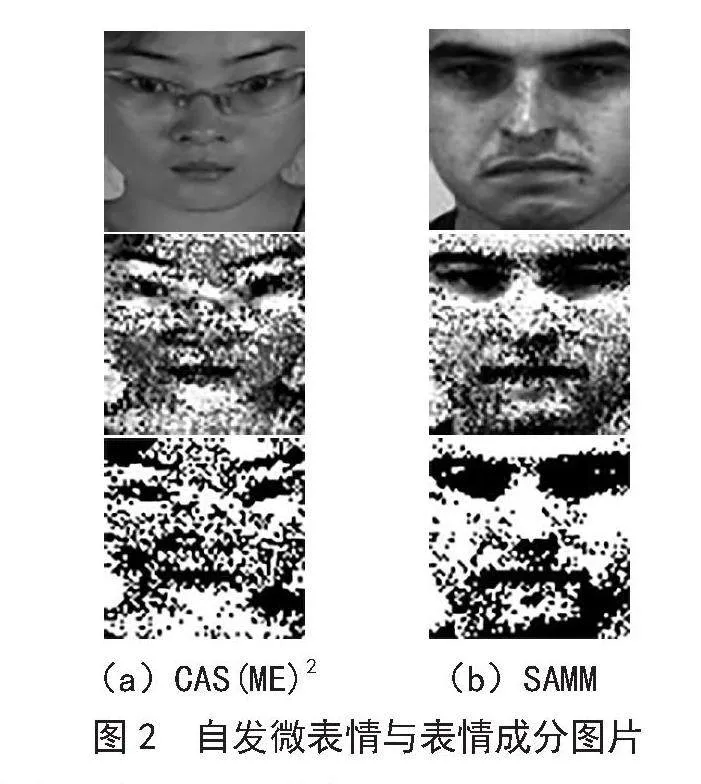

图2展示了第二阶段训练后的部分样本,从上至下分别为RGB样本、分解得到的自发微表情成分以及其二值图。从图2可以观察到,本文方法针对不同数据库间人种、肤色差异生成了不同颜色遮挡块,能够有效地遮盖非自发微表情发生的区域,尤其是眼眶内的区域,因为这部分难以传达自发微表情。同时,如图2(a)所示,本文方法也能剥离眼镜这一干扰项。

3.3 跨库的自发微表情识别

在我们之前的研究中[13],已对单一自发微表情数据库的表情种类判别取得不错的效果,因此本文主要针对跨库的自发微表情判别进行实验(即在A数据库上进行训练,在B数据库上测试)。并用F1、加权平均召回率(Weighted Average Recall, WAR)、未加权平均召回率(Unweighted Average Recall, UAR)对结果进行评估与分析。

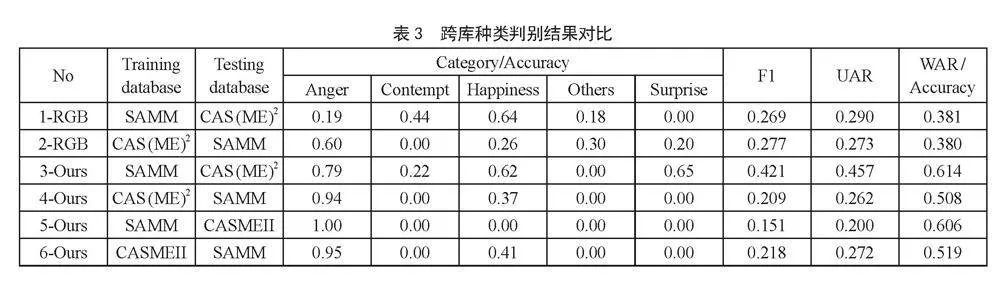

为验证本文方法对自发微表情有不错的判别效果,在测试实验中,将SAMM数据库与其他两个数据库(CASMEII、CAS (ME)2)两两组合进行跨库的自发微表情识别,实验结果如表3所示。

表3中1-RGB表示序号为1且测试样本为RGB样本,3-Ours表示序号为3且测试样本为自发微表情成分。从表3中可以观察到,相较于对未做任何处理的RGB样本直接用判别网络进行训练和测试,本文提出的方法在WAR上有较大提高,说明本文方法可以在跨库的条件下判别出测试样本中更多的自发微表情样本。对比序号1与3两组数据,可以发现本文方法在任何指标上都有较大的提高,说明本文方法能提高跨库的自发微表情种类判别的准确率。然而,对比序号2与4两组数据,可以发现本文F1与UAR的值略低,因为这两个评价指标忽略了每类数据样本的数量。当测试结果因某些数据样本数量少而表现不佳甚至无法正确判别时,F1与UAR的值就会剧烈下降。

本文提出的网络在序号3(SAMM训练CAS (ME)2用于测试)上表现最好,除“其他”类自发微表情,其余几类自发微表情都能较为准确地判别。对于序号5这一极端的分类结果,可能有如下几个原因:

1)生气类表情过多,占样本总比例的60%,影响网络的参数调节。

2)本网络对数量多的样本判别更优,尤其是生气类与高兴类,对这两种类别具有依赖性。

3.4 与现有算法对比

如表4所示,我们对CASMEII数据库与SAMM数据库进行样本增减,人为控制每类自发微表情样本的数量,在保证数据库原有样本的基础上实现了样本数量均衡化。

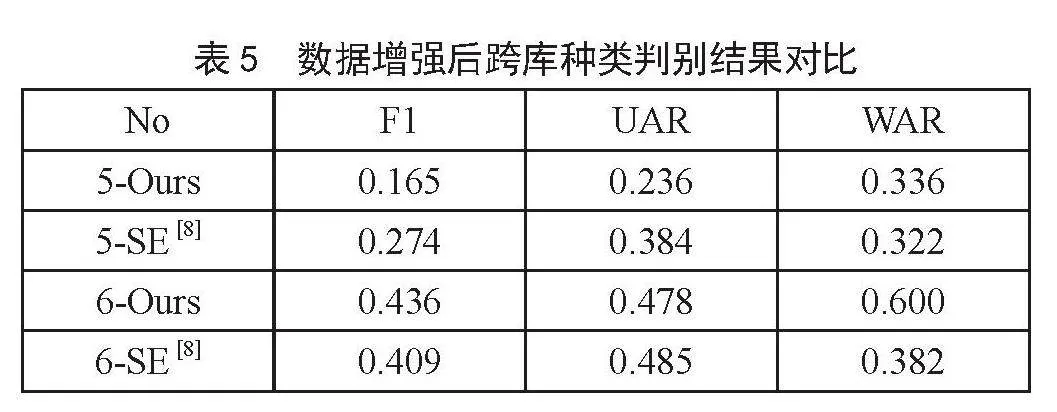

数据增强会导致训练困难,且难以收敛,并且一般的数据增强方式并不会增加样本的多变性,网络甚至可以学习到数据增强的方式,因此只对表情样本极少的类别进行数据增强。表4中“-”表示随机删除该类表情样本,“+”表示用数据增强的方式扩增样本数量,数据增强的方式为水平翻转。将经过处理的样本分别进行训练与测试,测试结果如表5所示(测试时去除了数据增强的样本)。

从表5中可以观察到,对比序号6-Ours与6-SE可见,本文网络的F1与WAR分别优于SE,表明本文方法在该条件下的判别效果是稍优的。

4 结 论

本文提出对抗分解卷积网络ADCN分解自发微表情,并对分解的表情成分进行种类判别。实验表明本文提出的方法对自发微表情分类时,相较于其他算法WAR有一定的提高,而F1与UAR则在某些测试条件下有所提高。

在以后的工作中,需更加关注自发微表情中数量极不均衡的问题,尤其是数量样本少的类易导致网络难以训练,并尝试使用基于GAN的样本生成方法扩增样本数量。

参考文献:

[1] OH Y H,SEE J ,LE N A C,et al. A Survey of Automatic Facial Micro-Expression Analysis: Databases, Methods, and Challenges [J/OL].Frontiers in Psychology,2018,9:1128(2018-07-10).https://doi.org/10.3389/fpsyg.2018.01128.

[2]王晓慧,贾珈,蔡莲红.基于小波图像融合的表情细节合成[J].计算机研究与发展,2013,50(2):387-393.

[3] DAVISON A,MERGHANI W,YAP M H. Objective Classes for Micro-Facial Expression Recognition [J].Journal of Imaging,2018,4(10):119-119.

[4] GOODFELLOW I J,POUGET-ABADIE J,MIRZA M,et al. Generative Adversarial Nets [C]//NIPS'14: Proceedings of the 27th International Conference on Neural Information Processing Systems.Cambridge:MIT Press,2014:2672-2680.

[5] RADFORD A,METZ L,CHINTALA S. Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks [J/OL].arXiv:1511.06434 [cs.LG].(2015-11-19).https://arxiv.org/abs/1511.06434v1.

[6] YANG H,CIFTCI U,YIN L. Facial Expression Recognition by De-Expression Residue Learning [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Salt Lake City:IEEE,2018:2168-2177.

[7] MAYYA V,PAI R M,PAI M M M. Combining Temporal Interpolation and DCNN for Faster Recognition of Micro-Expressions in Video Sequences [C]//Advances in Computing,Communications and Informatics (ICACCI).Jaipur:IEEE,2016:699-703.

[8] KHOR H Q,SEE J,PHAN R C W,et al. Enriched Long-Term Recurrent Convolutional Network for Facial Micro-Expression Recognition [C]//2018 13th IEEE International Conference on Automatic Face & Gesture Recognition(FG 2018).Xi'an:IEEE,2018:667-674.

[9] SZEGEDY C,IOFFE S,VANHOUCKE V,et al. Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning [C]// Thirty-First AAAI Conference on Artificial Intelligence. San Francisco:AAAI Press,2017:4278-4284.

[10] QU F,WANG S J,YAN W J,et al. CAS (ME)2: A Database of Spontaneous Macro-Expressions and Micro-Expressions [C]//International Conference on Human-Computer Interaction.Cham:Springer International Publishing,2016:48-59.

[11] YAN W J,LI X,WANG S J,et al. CASME II: an Improved Spontaneous Micro-Expression Database and the Baseline Evaluation [J].PLOS ONE,2014,9(1):e86041(2014-01-27).https://doi.org/10.1371/journal.pone.0086041.

[12] DAVISON A K,LANSLEY C,COSTEN N,et al. Samm:A Spontaneous Micro-Facial Movement Dataset [J].IEEE Transactions on Affective Computing,2018,9(1):116-129.

[13] 付晓峰,吴俊,牛力.小数据样本深度迁移网络自发表情分类 [J].中国图象图形学报,2019,24(5):753-761.

作者简介:吴俊(1993—),男,汉族,江西抚州人,助教,硕士研究生,研究方向:人工智能。

收稿日期:2024-01-17