PSOS-YOLOv5s:一种轻量级玉米雄穗快速检测算法

2024-09-19胡阵马宗军黄传宝赵景波唐勇伟郝凤琦

摘 要:针对玉米雄穗检测中速度较慢的问题,提出一种基于YOLOv5s 改进的轻量化快速检测算法———PSOS-YOLOv5s。所提算法在主干网络中采用轻量级PP-LCNet 替换CSPDarknet53,采用2 种不同的深度可分离卷积与注意力机制的组合来构成基本块,降低模型复杂度并加快检测速度;在预测部分采用SimOTA 标签匹配策略替换YOLOv5s 中的标签匹配策略,采用中心先验思想获得精准的先验知识,提出动态k 策略过滤冗余标签,提高模型对正样本的快速选取能力;在预测部分采用SIOULoss 替换GIOU Loss,引入角度损失因子来降低回归自由度、加快收敛速度、节省训练时间,重新定义惩罚指标,提高检测精度。实验结果表明,在玉米雄穗数据集中,提出的改进算法相比于YOLOv5s,模型参数量降低52. 86% ,模型的检测精度提升0. 6% ,模型的检测速度提升65. 5% 。改进后的算法提升效果明显,可以满足大规模玉米雄穗快速检测的要求。

关键词:玉米雄穗检测;轻量化网络;标签匹配策略;损失函数;YOLOv5

中图分类号:TP183 文献标志码:A 开放科学(资源服务)标识码(OSID):

文章编号:1003-3106(2024)06-1446-08

0 引言

玉米是雌雄同株的作物,可以进行自花授粉,但是自花授粉不利于优良种子的选育,因此,保证玉米的异花授粉,对育种以及产量提升有重要意义[1-3]。在异花授粉过程中,需要对雄穗进行去除,传统方法主要依靠人工识别去除,费时费力。现代农业对大规模、高通量分析的需求使得人工无法处理此类任务。计算机视觉技术在农作物识别方面的应用,为准确识别玉米雄穗并高效科学地指导去雄作业提供了有效的技术手段。

目前,玉米雄穗的检测主要分为基于机器视觉检测方法和基于深度学习的目标检测方法。Lu 等[3]开发了基于分割和支持向量机(SupportVector Machine,SVM)的名为mTASSEL 的系统来检测玉米雄穗,并以90. 38% 的准确率识别出具有穗的潜在区域。Yu 等[4]在数据集MrMT 上提出了一种新颖的轻量级神经网络TasselLFANet,可以准确有效地检测和计数高时空图像序列中的玉米雄穗。

近年来,基于深度学习的图像分类、目标检测等技术开始兴起。两阶段的区域卷积神经网络(R-CNN)系列模型[5]是目标检测中的里程碑之一。RCNN 的后续改进包括Fast R-CNN[6]和FasterR-CNN[7],通过引入共享特征提取来提高检测速度和准确性。此外,还有备受关注的一阶段模型SSD[8]模型和YOLO 系列模型。YOLO 模型是一种实时目标检测模型,YOLO[9] 的改进版本包括YOLOv2、YOLOv3、YOLOv4、YOLOv7[10]等,通过改进网络结构和使用更高分辨率的特征图来提高检测性能。Khaki 等[11]提出了一种基于YOLOv4 的计算机视觉方法来检测麦穗。Buzzy 等[12]利用Tiny-YOLOv3 网络准确地检测叶子的实时定位。YOLOv5 是YOLO 系列中成熟的算法,然而,直接应用YOLOv5 进行玉米雄穗检测存在一些挑战:由于玉米雄穗在生长过程中会产生遮挡和重叠现象,目标之间存在遮挡问题,导致检测困难。玉米雄穗一般比较细长,在生长过程中可能会呈现不同的姿态和形状,这些都会导致检测不准确。

为此,本文针对上述问题提出了一种基于YOLOv5s 的玉米雄穗检测模型———PSOS-YOLOv5s,能够快速、准确地检测出田中玉米雄穗的位置,而且参数量、每秒10 亿次的浮点运算数(GFLOPs)和模型复杂度较低。

1 材料和方法

1. 1 数据集

本研究选用的数据集为公开数据集MrMT[13],开发的一种自动化地面观测系统在中国山东省泰安市、河南省郑州市和河北省衡水市的实验田每天9:00—16:00 每小时拍摄一张,包含从抽雄阶段到开花阶段的12 个独立图像序列。该数据集包含不同场景下的玉米雄穗图像,如抽雄阶段到开花阶段的多个时间序列的图像,以及来自不同地点的示例图像。根据标准注释范例,使用开源标注工具labe-lImg 对每个玉米雄穗手动进行框级标记,共标注了96 434 个玉米雄穗。

1. 2 YOLOv5 目标检测算法

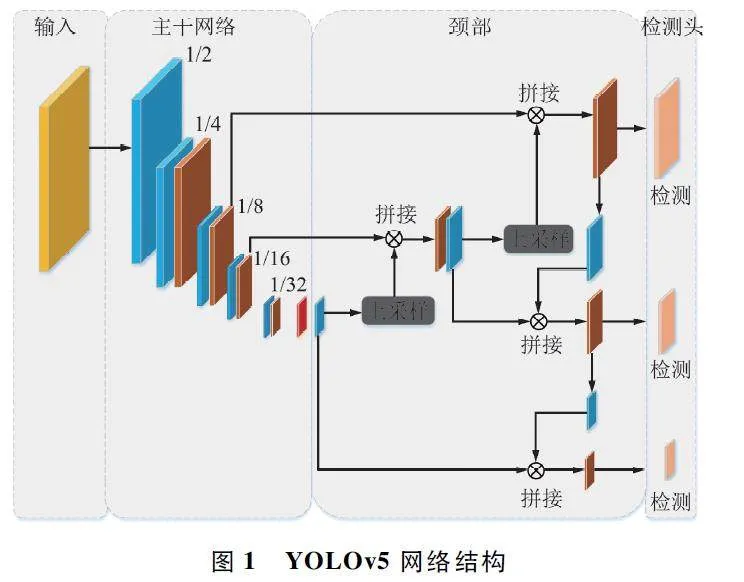

YOLOv5 是Ultralytics 团队于2020 年6 月提出的一种典型的单阶段目标检测算法,将检测任务转化为端到端的回归问题。根据网络结构的深度和宽度,YOLOv5 分为5 个版本:YOLOv5n、YOLOv5s、YOLOv5m、YOLOv5l 和YOLOv5x(n<s<m<l<x),其中n 模型参数量最小,x 模型参数量最大。为了实时检测和易于部署,本文选择YOLOv5s 网络作为基础模型。YOLOv5 网络结构如图1 所示。

YOLOv5 的输入组件如图2 所示,由3 个模块组成:马赛克数据增强、自适应锚框计算和自适应图像缩放。主干部分主要负责提取图像不同层次的图像特征,由CBS、C3 和SPPF 等模块组成。CBS 层由卷积、批量归一化和激活函数组成。C3 模块包括3 个标准卷积层和多个瓶颈。SPPF 使用5×5 和1×1两个池化核,可以增加感受野并输入任意图像长宽比和尺寸。在YOLOv5 主干中使用CBS、SPPF 和C3 架构时的潜在缺点包括计算复杂性和内存使用量增加,导致检测速度变慢和资源需求增加。因此,为了实现网络模型的轻量化,本文采用PP-LCNet[14]作为主干网络。

颈部特征融合网络采用特征金字塔网络(Feature Pyramid Network,FPN)[15]和路径聚合网络(Path Aggregation Network,PAN)[16]的结构。使用GIOU 损失(Loss)函数作为边界框损失函数,解决边界框不重叠的问题。对于GIOU Loss 函数,当2 个边界框相交时,水平和垂直方向的收敛速度都很慢。因此,本文选择SIOU Loss 函数。

1. 3 PSOS-YOLOv5s

为了保证玉米雄穗检测精度,同时尽量加快检测速度,本文提出了一种轻量级网络PSOS-YOLOv5s。

图3 展示了PSOS-YOLOv5s 的整体结构,包括三部分:用于特征提取的主干网络(backbone),用于特征融合的颈部(neck)以及用于位置和类别预测的预测头(head)。为了减少模型参数量和GFLOPs,使用PP-LCNet 作为主干来提取特征。为了改善轻量级网络PP-LCNet 带来的精度损失,本研究将原来的标签匹配策略换成了SimOTA 标签匹配策略并且把GIOULoss 更换为SIOU Loss。SimOTA 可以将筛选样本(anchor point)与真实框(gt)之间的匹配更加合理,SIOU Loss 考虑到了向量角度在回归中的重要性。

1. 3. 1 基于PP-LCNet 的骨干网络

PP-LCNet 是百度在2021 年提出的一种基于深度神经网络的数学内核库(MKLDNN)加速策略的轻量级中央处理器(CPU)网络,提高了轻量级模型在多个任务上的性能。图4 展示了PP-LCNet 的基本模块,其中Hswish 是激活函数,SE 是注意力机制。

该模型使用深度可分离卷积(DepthSepConv)作为基本块,其中不包含直连(shortcut),这样就没有拼接(concat)或逐元素相加(elementwise-add)等操作,这些操作不仅会降低模型的推理速度,而且无法提高小模型的精度。该模型将这些块(block)堆叠成一个基础网络,然后结合现有技术得到了PP-LC-Net。

本文的主干特征网络不仅仅由PP-LCNet 网络组成,将PP-LCNet 网络全局平均池化层换为SPPF层,因此主干特征网络由CBS、DepthSepConv 和SPPF 组成,激活函数的性能往往决定了网络的性能,为了避免大量的指数操作,本文将DepthSepConv 基础网络中的激活函数由ReLU 换成H-Swish,性能得到了很大的提升,而推理时间几乎没有增加。SE 模块自提出以来已被大量网络使用,但在英特尔CPU上,SE 模块会增加推理时间,因此不能在整个网络中都使用。通过大量实验发现将SE 模块用于网络的末端时,可以发挥更好的作用,因此本文只将SE模块用在网络尾端的block 中,获得了更好的精度-速度的平衡。同时卷积核的大小也会影响网络的性能。

M ixNet[17]中分析了不同大小的卷积核对网络性能的影响,最终在网络的同一层中使用不同大小的卷积核。但这种混合降低了网络的推理速度,因此本文在同一层只使用一种大小的卷积核,并确保在低延迟和高精度的前提下才使用大卷积核。通过实验发现,与使用SE 模块位置一样,只在网络的尾部用5×5 卷积替换3 ×3 卷积获得了和整个网络都使用5×5 卷积相近的性能,因此最终只在网络尾部才使用5×5 卷积。此外,该方法显著降低了计算复杂度和参数数量,使其适合在硬件有限的设备上部署。

1. 3. 2 SimOTA

本文采用YOLOX[18]提出的SimOTA 标签匹配策略来替换YOLOv5s 中的标签匹配策略。

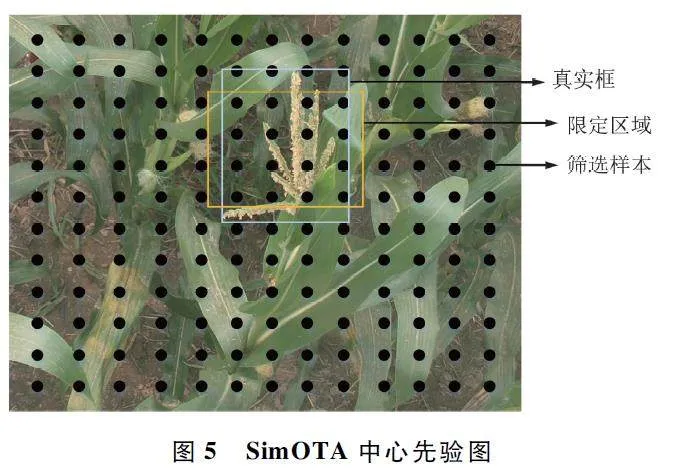

SimOTA 中的中心先验思想提供了更加精准的先验知识,提高了标签匹配的准确性。OTA[19]中通过Sinkhorn-Knopp 算法解决最优传输(OptimalTransport,OT)问题,但会带来25% 的额外训练时间,所以将其简化为动态k 策略,称为SimOTA,以获得近似解。与OTA 相比,SimOTA 运算速度快、训练时间短,大大提高了模型的每秒传输帧数(FPS),而且避免了额外的参数优化,并且提升了检测精度。SimOTA 中心先验图如图5 所示,gt 代表真实物体的标注框,限定区域也是中心先验区域。

在SimOTA 中,gi 和pj 之间的成本(cost)计算如下,其中gi 是任意真实框,pj 是任意预测框:

cij = Lclsij + λLregij , (1)

式中:λ 为平衡系数,本文取3;Lclsij 和Lregij 为gi 和pj之间的分类损失和回归损失。对于一张图上的所有anchor point 来说,整个匹配策略的代价是所有特征点与每一个gt 所产生的分类损失与回归损失之和。

SimOTA 会筛选出优质的正样本来匹配gt,从而减少这个匹配过程所产生的cost,首先SimOTA 进行预筛选,gt 的中心区域更有可能筛选出优质的正样本使得边界回归损失与分类损失较小,也就是匹配策略中的cost 较小。进行预筛选之后,cost 会有显著的下降,从而可以在这个限定区域内进行进一步的筛选,从而获得最后的anchor point。分别对限定区域中每一个anchor point 计算其相对于每一个gt的分类损失(cls Loss)、边界框损失(reg Loss)。从而根据分cls_Loss、reg_Loss 获取cost 矩阵以及交并比(Intersection Over Union,IOU)矩阵,每一个gt 匹配到的anchor point 数量记为s,将这个数与10 对比,取其中的最小值,然后根据IOU 来取前s 个或者10 个anchor point。将所有与当前gt 匹配的正样本求IOU 后进行求和并向下取整,得到的数即为动态k。得到动态k 后,选择cost 较小的前动态k 个样本作为当前匹配。如果同一正样本被分配到不同的gt真值,则选择cost 值较小的gt 真值负责预测。

此时得到所有的正样本以及正样本对应的gt,那么剩下的anchor point 全部归为负样本。对筛选预测框进行Loss 计算,要注意这里的reg Loss 和clsLoss 只针对目标框和筛选出的正样本预测框进行计算,而obj Loss 还是针对所有的anchor point(包含所有的正样本与负样本),损失函数如下:

式中:Lcls 表示分类损失,Lreg 表示边界框损失,Lobj 表示置信度损失,β 表示定位损失的平衡系数,本文设置为5. 0;Npos 表示被分为正样本的anchor point 数。

采用SimOTA 来进行标签匹配可以将限定区域内每一个anchor point 匹配到最合适的gt,大大提高了检测的速度和精度。

1. 3. 3 SIOU 损失函数

YOLOv5 中的损失函数包括三部分:分类损失、边界框损失和置信度损失。分类损失用来计算锚框与对应的标定分类是否正确,边界框损失用来计算预测框与标定框之间的误差,置信度损失用来计算网络的置信度。其中边界框损失用GIOU Loss[20]来计算。

GIOU Loss 函数在IOU 的基础上引入了预测框和真实框的最小外接矩形。假设bgt 为真实框,b 为预测的边界框,C 为A 和B 的最小外接矩形,则GIOU Loss 计算公式如下:

GIOU = IOU -( C - (b ∪gt)/C ), (3)

LGIOU = 1 - GIOU。(4)

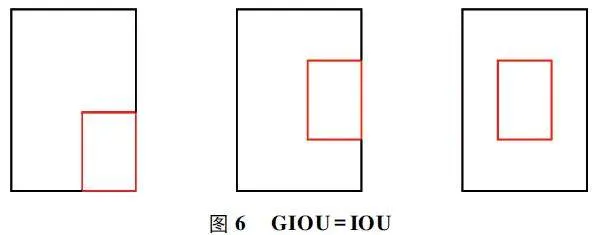

当预测框和真实框完全重合时(预测框在真实框的内部),如图6 所示,IOU 和GIOU 的损失值都一样,此时GIOU 退化为IOU,GIOU = IOU,最终还是无法区分预测框和真实框的位置关系,导致此时的边界框回归收敛很慢,检测结果失准。

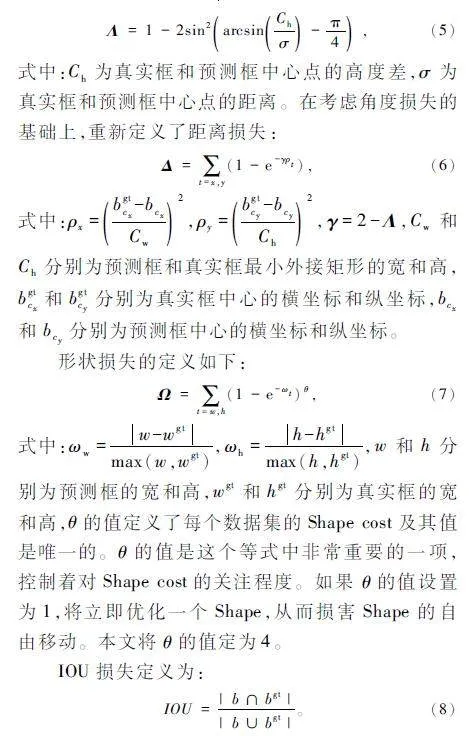

为了解决上述问题,本文使用SIOU Loss[21]代替GIOU Loss。SIOU 函数引入了真实框和预测框之间的向量角度,重新定义了相关损失函数,加快了网络收敛的速度,提升了回归精度。SIOU 损失函数具体包含四部分:角度损失(Angle cost)、距离损失(Distance cost)、形状损失(Shape cost)和IOU 损失(IOU cost)。

角度损失定义为:

最后,SIOU Loss 函数定义为:

LSIOU = 1 - IOU +( Δ + Ω/2) 。(9)

SIOU Loss 考虑到了所需回归之间的向量角度,引入角度损失因子来降低回归自由度,加快了收敛速度,而且重新定义了惩罚指标,提高了训练的速度和推理的准确性。

2 实验和结果

2. 1 实施细节

主要实验参数如下:本研究的训练数据集由从公开的MrMT 数据集中随机选择的1 120 张图像组成。验证集和测试集分别为480 张和368 张。所有实验均在使用PyTorch 1. 10 和CUDA 11. 3 实现的深度学习框架上进行,并在4 张具有40 GB 显存的NVIDIA A100 GPU 上执行。

为了反映模型的真实水平,本研究没有选择使用迁移学习。鉴于数据集中图像的高分辨率,将大小调整为640 pixel×640 pixel。使用单周期学习率调度的方法从0. 01 开始调度学习率。训练使用动量为0. 937 的随机梯度下降(Stochastic Gradient Descent,SGD)优化器进行,batch size 设为128,持续300 个epoch。

2. 2 与其他目标检测模型的对比

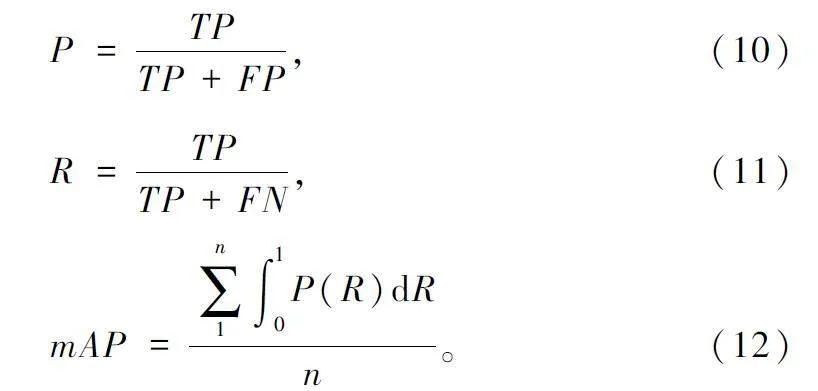

2. 2. 1 评价指标

在本研究中,改进的YOLOv5s 模型与其他模型相比的评价指标主要基于FPS、精度(Precision,P)、召回率(Recall,R)和平均精度均值(mean AveragePrecision,mAP)。TP、FP 和FN 分别是被模型预测为正类的正样本数、被模型预测为正类的负样本数和被模型预测为负类的正样本数。此外,本研究还综合考虑了模型参数、GFLOPs 以及权重大小。因为数据中只有一个类别(玉米雄穗),所以n 为1。mAP@ 0. 5 表示IOU 阈值为0. 5 时的平均mAP。mAP @ 0. 5:0. 95 表示不同IOU 阈值下mAP 的平均值(从0. 5 到0. 95,步长为0. 05)。各个评价指标的计算公式如下:

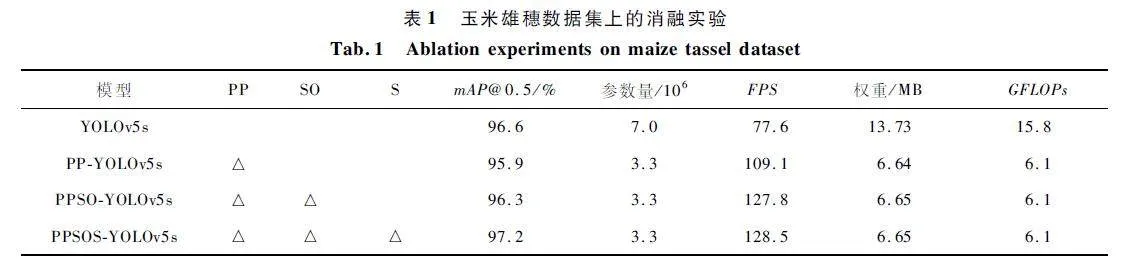

2. 2. 2 消融实验

利用消融实验来评估网络结构变化的影响。进行了4 组消融实验,结果如表1 所示。在消融实验中,本文将PP-LCNet 骨干网络缩写为PP,将SimOTA 缩写为SO,将SIOU Loss 函数缩写为S,其中△ 代表替换相应的模块。从表1 可以看出,与YOLOv5s 相比,PP-YOLOv5s 的参数量、权重大小和GFLOPs 分别降低了52. 86% 、51. 64% 和61. 40% ,FPS 提高了40. 59% ,以上提升表明了以PP-LCNet为主干网络提取特征实现了网络的轻量化,提高了网络检测速度。与PP-YOLOv5s 相比而言,PPSO-YOLOv5s 的mAP 提高了0. 4% ,FPS 提升了18. 7,表明了本文采用的SimOTA 标签分配策略不仅提升了模型的检测精度,还提升了一定的检测速度。与PPSO-YOLOv5s 比较,PPSOS-YOLOv5s 的mAP 提升了0. 9% ,FPS 也有一定的提升,这也证实了SIOULoss 函数可以有效地提高检测精度和速度。综上所述,与原始YOLOv5s 模型相比,PPSOS-YOLOv5s 的参数量、模型权重和GFLOPs 分别降低了52. 86% 、51. 57% 和61. 40% ,而mAP 提升了0. 6% ,FPS 提升了65. 5% 。上述分析表明本文提出的改进模型具有较理想的检测精度和速度。

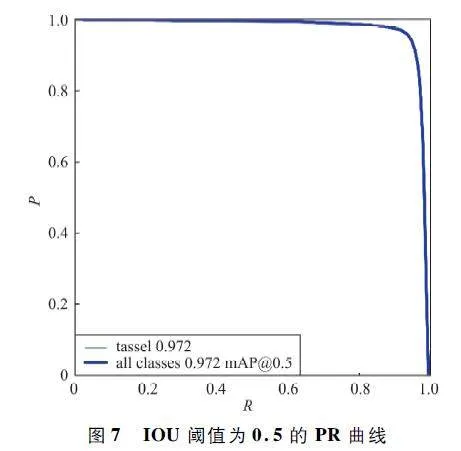

图7 是IOU 阈值为0. 5 时的PR 曲线图。蓝色曲线与横纵坐标之间的面积表示该类别的平均精度(Average Precision,AP),面积越大,检测效果越好。可以看出,玉米雄穗的AP 值为97. 2% ,本文提出的模型能够准确地检测出玉米田中的雄穗。

2. 2. 3 实验结果对比

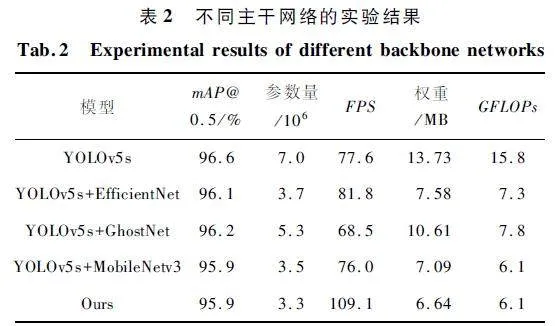

为了与基于PP-LCNet 的主干进行比较,本研究在网络其余部分保持不变的基础上用一些轻量级网络,例如MobileNetv3[22]、GhsotNet[23]和Efficient-Net[24]替换掉原来YOLOv5s 的主干。实验结果如表2 所示,与其他的轻量网络相比,在保证精度的基础上,PP-LCNet 显著地降低了参数量和模型的复杂程度。与此同时,模型的检测速度提升较为理想。

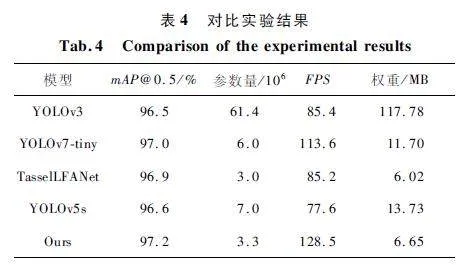

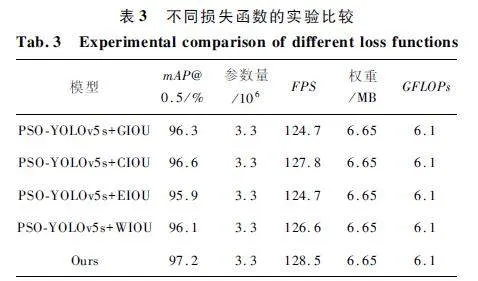

为了验证将SIOU Loss 函数替换掉GIOU Loss 的有效性,本文将SIOU Loss 函数应用于PSO-YOLOv5s模型中,并与CIOU、EIOU、WIOU 和GIOU 损失函数进行比较。如表3 所示,SIOU Loss 达到了最大的mAP 和最快的检测速度,验证了改进的有效性。

为了探究提出的PSOS-YOLOv5s 模型在玉米雄穗数据集上的检测精度、参数量、FPS 以及权重大小4 个评价指标,本文将其与YOLOv3、YOLOv7-tiny、TasselLFANet 以及YOLOv5s 四种模型进行比较。通过表4 可以看出,除TasselLFANet 以外,本文提出的改进模型的评价指标表现最佳,虽然TasselLFANet 参数量和权重大小比本文提出的模型要小,但是本文改进模型在检测精度和FPS 上表现更佳。本文提出的改进模型权重大小为6. 65 MB,参数数量仅为3. 3 M,但是mAP@ 0. 5 达到了97. 2% ,FPS 高达128. 5。

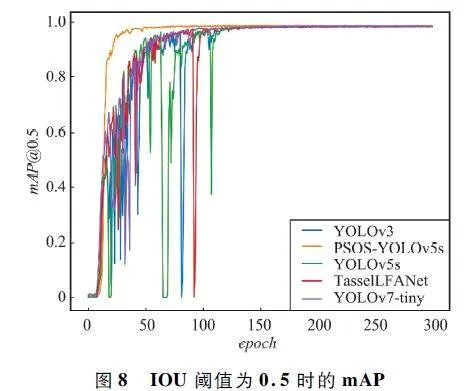

PSOS-YOLOv5s 与其他4 个模型的mAP @ 0. 5对比曲线如图8 所示,可以看出本文改进网络由于采用了SIOU Loss 损失函数和SimOTA 的标签匹配策略,收敛速度大大加快,虽然用更轻量化的网络替换了主干网络,但mAP 值依然有提升。

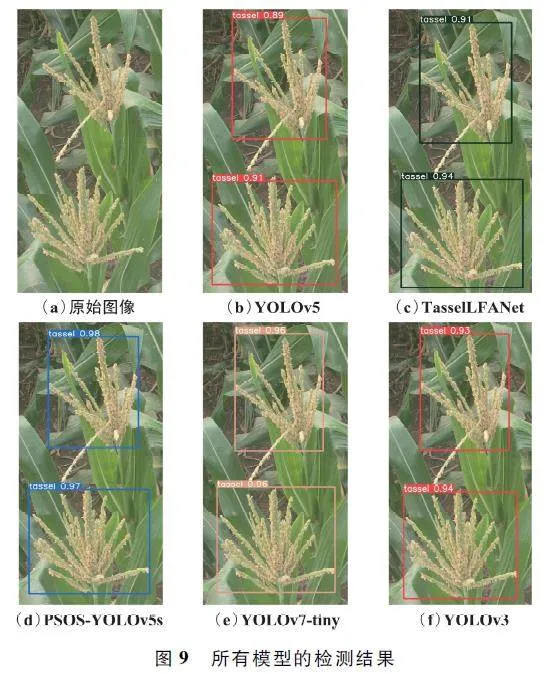

图9 展示了5 个模型的玉米穗检测结果。可以看出,本文提出的PSOS-YOLOv5s 模型,玉米雄穗检测的置信度分别为0. 98 和0. 97,明显高于其余4 个模型,充分展现了模型的优异检测性能。

3 结束语

本文提出了一种基于YOLOv5s 改进的轻量化网络模型———PSOS-YOLOv5s,在保证检测精度的基础上,可以显著提升检测速度。该模型利用轻量级网络PP-LCNet 结构作为提取特征的骨干网络,明显降低了模型的参数量和复杂度。为了弥补轻量化主干造成的检测精度下降,在检测头部分将标签匹配策略换为SimOTA 标签匹配策略,并且将边界框回归损失函数更换为更快、更准确的SIOU Loss。根据消融和对比实验得出的结果,本文提出的模型在玉米雄穗数据集上实现了FPS 高达128. 5,提升了65. 5% 。参数量、模型权重和GFLOPs 分别降低了52. 86% 、51. 57% 和61. 40% ,而mAP 提升了0. 6% 。为以后大规模玉米雄穗快速检测的实现提供了新的实用方法。

参考文献

[1] GAGE J L,MILLER N D,SPALDING E P,et al. TIPS:ASystem for Automated Imagebased Phenotyping of MaizeTassels [J]. Plant Methods,2017,13:21.

[2] HUANG J X,G?MEZDANS J L,HUANG H,et al. Assimilation of Remote Sensing into Crop Growth Models:Current Status and Perspectives [J]. Agricultural andForest Meteorology,2019,276-277:107609.

[3] LU H,CAO Z G,XIAO Y,et al. Finegrained MaizeTassel Trait Characterization with Multiview Representations [J ]. Computers and Electronics in Agriculture,2015,118:143-158.

[4] YU Z H,YE J X,LI C N,et al. TasselLFANet:A NovelLightweight Multibranch Feature Aggregation Neural Network for Highthroughput Imagebased Maize Tassels Detection and Counting [J]. Frontiers in Plant Science,2023,14:1158940.

[5] GIRSHICK R,DONAHUE J,DARRELL T,et al. RichFeature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]∥Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Columbus:IEEE,2014:580-587.

[6] GIRSHICK R. Fast RCNN [C ]∥ Proceedings of theIEEE International Conference on Computer Vision. Santiago:IEEE,2015:1440-1448.

[7] REN S Q,HE K M,GIRSHICK R,et al. Faster RCNN:Towards Realtime Object Detection with Region ProposalNetworks [J]. IEEE Transactions on Pattern Analysis &Machine Intelligence,2017,39(6):1137-1149.

[8] LIU W,ANGUELOV D,ERHAN D,et al. SSD:SingleShot Multibox Detector [C]∥ European Conference onComputer Vision. Amsterdam:Springer,2016:21-37.

[9] REDMON J,DIVVALA S,GIRSHICK R,et al. You OnlyLook Once:Unified,Realtime Object Detection[C]∥Proceedings of the IEEE Conference on Computer Vision andPattern Recognition. Las Vegas:IEEE,2016:779-788.

[10] WANG C Y,BOCHKOVSKIY A,MARK H Y. YOLOv7:Trainable Bagoffreebies Sets New Stateoftheart forRealtime Object Detectors [C ]∥ Proceedings of theIEEE / CVF Conference on Computer Vision and PatternRecognition. Vancouver:IEEE,2023:7464-7475.

[11] KHAKI S,SAFAEI N,PHAM H,et al. WheatNet:ALightweight Convolutional Neural Network for Highthroughput Imagebased Wheat Head Detection andCounting [J]. Neurocomputing,2022,489:78-89.

[12] BUZZY M,THESMA V,DAVOODI M,et al. RealtimePlant Leaf Counting Using Deep Object DetectionNetworks[J]. Sensors,2020,20(23):6896.

[13] YU Z H,CAO Z G,WU X,et al. Automatic ImagebasedDetection Technology for Two Critical Growth Stages ofMaize:Emergence and Threeleaf Stage [J]. Agriculturaland Forest Meteorology,2013,174-175:65-84.

[14] CUI C,GAO T Q,WEI S Y,et al. PPLCNet:ALightweight CPU Convolutional Neural Network [EB /OL]. (2021 - 09 - 17)[2023 - 08 - 12]. https:∥ arxiv.org / abs / 2109. 15099.

[15] LIN T Y,DOLL?R P,GIRSHICK R,et al. FeaturePyramid Networks for Object Detection[C]∥Proceedingsof the IEEE Conference on Computer Vision and PatternRecognition. Honolulu:IEEE,2017:936-944.

[16] LIU S,QI L,QIN H F,et al. Path Aggregation Network forInstance Segmentation [C]∥ Proceedings of the IEEEConference on Computer Vision and Pattern Recognition.Salt Lake City:IEEE,2018:8759-8768.

[17] TAN M, LE Q V. MixConv: Mixed DepthwiseConvolutional Kernels [EB / OL]. (2019-07-22)[2023-08-12]. https:∥arxiv. org / abs / 1907. 09595.

[18] GE Z,LIU S T,WANG F,et al. YOLOX:ExceedingYOLO Series in 2021 [EB / OL]. (2021-07-18)[2023-08-12]. https:∥arxiv. org / abs / 2107. 08430.

[19] GE Z,LIU S T,LI Z M,et al. OTA:Optimal Transport Assignment for Object Detection [C]∥ Proceedings of theIEEE / CVF Conference on Computer Vision and PatternRecognition. Nashville:IEEE,2021:303-312.

[20] REZATOFIGHI H,TSOI N,GWAK J,et al. GeneralizedIntersection over Union:A Metric and a Loss for BoundingBox Regression[C]∥Proceedings of the IEEE / CVF Conference on Computer Vision and Pattern Recognition. LongBeach:IEEE,2019:658-666.

[21] GEVORGYAN Z. SIoU Loss:More Powerful Learning forBounding Box Regression [EB / OL]. (2022 - 08 - 25 )[2023-09-01]. https:∥arxiv. org / abs / 2205. 12740.

[22] HOWARD A,SANDLER M,CHEN B,et al. Searching forMobileNetV3[C]∥Proceedings of the IEEE / CVF International Conference on Computer Vision. Seoul:IEEE,2019:1314-1324.

[23] HAN K,WANG Y H,TIAN Q,et al. GhostNet:More Features from Cheap Operations [C]∥ Proceedings of theIEEE / CVF Conference on Computer Vision and PatternRecognition. Seattle:IEEE,2020:1577-1586.

[24] TAN M X,PANG R M,LE Q V. EfficientDet:Scalableand Efficient Object Detection[C]∥ Proceedings of theIEEE / CVF Conference on Computer Vision and PatternRecognition. Seattle:IEEE,2020:10778-10787.

作者简介

胡 阵 男,(1999—),硕士研究生。主要研究方向:目标检测、多源遥感数据融合。

马宗军 男,(1997—),硕士研究生。主要研究方向:控制工程。

黄传宝 男,(1998—),硕士研究生。主要研究方向:计算机视觉、语音情感识别。

赵景波 男,(1971—),博士,教授。主要研究方向:机器人工程、计算机控制。

唐勇伟 男,(1991—),博士研究生,助理研究员。主要研究方向:工业物联网、智能感知和控制等。

(*通信作者)郝凤琦 男,(1979—),硕士,副研究员。主要研究方向:网络协议、人工智能和嵌入式系统等。

基金项目:山东省科技型中小企业创新能力提升工程项目(2023TSGC0111,2023TSGC0587);青岛市民生计划(22-3-7-xdny-18-nsh);山东省重点研发计划(软科学项目)(2023RZA02017);山东省重大科技创新工程项目(2019JZZY020603)