深度掩膜布朗距离协方差小样本分类方法

2024-08-17苟光磊朱东华李小菲韩岩奇

摘 要:针对小样本学习中,布朗距离协方差通过改善特征嵌入提升分类精度,但未聚焦分类中样本相关性特征的问题,提出了深度掩膜布朗距离协方差方法。该方法通过每对查询集与支持集之间的高维语意关系,生成查询引导掩膜,并将掩膜后的布朗距离协方差矩阵用作图像特征表示。分别在5way-1shot和5way-5shot情形下,对CUB-200-211、Mini-ImageNet及Tiered-ImageNet数据集进行评估验证,实验表明,深度掩膜布朗距离协方差方法取得了更优的分类精度。

关键词:小样本学习;掩膜;布朗距离协方差;图像识别

中图分类号:TP391 文献标志码:A 文章编号:1001-3695(2024)07-044-2229-06

doi: 10.19734/j.issn.1001-3695.2023.09.0514

Deep mask Brownian distance covariance for few-shot classification

Abstract: In few-shot learning, the Brownian distance covariance improves classification accuracy by enhancing feature embeddings, but it does not focus on the issue of sample-related features in classification. This paper proposed the deep masked Brownian distance covariance method that generated query-guided masks based on high-dimensional semantic relationships between each pair of query and support samples, and employed the masked Brownian distance covariance matrix as the image features. Under the 5way-1shot and 5way-5shot scenarios, it carried out validation and evaluation on CUB-200-211, Mini-ImageNet, and Tiered-ImageNet datasets. The experiments show that this method achieves superior classification accuracy.

Key words:few-shot learning; mask; Brownian distance covariance; image recognition

0 引言

人工智能技术飞速发展的当下,大数据的处理与运用正逐步成为衡量科技水平的一大重要标准。深度学习(deep lear-ning)作为人工智能技术中不可或缺的一环,被广泛应用于自动驾驶、图像识别、情感分析、文本辨识等领域,其借助海量数据支撑计算机学习,达到解决实际问题的目的,并取得了瞩目的成果。这些优异的成绩都要依托于蓬勃发展的算力资源,促进机器从大量的数据中学习知识信息,并应用于现实场景。然而并不是所有的问题都有与之适应的海量数据用作训练。诸如,濒危动物识别、军事武器识别、罕见疾病识别等。由于其已知样本稀少的缺点,传统的深度学习方法在识别精度方面明显捉襟见肘,所以小样本学习(few-shot learning,FSL)[1,2]的概念应运而生。

小样本学习的灵感源于实际生活,人类可以在只有少量学习数据或图像的情况下习得相关知识,认识新事物。例如:资深的医生能通过少数的症状来判断患者是否患有某种罕见疾病。这不同于深度学习中图像识别需要大量训练代价,即对海量图像数据训练,且对训练图像的获取及标注也有一定要求,从而耗费巨大的时间和人力成本。小样本学习的出现,旨在通过极少量的样本学习,高效地获取知识,赋予机器快速学习的能力。

目前小样本学习还面临着诸多挑战:由于只有极少量的样本,提取的信息量有限;如何利用好暨有的样本信息,避免过拟合,更加精准地进行识别显得至关重要。当前较为有效的方法是基于迁移学习的方法,它包含基于度量的学习方法[3]和基于元学习的方法。迁移学习方法将数据集划分为训练集(training set)、支持集(support set)和查询集(query set)三个部分。度量学习方法中,通常用欧氏距离或余弦距离衡量支持集和查询集之间的相似性,以识别查询集样本。而元学习方法(meta-learning),亦称学会学习(learning to learn),主要通过大量的先验任务学习元知识,继而指导模型在后续新的小样本任务中更快地学习。两者都采用了episodic training的训练模式,将数据集细分为多个小的子任务进行训练。

小样本学习经过近些年的研究与发展,可应对不同的使用场景,萌生了诸多优秀的方法。Snell等人[4]提出了原型网络(prototypical network,ProtoNet),通过将分类问题看作是寻找语义上的类中心点的方式,不断拟合类别中心,提炼类原型,用作分类。随后,Sung等人[5]提出了关系网络(relation network,RN),利用4层的卷积神经网络提取低维嵌入,并使用ReLU函数进行相似性度量。在此基础上,Zhang等人[6]提出了深度比较网络(deep comparison network,DCN),将关系模块与嵌入学习模块细分成多个子模块,并一一对应建立联系,各自打分并计算匹配度。Yu等人[7]提出了多任务聚类元学习方法,根据任务生成多个簇,每个簇具有相似的任务,模型参数由各簇的适应参数线性表示。Wang等人[8]提出了任务感知特征嵌入网络(TAFE-Net),首次将标签嵌入纳入到网络架构中来对图像特征的权重进行预测,使得语义信息与图像信息融合。Tian等人[9]提出了基于优秀嵌入的方法(good embedding),探讨了特征嵌入表示在小样本学习任务中的重要性,与传统元学习方法比较,仅在微调(fine-tunning)阶段就能达到与之相似的效果,为小样本学习打开了一扇新的大门。Zhang等人[10]提出基于推土距离的小样本学习方法(differentiable earth mover’s distance,EMD),借助差分EMD用于图像区域间的最佳匹配运算,借助大量的计算获得了不俗的性能。

现有统计学方法,将图像特征看作高维空间中的随机向量,并以概率分布衡量图像之间的相似程度。通常使用原型网络(ProtoNet)对图像表征,辅以欧几里德距离或余弦距离进行度量学习。Li等人[11]提出了协方差度量网络(covariance metric network,CovaMNet),利用协方差矩阵的二阶统计信息衡量查询集样本与支持集样本间分布的一致性。由于缺乏对图像局部特征的考量,Li等人[12]又提出了深度最近邻神经网络(DN4),在网络的末层使用局部描述代替图像特征,为每个查询样本的局部特征计算相似性,加和后得到查询样本的相似性。Xie等人[13]提出深度布朗距离协方差方法(deep Brownian distance covariance,DeepBDC),在二阶矩阵(covariance matrix)协同Kullback-Leiberler(KL)散度度量方法的基础上,综合考量边缘分布(marginal distribution)和联合分布(joint distribution)生成BDC矩阵用作图像表征,并将成对图像之间的BDC矩阵内积用作类间相似度的衡量指标,进行分类任务。

掩膜最早应用于CNN池化层中的最大池化,通过引入掩膜标记最大池化位置,从而记录最大池化前的位置信息,以解决最大池化可能导致的信息丢失问题。另一个重要的模型Transformer中的自注意力机制,通过计算输入序列中不同位置之间的相关性来获得每个位置的表示。为了处理可变长度的序,也采用掩膜来屏蔽无效位置。例如,在机器翻译任务中,可以使用掩码将当前位置之后的位置屏蔽掉,以防止模型在生成目标序列时能够“看到”未来的信息。目前,掩膜被广泛应用于图像分割、目标检测、图像生成等任务中。

尽管DeepBDC方法在传统方法与统计学方法中脱颖而出,取得了不俗的效果,但在特征的着重点上仍存在着注意力不集中的问题,使得某些相近类的重要特征权重占比不明显,忽略了一些能够对小样本图像分类起到重要作用的样本信息,使得布朗距离协方差在衡量图像上存在短板。基于上述问题,本文的工作如下:提出一种深度掩膜布朗距离协方差方法,针对不同类别的图像具有的特征差异化问题,在生成的布朗距离协方差矩阵中引入了掩膜的方法,指导查询样本与支持样本进行相似性度量时,将注意力侧重在更能凸显出某类图像的表征上,进而取得更为精准的分类。

1 Deep Mask-BDC深度掩膜布朗距离协方差方法

1.1 布朗距离协方差

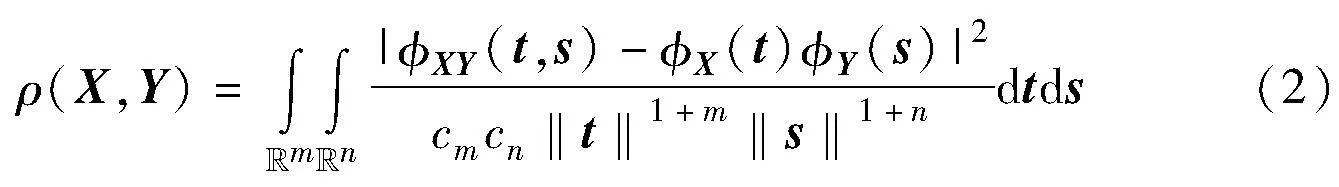

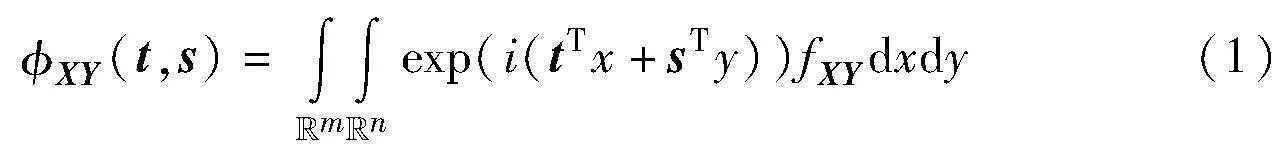

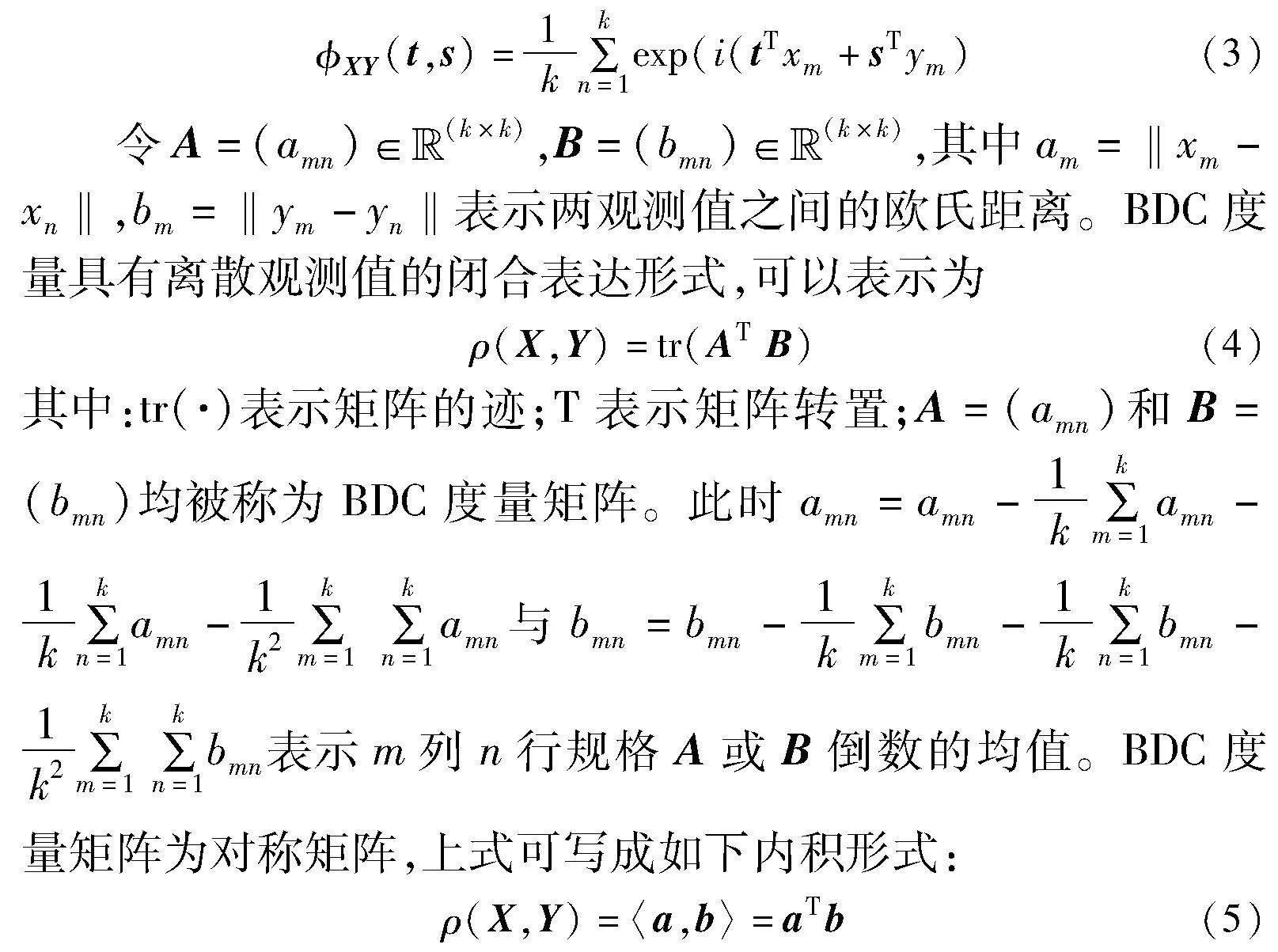

布朗距离协方差矩阵(BDC)[14]主要用于处理特征函数。设存在m维随机向量X及n维随机向量Y,使得X∈Euclid ExtraaBpm,Y∈Euclid ExtraaBpn,X与Y的概率分别定义为fX和fY,则联合概率密度为fXY。此时,X和Y的联合特征函数定义为

其中:i为虚单位;t和s为两随机向量。

令X、Y分别表示X和Y的特征函数,此时支持集或查询集图像的边缘分布可写为X(t)=XY(t,0)和Y(s)=XY(0,s)。当且仅当XY(t,s)=X(t)Y(s)时,独立性成立。假设X和Y具有有限的一阶矩,BDC度量定义为

其中:cm=π(1+m)/2/Γ((1+m)/2),Γ为伽马函数;‖·‖表示欧氏距离。对于形如(x1,y1),…,(xk,yk)的k个x与y的观测值集合,BDC度量一般可根据式(3)的经验特征函数定义。

其中:a和b均为BDC矩阵A和B的上三角矩阵;ρ(X,Y)为衡量分类标准的BDC度量。

1.2 深度掩膜布朗距离协方差

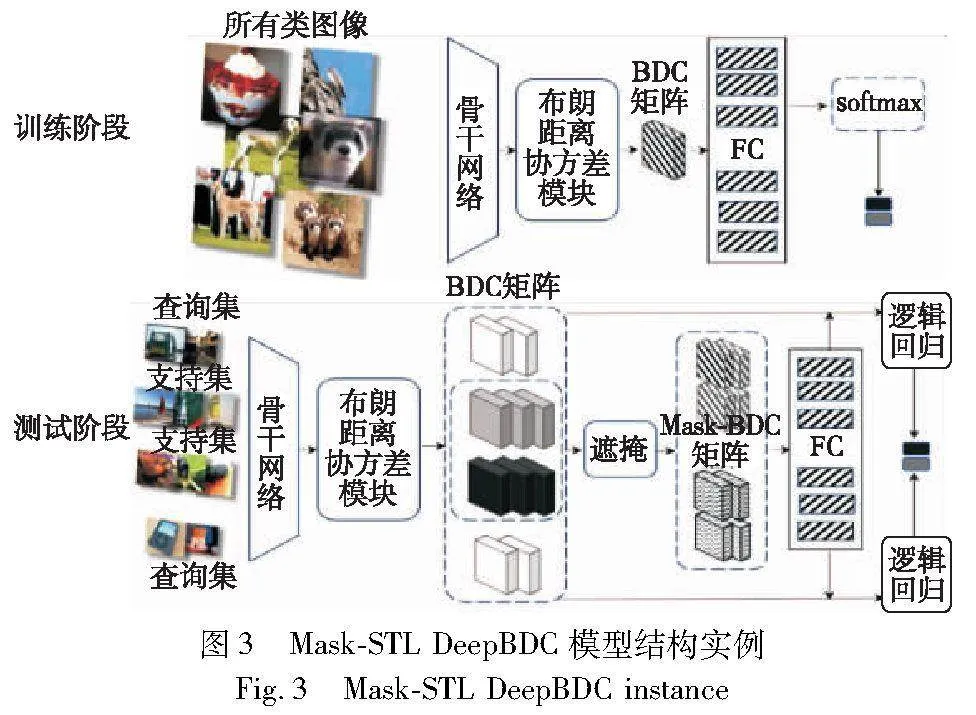

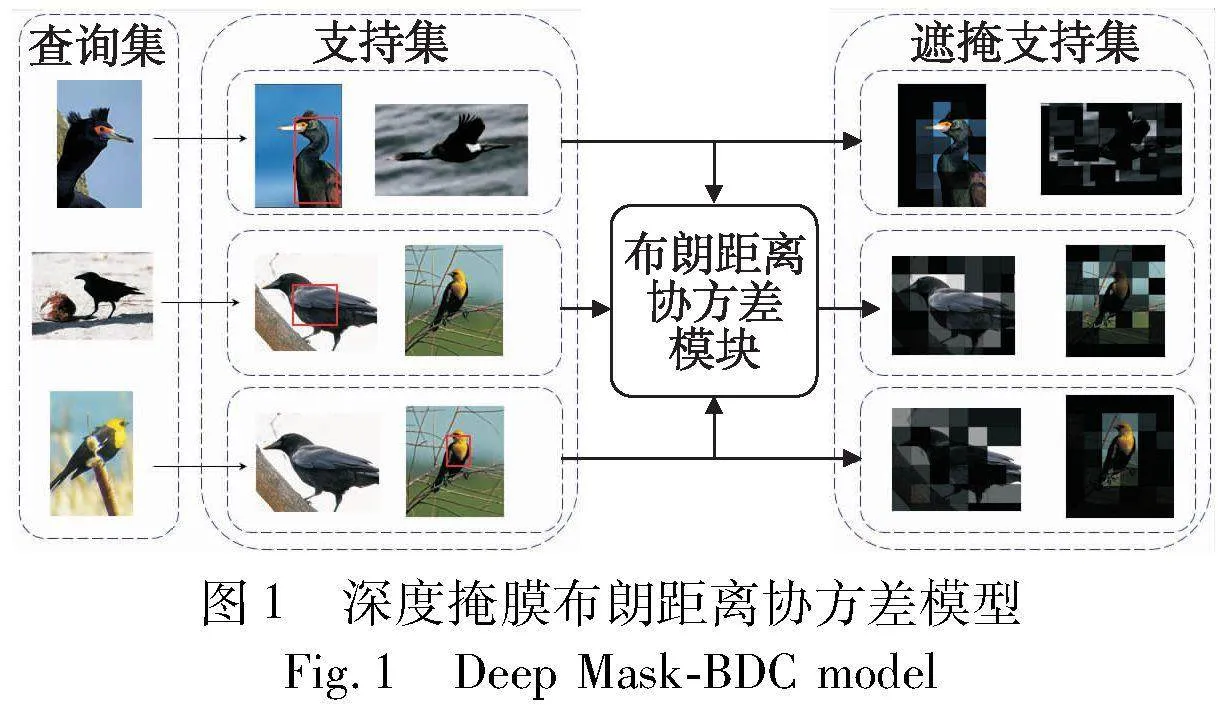

使用布朗距离协方差处理的图像特征,虽然将联合分布和边缘分布进行了综合考量,但未考虑成对支持样本与查询样本间独有的分布关系。对于每个分类任务采用统一的分布关系,这将导致大量类别差异明显的图像被正确分类,而差异较小的图像分类存在难以分辨的情况。掩膜方法就是应用在成对图像间进行区域像素信息标记的方法,可以通过掩膜将成对图像间重要区域像素信息进行标记,解决差异化较小图像间分类难以分辨的问题。因此本文提出一种深度掩膜布朗距离协方差方法Deep Mask-BDC,如图1所示。

掩膜是对于同一支持样本,通过成对查询样本和支持样本间高维语义乘积关系矩阵,经多层感知机计算得到,并结合支持集布朗距离协方差矩阵进行相似性度量。以达到提升度量时各查询样本与支持样本特征差异化的目的,即突出查询样本与当前支持样本间更为明显的特征,对样本差异较小的图像分类任务作出针对性的优化调整,并在元学习和简单迁移学习情境下有着不同的实现方式。

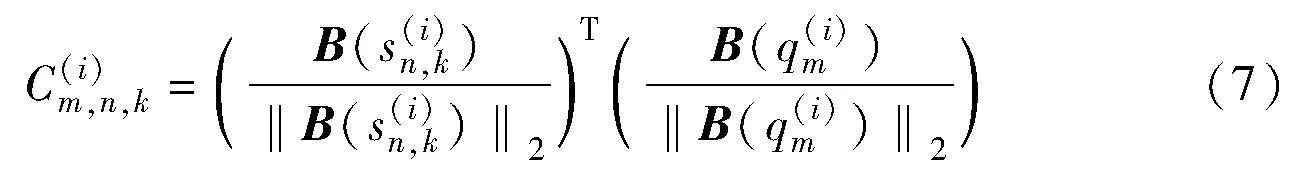

其中:Sk为支持集图像集合中一系列样本。各类BDC原型矩阵与查询集矩阵同时传入掩膜模块,并针对成对的支持集原型BDC矩阵和查询集BDC矩阵采用余弦距离计算语义相关性。

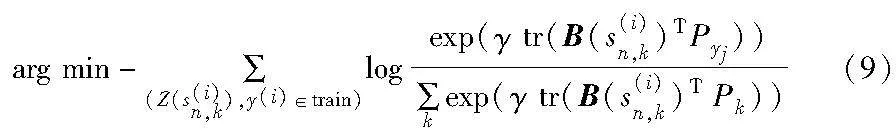

基于到支持集原型类之间距离上的softmax,采用如下损失函数,其中γ为可学习尺度参数从海量的元训练集中抽取类别数远大于N的任务来训练学习器,之后持续从元测试集中抽取任务来进行评估。

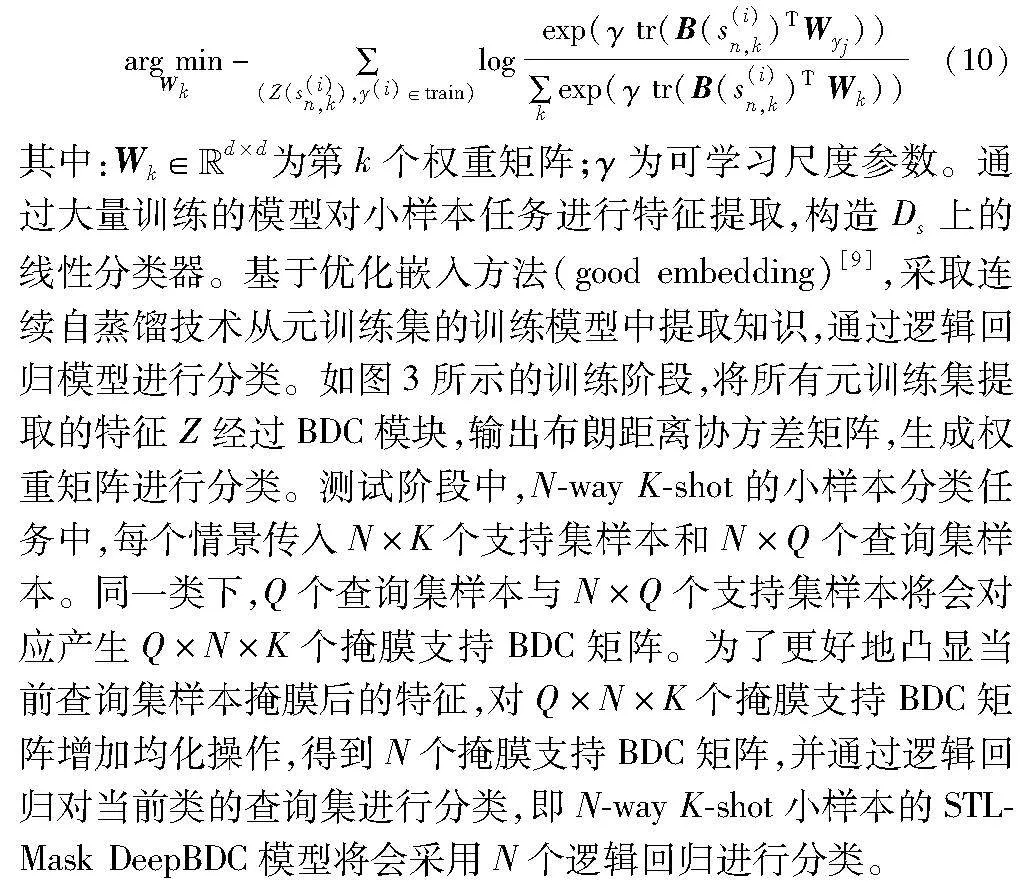

基于简单迁移学习(simple transfer learning, STL)框架亦可增添掩膜操作提升分类精度。原始的STL方法通过在大量数据集上训练深度网络,形成已有的知识体系,并生成嵌入模型,用于提取下游任务的特征。

将包含所有类的整个元训练集用作训练图像分类任务的基准,形成嵌入模型。使用预测值和真实值之间的交叉熵损失来训练学习器。

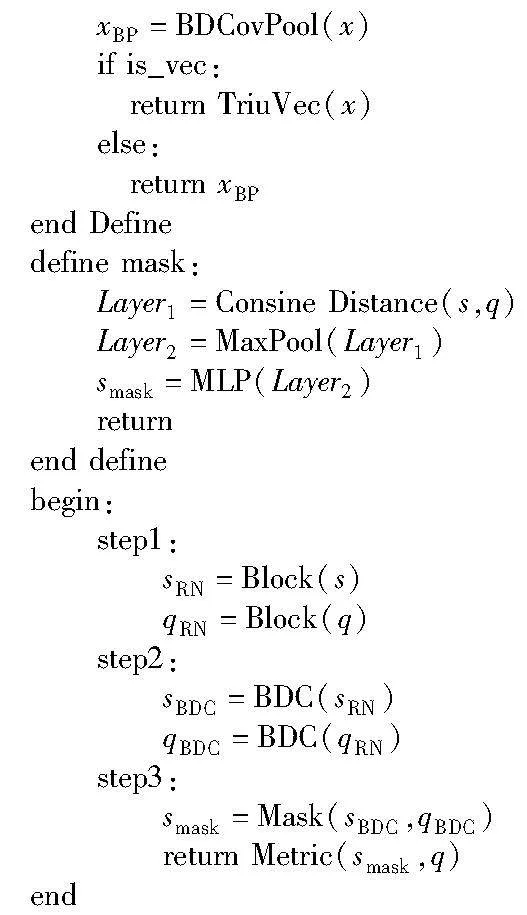

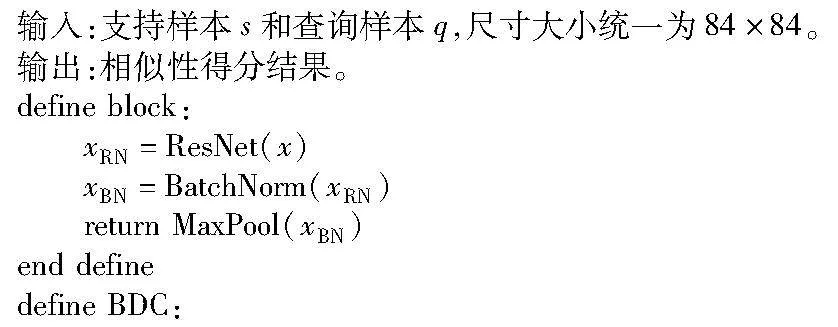

算法1为深度掩膜布朗距离协方差方法的伪代码实现过程,输入为成对的支持样本与查询样本,输出为相似性得分结果。内部定义了三个模块,分别为提取特征ResNet12的骨干网络,计算布朗距离协方差的BDC模块,以及通过高维语义遮掩支持样本特征的mask模块。

算法1 深度掩膜布朗距离协方差

2 实验与分析

本文采用配置为 Intel Xeon CPU E5-2680 v4 @ 2.40 GHz,30 GB RAM,NVIDIA RTX3090 24 GB,Ubuntu 20.04系统的计算机进行实验。

2.1 数据集

本文主要对Mini-ImageNet、Tiered-ImageNet及CUB-200-2011三个数据集进行对比实验。前两者为图像分类任务中的常用数据集,后者为细粒度图像分类中的数据集。其中Mini-ImageNet和Tiered-ImageNet均从ImageNet 1K(ILSVRC2012)中划分得来。具体数据集细分如表1所示。

Mini-ImageNet有100个类别,每个类别下均有600张图像,使用Vinyals等人[19]的数据集划分方式,且没有将图像大小重新设置为84×84,而是保留原始图像尺寸作为模型输入。

Tiered-ImageNet较之Mini-ImageNet最大的不同在于,其包含了ImageNet 1K(ILSVRC2012)中更多的类别和更多的类内图像。具体有34个父类,细分出608个子类,每个子类均有779 165张图像,使得Tiered-ImageNet的类别层次结构更加优异,覆盖面更广泛。同时采用默认的84×84图像大小。

CUB-200-2011为鸟类细粒度数据集,其图像尺寸设为224×224,包含100个类,每类均有1 000张图像。

一般数据集与细粒度数据集采取不同的图像尺寸以适用不同层次的特征提取网络,与既有方法保持一致,便于对比实验结果。Mini-ImageNet及Tiered-ImageNet采用ResNet-12作为骨干网络,而细粒度数据集CUB-200-2011则使用较深层次的ResNet-18。

2.2 实验结果及分析

Meta Mask-DeepBDC模型采用预训练的模型初始化权重参数,以原型网络作为主要框架,与一般的元学习模型一致,沿用情景训练的模式。每一轮episodic训练都是5-way 1-shot或5-way 5-shot的小样本分类任务。

特别指出的是,在计算布朗距离协方差矩阵时,各通道上的矩阵均为平方级矩阵,故采用1×1的卷积层降维,减少计算量。同时在掩膜模块进行操作时,生成掩膜所使用的多层感知机要根据每类样本中已知样本数目的不同,灵活设置卷积参数,减少推演的计算量。度量方式上,5-way 1-shot采用内积方式度量,5-way 5-shot则采用更加普遍的欧氏距离度量。

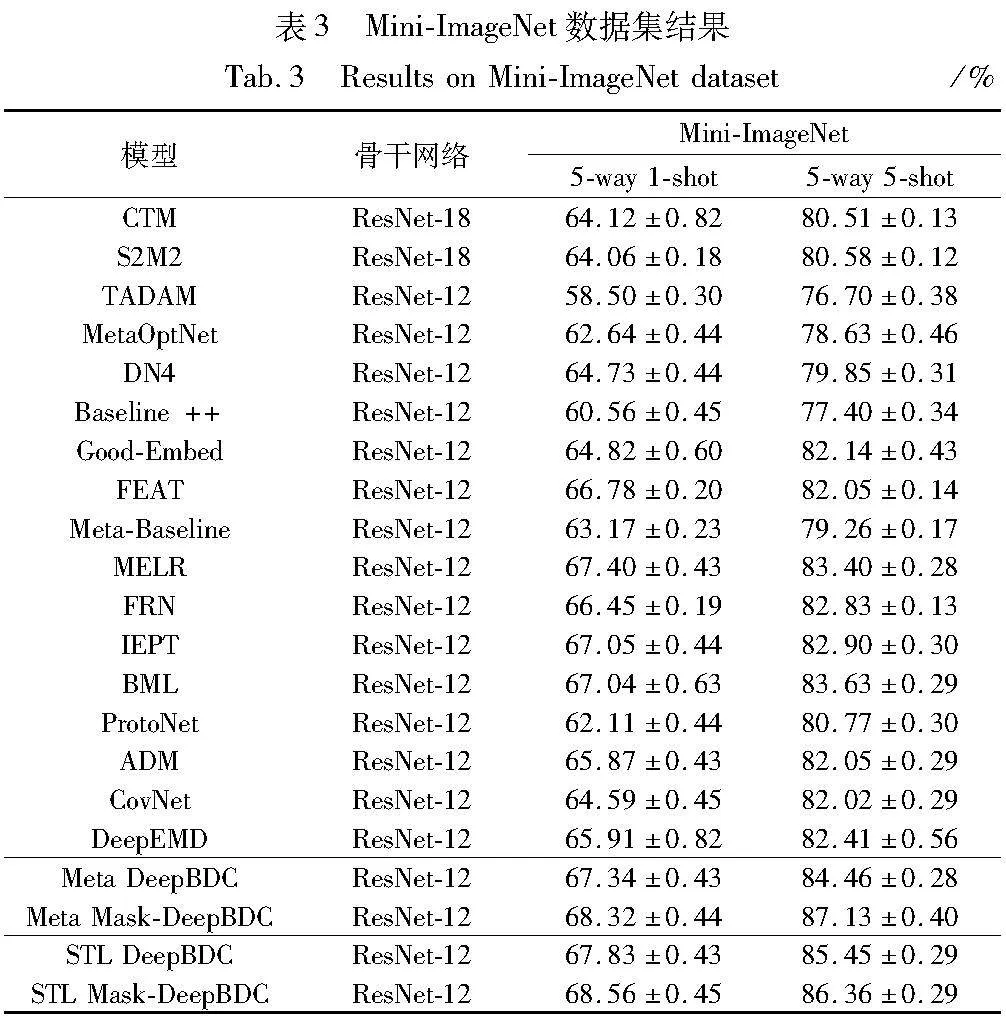

Mask-DeepBDC方法在元学习与简单迁移学习上应用,并与当前较为经典及先进的元学习与度量学习方法进行了比较,其中CUB-200-2011数据集包括ProtoNet[4]、FEAT[16]、MELR[17]、MVT[18]、MatchNet[19]、LR[20]、MAML[21]、Δ-encoder[22]、Baseline++[23]、AA[24]、Neg-Cosine[25]、Laplacian-Shot[26]、FRN[27]、Good-Embed[9]、ADM[28]、CovNet[29]、Meta DeepBDC[13]、STL DeepBDC[13]。Mini-ImageNet和Tiered-ImageNet数据集包括CTM[30]、S2M2[31]、TADAM[32]、MetaOptNet[33]、DN4[12]、Baseline++、MELR、FRN、IEPT[35]、BML[36]、ProtoNet、ADM[28]、CovNet、DeepEMD[10]、Meta DeepBDC、STL DeepBDC。

从表2的CUB-200-211数据集实验结果中可以发现,本文所提的基于掩膜的布朗距离协方差矩阵方法无论在5-way 1-shot还是5-way 5-shot情况下,较所有基准方法均有明显提升,其中5-way 1-shot提升最为明显。相同骨干网络下,Meta Mask-DeepBDC方法与ProtoNet相比,准确率分别提升了7.62%和6.86%,与基准Meta DeepBDC相比准确率分别提升了4.97%和2.85%。Mask STL-DeepBDC方法与Good-Embed相比,准确率分别提高了7.28%和6.16%,与基准STL DeepBDC相比准确率分别提升了1.19%和1.08%。

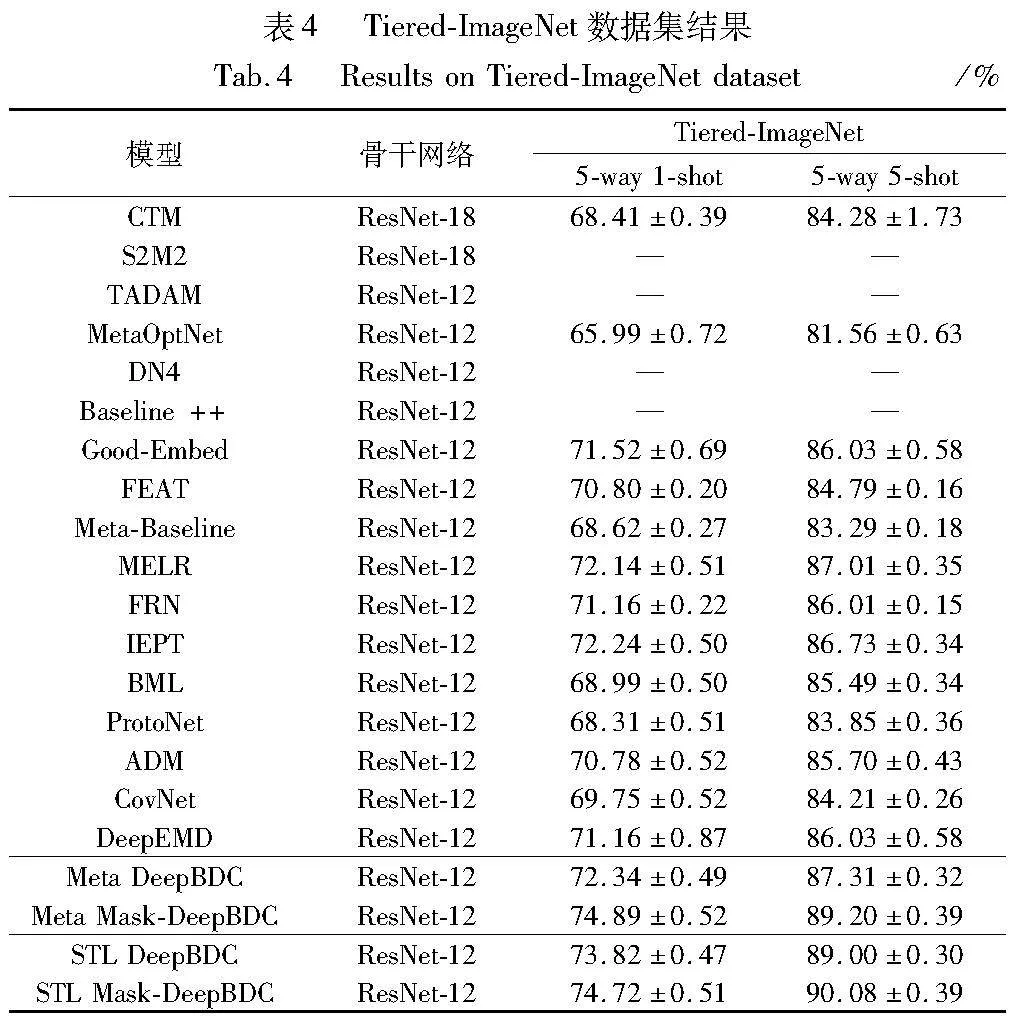

表3和4分别为Mini-ImageNet和Tiered-ImageNet数据集上的结果。其中Meta Mask-DeepBDC方法在Mini-ImageNet数据集下,Meta Mask-DeepBDC方法与ProtoNet相比,准确率分别提升了6.21%和6.36%,与基准Meta DeepBDC相比准确率分别提升了0.98%和2.67%。Tiered-ImageNet数据集下与ProtoNet相比,准确率分别提升了6.58%和5.35%,与基准Meta DeepBDC相比准确率分别提升了2.55%和1.89%。

STL Mask-DeepBDC方法在Mini-ImageNet数据集下与Good-Embed相比,准确率分别提升了3.74%和4.22%,与基准STL DeepBDC相比准确率分别提升了0.73%和0.91%。STL Mask-DeepBDC方法在Tiered-ImageNet数据集下与Good-Embed相比,准确率分别提升了3.2%和4.05%,与基准STL DeepBDC相比准确率分别提升了0.9%和1.08%。

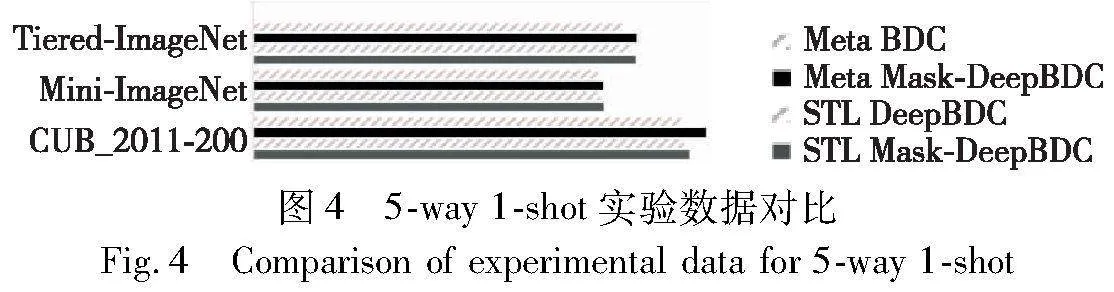

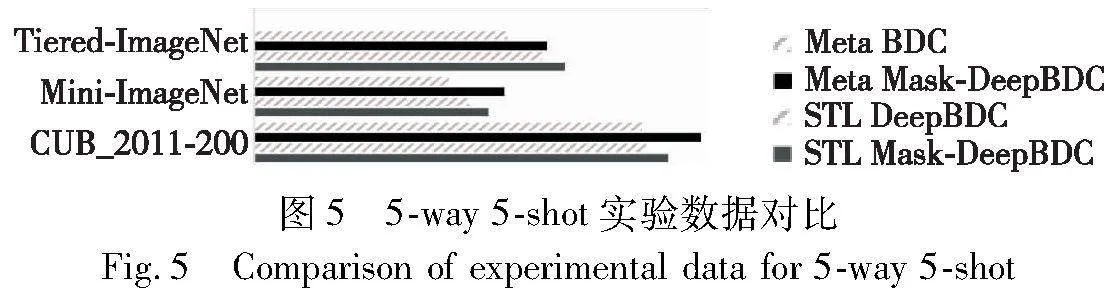

图4、5分别为本文方法在5-way 1-shot与5-way 5-shot上与原方法对比的精确度分析图。通过分析可知,本文算法可在布朗距离协方差矩阵充分利用图像的边缘分布与联合分布进行表征的前提下,根据查询集样本与支持集样本间的语意相关性对支持集样本附加掩膜,引导算法进一步明确图像突出特征,使得分类结果更加精确。因此,本文所提基于掩膜的深度布朗距离协方差模型拥有更高的识别精度。

为了说明深度掩膜布朗距离协方差方法对成对小样本分类的精度提升,针对Mini-ImageNet数据集进行了相应的对比实验,具体结果如表5所示。

本文共进行了四组实验,骨干网络均为ResNet-12以达到相同层次的网络特征提取。由实验可知,ProtoNet初始在5-way 1-shot和5-way 5-shots上的精度分别为62.11%及80.77%,在引入Mask掩膜操作后,两者均有1%左右的提升。

布朗距离协方差方法是在特征提取后,通过全连接提取原型(Proto)进而分类的方法。在单独实验过程中,精度在5-way 1-shot和5-way 5-shots上分别为67.34%与84.46%,较ProtoNet有明显提升。在引入Mask掩膜后,精度分别又提升了0.98%和2.71%。说明掩膜布朗距离协方差能够有效地使模型对小样本分类作出优化。

如图6所示,给出了本文方法在CUB-200-211数据集中的实例结果。针对某episode下,拥有5类样本的查询集和2类样本的支持集在进行分类时,支持集1中的样本由于与查询集中其余样本具有明显的鸟类外形、颜色、鸟冠等差异,所以无论是布朗距离协方差还是深度掩膜布朗距离协方差都给出了正确的预测结果。支持集2中的黑色鸟类与查询集中其余部YNkXxWc9aD8yCdDsUtuSVffjiKZG1tt2EBNRU6yKias=分样本存在相似性高的问题,此时布朗距离协方差方法未能作出正确预测,而深度掩膜布朗距离协方差方法则借助掩膜将成对间样本的特征突出化,作出了正确的预测。

2.3 消融研究及性能分析

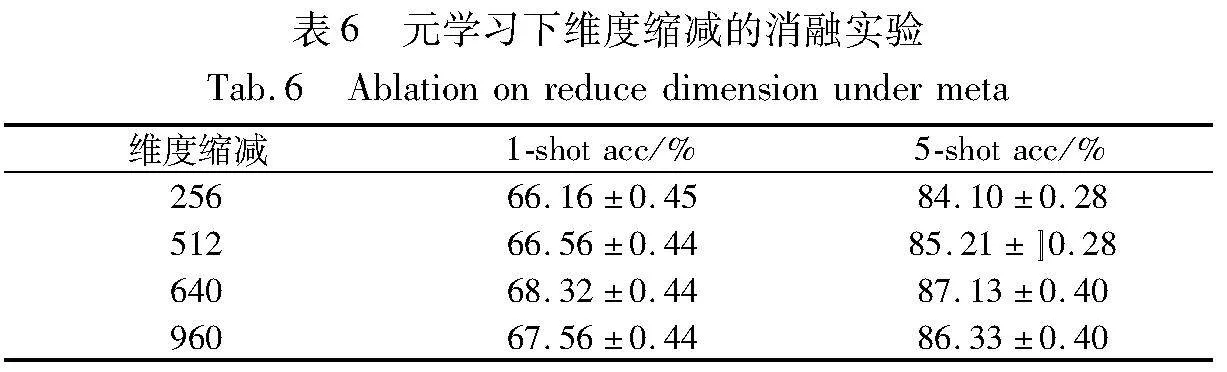

针对实验的其他参数进行了相应的消融实验,同样是在ResNet-12骨干网络下以Mini-ImageNet数据集作为参照,分别在元学习和简单迁移学习下,对比了不同维度缩减(reduce_dim)、相似性度量及分类器对实验结果的影响。

如表6和7所示,元学习情况下,模型的维度缩减在640时达到最佳的分类精度且相对稳定,采用的相似性度量函数在1-shot和5-shot情况下略有不同,分别在内积和欧氏距离的方法下取得最优精度。

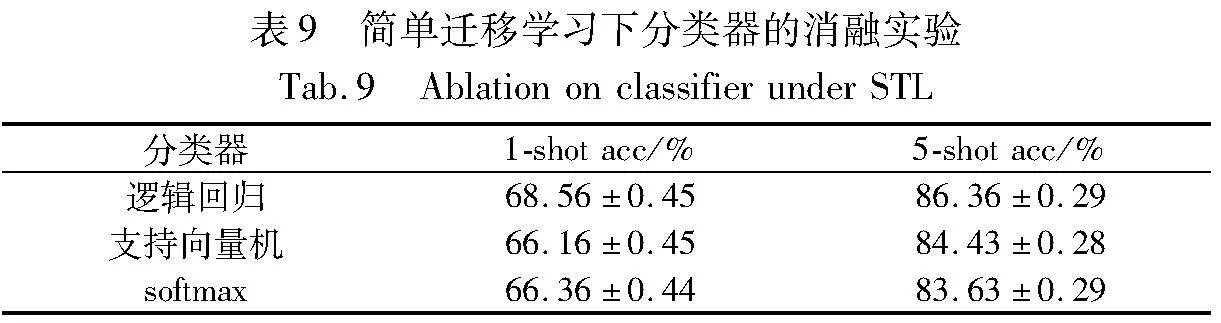

如表8和9所示,简单迁移学习下,维度缩减在128时达到最佳分类精度且相对稳定,逻辑回归在几种分类中脱颖而出,取得了最优的分类精度。

布朗距离协方差在计算时会消耗一定的时间成本,而Mask掩膜操作是成对的支持集与查询集之间的关联运算,也会加重运算的成本,提升复杂度。

如表10所示,分别在CUB-200-211和Mini-ImageNet两个数据集上进行参数指标统计。结果显示,掩膜布朗距离协方差运算会比单一方法的运算更加耗时,网络参数量提升并不明显。

3 结束语

本文提出了一种深度掩膜布朗距离协方差(Deep Mask-BDC)小样本分类方法。通过成对查询集样本与支持集样本间的语意相关性,协同一个带有单隐藏层的多层感知机计算查询掩膜,通过丰富布朗距离协方差矩阵下成对间图像特征的重点区域信息,解决小样本图像分类任务中部分图像类别相似性高、分布特征不明显的问题,并在CUB-200-211、Mini-ImageNet和Tiered-ImageNet三个常见数据集上取得了很好的实验效果。

实验结果还表明本文方法在支持集样本数量更低或细粒度图像下,产生了更优异的分类精度,因此在未来的小样本研究中,可拓展到细粒度图像领域中或更少的1-shot小样本分类任务中。

此外,本文方法尚存在以下不足之处:a)对于掩膜的计算是通过每一个成对查询样本和支持样本得来的,在提升计算效率上还有改进的空间;b)实验中,5way-1shot精确度提升幅度明显高于5way-5shot,且在细粒度数据集CUB-200-211上提升更为明显,说明本文方法在普适性上有待加强;c)简单迁移学习的方法实例中,测试验证阶段采用逻辑回归分类器,使得分类时所使用的掩膜支持样本必须契合当前查询样本,因而存在计算成本过高的问题。

参考文献:

[1]赵凯琳,靳小龙,王元卓. 小样本学习研究综述[J]. 软件学报,2021,32(2): 349-369.(Zhao Kailin,Jin Xiaolong,Wang Yuanzhuo. Survey on few-shot learning[J]. Journal of Software,2021,32(2): 349-369.)

[2]张玲玲,陈一苇,吴文俊,等.基于对比约束的可解释小样本学习[J].计算机研究与发展,2021,58(12): 2573-2584.(Zhang Ling-ling,Chen Yiwei,Wu Wenjun,et al. Interpretable few-shot learning with contrastive constraint[J]. Journal of Computer Research and Development,2021,58(12): 2573-2584.)

[3]汪航,田晟兆,唐青,等.基于多尺度标签传播的小样本图像分类[J].计算机研究与发展,2022,59(7): 1486-1495.(Wang Hang,Tian Shengzhao,Tang Qing,et al. Few-shot image classification based on multi-scale label propagation[J]. Journal of Computer Research and Development,2022,59(7):1486-1495.)

[4]Snell J,Swersky K,Zemel R. Prototypical networks for few-shot lear-ning[C]// Proc of the 31st International Conference on Neural Information Processing System. Red Hook,NY: Curran Associates Inc.,2017:4080-4090.

[5]Sung F,Yang Yongxin,Zhang Li,et al. Learning to compare: relation network for few-shot learning[C]//Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2018: 1199-1208.

[6]Zhang Xueting,Sung F,Qiang Yuting,et al. Deep comparison: relation columns for few-shot learning[EB/OL].(2018).https://arxiv.org/abs/1811.07100.

[7]Yu Mo,Guo Xiaoxiao,Yi Jinfeng,et al. Diverse few-shot text classification with multiple metrics[EB/OL].(2018).https://arxiv.org/abs/1805.07513.

[8]Wang Xin,Yu F,Wang R,et al. TAFE-Net: task-aware feature embeddings for low shot learning[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2019: 1831-1840.

[9]Tian Yonglong,Wang Yue,Krishnan D,et al. Rethinking few-shot ima-ge classification: a good embedding is all you need?[C]//Proc of European Conference on Computer Vision. Cham:Springer,2020: 266-282.

[10]Zhang Chi,Cai Yujun,Lin Guosheng,et al. DeepEMD: few-shot ima-ge classification with differentiable earth mover’s distance and structured classifiers[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020: 12203-12213.

[11]Li Wenbin,Xu Jingjin,Huo Jing,et al. Distribution consistency based covariance metric networks for few-shot learning[C]//Proc of the 33rd AAAI Conference on Artificial Intelligence and the 31st Innovative Applications of Artificial Intelligence Conference and the 9th AAAI Symposium on Educational Advances in Artificial Intelligence. 2019: 8642-8649.

[12]Li Wenbin,Wang Lei,Xu Jingjin,et al. Revisiting local descriptor based image-to-class measure for few-shot learning[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2019: 7253-7260.

[13]Xie Jiangtao,Long Fei,Lyu Jiaming,et al. Joint distribution matters: deep Brownian distance covariance for few-shot classification[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Re-cognition. Piscataway,NJ:IEEE Press,2022: 7962-7971.

[14]Székely G J,Rizzo M L. Brownian distance covariance[J]. The Annals of Applied Statistics,2009,3(4): 1236-1265.

[15]Guo Yurong,Du Ruoyi,Li Xiaoxu,et al. Learning calibrated class centers for few-shot classification by pair-wise similarity[J]. IEEE Trans on Image Processing,2022,31: 4543-4555.

[16]Ye Hanjia,Hu Hexiang,Zhan Dechuan,et al. Few-shot learning via embedding adaptation with set-to-set functions[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Pisca-taway,NJ: IEEE Press,2020: 8808-8817.

[17]Fei Nanyi,Lu Zhiwu,Xiang Tao,et al. MELR: meta-learning via modeling episode-level relationships for few-shot learning[C]//Proc of International Conference on Learning Representations. 2020.

[18]Park S J,Han S,Baek J W,et al. Meta variance transfer: learning to augment from the others[C]//Proc of the 37th International Confe-rence on Machine Learning. [S.l.]: MLR.org,2020: 7510-7520.

[19]Vinyals O,Blundell C,Lillicrap T,et al. Matching networks for one shot learning[C]// Proc of the 30th International on Neural Information Processing Systems. Red Hook,NY:Curran Associates Inc.,2016: 3631-3645.

[20]Wang Yikai,Xu Chengming,Liu Chen,et al. Instance credibility inference for few-shot learning[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2020: 12836-12845.

[21]Finn C,Abbeel P,Levine S. Model-agnostic meta-learning for fast adaptation of deep networks[C]//Proc of the 34th International Conference on Machine Learning. [S.l.]: MLR.org,2017: 1126-1135.

[22]Schwartz E,Karlinsky L,Shtok J,et al. Δ-encoder: an effective sample synthesis method for few-shot object recognition[C]// Proc of the 32nd International Conference on Neural Information Processing Systems. Red Hook,NY:Curran Associates Inc.,2018: 2850-2860.

[23]Chen Weiyu,Liu Yencheng,Kira Z,et al. A closer look at few-shot classification[EB/OL].(2019). https://arxiv.org/abs/1904.04232.

[24]Afrasiyabi A,Lalonde J F,Gagné C. Associative alignment for few-shot image classification[C]//Proc of European Conference on Computer Vision. Cham:Springer,2020: 18-35.

[25]Liu Bin,Cao Yue,Lin Yutong,et al. Negative margin matters: understanding margin in few-shot classification[C]//Proc of European Conference on Computer Vision. Cham: Springer,2020: 438-455.

[26]Masud Z I,Dolz J,Granger E,et al. Laplacian regularized few-shot learning[EB/OL].(2020). https://arxiv.org/abs/2006.15486.

[27]Wertheimer D,Tang Luming,Hariharan B. Few-shot classification with feature map reconstruction networks[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2021: 8012-8021.

[28]Li Wenbin,Wang Lei,Huo Jing,et al. Asymmetric distribution mea-sure for few-shot learning[EB/OL].(2020).https://arxiv.org/abs/2002.00153.

[29]Wertheimer D,Hariharan B. Few-shot learning with localization in realistic settings[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2019: 6558-6567.

[30]Li Hongyang,Eigen D,Dodge S,et al. Finding task-relevant features for few-shot learning by category traversal[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2019: 1-10.

[31]Mangla P,Kumari N,Sinha A,et al. Charting the right manifold: manifold mixup for few-shot learning[C]//Proc of IEEE/CVF Winter Conference on Applications of Computer Vision. Piscataway,NJ:IEEE Press,2020: 2218-2227.

[32]Oreshkin B N,Rodríguez P,Lacoste A. TADAM:task dependent adaptive metric for improved few-shot learning[C]//Proc of the 32nd International Conference on Neural Information Processing Systems. Red Hook,NY:Curran Associates Inc.,2018:719-729.

[33]Lee K,Maji S,Ravichandran A,et al. Meta-learning with differentiable convex optimization[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ:IEEE Press,2019: 10657-10665.

[34]Chen Yinbo,Liu Zhuang,Xu Huijuan,et al. Meta-baseline: exploring simple meta-learning for few-shot learning[C]//Proc of IEEE/CVF International Conference on Computer Vision. Piscataway,NJ:IEEE Press,2021: 9062-9071.

[35]Zhang Manli,Zhang Jianhong,Lu Zhiwu,et al. IEPT: instance-level and episode-level pretext tasks for few-shot learning[C]//Proc of International Conference on Learning Representations. 2020.

[36]Zhou Ziqi,Qiu Xi,Xie Jianan,et al. Binocular mutual learning for improving few-shot classification[C]//Proc of IEEE/CVF International Conference on Computer Vision. 2021:8402-841