习题内外表示异质融合的知识追踪模型

2024-05-24张凯付姿姿纪涛

张凯 付姿姿 纪涛

摘 要:現有知识追踪研究大多使用习题蕴涵的知识点等内隐信息或历史交互数据等外显信息建模习题表示,没有注意到内外信息的异质性特征,缺乏对习题内外信息的异质融合。针对上述问题,提出了融合内外异质信息的知识追踪模型。首先,基于知识点等内隐信息,计算历史知识点与当前知识点之间的相关程度,刻画历史知识点对当前知识点的影响,建模习题的内隐表示;其次,基于交互数据等外显信息,计算历史习题与当前习题之间的相关程度,获取历史习题对当前习题的影响,建模习题的外显表示;再次,基于上述习题的内外表示,使用通道注意力机制融合得到习题的内外异质表示,从而预测学习者的作答表现。为了验证提出模型的性能和有效性,选取了四个相关的基线模型,在三个真实数据集上进行了对比实验。实验结果表明:在性能方面,提出的模型在多个评价指标上均取得较好的效果;在有效性方面,消融实验证明了提出的模型可以更好地根据内外信息建模习题表示;在应用方面,设计智慧学习环境证明了提出的模型在实际教学场景中的可用性。

关键词:知识追踪; 习题表示; 通道注意力机制; 异质融合

中图分类号:TP391 文献标志码:A

文章编号:1001-3695(2024)03-017-0764-08

doi:10.19734/j.issn.1001-3695.2023.07.0308

Knowledge tracing via heterogeneous fusion ofexercises internal and external representations

Zhang Kai, Fu Zizi, Ji Tao

(School of Computer Science, Yangtze University, Jingzhou Hubei 434023, China)

Abstract:Most of the existing knowledge tracing research use implicit information such as concepts contained in exercises or explicit information such as historical interaction data to model exercises,they dont pay attention to the heterogeneity of internal and external information, and lack heterogeneous fusion of internal and external information. To address these issues, this paper proposed a knowledge tracing model that integrated heterogeneous internal and external information. Firstly, this model calculated the relevance between historical concepts and current concepts based on implicit information like concepts, depicted the influence of historical concepts on the current ones and modeled the exercises implicit representation. Secondly,it computed the relevance between historical exercises and current exercises by explicit information like interaction data, captured the impact of historical exercises on the current ones and established the exercises explicit representation. Furthermore, this paper utilized the channel attention mechanism on the aforementioned internal and external exercises representation, and achieved a fusion of heterogeneous information to create the exercises heterogeneous representation, enabling the prediction of learners performance. To validate the performance and effectiveness of the proposed model, this paper conducted comparative experiments on three real-world datasets using four relevant baseline models. The experimental results demonstrate that the proposed model achieves superior performance on multiple evaluation metrics. Additionally, ablation experiments confirm the effectiveness of the proposed model in better modeling exercise representations by incorporating both internal and external information. In the terms of applications, it designed a smart learning environment to prove the advantages of the proposed model in actual teaching scenarios.

Key words:knowledge tracing; exercises representation; channel attention; heterogeneous fusion

0 引言

知识追踪以学习者与习题的交互记录为输入,通过刻画习题及其知识点的信息,探索历史习题对当前习题的作用来增强习题表示,建模学习者的知识状态,最终预测学习者未来的答题表现。随着在线教育平台,如edX、Courersa和学堂在线等的广泛应用,为知识追踪模型提供了海量的交互数据,从而可以自动追踪学习者动态变化的知识状态,为个性化教学提供依据[1~6]。

习题的表示是知识追踪领域关注的焦点,现有的研究主要从两个方面来刻画习题:a)通过描述习题及其知识点蕴涵的信息,聚合得到习题的表示,这种信息属于习题的内隐信息;b)捕获历史交互数据对当前习题的影响,以此增强习题表示,这种信息属于习题的外显信息。然而上述两种方法均只从习题的内隐信息或外显信息单方面考虑,忽略了这两种信息的异质性特征,没有实现习题内外信息的融合协同。

基于这种研究现状,为了更好地刻画习题,提出了习题内外表示异质融合的知识追踪模型。首先,根据习题及其知识点的内隐信息,建模基于内隐信息的习题表示;其次,利用学习者与习题的历史交互数据计算历史习题对当前习题的影响,建模基于外显信息的习题表示;再次,根据上述两种习题表示,建模习题内外表示异质融合的过程,推导出习题的内外融合表示;最后计算知识状态,预测学习者未来的答题表现。

1 相关工作

1.1 基于内隐信息的习题表示

表示习题所用到的内隐信息一般包括习题和知识点的编号、习题文本信息以及习题内部知识点之间的相互关系等。DKT[7]是深度学习模型在知识追踪领域的首次应用,它利用独热编码的方法表示习题编号。与DKT类似的还有DEKT[8]、S-GRU-R[9]和ATCKT[10]等,它们把习题描述成嵌入向量,每个嵌入向量包含了对应习题的编号信息。另外,EERNN[11]定义了一个双向LSTM网络来提取习题文本信息,以此获取习题的表示。这些模型都是通过建模习题的编号、文本信息等来描述习题,没有具体从知识点的角度细化习题的表示。针对这一问题,DKVMN[12]利用静态矩阵存储知识点编号,通过归一化计算不同知识点的权重,以此计算出习题的表示,这种方法用知识点编号等信息来建模习题。与该方法相似的还有MSKT[13]和EKT[14]等。更进一步地, ContextKT[15]设计QR矩阵,包含习题和知识点的上下文信息,得到习题的表示。CRKT[16]以知识点的内涵表示为基础,根据知识点间的相似性,利用图神经网络建模知识点间的关系,以此表示习题。IDKT[17]结合上下文信息构建知识点-习题的关系图,利用图注意力网络聚合知识点之间的相互关系得到增强的习题表示。DGMN[18]用图卷积神经网络捕获知识点之间的作用关系,进而利用知识点来描述习题。

上述模型主要通过习题的内隐信息来表示习题,这种方式以习题和知识点为基础,从不同的角度建模了内隐信息在习题表示中的各种作用,取得了不错的效果。但也把表示习题的信息局限在了内隐信息的范畴,没有考虑到学习者与习题的交互数据等外显信息对习题表示的影响。

1.2 基于外显信息的习题表示

表示习题所用到的外显信息一般包括学习者作答习题的正误情况等交互数据、学习者尝试作答次数和请求提示次数等学习行为数据以及历史习题与当前习题之间的影响等。TCN-KT[19]根据学习者与习题的交互数据计算遗忘参数,融入习题的表示,利用卷积神经网络聚合时间窗口内历史习题对当前习题的影响,增强了习题的表示。与这种方法类似的还有F-TCKT[20],它利用历史交互数据,引入三个遗忘因素来建模习题的表示。更进一步地,NKTF-DKT[21]通过人工标注的方式,为习题表示引入了难度特征;AKTHE[22]从学习者与习题的交互数据中计算出习题的难度和区分度等外显信息,以此构建异构图,利用注意力机制对每个历史习题分配权重,得到更有表征能力的习题表示;DKT-DSC[23]结合学习者的作答记录计算出学习者能力,以此更新习题表示;DSCMN[24]利用学习者与习题间的交互信息区分习题的难度并将学生能力动态分类,得到更有表征能力的习题表示;KTCR [25]利用Q矩阵得到知识点的上下文信息,结合学习行为数据建模习题的表示;QRAKT[26]通过历史交互数据计算出习题之间的相似性,建模习题的关系矩阵,从而建模习题的表示;DKTS[27]构建习题关系图,从历史交互数据中捕获习题之间的相似关系,聚合得到习题的表示;RKT[28]结合习题的上下文以及学习者与习题的交互数据,计算习题之间的作用关系,以此得到习题的表示。

上述模型都是通过习题的外显信息建模习题的表示,这种方法建模了外显信息对习题表示的不同作用,但仅考虑了时间窗口内固定长度的历史习题序列,无法从全局的角度建模所有历史习题对当前习题的直接影响。综上所述,当前的研究利用习题的内外信息从两个方面建模习题的表示。然而,在根据知识点等内隐信息刻画习题时,未能注意到相同知识点在不同习题表示中的不同作用。在根据交互数据等外显信息刻画习题时,仅考虑了时间窗口内的数据,没有从全局建模历史习题对当前习题的直接影响。更重要的是,分别基于内隐信息和外显信息得到的习题表示具有异质性差异,上述研究没有建模习题内外信息融合协同的过程,无法形成融合协同的习题表示。

为了更准确地建模习题的表示,利用习题的内隐信息和外显信息等刻画习题的内外表示,消弭内外表示的异质性差异,融合得到更具表征能力的习题表示。主要工作包括:a)以習题、知识点及知识点间的相互关系等内隐信息为基础,建模习题的内隐表示;b)根据学习者与习题的交互数据等外显信息计算历史习题与当前习题之间的相关程度,建模历史习题对当前习题的影响,聚合刻画习题的外显表示;c)建模上述两种习题表示的融合过程,利用通道注意力机制提取权重,实现习题内外信息的异质性协同,得到习题的内外融合表示,并结合答题结果结合,建模知识状态,从而预测学习者的未来表现。

2 习题内外表示异质融合的知识追踪模型

2.1 提出的思想

在知识追踪模型中,习题的表示受其蕴涵知识点等内隐信息的影响,例如包含不同知识点的习题,在表示上会存在区别。另一方面,习题的表示也受到学习者与习题的交互数据等外显信息的影响,例如已作答的习题会影响未来相似习题的表示。已有研究分别基于内隐信息和外显信息刻画了习题的表示,但尚未注意到这两种表示的异质性特征,无法实现习题内外信息异质性协同表示。

综上所述,为了准确地描述习题,本文提出了习题内外表示异质融合的知识追踪模型。a)根据习题、知识点以及知识点间的相互关系获取习题的内隐表示;b)根据交互数据建模历史习题对当前习题的影响,获取习题的外显表示;c)通过对上述两种习题表示的融合,实现内外异质信息的协同,获取习题的内外融合表示;d)利用自注意力机制建模不同时刻的知识状态,计算历史作用到当前的融合知识状态。整体模型架构如图1所示。

2.2 问题定义

设知识点的总数为M,任一知识点可以表示为cp,其中p的取值为1≤p≤M。设习题的总数为N,学习者作答的第t个题目可以表示为qt∈Euclid ExtraaBpN×1,其中t的取值为1≤t≤T,T表示某次学习过程交互习题的总数。rt={0,1}表示习题qt作答的结果,0表示作答错误,1表示作答正确,(qt,rt)是学习者与习题的交互数据。lt表示习题qt作答完成的时刻。

2.3 基于内隐信息的习题表示

习题的表示会受其蕴涵知识点的影响,并且不同的知识点之间也会存在作用关系,这些作用关系通过改变知识点,进而改变包含知识点的习题,最终影響习题的表示。为了建模上述过程,首先计算知识点的嵌入表示,其次建模历史知识点对当前知识点的影响,最后根据上述知识点及其作用关系等内隐信息聚合得到习题的内隐表示。

3 实验与分析

3.1 实现方法

HFER-KT模型以知识点、习题、习题的作答结果和习题的作答时间等为输入,以当前习题的预测结果为输出,具体实验步骤如下:

a)建模习题的内隐表示。对数据集中的全体知识点进行编码并映射成嵌入向量,利用皮尔森相关系数计算知识点之间的相关程度,建模知识点之间的影响,得到习题的内隐表示qIt。

b)建模习题的外显表示。对数据集中的全体习题进行编码,通过对数据集中的交互记录进行统计,计算得到习题之间的相关程度,建模习题之间的影响,得到习题的外显表示qEt。

c)建模习题的内外融合表示。定义习题的内隐表示矩阵XI和习题的外显表示矩阵XE,利用通道注意力计算习题内外表示的权重,通过卷积网络提取特征得到习题内外融合表示矩阵XIE,矩阵中的每一列代表对应时刻的作答习题的内外融合表示。

d)建模知识状态。把不同时刻的学习者的答题结果映射成零向量,结合习题的内外融合表示,通过注意力机制建模知识状态ht。

e)预测结果。将知识状态与习题的内外融合表示结合,输出预测结果yt。

3.2 数据集

本节使用三个在知识追踪领域常用的真实数据集进行对比实验,具体介绍如下:

a)ASSISTments2009(Assist09)[29]。该数据集是2009—2010年由在线教育平台ASSISTments收集而来的。因其存在较多重复数据的问题,后续又发布了更新版本,去除了重复的数据,使用的是更新版数据集。

b)Statics2011(Statics11)[30]。该数据集来源于某大学的工程力学课程,该类习题一般包括多个知识点。相较于其他数据集而言,Statics11包含相对较少的习题,习题中每个知识点都作为单独的标签。

c)Junyi Academy(Junyi)[31]。该数据集源于2015年Junyi学院的交互日志,包含了25万名学习者的超过2 500万交互记录,是目前数据量最大的数据集。

表1从习题、学习者和交互记录数量三个方面描述了数据集的基本信息。

3.3 基线模型

为了展示HFER-KT模型的性能,从使用内隐信息或外显信息的角度选取了四个基线模型,分别是ATCKT、DKVMN、QRAKT、RKT。ATCKT模型嵌入表示习题编号,习题编号属于内隐信息,但是它没有考虑习题蕴涵的知识点等内隐信息,也未能建模外显信息对习题表示的影响;DKVMN模型首次使用静态矩阵存储知识点编号,以此来表示习题,知识点编号属于内隐信息,该模型开辟了用知识点表示习题的新方法,但尚未注意交互数据等外显信息对习题表示的影响;QRAKT模型通过计算习题嵌入向量之间的相似性,得到习题的关系矩阵Q,历史习题与当前习题的作用关系属于外显信息,但该模型没有考虑到习题的知识点及其作用关系等内隐信息对习题表示的影响;RKT模型利用学习者与习题的交互数据和习题的文本信息计算习题之间的相似程度,习题的交互数据属于外显信息,习题的文本信息属于内隐信息,但该模型没有融合习题内外信息之间的异质性差异。

3.4 实验环境

实验的运行环境配置如表2所示,具体包含了主要的软硬件配置基本情况。

3.5 性能对比实验

本文使用AUC(area under ROC curve)、准确率(Acc)和精确率(precision)作为评价指标,通过与上述基线模型的对比来验证HFER-KT模型的性能。其中:AUC是指ROC曲线下面积,表示模型在预测过程中真实答对率(预测答对且实际答对)大于虚假答对率(预测答对但实际答错)的概率,取值为[0.5,1],AUC的值越大,说明模型预测性能越好;Acc表示模型预测正确的样本个数(预测答对实际答对与预测答错实际答错的样本个数之和)占所有样本个数的比值,Acc的值越大,说明模型预测正确的概率越高;precision表示模型预测答对的样本个数与总答对样本个数的比值,precision的值越大,说明作答结果为对时模型预测的准确率越高。

图2是本文HFER-KT模型与四个基线模型在三个真实数据集上的AUC结果对比。

根据图2展示的实验结果可以看出,HFER-KT模型在三个数据集上的AUC均表现较好,对比第二名ATCKT模型,在三个数据集中分别提高了0.023%、1.96%和2.32%。分析呈现出这种结果的可能原因是:ATCKT模型根据习题的编号等嵌入表示习题,使用的信息较为单一,缺乏建模交互数据等外显信息对习题表示的影响,从而导致该模型的预测性能略低于HFER-KT模型。与ATCKT模型不同的是,HFER-KT模型不仅使用了知识点等内隐信息描述习题,也把交互数据等外显信息纳入建模范畴,融合推导出更具表征能力的习题表示,从而取得了更好的实验结果,说明了HFER-KT模型的有效性。

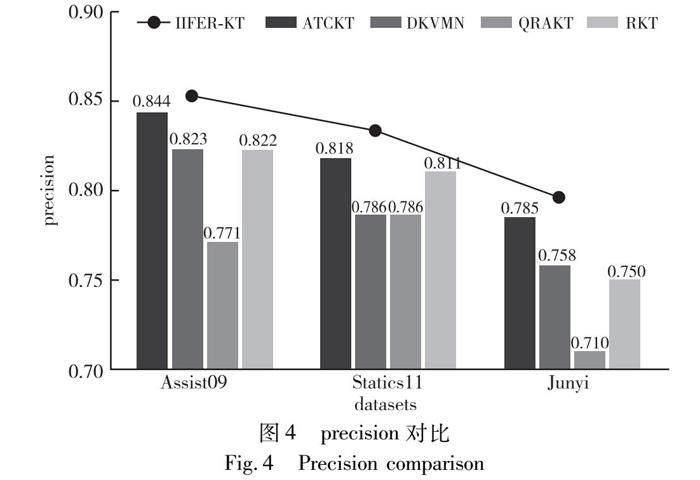

图3是本文HFER-KT模型与四个基线模型在三个真实数据集上的Acc结果对比。

根据图3展示的实验结果可以看出,HFER-KT模型在三个数据集上的Acc均取得了一定的优势。其中,在Statics11数据集上的表现最好,与第二名RKT模型对比,Acc提高了4.74%。出现这种结果的主要原因可能是:RKT模型利用习题的内隐信息和外显信息建模习题的表示,但没有注意到这两种信息的异质性特征,缺少建模习题内外信息协同融合的过程,导致习题的表示不够全面,从而表现出实验结果欠佳。HFER-KT模型分别描述了习题内外异质信息对习题表示的作用,并实现了内外异质信息的协同,融合得到新的习题表示。上述实验结果可以验证该建模方法的有效性。

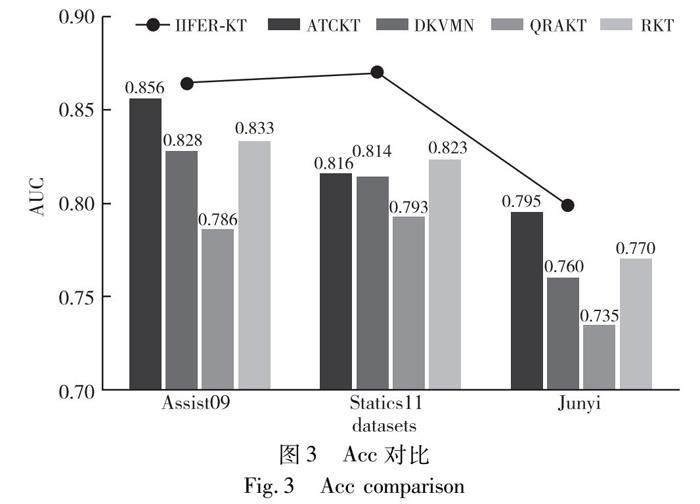

图4是本文HFER-KT模型与四个基线模型在三个真实数据集上的precision结果对比。

根据图4的实验结果可以看出,HFER-KT模型在三个数据集中的precision均取得了更好的结果,与第二名ATCKT模型对比,本文模型在三个数据集中的precision分别要高出0.09%、1.55%和1.14%。说明HFER-KT模型的预测性能略优于对比模型。可以看出在Junyi数据集上,所有模型的precision均有不同程度的降低,分析造成这种结果的原因是Junyi数据集庞大的数据量造成的误差。

3.6 参数对比实验

参数设置是影响模型训练效率以及预测准确率的重要因素,为了进一步确定HFER-KT模型的最佳参数,设计了参数对比实验。具体如下:分别把习题表示的维度设置为32,64,128,对比不同维度的情况下HFER-KT模型的最佳AUC,实验结果如表3所示。

从表3可以看出,当表示习题的向量维度是64时,HFER-KT模型的AUC在多个数据集中表现较好。因此,将HFER-KT模型的习题表示设置为64。

3.7 消融实验

本文研究基于“习题的表示会受到习题内外异质信息的协同作用”这一假设,为了进一步验证本文模型在建模习题表示方面的有效性,本节设计了三个消融实验:a)消融习题的内隐表示,在HFER-KT模型中,用习题的嵌入表示qi代替由知识点及其相互关系聚合而成的习题内隐表示qIi,把该模型记作HFER-KT-A;b)消融习题的外显表示,在HFER-KT模型中,用习题的嵌入表示qi代替由历史交互数据计算得到的习题外显表示qEi,把该模型记作HFER-KT-B;c)消融习题的内外融合表示,在HFER-KT模型中,拼接获取到的习题内外表示,通过全连接层获取习题的融合表示,以此代替通道注意力机制和卷积网络建模的习题内外异质信息融合的过程,把该模型记作HFER-KT-C。以AUC、Acc和precision为评价指标,在数据集Assist09上进行相关实验,结果如表4所示。

从表4可以看出,在Assist09数据集中,HFER-KT模型的AUC、Acc和precision均取得了最好的結果。另外,HFER-KT-A模型的性能数据与HFER-KT模型相差最大,分析其原因可能是:HFER-KT-A模型没有描述知识点及其作用关系对习题表示的影响,导致获取的习题表示缺乏表征能力,从而影响模型的性能。这验证了内隐信息会作用于习题表示的假设。HFER-KT-B模型的性能略好于HFER-KT-A模型,但依旧不及HFER-KT模型,其原因可能是:HFER-KT-B模型忽略了学习者与习题的交互数据对习题表示的作用,只建模了基于内隐信息的习题表示,从而导致模型性能不佳。这验证了外显信息会作用于习题表示的假设。最后,HFER-KT-C模型的性能也次于HFER-KT模型,其原因可能是:该模型仅利用全连层计算了习题的融合表示,建模习题内隐和外显信息异质融合的方式欠妥,导致模型的性能不佳。这验证了利用通道注意力机制和卷积神经网络建模协同融合习题内外信息,建模习题内外异质融合表示的有效性。

3.8 表示质量对比实验

模型的表示质量是指模型的预测结果与实际应用结果之间的差异。例如,A模型通过某个真实数据集训练后,测试显示具有良好的预测性能。现将A模型应用于实际教学环境中,该模型预测有80%的学生能够答对B习题,但实际情况显示只有60%的学生能作答正确。这显然与真实情况相差较大,说明A模型的表示质量欠佳,不能很好地适用于实际环境。一般使用模型的预测概率与真实概率之间的差值来衡量模型的表示质量,预测概率与真实概率之间的差值越小,说明模型更能贴合实际情况。

从表5的结果可以看出,不论真实概率较低还是较高,HFER-KT模型与真实概率之间的差值都最小,这表明了HFER-KT模型的表示质量更好,具有更稳定的性能,更为贴合实际情况。其次,ATCKT模型的差值表现仅次于HFER-KT模型,分析原因可能是ATCKT模型嵌入表示了习题编号,但没有建模交互数据等外显习题对习题表示的影响。实验结果验证了HFER-KT模型协同融合习题内外异质信息,建模习题内外异质融合表示的有效性。

3.9 模型的应用

为了检验本文HFER-KT模型在实际教学场景中的有效性,设计开发了“学习数据与认知模型双驱动的跨模态多尺度自适应智慧教学环境 (CMA-ITE)”。该智慧教学环境包含习题、知识点等多模态内隐信息,也包含学习者答题记录和学习行为数据等多模态外显信息,建模多时空尺度的学习者认知功能来完成对学习者知识状态的判断和预测;同时,集成了选取的若干基线模型,便于在实际教学环境中对比分析各个模型的效果并进行差异评估。智慧教学环境的部分功能如图5和6所示。

智慧教学环境包含4 151名学习者和110个知识点,保存了不同学习者与习题的交互记录,并对这些记录进行处理,将80%用作训练集,20%用作测试集,得到各个模型的平均预测准确率,具体结果如表6所示。

从表6可以看出,HFER-KT模型相较于只利用内隐信息建模习题表示的ATCKT和DKVMN模型,在实际应用中呈现出一定的优势,与只利用外显信息建模习题表示的QRAKT模型相比,更是具有明显的优势。RKT模型虽然使用了内隐信息和外显信息,但没有建模内外信息异质融合的过程,因此在实际应用中的效果与本文HFER-KT模型相比略有不足。上述实验结果验证了HFER-KT模型通过习题内外信息建模内外信息异质融合表示的有效性。

4 结束语

本文提出了一个习题内外表示异质融合的知识追踪模型,用于解决现存知识追踪模型未曾综合建模习题内外异质信息的问题。HFER-KT模型分别根据习题的内隐信息和外显信息计算出习题的两种表示,并利用通道注意力机制和卷积神经网络融合上述两种表示的异质性特征,完成了对不同信息的协同融合。该模型在三个真实数据集上与四个基线模型进行对比,多个实验结果表明,本文模型在性能和训练效率方面具有一定的优势,同时验证了模型在协同建模习题的内外信息方面的有效性。未来的研究工作将进一步挖掘习题的表示及其作用关系对知识追踪模型的影响。

参考文献:

[1]张暖, 江波. 学习者知识追踪研究进展综述[J]. 计算机科学, 2021,48(4): 213-222. (Zhang Nuan, Jiang Bo. Review progress of learner knowledge tracing[J]. Computer Science, 2021,48(4): 213-222.)

[2]刘铁园, 陈威, 常亮, 等. 基于深度学习的知识追踪研究进展[J]. 计算机研究与发展, 2021,59(1): 81-104. (Liu Tieyuan, Chen Wei, Chang Liang, et al. Research advances in the knowledge tracing based on deep learning[J]. Journal of Computer Research and Development, 2021,59(1): 81-104.)

[3]梁琨, 任依梦, 尚余虎, 等. 深度学习驱动的知识追踪研究进展综述[J]. 计算机工程与应用, 2021,57(21): 41-58. (Liang Kun, Ren Yimeng, Shang Yuhu, et al. Review of knowledge tracing preprocessing based on deep learning[J]. Computer Engineering and Applications, 2021,57(21): 41-58.)

[4]李菲茗, 叶艳伟, 李晓菲, 等. 知识追踪模型在教育领域的应用: 2008—2017年相关研究的综述[J]. 中国远程教育, 2019(7): 86-91. (Li Feiming, Ye Yanwei, Li Xiaofei, et al. Application of knowledge tracing models in education: a review of relevant research from 2008 to 2017[J]. Distance Education in China, 2019(7): 86-91.)

[5]盧宇, 王德亮, 章志, 等. 智能导学系统中的知识追踪建模综述[J]. 现代教育技术, 2021,31(11): 87-95. (Lu Yu, Wang De-liang, Zhang Zhi, et al. A review of knowledge tracing modeling in intelligent tutoring systems[J]. Modern Educational Technology, 2021,31(11): 87-95.)

[6]曾凡智, 许露倩, 周燕, 等. 面向智慧教育的知识追踪模型研究综述[J]. 计算机科学与探索, 2022,16(8): 1742-1763. (Zeng Fanzhi, Xu Luqian, Zhou Yan, et al.Review of knowledge tracing model for intelligent education[J]. Journal of Frontiers of Computer Science and Technology, 2022,16(8): 1742-1763.)

[7]Piech C, Bassen J, Huang J, et al. Deep knowledge tracing[C]//Proc of the 28th International Conference on Neural Information Processing Systems. Red Hook, NY: Curran Associates Inc., 2015: 505-513.

[8]熊余, 张健, 王盈, 等. 基于深度学习的演化知识追踪模型[J]. 电化教育研究, 2022,43(11): 23-30. (Xiong Yu, Zhang Jian, Wang Ying, et al. An evolutionary knowledge tracing model based on deep learning[J]. e-Education Research, 2022,43(11): 23-30.)

[9]黄彩蝶, 王昕萍, 陈良育, 等. 基于堆叠门控循环单元残差网络的知识追踪模型研究[J].华东师范大学学报:自然科学版, 2022(6): 68-78. (Huang Caidie, Wang Xinping, Cheng Liangyu, et al. Research on a knowledge tracing model based on the stacked gated recurrent unit residual network[J]. Journal of East China Normal University: Natural Science, 2022(6): 68-78.)

[10]邵小萌, 张猛. 融合注意力机制的时间卷积知识追踪模型[J]. 计算机应用, 2023,43(2): 343-348. (Shao Xiaomeng, Zhang Meng. Temporal convolutional knowledge tracing model with attention mechanism[J]. Journal of Computer Applications, 2023,43(2): 343-348.)

[11]Su Yu, Liu Qingwen, Liu Qi, et al. Exercise-enhanced sequential modeling for student performance prediction[C]//Proc of the 32nd AAAI Conference on Artificial Intelligence and the 30th Innovative Applications of Artificial Intelligence Conference and the 8th AAAI Symposium on Educational Advances in Artificial Intelligence. Palo Alto, CA: AAAI Press, 2018: 2435-2443.

[12]Zhang Jiani, Shi Xingjian, King I, et al. Dynamic key-value memory networks for knowledge tracing[C]//Proc of the 26th International Conference on World Wide Web. New York:ACM Press, 2017: 765-774.

[13]宗曉萍, 陶泽泽. 基于掌握速度的知识追踪模型[J]. 计算机工程与应用, 2021,57(6): 117-123. (Zong Xiaoping, Tao Zeze. Knowledge tracing model based on mastery speed[J]. Computer Engineering and Application, 2021,57(6): 117-123.)

[14]Liu Qi, Huang Zhenya, Yin Yu, et al. EKT: exercise-aware know-ledge tracing for student performance prediction[J]. IEEE Trans on Knowledge and Data Engineering, 2021,33(1): 100-115.

[15]Yu Minghe, Li Fan, Liu Hengyu, et al. ContextKT: a context-based method for knowledge tracing[J]. Applied Sciences, 2022,12(17): 8822.

[16]张凯, 刘月, 覃正楚, 等. 概念表示增强的知识追踪模型[J]. 计算机应用研究, 2022,39(11): 3309-3314. (Zhang Kai, Liu Yue, Qin Zhengchu, et al. Concept representation enhanced knowledge tracing[J]. Application Research of Computers, 2022,39(11): 3309-3314.)

[17]刘坤佳, 李欣奕, 唐九阳, 等. 可解释深度知识追踪模型[J]. 计算机研究与发展, 2021,58(12): 2618-2629. (Liu Kunjia, Li Xinyi, Tang Jiuyang, et al. Interpretable deep knowledge tracing[J]. Journal of Computer Research and Development, 2021,58(12): 2618-2629.)

[18]Abdelrahman G, Wang Qing. Deep graph memory networks for forgetting-robust knowledge tracing[J]. IEEE Trans on Knowledge and Data Engineering, 2022,35(8): 7844-7855.

[19]王璨, 刘朝晖, 王蓓, 等. TCN-KT:个人基础与遗忘融合的时间卷积知识追踪模型[J]. 计算机应用研究, 2022,39(5): 1496-1500. (Wang Can, Liu Zhaohui, Wang Bei, et al. TCN-KT:temporal convolutional knowledge tracking model based on fusion of personal basis and forgetting[J]. Application Research of Computers, 2022, 39(5): 1496-1500.)

[20]张鹏, 文磊. F-TCKT:融合遗忘因素的深度时序卷积知识追踪模型[J]. 计算机应用研究, 2023,40(4): 1070-1074. (Zhang Peng, Wen Lei. F-TCKT: deep temporal convolutional knowledge tracking model with forgetting factors[J]. Application Research of Computers, 2023,40(4): 1070-1074.)

[21]魏思, 沈双宏, 黄振亚, 等. 融合通用题目表征学习的神经知识追踪方法研究[J].中文信息学报, 2022,36(4): 146-155. (Wei Si, Shen Shuanghong, Huang Zhenya, et al. Integrating general exercises representation learning into neural knowledge tracing[J]. Journal of Chinses Information Processing, 2022,36(4):146-155.)

[22]Zhang Nan, Du Ye, Deng Ke, et al. Attention-based knowledge tracing with heterogeneous information network embedding[C]//Proc of the 13th International Conference on Knowledge Science, Engineering and Management. Cham: Springer, 2020: 95-103.

[23]Minn S, Yu Yi, Desmarais M C, et al. Deep knowledge tracing and dynamic student classification for knowledge tracing[C]//Proc of IEEE International Conference on Data Mining. Piscataway, NJ: IEEE Press, 2018: 1182-1187.

[24]Minn S, Desmarais M C, Zhu Feida, et al. Dynamic student classification on memory networks for knowledge tracing[C]//Proc of the 23rd Pacific-Asia Conference on Advances in Knowledge Discovery and Data Mining. Cham: Springer, 2019: 163-174.

[25]王文濤, 马慧芳, 舒跃育, 等. 基于上下文表示的知识追踪方法[J]. 计算机工程与科学, 2022,44(9): 1693-1701. (Ma Wentao, Ma Huifang, Shu Yueyu, et al. Knowledge tracing based on contextualized representation[J]. Computer Engineering & Science, 2022,44(9): 1693-1701.)

[26]Li Lingqin, Wang Zhifeng. Calibrated Q-matrix-enhanced deep know-ledge tracing with relational attention mechanism[J].Applied Scien-ces, 2023,13(4): 2541.

[27]Wang Zhiwei, Feng Xiaoqin, Tang Jijiang, et al. Deep knowledge tracing with side information[C]//Proc of the 20th International Conference on Artificial Intelligence in Education. Charm: Springer, 2019: 303-308.

[28]Pandey S, Srivastava J. RKT: relation-aware self-attention for know-ledge tracing[C]//Proc of the 29th ACM International Conference on Information & Knowledge Management. New York: ACM Press, 2020: 1205-1214.

[29]Feng Mingyu, Heffernan N, Koedinger K. Addressing the assessment challenge with an online system that tutors as it assesses[J]. User Modeling and User-Adapted Interaction, 2009,19(8): 243-266.

[30]Koedinger K R, Baker R S J, Cunningham K, et al. A data repository for the EDM community: the PSLC DataShop[M]//Handbook of Educational Data Mining. Boca Raton, FL: CRC Press, 2010: 43-56.

[31]Chang H S, Hsu H J, Chen K T. Modeling exercise relationships in e-learning: a unified approach[EB/OL]. (2019-09-28). https://homepage.iis.sinica.edu.tw/~swc/pub/elearning_exercise_relationship.html.