大数据中的数据清洗与预处理技术研究

2024-05-03赵恩毅

赵恩毅

(陕西财经职业技术学院 陕西 咸阳 712000)

0 引言

随着信息技术的迅猛发展,大数据已经成为现代社会必不可少的一部分。大规模、多样性和高速度的数据流持续涌入,为众多领域带来了前所未有的机遇,同时也带来了巨大的挑战。其中如何确保数据的高质量和高效处理是大数据应用的核心问题。为此本文探讨了数据清洗和预处理技术在大数据时代的研究与挑战,尤其关注了任务合并技术、部队级别信息(force level information, FLI)三层体系。相关技术和策略的提出,旨在为大数据的高效、高质量处理提供有效的方法和工具,确保数据能够为众多应用领域带来真正的价值。

1 大数据时代数据清洗与预处理技术的研究与挑战

1.1 Hadoop 框架下的数据处理效率问题

在大数据时代,数据清洗与预处理技术的重要性日益凸显。此技术确保了数据的准确性和可靠性,为后续的数据分析提供了坚实的基础。其中Hadoop 作为一个广泛使用的大数据处理框架,其数据处理效率问题尤为重要。Hadoop 框架主要包括Hadoop 分布式文件系统(Hadoop distributed file system, HDFS) 和MapReduce 两大核心组件。HDFS 为大规模数据集提供了可靠的存储,而MapReduce 则为大规模数据处理提供了并行计算的能力。然而,在实际应用中,Hadoop 面临着一系列的数据处理效率问题。

MapReduce 的编程模型相对固定,导致其在处理复杂的数据转换和数据清洗任务时,往往需要多个阶段或多轮迭代。一个涉及多步骤的数据清洗流程可能需要多个MapReduce 作业串联执行,增加了整体的计算时间,因为每一轮MapReduce 作业都会产生磁盘I/O 和网络传输开销。下面是MapReduce 处理时间与运算轮数的关系:

式(1)中,Ttotal是总的处理时间,n是MapReduce 作业的轮数。

Hadoop 的Shuffle 阶段是数据处理的一个关键环节,但也常常成为性能瓶颈。在Shuffle 阶段,由Map 任务产生的中间数据需要被传输到Reduce 任务进行处理。当处理大规模数据集时,Shuffle 阶段的数据传输和排序开销可能会非常巨大。此外Hadoop 的默认配置可能不适合所有应用[1]。

1.2 数据清洗与预处理的效率挑战与目标设定

数据清洗与预处理是数据分析的基石,确保数据的质量和完整性。然而,在大数据环境中,数据清洗与预处理面临着巨大的效率挑战。随着数据量的增长,传统的数据清洗方法在时间和资源消耗上变得不可接受。大数据环境中的数据清洗任务通常涉及多种数据源,数据源之间可能存在格式、结构和语义的差异。合并、标准化和解决差异需要大量的计算资源。数据的异常值和噪声也为大数据清洗带来了挑战[2]。传统的异常检测方法如基于统计的方法,在大数据环境中可能会受到数据分布的影响,导致检测效果不佳。因此需要设计更加复杂的模型,如基于深度学习的异常检测模型,但也增加了计算开销。

为了应对计算效率相关的挑战,数据清洗与预处理的目标设定在以下几个方面:

(1)计算效率。考虑数据的规模和分布,目标是减少数据清洗任务的总体计算时间。可以通过并行处理、采样和其他优化方法来实现。

式(2)中,Tcleaning表示数据清洗的总时间,T1,T2,…,Tn表示各个数据清洗子任务的时间。

(2)数据质量。确保数据清洗后的数据集具有高质量,通常通过准确率、召回率和F1 分数等指标来评估。

式(3)中,precision表示准确率,recall表示召回率。

1.3 数据清洗中的质量问题

数据清洗在大数据分析和处理中占据核心地位,但质量问题依然是一个无法回避的挑战。数据质量问题通常表现为数据冗余、数据不一致、错误数据和缺失数据。数据冗余指的是在数据集中出现重复数据,可能源于多个不同的数据源或者数据收集过程中的错误。在大数据环境中,数据冗余不仅消耗了宝贵的存储资源,还可能影响数据分析的准确性。例如,数据冗余可能导致统计指标的失真,从而影响到基于指标的决策和预测[3]。

2 基于任务合并的优化技术

2.1 合并冗余计算与使用同一输入文件的任务

在大数据处理中,任务合并是一个有效的优化手段,特别是针对那些涉及冗余计算或使用同一输入文件的任务。任务合并旨在减少不必要的计算、I/O 操作和数据传输,从而提高整体的处理效率。考虑一个场景,其中多个任务从同一输入文件读取数据并执行类似的计算。在没有优化的情况下,每个任务都会单独读取输入文件,导致多次的I/O 操作。通过任务合并,可以将任务合并为一个大任务,输入文件只需要读取一次。设任务数为n,单个任务的I/O 时间为T,未经优化的总I/O 时间为n×T,经过任务合并,总I/O 时间减少,大大减少了I/O 开销:

再考虑冗余计算问题。在大数据处理中,可能存在多个任务执行相同或相似的计算,导致计算资源的浪费。通过任务合并,可以识别合并这些冗余计算,从而减少总的计算量。设每个任务的计算量为C,未经优化的总计算量为n×C,经过任务合并,总计算量可能减少到k×C。

任务合并不仅可以减少I/O 和计算开销,还可以减少数据传输和存储开销。当多个任务合并为一个任务时,中间结果可以在内部共享,无须额外存储或传输。基于任务合并的优化技术是大数据处理中的一个重要策略。通过合并冗余计算和使用同一输入文件的任务,可以有效地减少I/O、计算、数据传输和存储开销,从而提高整体的处理效率。此优化方法为大数据应用提供了一个新的、高效的解决方案,有助于满足日益增长的数据处理需求。

2.2 减少MapReduce 的轮数以优化性能的方法

MapReduce 作为处理大规模数据的编程模型和执行环境,已被广泛应用于各种数据处理任务。然而多轮MapReduce 作业经常导致性能瓶颈,尤其是当数据流需要经过多个Map 和Reduce 阶段时[4-5]。为了优化性能,减少MapReduce 的轮数成了关键策略。在传统MapReduce作业中,每一轮都包括Map 阶段、Shuffle 阶段和Reduce 阶段。每个阶段都伴随着数据读写、网络传输和资源分配的开销。给定一个包含n轮的MapReduce 作业,总开销可表示为:

式(6)中,Omap、Oshuffle、Oreduce分别代表Map、Shuffle 和Reduce 阶段的开销。

为了减少开销,一个有效的策略是合并多个MapReduce 轮次。通过合并,可以减少数据的中间读写和网络传输从而提高整体性能,可以采用以下策略:①流水线执行。当两个MapReduce 作业有依赖关系时,可以将第一个作业的Reduce 阶段与第二个作业的Map 阶段合并,形成一个流水线。通过此方式数据可以直接从第一个作业的Reduce 阶段传递到第二个作业的Map 阶段,避免了中间数据的存储和读取。②共享扫描。当多个MapReduce 作业处理相同的输入数据时,可以将作业的Map 阶段合并,共享一个数据扫描。由此可以避免重复读取相同的数据。③局部聚合。在Map 阶段结束后,可以先进行局部聚合,减少传递到Reduce 阶段的数据量。

3 FLI 三层体系的提出与描述

3.1 FLI 体系的定义与核心思想

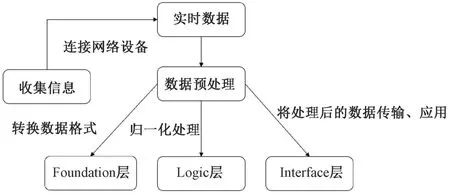

FLI 三层体系是为了解决大数据环境中数据处理和管理的复杂性而设计的。该体系旨在提供一个统一、结构化的框架,以支持数据的存储、处理和查询。FLI 体系的名称来源于3 个核心层:Foundation、Logic 和Interface。3个层次为大数据应用提供了一个从底层到上层的完整解决方案。图1 展示了FLI 三层体系是如何利用、处理收集到的数据。

图1 FLI 三层体系处理数据流程

(1)Foundation 层:FLI 体系的底层,主要负责数据的存储和管理。Foundation 层提供了一个分布式、容错的数据存储系统,可以支持大规模数据的存储、备份和恢复。此外,该层还提供了数据的分片、复制和负载均衡功能,确保数据的高可用性和持久性。

数据存储模型可以表示为:

式(7)中,D表示整个数据集,di表示第i个数据分片。

(2)Logic 层:FLI 体系的中间层,主要负责数据的处理和分析。Logic 层提供了一个分布式计算框架,支持各种数据处理任务,如数据清洗、转换、分析和查询。该层采用声明式编程模型,允许用户使用高级语言描述数据处理逻辑,然后自动将逻辑转化为分布式执行计划。数据处理模型可以表示为:

式(8)中,P(D) 表示对数据集D的处理结果,pj(D) 表示第j个处理任务。

(3)Interface 层:FLI 体系的上层,主要负责与用户的交互。Interface 层提供了一系列的应用程序接口和工具,支持数据的查询、可视化和报告。该层还提供了数据安全和隐私保护功能,确保数据的安全存储和访问。用户查询模型可以表示为:

式(9)中,Q(D) 表示对数据集D的查询结果,qk(D) 表示第k个查询任务。

FLI 体系的核心思想是提供一个完整、统一的大数据解决方案,从数据的存储、处理到查询,都在同一个体系内完成。通过三层结构,FLI 体系可以支持各种规模和复杂性的大数据应用,满足不同用户的需求。FLI 体系还强调了模块化和扩展性,每个层次都可以独立地进行升级和扩展,确保体系的长期稳定性和可维护性。例如可以在Foundation 层增加新的存储引擎,或者在Logic层添加新的处理算法,而不影响其他层次的功能。FLI三层体系为大数据应用提供了一个全面、灵活的解决方案。通过三个核心层次,FLI 体系可以支持从数据存储到处理、查询的整个数据生命周期,满足大数据时代的各种挑战和需求。

3.2 与任务合并技术的协同作用与优势

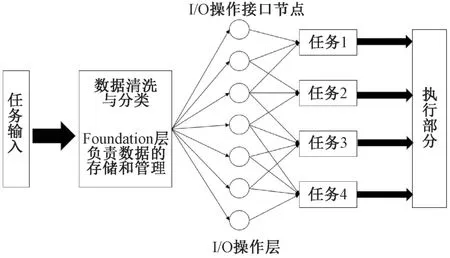

在面对大数据挑战时,FLI 三层体系提供了一个结构化的框架,支持从数据存储到处理的全过程。与此同时任务合并技术为数据处理提供了一种有效的优化手段。两者的结合可以发挥出强大的协同效应,为大数据应用带来显著的性能提升。在FLI 体系中,Foundation层负责数据的存储和管理,确保数据的高可用性和持久性。当处理大规模数据时,I/O 操作成为性能瓶颈,任务合并技术可以通过合并多个任务来减少冗余的I/O 操作,从而提高数据处理的效率,当多个任务读取同一数据分片时,可以将任务合并为一个任务,共享一个数据扫描,从而减少数据读取的次数。图2 是任务合并技术的简单示意图。

图2 任务合并技术简单示意图

在Logic 层数据处理和分析是主要任务。传统的数据处理方法往往需要多轮MapReduce 作业,每轮都涉及大量的数据读写和网络传输。任务合并技术可以将多轮作业合并为一轮,减少中间结果的存储和传输,从而提高处理速度。例如,当两个MapReduce 作业有依赖关系时,可以将两者合并,使数据直接从一个作业流向另一个作业,避免中间数据的存储和读取。此外任务合并技术还可以减少Logic 层的计算开销。在大数据处理中,往往存在大量的冗余计算。通过任务合并可以将冗余计算合并为一次计算,从而减少总的计算量。

4 结语

综上所述,大数据时代数据的质量和处理速度成为实现有效数据应用的基石。面对Hadoop 框架的数据处理效率问题,任务合并技术的引入显著减少了MapReduce 的轮数,优化了性能。同时,数据清洗中的质量问题,如数据冗余、不一致性、错误和缺失,被深入探讨并提出了相应的解决策略。FLI 三层体系结构化地为大数据应用提供了从底层到上层的解决方案,与任务合并技术协同作用,进一步提高了数据处理的效率。本研究为大数据处理提供了一套完整的框架和策略,确保了数据的高质量和高效处理,满足了大数据应用中的各种需求。