非匀速条件下车辆底盘超近距成像测量方法

2024-03-20张月莹殷其昊荆根强颜露新王相勋

张月莹, 殷其昊, 荆根强, 颜露新, 王相勋

(1.浙江省机电产品质量检测所有限公司,浙江 杭州 310051; 2.交通运输部公路科学研究所,北京 100088;3.华中科技大学 多谱信息智能处理技术全国重点实验室,湖北 武汉 430074)

1 引 言

国家标准《汽车、挂车及汽车列车外廓尺寸、轴荷及质量限值》对各类货车提出了明确的外廓尺寸、轴荷及质量限值要求,货车的外廓尺寸和轴型、轴距的测量是开展“治超”工作的重要依据[1]。常见的货车外廓尺寸测量方法有激光阵列测量方法[2]、机器视觉方法[3]等。而对于货车轴型识别,则主要有激光雷达法[4]和机器视觉法[5]等方法。近年来,基于神经网络、支持向量机的车型识别方法开始被用于小型车辆品牌型号的识别[6,7], 在各自的场景下均取得了较好的效果,但在治超场景下,由于车辆底盘结构隐蔽,这些方法在涉及驱动轴识别时,难以对货车的驱动轴和从动轴进行有效辨别。另外,在车速不受控的情况下,对货车轴距也难以进行准确的测量。

另一方面,在行业管理过程中,也需要保存清晰完整的车辆底盘图像信息作为计量依据。在安防领域,为了检查车底安全隐患,国内外相关研究人员开展了基于线阵或面阵相机图像拼接的底盘成像技术的设计与开发。在实际应用中,车辆往往需要在安防人员控制之下有序匀速通过系统,获取完整清晰的底盘图像,进而对底盘图像进行定性分析,包括底盘部件异常检查、人员或物品藏匿的判断,而在对底盘的结构参数测量方面则关注较少。在超限治理的动态、非匀速、不受控的行车条件下,这类技术则相对难以实现底盘结构参数测量的功能。

为获取清晰完整的车辆底盘图像以实现结构参数测量,需着重解决2个棘手问题:一是超近距、大面积成像造成的图像畸变;二是车辆行驶非可控、非匀速造成的图像序列重叠度不均。对于被检车辆这类非受控目标,当车辆移动速度不均匀时,线阵相机由于按时间均匀采集,会导致底盘图像沿行车方向上拉伸或压缩的现象。普通面阵相机虽可以直接拍摄底盘图像,但由于镜头的视场有限,难以获取完整的底盘图像。相比之下,鱼眼相机可以通过单个摄像头获取超大视角的图像,可以满足大角度成像需求,在全景图像拼接[8,9]、大视角范围物体检测[10]、大尺寸物体测量[11]等场景下均有较成熟的应用。

对于行驶中的货车底盘成像场景,相机无法一次性拍摄完整的底盘图像,需要通过时序上的视频影像拼接来获得完整的车辆底盘图像。关键帧提取是目前视频影像拼接领域广泛应用的技术之一,现有算法包括基于图像描述子的算法[12],基于图像相关系数的算法[13]和基于深度学习的算法[14]等。然而,由于存在同样的大畸变、视频帧重叠度不均等问题,导致这些算法在处理图像校正、图像配准等步骤时出现困难,从而影响关键帧提取结果。

针对上述存在的问题,本文提出了一种非匀速条件下车辆底盘超近距成像测量方法。该方法利用鱼眼相机采集运动车辆底盘的超广角图像序列,基于三维成像模型对鱼眼图像进行畸变校正,并设计一种基于图像内容的帧提取方法,解决非匀速条件下对底盘图像拼接和结构参数(如轴距)测量的影响。

2 系统流程及视频采集方案设计

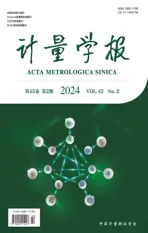

车辆底盘成像系统的算法流程图如图1所示,主要流程包括视频采集、图像预处理、图像校正、关键帧提取和图像拼接。

图1 算法流程图Fig.1 Technical framework of proposed method

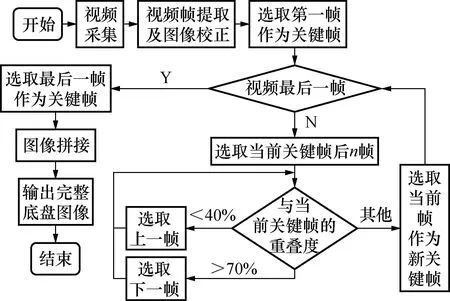

在视频采集步骤中,通常货车底盘的离地间隙大约为0.3 m,宽度约2 m至2.5 m。为了使相机能够拍摄到完整的车辆底盘,需同时满足近距成像和大视野两个条件,相机拍摄货车底盘示意图如图2所示。

图2 相机拍摄货车底盘视角示意图Fig.2 Diagram of a truck chassis with a camera

视场角θs的计算公式为

(1)

式中:W表示货车底盘的宽度;H表示货车底盘的高度。

当W取2.5 m,H取0.3 mm,可以计算得到相机视场角θs需要大于154°。为保证相机采集到车辆完整底盘图像信息,这里采用超广角(鱼眼)镜头作为成像器件。为尽可能消除光照变化和噪声带来的影响,视频中每一帧图像均进行了自适应直方图均衡化及高斯平滑处理。为满足车长方向的完整、低畸变成像,还需解决图像校正、拼接等技术难题,相关内容将在后续章节阐述。

3 车辆底盘图像畸变校正

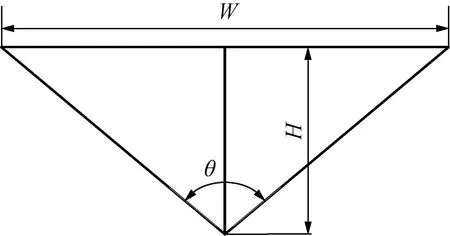

3.1 底盘鱼眼图像有效区域提取

目前提取鱼眼图像有效区域的主要方法包括面积统计法和线扫描法。面积统计法通过计算图像的质心来求解鱼眼图像有效区域的圆心和半径,其核心思想是统计鱼眼图像中黑色像素点的个数和分布,因此其结果的准确性很容易受到鱼眼图像中有效区域中的黑色像素点的影响;而线扫描法利用不同方向上的扫描线对鱼眼图像进行扫描,通过寻找有效圆形区域的外切线的位置求解鱼眼图像的圆心和半径。由于只能获得4个外切点,其结果准确性不易保证。

为解决样本点较少的问题,本文提出一种改进的线扫描法。该方法采用多采样点的圆拟合方法提取鱼眼图像的感兴趣区域,将鱼眼图像在垂直与水平两个方向上均等划分,并对每条直线在圆上产生的两个交点的坐标进行阈值设置以获得边界点。在实际操作中,若获得的边界交点总数过少(<10个),则算法划分的份数增加1份,直到获取足够数量的样本点。

如图3所示,在图例中算法共选取了12个样本点。

图3 多点拟合法提取交点示意图Fig.3 Diagram of intersection points in proposed multi-point fitting method

在算法获取到足够多的样本点后,再通过这些点进行圆拟合,计算得到鱼眼图像有效区域的圆心坐标和半径。这里采用Kasa圆拟合法[15]进行对鱼眼图像有效区域圆心和半径的求解。

3.2 底盘鱼眼图像畸变校正

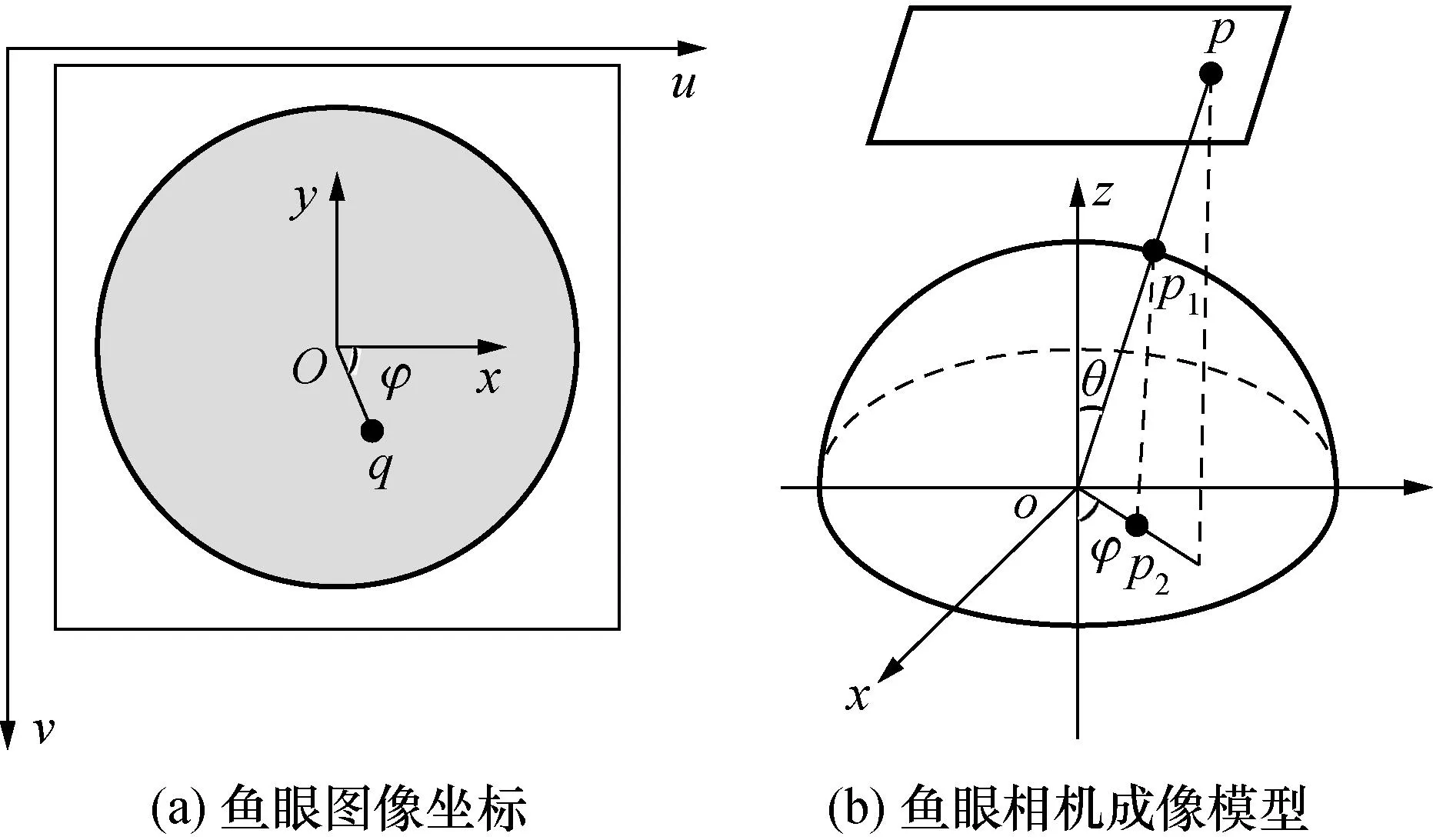

获取鱼眼图像后,通过3D投影模型的方法获取鱼眼图像中每个像素点与真实图像坐标点之间的变换关系,并通过双线性插值进行鱼眼图像的畸变校正。鱼眼图像坐标转换关系如图4所示。

图4 鱼眼图像坐标转换关系示意图Fig.4 Diagram of coordinate transformation between fish-eye image and plain image

记鱼眼图像上任意一点q坐标为(u,v),与圆心O(u0,v0)的距离为r,鱼眼图像的有效区域半径为R,见图4(a),则其在以O点为原点的直角坐标系中应满足:

(2)

图4(b)展示了鱼眼相机成像的模型,由等距模型可以得到:

(3)

式中:f为相机焦距;θ为光线的入射角;φ为鱼眼图像中点q与真实坐标系中X轴正方向的夹角。

点q在真实坐标系中坐标为(x,y,0),则q在单位球面上对应点p1(x1,y1,z1)的坐标为

(4)

将球面中心O与点p1连线,在目标图像上的交点p(xp,yp,zp)即为点q在目标图像上的对应点。在等距模型中有zp=RzP=R,依此可以得到点p与p1之间的关系,即:

(5)

联立公式(3)和公式(5)可以得到

(6)

最后,令鱼眼图像中O点在校正图像中坐标保持不变,则q点在校正图像的最终坐标(i,j)即为

(7)

从而可以得到鱼眼图像有效区域内任一点在校正图像中的坐标转换算法,并通过双线性插值算法得到最终的校正图像。

4 基于关键帧的车辆底盘图像拼接

4.1 视频关键帧的多步分层提取

本节提出的关键帧提取算法包括初筛和精筛两个步骤。初筛过程中,通过采样间隔n对采集视频帧进行采样,即每隔n帧提取一帧图像进行重叠度的计算。经估算,当采样间隔n=2,可保证车辆以30 km/h的速度通过相机时,采样图像间的重叠区域足够大,满足拼接所需的重叠度要求。

在视频采集过程中,货车会不可避免地出现加减速行为。当速度v减小时,采样图像之间的重叠区域会增加,采样图像存在数量过多和图像间重叠度过大,带来计算上的冗余。因此,需要对采样得到的图像进行精细筛选,从而缓解上述问题。精筛的具体步骤如下:

1) 选取视频的首帧图像作为关键帧;

2) 选取后续第n帧图像作为候选关键帧;

3) 计算当前关键帧和候选关键帧之间的重叠度大小;

4) 若两帧间重叠度达到拼接要求 (40%~70%),则将候选关键帧加入新的关键帧,否则放弃该候选帧,并根据重叠度大小选取新的候选关键帧:若重叠度过大,则选取下一帧,反之则选取上一帧。直到新的候选关键帧的重叠度符合拼接需求,将其作为新的关键帧;

5) 重复步骤2)~4),直到视频结束。

可以看到,上述精筛选步骤的关键点在于两帧间的重叠度计算。下文将介绍基于图像内容的重叠度计算方法,即通过图像配准将两幅图像对齐,通过重叠区域的面积计算得到图像间的精准重叠度。

4.2 底盘图像配准

ORB(oriented FAST and rotated BRIEF)算法[16]是常用的图像配准算法之一,算法通过特征点提取和匹配实现图像的配准。在车辆底盘图像配准过程中,匹配算法出现了许多误匹配点对,其原因一是底盘上存在许多结构相似的部分,导致出现了特征点一对多的现象;二是特征点缺少全局约束,导致一些误匹配点对只满足了局部相似,在全图中并不合理。

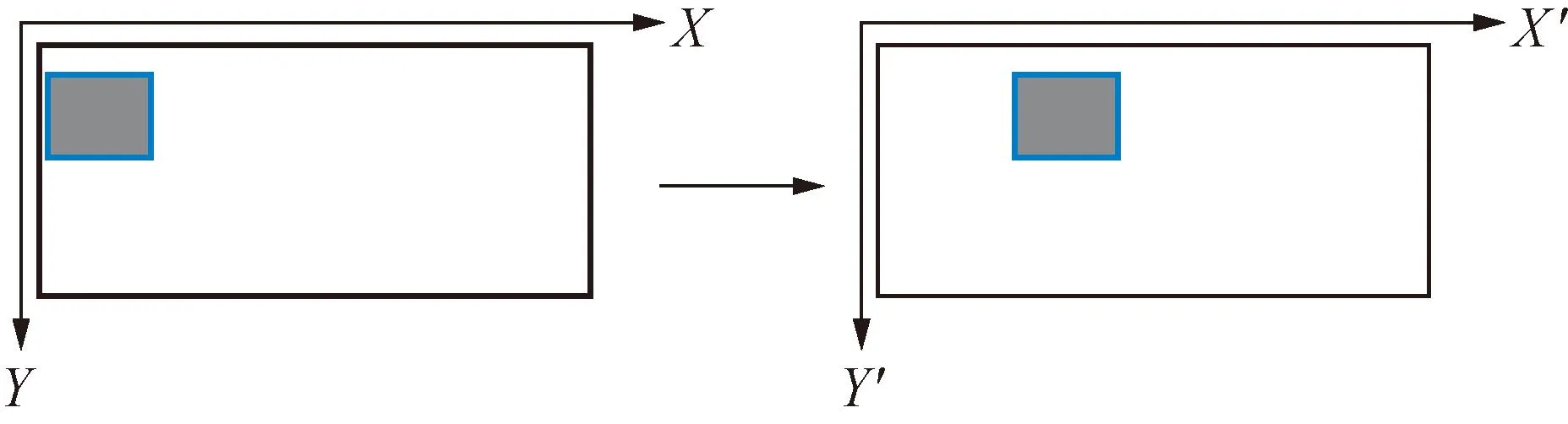

在通常情况下,车辆单方向运动,相机两帧图像之间相当于做了1次平移变换。因此,可以使用模板匹配算法[17]对图像进行匹配,以获得平移变换参数,并利用该平移参数对特征点对进行二次筛选。模板匹配示意图如图5所示。

图5 模板匹配示意图Fig.5 Diagram of template matching

首先从待配准图像中人工选取一块合适区域作为模板,将该区域在固定图像上进行滑动,并计算该位置模板与对应区域的归一化相关系数作为相似度,计算公式如下:

(8)

式中:T(x′,y′)为模板区域中坐标点像素值;I(x+x′,y+y′)为固定图像上坐标点像素值。

滑动完成后,选择最大相似度对应的区域作为最佳匹配区域,从而确定模板区域在固定图像中的位置,最终得到两张图像之间的平移变换参数:记模板区域左上角在待配准图像中坐标为(xb,yb),在固定图像中坐标为(xa,ya),则两张图像之间的平移系数即为(xa-xb,ya-yb)。通过这一参数便可以进行匹配点对的进一步筛选:对任意一对匹配点对p和q,在进行平移操作后,p平移到点P1,其与点q的曼哈顿距离<15 pixel,则保留该匹配点对,否则删除。

最后通过特征点匹配算法[18]对进一步筛选后的特征点进行计算,得到精确的图像配准结果,即单应性矩阵H。

4.3 重叠度计算

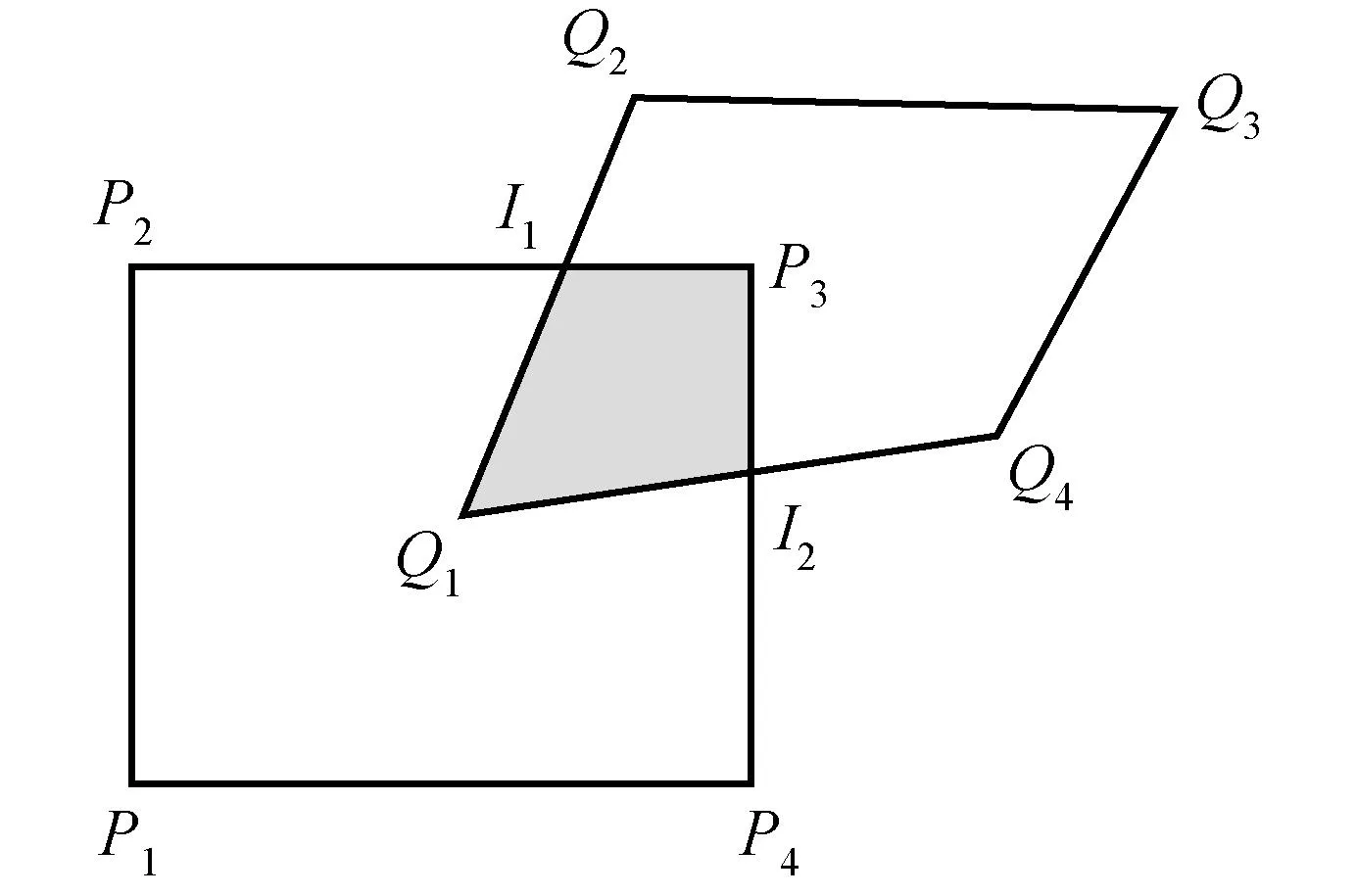

两张图像可以通过单应性矩阵H进行精确匹配,多边形交点示意图如图6所示。

图6 多边形交点示意图Fig.6 Diagram of intersection point in polygons

两者重叠度计算步骤如下:

3)分别计算多边形I与P的面积AI和AP,则两幅图像的重叠度表示为多边形I与P的面积比值:

(9)

4.4 图像融合

最后,通过线性约束的加权图像拼接算法计算拼接图像各个位置的像素值:

(10)

式中:w1和w2为权值函数,而且w1+w2=1,权值函数计算公式为

(11)

式中:xmin表示重叠区域起始位置的横坐标;xmin≤x≤xmin+xo,xo表示重叠区域的长度。

5 实验与结果分析

5.1 鱼眼图像的校正分析

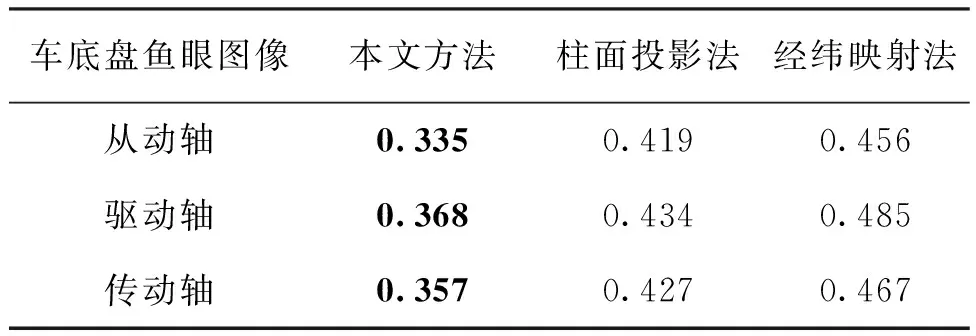

首先针对不同的投影模型展开实验。从采集的鱼眼视频中人工筛选出的具有代表性的从动轴、驱动轴和传动轴图像进行图像校正实验。校正效果如图7所示,其中第一列为原始鱼眼图像,后3列分别为本文图像校正方法、柱面投影法和经纬映射法的畸变校正结果。表1为3种算法所用时间。

表1 3种算法图像校正时间Tab.1 Time spent for correction of 3 methods

图7 底盘鱼眼图像校正效果对比图Fig.7 Comparison between different methods for chassis fish-eye image correction

由图中结果可见:对于同一张鱼眼图像,3种方法均能在中心区域获得较好地校正效果,但柱面投影法和经纬映射法均在图像周围出现严重拉伸。相比之下,本文校正算法则在图像边缘区域仍保持较好的校正效果,其时间消耗也是最少,这对于实时测量应用是很重要的。

5.2 速度自适应的车辆底盘图像拼接分析

为了验证本文算法的速度自适应效果,对在不同车速下进行了实验,速度模式分别为匀速行驶、变速行驶和停车再行驶3种。表2展示了不同速度模式下的数据信息。

表2 不同速度模式下的数据信息Tab.2 Data information under different speed conditions

由表2可以看出:提取的关键帧平均重叠度保持在一定合适的范围内,保证了图像拼接高效可行。相对而言,若使用等时间间隔采样的方法提取拼接图像,停车再行驶模式下,相邻两帧平均重叠度达到了88.81%,变速行驶模式下平均重叠度也达到了78.58%,过高的重叠度会导致图像拼接时大量的冗余计算。

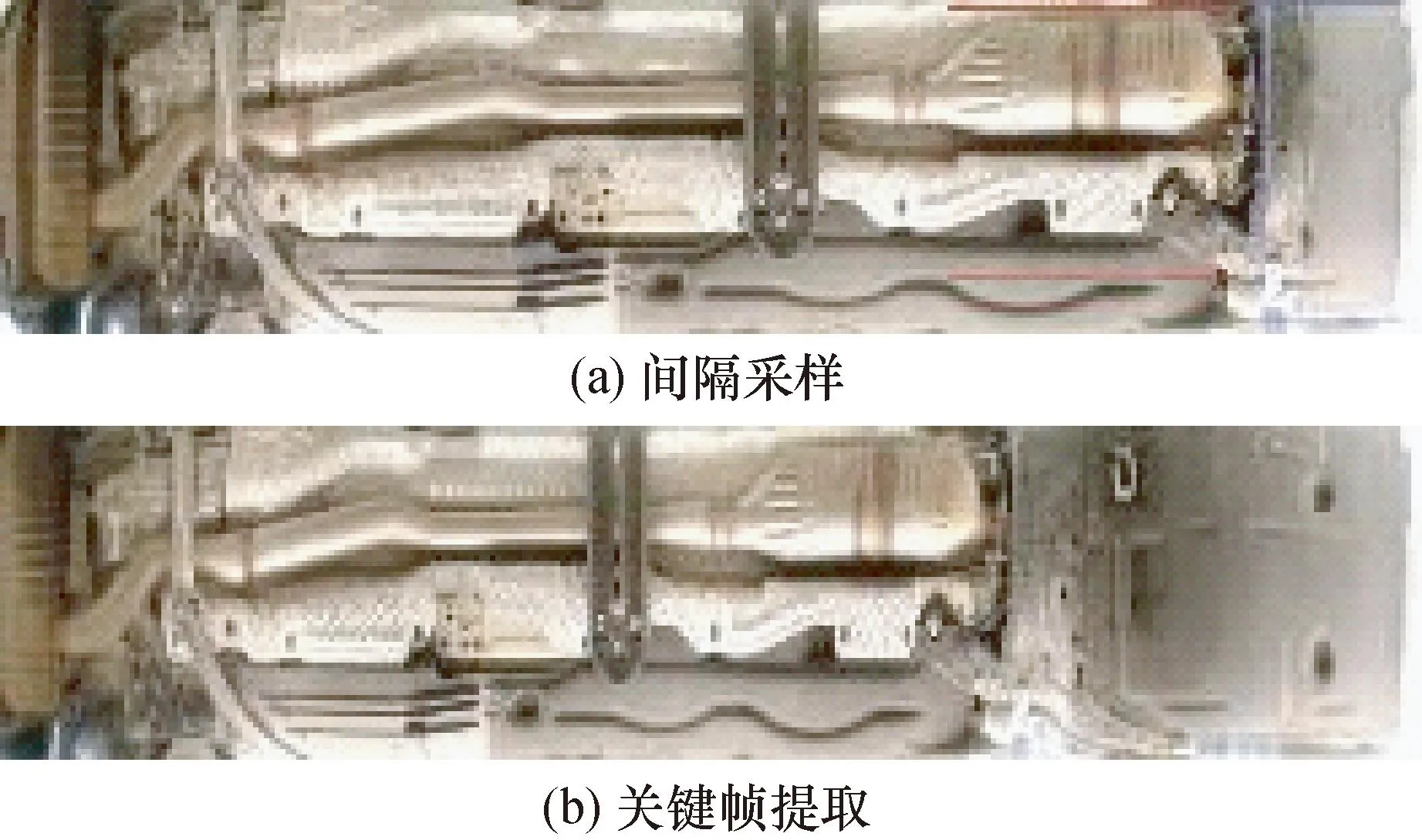

针对最具挑战性的停车再行驶速度模式,进一步进行了车底盘图像拼接,其拼接结果如图8所示。可以观察到,间隔采样下,拼接结果的部分区域出现了明显的变形情况。相比之下,基于提取关键帧的拼接结果则减少了变形。

图8 2种算法针对途中停止车辆的底盘拼接结果Fig.8 Results of chassis mosaic by 2 methods

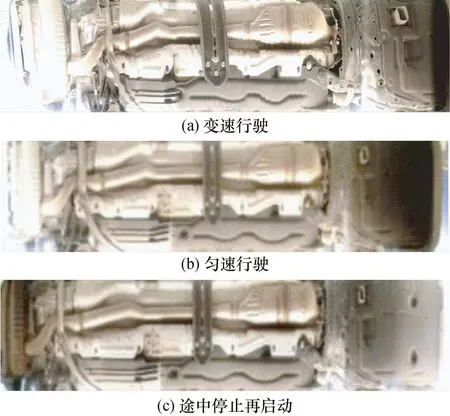

本文算法在3种速度模式下最终得到的底盘图像结果见图9。

图9 不同速度模式下的拼接结果Fig.9 Mosaic results under 3 speed conditions

从图9可以看到,不同速度模式下的车辆底盘图像拼接结果基本一致,没有出现明显的变形情况,进一步验证了该算法对车辆行驶速度的自适应性能。

5.3 高速路口货车底盘拼接实例

为了验证本文算法在实际场景下的性能,在国内某高速公路口搭建了采集环境,实际采集了部分货车的底盘视频数据,并依序进行了图像校正、提取和拼接,最终成功获取了完整的货车底盘图像。下面将对实验结果进行定性及定量分析。

首先是鱼眼图像校正结果,图10展示了经过图像校正算法后,某货车的部分底盘图像示例。

图10 校正后车底盘图像Fig.10 Chassis images after correction

关键帧提取过程中,初筛步骤从视频中提取出660帧车底盘图像,在经过精筛步骤后,关键帧数量减小到61张,相邻关键帧的重叠度均维持在 40%~70%。

最后,使用这61张关键帧进行了底盘图像的拼接,拼接结果见图11。可以看出:拼接后的车底盘图像清晰展示了货车底盘的轴型信息,6个轮轴如红色方框所示。此外,也可以从底盘图像中快速进行轴型分析,判断该轴是否为驱动轴(驱动轴如左数第2、3个红框所示)。

图11 六轴货车的底盘拼接结果Fig.11 The mosaic result of a six-axle truck

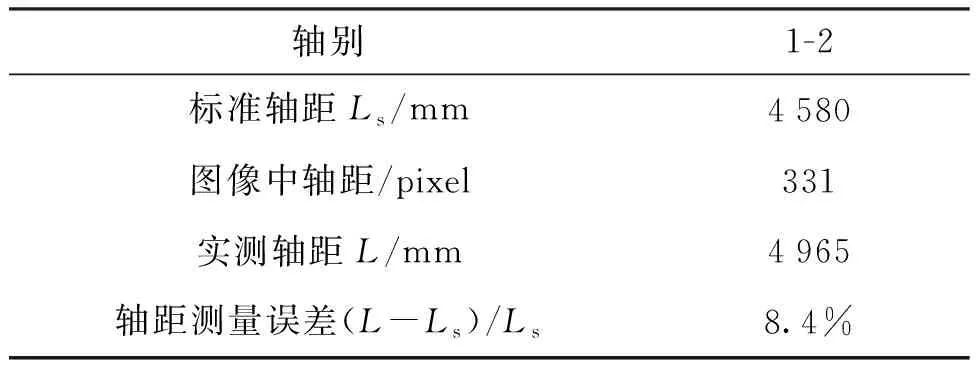

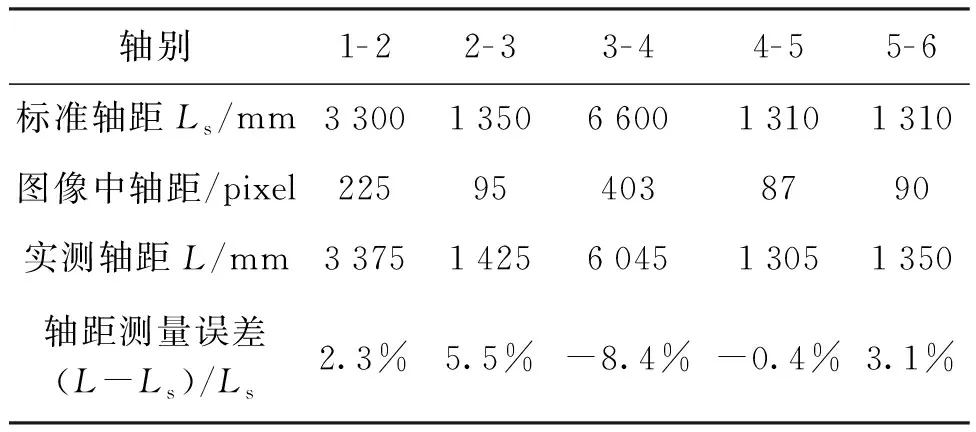

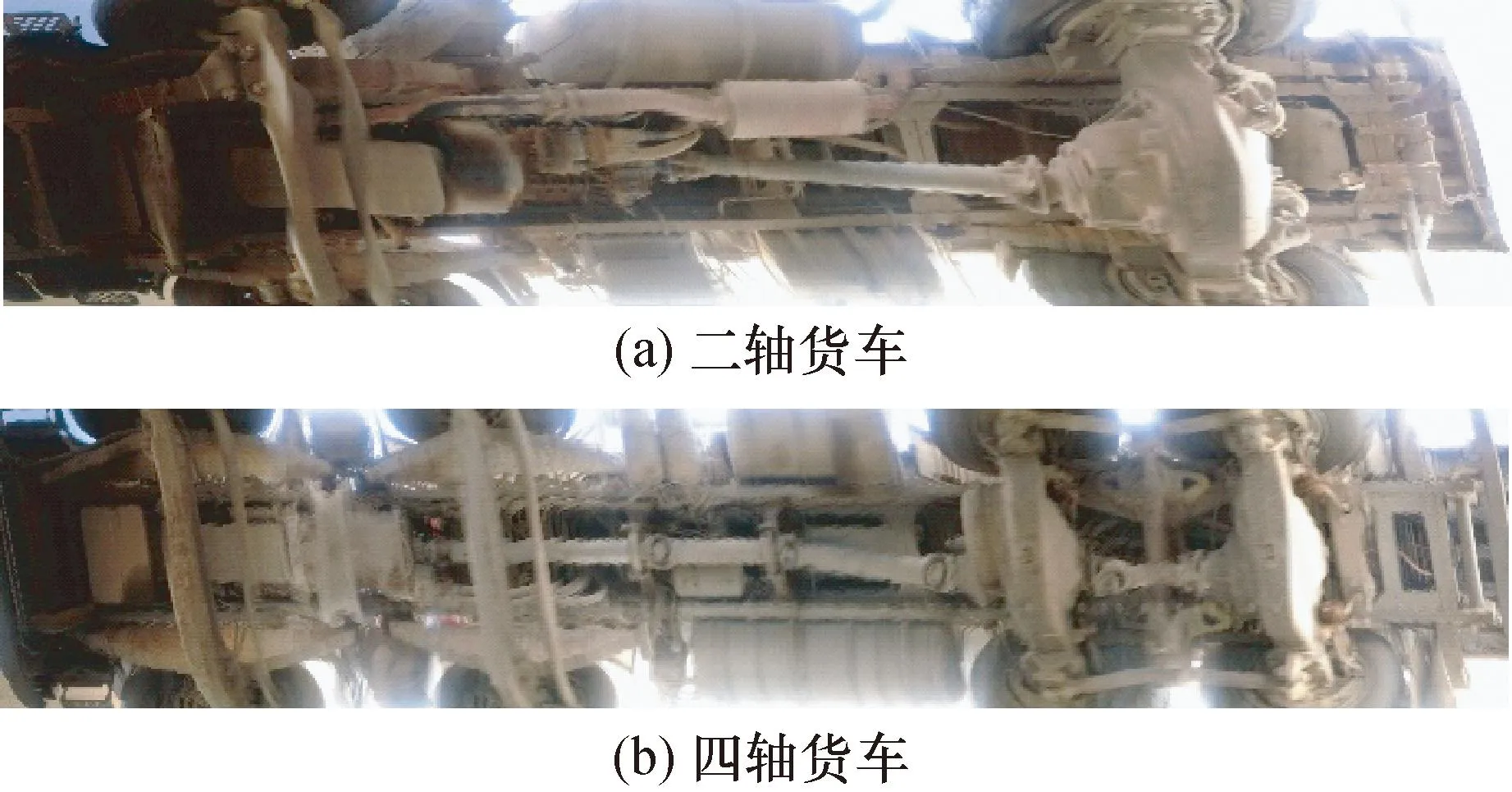

为了更精确地分析本文的算法的精确度,在该六轴货车外选取了二轴、四轴货车各一辆,结果见图12,在底盘拼接结果的基础上进行轴距的定量计算,并与货车轴距的标准值进行比较,结果如表3~表5所示。表格中货车标准轴距可以查询货车型号获得,算法的轴距计算则采用了基于图像空间的像素坐标测量方式,获取车轴中心点,通过像素间的距离差和预先标定的图像分辨率计算得到。

表3 二轴货车轴距比较结果Tab.3 Comparison results of wheelbase of the two-axle truck

表4 四轴货车轴距比较结果Tab.4 Comparison results of wheelbase of the four-axle truck

表5 六轴货车轴距比较结果Tab.5 Comparison results of wheelbase of the six-axle truck

图12 二轴、四轴货车的底盘拼接结果Fig.12 The mosaic results of two-axle and four-axle trucks

从表3~表5可见:本文方法所得到的货车轴距测量误差均<±9%,测量误差绝对值的均值约为5.0%,结合我国车型信息数据,可进行车辆轴型的准确判断。

6 结 论

本文面向交通领域超限超载治理中货车轴型检测及轴距测量需求,设计并实现了一套可溯源的货车底盘成像测量系统。

针对货车底盘大,成像距离短的问题,使用鱼眼相机采集货车底盘图像,并提出了基于多点拟合的有效区域提取算法和基于等距投影模型的鱼眼图像畸变校正方法;针对货车速度不可控的问题,提出了一种分层的有效帧提取方法,通过计算图像间的重叠度对图像进行筛选,避免了图像采样不均匀对拼接结果的影响,最终实现了速度自适应的车辆底盘图像拼接。本文方法在内部场地实验和高速路口现场条件下均取得了良好效果,二轴、四轴和六轴货车底盘轴距测量误差均<±9%,均值约为5%。

未来研究的后续工作包括:

1) 基于现有车辆底盘成像方法实现车轴自动检测和关键参数的自动化测量;

2) 结合速度自适应的关键帧提取策略,反向进行车辆的驾驶行为分析。