超图神经网络综述

2024-02-20林晶晶冶忠林赵海兴李卓然

林晶晶 冶忠林 赵海兴 李卓然

1 (青海师范大学计算机学院 西宁 810008)

2 (藏语智能信息处理及应用国家重点实验室(青海师范大学) 西宁 810008)

3 (西宁城市职业技术学院信息工程系 西宁 810003)

(ljj_mail@126.com)

卷积神经网络[1](convolutional neural network,CNN)、循环神经网络[2](recurrent neural network, RNN)等传统的深度学习模型在图像、音频等任务中取得较好的效果,这取决于它们被具有平移不变性和局部连通性的欧氏数据来表示.CNN 的核心思想局部连接、参数共享、池化采样和多层使用[3],降低了网络模型的复杂度,减少了权值的数量,却未减弱其表达能力.RNN 拥有处理可变长度的序列数据的能力,能够挖掘数据中的时序信息和语义信息. 长短期记忆[4](long short-term memory,LSTM)是一种采用门控机制改进的RNN,而门控递归单元[5](gated recurrent unit,GRU)是LSTM 的变体,只包含重置门和更新门,简化了LSTM 的架构. 尽管这些传统的深度学习方法能够有效地提取欧氏数据的特征,但许多实际应用场景中还存在一种用图结构表示的非欧氏数据,如社交网络、交通网络、知识图谱和蛋白质网络等[6-8]. 因此,研究者对深度学习方法在图数据上的扩展越来越感兴趣.

近年来,受CNN 和RNN 的启发,研究者们创新性地设计了用于处理图数据的深度学习方法,统称为图神经网络(graph neural networks,GNNs). 由于GNNs具有丰富的表达能力、灵活的建模能力和端到端的训练能力,被广泛地应用于图分析领域,突破性地优化和提高了节点分类[9-11]、预测[12-13]、视觉分析[14]和自然语言处理[15-16]等任务的性能. 在文献[17] 中将GNNs 分为循环图神经网络、卷积图神经网络、图自动编码器和时空图神经网络. 其中,卷积图神经网络也可称为图卷积神经网络(graph convolution networks,GCNs)是最流行和发展最快的图神经网络之一. 与CNN 相比,GCNs 需要在图上设计卷积操作来刻画节点的邻域结构. 依据卷积操作定义方式的不同,GCNs分为谱域方法和空域方法. 谱域方法通过卷积定理在谱域定义卷积操作; 空域方法通过聚合函数汇集每个顶点及其邻域节点的方式定义卷积操作.

在现实世界的网络中,虽然图可以很好地刻画对象间的成对关系,但是对象间还存在大量比成对关系更加复杂的非成对关系. 如果简单地用图表示对象间的复杂高阶关系,可能会导致信息丢失或信息冗余. 例如,多位作者撰写了一篇文章,每位作者视为顶点,若这几位作者中的任何2 位都非必要直接联系[18],用图直接将他们两两连接,会产生信息冗余,无法恰当地描述出多人撰写文章的合著关系,使得展示的信息不准确. 超图由顶点集和超边集组成,每条超边可以连接多个顶点而非仅2 个顶点. 故超图拥有描述顶点间复杂高阶关系的能力,可用于建模具有高阶相互作用的复杂网络和系统. 因此,若用一条超边连接多位合著者,能够更加简洁和准确地刻画出多位作者的合著关系.

近3 年来,受GNNs 和超图建模优势的启发,研究者们开始关注如何将GNNs 扩展到超图,设计出基于超图的神经网络,改善具体应用的性能.2019 年,Feng 等人[19]提出第1 个超图神经网络 (hypergraph neural networks,HGNN),将GCNs 的谱方法很自然地扩展到超图上,并设计了超图卷积操作. 同年,Yadati等人[20]设计HyperGCN 实现在超图上处理半监督分类问题. 随后,陆续出现的大量超图神经网络模型被充分运地用到计算机视觉[21-22]、推荐系统[23-24]、生物化学[25-26]等领域并取得显著的成绩. 超图神经网络已逐渐成为一个新的研究热点. 目前,对于上文中提到的CNN、GNNs 和GCNs,存在多篇经典的综述性文献对它们进行全面的归纳和总结. 例如,文献[17]提供了一种划分GNNs 的策略,总结了GNNs 的数据集、开源代码和模型评估等. 在文献[27]中详细地介绍了GNNs 模型及其变体,从结构场景、非结构场景和其他场景详细地概括了GNNs 的应用;同时探讨了4个开放性问题. 文献[28]系统地总结了CNN 的发展史、网络结构、训练方法及应用场景等. 文献[6]全面梳理了GCNs 的谱域方法和空域方法、最新进展、相关应用和发展趋势. 除此之外,还有大量的文献[29−31]从非欧空间、具体应用领域等方面总结和展望了GNNs.

Gao 等人[32]详细介绍了超图学习方法,但关于超图神经网络的分类方法、模型分析和应用领域等方面的探讨和总结仍为空白. 因此,系统地综述现有超图神经网络模型十分必要,有助于推动超图神经网络今后在更多的领域中发展和应用. 本文全面地梳理了超图神经网络近3 年的发展历程、代表性模型及其未来研究方向. 根据设计模型采用的方法不同,将超图神经网络分为超图卷积神经网络、超图循环神经网络和超图生成对抗网络3 类,并根据实现卷积的方法细分超图卷积神经网络. 重点阐述了每类中的代表性模型,并做分析和比较. 同时讨论了超图神经网络未来的研究工作.

1 研究历程

在过去的几年里,GNNs 作为一种强大且实用的工具,推动深度学习在图数据上快速发展. 大量研究表明GNNs 在计算机视觉[33-35]、自然语言处理[36-37]、交通网络[38-40]、推荐系统[41-43]、生物化学[44-46]、知识图谱[47-49]等各领域获得成功.GNNs 主要处理图数据,但现实网络中还存在超越二元的关系,若用图简单地表示,会丢失对象之间潜在的高阶关系. 超图[50]是一种建模复杂关系的灵活工具,其包含顶点集和超边集,利用每条超边连接多个顶点表示潜在的高阶关系. 本质上,每条超边是顶点的子集,即一条超边连接多个顶点,而非只连接2 个顶点. 因此,超图作为图的一种推广,可以刻画出更加丰富的信息,充分地挖掘图中顶点之间潜在的高阶交互.

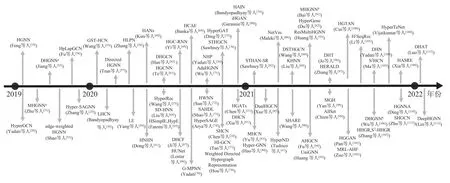

在过去3 年中,超图神经网络吸引了很多研究者探究如何在超图上设计神经网络,以及如何将其应用于各个领域. 借鉴GNNs 中的卷积运算、注意力机制、生成对抗等技术,超图神经网络迅速发展. 研究者们在超图上开发出超图卷积、超图注意力和超图生成对抗网络等,相继地涌现出大量的超图神经网络模型.图1 详细地展示了从2019—2022 年初超图神经网络模型发展进程的时序情况,横轴表示时间(以年为间隔),纵轴表示模型,着重列出了每个模型的简称和作者信息.

Fig. 1 The sequential development of hypergraph neural network model图1 超图神经网络模型的发展时序

从图1 中可以清晰地看出超图神经网络模型的数量逐年递增,研究重心也发生了变化,具体如下所述. 首先,超图神经网络建模的超图结构从无向超图扩展到有向超图,以及从静态超图结构拓展到动态超图结构. 分别设计出有向超图神经网络,如有向超图卷积网络 (directed hypergraph convolutional networks,DHGCN)[62]和有向超图神经网络(directed hypergraph neural network,DHN)[104];以及动态超图神经网络,如DHGNNa(dynamic hypergraph neural network)[52]、自适应超图神经网络(adaptive hypergraph neural network,AdaHGNN)[71]和自适应超图卷积网络(adaptive hypergraph convolutional network,AHGCN)[94]. 其次,超图神经网络的消息传递方式从单纯的超图卷积转变到引入注意力机制、循环神经网络和生成对抗网络,再通过组合它们,设计出基于注意力机制的超图神经网络, 如Hyper-SAGN[25]、 超图注意力网络HANs[60]和HyperGAT[75];超图卷积循环神经网络(hypergraph convolutional recurrent neural network,HGCRNN)[66];超图生成对抗网络 (hypergraph generative adversarial network,HGGAN)[101]和多模态表示学习与对抗超图融合(multimodal representation learning and adversarial hypergraph fusion,MRL-AHF)[102]框架. 再次,超图神经网络的维度从单通道超图卷积升级到多通道,设计出双通道和多通道超图神经网络,如双通道超图协同滤波(dual channel hypergraph collaborative filtering,DHCF)[67]、双通道超图卷积网络 (dual channel hypergraph convolutional network,DHCN)[62]和多通道超图卷积网络 (multi-channel hypergraph convolutional network, MHCN)[83]. 最后,超图神经网络的应用从最初的引文网络分类任务拓展到推荐系统、自然语言处理、股票和交通预测等任务,设计出多种适用于各领域下游任务的超图神经网络,如信号超图卷积网络 (signed hypergraph convolutional network,SHCN)[24]、2HR-DR[62]、时空超图卷积网络(spatio-temporal hypergraph convolution network,STHGCN)[76]和地理-语义-时间超图卷积网络(geographic-semantic-temporal hypergraph convolutional network,GST-HCN)[55].

2 定 义

本节给出了涉及的定义及常见符号的含义,有助于理解本文中的公式. 下面依次给出符号描述,以及图、超图和有向超图的定义.

2.1 符号定义

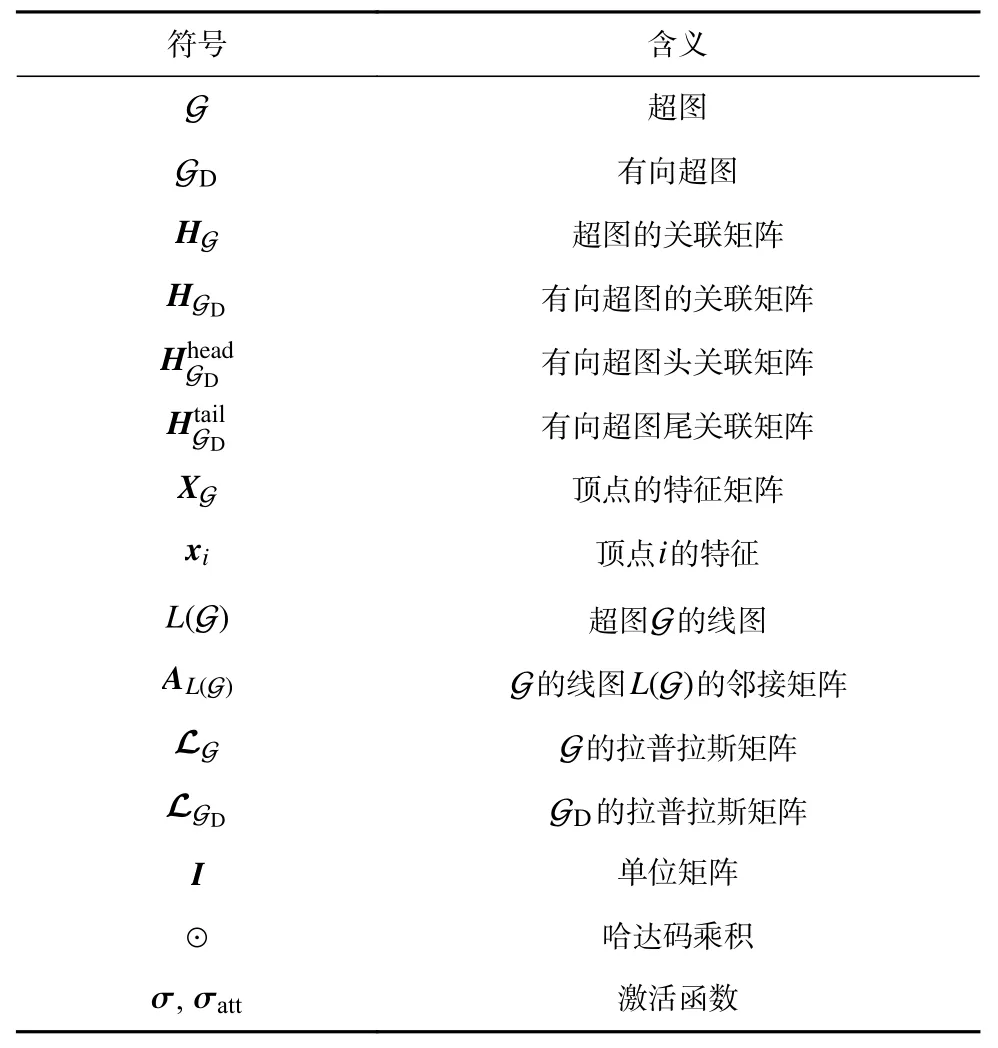

本文中用到的符号及其含义如表1 所示.

Table 1 The Symbol Description表1 符号描述

2.2 图

G=(VG,EG,WG)是一个图,其中VG是顶点的集合,EG是边的集合.|VG|=NG和|EG|=MG,NG∈R,MG∈R分别表示图中顶点和边的数目. 若令和是G中的顶点,则eij=(,)∈EG代表G中连接和的一条边.WG是边的权重矩阵. 图的邻接矩阵A∈RNG×NG定义为

其 中aij表示A中的元素,i,j=1,2,…,NG.

2.3 超 图

G=(VG,EG,WG)代表一个超图,VG是顶点集,EG是超边集. G包含|VG|=NG个顶点和|EG|=MG条超边. 若令是顶点,则超边其中1 ≤me≤NG,1 ≤ne≤NG.WG表示超边的权重矩阵.

通常情况下,超图用关联矩阵HG∈RNG×MG表示,定义为

其中hij是HG的元素,i=1,2,…,NG,j=1,2,…,MG.

若∈VG,节点的度指包含的超边的数目,记为

若∈EG,超边的度指超边中包含的顶点的数目,记为

DVG和DEG分别表示顶点和超边的度矩阵. 有关超图的详细说明可参见文献[50].

事实上,图是超图的一个特例,当超图中的每条超边只包含2 个顶点时,超图就退化为一个普通图.如图2(a)是一个普通图,每条边连接2 个顶点;图2(b)是一个超图,每条超边连接3 个或4 个顶点. 当图2(b)中的每条超边只连接2 个顶点时,超图就退化为一个图,即图2(c)(d).

Fig. 2 Hypergraph and graph图2 超图和图

2.4 有向超图

GD=(VGD,EGD,WGD)代表有向超图,VGD是顶点集,EGD是超弧集,WGD表示超弧的权重矩阵.|VGD|=NGD和|EGD|=MGD分别表示顶点和超弧的数目.每条超弧,其中表示超弧的弧头,∈VGD表示超弧的弧尾. 且关于有向超图的其他描述可参见文献[50,57].

3 超图神经网络模型

在本节中,梳理出一种超图神经网络的分类,依据设计模型采用的方法不同,将现有超图神经网络模型划分为超图卷积神经网络、超图循环神经网络和超图生成对抗网络. 进一步将超图卷积神经网络细分为3 类,详细地介绍每类中的代表性模型.

3.1 超图卷积神经网络

超图卷积神经网络本质上是将GCNs 显式或隐式地扩展得到超图上,又或者引入注意力机制,设计出适用于超图上的卷积操作. 根据设计卷积算子的策略不同,将超图卷积神经网络进一步细分为基于谱域的超图卷积神经网络、基于普通图的超图神经网络和基于注意力机制的超图神经网络.

3.1.1 基于谱域的超图卷积神经网络

基于谱域的超图卷积神经网络是利用图信号和超图谱理论,巧妙地借助傅里叶变换和小波变换,将GCNs 隐式地扩展到超图上. 本节根据超图结构是否有向、是否动态将基于谱域的超图卷积神经网络细分为无向超图神经网络、有向超图神经网络和动态超图神经网络.

首先回顾一下谱域的GCN[114],可以帮助读者更好地理解基于谱域的超图卷积神经网络的演化.Spectral CNN[115]最早利用卷积定理在图上设计谱卷积算子,但它的计算复杂度高. 为解决这一问题,ChebyNet(ChebyShev network)[116]采用K阶切比雪夫多项式近似卷积核,此时图卷积算子仅依赖于顶点的K阶邻居. Kipf 等人[114]继续简化参数,提出只考虑1 阶邻居的GCN,提升了图上半监督学习的性能. GCN 的卷积层定义为:

其中H(l)和H(l+1)分别是第l和l+1层顶点的隐层表示,是参数矩阵.

3.1.1.1 无向超图神经网络

通常情况下超图都是无向超图,即超边不具有方向性,本节主要介绍以无向超图为拓扑结构的超图的神经网络模型.

1)HGNN

利用超图建模数据间的高阶关系,充分地考虑了对象间的高阶关系和多模态特性. 为更好地理解HGNN 定义的卷积,首先要理解超图的拉普拉斯矩阵. Zhou 等人[117]定义了超图拉普拉斯矩阵,其特征分解为其中 Λ是特征值的对角矩阵,UG是特征向量矩阵. 依据超图的拉普拉斯矩阵的定义,将GCN 类比到超图上,设计出超图卷积算子.

对于超图上的信号x,首先将x经过傅里叶变换从空域转换到谱域,再在谱域上执行卷积操作,然后利用傅里叶逆变换将卷积结果从谱域转换到空域.因此,通过傅里叶变换和逆变换,信号x与滤波器g的谱卷积可定义为

其中g(Λ)是傅里叶系数的函数.

由于傅里叶变换及其逆变换的计算成本高,采用截断切比雪夫多项式作为其近似多项式,谱卷积被重新定义为

其中Tk(y)=2yT(k−1)(y)−T(k−2)(y)代表切比雪夫多项式的递归形式,Tk()是变量为拉普拉斯算子的截断切比雪夫多项式.

若令K=1 且λGmax=2,降低阶数和减少计算的谱卷积定义为

其中 Θ0和 Θ1是参数. 若用式(10)中的 Θ表示 Θ0和Θ1来进一步约束参数数量:

则式(10)代入式(9)得到1 阶卷积为

最终,采用矩阵形式表示HGNN 的超图卷积层定义为

其中和分别是第l和l+1层顶点的隐层表示.若令则式(12)可重写为

从式(6)(13)可以发现GCN 和HGNN 的卷积计算形式很相似,都是矩阵相乘,只是两者描述数据关系所使用的建模工具不同,分别是图和超图,用SG和PG表示. 与传统的超图学习方法相比,HGNN 未使用超图拉普拉斯矩阵的逆运算,节约了计算成本.

2)行归一化超图卷积层

文献[118]给出另一种超图卷积的形式,即行归一化超图卷积层,定义为

3)MultiHGNN

Huang 等人[93]提出多超图神经网络 (multi-hypergraph neural network,MultiHGNN)学习具有多模态特性的数据,用超图建模每种模态,分别在每个超图上执行卷积操作,采用均值方法生成顶点的最终表示;而HGNN 在拼接所有模态对应的超图后,执行卷积操作得到顶点的最终表示.HGNN 与MultiHGNN 的具体框架比较如图3 所示.

Fig. 3 Comparison of HGNN and MultiHGNN图3 HGNN 与MultiHGNN 的比较

4)HplapGCN

Ma 等人[119]将超图拉普拉斯LG推广到超图p-拉普拉斯LpG. 鉴于超图p-拉普拉斯能够保存超图概率分布的几何特性,Fu 等人[54]专门为超图p-拉普拉斯设计了超图p-拉普拉斯图卷积网络 (hypergraph p-Laplacian graph convolutional network,HpLapGCN).HpLapGCN 的卷积层定义为

5)HWNN

为避免耗时的拉普拉斯分解,Sun 等人[72]采用多项式近似的小波变换代替傅里叶变换,设计出适用于异构超图的超图小波神经网络(hypergraph wavelet neural network,HWNN). 用小波变换替换式(7)中的傅里叶变换,可得到基于小波变换的超图卷积定义:

根据Stone-Weierstrass 定理[120]得到小波变换及其逆变换的近似多项式和其中LG是的1 阶多项式. 这2 个近似多项式避免了HGNN 中的拉普拉斯分解操作. 将它们代入式(16)后,基于小波变换的超图卷积定义为

最终的HWNN 的卷积层定义为

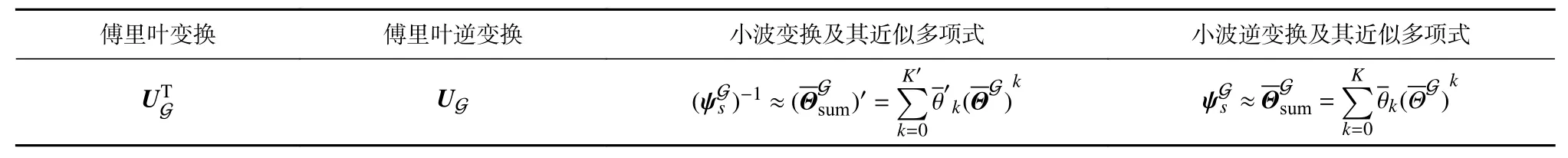

其中是特征投影矩阵,是滤波器.HGNN 中的傅里叶变换和HWNN 中的小波变换的详细描述如表2 所示.

Table 2 Fourier Transform and Wavelet Transform表2 傅里叶变换和小波变换

6) HGWNN

HGWNN[22]是另一种引用小波的超图小波神经网络,直接采用截断切比雪夫多项式近似小波系数.它的卷积层定义为

除此之外,HNHN[61]是一种对顶点和超边加入非线性激活函数和归一化操作的超图卷积网络. 超图卷积过程包含归一化节点、更新超边、归一化超边和更新节点4 个阶段. 双超图卷积网络(dual hypergraph convolutional network,DualHGCN)[85]通过2 个同构超图建模多重二分网络,根据二分网络的特性设计消息内和消息间的传递策略,促进信息共享.Wu等人[106]提出用于属性图学习的双视图超图神经网络(dual-view hypergraph neural network,DHGNNb),采用属性超图和结构超图,分别表示顶点的属性和拓扑结构;再送入共享超边卷积层、特定超边卷积层和注意力层,生成顶点的最终表示.

从上述可知,无向超图卷积神经网络都是以谱理论为基础,通过傅里叶变换或小波变换实现超图卷积,同时也可加入非线性变换、归一化操作、无监督等增强学习能力.

3.1.1.2 有向超图神经网络

有向超图是一种特殊的超图,有向超边携带重要的方向信息,本节主要介绍以有向超图为拓扑结构的神经网络模型.

1)基于有向超图拉普拉斯的超图神经网络

Tran 等人[57]提出基于有向超图拉普拉斯算子的有向超图神经网络,应用于有向超图的半监督学习.首先用D和表示有向超图

有向超图拉普拉斯算子LGD定义为

基于此,有向超图卷积层被定义为

其中表示超弧的头度矩阵,表示顶点的尾度矩阵,S是对角矩阵,表示第l层可学习的参数矩阵,和是第l和l+1层顶点的隐层表示.

2) DHGCN

在超图卷积运算中融入方向信息,DHGCN 的卷积层定义为

3)DHConv

有向超图卷积(directed hypergraph convolution,DHConv)[112]包含顶点聚合和有向超边聚合2 个阶段.DHConv 中有向超图的关联矩阵∈定义为

4) DHN

其中是超边在第l层的隐层表示,是有向超图对应的无向超图的关联矩阵,和分别是第l和l+1层顶点的隐层表示,表示可学习的参数矩阵,[·,·]代表拼接运算. 从式(27)可以看出,当DHN更新顶点的特征表示时,考虑到顶点表示、有向超边表示和无向超图结构.

从上述可知,有向超图神经网络模型中的超边都带方向信息. 其中,DHN 将有向超图转换为有向图,卷积操作中融入了无向超图的结构. 而其他3 种有向超图神经网络都定义了含有方向信息的有向超图关联矩阵,但各自具体的定义方式不同.

3.1.1.3 动态超图神经网络

在无向超图和有向超图神经网络中,建模数据的超图结构都是静态的,超图结构没有随着顶点特征的更新而动态调整,这会影响模型性能. 为了动态地构建和更新超图结构,学者们设计出动态超图神经网络模型.

1) DHGNNa

最初始构造的超图可能不适合表示最终的数据结构,Jiang 等人[52]提出一种动态超图神经网络DHGNNa,包含动态超图构建(dynamic hypergraph construction,DHG)和超图卷积(hypergraph convolution,HGC)2 个模块. 其中,HGC 模块由顶点卷积VertexConv 和超边卷积HyperedgeConv 组成. VertexConv 聚合超边e包含的所有顶点特征,生成超边特征xe=VertexConv(XGu);HyperedgeConv 引入注意力机制聚合包含顶点u的超边特征,生成u的新特征xu=HyperedgeConv(xe). 然后根据更新后的顶点特征重新构建超图,堆叠多层DHG 和HGC 实现动态地构建超图.

2) AdaHGNN

AdaHGNN 通过关联矩阵自动学习,构造自适应超图,进而学习高阶语义关系. 在构造超图的过程中,超边被定义为顶点之间的一种抽象关系,可在训练阶段自动地学习.HGA表示自适应超图的关联矩阵,AdaHGNN 的超图卷积层定义为

3) AHGCN

AHGCN 采用自适应超边的构造方法生成基于位置的超图Gloc和基于内容的超图Gcon,并引入批量归一化[121]和残差连接加速和稳定训练,AHGCN 的超图卷积层定义为

其中BN(·)是批量归一化,和是第l和l+1层顶点的隐层表示,和代表可学习的参数,HG由Gloc和Gcon组成.

从上可知,本节提到的超图神经网络通过不同的方式动态地优化超图的建模过程. 其中,DHGNNa利用更新后的顶点特征构建新的超图,AdaHGNN 在训练阶段自动地学习顶点间的抽象关系,AHGCN 用一种自适应超边的构造方法生成超图. 除此之外,半动态超图神经网络(semi-dynamic hypergraph neural network,SD-HNN)[64]通过构建静态超图和动态超图捕获人体运动学.Zhang 等人[97]设计一个可以自适应优化超图结构的超图拉普拉斯适配器 (hypergraph laplacian adaptor,HERALD),动态地更新超图结构. 基于张量的动态超图学习(tensor-based dynamic hyperg raph learning,t-DHL)[32]采用张量表示建模超图结构,在学习的过程中动态地更新超图结构.

3.1.2 基于普通图的超图神经网络

在介绍本节内容之前,需要明确本节涉及的普通图的含义,具体可参见2.2 节中图的定义,每条边仅连接2 个顶点. 本节介绍基于普通图的超图神经网络,显示地将图卷积网络扩展到超图上. 它们具有共同的特点,即首先采用特定的方法将超图转换成普通图,然后在这个普通图上执行图卷积神经网络.

1) HyperGCN

HyperGCN 是一种对超图运用图卷积网络进行训练的方法. 超图谱理论[122-123]可以将超图转换为一个带权普通图. 具体地,选取每条超边中信号特征最大的2 个顶点,形成一条边来表示该超边,超边中的其他顶点被删除,将导致信息的丢失. 因此,HyperGCN引入由删除的顶点组成的中介,将中介中的每个顶点与代表超边选取的2 个顶点相连接,使用Chan 等人[124]的方法定义超图拉普拉斯. HyperGCN 本质是用带权的普通图代替超图,每条超边退化为带权重的边,然后在带权重的普通图上执行图卷积操作即可.

2) LHCN

线超图卷积网络 (line hypergraph convolution network,LHCN)[56]首次引入超图的线图这一概念,超图的线图是一个普通图. 首先将超图G映射到一个加权带属性的线图L(G),其次对线图L(G)执行图卷积操作,超图的线图的卷积定义为

3) HAIN

LHCN 需要显式地计算线图,计算成本高,超图注意力同构网络 (hypergraph attention isomorphism network,HAIN)[79]用一种隐式的方式生成线图来解决此问题. 超图G 被隐式地生成线图表示融入超图结构的邻接矩阵. 由于线图中的顶点代表的是超图中的超边,HAIN 采用自注意力机制学习线图中顶点的权重,衡量了不同超边对顶点的重要性. 受图同构网络(graph isomorphism network,GIN)[125]的启发,HAIN 每层定义为

4) HI-GCN

超图诱导图卷积网络(hypergraph induced graph convolutional network,HI-GCN)[77]将超图结构植入到图卷积运算中来更新顶点嵌入.HI-GCN 的卷积层定义为

其中DGc是Gc的度矩阵,Gc是超图通过团扩张生成的普通图,WGc是超边权重矩阵,是可学习权重矩阵,和是第l和l+1层顶点的隐层表示.HI-GCN 有效包含了图和超图的信息.

从上述4 个模型可知,基于普通图的超图神经网络的共同点是采用一定的策略先将超图转化为普通图,然后以图或者超图作为拓扑结构开发模型. 与上述4 个模型类似,神经超链接预测器(neural hyperlink predictor, NHP)[26]采用无向超图和有向超图建模数据,利用团扩张将2 种超图转化为普通图后实现超图链路预测.Hou 等人[78]提出将加权有向超图转换为加权超边图,而加权超边图就是一个普通图. 除此之外,文献[59]提出一种超图转换为普通图的方法,线扩张 (line expansion,LE),将超图中的顶点-超边对作为普通图中的一个顶点,称之为线顶点,如果线顶点(顶点-超边对)之间有公共的顶点或超边,连接这2个线顶点形成一条边,依次执行,最终得到与之对应的普通图.

3.1.3 基于注意力机制的超图神经网络

注意力机制常用于图神经网络中权衡顶点和边的重要性,取得显著成效. 同样,超图神经网络也可引入注意力机制来体现顶点和超边等的重要性. 本节对现有的超图神经网络以注意力机制为关键技术的模型进行归纳和总结,具体如下所述.

1) Hyper-SAGNN

Hyper-SAGNN 是一种用于超图学习的框架,能够处理同构和异构超图、一致和非一致超图,并利用学习到的节点嵌入预测非一致异构超图中的超边.Hyper-SAGNN 包含静态嵌入模块、动态嵌入模块和预测模块,在动态嵌入模块中引入多头注意力机制生成动态嵌入.

2) HANs

HANs 调整输入的多种模态之间的信息层次,将它们整合到同一信息层次. 采用符号图定义不同的模态之间的公共语义空间,在语义空间中构建共同注意力映射以获取不同模态的联合表示.

3) HyperGAT

HyperGAT 设计双注意力机制学习有鉴别力的表示,用于归纳式文本分类和降低计算成本.HyperGAT 层定义为

其中和是第l+1层的顶点vi和超边ei的表示.超边聚合函数HyperedgeAGG(·)将包含顶点的所有超边的特征聚合到该顶点,并通过超边级注意力机制为每条超边分配权重以表明每条超边对该顶点的贡献度;节点聚合函数VertexAGG(·)将超边中所有顶点的特征聚合到该超边,并通过顶点级注意力机制为每个顶点分配权重以表明每个顶点对于超边的贡献度.

4) HGATs

与HyperGAT 类似,超图注意力网络(hypergraph attention networks,HGATs)[21]也是基于双注意力机制的超图注意力网络,包含注意力顶点聚合和注意力超边聚合,在聚合特征的过程中引入注意力机制为顶点和超边分配不同的权重.

5) SAHDL

稀疏注意超图正则化字典学习(sparse attention hypergraph regularized dictionary learning,SAHDL)[73]算法设计出一种新的稀疏注意力机制为每个顶点分配重要性权重,并将权重值融入到构建超图的过程中. 引入稀疏注意力的超图关联矩阵HSA定义为

其中eSA代表一条超边,dis(·)表示计算2 点之间的距离,表示顶点i的注意力权重值,可通过公式计算得到.aSA是权重向量,PK表示从K个最近邻居中选取的样本的特征, τ是控制稀疏性的超参数.

6) STHAN-SR

时空超图注意力网络(spatiotemporal hypergraph attention network,STHAN-SR)[82]利用超图注意力巧妙地将时间霍克斯注意力与空间超图卷积相结合,捕捉时空相关性.表示引入注意力机制的超图关联矩阵,STHAN-SR 的超图卷积层定义为

它采用多头注意力机制确保训练稳定.

7) HGTAN

超图三注意力网络(hypergraph tri-attention network,HGTAN)[100]设计了超边内、超边间和超图间3 个注意力模块,考虑顶点、超边和超图的重要性. 其中,超边内注意力和超边间注意力与HyperGAT 和HGATs类似,但HGTAN 中采用超图间注意力模块,权衡不同超图的重要性.

从上述可知,该类超图神经网络模型的共同之处是利用注意力机制突显顶点、超边或超图在消息聚合过程中各自的重要性. 除此之外,有向超图注意力网络(directed hypergraph attention network,DHAT)[112]结合3.1.1.2 节中介绍的DHConv 和注意力机制挖掘数据间的潜在关系.Sun 等人[126]提出一种基于多级超边蒸馏策略的超图神经网络,采用节点级、超边级和语义级注意力学习和更新顶点表示.

3.2 超图循环神经网络

本节重点介绍引入RNN 构建超图神经网络模型,RNN 主要用于捕获时间特性.

1)HGC-RNN

HGC-RNN 是一种能够预测结构化时间序列传感器网络数据的模型. 它使用超图卷积提取数据的结构特征,同时采用RNN 结构提取数据序列中的时间依赖性. 随时间演化的HGC-RNN 层定义为

其中FRNN是循环神经网络,如GRU.FHGC1和FHGC2是用于更新顶点表示的超图卷积操作.

2) 基于卷积、注意力和GRU 的超图神经网络

Xia 等人[127]开发了一种基于时间的超图神经网络,集成了超图卷积、GRU 和注意力机制,有效地学习超图中异构数据之间的高阶相关性.

上述2 种超图神经网络有效地组合RNN 与超图卷积. 与它们不同的是3.1.3 节中的HGTAN 结合RNN 和超图注意力机制,使用GRU 从时间序列数据中捕捉顶点的时间动态性,再将其送入HGTAN 更新节点的表示. 1)和2)都充分地考虑了数据间的时间特性和拓扑结构.

3.3 超图生成对抗网络

受生成对抗网络的启发,研究者引入生成对抗网络设计出超图神经网络模型,本节详细地介绍这类网络.

1) HGGAN

HGGAN 提出用交互式超边神经元模块(interactive hyperedge neurons module,IHEN)作为生成器捕获数据间的复杂关系;鉴别器是MLP.IHEN 的定义为:

2) MRL-AHF

MRL-AHF 利用多模态间的互补和多模态内的交互,提升表示学习能力和多模态融合性能. 潜在表示分别送入编码器EA 和EB 得到表示和,且生成的2 个超图用关联矩阵HEA和HEB表示. 通过对抗训练策略实现超图融合,得到顶点的特征.

其中DVEA和DVEB分别是HEA和HEB的顶点度矩阵,DEEA和DEEB分别是HEA和HEB的超边度矩阵,ΘEB是权重矩阵.

从上述可知,HGGAN 和MRL-AHF 巧妙地在生成对抗网络中融入超图结构,提升了模型学习表示的能力.

3.4 其他模型

文献[128] 通过低秩滤波器设计高效的超图卷积. 非线性超图扩散 (nonlinear hypergraph diffusion,HyperND)[87]沿着超图结构传播特征和标签. 受双曲图卷积神经网络[129]的启发,Li 等人[103]提出一种带有预训练阶段的双曲超图表示学习方法(hyperbolic hypergraph representation learning method for sequential recommenddation,H2SeqRec)有效地缓解超图的稀疏性和长尾数据分布问题,通过双曲空间超图神经网络学习动态嵌入. DHT(dual hypergraph transformation)[96]是一种边表示学习框架. Srinivasan 等人[130]设计了一种用于学习顶点、超边和完全超图表示的超图神经网络. 受GCNII[131]的启发,残差增强多超图神经网络(residual enhanced multihypergraph neural network,ResMultiHGNN)[93]缓解加深HGNN 引起的过平滑等问题. Lin 等人[113]使用采样超边等方式设计出一种深层超图神经网络(deep gypergraph neural network,DeepHGNN). 深度超边 (deep hyperedges,DHE)[132]利用上下文和集合成员对超图进行转导和归纳式学习. G-MPNN[70]统一不同结构的消息传递神经网络(message passing neural network,MPNN)[133],对多关系有序超图有强大的归纳能力. UniGNN[95]是一种将经典的GNNs,如GCN,GAT(graph attention network)等推广到超图上的统一框架. HyperSAGE[74]受GraphSAGE(graph sample and aggregate) [134]的启发,设计出一种归纳式超图学习框架. HyperGene[92]是一种基于GNNs 的超图预训练框架. NetVec[86]是一个能够提高运行速度,用于解决大型超图的多层超图嵌入框架.AllSet [99]将传播规则描述为2 个多集函数的组合,并将多集函数的学习问题与超图神经网络联系起来.

4 应 用

现实生活中很多数据间的交互关系可以很自然地用超图表示,虽然超图神经网络的发展历程较短,但它已经被广泛地应用到不同领域的任务中并取得成功. 本节详细地介绍超图神经网络在各领域中的实际应用.

4.1 社交网络

4.1.1 引文网络分类

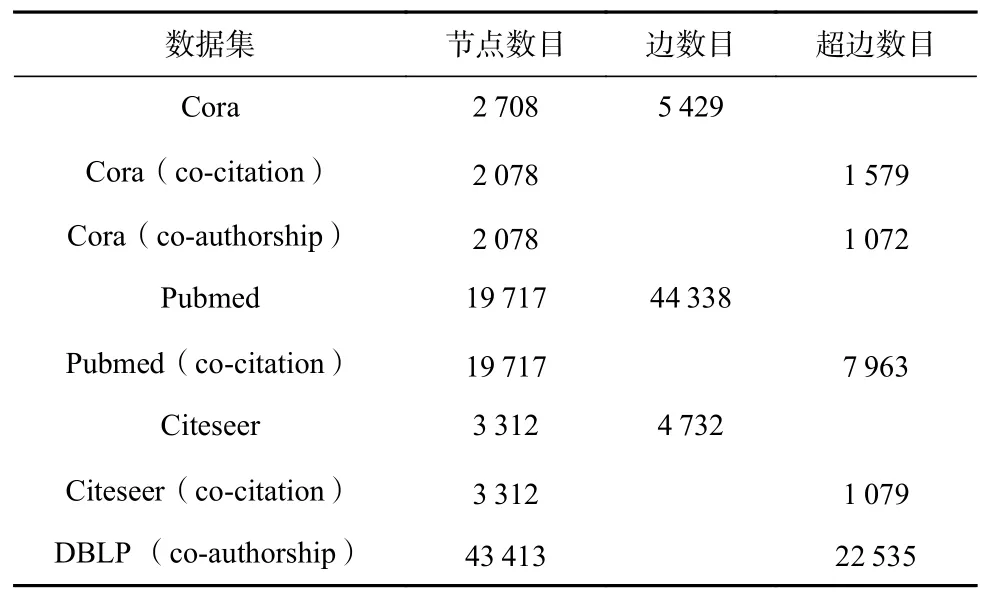

在引文网络中,超图可用于建模论文的引用关系和论文的合著关系. 引文网络分类任务属于节点级任务,常用的数据集有Cora,DBLP,Pubmed,Citeseer,具体描述如表3 所示. HGNN, HyperGCN, DHGNNa,HyperSAGE, LHCN, iHGAN[80],HNHN ,HyperND 等都可用于引文网络分类. 表4 列举了应用于引文网络分类的超图神经网络模型及其采用的数据集和评价指标.

Table 3 Common Datasets of Citation Network表3 引文网络常用数据集

Table 4 Hypergraph Neural Network Models, Datasets and Evaluations Applied for Citation Network Classification表4 应用于引文网络分类的超图神经网络模型、数据集和评价指标

对于半监督节点分类任务,表5 罗列了3 种超图神经网络模型与经典的GCN 在Cora 上的比较,实验中的训练集和测试集数目分别为140 和1 000.其中DHGNNa和iHGAN 的准确度分别比GCN 提升了1%和1.4%,展现了超图神经网络的有效性.

Table 5 Experimental Results of Different Models on Cora Dataset表5 不同模型在Cora 数据集上的实验结果%

4.1.2 情感识别

多超图神经网络(multi-hypergraph neural network,MHGNNa)[51]利用生理信号识别人类情绪,每种类型的生理信号建模为一个超图,超图中的顶点是一个受试对象和刺激物的二元组,超边代表受试者之间的相关性. 若存在多种生理信号,则采用多个超图建模. 每个超图上执行卷积后融合多个超图卷积的输出结果,得到顶点的最终表示. 文献[53]中提出一种利用生理信号识别情绪的边加权超图神经网络,在训练的过程中同时学习超边权重和滤波器参数.

4.2 推荐系统

序列超图增强下一项推荐(sequential hypergraphs to enhance next-item recommendation,HyperRec)[23]是一种端到端的框架,该框架利用序列超图描述项目之间的短期相关性,结合超图卷积层生成有效的项目动态嵌入. H2SeqRec 在双曲空间中设计超图卷积,从年度、季度和月度多个时间维度学习项目的嵌入.DHCF 是双通道协同过滤框架,它采用分治策略学习用户和项目的不同表示. 用户间和项目间的高阶相关性建模为用户超图和项目超图,并利用超图卷积学习用户和项目的表示. 双通道的设置使得在集成用户和项目一起推荐的同时,又保持各自的属性.SHCN 是基于用户评论的信号超图卷积网络,设计了符号超边卷积操作,通过自定义的邻域聚合策略有效地传递用户偏好,改进特征感知的推荐性能.

DHCN, SHARE[90], HGNNA[110]是基于会话推荐的超图神经网络模型. DHCN 是结合超图和超图线图设计的双通道超图卷积网络,其中超图卷积负责捕获项目级的高阶关系,超图的线图卷积负责学习会话级关系. S2-DHCN 是加入了自监督学习的DHCN变体. SHARE 用一个超图表示每个会话,项目是超图中的顶点,超边连接一个上下文窗口中所有的项目.引入超图注意力机制来衡量项目对会话的重要性和会话对项目的影响. HGNNA 是基于超图神经网络和注意力机制的推荐模型. HGNNA 首先利用超图神经网络学习项目间的关联,然后引入自注意力机制聚合会话信息,最后通过图注意机制挖掘出会话间的相关性.

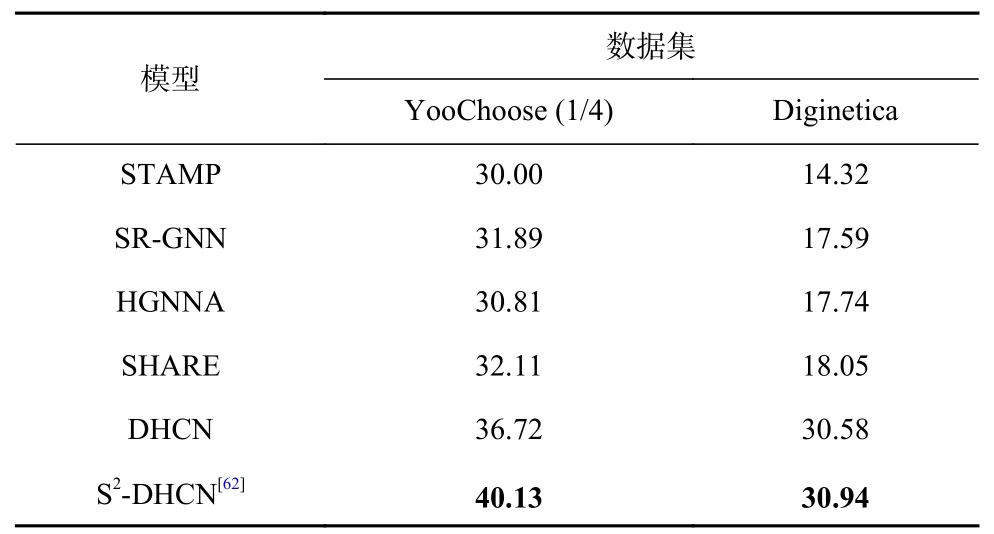

STAMP(short-term attention/memory priority)[135]和SR-GNN(session-based recommendation with graph neural networks)[136]是2 个先进的基线模型,分别通过引入注意力机制和GNNs 来增强基于会话的推荐.表6 记录了基于会话推荐常用的数据集YooChoose和Diginetica. 从表7 中可以看出,超图神经网络模型SHARE,DHCN, S2-DHCN 优于SR-GNN,在Yoochoose 1/4 上平均倒数排名(mean reciprocal ranking,MRR)的MRR@K 值分别提升了0.22%,4.83 %,8.24%;在Diginetica 上MRR@K 值分别提升了0.46%,12.99%,13.35%. 而HGNNA 的性能也优于STAMP,证明了超图神经网络模型在该任务中的成效显著.

Table 6 Common Datasets of Session-Based Recommendation表6 基于会话推荐的常用数据集

Table 7 Results of Different Models for Session-Based Recommendation(MRR@K)表7 基于会话推荐不同模型的结果(MRR@K) %

MHCN,HASRE[109],SHGCN[111]都是用于社会推荐的超图神经网络模型.MHCN 是多通道超图卷积网络,它利用多通道,如社交通道、联合通道和购买通道分别编码用户的高阶关系,在超图卷积网络的训练中引入自监督学习增强推荐性能. HASRE 是基于超图注意力网络的社会推荐算法,超图建模用户之间的高阶关系,引入图注意力机制为用户的好友分配合适的权重,反映出好友对用户的不同影响.SHGCN 主要解决非同质社会推荐问题,利用超图表示复杂的三元社交关系(用户-用户-项目),设计超图卷积网络学习社会影响和用户偏好.

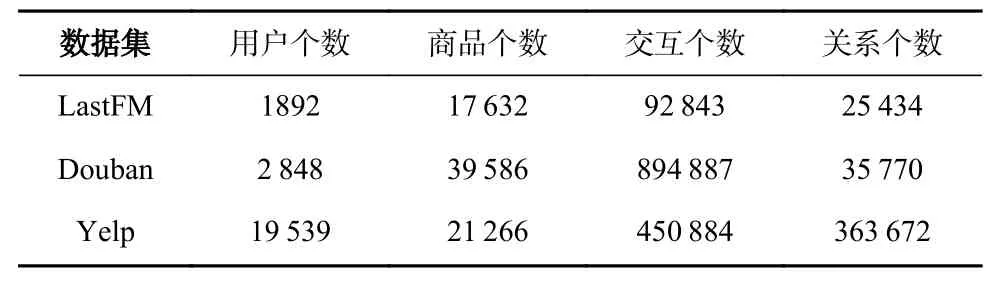

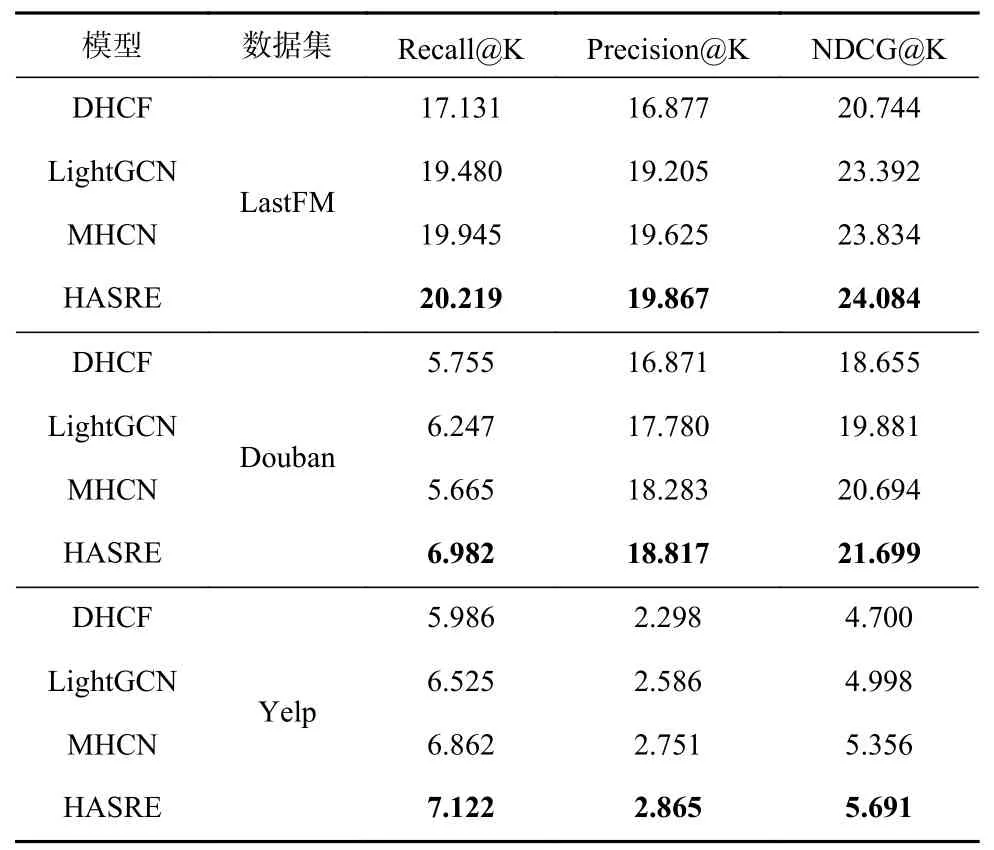

LightGCN[137]是一个非常具有竞争力的基线模型,它对GCN 的内部结构进行了调整,大多数情况下在社会推荐任务中表现出最好或次优的性能. LastFM,Douban,Yelp 是常用于社会推荐的数据集,详情如表8 所示. 表9 记录了LightGCN 与超图神经网络模型DHCF,MHCN,HASRE 的比较,实验结果引用自HASRE,故这里的训练集、验证集和测试集的占比与HASRE 一样,分别为80%,10%,10%. 除了DHCF,其他3 个超图神经网络模型的性能都优于LightGCN.其中,HASRE 在3 个数据集中均表现出最佳的效果,展现了超图神经网络模型在社会推荐任务中具有显著的效果.

Table 8 Common Datasets of Social Recommendation表8 社会推荐的常用数据集

Table 9 Results of Different Models for Social Recommendation表9 社会推荐不同模型的结果%

群体推荐的分层超图学习框架HHGR[107]分别在用户级和组级超图上设计超图卷积网络,捕获用户之间的组内和组间的交互. HyperTeNet[108]用于实现任务中的个性化列表延续任务,构建3 一致超图,采用Hyper-SAGNN 学习用户、项目和列表之间的三元关系. Liu 等人[89]设计的知识感知超图神经网络(knowledge-aware hypergraph neural network,KHNN),从知识图谱学习用户、项目和实体之间的高阶关系. 表10介绍了应用于推荐的超图神经网络模型及其采用的数据集和评价指标.

Table 10 Hypergraph Neural Network Models, Datasets and Evaluation Applied for Recommendation System表10 应用于推荐系统的超图神经网络模型、数据集和评价指标

4.3 计算机视觉

4.3.1 图像任务

Wadhwa 等人[138]提出一种基于超图卷积的图像补全技术,从输入的数据中学习超图结构. 超图卷积中代表超图结构的关联矩阵包含每个顶点对超边的贡献信息,由空间特征的互相关计算贡献权重. HGCNN(hypergraph convolutional neural networks)[63]是解决3D 人脸反欺骗问题的超图卷积神经网络. 每张人脸构建一个超图,利用超图卷积学习深度特征和纹理特征,将它们拼接起来作为用于分类的最终表示. 谱-空间超图卷积神经网络(spectral-spatial hypergraph convolutional neural network,S2HCN)[105]是用于高光谱图像分类的超图卷积神经网络,首先从高光谱图像中挖掘谱特征和空间特征,然后分别基于这2 个特征构建超图,并将这些超图融合为一个超图,最后将超图和初始高光谱图像作为超图卷积的输入. 多粒度超图(multi-granular hypergraph,MGH)学习框架[98]能够同时运用时间和空间线索完成视频身份识别,故超图神经网络可用于探索视频序列中的多粒度时空线索之间的高阶相关性.

HI-GCN 和AdaHGNN 用于多标签图像分类任务.HI-GCN 采用数据驱动的方式为标签构建一个自适应超图,再利用超图诱导图卷积网络更新标签嵌入. AdaHGNN 用自动学习关联矩阵的方法来构造自适应超图,利用超图神经网络学习多标签之间的高阶语义关系. HI-GCN 和AdaHGNN 构建的超图中,每个标签作为一个顶点,但定义超边的方法不同. Dang等人[139]设计一种用于解决带噪声的标签学习问题的超图神经网络.

4.3.2 视觉对象抽取

Zheng 等人[140]为视觉事件推理任务设计了一种多模态模型,称为超图增强图推理. 该模型通过有效地集成图卷积、超图卷积和自注意力机制,提升模型的视觉推理和视觉叙述能力. 超图构建采用KNN 算法,其中顶点代表视觉特征和文本特征,超图卷积操作与HGNN 类似.

4.3.3 视觉问答

多模式学习的主要任务是处理来自多个不同来源的信息,视觉问答(VQA)是一种典型的多模式学习任务,它的任务目标是回答关于图像场景的文本问题,需要处理包括图像和文本的信息.HANs 是用于多模态学习的超图注意力网络.

4.3.4 行为识别

Hyper-GNN[84]是基于骨骼的动作识别的超图神经网络,通过三流超图神经网络动态地融合关节流、骨骼流和运动流3 种特征,并充分地利用它们之间的互补性和多样性. SD-HNN 通过半动态超图神经网络从2D 姿势重新估计人体的3D 姿势,用超图建模人体,使用静态超图和动态超图分别表示关节之间的局部和全局运动约束,有效地刻画了人体关节之间的复杂运动学关系.

4.3.5 视觉对象分类

视觉对象分类任务中,每个对象作为顶点,采用KNN 算法生成超边,运用HGNN 和HGATs 实现对象识别任务. HGNN 完全依赖超图结构,没有突显出顶点和超边的重要性;HGATs 不依赖于超图结构,对顶点和超边赋予不同的重要性,可以用于归纳学习. 对于多模态数据,MultiHGNN 拼接(采用均值)的是卷积结果,而HGNN 拼接的是超图结构. HGWNN 是引入小波变换设计的超图小波神经网络,采用最远点采样(FPS)算法和球查询方法构建超图. 多尺度超图神经网络(multi-scale hypergraph neural network,MHGNNb)[91]的超图卷积操作与HGNN 类似,但它融合了每层超图卷积的顶点特征;而HGNN 仅使用最后一层特征,未考虑每一层的顶点特征信息,显得信息比较单一. DeepHGNN 是一种加深HGNN 的超图神经网络.

NTU 和ModelNet40 是超图神经网络常用于视觉对象分类的数据集,具体细节如表11 所示. 表12 记录了6 个超图神经网络与GCN 在2 个数据集上的实验结果,可以观察到超图神经网络模型在NTU 上的分类准确率都高于84%,比GCN 至少提高了8%, 其中HGWNN 和ResMultiHGNN 分类准确率分别提高了15%和16%. 同样地,超图神经网络模型在Model-Net40 上的分类准确率也都优于GCN,充分地展现出超图神经网络在这类任务中的优势. 表13 总结了应用于计算机视觉的超图神经网络模型及其采用的数据集和评价指标.

Table 11 Common Datasets of Visual Object Classification表11 视觉对象分类常用数据集

Table 12 Results of Different Models for Visual Object Classification (Accuracy)表12 视觉对象分类不同模型的结果(Accuracy)%

Table 13 Hypergraph Neural Network Models, Datasets and Evaluations Applied for Computer Vision表13 应用于计算机视觉的超图神经网络模型、数据集和评价

4.4 自然语言处理

4.4.1 文本分类

HyperGAT 是针对文本分类任务设计的基于双注意力机制的超图注意力网络,使用文档级超图建模每个文本文档,顶点表示文档中的单词,存在顺序超边和语义超边. 采用顶点级和边级注意力学习高阶关系和有判别力的表示. 该模型适用于归纳式训练.

4.4.2 生物事件抽取

生物医学事件抽取是涉及生物医学概念的一项抽取任务,需要从生物医学的上下文本中提取有用的基本信息. Zhao 等人[141]提出一个用于解决该任务的端到端的文档2 级联合框架,通过堆叠 HANN 层,有效地建模生物医学文档中局部和全局上下文之间的相互关联.

4.4.3 知识图谱

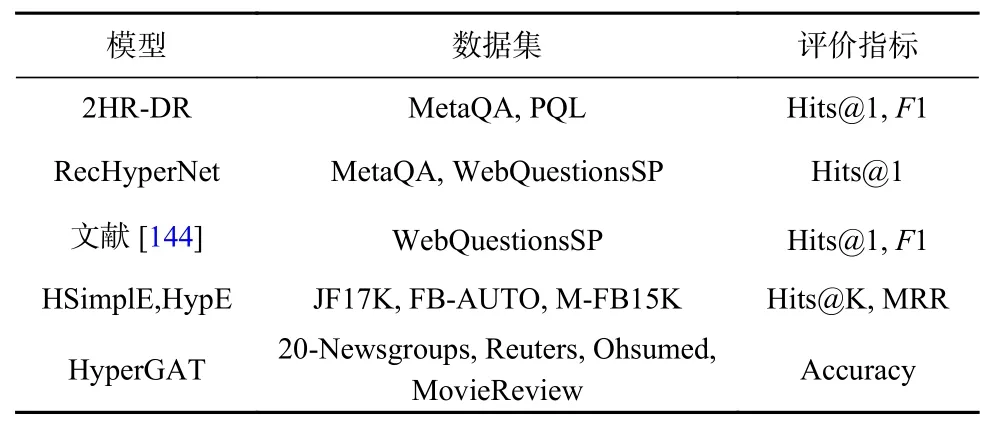

DHGCN 是在超图卷积操作中融入方向信息的有向超图卷积网络,它很自然地将超图卷积扩展到有向超图,提出基于有向超图卷积网络的多跳知识库问答模型2HR-DR. 受CompGCN [142]和递归超图的启发,Yadati 等人[143]引入递归超图建模知识库,提出递归超图网络(recursive hypergraph network, Rec-HyperNet),用于知识库问答任务. Han 等人[144]提出基于文本增强知识图谱的开放领域问答模型,利用文本语义信息增强实体表示和文本结构补充知识库中的关系. 其中每个文本视为一条超边,用于连接该文本中的实体,然后对文本超边形成的超图执行超图卷积,更新实体信息. Fatemi 等人[65]提出HSimplE和HypE 直接对知识超图进行链路预测.

知识库问答是自然语言处理中的一种任务,常用的传统模型有KV-MemNet(key- value memory network)[145]和 GraftNet(graphs of relations among facts and text networks)[146],前者将知识库事实以键-值的结构存储;后者用文本信息和实体一起构建图,并将 GCN应用于推理. 常用数据集MetaQA 和WebQuestionsSP的描述如表14 所示. 虽然传统模型有各自的优势,但从表15 可以看出超图神经网络模型2HR-DR 和RecHyperNet 的性能更优. 特别地,RecHyperNet 在2个数据集上比GraftNet 分别提升了2.1 个百分点和1.6 个百分点,表明超图神经网络模型的可行性和有效性. 实验结果来自RecHyperNet 中的实验,故具有可比性. 表16 总结了应用于自然语言处理的超图神经网络模型及其采用的数据集和评价指标.

Table 14 Common Datasets of Knowledge Base Question Answering表14 知识库问答常用数据集

Table 15 Results of Different Models for Knowledge Base Question Answering(Hits@1)表15 知识库问答不同模型的结果(Hits@1)%

Table 16 Hypergraph Neural NetWork Models, Datasets and Evaluations Applied for Natural Language Processing表16 应用于自然语言处理的超图神经网络模型、数据集和评价指标

4.5 股票预测

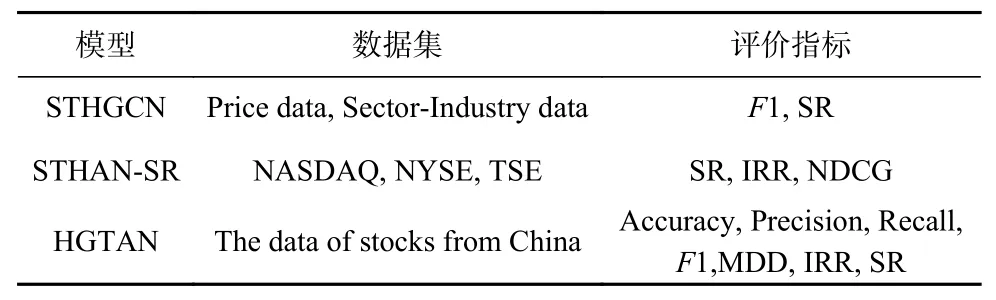

时空超图卷积网络STHGCN、时空超图注意力网络STHAN-SR 和超图三注意力网络HGTAN 都是用于预测股票趋势的模型. 具体地,STHGCN 用超图表示股票间的产业关系,设计时空超图卷积学习股票价格的时间演化和股票之间的关系. STHAN- SR将股票预测任务刻画为一个学习排序问题,结合超图卷积和时间霍克斯注意机制探索股票之间的空间复杂关系和时间依赖性. HGTAN 引入分层注意力机制,设计超边内、超边间和超图间的注意力分别衡量顶点、超边和超图在股票间信息传递中的重要性,从而挖掘出股票运动的潜在关系. 表17 记录了应用于预测股票趋势的超图神经网络模型及其采用的数据集和评价指标.

Table 17 Hypergraph Neural Network Models, Datasets and Evaluation Applied for Stock Trend Prediction表17 应用于预测股票趋势的超图神经网络模型、数据集和评价指标

4.6 化学和医疗

Hyper-SAGNN 能够学习有效的细胞嵌入,有助于理解高阶基因组的细胞间变化. NHP 采用有向超图和无向超图建模化学反应网络,2 个变体NHP-D(有向)和NHP-U(无向)用于化学反应预测,通过团扩张将超图转化为普通图后实现超图链路预测. Hou等人[78]用加权有向超图建模细胞之间的多对多关系,将加权有向超图转换为超边图,并在超边图上运用MCL (Markov cluster algorithm)[147]和Louvain[148]社区检测算法.

HGGAN 是用于分析阿尔茨海默病的超图生成对抗网络. MRL-AHF 是用于诊断阿尔茨海默病的框架,由多模态表示学习和对抗性超图融合组成.HUNet(hypergraph U-Net)[68]利用超图结构学习数据样本的嵌入和高阶关系,应用于脑图的嵌入和分类.Banka 等人[69]设计超图自编码器学习大脑区域间的高阶关系,实现脑状态分类. Madine 等人[149]设计了诊断自闭症谱系障碍的超图神经网络,提出用无监督多核学习增强超图神经网络的学习能力. 表18 描述了应用于生化医疗领域的超图神经网络模型及其采用的数据集和评价指标.

4.7 交通机械

地理-语义-时间超图卷积网络GST-HCN 用于预测交通流,利用地理-时间图卷积和语义-时间超图卷积联合学习地理、语义和时间的高阶相关性. 动态时空超图图卷积网络(dynamic spatio-temporal hypergraph graph convolution network,DSTHGCN)[88]用于预测地铁客流,超图建模轨道交通数据,充分地考虑了地铁的拓扑结构和乘客出行方式的多样化,设计超图卷积和时间卷积学习顶点的时空特征,进而提高预测性能. 鉴于有向超图可以同时刻画空间信息和有向关系, DHAT 采用了有向超图建模道路网络,基于有向超图设计有向超图卷积挖掘交通序列之间的空间关系,并结合注意力机制实现有效的交通预测. 表19描述了应用于交通预测的超图神经网络模型及其采用的数据集和评价指标.

Table 19 Hypergraph Neural Network Models, Datasets and Evaluation Applied for Traffic Forecast表19 应用于交通预测的超图神经网络模型、数据集和评价指标

化学机械抛光(chemical mechanical planarization,CMP)是半导体行业中的一种关键工艺,其表面平整度在很大程度上影响制造质量. 材料去除率(material removal rate, MRR)在这个过程处于重要的地位. Xia等人[127]开发了一种基于时间的超图卷积网络,用于预测CMP 过程中的MRR,通过超图卷积、超图注意力和GRU 学习异构数据之间的相关性.

5 未来研究方向

近3 年,在图神经网络的成功和超图建模的优势的推动下,超图神经网络快速发展并取得显著的成果,但由于超图神经网络的研究还处于新起阶段,因此存在需要迫切解决的问题,并可将其作为进一步研究的方向.

5.1 超图建模方法

采用图建模数据在设计图神经网络时扮演着重要的角色,与构建图神经网络一样,构建超图在设计超图神经网络模型的过程中也具有重要的地位,会直接影响模型性能. 现有的超图神经网络利用超图建模数据间的高阶复杂关系,构建超图的常用方法有基于距离、基于表示、基于属性和基于网络的方法[32].然而,这些方法所构建出的超图结构是静态的,在学习的过程中没有随着顶点表示的更新而动态调整.虽然DHGNNa和AHGCN 等模型中已经考虑动态地构造超图,但是都有各自的局限性. 如在加入新数据时需要重新训练等问题. 现有的适用于超图神经网络的超图构造方法的研究工作比较少,故对于如何构造切实有助于从结构上提升模型性能的超图十分必要.

5.2 深层超图神经网络

图神经网络关于深层模型的探索已取得令人鼓舞的成果,如JK-Nets(jumping knowledge networks)[150],DropEdge[151],GCNII 等. 尽管近3 年来超图神经网络在各个领域都有广泛的应用,但它们大多是浅层模型. 在不牺牲性能的前提下,关于深层模型的研究很少, 如ResMultiHGNN,DeepHGNN,UniGNN, 其中ResMultiHGNN 和UniGCN 引入GCNII 中的方法,将其直接地从图结构推广到超图上. DeepHGNN 提出用采样超边等方式加深网络,但局限于加深的模型有限,并未提出一个超图神经网络通用的深层框架.因此,在加深的过程中是否会遇到与加深GNNs 时相同的问题,如过拟合、过平滑等;是否会出现GNNs中未遇到的其他问题;通过什么技术可以有效地缓解出现的问题都需要在将来加以解决和研究.

5.3 超图神经网络的理论

现有的超图神经网络模型大多数是显式或隐式地推广图神经网络模型到超图建模的数据上. 图和超图刻画和表示数据相关性不同,但现有探讨超图神经网络模型的文献中涉及模型理论研究的很少.这些文献的重点是在具体任务中提升模型性能,少有从理论的角度解释模型. 超图除了拥有灵活的建模能力外,还具有其他属性和性质,因此,如何使用这些属性和性质构建更好的超图神经网络,如何将超图理论作为工具探究和解释模型也是值得研究的工作.

5.4 超图神经网络的深度应用

现实生活中存在很多关系复杂的网络,虽然现有超图神经网络的应用涉及社交网络、推荐系统、计算机视觉、自然语言处理、金融、生物化学和交通预测等,但在具体的领域中涉及的任务较少且单一,如金融领域仅考虑了股票趋势预测的任务. 因此,研究如何将超图神经网络深度地应用于各个领域也十分有意义.

6 总 结

从2019 年Feng 等人[19]首次提出的超图神经网络HGNN,到DHGCN,DHGNNa,HWNN,HyperGAT,HGC-RNN,HGGAN, MHCN 等不同模型. 这些模型不断丰富和完善超图神经网络家族. 虽然超图神经网络发展的时间短、起步晚,但它借助可以挖掘数据间的潜在高阶关系吸引越来越多的研究者从事这方面的探索和钻研. 他们主要的工作是优化和改进模型算法、超图结构,推动超图神经网络应用于各个领域并取得不俗的表现. 因此,通过阅读大量文献,本文全面地回顾和综述了超图神经网络模型的研究历程.

本文概括和分析了近3 年出现的超图神经网络模型和框架,将超图神经网络分为超图卷积神经网络、超图循环神经网络和超图生成对抗网络3 类. 在第3 节中详细地介绍了这3 类中代表性的模型算法并做比较. 第4 节中归纳了超图神经网络在社交网络、推荐系统、计算机视觉和自然语言处理等领域的应用,并列举了所采用的数据集和评价指标. 通过第5节探讨了存在于超图神经网络中一些需要解决的关键研究问题.

总之,超图神经网络作为一种新兴的研究方向,由于其发展历程较短,现有的模型存在自身的不足和局限性,有待改进和提升的空间很大. 因此,其具有丰富的可研究内容. 未来,随着更多研究者的加入,这些问题会得到不断改善和解决,同时会开发出更多优秀的模型来扩充超图神经网络体系,拓展其应用的广度和深度.

作者贡献声明:林晶晶收集和分析相关参考文献,负责论文撰写和校对;冶忠林、赵海兴提出指导意见并修改论文;李卓然收集和整理相关文献.