融合自适应注意力的多尺度火灾检测算法

2024-01-16梁煜陈童张为

梁煜,陈童,张为

(天津大学 微电子学院,天津 300072)

火灾是日常生活中最常见的灾害之一,一旦发生,会给人们的生命财产带来巨大的威胁.因此,在火灾发生的初期进行快速有效的检测并进行预警具有重大的意义.早期基于传感器的火灾检测方法受环境、空间的影响较大,且响应时间长,局限性较大.随着计算机视觉的发展,火焰检测技术逐渐由基于传感器的识别演变为图像检测技术,其检测速度快,准确率高,且能够感知火灾发生的具体位置,逐渐成为火灾检测的主流.

传统的图像检测技术主要是利用机器学习算法,选择火焰的颜色、运动以及闪烁频率等特征进行提取并分类识别,进而输出火焰检测结果.FOGGIA等[1]基于火焰的形状、颜色和运动特性,设计了一个实时的火灾检测系统模型.MUHAMMAD 等[2]使用了多种经典分类网络分别来提取火焰特征,避免了繁琐耗时的预处理过程,根据实际问题提出了轻便高效的火灾检测模型.YU 等[3]提出了一种用于火灾烟雾实时检测的纹理分析方法,利用了火焰的纹理特征进行识别.KHAN 等[4]提出一种结合火焰的颜色、边界、面积、圆形度等特征的分类模型,同时利用了火焰的静态与动态特征.但是上述方式均是基于人工提取特征,消耗时间长,且算法鲁棒性低.

近年来,基于深度学习技术的图像型火灾检测技术由于其准确率高、速度快且受外界干扰小逐渐发展起来.KIM 等[5]运用了Faster R-CNN 检测疑似火灾区域和非火灾区域,构建了一种基于深度学习和视频序列的火灾检测方法.将卷积神经网络广泛应用于火焰特征提取,能够使用户获得更加丰富的火焰特征信息,增强了对火焰的识别能力.皮骏等[6]将YOLOv5s 的主干网络替换成Shufflenet v2,并加入CA 注意力模块,让骨干网络对图片信息的提取效率变得更快,在保持网络精度的同时保证检测速度,能满足在白天、黑夜或视野良好等情况下对森林火灾的实时性预防与检测.叶铭亮等[7]结合Transformer 与深度学习算法并应用于森林火灾检测领域,在Swin Transformer 网络结构中对窗口自注意力机制进行改进,采用了KNN 自注意力提高对小块噪声的识别,使用Augmentation 数据增强方法增加模型的泛化能力.

上述的检测算法在火灾检测任务中取得了不错的效果,但是也存在一些局限性,首先是实际场景下检测效果不太理想,针对一些特定背景、特定形状的火焰检测效果好,但是不能很好地应用于复杂场景,环境背景适应性较差.其次,由于摄像头远近以及火势蔓延程度不同,火焰在图片中呈现的尺度变化较大,算法对多尺度火焰检测精度较低.

鉴于目前火焰检测算法中存在的问题,本文采用了Anchor Free 结构设计了一种适用于实际场景的多尺度火灾检测算法.该算法将主干网络残差模块设置为多分支结构并替换原本的3×3 卷积为自适应注意力模块提取出更具表达力的火焰特征,之后在特征融合网络通过亚像素卷积减少信息丢失,并对高层特征进一步增强融合,最后根据火焰形状自适应地产生正样本用于之后的预测,改进GIoU Loss 以获得更准确的边界框回归.该算法能够实时检测多尺度火焰目标,而且具有准确率高、误报率低等优点,适用于各种实际场景下的火灾检测任务.

1 算法设计

1.1 网络整体结构

本文构建了如图1 所示的火灾检测算法,整体采用了无锚框网络的基本形式.为了提取到更为丰富的火焰特征,选取经典的特征提取网络ResNet-50[8]作为基础的主干网络,将残差模块设置为多分支结构,并添加自适应注意力模块用于关注通道信息以及选取适合的感受野.颈部网络用于将高分辨率特征和强语义特征结合,本文首先引入了特征金字塔FPN[9]结构用于融合不同层的特征.在此基础上,通过亚像素卷积减轻通道缩减造成的信息缺失问题,并引入特征增强模块丰富特征解决了FPN 自上而下融合过程中导致的高层特征缺失问题.

图1 火灾检测算法网络结构Fig.1 Network structure of fire detection algorithm

此外,检测网络分为两个分支分别用于分类和回归,两个分支都先经过4 个卷积层进行特征强化.之后,分类分支再通过一个3×3 卷积得到的特征图,该特征图上每一个点对应的值代表预测为火焰的概率,中心度分支预测当前位置与要预测的目标中心点的归一化距离.在分类网络训练过程中,由于背景点数量较多会导致正负样本不均衡,因此选用Focal Loss[10]作为分类损失函数,具体运算如公式(1)所示,取γ=2 ,α=0.25.回归分支生成的H×W×4特征图预测锚点到检测框上下左右四条边界的距离.并用改进后的GIoU Loss[11]作为回归损失函数.

1.2 融合自适应注意力的主干网络

火焰本身具有丰富的自身特征.例如,火焰颜色在实际场景中往往与周围环境有较大的差异性.诸如温度和燃烧物的材料都会影响火焰的颜色,颜色随着温度的升高而倾向于冷色,随着温度的降低而倾向于暖色.燃烧温度的高低也会影响火焰饱和度和亮度的变化.此外,火焰形状大小多变,受不同燃烧材料和燃烧环境的影响,火焰随时间的蔓延程度也有很大不同.然而由于现有的主干网络感受野大小有限并且缺乏跨通道之间的相互作用,往往不能很好地关注到火焰本身的特征,因此,本文对ResNet-50 主干网络进行了改进,以期网络能在众多背景点中更关注火焰的特征,提高检测的准确度.

本文将ResNet 主干网络中的每一个残差模块设计成多分支结构,即用一种平行堆叠相同结构的block,可以在不增加参数量级的基础上提升模型的准确率,同时还能减少超参数的数量,并添加注意力模块.改进前后的残差模块如图2 所示,整体采用组卷积的形式,group 数为32,并将原本的3×3 卷积替换成本文设计的自适应注意力模块.

为了更好地适应火灾尺度变化较大的特征,提升对于火灾的检测效果,受SKNet[12]的启发,本文设计了如图3 所示的自适应注意力模块,双分支结构可以对不同的输入分配不同大小的感受野.与SKNet 不同的是,本文并没有采用全连接的方式对通道嵌入空间信息,而是借鉴ECANet[13]的思想,采用局部跨通道交互的方式对通道分配权重,避免了降维对于学习通道注意的影响,自适应地分配通道权重.2.2.1 节对比试验可以显示本文提出的自适应注意力模块对于火焰检测的效果优于SKNet 和ECANet.该模块整体结构分为3×3 和5×5 两个分支,对于H×W×C的输入特征分别经过这两个分支之后进行特征相加融合,此时得到的H×W×C的中间特征融合了不同感受野的上下文信息.该融合后的特征再经过一个全局平均池化层(global average pooling, GAP)整合全局空间信息,并且与相邻的5 个通道进行跨通道交互,局部跨通道之间的交互可以使得网络更关注有效的通道,此时得到的1×1×C的特征包含了丰富的通道信息.再通过归一化函数Softmax 分配通道权重,该权重代表了每个通道对特征提取的影响力.通过保留更有价值的特征,从而达到提高特征表示能力的目的.最后再与原图像相乘得到携带通道权重的输出,两部分相加即为最终自适应注意力模块的输出.

图3 自适应注意力模块的具体实现Fig.3 Concrete implementation of adaptive attention block

局部跨通道之间的交互是通过一个权重共享的卷积核大小为k的一维卷积实现的,在全局平均池化层之后的特征上进行跨通道之间的交互,分配权重信息,对应表达式如下:

式(2)为整体权重计算表达式,其中 ω代表通道权重,S代表SoftMax 激活函数,C1Dk代表卷积核大小为k的一维卷积,k代表局部跨通道的覆盖率.式(3)为单层特征权重计算的表达式, ωi为第i层特征yi对应的权重,j表示通道, ωi是通过yi相邻的k个通道计算得到的,代表了yi相邻k个通道的集合.经实验验证当k= 5 时效果最好,因此本文设置超参数k为5,具体实验见2.2.1 节.

自适应注意力模块的3×3 和5×5 两个分支可以提供不同的感受野大小.而火焰在实际场景中由于距离摄像头远近的不同以及蔓延程度的不同,在图像中展示出的尺度不同.因此,网络可以根据火焰不同尺度进行自适应的调整,对于不同输入使用的卷积核感受野不同,参数权重也不同,可以自适应地对输出进行处理,分配不同的感受野大小.考虑每个通道及其相邻的5 个通道来捕获跨通道交互,即每一层都关注和它相邻的5 层通道的相互作用,通过分配权重表示了每个通道对特征提取的影响力.提升对当前火灾检测有用的特征图通道的权重,抑制对当前任务作用不大的特征通道,从而让神经网络重点关注权重值大的通道,通过显式的构建卷积特征通道之间的相互依赖关系来提高网络的表示能力.所以经过自适应注意力模块,网络不仅可以根据火焰本身尺度大小自适应地选取感受野,还能够自适应地给定通道权重,更适于提取火焰特征.为了证明本文设计注意力模块的有效性,与经典的注意力机制进行了对比试验,具体实验结果见2.2.1 节.

本文改进后的整体主干网络结构和ResNet-50对比如表1 所示,改进后的主干网络更关注通道特征之间的关系,增加了有用通道的权重,抑制了不相关的特征信息.此外,网络可以对不同尺度的火焰自适应的选择感受野大小,使得网络的输出特征更加丰富,提高了火焰特征提取网络的鲁棒性,有利于提高火焰检测任务的检测效果.

表1 改进前后主干网络结构对比Tab.1 Comparison of backbone structure before and after improvement

1.3 多尺度特征增强

在实际火灾场景中,火焰离摄像头远近不同或者火灾蔓延的程度都会导致火焰尺度有明显的变化,这对算法模型的多尺度检测能力提出了更高的要求.高层网络感受野较大,语义信息表征能力强,但空间信息表征能力较弱;而低层网络感受野空间信息表征能力强,语义信息表征能力弱.传统的FPN 结构通过自上而下的信息融合一定程度上改善了对于多尺度目标的检测效果,但是也存在以下两点不足:

1) FPN 网络初期为了提高计算效率采用1×1卷积进行通道维度缩减时会导致严重的信息丢失,侧重于在缩减后的256 个通道的特征金字塔Pi上开发有效的模块,但是没有充分利用Ci丰富的通道信息.

2) 较低层次的特征映射通过自上而下的融合可以合并较高层次的语义信息,但是最高层次的特征只包含单一级别的上下文信息.

因此,为了更好地满足多尺度火焰检测的需求,本文在原有FPN 的基础上添加了亚像素融合方法(sub-pixel conv),并且利用特征增强模块(feature augmentation)对P5进行特征增强,以充分利用全局特征信息,提升对多尺度火焰的检测能力.改进后的FPN网络结构如图4 所示.

图4 特征增强FPN 网络结构Fig.4 Feature enhanced FPN network structure

其中{C2,C3,C4,C5}表示主干输出,通过亚像素卷积生成{F2,F3,F4,F5}特征层,通道数减少为256,对应输入图片的步长为{4,8,16,32}.特征金字塔{P2,P3,P4,P5}通过FPN 中自上而下路径生成,单独对P5进行了特征增强,有效解决了最高层特征上下文信息单一的问题.

主干网络的高级特征{C4,C5}包含丰富的语义信息.但是传统的FPN 结构直接采用1×1卷积层来减少Ci的通道维数,这导致了严重的通道信息丢失.而本文采用的亚像素融合是指采用亚像素卷积[14]的方法融合低分辨率特征和高分辨率特征,卷积过程如图5 所示,它通过像素重组(shuffling pixels) 来增加宽度和高度的尺寸,而不是单纯地通过补零进行反卷积.将多通道特征图上的单个像素组合成新特征上单位通道像素,这样原特征图上的每个像素就相当于新的特征图上的一个亚像素.其结果就是将尺度大小为H×W×C·r2的特征重新排列为rH×rW×C,其数学表达式如下:

图5 亚像素卷积方法实现Fig.5 Implementation of subpixel convolution method

亚像素融合充分利用了{C4,C5}丰富的通道信息,并将它们合并到Fi中,如图4 网络架构所示,亚像素卷积可以看作是C5、C4到F4、F3的两个额外连接,同时进行上采样和通道融合,然后利用C5、C4丰富的通道信息增强特征金字塔的表达能力,弥补了因通道缩减导致的信息丢失.为了证明本文采用的亚像素卷积方法的优势,在2.2.2 节进行了对比试验.

此外,在传统的FPN 中,较低层次的特征映射通过合并较高层次的语义信息,自然地赋予不同的上下文信息.但是,最高级别的特征层P5只包含单一级别的上下文信息,而没有从其他层级中受益.因此,本文设计了一个如图6 所示的特征增强模块(feature augmentation)用来丰富P5的通道信息.对F5特征进行膨胀率为2, 4, 8, 16, 24 的空洞卷积提取不同感受野范围的上下文,将每个空洞卷积层的输出拼接到输入特征图上,然后再输入到下一个空洞卷积层,并且空洞卷积之间采用了密集连接的形式,注入不同的空间上下文信息,强化了P5的特征表示.

图6 特征增强模块的具体结构Fig.6 Specific structure of feature augmentation modules

改进后的FPN 结构融合后的特征被赋予多尺度的上下文信息,利用高层语义信息对低层特征进行映射增强,更好地利用了全局空间信息,使得网络的输出特征更加丰富,更有利于后续的多尺度目标检测过程.

1.4 自适应标签分配

标签分配在目标检测中有着重要的作用,传统的标签分配方法例如FCOS[15]通过标准框中心点和铺设点之间的距离和尺寸来确定正负样本,目标框内的锚点作为候选样本.这样做忽略了具有不同大小和形状的对象的划分边界可能会有所不同的事实,限制了检测器的学习能力.因此,为了适应火焰形状多变的特点,本文引入了一种自适应的选取样本[16]的方法,依据中心点距离以及IoU 阈值的统计特性自动划分正负样本.

离对象中心越近的锚点更有可能产生更高质量的检测,所以首先根据锚框和对象之间的中心距离选择候选对象.对于每个输出的检测层,计算锚框和目标的中心点的L2距离,选取K个锚框离目标中心点最近的锚框作为候选正样本.其次计算每个候选正样本和ground truth 之间的IoU,得到每组IoU 的均值和标准差.均值高表示具有高质量的候选框,应当提高阈值来调整正样本,同样均值较低则应该降低阈值.此外,标准差是用来衡量哪些层适合检测该对象的,标准差高意味着高质量的锚框集中在一层中,低标准差则表示多个层都适合该ground truth.所以将IoU 阈值设置为每组IoU 的均值和标准差之和,根据对象的统计特征,自动选择对应特征层上合适的锚框,解决固定阈值对检测器的限制.

FCOS 的采样方式如图7(a)所示,其结果较为固定,而且由于火焰形状多变,会引入了大量的背景点作为正样本加入训练,对模型的学习造成困扰.而本文引入的自适应标签分配方法采样方式如图7(b)所示,能够很好地适应火焰自身形状,筛选出更适合的正样本,有效规避经典采样方式的弊端,对于火焰特征的学习更为充分,有效提升了不同环境背景下的火焰检测能力,增强了算法的环境适应性.

图7 正样本分配效果图Fig.7 Positive sample distribution effect

在此基础上,由于火灾形态尺度多变,对边界框回归也提出了更高的要求,GIoU Loss 在IoU 损失中引入惩罚项以缓解梯度消失问题,可以较好的反应相交情况,本文在现有的GIoU Loss 的基础上引入了参数λ,改进前后的损失函数如下.将λ应用于IoU损失函数以及正则化项,可以获得更准确的边界框回归,提高bbox 的回归精度.改进前后的GIoU Loss公式如下:

GIoU Loss 对应λ=1 的情况,IoU 的梯度一直是-1.当λ>1 时,如果对应IoU 大于0.5,损失梯度大于-1,可以加速收敛.因此,λ>1 可以增加了高IoU 目标的损失和梯度,通过更多地关注高IoU 目标来获得高的bbox 回归精度.而当λ<1 时,它降低了高IoU 目标的权重,会影响bbox 的回归精度.根据本文实验可得当λ=3 时效果最好,具体实验过程见2.2.2 节.

2 实验内容及结果分析

2.1 实验环境

由于目前缺乏高质量的火灾公共数据集,本文按照MS COCO 数据集格式要求自建了一个包含丰富环境背景的火灾数据集.数据集图片搜集于实际火灾视频、实验火灾视频以及网络上公开火灾视频等191 段视频,共包含火灾图像13 573 张,其中训练集10 014 张,测试集3 559 张.数据源涵盖了地铁站、停车场、超市、学校、工厂和寺庙等数百个场景,包括多种尺度形态的火灾图像,大、中、小尺度图像根据火焰标准框占图像的像素点百分比划分,图像尺度越大在实际场景中代表火焰距离摄像头越近或者蔓延程度越大.部分数据集图片如图8 所示,包括室内、室外、黑天和灯光、红色物体、光线干扰等多种场景下的图像,从左到右尺度由小到大,能够充分验证本文提出的适用于实际环境的多尺度火灾检测算法的有效性.此外,为了验证模型的泛化能力,本文在划分测试集与训练集时选择了不同场景.

图8 部分数据集火灾图像Fig.8 Partial data set fire images

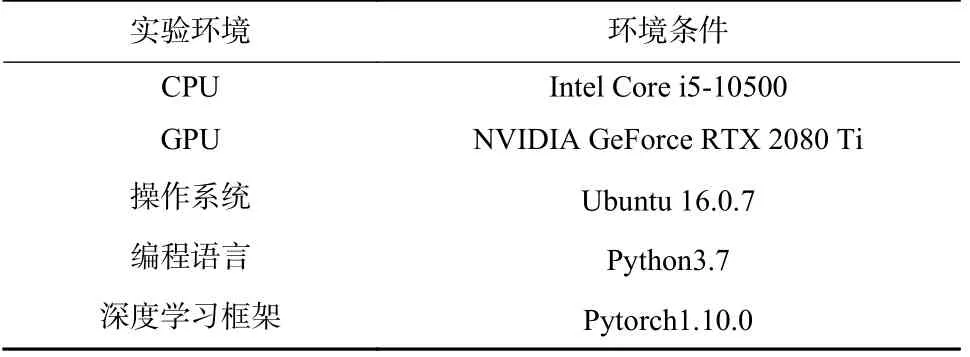

本文训练和测试的实验环境如表2 所示.采用随机梯度下降优化器进行迭代训练,批训练规模为4,训练轮数为12 轮,动量和权重衰减因子分别为0.9和0.000 1,初始学习率为0.001 25.学习率在第8 轮和第11 轮分别衰减为当前学习率的10%.训练过程中采用随机翻转、随机缩放及亮度变化等数据增强方式,增加训练的数据量,解决过拟合和样本不平衡问题,提高模型的泛化能力.

表2 实验环境参数Tab.2 Experimental environmental parameters

2.2 消融实验

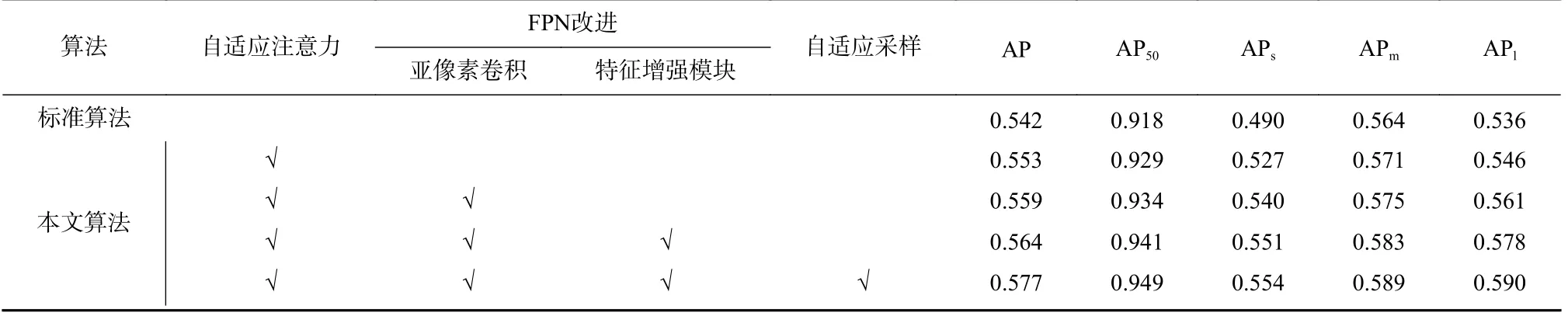

为了验证本文主干网络中设计的自适应注意力模块、利用亚像素卷积和特征增强模块改进后的FPN 模块以及自适应标签分配包含改进GIoU Loss的效果和对整体网络的贡献,设计了消融实验,整体实验结果如表3 所示.本文对模型综合性能的评价指标采用的是COCO 评价标准中的AP 和AP50,其中AP50代表IoU 阈值为0.5 时模型检测的精度,即网络输出的检测框与数据集标注框IoU 大于0.5 则为预测正确;而AP 代表IoU 阈值取0.5~0.95 之间的10个值时模型检测的精度的平均值.此外,采用COCO评价标准中的APl,APm和APs表征模型对大、中、小尺度目标的检测精度,衡量算法对多尺度火焰的检测效果.以下是对各个模块消融效果分析.

表3 整体网络消融实验结果Tab.3 Results of global network ablation experiment

本文首先将主干网络残差模块设置为多分支结构,并把残差模块中的3×3 卷积替换为本文设计的自适应注意力模块.如表3 实验结果显示,嵌入自适应注意力模块之后,AP 由54.2%提升为55.3%,AP50由91.8%提升为92.9%,多尺度的检测精度均有提升.由此可以证明本文设计的自适应注意力模块的有效性,可以根据火焰尺度自适应选取感受野并自适应分配通道权重,提升了特征提取能力.

本文在FPN 基础上添加了亚像素融合之后,在原有精度基础上各个尺度的检测精度均有提升,如表3 所示,其中APs和APl增幅均超过了一个百分点,证明了本文引入的亚像素融合可以充分利用高层特征图丰富的通道信息,弥补因通道缩减造成的信息丢失.

在此基础上进行多尺度特征增强之后,整体火焰检测精度进一步提升,APs由54.0%上升为55.1%,APl由56.1%上升至57.8%.证明了本文设计的特征增强模块的有效性,可以注入不同的空间上下文信息,增强特征金字塔的特征表达能力.

在原有改进的网络基础上,采用自适应采样方式对模型进行改进,整体网络检测精度以及各个尺度目标的检测精度均有提升,如表3 所示.其中AP50由94.1%上升到94.9%,证明了自适应采样方式对于火灾检测任务的有效性,改进后的标签分配利用统计特性作为阈值,克服了固定阈值对检测器学习能力的限制,更适应火焰形状多变的特点,可以有效提升不同环境背景下的火焰检测能力.

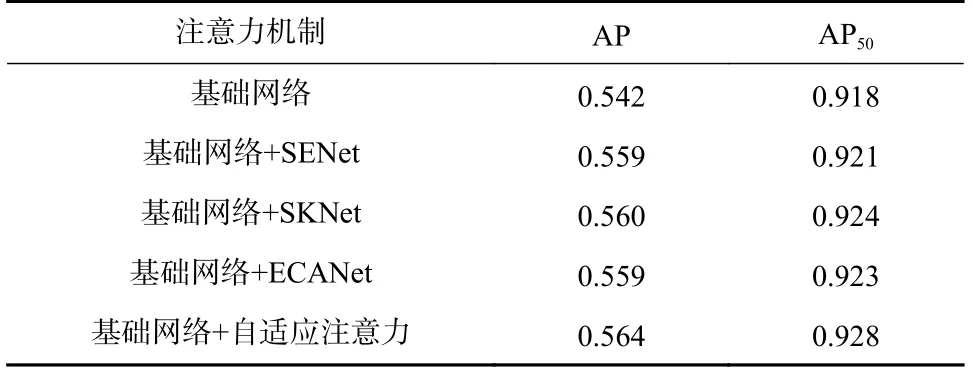

2.2.1 自适应注意力模块

为了验证本文设计的自适应注意力模块的有效性,本文与SENet、SKNet 以及ECANet 注意力机制进行了对比试验.保持基础的网络结构不变,保持数据集和实验环境配置不变,在其基础上分别嵌入了不同的注意力模块,实验结果如表4 所示.

表4 注意力机制对比试验结果Tab.4 Comparison experimentation results of the attention mechanism

通过表4 的结果,可以看到本文设计的自适应注意力模块对网络检测效果提升最为明显,说明本文设计的自适应注意力模块可以使得网络不仅可以根据火焰本身尺度大小自适应选取合适的感受野大小,并且可以给定通道不同的权重,提取到更适合的火焰特征,更有利于火灾检测任务.

此外,为得到对网络提取特征更为有效的超参数k,本文在原网络基础上嵌入自适应注意力模块进行了多次对比试验,实验结果如图9 所示,其中k为[4, 8]区间内整数.随着k逐渐增大,AP 值先增加后下降.实验结果表明,k= 5 时网络效果最好.因此本文在最终算法中固定k为5.

图9 k 参数对比实验结果Fig.9 Comparison experimentation results of value k

2.2.2 自适应注意力模块

为了验证本文亚像素卷积上采样方式对于弥补信息丢失的有效性,本文进行了以下对比试验.保持基础的网络结构以及实验环境配置不变,在原FPN基础上将上采样方式分别替换为双线性插值和亚像素卷积,实验结果如表5 所示.

表5 上采样方式对比试验结果Tab.5 Comparison of upsampling mode with experimental results

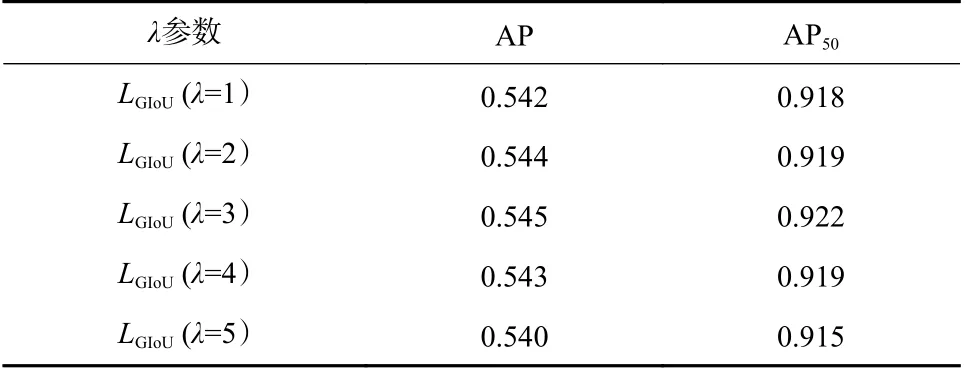

2.2.3 损失函数

为得到提升效果最好的损失参数λ,本文在不进行其他改进的基础上进行了多次对比试验,分别取λ为[1, 6]区间内整数.λ为1 时代表GIoU Loss 损失函数,实验结果如表6 所示.随着λ逐渐增大,AP 值增加后趋于平稳再逐渐下降,于3 处到达最高值.实验结果表明,调整λ的值会影响模型的检测效果,且λ为3 时模型的检测效果最好.因此本文在最终算法中固定λ为3.

表6 λ 参数取值对比试验结果Tab.6 Comparison of value λ with experimentation results

2.3 算法对比与分析

为了验证本文算法的有效性,保持实验环境和实验参数不变,在本文自建数据集上利用经典的目标检测算法FCOS、RetinaNet 以及最新的目标检测算法YOLOF[17]、TOOD[18]和DETR[19]进行了对比实验.实验结果如表7 所示.可以看出,本文算法在整体检测精度和多尺度的检测精度上均有更好的检测效果.

表7 与经典目标检测算法的对比实验结果Tab.7 Comparison of experimentation results with classical object detection algorithms

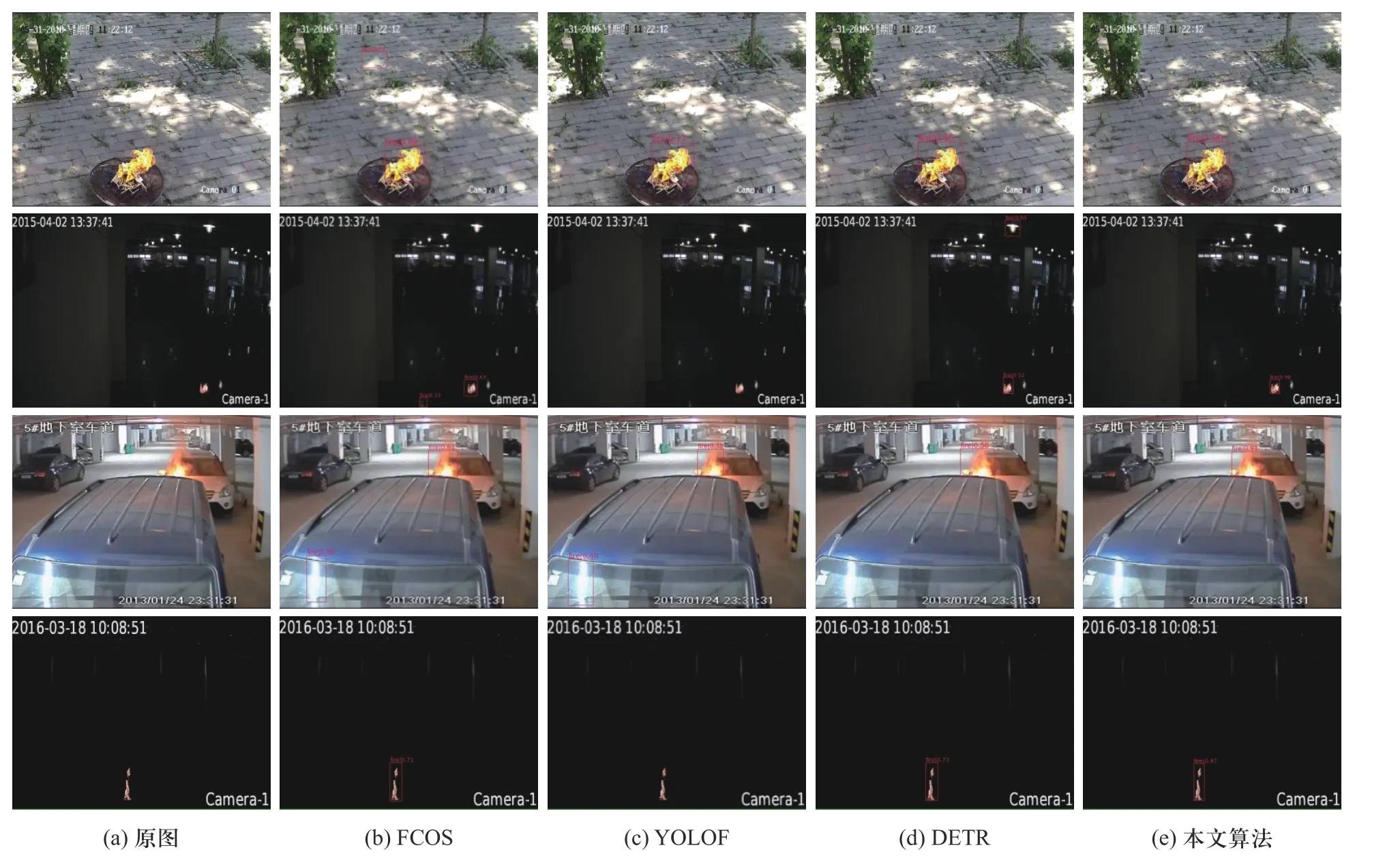

此外,为了证明本文算法的先进性,和经典的Anchor Free 目标检测算法FCOS 以及最新的目标检测算法YOLOF 和DETR 在检测效果上进行了对比,对比效果如图10 所示.可以看出本文提出的算法在黑夜、白天以及有光斑、灯光干扰时检测效果均优于其他3 种算法,明显抑制了实际场景中误报漏报情况的发生,说明本文算法抗干扰能力更强,综合性能更好.

图10 不同场景多尺度火焰检测效果对比图Fig.10 Detection effect comparison of multi-scale flame in different scenes

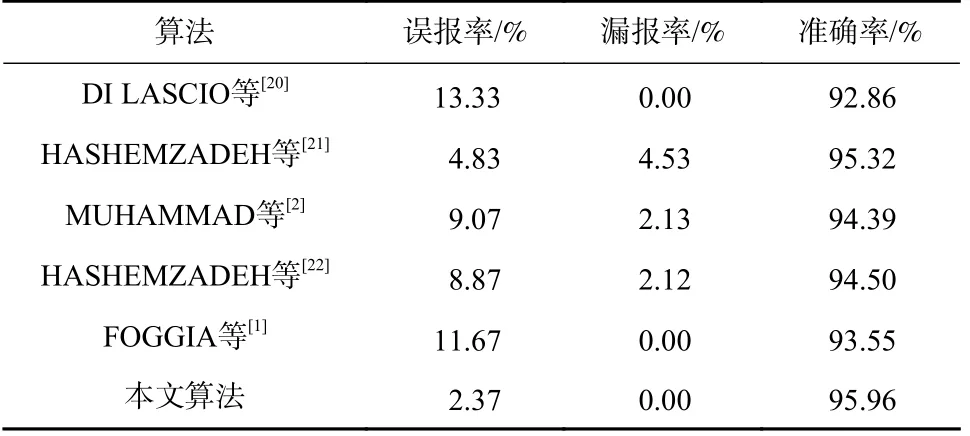

为了进一步验证本文提出算法模型的有效性,在火灾检测常用的公开数据集Mivia(http://signal.ee.ilkent.edu.tr/VisiFire/)上与一些常用的火灾检测算法进行了对比.Mivia 数据集由FOGGIA 等收集,涵盖不同环境下的31 段视频,其中火灾视频14 段,非火灾视频17 段,包含灯光、移动物体以及红色类火物体等干扰环境,更适用于检测模型的鲁棒性.表8 展示了本文算法与经典火灾算法在Mivia 数据集上准确度(precision)、误报率(false positive, FP)以及漏报率(false negative, FN)的性能评估结果,其他算法的数据均来源于原文献.误报率代表假阳性,即非火物体被预测为火的概率;漏报率即假阴性,即火灾目标没有被检测出来的概率;而准确率代表预测为火灾的样本中有多少比例为真值.

表8 与经典的火灾检测算法对比实验结果Tab.8 Comparison of experimentation results with classical fire detection algorithms

基于以上实验结果,本文算法在检测精度相比其他火灾检测算法均具有优势,并且漏报率为0,针对数据集中室内、室外、黑夜、白天等多种环境下的多种尺度火灾都有较好的检测效果,能够实现火灾的精准定位和分类.此外,本文算法在也不易受光照、灯光和移动物体等条件的影响,环境背景适应性更强,与其他算法相比更具有优势,更能满足实际火灾检测的需要.

3 结 论

本文提出了一种适用于实际场景的多尺度火灾检测算法,有效解决了当前火灾检测算法容易受外界干扰产生误报漏报的问题.将主干网络残差模块设计为多分支结构,并嵌入自适应注意力模块提取到了更具表达力的火焰特征;通过亚像素卷积改进了特征图上采样过程中出现的信息缺失问题,并且添加了特征增强模块丰富了最高层特征,提升了对多尺度火焰的检测效果;采用自适应标签分配适应火焰自身形状尺度,增强了算法的学习能力;对GIoU Loss 函数进行了改进,获得了更精确的边界框回归.

经实验表明,与常用的目标检测算法和火灾检测算法相比,本文提出的火灾检测算法检测精度高,抗干扰能力强,能够适用于实际场景下的不同形态的火灾检测场景,具有较高的应用价值.