基于深度学习的动态目标跟踪研究

2024-01-14戴华珍张袖斌朱恺文

谌 颃 钟 贵 戴华珍 张袖斌 朱恺文

(广州科技贸易职业学院,广东 广州 511442)

1 引言

现实空间环境中动态目标对象遮挡、变形情况下的视觉跟踪,是计算机图像视觉领域研究的重要课题之一,特别是随着城市交通网络日益复杂化、城市居民数量的不断增加,对于公共空间内不同人员个体的目标对象识别和跟踪,成为计算机图像视觉识别与分析的主要方向,对于实现空间人物目标的智能化识别与监控具有现实意义。目前有关空间动态目标的识别与跟踪研究,诸如文献[1-4],这些文献从运动目标图像序列的像素点识别、像素样本学习训练、目标模板匹配等技术出发,对存在遮挡、干扰噪声的动态目标识别跟踪作出分析,但即便如此,以上算法在动态目标识别跟踪的准确性、鲁棒性和可扩展性等方面依然存在不足,在复杂光照、遮挡和变形情况下的图像处理质量仍有待提高。基于此,本文从深度学习卷积神经网络的角度出发,提出卡尔曼滤波的SiamRPN 深度学习算法进行动态目标跟踪。首先运用SiamRPN网络算法提取运动目标的检测帧、模板帧的重要特征,运用卡尔曼滤波预测模块对现有的图像帧进行目标预测,随后通过置信度加权融合2个及以上的跟踪模型,利用区域候选网络RPN对存在遮挡、背景干扰等的动态目标对象,进行跟踪框的位置坐标和尺度的计算,确定最优跟踪框准确地定位跟踪目标位置,实现对全遮挡目标、噪声干扰目标的多次跟踪识别,提高外部环境中动态目标的跟踪准确率。

2 基于卡尔曼滤波的孪生(Siamese)网络框架

2.1 Siamese跟踪网络框架架构

Siamese跟踪网络是在Faster RCNN网络框架的基础上,建立起的用于区域候选网络确定、目标对象特征提取的卷积神经网络。[1]其中,RPN网络判断图像帧的空间环境中,是否有动态监测目标,以及修正anchor 使跟踪框更准确,且RPN网络的区域候选框提取、目标对象跟踪耗时更少,具体Siamese跟踪网络框架如图1所示。

图1 Siamese动态目标跟踪网络框架

从图1可以看出,Siamese网络框架为具有孪生结构的深度学习模型,分为搜索区域确定、动态跟踪目标特征提取两个分支,左边上下两个支路为动态目标特征提取的孪生网络,支路的网络结构、提取特征参数完全相同,根据上方靠近候选区域的目标模板帧,对下方的提取检测帧作出对比分析,通过全卷积神经网络形成2个分支的连接。

右边为搜索区域确定并输出的孪生网络,中间为搜索区域学习与提取网络,包括分类分支、回归分支,这里分类分支输出含有2k个通道的特征图像,红色和蓝色分别表示k个锚点的前景得分、背景得分;回归分支输出含有4k个通道的特征图像,用不同颜色分别表示k个锚点的坐标偏移预测值。

基于Siamese 网络框架的动态目标跟踪,是在图像搜索区域x内,找到与模板帧z最相似的目标跟踪对象。[2]因而在Siamese全卷积网络中,采用完全卷积函数h(),引入LT来表示平移算子,则对任意图像帧平移转换T、整数步长k之间的关系定义如式1:

计算图像帧搜索区域x的所有目标跟踪对象,与模板帧z之间的相似性。使用卷积网络嵌入函数ψ,计算搜索区域的目标跟踪对象x、模板帧z的相似性,计算公式如式2所示:

其中f表示相似性函数,*表示相关性操作符,φ(x)表示搜索图像对象、φ(z)表示模板帧图像。

2.2 SiamRPN深度学习算法

SiamRPN 算法包括目标对象特征提取、分类回归、分支回归计算等执行流程,其中分类回归是对图像搜索区域内,存在的模板帧作出卷积运算;分支回归是对图像搜索区域内,存在的检测帧作出卷积运算[3],计算公式如式3:

其中(Adx,Ady)为锚点框的中心点坐标,Adw、Adh为锚点框的长和宽;(Tdx,Tdy)为真实检测框的中心点坐标,Tdw、Tdh为真实检测框的长和宽,由于不同提取图像的长和宽存在差异,因而需先对图像尺寸作正则化处理。

采取RPN孪生网络的端到端训练方式,在图像搜索区域内随机提取模板帧、检测帧,进行锚框、真实检测框的相似性识别训练。由于相邻两帧的目标跟踪对象变化较小,因而选取[0.33,0.5,1,2,3]等5种不同比例的锚,结合公式3、4,对0、1、2、3 等不同检测框作出样本训练识别,真实框样本的正则化处理、损失函数如式5、6所示:

其中Lcls表示检测图像的目标对象交叉的熵损失;λ表示分类或分支回归的损失参数。在RPN 孪生网络的锚框识别训练时,使用锚点框、真实目标对象框的交并比(IOU),判断识别的目标对象框属于正样本或负样本,定义IOU>0.6 为正样本、IOU<0.3 为负样本。

3 卡尔曼滤波模型的跟踪目标位置预测与估算

3.1 卡尔曼滤波模型

卡尔曼滤波是利用观测方程、状态方程,对动态目标的状态进行实时跟踪、迭代预测的方法。当跟踪动态目标受到遮挡、噪声干扰等影响时,将很大可能导致动态目标跟丢的问题。[4]这一情况下,使用卡尔曼滤波器、滤波回归算法,可对受到遮挡、噪声干扰的目标对象,进行目标位置预测及标记,以保证前后相邻帧目标对象跟踪的连续性。当前卡尔曼滤波模型的状态转移方程、观测方程如式7、8所示:

3.2 基于卡尔曼滤波的跟踪目标对象位置估算

在使用卡尔曼滤波模型,对动态跟踪目标的状态进行预测时,首要任务是确定图像帧中目标的初始状态。假定某一动态跟踪目标的状态为x=(p,v),其中p表示目标对象的位置、v表示目标对象的速度[5],则跟踪目标的状态向量、观测方程可用如式11、12表示。

其中x(0)表示观测目标的初始状态、θ 表示目标对象的转动角度。在初始化阶段定义目标的模板帧为zpos,采用卡尔曼滤波模型,对目标对象将会出现的区域作出预测,计算公式为式13、14,根据公式13 计算得到预测目标对象的下一位置,多次迭代后得出目标跟踪的最优化估计结果。

4 卡尔曼滤波模型、SiamRPN 深度学习算法融合的目标跟踪实现

面对跟踪动态目标存在遮挡、噪声干扰的情况,提出卡尔曼滤波模型、SiamRPN 深度学习算法相融合跟踪的方式,完成目标对象跟踪的总体流程设置,[6]具体如图2所示。

图2 卡尔曼滤波模型、SiamRPN融合算法的目标跟踪实现

首先使用跟踪器采集图像帧,使用RPN网络确定跟踪目标的候选区域。随后在初始化模块中,将目标对象的初始框中心点、坐标位置,赋值给卡尔曼滤波器、SiamRPN 神经网络,并对卡尔曼滤波器中的跟踪目标初始状态、初始预测值作出修改。

然后由SiamRPN神经网络算法,进行跟踪目标对象的分类回归、分支回归卷积运算,提取图像搜索区域内的检测帧特征,包括动态目标对象跟踪框的位置坐标、尺度信息。最后将使用SiamRPN深度学习算法、卡尔曼滤波器,得到的目标对象跟踪框置信度值k1、k2,作出自适应的加权融合计算,得到加权融合后的最优跟踪框值x为如式15、16:

其中w1、w2表示SiamRPN 网络算法、卡尔曼滤波器的加权因子。假设使用SiamRPN 深度学习算法、卡尔曼滤波器,得到的动态目标对象跟踪框值分别为x1、x2,则利用公式15可得到加权融合后的目标最优跟踪框值x。

5 实验及结果分析

5.1 实验环境及参数设置

基于Linux 系统平台、MATLAB R2021a 仿真软件,建立包含100 个视频的OTB 跟踪数据集(100 帧),该数据集中涉及到跟踪目标对象,存在快速运动、背景相似、噪声干扰、光照变化等一系列问题,基本上能够全面反映卡尔曼滤波器、SiamRPN网络算法的目标跟踪性能。

利用RPN 区域候选网络,对OTB 跟踪数据集的两个卷积层参数作出调整,通过以上的损失函数进行参数优化。假设跟踪目标对象的边界框的大小表示为(w,h),则将裁剪后的模板帧大小设置为A*A,计算公式如式17:

其中p=(w+h)/2,按照图1 的跟踪目标对象帧要求,将裁剪后的模板帧大小调整为127×127,将检测帧设置为模板帧大小的2倍为255×255。

5.2 定性分析

选取OTB跟踪数据集内的3组典型跟踪数据序列,设置为Soccer、Human6 和Bolt2 序列,其中Soccer 序列内的跟踪目标对象,存在着遮挡、快速运动等影响因素;Human6 和Bolt2 序列的跟踪目标对象,存在着遮挡、平面旋转、运动模糊等影响因素。采用卡尔曼滤波器、SiamRPN 深度学习算法,对以上3组序列的动态目标对象作出跟踪,具体的跟踪结果如图3所示。

图3 Soccer、Human6和Bolt2序列的目标对象跟踪结果

从图3 可以看出,最上层一组跟踪图像为Soccer 序列图像,其存在着遮挡、快速运动等的干扰因素。在目标对象未经过红绿灯杆时,采用卡尔曼滤波器(红框)、SiamRPN 网络算法(绿框)及SianFC 单目标跟踪算法(蓝框),都能够顺利完成对动态行人目标的有效跟踪,且跟踪精度差异不大。而当目标遇到红绿灯杆的遮挡后(#56,#67 帧),基于SianFC算法的单目标跟踪很快丢失目标,卡尔曼滤波器、SiamRPN网络算法的跟踪仍旧保持着较高精度,其中SiamRPN 深度学习算法的跟踪精度最高,跟踪效果基本上不受外部干扰因素的影响。

图3 的中间层为Human6 序列,跟踪目标对象存在着平面旋转、运动模糊等影响因素,如发现38帧以后跟踪目标快速运动、伴随运动模糊,此时采用卡尔曼滤波器、SiamRPN深度学习算法相融合的跟踪方式,均可以保证在连续多帧时间内的跟踪效果。图3的最下层为Bolt2序列,跟踪目标对象存在着遮挡、平面旋转等影响因素,在20~78 帧是的跟踪时间范围内,发现使用卡尔曼滤波器、SiamRPN深度学习算法,均能保证跟踪框、标记目标对象的跟踪精准性,而SianFC算法在面对人物遮挡的情况,很容易发生再次识别的跟踪丢失问题。综上分析可知,在上中下三组图像的目标对象跟踪中,基于卡尔曼滤波的SiamRPN算法,可被用于含有遮挡、平面旋转、快速运动的跟踪情况,且具有明显的算法跟踪优势。

5.3 定量分析

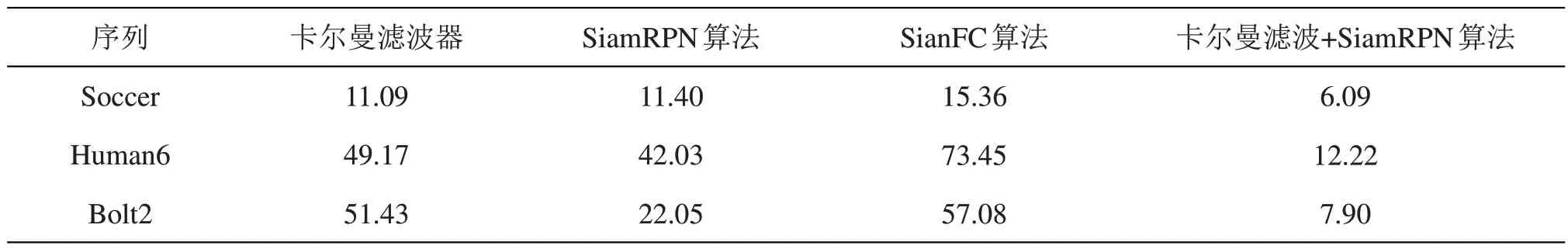

根据跟踪目标的中心位置误差(CLE)、重叠率(OR)等量化的度量指标,对使用卡尔曼滤波器、SiamRPN 网络算法、SianFC 算法、融合算法的目标跟踪精度,进行量化性能分析。通常情况下,跟踪目标的中心位置误差、重叠率成反比,也即CLE越小时OR越大,跟踪精度越高。利用以上多种算法,进行目标对象帧测试序列的跟踪分析,得到的CLE、OR相关量化指标结果如表1、表2所示。

表1 动态目标跟踪的中心位置误差(CLE)结果

表2 动态目标跟踪的重叠率(OR)结果

从表1、表2可以看出,针对以上三组跟踪目标序列的测试视频帧,使用“卡尔曼滤波+SiamRPN算法”的跟踪方式,平均跟踪速率为37帧/秒,高于SianFC算法的18帧/秒、低于SiamRPN算法的49帧/秒,满足目标跟踪的图像帧实时性处理需求。同时相比于卡尔曼滤波器、SiamRPN 网络算法、Sian-FC 算法而言,融合算法得到的动态目标跟踪的中心位置误差(CLE)更小,目标跟踪的重叠率(OR)更高,在运行实时性、跟踪精度方面体现出良好的性能。

6 结语

外部空间环境中动态目标对象的视觉跟踪,是近年来计算机视觉及姿态评估等领域关注的重要问题。特别在面对具有噪声干扰、遮挡、变形的复杂场景中,需要采取滤波器目标跟踪、相邻两帧关联分析的级联匹配方法,对包含多个目标的变量问题作出跟踪分析。因此,在Faster RCNN 网络框架的基础上,建立用于区域候选网络确定、目标对象特征提取的卷积神经网络,使用卡尔曼滤波模型、SiamRPN 深度学习的融合算法,进行图像帧关联分析,解决相似目标的运动检测、交互或遮挡监测问题,对跟丢或再次出现的目标作出准确识别,相比于传统的动态目标跟踪算法的识别跟踪性能更优。