基于改进UNet的遥感图像语义分割

2024-01-01高康哲王凤艳刘子维王明常

摘要:全卷积神经网络在遥感图像语义分割中得到了广泛应用,该方法地物分类精度和效率较高,但对地物分布不均匀遥感图像占比较少地物的分类准确率较低。为了提高遥感图像的分类精度,本文通过添加先验知识方法丰富输入数据特征,采用密集链接方式提高上下采样过程中特征的重复利用率,采用可以优化交并比的损失函数Dice Loss和可以提高难分类类别精度的损失函数Focal Loss相加组合作为网络模型的损失函数,采用LayerScale模块加快模型收敛、抑制无用特征、突出有效特征的方式,对UNet的输入、网络结构、损失函数进行改进,优化语义分割效果。结果表明,基于高分影像数据集(GID)改进的UNet相较于原始UNet像素精度、均类像素精度、平均交并比分别提高了0.023 3、0.040 9、0.066 5,提升了地物分类精度,取得了较好的分类效果。

关键词:深度学习;多特征;密集链接;Focal Loss;Dice Loss;LayerScale模块;改进UNet;语义分割

doi:10.13278/j.cnki.jjuese.20230145

中图分类号:TP753

文献标志码:A

高康哲,王凤艳,刘子维,等. 基于改进UNet的遥感图像语义分割. 吉林大学学报(地球科学版),2024,54(5):17521763. doi:10.13278/j.cnki.jjuese.20230145.

Gao Kangzhe, Wang Fengyan, Liu Ziwei, et al. Semantic Segmentation of Remote Sensing Images Based on Improved UNet. Journal of Jilin University (Earth Science Edition), 2024, 54 (5): 17521763. doi:10.13278/j.cnki.jjuese.20230145.

收稿日期:20230602

作者简介:高康哲(1998—),男,硕士研究生,主要从事遥感图像分类方面的研究,E-mail: gaokz21@mails.jlu.edu.cn

通信作者:王凤艳(1970—),女,教授,博士,主要从事工程测量、工程地质方面的研究,E-mail: wangfy@jlu.edu.cn

基金项目:国家自然科学基金项目(42077242,42171407);自然资源部城市国土资源监测与仿真重点实验室开放基金项目(KF202005024);吉林省自然科学基金项目(20210101098JC)

Supported by the National Natural Science Foundation of China (42077242, 42171407), the Open Fund of Key Laboratory of Urban Land Resources Monitoring and Simulation, Ministry of Natural Resources of China (KF202005024) and the Natural Science Foundation of Jilin Province" (20210101098JC)

Semantic Segmentation of Remote Sensing Images Based on Improved UNet

Gao Kangzhe, Wang Fengyan, Liu Ziwei, Wang Mingchang

College of GeoExploration Science and Technology, Jilin University, Changchun 130026, China

Abstract:

Fully convolutional neural network has been widely used in semantic segmentation of remote sensing images, and the accuracy and efficiency of feature classification are high, but for remote sensing images with uneven distribution of features, the accuracy of feature classification is low. In order to improve the classification accuracy of remote sensing images, this paper enriches the input data features by adding priori knowledge methods, uses the dense link method to improve the reuse rate of features in the process of up and down sampling, combines the loss function Dice Loss that can optimize the intersection of union and the Focal Loss that can improve the accuracy of difficult classification categories as the loss function of the network, and uses the LayerScale module to accelerate the model convergence and suppress irrelevant features while emphasizing useful features, improves input, network structure and loss function of UNet to optimize the effect of semantic segmentation. The results show that, compared with the original UNet, the improved UNet based on Gaofen image" dataset is improved by 0.023 3, 0.040 9 and 0.066 5 in terms of pixel accuracy, average pixel accuracy and mean intersection of union, respectively, which improves the classification accuracy of ground objects and achieves better classification effects.

Key words:

deep learning; multi-feature; dense linking; Focal Loss; Dice Loss; LayerScale module; improved UNet; semantic segmentation

0" 引言

近年来,遥感图像光谱特征不断丰富,时间、空间分辨率不断提高,在城市规划[1]、土地利用、军事、测绘方面得到了广泛应用[2],其中高分图像分类研究是土地资源管理和用途管制的基础[3]。最初人工目视解译的遥感图像分类方法已无法满足遥感图像地物信息的高效提取需求,基于遥感图像特征提取的分类方法应运而生,如最大似然法、支持向量机[4]、随机森林[5]等,这些方法在分类中有良好的表现,但也需要人工干预[6],因不适用于多分类,容易过拟合[7]。相较于以上方法,卷积神经网络(convolutional neural networks, CNN)方法泛化性好、分类精度高[8],对图像识别取得了优异的成绩,如LeNet[9]、AlexNet[10]、VGG(visual geometry group)[11]、GoogLeNet[12]、ResNet[13]等。与上述图像整体分类网络不同,全卷积神经网络(fully convolutional neural networks, FCN)实现了图像像素级分类,基于FCN的语义分割方法不断发展和完善,为遥感图像地物分类提供了新思路。该方法可以有效提取影像中的地表覆盖信息,自动获取分类后的语义分割结果,因此被广泛引入到遥感影像语义分割领域,如FCN[14]、UNet[15]、SegNet[16]、DeepLabV3[17]、ResUnet[18]等。

基于高分辨率遥感图像的地物分类可以获得更加精细的分类结果,本文选择高分影像数据集(GID)开展研究。GID有十景高分二号影像,分辨率为1 m。由于数据量较少,本文采取在小样本数据集上表现较好的UNet。GID地物占比不均匀,类间相似性较大、类内相似性较小,因此本文分别从加入先验知识(如纹理、颜色、边缘[19]特征)、改进网络结构(如加入密集链接重复利用特征)、使用不同损失函数(如Focal Loss与Dice Loss相加组合)三方面对UNet进行改进,改善UNet语义分割效果,以提高网络性能评价指标,达到良好的语义分割水准。

1" 改进UNet

1.1" 多特征信息

随着遥感图像空间分辨率的提升,表达的地物信息更加丰富。然而,仅使用遥感图像的光谱信息难以有效分辨地物类别。本文添加了图像的边缘特征、纹理特征和颜色特征改进网络输入端,以分辨在原始图像上相似的地物类别[20],提升语义分割的准确率。

1.1.1" 边缘特征

对于遥感图像的语义分割,边界部分一直是分类的重点,使用边缘检测算子可以有效保留物体的形状特征、局部细节信息以及空间上的全局信息。常用的边缘检测算法有Canny算子、Sobel算子、Prewitt算子,相较于其他边缘检测算子,Canny算子能够尽可能多地标记和接近实际地物边缘,图像中的边缘仅标记一次,且具有良好的抗噪性。本文采用Canny算子提取的边缘特征作为加入网络训练的先验知识。

1.1.2" 纹理特征

纹理特征能反映图像同质现象的视觉特征,体现了物体表面具有缓慢变化或者周期性变化的表面结构组织排列属性。

纹理通过像素及其周围空间邻域的灰度分布来表现。纹理在体现全局特征的同时,也描述了图像或图像区域所对应景物的表面性质。本文所使用的灰度共生矩阵[21]是用于图像纹理特征描述的方法,该方法通过分析图像中像素灰度值间的相对位置关系来描述纹理特征。

灰度共生矩阵可以描述图像的多种纹理特征,如灰度分布、对比度、方向性等,常用的特征包括能量、对比度、相关性、熵等。本文选择能量、对比度、同质性作为输入模型的特征:

E=∑i∑jg(i,j)2;(1)

C=∑i∑j(i-j)2g(i,j);(2)

Hh=∑i∑jg(i,j)1+(i-j)2。(3)

式中:E为能量;g(i,j)为灰度共生矩阵计算操作;i、j分别为像素所在行、列;C为对比度;Hh为同质性。

能量用来描述图像纹理的变化趋势,是度量图像灰度分布均匀和纹理粗细程度的标准;对比度反映图像的清晰度和纹理沟纹深浅的程度;同质性用来度量纹理的局部变化程度,其值越大表示图像局部纹理变化越小。

1.1.3" 颜色特征

颜色特征是一种全局特征,描述了图像或图像区域内对应景物的表面性质。 常用的颜色空间有RGB(red green blue)、HSV(hue saturation value)、CMY(cyan magenta yellow)、Lab(CIELab)等,相较于其他颜色空间,HSV颜色空间有直观、颜色调节方便、识别简单、易于实现等优点,在保留图像空间信息的同时,还能反映人眼的感知及鉴别能力。本文选取HSV颜色空间作为图像的颜色特征。RGB颜色空间转换为HSV颜色空间的计算公式如下:

V=max(R,G,B)。(4)

S=60(G-B)V-min(R,G,B),V≠0;""" 0,""" V=0。(5)

H=60(G-B)V-min(R,G,B),V=R;120+60(B-R)V-min(R,G,B),V=G;240+60(R-G)V-min(R,G,B),V=B。(6)

式中:V为亮度;R为红色通道像元值;G为绿色通道像元值;B为蓝色通道像元值;S为饱和度;H为色相。 V、S、H 3个分量相互独立。

1.2" 改进网络结构

1.2.1" 主体结构

UNet是一种用于图像分割任务的深度学习网络,主要采取了对称性的结构以及跳跃式链接的设计,最初由Ronneberger等[15]于2015年提出并用于生物医学影像分割中。UNet的网络结构分为两部分:编码器和解码器。编码器为下采样部分,采用传统CNN结构[22],每一层输出后通过最大池化进行下采样,用于提取影像高维抽象特征并缩减图像尺寸,提取的高维图像特征用于输入上采样部分;解码器部分采用反卷积方式进行上采样,通过反向传播算法调整反卷积参数更好地拟合数据。 UNet具有对称式结构并采取了跳跃式链接,可以在不需要大量标注数据集的情况下进行训练;跳跃式的链接设计可以使网络同时利用高、低层次信息,从而更好地进行图像的语义分割。

Densenet由Huang等[23]于2016年提出,该网络的每层都与前面的所有层链接,从而形成一种密集链接结构。该网络采用拼接方式结合其他层的提取特征,方便后续层直接访问前面层的所有信息,从而提高特征的重用率与表达能力。通过这种密集链接方法使模型每一层的参数都得到共享,减少网络参数量。同时,密集链接的参数共享有利于梯度从后向前的流动,加速模型训练过程,防止梯度消失问题,从而提高模型的鲁棒性和泛化能力。

本文的网络结构如图1所示,利用以上两种网络的特点,以UNet为主干结构,结合Densenet的密集链接思路改进UNet。通过将UNet每一个卷积模块内部的输入传递给该卷积模块的每一个卷积层,形成模块内的稀疏链接;同时保留了原始UNet编码器与解码器之间的跳跃链接,使上采样过程可以利用下采样过程的高、低维信息恢复图像尺寸,增强语义分割效果。

1.2.2" LayerScale模块

LayerScale模块具有加快收敛的作用[24],可以显著提高收敛速度并提高模型深处的精度。相较于BN以及LN(layer normalization)两种归一化方式,LayerScale具有计算量小、效果稳定且易于训练的优势,同时不需要计算均值、方差,而直接对每一层输出进行缩放。将此模块加入到编码器和解码器之间(图1),由于编码器最后一层具有较多的特征图且为模型深层,加入LayerScale模块可以加快模型的收敛,同时在深度方向上获得自适应的缩放参数,

Conv. 卷积;K3S1. 3×3大小的卷积核,步长为1;BN. 批标准化;ReLU. 线性整流函数;Conc. 拼接最大池化;k2s2. 2×2大小的池化窗,步长为2;ConvT. 转置卷积;λ. LayerScale模块中的缩放参数。

加强编码器与解码器之间的特征传递效率,使解码器部分获得更有效的特征,优化模型语义分割效果。

1.3" 损失函数

损失函数是CNN的重要组成部分,评估模型真实值与预测值不一致的程度,决定了模型优化的方向。模型通过反向传播调整参数,减小损失值,优化分类效果。本文基于加权交叉熵损失函数、Focal Loss函数、Dice Loss函数进行试验,提高交并比和难分类类别的分类精度。

1.3.1" 加权交叉熵损失函数

CNN分类应用中一般使用交叉熵(cross entropy, CE)作为损失函数,计算公式如下:

LCE=-∑ki=1yilgpi。(7)

式中:LCE为交叉熵损失函数;k为类别数;yi∈{0,1},表示真实标签中第i类的取值;pi为模型预测第i类的概率。随着训练次数的增多,损失值减小,准确率上升。在模型训练中,分类损失是所有样本分类损失的平均值,如果每个样本反向传播权值调整的贡献相同,会导致样本中占比较大的类别在权值更新中占据主导地位,模型的权重更新倾向于该类,使占比较少样本的识别率降低[25]。

针对不同类别样本占比不平衡的问题,本文使用加权交叉熵损失函数作为损失函数改进的对比,权重为

ωi=Nallk·Ni。(8)

式中:ωi为第i类样本的权重;Nall为样本总数;Ni为第i类样本的数量。

1.3.2" Focal Loss函数

Focal Loss函数由Lin等[26]提出,公式为

LFpi=-∑ki=1αi·yi1-piγlnpi。(9)

式中:LFpi为Focal Loss函数;αi为平衡分类中各类别的参数;γ为可调节因子,γgt;0。

对于分类准确的样本,pi接近于1。相较于交叉熵损失函数,Focal Loss函数对分类不准确的样本,损失并没有改变,而对分类准确的样本,损失变小,提升了分类不准确样本在整体损失中所占的比例。

同时,pi反映了样本分类的难易程度,易分类样本pi大,难分类样本pi小。难分类样本损失大,因此在优化过程中,损失函数倾向于难分样本,有助于提高难分类样本的准确度。

1.3.3" Dice Loss函数

Dice Loss函数是一种用于图像分割的损失函数[27],该函数由Dice系数得名。Dice系数是一种用于评估样本相似性的度量函数,其值越大,两个样本越相似。Dice系数的数学表达式为

D=2X∩YX+Y。(10)

式中:X为真实分割图像的像素标签;Y为模型预测分割图像的像素类别;X∩Y近似为预测图像的像素与真实标签图像像素之间的点乘,并对点乘结果进行求和;X和Y分别近似为它们各自对应图像中像素相加。Dice Loss函数表达式为

LD=1-D=1-2X∩YX+Y。(11)

式中,LD为Dice Loss函数。Dice Loss函数可以缓解样本中类别不平衡带来的消极影响。类别不平衡说明未分类地物占据了图像中的大部分面积,该部分不包含分类目标。Dice Loss函数专注于减少假反例的数量,重点关注正样本;而交叉熵损失函数平等处理正负样本,正样本比例较小时,会被负样本淹没。Dice Loss函数在训练时会出现梯度不稳定的现象,甚至会出现梯度饱和现象,一般与交叉熵损失函数组合使用。

为同时提高难分类类别的分类精度、各类别的交并比和平均交并比,优化由于占比较少而较难分类的地物以及RGB信息相似导致较难分类的地物,防止Dice Loss函数带来的梯度不稳定现象,本文将Focal Loss函数与Dice Loss函数相加组合使用。

1.4" 精度指标

遥感图像语义分割是一种像素级的分类,本文采用像素精度、均类像素精度、交并比、平均交并比、召回率5个指标评价网络模型。

像素精度为所有像素中分类正确的像素占所有像素的比例:

ap=∑ki=1pii∑ki=1∑kj=1pij。(12)

式中:ap为像素精度;pii为类别为i被分类正确的像素数目;pij为实际类别为i、分类类别为j的像素数目。均类像素精度为每个类别分类正确像素占所有被预测为该类像素总数比例的平均值:

amp=1k∑ki=1pii∑kj=1pij。(13)

式中,amp为均类像素精度。交并比为像素真实值与预测值的交集和像素真实值与预测值并集的比值:

rIoU=pii∑kj=1pij+∑kj=1pji-pii。(14)

式中,rIoU为交并比。平均交并比为所有类别计算出的交并比取平均值:

rmIoU=1k∑ki=1pii∑kj=1pij+∑kj=1pji-pii。(15)

式中,rmIoU为平均交并比。召回率为分类正确的像素占实际为该类像素的比例:

rre=pii∑kj=1pij。(16)

式中,rre为召回率。

2" 实验过程

本文选取GID作为实验数据集,首先裁剪并扩增数据集,提取多种底层特征,构建网络模型,对不同的损失函数进行试验,训练模型得到最优参数,然后用消融实验确定各个改进的贡献,与经典网络进行对比,验证网络有效性;最后对实验结果进行分析,得出结论。实验流程如图2所示。

2.1" 数据集介绍

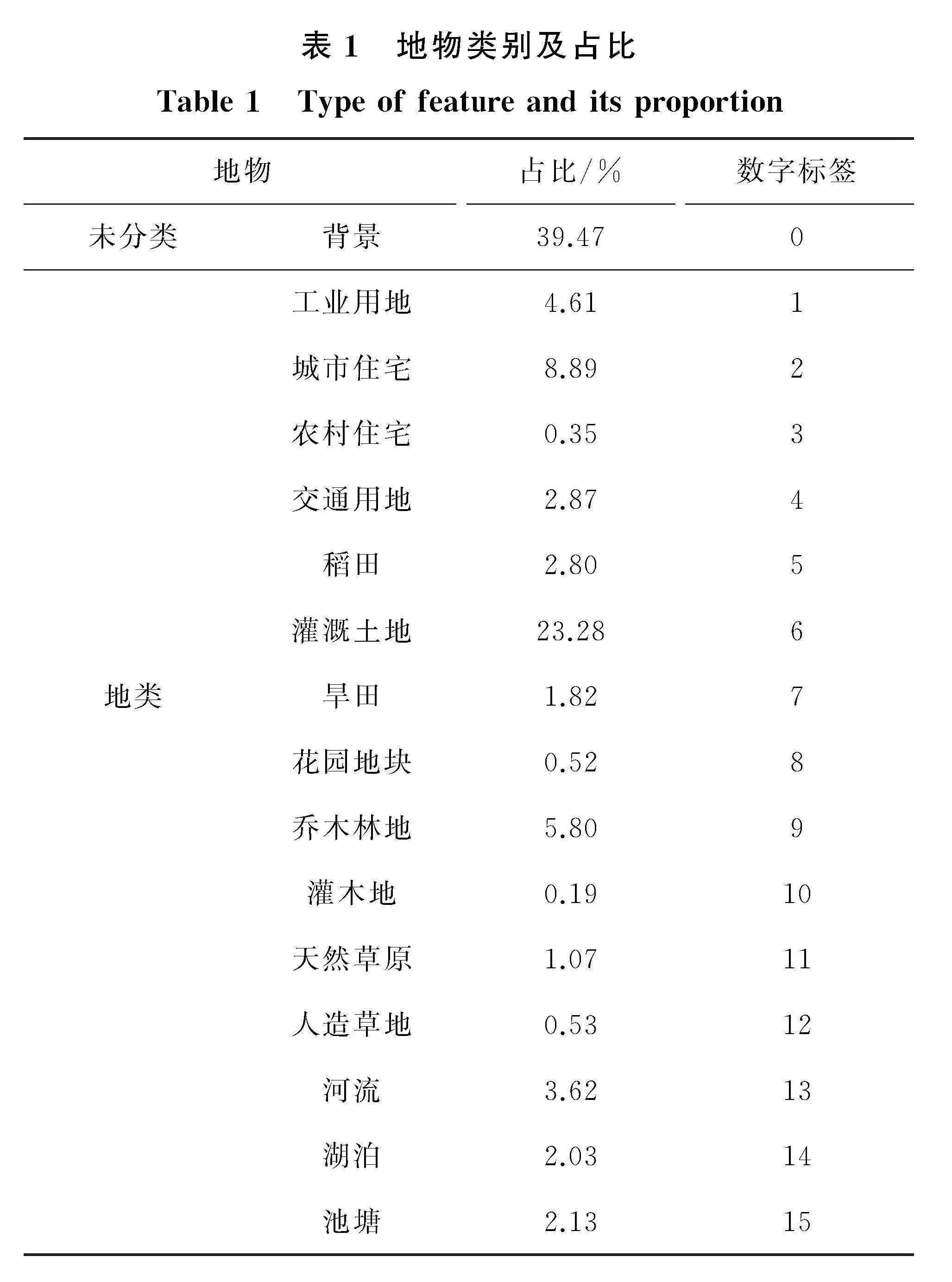

GID[28]由武汉大学收集的高分二号影像制作完成,该数据集含有15类地物及1类未分类地物,共10张7 200×6 800大小的高分二号卫星影像,分辨率为1 m。

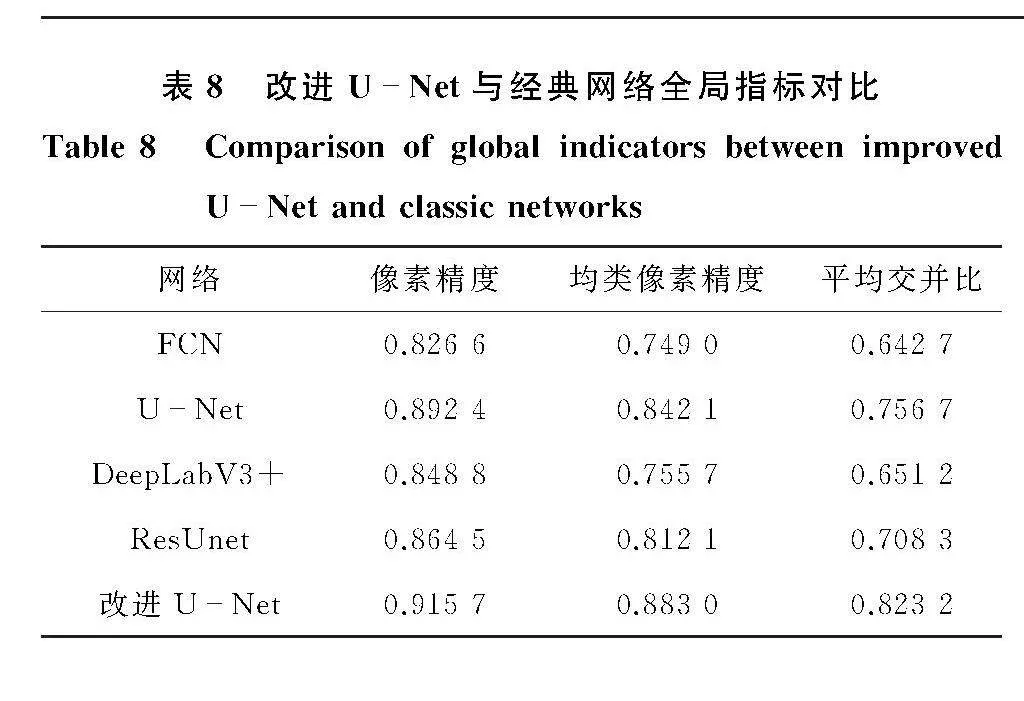

如表1所示:地类分别为工业用地、城市住宅、农村住宅、交通用地、稻田、灌溉土地、旱田、花园地块、乔木林地、灌木地、天然草原、人造草地、

河流、湖泊、池塘;未分类地物,即背景占比较大,而地类中的花园地块、灌木地等占比较小。背景与花园地块等占比差别较大,这会影响花园地块等占比较小类地物的分类结果。

2.2" 样本数据集制作

将影像平均裁剪为256×256大小,按7∶2∶1分为训练集、验证集、测试集。影像大小为7 200×6 800,由于宽高无法被256整除,裁剪影像时将宽高不足256的部分舍弃。

由于训练集样本数量较少,而训练样本过少易导致过拟合,使模型泛化能力不足;因此,本文在实验中对数据集进行数据增强,增强数据集原始图像的亮度,扩增数据集,增强模型的泛化能力。

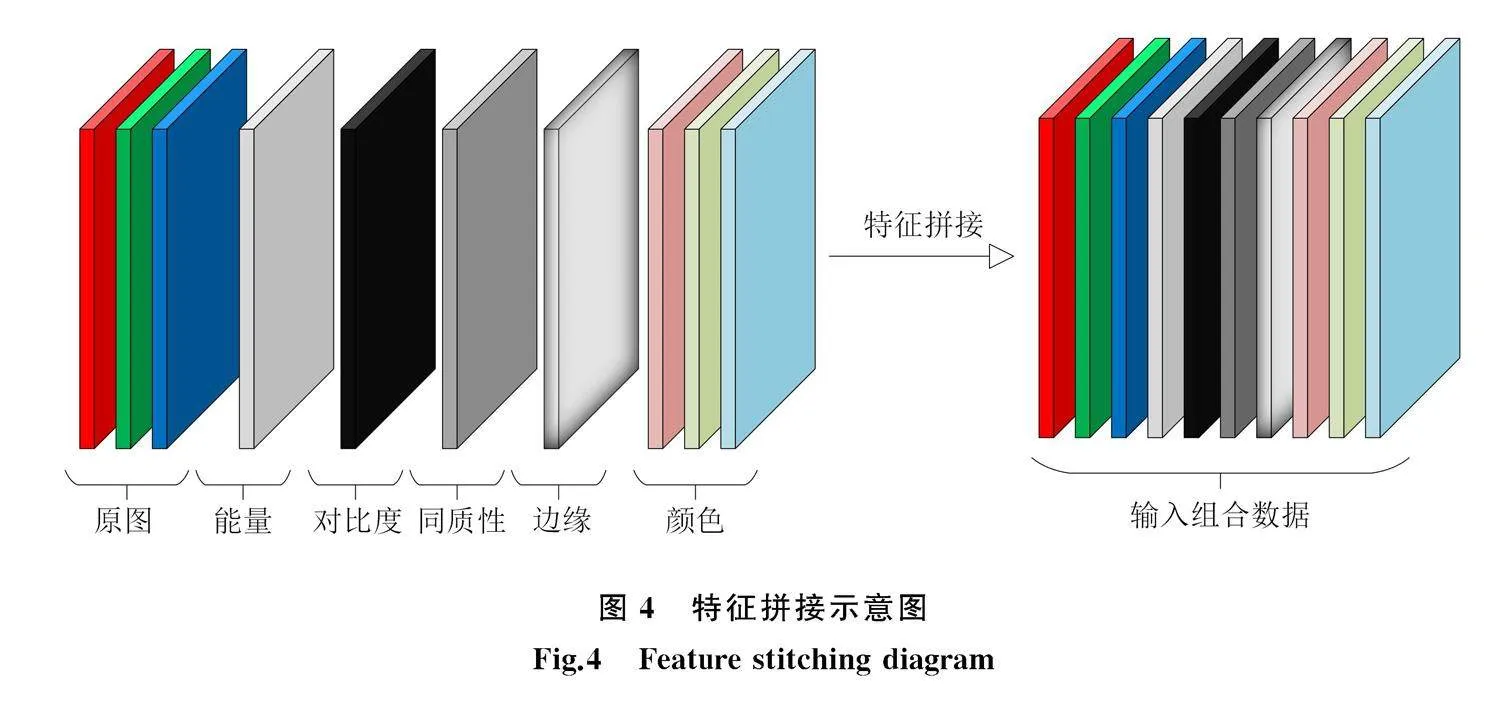

提取数据集的边缘、纹理、颜色特征,将这些特征在通道方向拼接到原始数据集。本文将原始RGB三通道数据转化为灰度数据,通过灰度共生矩阵提取图像的能量、对比度、同质性作为纹理特征。各种特征如图3所示。

数据集原始形状为(256," 256, 3)的RGB三通道,将边缘、纹理、颜色按照波段叠加的方式叠加为形状为(256, 256, 10)的数据(图4)。

2.3" 模型训练

本文基于tensorflow+keras框架进行训练,使用Adam优化器,初始学习率为0.001,每次输入网络的图像数量为32。为确保模型可以最优化,每3个批次失函数如果不下降,学习率变为原来的一半,通过监测验证数据集的准确率确定模型是否达到最佳。

3" 结果分析

3.1" 损失函数对比

在UNet模型下,为提高网络的平均交并比及均类像素精度,分别使用表2列出的损失函数,并对得到的结果进行分析。

由表2可知:由于未分类地物在数据集中占比较多,加权交叉熵损失函数在均类像素精度上虽然相比交叉熵损失函数

有所提升,但抑制优化未分类地物的优化方向使得像素精度降低,同时较多的未分类地物被分到其他种类地物中,对占比较小地物

a. 原始图像;b. 边缘特征;c. 纹理特征(能量);d. 纹理特征(对比度)e. 纹理特征(同质性);f. 颜色特征。

的交并比造成较大影响,平均交并比低于交叉熵损失函数;Focal Loss函数与Dice Loss函数相加组合像素精度、均类像素精度、平均交并比均高于其他损失函数,本文采用Focal Loss与Dice Loss相加组合作为损失函数。

3.2" 消融实验

为验证每种改进的有效性及其对像素精度、均类像素精度、平均交并比的贡献,分别按消去一种改进(实验1—3)、消去两种改进(实验4—6)、不消去改进(实验7)进行实验(表3)。

消融实验结果见表4。从表4可以看出,消去密集链接结构(实验1)、损失函数组合(实验2)和多特征(实验3)的添加,像素精度、均类像素精度、平均交并比均降低;实验4、5、6中又在实验1、2、3的基础上分别消去了多特征、密集链接结构、损失函数组合的添加,3种指标均降低。3种改进在缺少一种或两种的情况下,精度指标均降低,证明了本文对UNet所做改进的有效性。

在实验7中3种改进的基础上添加LayerScale模块,记作实验8。实验7、8结果对比见表5。

实验8相较于实验7,像素精度、均类像素精度、平均交并比均有不同程度的提升,分别提升了0.000 5、0.005 8、0.007 3,证实了在本文改进UNet中添加LayerScale模块的有效性。

综上,本文提出的改进UNet相比其余6组消融实验具有更好的语义分割效果。

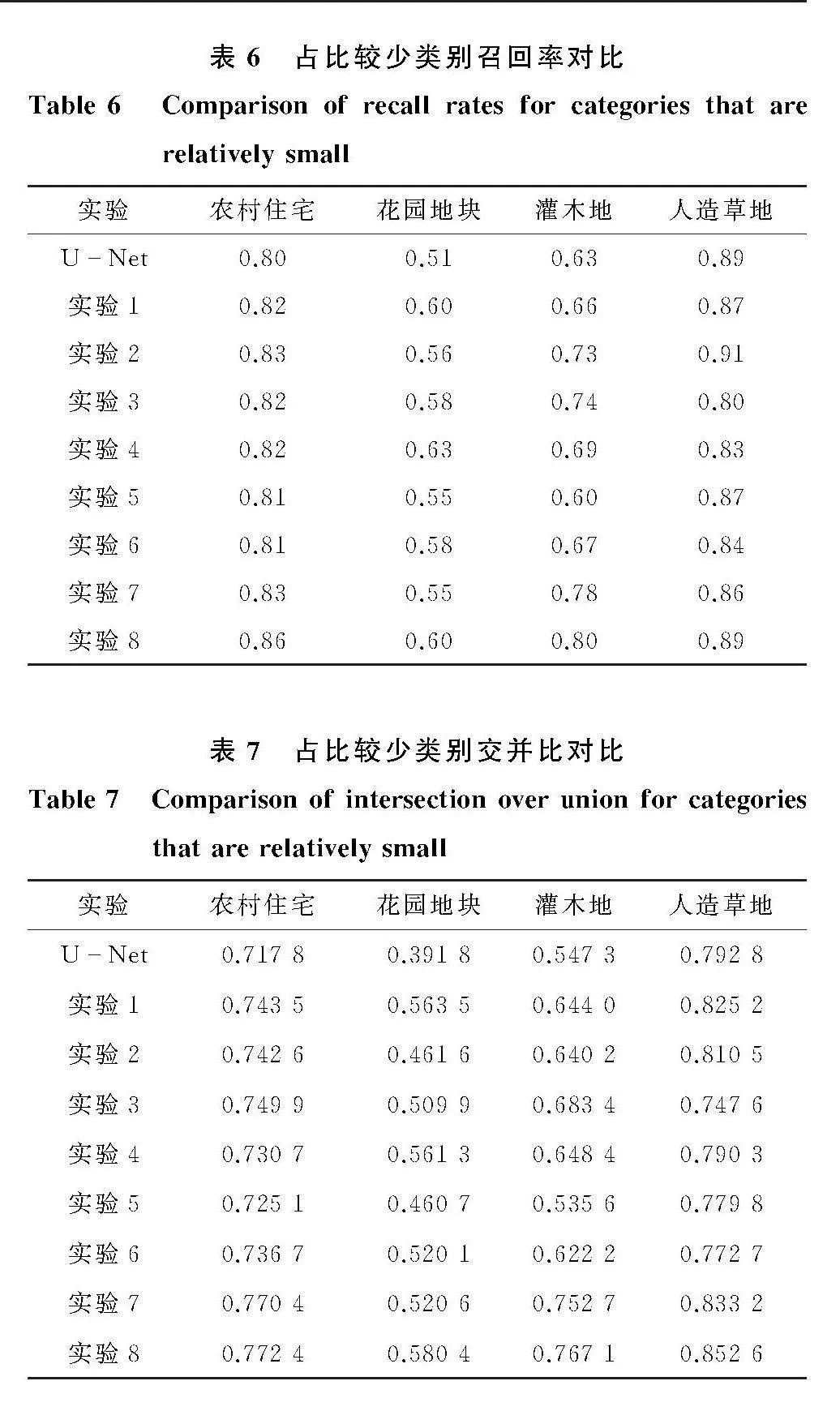

3.3" 占比较少类别召回率前后对比

农村住宅、花园地块、灌木地、人造草地在数据集中占比分别为0.35%、0.52%、0.19%、0.53%(表1),均小于1%,将原始UNet在这四类上的分类召回率和交并比与实验1—8进行对比,结果见表6、表7。可见,本文所采用的方法在四种占比较少的类别中,实验8相比其余7组消融实验有更好的表现,且召回率、交并比均大于或等于原始UNet。证明了本文方法对增强占比较少地类分类效果的有效性。

3.4" 与其他网络结构对比

基于GID,采用FCN、UNet、DeepLabV3+、ResUnet四种经典网络与本文改进UNet进行对比,证明本文改进UNet的有效性。

3.4.1" 分割结果图

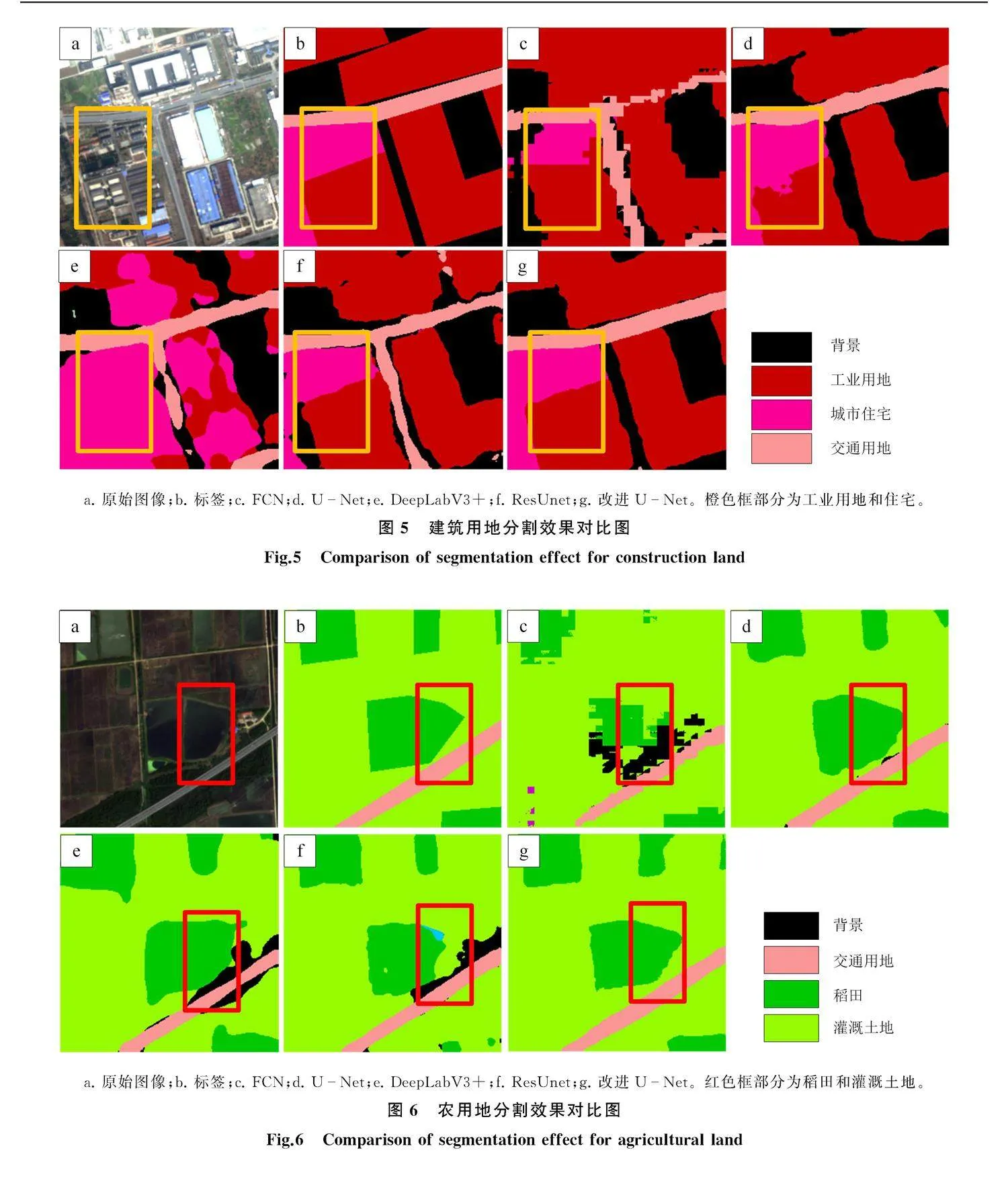

为体现本文改进UNet的优越性,本文将分割结果可视化,将网络最后一层输出结果转换为代表类别的颜色,直观体现分割效果的差异。

如图5所示:原始图像中的橙色框部分为工业用地与住宅,为相近地类,二者RGB信息相似,易造成错分现象;本文改进UNet的可视化分割结果相较于其他网络分类效果更好,分类边界更清晰,与标签贴合更好,证明了本文改进方法的有效性。

如图6所示:对于相近地类,即原始图像中红色框部分的稻田与灌溉土地,两者RGB信息相似,本文改进UNet分割边界较为清晰,分类较为明确;对于类内相似度低、类间相似度高的地类,如背景以及灌溉土地,本文改进UNet也有较好的表现,地类之间的分割边界较为锐利,地类的分割效果好于本文所对比的其他网络。

3.4.2" 全局评价指标

像素精度、均类像素精度、平均交并比3种全局评价指标是比较网络优劣的基础,本文改进UNet与经典网络全局评价指标对比见表8。

从表8可以看出,本文使用的改进UNet在像素精度、均类像素精度、平均交并比方面均高于对比网络,像素精度为0.915 7,分别比FCN、UNet、DeepLabV3+、ResUnet提高了0.089 1、0.023 3、0.066 9、0.051 2;均类像素精度为0.883 0,分别比FCN、UNet、DeepLabV3+、ResUnet提高了0.134 0、0.040 9、0.127 3、0.070 9;平均交并比为0.823 2,分别比FCN、UNet、DeepLabV3+、ResUnet提高了0.180 5、0.066 5、0.172 0、0.114 9。五种网络语义分割结果的优劣排序为:改进U

Net、UNet、ResUnet、DeepLabV3+、FCN。

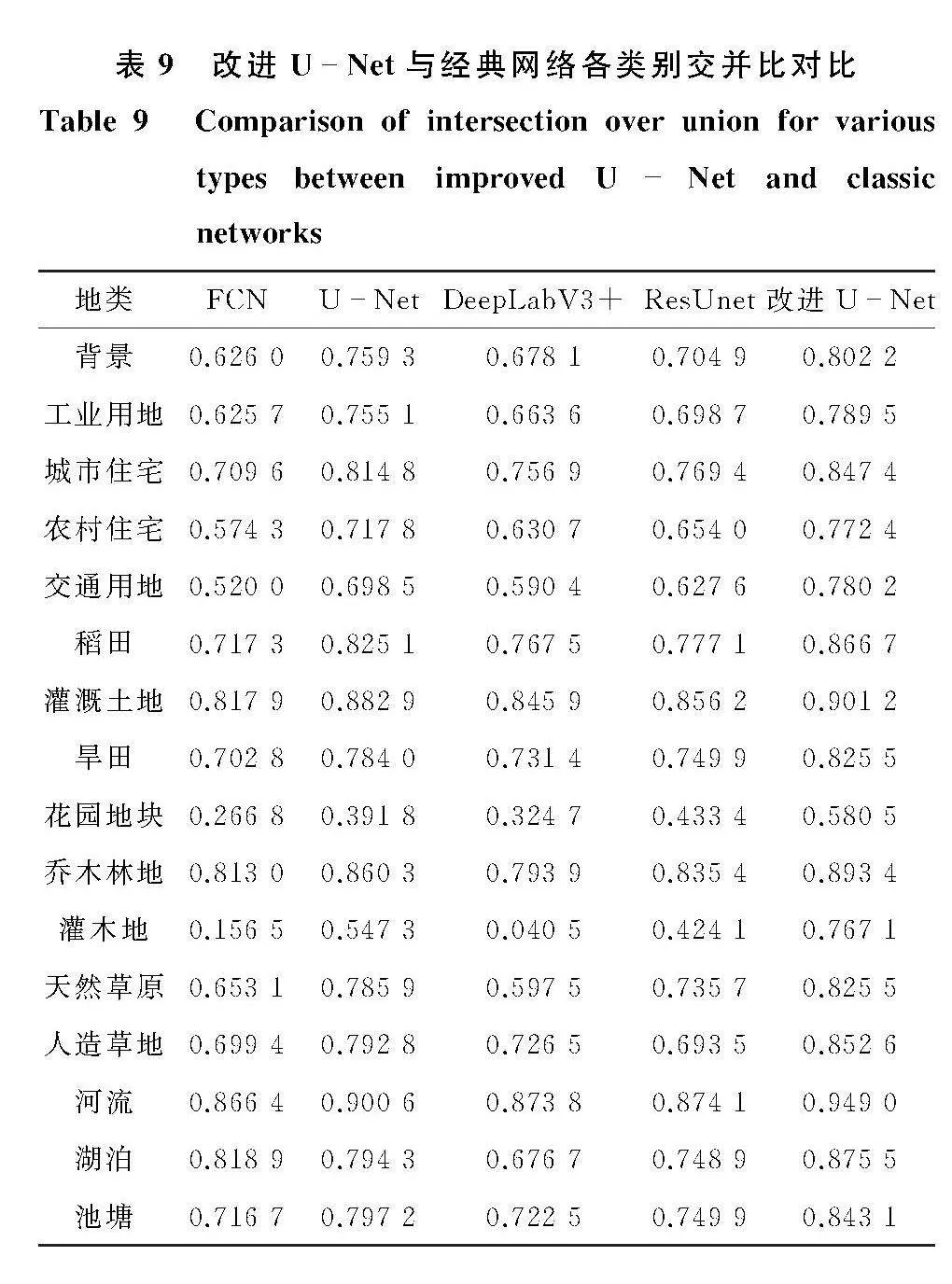

3.4.3" 交并比

对于样本数据集中占比较少的类别以及难分类的类别,交并比可以更好地显示本文改进的作用。表9为本文改进UNet与经典网络的对比,可以看出:本文改进UNet各类别的交并比均高于其他网络以及原始UNet,突出显示了本文改进UNet的有效性。对占比少于1%的农村住宅、花园地块、灌木地和人造草地,交并比有所提升。相比于UNet,交并比提升了0.054 6、0.188 6、0.219 6、0.059 8,本文改进UNet中加入且充分利用不同的底层特征,使这四种地类交并比有所提升。

4" 结论

本文改进UNet,通过消融实验、LayerScale模块添加实验、与FCN、UNet、DeepLabV3+(ResNet50)、ResUnet四种经典网络的对比实验,验证改进UNet的可靠性,结论如下:

1)改进UNet模型优于其他四种经典网络模型。与FCN、UNet、DeepLabV3+(ResNet50)、ResUnet四种经典语义分割模型相比,本文改进UNet在GID上像素精度分别提高0.089 1、0.023 3、0.066 9、0.051 2,均类像素精度分别提高0.134 0、0.040 9、0.127 3、0.070 9,平均交并比分别提高0.180 5、0.066 5、0.172 0、0.114 9。

2)加入多特征、密集链接结构、Focal Loss函数与Dice Loss函数相加组合可有效优化语义分割效果。本文以UNet为基础搭建网络,添加多特征,提高了网络对相似地物的分辨能力;采用密集链接,提高了特征的利用率;使用Focal Loss函数和Dice Loss函数相加的方法,提升了网络模型的交并比,优化了网络模型在难分类地类上的语义分割效果。相比原始UNet,改进UNet像素精度、均类像素精度、平均交并比分别提高了0.023 3、0.040 9、0.066 5。

3)LayerScale模块可优化编码器、解码器之间的特征传递,提高像素精度、均类像素精度、平均交并比。本文将LayerScale模块加入到编码器与解码器之间,缩放网络深层特征图参数,加快网络收敛,抑制无效特征、突出有效特征,在添加多特征、构建密集链接结构、使用Focal Loss函数与Dice Loss函数相加组合的基础上,像素精度、均类像素精度、平均交并比分别提高了0.000 5、0.005 8、0.007 3。

4)本文方案对占比较少地类有较好的语义分割效果,对占比少于1%的农村住宅、花园地块、灌木地和人造草地,交并比有所提升。相比于UNet,交并比分别提升了0.054 6、0.188 6、0.219 8、0.059 8。

参考文献(References):

[1]" 李美霖, 芮杰, 金飞, 等. 基于改进 YOLOX 的遥感影像目标检测算法[J]. 吉林大学学报 (地球科学版), 2023, 53(4): 13131322.

Li Meilin, Rui Jie, Jin Fei. et al. Remote Sensing Image Target Detection Algorithm Based on Improved YOLOX[J]. Journal of Jilin University (Earth Science Edition), 2023, 53(4): 13131322.

[2]" 宝音图,刘伟,李润生,等. 遥感图像语义分割的空间增强注意力U型网络[J].北京航空航天大学学报,2023, 49(7):18281837.

Bao Yintu, Liu Wei, Li Runsheng, et al. Scene Classification and Semantic Segmentation of Optical Remote Sensing Image Based on Deep Learning [J]. Journal of Beijing University of Aeronautics and Astronautics, 2023, 49(7): 18281837.

[3]" 门计林. 基于卷积神经网络的高分辨率遥感影像土地利用分类[D].武汉:中国地质大学,2019.

Men Jilin. Land Use Classification of High Resolution Remote Sensing Images Based on Convolutional Neural Networks[D]. Wuhan: China University of Geosciences, 2019.

[4]" Wallraven C, Caputo B, Graf A. Recognition with Local Features: The Kernel Recipe [C]//Ninth IEEE International Conference on Computer Vision. Nice: IEEE,2003: 257264.

[5]" Breiman L. Random Forest[J]. Machine Learning, 2001, 45: 532.

[6]" 贺婷, 周宁, 吴啸宇. 基于深度全连接神经网络的储层有效砂体厚度预测[J]. 吉林大学学报 (地球科学版), 2023, 53(4): 12621274.

He Ting, Zhou Ning, Wu Xiaoyu. Thickness Prediction of Reservoir Effective Sand Body by Deep Fully Connected Neural Network[J]. Journal of Jilin University (Earth Science Edition), 2023, 53(4): 12621274.

[7]" 朱丽,王新鹏,付海涛,等.基于注意力机制的细粒度图像分类[J].吉林大学学报(理学版),2023,61(2):371376.

Zhu Li, Wang Xinpeng, Fu Haitao, et al. Few-Shot Learning Based on Contrastive Learning Method [J]. Journal of Jilin University (Science Edition), 2023, 61(2): 371376.

[8]" 黄梅,杨文忠,汪传建,等.基于SEDRUnet的遥感影像耕地变化检测[J].东北师大学报(自然科学版),2022,54(2):6167.

Huang Mei, Yang Wenzhong, Wang Chuanjian, et al. Change Detection for Cultivates Land in Remote Sensing Images Based on SEDRUnet[J]. Journal of Northeast Normal University (Natural Science Edition), 2022, 54(2): 6167.

[9]" Lecun Y, Bottou L. Gradient-Based Learning Applied to Do Cument Recognition[J]. Proceedings of the IEEE, 1998, 86(11): 22782324.

[10]" Krizhevsky A, Sutskever I, Hinton G E. ImageNet Classification with Deep Convolutional Neural Networks[J]. Communications of the ACM, 2017, 60(6): 8490.

[11]" Simonyan K, Zisserman A. Very Deep Convolutional Networks for Large-Scale Image Recognition[J/OL]. Computer Science[2023510]. DOI:10.48550/arXiv. 1409.1556.

[12]" Szegedy C, Liu W, Jia Y, et al. Going Deeper with Convolutions[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015: 19.

[13]" He K, Zhang X, Ren S, et al. Deep Residual Learning for Image Recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 770778.

[14]" Long J, Shelhamer E, Darrell T. Fully Convolutional Networks for Semantic Segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 39(4): 640651.

[15]" Ronneberger O, Fischer P, Brox T. UNet: Convolutional Networks for Biomedical Image Segmentation[C]//Medical Image Computing and Computer: Assisted Intervention. [S. l. ]: Springer, 2015: 234241.

[16]" Badrinarayanan V, Kendall A, Cipolla R. Segnet: A Deep Convolutional Encoder-Decoder Architecture for Image Segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 24812495.

[17]" Chen L C, Zhu Y, Papandreou G, et al. Encoder-Decoder with Atrous Separable Convolution for Semantic Image Segmentation[C]//Proceedings of the European Conference on Computer Vision (ECCV). Berlin: Springer Cham, 2018: 801818.

[18]" Xiao X, Lian S, Luo Z, et al. Weighted Res-UNet for High-Quality Retina Vessel Segmentation[C]//9th International Conference on Information Technology in Medicine and Education (ITME). [S. l. ]: IEEE, 2018: 327331.

[19]" 许慧敏.基于深度学习UNet模型的高分辨率遥感影像分类方法研究[D].成都:西南交通大学,2018.

Xu Huimin. Method Research of High Resolution Remote Sensing Imagery Classification Based on UNet Model of Deep Learning[D]. Chengdu: Southwest Jiaotong University, 2018.

[20]" Zhang H, Wang M, Wang F, et al. A Novel Squeeze-and-Excitation W-Net for 2D and 3D Building Change Detection with Multi-Source and Multi-Feature Remote Sensing Data[J]. Remote Sensing, 2021, 13(3): 440.

[21]" Smith J R, Chang S F. Automated Binary Texture Feature Sets for Image Retrieval[C]//IEEE International Conference on Acoustics, Speech, and Signal Processing Conference Proceedings. [S. l. ]: IEEE, 1996: 22392242.

[22]" 曹智慧. 基于全卷积U形网络的脑核磁共振图像分割[D].南京:南京信息工程大学,2019.

Cao Zhihui. Modified UNet for Brain MR Image Segmentation[D]. Nanjing: Nanjing University of Information Science amp; Technology, 2019.

[23]" Huang G, Liu Z, Laurens V D M, et al. Densely Connected Convolutional Networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. doi:10.1109/CVPR.2017.243.

[24]" Touvron H, Cord M, Sablayrolles A, et al. Going Deeper with Image Transformers[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021: 3242.

[25]" 彭晓婷.基于深度学习的不平衡数据集分类的方法研究[D].北京:北京化工大学,2021.

Peng Xiaoting. Research on Classification of Imbalanced Data Set Based on Deep Learning [D].Beijing: Beijing University of Chemical Technology, 2021.

[26]" Lin T Y, Goyal P, Girshick R, et al. Focal Loss for Dense Object Detection[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice: IEEE, 2017: 29802988.

[27]" Li X, Sun X, Meng Y, et al. Dice Loss for Data-Imbalanced NLP Tasks[J/OL]. arXiv Preprint[2023510]. https://doi.org/10.48550/arXiv:1911.02855.

[28]" Tong X Y, Xia G S, Lu Q, et al. Land-Cover Classification with High-Resolution Remote Sensing Images Using Transferable Deep Models[J]. Remote Sensing of Environment, 2020, 237: 111322.