CNN影像输入尺寸和分辨率对川西针叶林植被分类精度的影响

2024-01-01石伟博廖小罕王绍强岳焕印王东亮

石伟博,廖小罕,王绍强,5,6,岳焕印,王东亮

1.中国地质大学(武汉) 地理与信息工程学院 区域生态过程与环境演变实验室,武汉 430074;

2.中国科学院地理科学与资源研究所 资源与环境信息系统国家重点实验室,北京 100101;

3.中国科学院无人机应用与管控研究中心,北京 100101;

4.中国民航局 低空地理信息与航路重点实验室,北京 100101;

5.中国科学院地理科学与资源研究所 生态系统网络观测与模拟重点实验室,北京 100101;

6.中国科学院大学 资源与环境学院,北京 100049

1 引言

森林作为地球上十分重要的生态系统,具有生物多样性保护、固碳释氧、气候调节、水源涵养、水土保持、环境净化等生态功能(廖亮林 等,2016;Iverson 等,2018;朱万泽 等,2021),对区域内乃至全球的生态多样性、碳循环等有很大的贡献。川西亚高山针叶林作为我国第二大林区(西南林区)的主体(杜志 等,2014),是长江上游重要的生态屏障,在区域气候调节、水源涵养和生物多样性保育等方面具有不可替代的作用和地位(刘庆 等,2001)。就森林生态系统而言,了解森林植被分布对于森林的可持续管理十分重要。过去,为了获取植被的分布情况,往往采取实地调查的方式。这种方法耗时耗力,成本也很高,对于西南林区而言,由于其复杂的地形条件,还会有一定的安全隐患。随着遥感技术的不断进步,遥感已经成为获取森林植被分布的重要手段之一,在林业中得到广泛的应用(Fassnacht 等,2016)。传统的卫星数据,如Landsat、SPOT 系列等卫星影像,由于其空间分辨率较低,无法提供足够的空间细节,往往只用作大范围植被制图。高分卫星数据,如IKONOS、QuickBird、WordView 等卫星影像,能提供能米级甚至亚米级的遥感数据,但面临着时效性差、成本高等问题,同时受制于西南林区多云多雨多雾的气候特点,导致卫星有效观测时间更短,获得高质量、多时空的遥感影像数据难度更大。

近年来随着无人机和遥感器技术的不断发展,无人机的续航时间不断提升,搭载能力越来越强,无人机已经成为一种新型的遥感观测平台,被广泛应用于各个领域(Colomina 和Molina,2014;廖小罕等,2016;Pajares,2015;Maes 和Steppe,2019)。无人机的主要优势就在于高频次、迅捷(廖小罕 等,2019),可以用一种相对较近的方式观察地物,能够灵活、方便、快捷的获取遥感数据。此外,相较于卫星平台,无人机往往在云层下面进行观测,所以无人机遥感数据不需要进行过多的大气校正;由于无人机对于起降场地要求不高,能够适应林业复杂的地理环境,可以获取高时间、高空间分辨率的林业影像数据,对森林资源的调查和监测提供了强有力的技术支撑(曹忠,2016;刘清旺 等,2017),无人机遥感技术已经应用到林火与病虫害监测(何诚 等,2014;黄华毅 等,2021)、森林结构参数估测(王娟 等,2022;王越 等,2022)、森林植被观测(Zheng等,2021)与分类(Zhang等,2020b;Hao等,2021)、树种多样性监测(Xu等,2021)等方面。

随着深度学习的兴起,特别是卷积神经网络CNN(Convolutional Neural Networks)的兴起,在计算机视觉和模式识别上取得了较大进展,越来越多的研究者使用新兴的平台和技术进行森林植被研究(Kattenborn 等,2021)。Zhang 等(2020a)使用机载高光谱数据对南方人工林林场植被进行分类,利用改进的3D-CNN 分类模型实现了大面积、高精度的树种分类;Trier 等(2018)使用机载激光扫描和高光谱数据,结合深度神经网络对挪威森林中的3个优势树种进行分类制图,精度达87%。然而,高光谱载荷设备昂贵,飞行成本较高,并且高光谱遥感数据往往需要专业的人员进行影像处理,门槛较高,难以在林业研究中进行普及。

随着消费级无人机的兴起,林业研究者能够以低成本的代价获取超高空间分辨率的RGB 影像数据,这对于林业研究有着非常重大的意义。RGB影像数据不依赖于复杂的传感器,不需要专业的校准和数据预处理,节约了影像处理时间和减少数据成本,并且能够广泛的应用在国内外林业工作中(Natesan 等,2019;林志玮 等,2019;戴鹏钦等,2020)。Natesan等(2019)等使用消费级无人机获取加拿大安大略省保护林的RGB 影像,使用CNN 对白松、红松两种优势树种进行分类,精度可达80%;林志玮 等(2019)使用无人机光学图像结合DenseNet 卷积神经网络模型对12 个树种进行分类,模型精度达到87.54%。然而在这些研究中大多只考虑了森林的物种多样性,大部分的实验地点和研究区域往往倾向于良好的生态条件,如地势较为平坦、林内物种复杂度较低、种内年龄组数量较少、距道路较近等,没有考虑到森林内复杂的生态条件,人为干扰因素较多。并且由于无人机影像的获取与处理有着自身的特殊性,研究主要集中在树种分类的精度上,但对于空间分辨率与影像裁剪尺寸上的研究尚不多见。

基于此,本研究选取地形条件复杂、种内年龄组差异较大、人迹罕至、高原高山生态环境的川西亚针叶林为研究区域,拟使用无人机获取典型区域的高分辨率RGB 影像,结合多类语义分割方法(U-Net)对实验区进行植被分类,构建不同分辨率和裁剪尺寸的样本集,并建立基于多个样本集的森林指纹库;通过模型构建和精度比较,分析讨论无人机影像的空间分辨率和裁剪尺寸对CNN 模型精度的影响,以期为川西亚针叶林的植被监测研究提供科学依据。

2 研究区域概况

研究区域位于中国四川省平武县王朗国家级自然保护区(103°55′E—104°10′E,32°49′N—33°02′N)(图1)。王朗自然保护区位于青藏高原与四川盆地两大地貌单元的交汇地段,地处横断山脉北缘的川西高山峡谷地区,其原始森林是川西北地区保存最完好的一片(顾人和,2005)。保护区属于丹巴—松潘半湿润气候,海拔高度为2300—4980 m,气候有明显的垂直地带性,年平均温度2.5 ℃—2.9 ℃,最低温-17.8 ℃,最高温26.2 ℃,年降雨量859.9 mm。

图1 研究区域概况Fig.1 Overview of the study area

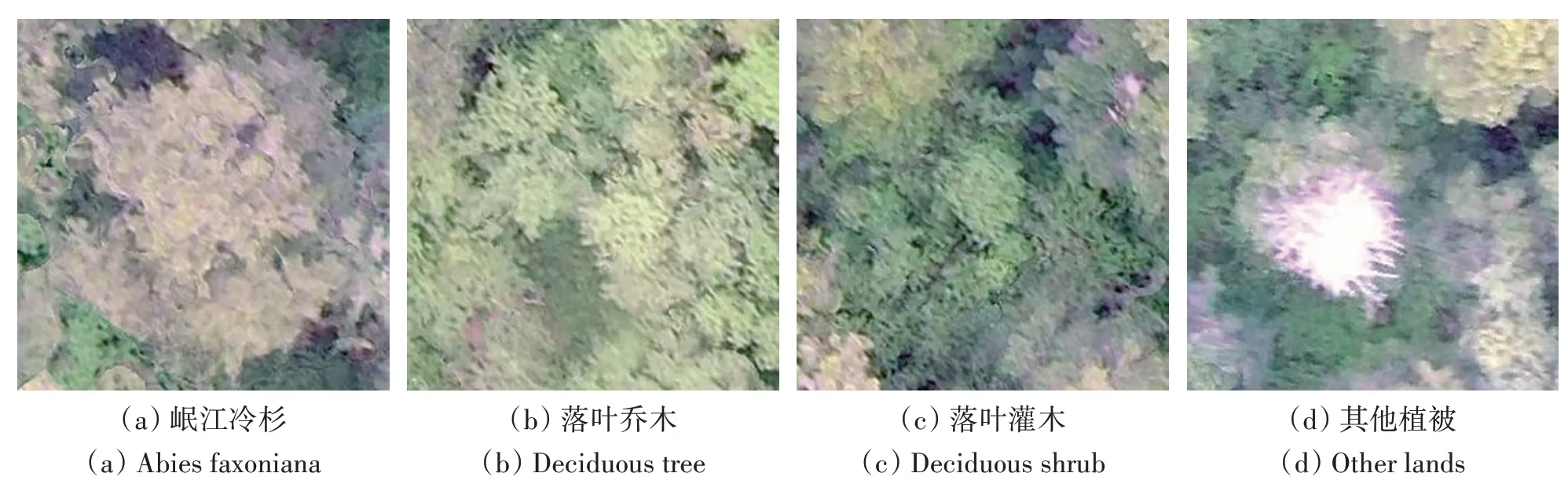

该研究区域地处岷山北部野生大熊猫核心栖息地,是北京大学和中国科学院植物研究所主持共建的监测样地,于2020 年加入“中国森林生物多样性监测网络(CForBio)”;其远离道路和人为因素干扰,生态环境复杂,种内年龄组差异较大,属于高山高原地区,区域内地形起伏较大,高差达100多米。根据样地清查数据显示,研究区域内以针叶树、落叶乔木、落叶灌木、藤本为主,其中针叶树中以岷江冷杉(Abiesfaxoniana)为优势树种,林中伴随着紫果云杉(Piceapurpurea)与方枝柏(Sabinasaltuaria);落叶乔木主要以川西樱桃(Cerasustrichostoma)、红桦(BetulaalbosinensisBurk)、紫华卫矛(EuonymusporphyreusLoes)为主;落叶灌木主要有紫萼山梅花(Philadelphuspurpurascens)、陕甘花楸(SorbuskoehneanaSchneid)、红脉忍冬(LoniceranervosaMaxim)等为主;藤本主要以猕猴桃藤山柳(ClematoclethraactinidioidesMaxim)为主。由于原始森林内部情况复杂,难以在无人机影像上进行一一对比,因此本研究综合考虑了野外实地调查结果和植被树冠特征,将森林植被分类为岷江冷杉、落叶乔木、落叶灌木、其他植被。其中,其他植被主要指研究区内面积所占比例很小的林窗、藤本、枯木等植被。由于保护区为国家级自然保护区,同时也是大熊猫栖息地之一,人迹罕至,除却河流、裸石外无复杂地物,所以标记其他类型植被时人为误差较小。

3 数据来源与研究方法

3.1 数据来源

无人机影像是于2020 年06 月15 日下午使用DJI 大疆Mavic 2 无人机在王朗自然保护区进行飞行获取。该无人机是消费级无人机,小巧轻便,不到1 kg,便于携带,搭载1 英寸CMOS 相机,具有障碍物感知能力,适合在森林中进行无人机RGB 影像的获取。由于样地内地形起伏较大,为了保障无人机飞行时的安全,还能够获取较高质量的超高分辨率RGB 影像,飞行高度设置为距起降地300 m,旁向重叠率80%,航向重叠率80%,飞行时天气整体良好,空中无云。本研究对样地进行了两次飞行,6月15日中午飞行一次,下午飞行一次;6月16日下午又对样地进行一次飞行,并以相同飞行参数对相邻样地进行拍摄。因为15日中午阳光强烈,无人机原始航拍照片过曝严重,导致飞行数据无法使用;而下午飞行时阳光较弱,数据质量无明显阴影效果;所以最终选择15日下午的飞行影像进行样本标注,而16日拍摄的两组影像则作为未训练的影像。后续将获取到的原始航拍影像等信息导入到专业拼图软件Pix4D Mapper,经过影像质量检查、影像数据自动匹配、点云处理等操作后,生成DSM和空间分辨率为5 cm的25 hm2正射影像。

3.2 训练样本的选取及制作

训练卷积神经网络模型的前提条件之一就是要制作训练样本。本研究区域位于王朗自然保护区北部,海拔3000 多米,远离道路,无法进入实地与无人机影像上树木进行一一比对。基于无人机高分影像、树冠特征与野外调查数据,选取正射影像中典型区域作为感兴趣区,使用ArcGIS Pro软件将图斑标记为岷江冷杉、落叶乔木、落叶灌木,其他植被。

由于无人机正射影像尺寸较大,难以直接进行训练,所以要先进行影像裁剪。为研究不同尺寸下影像裁剪对分类精度的影响,对无人机RGB影像选择三种尺寸进行裁剪,分别是128×128、256×256、512×512像素,在野外对应6.4 m、12.8 m、25.6 m的样地距离;在设置步长时,本研究选择步长等于裁剪尺寸的一半,保证样本之间有50%的重叠,步长分别为64、128、256 像素。为了研究不同空间分辨率下的无人机影像与深度学习模型之间的精度关系,对5 cm 的正射影像进行重采样到10 cm、15 cm、20 cm,以最优裁剪尺寸进行分割。样本集的部分样本如图2所示。样本集均通过数据增强的方式来扩充样本数量,这样可以在增强样本量的同时降低数据拟合的风险;最后将样本集中的90%用作训练集,进行模型的训练和拟合,取10%作为验证集进行验证。

图2 样地内植被类型展示Fig.2 Demonstration of vegetation types in the sample plots

3.2 研究方法

3.2.1 U-Net网络模型

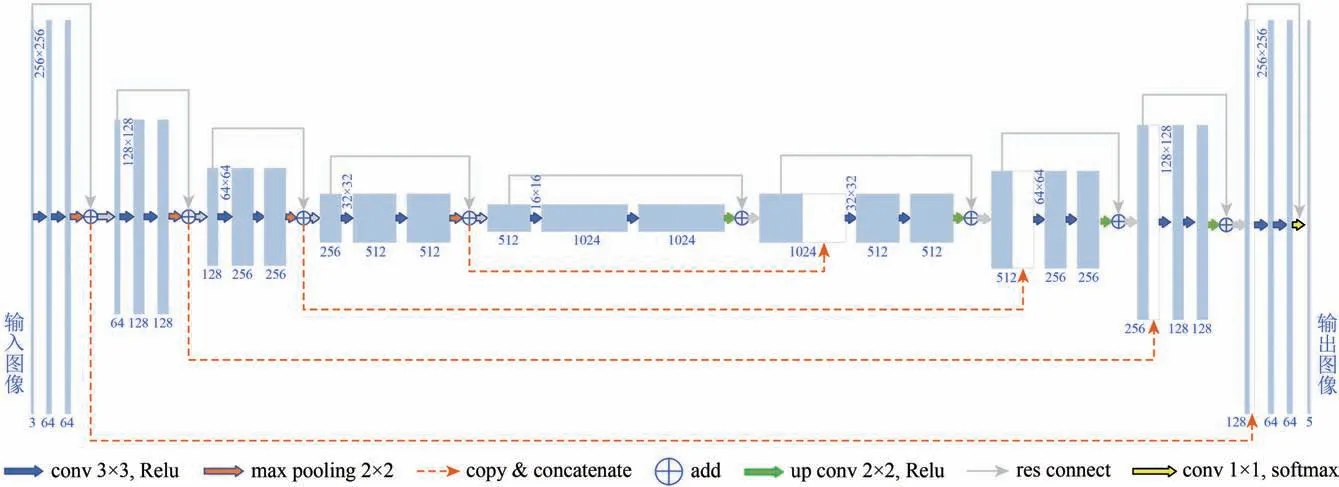

U-Net 网络模型由Ronneberger 等(2015)提出,是一种端到端网络模型结构,沿用了编码器—解码器结构和跳跃网络的特点,使得模型能够将高层语义信息和浅层特征进行融合,充分利用上下文信息和细节信息,使得模型在较小的训练集上,也能得到更为准确的特征图。

U-Net 网络模型主要包括收缩路径和扩展路径。收缩路径主要用于提取图像的上下文特征,有4 个区块,每个区块有两个3×3 的卷积层和一个2×2的池化层组成,其中卷积层使用修正线性单元ReLU(Rectified Linear Unit)作为激活函数。池化层使得图像经过每一个区块后图像的尺寸减少了一半,而卷积层则使得特征通道增加了一倍。扩展路径主要将上下文信息映射到原始尺度,同样也有4个区块。每个区域先通过一个上采样的卷积层,再进行特征拼接后,最后通过两个3×3的卷积层和激活函数(ReLU),每个区块都使得图像的尺寸扩大一倍,特征通道减少一倍,同时连接了收缩网络的特征信息。最后,通过1×1的卷积操作将全部的特征向量映射到所设定的类别上。

3.2.2 ResNet-34

ResNet-34 是ResNet 残差网络的一种网络结构,是由He 等(2016)提出,主要参考了VGG19网络,通过短路机制加入了残差单元,使得深度网络收敛速度加快,解决了深度网络的退化问题。ResNet-34 网络是指具有34 层结构的ResNet 网络结构,先采用7×7 尺寸,通道64 的卷积核进行卷积处理,再进行最大池化操作,然后构造了由4个不同残差模块组成的32 层的卷积残差结构,最后使用平均池化和全连接层输出结果。

本研究将ResNet34 与U-Net 网络模型进行结合,使用ResNet34 作为U-Net 模型的骨架模型,能够有效的利用卷积网络模型的深度优势,提升模型的精度。由于研究区内岷江冷杉为优势树种,落叶灌木样本较少,所以出现样本分布不均的情况。为了缓解这种情况,本研究使用加权分类交叉熵作为损失函数,使用随机梯度下降算法作为分类器的优化算法,每次迭代训练的样本数目为8,模型训练的epoch 设置为100,并且当模型不在改进时,将终止模型训练。模型架构如图3所示。

图3 基于ResNet34骨架结构的U-Net模型Fig.3 U-Net model based on ResNet34 backbone

3.2.3 精度评价

为了分析尺寸大小、空间分辨率对CNN模型精度的影响,本研究基于生产者精度PA(Producer’s Accuracy)、用户精度UA(User’s Accuracy)、总体精度OA(Overall Accuracy)和Kappa 系 数(Kappa Coefficient)来对模型进行精度评价。计算公式如下:

式中,mi为第i类的分类正确样本数;Ci为第i类的分类像元总数;Gi为第i类的真实像元总数;N为分类像元总数。

4 结果与分析

4.1 模型训练情况

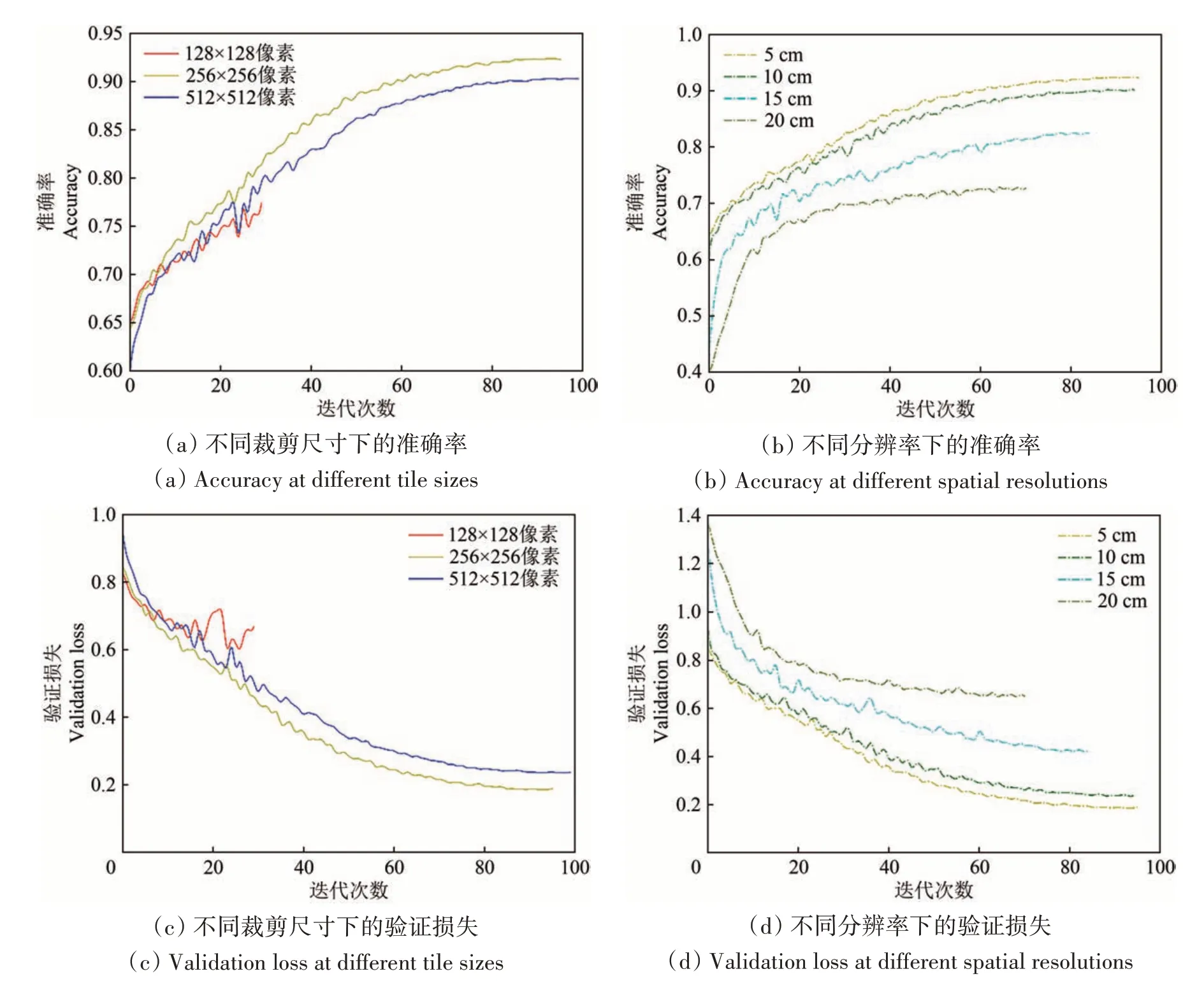

无论是在训练集还是验证集上,每个模型的损失值都随着批处理的不断增加而不断收敛。使用128×128 像素的模型在验证集上模型精度最差,使用256×256像素的模型精度最高。在空间分辨率的研究中,均选择最优裁剪尺寸256×256像素来裁剪影像。使用空间分辨率5 cm和10 cm的模型都能达到高精度水平,使用空间分辨率20 cm 的模型精度最差。模型训练的情况如图4所示。

图4 不同裁剪尺寸和不同分辨率的模型训练结果Fig.4 Training results of models with different crop sizes and different resolutions

4.2 模型训练结果

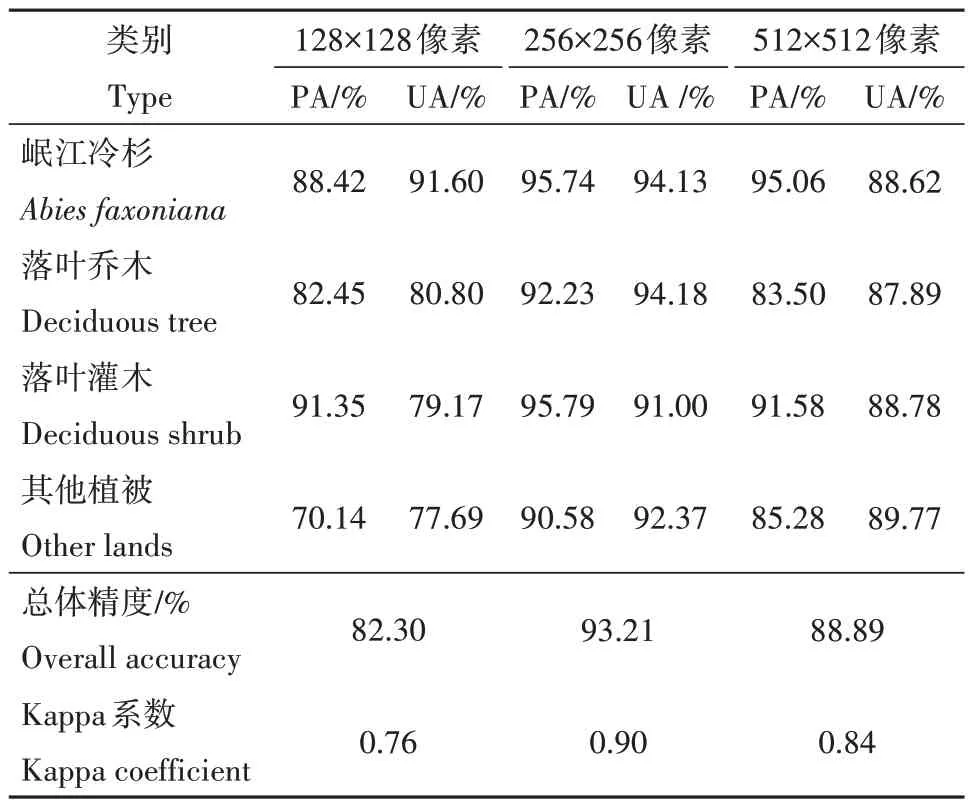

基于不同裁剪尺寸和不同分辨率的植被模型分类情况见表1 和表2。由表1 可见:表现最好的模型是在5 cm 空间分辨率下使用256×256 像素进行训练的模型,总体精度达93.21%,Kappa 系数为0.90;在使用不同裁剪尺寸建立的深度学习模型中,128×128像素的模型效果最差,总体精度为82.30%,Kappa 系数为0.76;使用512×512 像素的深度学习模型效果比使用256×256像素的深度学习模型效果差一些,总体精度为88.89%,Kappa 系数为0.84。在不同尺寸的深度学习模型中,对于覆盖范围大的植被类型,如岷江冷杉,无论是生产者精度上,还是用户精度上变化不大,生产者精度从最高95.74%下降到88.42%,用户精度从最高94.13%下降到88.62%;而对于覆盖范围较少的植被类型来说,精度则相差较大,如落叶灌木,用户精度从最高91.00%下降到79.17%。

表1 基于不同裁剪尺寸大小的植被模型精度对比Table 1 Accuracy comparison of vegetation model based on different pixel tile sizes

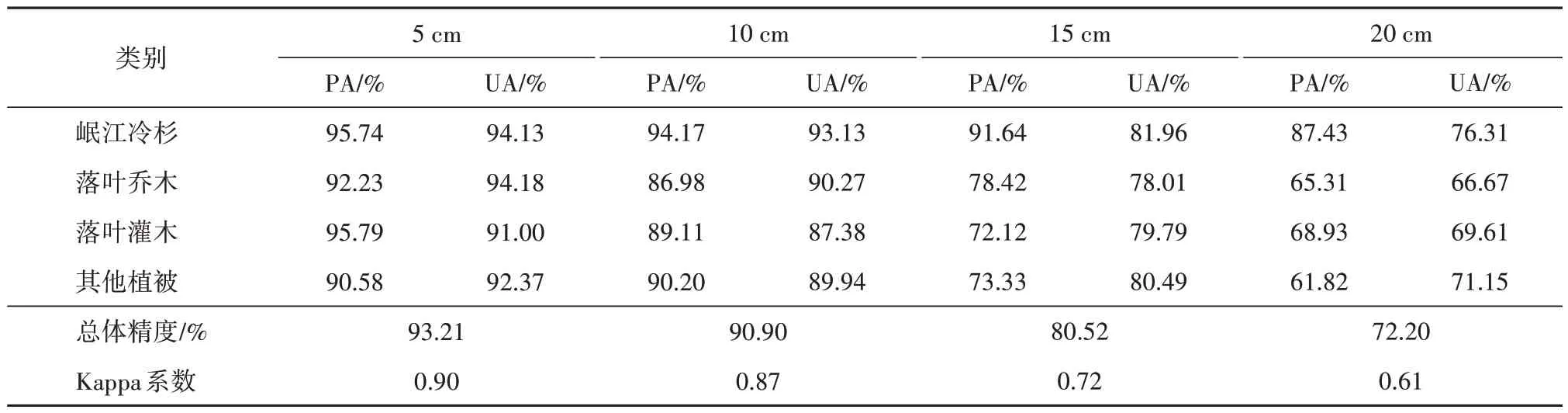

表2 基于不同空间分辨率的植被模型精度对比Table 2 Accuracy comparison of vegetation model based on different spatial resolutions

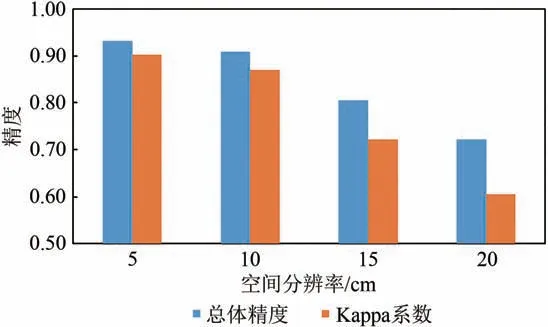

由表2可见,在不同空间分辨率的深度学习模型中,模型精度最差的是空间分辨率为20 cm 的深度学习模型,总体精度为72.20%,Kappa 系数为0.61。空间分辨率为15 cm 的深度学习模型效果一般,总体精度为80.52%,Kappa系数为0.72;空间分辨率为10 cm 的深度学习模型效果良好,总体精度为90.17%,Kappa系数为0.89。对于覆盖范围大的植被类型而言,生产者精度和用户精度在较高的空间分辨率模型中相差不高,但在低空间分辨率模型中则有下降的趋势,如岷江冷杉在空间分辨率为5 cm和10 cm的深度学习模型中生产者精度和用户精度均在90%以上,但在20 cm 的深度学习模型中,岷江冷杉生产者精度为87.43%,用户精度为76.31%。而覆盖范围低的植被类型在低分辨率的深度学习模型中生产者精度和用户精度下降的更快,如落叶灌木在10 cm空间分辨率的模型下,生产者精度为89.11%,用户精度为87.38%,而在15 cm 的深度学习模型中生产者精度为72.12%,用户精度为79.79%。

4.3 模型应用

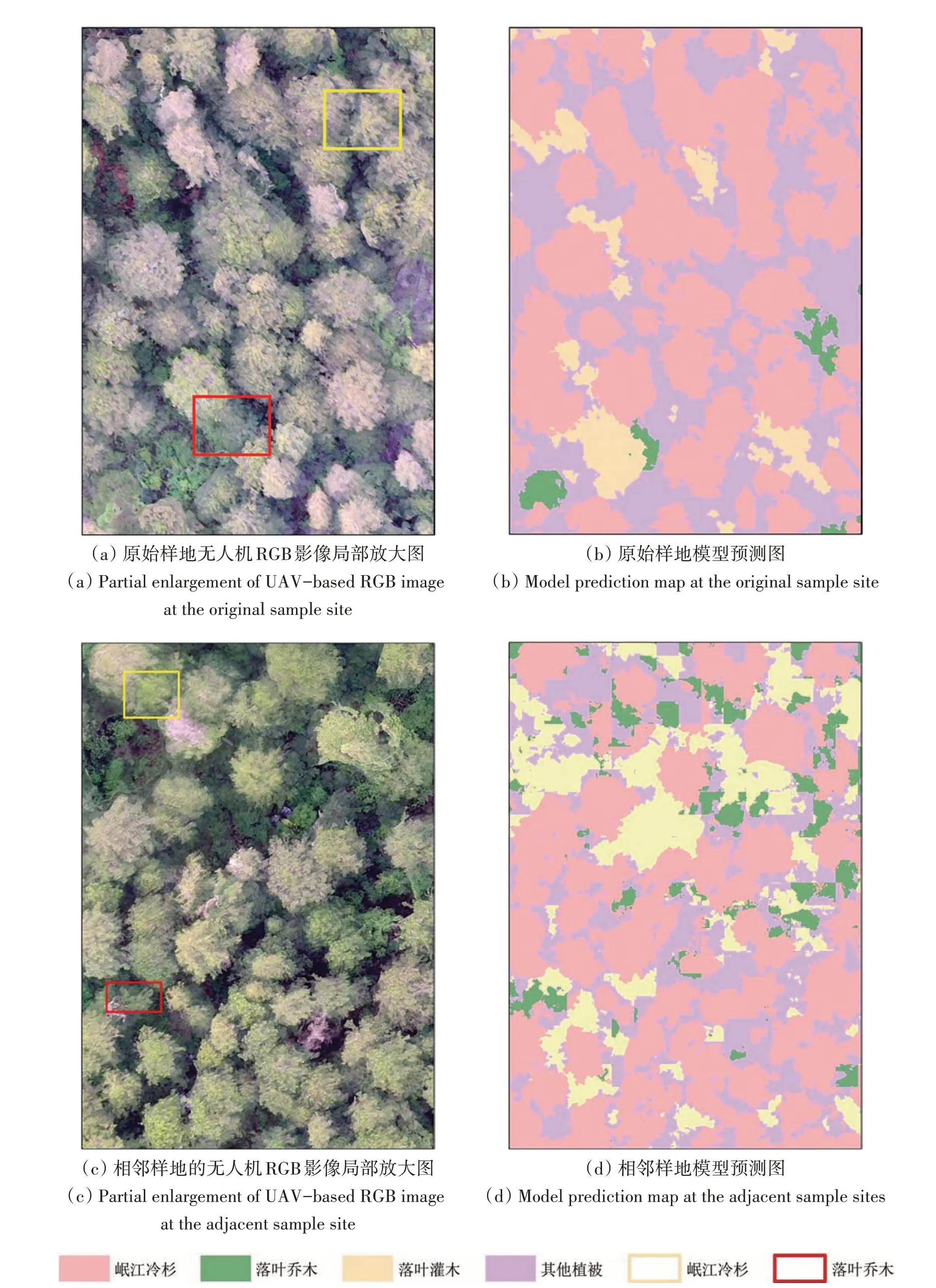

为了验证模型的适用性和可迁移性,本研究选择16 日拍摄的两幅无人机RGB 影像作为研究对象,使用256×256 像素下5 cm 空间分辨率的最优模型进行分类。其中,对同一样地进行飞行拍摄得到的无人机影像局部放大图为图5(a)所示,图5(b)是模型检测后的分类图。由图5(a)可见岷江冷杉由于其生长周期不同,种间年龄差异较大,树冠呈现出不同的颜色差异,出现“同物异谱”的现象。从图5(b)可见:各植被类别边界清晰,碎图斑较少,能够把绝大部分岷江冷杉识别出,岷江冷杉的冠层形态较好;落叶乔木和落叶灌木整体识别良好,部分区域出现漏识。黄框标注的树木为岷江冷杉,模型能够准确识别,但对于特复杂的树木边缘识别能力较弱;红框标注的树木为落叶乔木,模型将其误识为其他植被;整体分类效果不错,能够较为准确的识别出各种植被类型(图5(a))。

图5 样地影像与模型预测图对比Fig.5 Comparison of sample site images and model prediction maps

图6 空间分辨率模型的精度趋势Fig.6 Accuracy trend of spatial resolution model

对周边样地的无人机可见光影像局部放大图为图5(c)所示,图5(d)是模型检测后的分类图。图5(c)中黄框标注的为岷江冷杉,模型误识为其他类别;红框标注的为落叶乔木,模型误识为落叶灌木。从图5(d)中,能看到岷江冷杉的分类效果较好,只有少量的漏分错分,而落叶乔木和落叶灌木分类效果一般。但从总体来看,主要植被类型都能够正确的进行分类,分类精度较好;不过分类结果中出现“椒盐现象”,存在不少碎图斑,边缘效应明显。

5 讨论

5.1 模型整体表现

虽然本研究区域生态条件复杂,远离道路,地形起伏较大,但在仅使用无人机高分辨率RGB影像的情况下,通过使用U-Net语义分割模型,结合ResNet 残差网络在复杂生态条件下对川西亚高山针叶林植被进行分类得到较高的精度;并通过该模型对不同区域的植被检测获得了不错的分类效果,证明了模型具有一定的可移植性。Zhang 等(2021)使用深度学习和无人机高分影像对杭州城市森林进行分类,得到较高的分类精度;Zhang 等(2020a)使用3D 卷积神经网络处理机载高光谱数据,对南方国有林场进行大范围的树种分类,在50 ha内取得了93.14%的分类精度。然而他们的研究对象生态环境简单,森林异质性低,没有考虑到原始森林的复杂性,并且后者使用的机载高光谱数据虽然覆盖范围广,能够获得大面积的树种信息,但是数据获取成本高,难以进行大面积推广。

本研究使用消费级无人机对原始森林进行影像获取,建立了高山暗针叶林森林指纹库。指纹库内包含一个树种、2个植被类型,不同空间分辨率、不同尺寸的无人机可见光影像数据。这些数据具有高度异质性的特点,因为研究区域包括不同的植被类型,并且具有不同的年龄结构,如岷江冷杉一年生枝淡黄褐色或淡褐色,二、三年生则呈淡黄灰色或黄灰色,这就导致了岷江冷杉的冠层在同一时期会有不同的颜色,使得同一物种在无人机可见光影像上有不同的光谱特征,这种特征也在图5(a)和图5(c)中有所展示,增加数据的异质性的同时也增加了分类难度。该结果也表明,使用卷积神经网络模型能够有效的解决“同物异谱”的分类问题。

由于样地内部没有通讯信号,使用RTK 获取样地内坐标信息进行地形校正较困难,使得拼接好的无人机影像在部分起伏较大的区域出现轻微变形和空洞情况,但使用高空间分辨率的无人机影像结合卷积神经网络模型仍然取得了较好的分类结果,这与Schiefer 等(2020)和贾莉 等(2022)的研究情况一致。Schiefer 等(2020)在研究德国温带森林时表示,对比RGB 影像,使用RGB+DSM 数据仅能略微提高分类精度,他认为这可能是因为高度信息以阴影和光照差异的形式已经包含在RGB影像中。贾莉 等(2022)使用Landsat 8 OLI 30 m影像,结合GDEM_V2 30m 地形数据,也发现对森林地类精细的划分下地形校正未能提高U-Net分类器的分类精度。由于地形起伏所造成的影像差异可能以其他的方式学习到模型中,这也充分说明了卷积神经网络模型在森林起伏环境下的泛化能力。本研究充分利用了卷积神经网络中端到端的学习能力,结合使用消费级无人机获取的可见光影像,验证了CNN 能够在复杂的森林生态条件下进行川西亚高山针叶林植被分类的潜力。

5.2 卷积神经网络模型

随着深度学习的不断发展,大量的研究表明CNN优于浅层机器学习方法,能够非常有效的从遥感图像中提取广泛的植被特征,甚至能够提高我们对于植被遥感信号的理解(Kattenborn 等,2021)。这是因为CNN 通过大量的输入数据,在不同的空间尺度上进行连续变化,学习图像的空间特征,如边缘信息,纹理信息等抽象信息,从而能够准确的描述目标的类别和数量。

对于高光谱数据来说,由于其数据高纬度的特性,多用于3D-CNN 模型进行处理;而对于可见光数据,大多使用二维CNN 模型进行处理。而U-Net模型是一种端到端的学习方法,不需要过多的预处理步骤,在小训练集的情况下也能够得到不错的分类效果,同时考虑到研究区植被郁闭度较高、具有复杂的生态条件和地形情况,所以选取了U-Net模型进行植被分类。

植被指数作为地表植被状况最有效度量之一,随着无人机可见光影像的不断发展,无人机可见光指数也越多越多的被提及和使用(汪小钦 等,2015)。戴鹏钦 等(2020)使用融合VDVI和ExGExR 两种植被指数的FCN 方法提高了无人机影像的树种分类精度,然而更复杂的模型也需要更多的数据预处理步骤和模型处理时间。由于本研究主要讨论空间分辨率和裁剪尺寸对深度学习模型分类精度的影响,所以并没有添加可见光植被指数进行模型实验。

5.3 尺寸大小

由表1可见选择合适的裁剪尺寸大小能够提高模型的分类精度。尺寸为256×256像素的训练模型与尺寸为128×128 像素、512×512 像素的训练模型相比,模型总体精度高10.91%、4.32%,Kappa 系数高0.14、0.06。尺寸为128×128 像素的模型精度最低,而尺寸为256×256 像素的模型精度比512×512 像素的模型精度略微提升,这可能是因为较大的尺寸能够增加CNN 的视野,使得模型获得更多的空间上下文信息,从而提高模型的准确性;而过大的尺寸大小可能会影响映射输出的空间粒度,从而降低模型的学习能力。

在尺寸模型中,岷江冷杉的生产者精度和用户精度都在88%以上,落叶乔木在256×256 像素的模型与512×512 像素的模型中精度较高,在128×128 像素的模型中精度最低,PA 为82.45%,UA 为80.80%;落叶灌木和其他植被在128×128 像素的模型中精度最低。对于覆盖范围大的植被类型来说,尺寸大小对于训练模型的精度影响不大;然而对于植被覆盖范围小的植被类型来说,特别是落叶灌木,尺寸的大小对模型的精度影响很大,这可能与分类目标的覆盖度和尺寸有关。因为低覆盖度的植被在小切片上容易丢失上下文信息,并且由于落叶灌木的分布比较零散,更加剧了这一现象。而岷江冷杉为研究样地的优势树种,并且树冠直径适中,在实际距离为6.4 m、12.8 m 和25.6 m的尺寸下获得不错的分类精度;落叶乔木树冠则比岷江冷杉较大,在低尺寸下的分类精度则一般,在较大尺寸下分类精度得到明显提高。所以,我们在进行图像裁剪时,要根据待分类目标的尺寸大小和覆盖度选取合适的裁剪尺寸,这会更好的发挥CNN的模型能力,提高分类精度。

5.4 空间分辨率

由表2 发现随着空间分辨率的升高,训练模型的分类精度逐渐提升。当空间分辨率从5 cm 降到20 cm 时,模型的总体精度从93.21% 降到72.20%,Kappa 系数从0.90 降到0.61,各类别的分类精度都呈现大幅度降低的情况。这可能是较高的空间分辨率能够提供更多的空间特征,如纹理信息、边缘信息等,低分辨率使得模型无法获得更多的深度信息,导致模型效果变差。林志玮 等(2019)对比不同航拍高度的影像分类结果,也发现随着航拍高度的上升,分类的正确率呈现下降的趋势。

在15 cm 空间分辨率的模型中,落叶灌木精度最低,PA 为72.12%,UA 为79.79%;落叶乔木PA为78.42%,UA 为78.01%;而在20 cm 空间分辨率的模型中,落叶乔木精度最低,PA为65.31%,UA为66.67%,落叶灌木的PA为68.93%,UA为69.61%,这是因为在丢失了较多的空间细节后,落叶乔木与岷江冷杉容易混淆,导致分类精度降低。然而,从整个模型精度走势来看,落叶灌木受分辨率影响最大,在低分辨率模型中分类精度一直呈现较低的状态。

在空间分辨率模型中,较高分辨率的模型之间精度相差不大。当空间分辨率从10 cm 升高到5 cm时,总体精度从90.90%提高到93.21%,Kappa系数从0.87 提高到0.90,模型的分类精度并没有明显提升。这说明当空间分辨率到一定精度时,地物的类内差异性和类间变异性达到一个平衡,模型精度的提高受空间分辨率的影响会变低。我们可以这样认为,影像的空间分辨率要根据待分类地物的特征和类别数量进行选择;盲目追求过高的空间分辨率并不一定能带来模型分类精度上的提升,反而会降低无人机的作业效率,要求更高的存储空间,增加更多的模型计算。这些发现更加强调了,与卫星影像和机载数据相比,无人机获取的高分影像数据结合CNN 在林业树种精细识别和分类方面能够有巨大的应用空间和潜力。

6 结论

本研究使用消费级无人机对复杂生态场景下的川西亚高山针叶林获取可见光影像数据,建立不同分辨率、不同裁剪尺寸下的森林指纹库;并基于卷积神经网络构建深度学习模型进行植被分类,对比了不同分辨率和不同尺寸下的分类精度,并且对不同情况下的分类结果进行了分析,主要结论如下:

(1)结合无人机可见光影像和U-Net模型进行复杂生态场景下的川西亚高山针叶林植被分类,在5 cm 分辨率和256×256 像素的尺寸下获得总体精度93.21%,Kappa 系数为0.90 的高精度分类结果。本研究也证明了该模型在复杂生态场景下的适应性和可移植性,同时也放宽了森林数据获取的质量要求,有利于森林树种影像的获取和森林指纹库的建立与共享。

(2)根据待分类目标的尺寸大小和覆盖度选取合适的裁剪尺寸,能够让卷积神经网络获得更多的上下文信息,提高分类精度。低覆盖度和较小尺寸的植被类别在小尺寸的模型上精度较低。

(3)随着空间分辨率的升高,训练模型的分类精度逐渐提升,但当在空间分辨率达到一定程度时,模型的分类精度并没有明显的提升。因此,模型的空间分辨率要根据待分类地物的类内差异性、类间变异性及类别数量进行选择,盲目追求过高的空间分辨率是不可取的。

(4)对于区域内代表性不足的植被类型来说,受空间分辨率和尺寸大小的影响要远高于区域内优势树种,特别是空间分辨率的影响最大。

本研究证明了在复杂的生态环境下,使用卷积神经网络对高空间分辨率的无人机可见光影像进行川西亚高山针叶林植被分类是有效可行的,并且研究了不同尺寸和不同空间分辨率下对模型精度的影响,给林业工作者对森林植被分类与识别的研究进行提供借鉴。同时,建立了以川西亚高山针叶林为研究对象的森林指纹库,能够满足不同尺度下的森林研究,这点对于植被分类,尤其是在区域性的森林研究有着重大的意义。在未来的研究中,要更加考虑研究区域的物候性特征,收集多季节影像增加模型的泛化能力;还要应该进一步考虑种间类型的差异,进行实地考察搜集复杂环境下的落叶乔木树种信息,细化植被分类的类别。