关于AI算法在音乐生成中的新视角

2023-12-28程丹蕊

程丹蕊

摘 要:随着AI技术的快速发展,如何在音乐创作中应用AI技术已经成为一个新兴前沿的研究领域。本文以研究AI算法技术为核心,分析AI算法技术中的监督神经系统(RNN、LSTM)与无监督神经系统(GAN、VAE)等模式。同时结合已有的AI音乐应用研究背景,探讨计算机在交互音乐与AI音乐中的角色,旨在思考音乐AI与音乐创作主体的关系,作曲家未来的创作视角,以及音乐AI领域下音乐生成模式的发展方向。

关键词:AI;神经网络;音乐创作;交互音乐

中图分类号:J614文献标识码:A文章编号:2096-0905(2023)33-0-03

21世纪以来,AI音乐是一个新兴的研究领域,已逐渐应用于实践。从Lejaren Hiller的《伊利亚克组曲》到谷歌的Magenta Studio和Open AI的MuseNet和Jukebox音乐生成网络模型,AI音乐涵盖多种流派和艺术家风格,并可应用于广告、游戏、电影等媒体。国内也有一些AI音乐创作软件,如上海音乐学院的音虫和网易天音的智能音乐创作工具,为音乐创作领域注入了新的活力。

目前,AI算法已广泛应用于音乐创作领域,AI技术辅助作曲备受关注。然而,AI是否会取代人类作曲家仍是一个备受关注的问题。人们对于人类作曲思维和创作空间是否还存在的讨论仍在进行中。人类是在影响计算机,还是计算机学习有限的人类知识,最终替代作曲家的创作方式?这是一个充满未知的领域。

一、由交互音乐到AI作曲

(一)计算机技术在交互音乐中的角色

20世纪60年代,音乐创作经历了革新,磁带录音和数字音频技术的发展使数字信号处理(DSP)在音乐中得到广泛应用。均衡器、压缩器、混响器和延时器等音频处理器和效果器改变了声音的音色和效果。数字信号合成器创造了电子声音,与传统乐器不同的是,可以使音乐创作更加多样化。计算机改变了音乐的形式,创造出新的音色和空间音响效果,为作曲家提供更广阔的创作方法和想象空间。20世纪90年代末,法国IRCAM音乐工作站推出了实时音频处理的人机交互系统,后来发展为具备实时音频合成和信号处理功能的MAX/Msp系统平台。

计算机在交互音乐中扮演虚拟乐器的角色,作曲家通过程序控制的素材实时触发并形成新的声部。计算机的乐谱跟踪器可以追踪演奏者的音频信息,实时控制数字合成算法,将演奏者的声音素材转换成电子音乐部分。这种方式开辟了音乐创作的新方向,对即兴演奏和创作产生影响。

这些科技的发展革命性地改变了音乐创作模式,为作曲家提供了更多的创作空间。然而,虽然计算机在音乐创作中发挥了重要作用,但它并没有完全取代人类作曲家的创作能力和创作思维。人类作曲家仍然具有独特的情感,能够创作出富有个性和深度的音乐作品。因此,AI音乐的发展并不意味着人类作曲家将被取代,而是为他们提供了更多的工具和资源,丰富了音乐创作的可能性。

(二)计算机语言在AI音乐中的角色

在交互音乐创作中,人机交互和计算机技术的发展为作曲家带来了全新的创作手法[1]。计算机可以模仿作曲元素,如音高、旋律、节奏等,通过程序语言实现音乐创作。这引发了一个问题:是人类在创作音乐,还是计算机在创作音乐?

计算机强调程序、公式和运算规则,通过将作曲元素转换为程序语言,实现对这些元素的模仿。作曲元素包括音高、旋律、节奏、调式、调性、和声、曲式结构、复调等,它们构成了音乐的基本组成部分。这些元素以数据化的形式被电脑学习,从最早的调性音乐到后调性音乐,音乐的风格逐渐从具体可感的纯听觉艺术转向抽象思辨的非纯听觉艺术[2]。音乐创作中的调性和乐音不再是单一的主体,人类对声音想象的扩张和艺术样式的拼贴创造挑战了传统创作手法的地位。音乐与音响元素的重新组合、拼贴和交融成为新时代创作的主导趋势。

在物理声学和电子技术的推动下,人们更加关注声音和音响结构,音乐内容与音频技术紧密相交,为计算机算法提供了技术基础。这些数据化的作曲音乐元素被量化、拆解、归类和统一,形成了计算机的程序语言,并通过学习和迭代更新。音乐的流派每次革命性的突破都挑战旧有的理论框架,人们的反叛、挑战和追求使音乐审美标准瓦解,产生新兴的音乐体系。因此,AI为音乐创作提供了新的工具和资源,但人类作曲家的创造力和创作能力仍然是不可替代的。作曲家在创作时需要考虑如何结合人机交互和个人创作视角,以创作富有个性和深度的音乐作品。

二、AI技术与音乐创作

(一)算法技术表征

AI作曲算法,从机器学习到深度学习,首先需要了解的是数据表征。这涵盖了音频域与象频域,通常包括MIDI消息、钢琴卷帘、ABC标记、Music XML与MEI。作曲家运用乐谱来谱写音乐,而计算机用数据表征来表示音乐。这些格式和语言构成了音乐与计算机之间的桥梁,计算机通过数据表征来识别音乐中的音高、节奏、时值、响度等,从而形成乐谱。

(二)主流算法生成模式

音乐中的机器学习起源可以追溯到20世纪末和21世纪初。这期间,计算机科学、AI和音乐学领域的交叉研究开始涌现出许多关于如何利用计算机技术来理解、模拟和生成音乐的想法。直至2010年代,深度学习作为机器学习的一个分支,其神经网络得到了显著的发展,在音乐创作中的应用主要分为监督神经系统和无监督神经系统两大类型。

1.监督神经网络

神经网络是一种模拟人脑神经元连接结构的训练模型,在音乐创作中被广泛应用。监督神经網络可以通过训练学习生成具有特定音乐特征或风格的音乐。常见的监督神经网络模型包括循环神经网络(RNN)、卷积神经网络(CNN)和长短时记忆网络(LSTM)等[3]。

前馈神经网络(FNN)是一种没有反馈连接的模型,信息流是单向的。在音乐生成中,研究团队使用FNN模型开发了一个迷你巴赫合唱对位伴奏符号音乐生成系统,用于生成“巴赫式”四声部音乐。然而,由于FNN模型的确定性,相同的旋律总会产生完全相同的伴奏,限制了生成音乐的多样性和复杂性。

虽然前馈神经网络在音乐创作中的应用可以通过FNN模型展示,但在满足音乐创作的多样性和复杂性方面存在局限性。未来研究还需要探索更灵活和具有创造性的模型,以实现音乐创作中多样性、内容变化、表现力增强、旋律与和声更丰富、一致性、递增性、交互性和可解释性等目标。

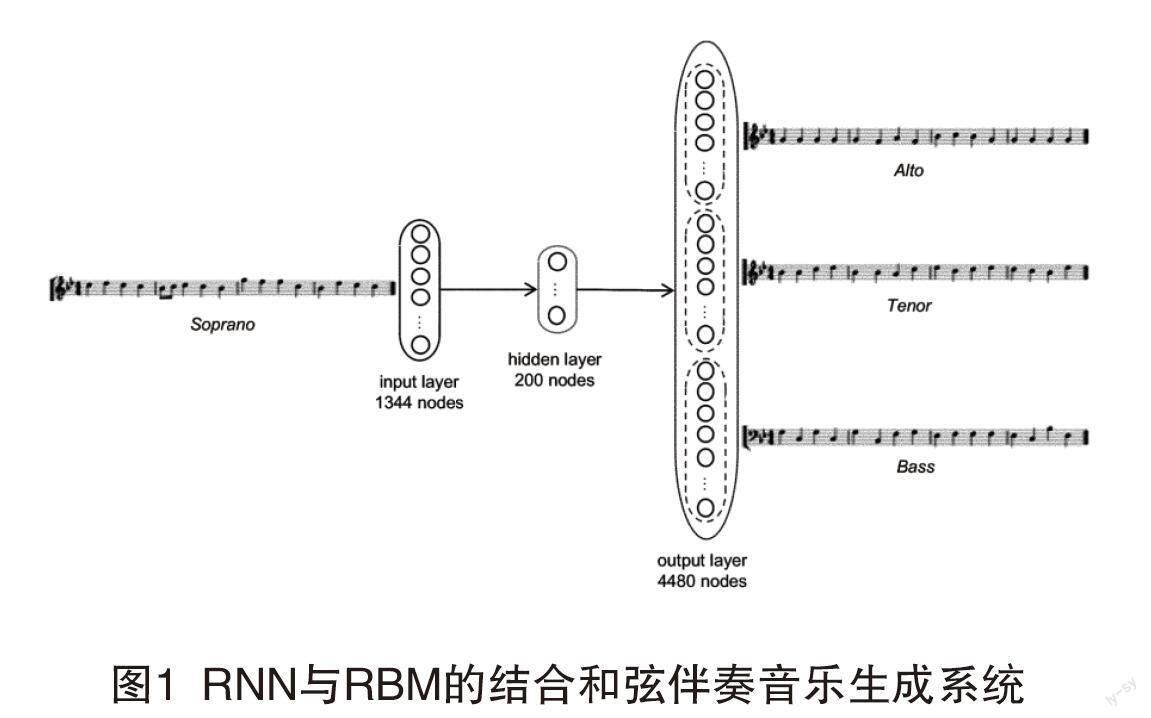

神经网络模型的升级包括RBM基础和弦音乐生成系统和BLSTM和弦伴奏音乐生成系统,如圖1。它们用于建模多声部音乐,提高由单声部音频转录至多声部的能力。然而,这些系统存在一些限制,需要明确的语料库作为输入,并在固定的音乐框架下生成音乐。此外,深度学习方法缺乏可解释性,难以使人类参与到机器创作的过程中。

为了解决这些问题,需要进一步研究和发展新的方法。这些方法应该更好地平衡机器生成的约束性和艺术家的创造性,提高可解释性以促进更深层次的合作。在机器创作的过程中,人们希望获得更多的自然性、创造性和对音乐结构的敏感性。

2.无监督神经网络

无监督神经网络是一类不需要标签或目标输出进行训练的神经网络。在音乐创作中,无监督学习模型可以从未标记的音乐数据中提取重要信息,降低数据复杂性,并保留关键的音乐特征。这种方法在音乐聚类和分类方面表现出色,有助于发现音乐中的不同风格、流派或模式。

无监督学习还支持迁移学习,即将从一种音乐风格中学到的特征应用于另一种音乐风格的创作。常见的无监督神经网络模型包括自编码器、生成对抗网络和变分自编码器。

音乐变分自编码器的一个典型例子是MusicVAE,它是一个多声部分层符号音乐生成系统。该系统利用变分循环自编码器(VRAE)的架构,包含编码器和解码器。它能够从MIDI文件中提取不同类型的音乐示例:2-16小节长的单音旋律、鼓组模式以及包含三个不同声音的16小节长的三重奏序列,如图2,并通过分层建模考虑不同层次的音乐元素,如旋律和鼓组模式,以生成更富有多样性和层次感的音乐。

使用神经网络的目标是协助作曲家提高创作能力,而不是完全取代他们进行自主创作。因此,在评估音乐生成系统时,作曲家的满意度是一个重要的评估标准。为了建立更深度和系统的音乐创作支持系统,我们还需要考虑环境、历史和文化背景等因素。

除了监督和无监督学习模式,半监督学习和强化学习模式也可以应用于音乐生成。半监督学习结合了监督和无监督学习的元素,以更全面地利用数据。在音乐生成中,半监督学习可以解决数据稀缺或标记成本高昂的问题。它通过使用带有标签的复杂数据进行监督学习,然后使用无监督学习方式对未标记的数据进行预测,并将置信度较高的预测结果添加到训练集中。通过重复和更新这个过程,可以优化模型以不断实现音乐生成的目标。

综上所述,将作曲家的满意度作为评估标准,并结合不同的学习模式,包括半监督学习和强化学习,可以建立更有深度和系统的音乐创作支持系统,以提高音乐生成的质量和多样性。

(三)作曲中的算法生成模式分析

在作曲创作过程中,有四个重要的理论元素,包括和声、曲式结构、旋律与肢体、配器。不同的理论组织可以搭建更匹配的神经网络运作模型,以实现更高的生成准确度。其中,最具挑战性的是音乐流派的转移。这要求模型能够理解并捕捉每个音乐流派独特的风格。解决这个问题的关键在于建立一个能够适应不同流派特征的神经网络架构,以便有效地处理各种音乐生成任务。

在音乐生成领域,深度学习模型取得了一系列的进展。在旋律生成方面,谷歌的Magenta Melody RNN模型、DeepBach模型和MusicVAE2模型等都具有代表性。这些模型能够生成具有特定风格的旋律。和声生成方面,巴赫涂鸦模型使用椰子模型为给定的巴赫风格旋律生成伴奏,提高了和声的质量。在配器方面,MMM模型可以根据预定义的乐器音色特征生成旋律内容。然而,模型仍面临模式不符合人类作曲过程的挑战。这些研究是为了提高生成音乐的质量并解决特定问题,如和声生成的挑战和多乐器模型的限制。未来的研究需要进一步模拟人类创作的复杂性和灵活性。

三、结束语

音乐与科技的不断交融,AI在音乐创作中将会占据更多的话语权,作曲家更需要思考如何利用与结合AI技术与创作,将之视为一种“辅助创作工具”,并将其与自身创作思维的延伸结合,而非以绝对论是或否定义AI音乐的发展。这意味着发展方向应是更好地让作曲家与技术人员合作,建立组合形式的深度学习模型,形成从头开始生成的高创意音乐形式,并构建作曲家能与AI交互的交互模型。而AI一方面可以快速掌握清晰的具有高度规则化和程序化的音乐元素,高速发展模型,但人类的音乐情感,涉及美学、心理学、哲学这些人文因素,是机器算法短期无法跨越的鸿沟。还有更多未解决的问题不在本文的讨论范围之内。比如,如果神经网络是用有版权的音乐训练的,那么谁拥有由深度学习生成的音乐的知识产权,以及如何发展与输入不相似的音乐生成系统等。

最后,在流派的创新方面,一开始总面临着无秩序和挑战。因此,在研究前沿技术的同时,作为作曲家同时需要审视我们作为音乐创作主体,什么创作部分是需要坚持的。这种审视是有必要的,以确保在AI音乐创新中保持传统创作中不可替代的核心内容,并在新技术的推动下找到创新与传统的平衡点。

参考文献:

[1]范翎.关于交互式电子音乐分类方法的思考[J].南京艺术学院学报(音乐与表演),2020(02):108-115.

[2]贾达群.后调性音乐音高组织发展引论[J].音乐研究,2022(02):63-70.

[3]陈世哲.浅谈人工智能技术在音乐创作中的应用[J].音乐探索,2020(01):125-132.