生成式人工智能滥用恶用的安全威胁及对策建议研究

2023-12-15国家信息中心王晓冬李木子

文 |国家信息中心 王晓冬 李木子

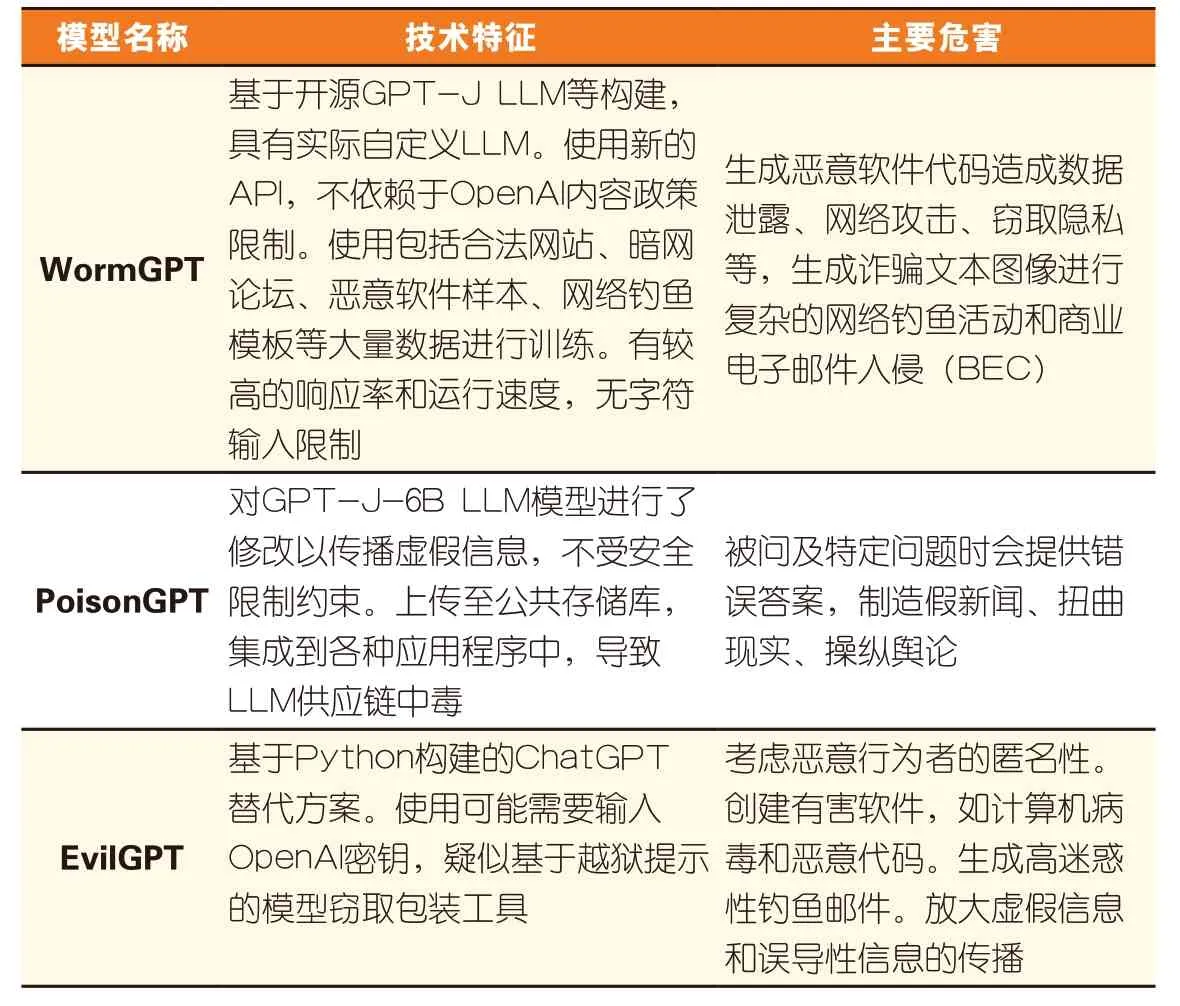

以ChatGPT为代表的生成式人工智能(AIGC)给人类社会带来了巨大的技术红利,为第四次工业革命提供了新动能。但也逐渐暴露出一系列安全风险。尤其是2022年下半年以来,涌现出WormGPT、PoisonGPT、EvilGPT等一批恶意人工智能大模型,给AIGC的安全治理带来了新的严峻挑战,亟待未雨绸缪,加强治理。

一、生成式人工智能滋生了恶意大模型的新威胁

生成式人工智能滋生了一批恶意人工智能大模型。恶意人工智能大模型是指由非法组织或不法分子操纵,借助开源模式模仿ChatGPT等合法模型,基于有害语料库训练而生滋生的、专门用于网络犯罪、诈骗等非法行为的一类非法大模型。恶意大模型与人工智能的滥用还不尽相同,其产生的直接目的就是用于各类非法行为,主要运行于暗网,具有更强的隐蔽性、危害性,形成了“人工智能+犯罪”新治理挑战,对国家安全、行业创新、生产生活等方面造成危害。

表1 恶意人工智能聊天机器人典型代表

(一)对维护国家安全提出新挑战

滥用、恶用AIGC给国家政治和军事带来了新的安全挑战。一是在意识形态安全方面,AIGC在数据投喂、算法训练等环节易受到核心技术掌控方操纵,出现污染投毒和算法偏见等问题。可能成为西方国家对华“认知战”的新工具。二是在技术自主可控方面,霸权国家主导AIGC标准制定,技术相对弱势的国家可能盲目大规模进行产品使用和追随开发,出现因科技封锁和贸易制裁等遭遇“卡脖子”危险。三是在国防军事安全方面,AIGC提高了作战人员、武器和指挥信息系统的智能交互水平,对历史战况和现实情报通过先进算法进行快速推演分析,提升打击精度和反应速度。美国军方在2023年已开始利用AIGC撰写国防咨询报告,并成立Lima工作组在五角大楼评估、整合和使用该技术。

(二)对行业应用创新造成新冲击

滥用、恶用AIGC给产业和行业发展带来了新的安全冲击。一是在教育就业方面,各种AIGC产品总体内容质量仍良莠不齐,容易出现创作的“劣币驱逐良币”现象。利用AIGC辅助完成课业和学术研究减少了必要的批判甄别和分析研究过程,会产出更多虚假信息和学术垃圾。二是在产业转型方面,大部分传统行业数字化转型进程仍较为缓慢,对于正确运用AIGC收集、处理数据,并将其应用于研发、生产、销售等各环节的意愿和能力尚且不足,大规模盲目引入AIGC可能会适得其反。

(三)对生产生活方式带来新威胁

滥用、恶用AIGC给企业经营和个人生活带来了新的安全威胁。一是在企业经营安全方面,易出现数据合规风险、版权侵权、商业秘密泄露等问题。使用AIGC的分析决策黑盒、专业化团队培养、投资预算等问题也会对企业的平稳运行造成困难。二是在个人使用安全方面,山寨版GPT不断涌现,相关域名注册和盗用暴涨,频繁向用户索取信息授权,服务质量差,跑路风险高。AIGC还可绕过邮件过滤和防病毒软件等传统安全措施,生成低成本、个性化的网络钓鱼软件和虚假广告。

二、生成式人工智能安全治理难点

(一)包容审慎存在失衡,政策尺度有待细化

AIGC是一个新生事物,其发展规律还未完全明晰,包容审慎的政策尺度和平衡点较难把握。一方面,目前AIGC安全治理政策在适应数字时代新型商业模式和秩序框架,鼓励新业态自主创新、资源共享、国际合作等方面还有待健全完善。另一方面,在AIGC政策具体实施层面还存在市场形势判断难、干预时机决断难、责任主体划分难等难点,市场主体开展安全可信技术创新激励和容错措施尚未制度化。包容审慎监管试点较少,对拟实施或已实施的监管产生的积极影响和消极影响进行评估的监管影响分析程序重视度不够,科技伦理治理公共服务平台有待建设。

(二)协同治理能力不足,联动合力有待提升

人工智能技术加速和深化了跨部门的数据共享、流程再造和业务联动。跨部门协同监管仍存在信息孤岛、职责孤岛,人工智能立法存在困境。AIGC市场主体间竞争态势强、利益冲突多、合作意愿弱,数据、技术、人才等资源的共享壁垒高,参与标准制定意愿较低,相关开源社区的建设和技术创新生态布局迟缓。

(三)监管手段相对滞后,技术赋能有待加强

“以技术管技术、以技术治技术”的监管治理体系尚不健全。在伦理安全层面,深度伪造技术层出不穷,而检测算法的泛化性、健壮性等还有待提升。在算法安全层面,算法安全内生机理、风险评估、全生命周期安全监测等关键技术支撑还需进一步加强。在数据安全层面,数据安全监测预警技术有待创新,数字贸易跨境监管仍有进步空间。非现场、物联感知、穿透式等新型监管手段运用不够充分,监管智能化水平有待提升。

三、生成式人工智能安全治理对策建议

(一)健全制度规则,提升政企协同治理能力

1.政府发挥规范引导指挥棒作用

一是加大查处管控和宣传教育。实行包容审慎和分类分级监管,监控查处非法使用和传播恶意AIGC行为,管制违规账号。二是健全技术规范和评价标准。制定AIGC预训练和优化训练数据、标注、数据分类分级保护等方面的国家标准,以及深度伪造、智能群呼设备等高风险AI技术的使用规范。三是完善法律体系和制度框架。采用安全港等机制处理内容责任归属问题,加强和改进反垄断和反不正当竞争执法。探索我国数据存储体系优化,构建数据被动出境的主动防御体系,建立跨境数据流动规则和白名单等机制。

2.相关企业强化责任与安全意识

一是保障内容安全可信。采用人机审核相结合的方式弱化和删减不当内容,对AIGC进行显著标识,提供使用和退出服务简明的解决方案。考虑采用时间戳、哈希值校验、电子签名等技术手段为AIGC提供溯源与认证,主动向使用统一的AIGC数据标准或元数据标准靠拢。二是完善安全制度流程。抓取开放数据应遵循合法、正当和必要原则,敏感信息进行脱敏处理,企业内部针对不同的岗位和职级设置数据权限。设定高奖励额度的“漏洞悬赏计划”。三是配合安全监管检查。严格遵从开源许可协议规定行使开源软件的复制权、修改权、发行权。主动向主管部门申报安全评估,履行算法备案和变更等手续,提升服务透明度。对于机密程度高、创新要求高的技术密集型产业,例如军工、航天、芯片等行业在使用AIGC过程中要着重进行审慎评估和内查外纠。

(二)加强技术创新,健全安全治理技术体系

1.完善人工反馈的强化学习机制

注重对人工反馈的强化学习机制(RLHF)的优化。从与训练语言模型、收集数据并训练奖励模型、强化学习微调语言模型等阶段,降低数据成本、优化算法、改进微调策略,防止被某些策略绕开而产出不当内容,使模型与人类需求对齐。自动化调用模型知识,进一步降低对大规模高质量人工标注数据的依赖。

2.加强模型安全技术研究及应用

一是部署数据和模型安全防御。通过优化鲁棒训练算法应对数据投毒,采取截断混淆、差分隐私等手段使模型隐私信息模糊化,采取模型水印、模型指纹等溯源手段保障知识产权专有性。二是做好各类接口安全性设计。采用身份验证、日志监控、网关等技术手段加强API和网页端接口的安全防范管理。使用VPN等加密通道传输数据,部署抵御DdoS的工具,使用嗅探器等检测安全问题并跟踪数据泄露。三是分析研究新型LLM。探索利用人工智能工具逐步实现自动化对抗恶意AIGC,进而用大模型“对抗”大模型。

(三)优化监管手段,提升智能治理监管能力

一是完善内容分类筛选机制。完善内容分类、滥用模式捕获、人工评审决策和通知用户机制,并增强对非英语语言的支持。二是强化生成内容检测技术。通过实时聚类、特征库匹配等强化文本检测技术,依托生理信号特征、GAN图像特征、数据驱动等强化深度伪造检测技术。三是拓展监管工具场景应用。探索智能化监管手段,例如数字沙盒、隐私护盾等与相关行业企业对接。

四、结语

本文对AIGC滥用恶用的安全治理进行了研究。归纳了滥用恶用AIGC对国家安全、行业创新、生产生活等三方面威胁,总结出AIGC政策尺度有待细化、联动合力有待提升、技术赋能有待加强等难点。最后,从健全制度规则、加强技术创新、优化监管手段等方面提出对策建议,对促进AIGC规范应用和健康发展具有重要启示作用。