级联融合边缘特征的高分辨率遥感影像道路提取

2023-12-14李佳优董琰郭俊陈芸芝

李佳优 董琰 郭俊 陈芸芝

摘 要:针对进行高分辨率遥感影像道路提取时常出现的识别错误和提取结果断裂等问题,提出一种级联融合边缘特征和语义特征的ACEResUNet多任务融合模型。该模型通过边缘检测任务进行道路边缘特征自动化提取,将其与改进的ResUNet模型对应的卷积单元进行特征级联融合,为语义分割道路训练提供更多的决策依据,提升道路提取结果的连通性。通过在各模型特征提取单元中引入交叉压缩注意力模块,提升模型的特征提取能力,并在改进的ResUNet模型的编解码器之间添加全局多尺度特征融合模块,获取不同尺度目标地物的全文特征信息,以提升道路最终提取结果的完整性。在DeepGlobe道路数据集上的实验结果表明,该模型的道路提取精确率和交并比分别达到了0.798和0.661,相较于VNet和ResUNet等经典模型均有提升。

关键词:道路提取;模型融合;多任务;高分辨率遥感影像;边缘检测

中图分类号:P237

文献标志码:A

近年来,随着高分辨率遥感影像的不断发展,其逐渐被广泛应用于地物提取、国土资源调查、变化检测和灾害评估等多个领域[1]。在进行高分辨率遥感影像道路提取时,由于光谱信息混淆及树木等障碍物对道路的遮挡等问题使道路提取结果经常出现漏提、断裂现象。因此,如何在众多复杂背景信息的干扰下,将道路有效、完整、准确地提取出来成为目前的研究重点。随着深度学习技术的发展,卷积神经网络(convolutional netural network,CNN)[2]因其能获得不同层次的特征结构,并从复杂抽象的特征中进行自动化分析与处理,使其在影像信息处理方面获得广泛的应用。如刘笑等[3]应用全卷积网络进行遥感影像道路提取,实现了端对端的训练。RONNEBERGER等[4]提出了U-Net模型,实现了多层特征压缩提取和由深到浅的逐步特征恢复以进行目标特征输出。在此基础上,结合残差学习[5]的思想,ZHANG等[6]提出了ResUNet模型,使得提取结果的召回率提升。李智等[7]则利用深度残差模型进行医学图像的特征信息提取。孙若钒等[8]在SqueezeNet[9]中引入残差网络,在提升准确率的同时压缩了参数,提高了整体效率。ABDOLLAHI等[10]引入一种新的卷积神经网络VNet进行道路提取,该网络结合残差网络和5×5卷积来提升模型的性能。陈振等[11]提出DAFCRes-UNet模型,通过增加轻量级的双注意力和特征补偿模块实现模型在性能和时空复杂度上的平衡。ZHOU等[12]在LinkNet[13]模型的基础上添加了膨胀卷积[14],通过级联和并行2种模式的膨胀卷积来增加模型的感受野,提高模型对道路细节特征的表示能力。但随着单一模型的不断改进,结构变得愈发复杂,常需要耗费大量的计算,且泛化能力较差,因此多任务学习[15]的思想被人们广泛关注。如陈嘉浩等[16]通过融合级联全连接条件随机场(fully connected conditional random fields,CRFs)和UNet模型进行遥感影像建筑物提取,提升模型对建筑物边界的分割能力。刘韵婷等[17]将ResNet和DenseNet网络模型进行融合搭建的RSDC-Net网络模型,提高了网络的泛化和感知能力。

地物的边缘特征可以为图像分割模型提供更多的决策依据,提升模型的分割精度。如尹昊等[18]提出EFFNet模型将分别提取的边缘特征和语义特征进行多尺度分级融合,以获取兼有较高的类间区分性和类内一致性的特征向量。赫晓慧等[19]提出VAF-Net模型,通过自适应加权方式进行边缘特征融合,增强语义分割,弥补了细节特征,实现边缘特征和语义特征的有效联合。

基于以上分析,本文提出级联融合边缘特征和语义特征的ACEResUNet多任务融合模型。该模型以边缘检测模型和改进的ResUNet网络模型进行多任务模型融合,用于在背景信息复杂的高分辨率遥感影像上进行道路提取。

1 ACEResUNet多任务融合模型

ACEResUNet模型由道路边缘检测和道路提取2个相互独立的任务模型构成,其通过边缘检测模型对输入影像进行道路边缘特征自动化提取,并将其不同层级的边缘特征与改进的ResUNet模型的下采样模块中对应的改进残差卷积单元进行特征融合,以增强语义分割训练效果,提升道路提取结果的连通性,充分实现不同特征的优势互补。ACEResUNet模型网络结构如图1所示。

由图1可知:边缘检测模型(图1下)由4层边缘特征提取单元分别进行不同层级不同尺寸的边缘特征图提取,并输出传入对应的改进的残差卷积单元。改进的ResUNet模型(图1上)为编解码结构,编码器通过特征初提部分和4层改进残差卷积单元进行特征提取和特征图压缩,编解码器之间通过全局多尺度特征融合模块来聚合多尺度的深层特征以获取全局特征信息,解码器由4层改进残差卷积单元和上采样层对编码器生成的特征图进行特征融合和還原,最后通过输出层完成道路提取。由于不同层级特征的空间维度不同,且低、高层不同特征所代表的语义信息不同,故需将其与改进的ResUNet模型编码器中相同空间维度的卷积单元由低到高进行对应层级特征融合。

1.1 边缘特征提取单元

相较于传统的sobel[20]、canny[21]算子等边缘检测算法,卷积神经网络可以对单一目标进行边缘检测,同时提取多层次边缘特征,具有精度高、边缘特征连续性强和抗干扰性强等特点。

因此本文基于丰富的卷积特征(richer convolutional features,RCF)[22]边缘检测模型的卷积特征单元,通过添加交叉压缩注意力(cross squeeze attention,CSA)模块来构建边缘特征提取单元,其具有更高性能的特征提取能力,结构如图2所示:

由图2可知:特征图传入边缘特征提取单元后,通过双卷积层初步获取边缘特征信息,在经过一维卷积后通过CSA模块充分学习重要的道路边缘特征并进行特征融合,最后通过一维卷积进行特征图融合,实现边缘特征的精细化提取。

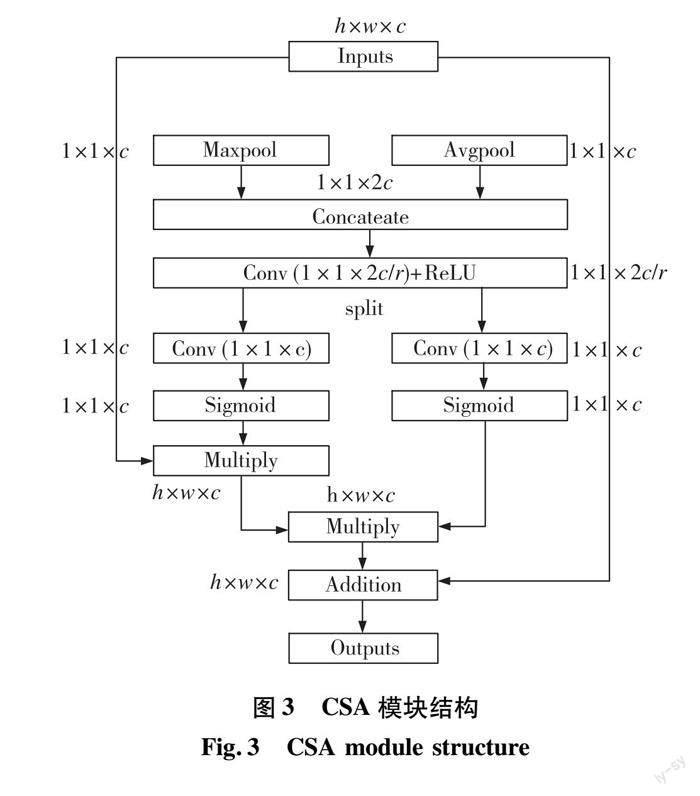

1.2 交叉压缩注意力模块

ACEResUNet模型进行训练时其特征图具有丰富的通道特征信息,注意力机制[23]可以为其不同维度的特征赋予权重,使模型在训练中更加关注重要特征,提升模型的计算效率和精度。SE注意力模块(Squeeze-and-Excation Module)[24]是一种即插即用的通道注意力,其提升了模型对于权重较高的通道特征的感应。但是SE注意力模块是通过单一的全局均值池化方式进行特征压缩,对于某些有效区域占比很小的特征图进行压缩时会产生较大的误差。因此,本文基于SE模块的实现原理,设计了CSA模块,以提升模型对不同压缩方式的通道维度特征感应,其结构如图3所示。

由图3可知:CSA模块采用全局均值池化和全局最大池化并行的双池化方式,通过对称的2条通路进行空间维度特征压缩,从而得到2个通道特征向量。利用一维卷积将2个通道特征向量进行扩通道特征交互并进行切分,充分保留不同池化方式的有效特征。切分后,通过一维卷积和Sigmoid函数进行通道维度权重赋予,将2个通道权重向量与输入特征图依次进行扩维矩阵相乘,最后将调整通道特征权值后的特征图与初始特征图进行残差融合,有效避免出现特征退化现象。

1.3 改进残差卷积单元

ResUNet模型通过将UNet模型中的卷积单元替换为残差卷积单元,解决了当模型层数较深时会出现的特征损失问题。为进一步提升模型的性能,本文在残差卷积单元的基础上引入CSA模块,形成改进残差卷积单元以提升模型特征提取能力,其结构如图4所示。

由图4可知:特征图在经过CSA模块后充分学习道路的通道分布特征,并与初始特征图进行映射跳转连接。在提升卷积单元特征提取性能的同时,有效避免深层网络退化的问题。

1.4 全局多尺度特征融合模块

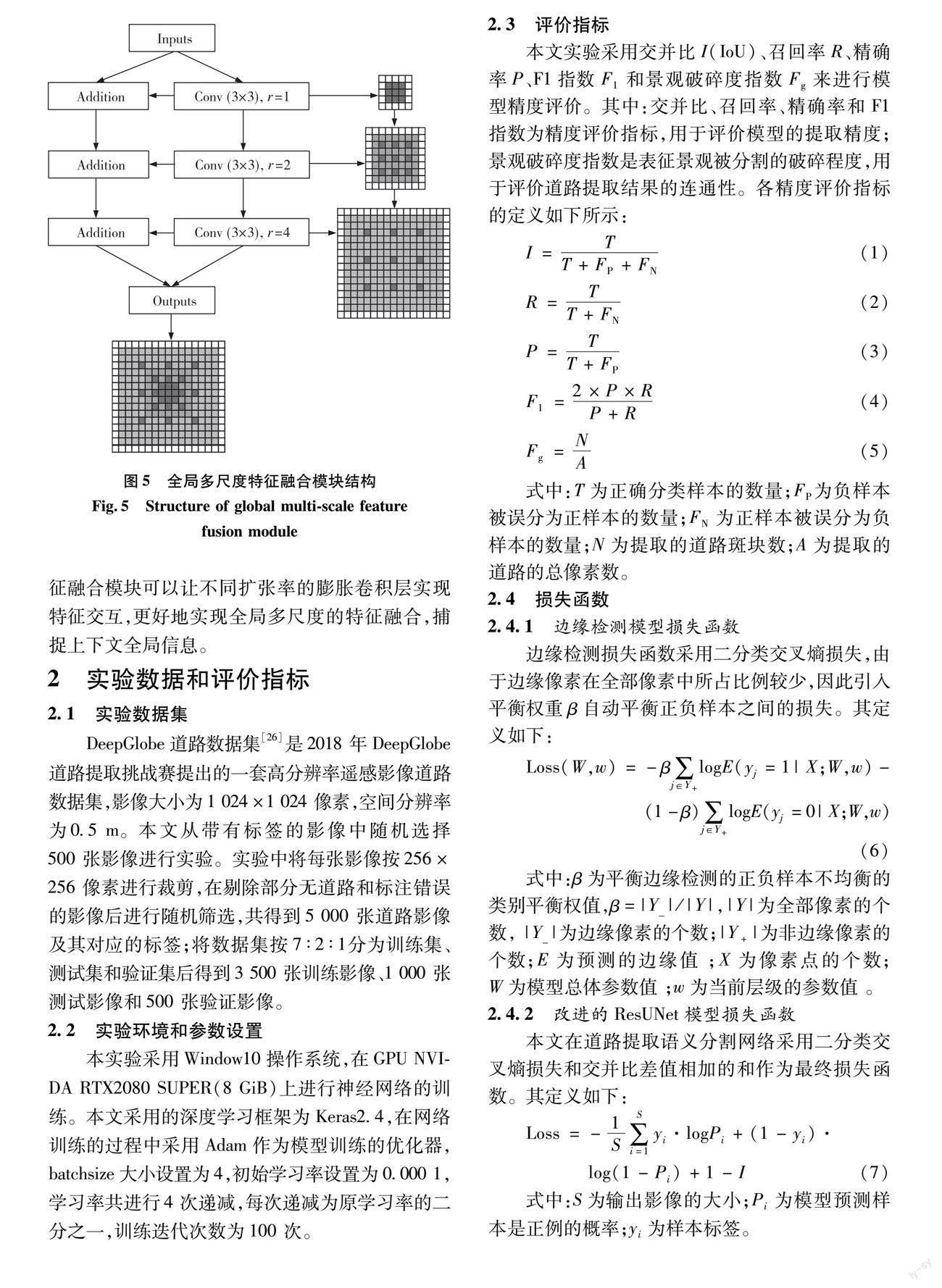

膨胀卷积[14]是一种卷积运算,通过在参与卷积计算的元素之间忽略一些空间元素,从而扩大卷积核感受野的同时有效减少特征图的分辨率损失。

特征图在经过多次下采样后分辨率会大幅降低,此时需识别的目标地物在特征图中可能仅为1个像素所表示,若再次进行特征图压缩则可能丢失目标地物特征,无法通过上采样操作进行还原。因此本文基于金字塔表达[25]的思想,在改进的ResUNet模型编解码器之间构建一个全局多尺度特征融合模块,其结构如图5所示。

由图5可知:全局多尺度特征融合模块对特征图采用1、2和4的扩张率(r)依次序进行膨胀卷积特征提取,并通过叠加融合的方式依次进行多尺度特征融合,从而获取多尺度的全局特征。相较于传统金字塔表达的并行膨胀卷积方式,全局多尺度特征融合模塊可以让不同扩张率的膨胀卷积层实现特征交互,更好地实现全局多尺度的特征融合,捕捉上下文全局信息。

2 实验数据和评价指标

2.1 实验数据集

DeepGlobe道路数据集[26]是2018 年DeepGlobe道路提取挑战赛提出的一套高分辨率遥感影像道路数据集,影像大小为1 024×1 024 像素,空间分辨率为0.5 m。本文从带有标签的影像中随机选择500 张影像进行实验。实验中将每张影像按256×256 像素进行裁剪,在剔除部分无道路和标注错误的影像后进行随机筛选,共得到5 000 张道路影像及其对应的标签;将数据集按7 ∶2 ∶1分为训练集、测试集和验证集后得到3 500 张训练影像、1 000 张测试影像和500 张验证影像。

2.2 实验环境和参数设置

本实验采用Window10操作系统,在GPU NVIDA RTX2080 SUPER(8 GiB)上进行神经网络的训练。本文采用的深度学习框架为Keras2.4,在网络训练的过程中采用Adam作为模型训练的优化器,batchsize大小设置为4,初始学习率设置为0.000 1,学习率共进行4 次递减,每次递减为原学习率的二分之一,训练迭代次数为100 次。

2.3 评价指标

本文实验采用交并比I(IoU)、召回率R、精确率P、F1指数F1和景观破碎度指数Fg来进行模型精度评价。其中:交并比、召回率、精确率和F1指数为精度评价指标,用于评价模型的提取精度;景观破碎度指数是表征景观被分割的破碎程度,用于评价道路提取结果的连通性。各精度评价指标的定义如下所示:

I=TT+FP+FN(1)

R=TT+FN(2)

P=TT+FP(3)

F1=2×P×RP+R(4)

Fg=NA(5)

式中:T为正确分类样本的数量;FP 为负样本被误分为正样本的数量;FN为正样本被误分为负样本的数量;N为提取的道路斑块数;A为提取的道路的总像素数。

2.4 损失函数

2.4.1 边缘检测模型损失函数

边缘检测损失函数采用二分类交叉熵损失,由于边缘像素在全部像素中所占比例较少,因此引入平衡权重β自动平衡正负样本之间的损失。其定义如下:

Loss(W,w)=-β∑j∈Y+logE(yj=1|X;W,w)-

(1-β)∑j∈Y+logE(yj=0|X;W,w)(6)

式中:β为平衡边缘检测的正负样本不均衡的类别平衡权值,β=|Y_|/|Y|,|Y|为全部像素的个数, |Y_|为边缘像素的个数;|Y+|为非边缘像素的个数;E为预测的边缘值 ;X为像素点的个数;W为模型总体参数值 ;w为当前层级的参数值 。

2.4.2 改进的ResUNet模型损失函数

本文在道路提取语义分割网络采用二分类交叉熵损失和交并比差值相加的和作为最终损失函数。其定义如下:

Loss=-1S∑Si=1yi·logPi+(1-yi)·log(1-Pi)+1-I(7)

式中:S为输出影像的大小;Pi为模型预测样本是正例的概率;yi为样本标签。

3 实验结果与分析

3.1 消融实验

为进一步验证ACEResUNet模型中各个模块的效果,本文使用2.3节中的评价指标在DeepGlobe道路数据集上进行了消融实验,其中Base模型为ResUNet模型,分别与CSA模块、全局多尺度特征融合(global multi-scale feature fusion, GMFF)模块、边缘特征结合进行训练。消融实验結果见表1。

从表1可知:CSA模块、GMFF模块和边缘特征的引入均对提取精度有不同程度的提升,其中CSA模块和边缘特征的引入使得景观破碎度指数均出现较大程度的减小;实验2的结果显示CSA模块的引入使得IoU指数出现明显提升;实验4的结果显示边缘特征的引入有效地降低了景观破碎度指数,充分说明边缘特征的引入可以有效提升道路提取结果的连通性;实验5的结果显示ACERes-UNet模型整体精度最高、景观破碎度指数最低,说明各模块的结合可以有效提升模型的最终性能。

3.2 各模型训练损失曲线分析

为验证模型的性能,本文在DeepGlobe道路数据集上以相同的实验条件分别对UNet、ResUNet、VNet[10]、DAFCResUNet[11]和ACEResUNet模型进行训练测试。图6是不同模型训练的Loss曲线走势图。

从图6可知:各个模型在道路数据集上训练的Loss曲线变化趋势基本一致,随着迭代次数的增加均处于稳定收敛状态;相较于其他模型,ACERes-UNet模型的Loss最低,模型的拟合效果最好。

3.3 各模型提取结果对比

为了更加直观地展示不同模型道路提取的效果,对部分道路的提取结果进行对比,结果如图7所示。

图7显示:对区域a、b的道路提取,当道路周围存在相似地物干扰或者道路界限比较模糊时,ACEResUNet模型可较为完整的提取出道路区域,其他模型则会出现不同程度的漏提、断裂等现象。对区域c、d和e的道路提取,在建筑物和树木等遮挡物密集的区域,其他模型的道路提取结果出现了较为严重的漏提现象,ACEResUNet模型则较为完整地提取出道路区域,有效提升了道路提取结果的连通性。

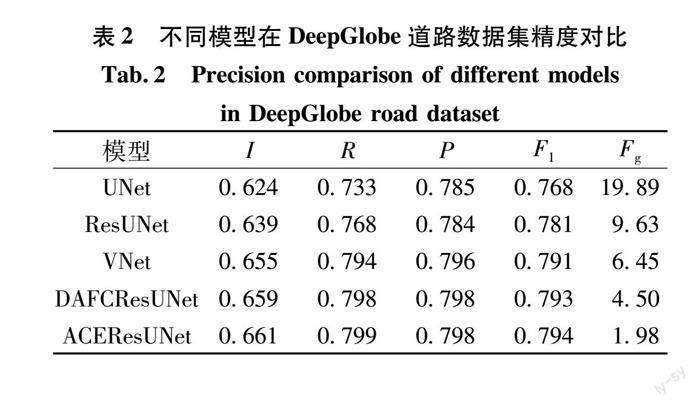

为了更加直观地验证对比不同模型的性能,使用评价指标对各模型的性能进行测试评价,结果如表2所示。

从表2可知:ACEResUNet模型的IoU、Recall、Precision和F1-score指数均大于其他模型,相较于UNet模型分别提升了3.7%、6.6%、1.3%和2.6%,相较于ResUNet模型分别提升了2.2%、3.1%、1.4%和1.3%,相较于VNet模型分别提升了0.6%、0.5%、0.2%和0.3%,相较于DAFCRes-UNet模型分别提升了0.2%、0.1%、0%和0.1%。ACEResUNet模型的景观破碎度指数最小,比其他模型依次下降了90%、79%、69%、56%。

因此,ACEResUNet模型可以在复杂的背景信息干扰下较完整地提取出道路分布区域,相较于DAFCResUNet模型,整体精度提升有限,但是景观破碎度则出现较大幅度的下降,有效地解决了道路提取中漏提、断裂等问题,提升了道路提取结果的连通性。

4 结论

1)本文提出了一种适用于高分辨率遥感影像道路提取的ACEResUNet多任务融合模型,其通过级联融合边缘特征和语义特征进行道路信息提取。边缘特征可以有效弥补图像分割中的边缘信息,为图像分割模型提供更多地决策依据,提升道路提取结果的连通性,实现语义特征和边缘特征的优势互补,有效解决道路提取中的漏提、断裂等问题。

2)CSA模块的双池化的交叉压缩方式可以最大程度保留有效区域的特征,使模型更加高效地学习不同通道维度的道路特征。全局多尺度特征融合模块则可以实现多尺度全局特征的信息交互,捕捉上下文全局信息,提升道路提取结果的完整性。

3)在DeepGlobe道路数据集上的模型测试结果表明,ACEResUNet多任务融合模型提取精度相较于其他模型具有不同程度的提高,有效降低了景观破碎度指数,使得道路提取结果较为完整,较好地完成了道路提取任务。

参考文献:

贺浩, 王仕成. 基于Encoder-Decoder网络的遥感影像道路提取方法[J]. 测绘学报, 2019, 48(3): 330-338.

[2] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Im-ageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90.

[3] 刘笑, 王光辉, 杨化超, 等. 全卷积神经网络遥感影像道路提取方法[J]. 遥感信息, 2018, 33(1): 69-75.

[4] RONNEBERGER O, FISCHER P, BROX T. U-Net: Convolutional networks for biomedical image segmentation[C]//Medical Image Computing and Computer-Assisted Intervention-MICCAI 2015: Part Ⅲ. Munich: Springer International Publishing, 2015: 234-241.

[5] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV: IEEE, 2016: 770-778.

[6] ZHANG Z X, LIU Q J, WANG Y H. Road extraction by deep residual U-Net[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(5): 749-753.

[7] 李智, 周旭阳, 殷昕旺, 等. 基于深度残差网络的医学图像鲁棒可逆水印算法[J]. 贵州大学学报(自然科学版), 2020, 37(3): 58-68.

[8] 孫若钒, 高建瓴, 陈娅先. VansNet轻量化卷积神经网络[J]. 贵州大学学报(自然科学版), 2020, 37(2): 51-56.

[9] UCAR F, KORKMAZ D. COVIDiagnosis-Net: deep Bayes-SqueezeNet based diagnosis of the coronavirus disease 2019(COVID-19) from X-ray images[J]. Medical Hypotheses, 2020, 140: 109761.1-109761.12.

[10]ABDOLLAHI A, PRADHAN B, ALAMRI A. VNet: an end-to-end fully convolutional neural network for road extraction from high-resolution remote sensing data[J]. IEEE Access, 2020, 8: 179424-179436.

[11]陈振, 陈芸芝, 吴婷, 等. 面向高分遥感影像道路提取的轻量级双注意力和特征补偿残差网络模型[J]. 地球信息科学学报, 2022, 24(5): 949-961.

[12]ZHOU L C, ZHANG C, WU M. D-LinkNet: LinkNet with pretrained encoder and dilated convolution for high resolution satellite imagery road extraction[C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Salt Lake City: IEEE, 2018: 192-196.

[13]CHAURASIA A, CULURCIELLO E L. Exploiting encoder representations for efficient semantic segmentation[C]// 2017 IEEE Visual Communications and Image Processing (VCIP). St. Petersburg: IEEE, 2017: 1-4.

[14]ZHANG J, LIN S F, DING L, et al. Multi-scale context aggregation for semantic segmentation of remote sensing images[J]. Remote Sensing, 2020, 12: 701.1-701.16.

[15]邵蔚元, 郭跃飞. 多任务学习及卷积神经网络在人脸识别中的应用[J]. 计算机工程与应用,2016, 52(13): 32-37.

[16]陈嘉浩, 邢汉发, 陈相龙. 融合级联CRFs和U-Net深度学习模型的遥感影像建筑物自动提取[J]. 华南师范大学学报(自然科学版), 2022, 54(1): 70-78.

[17]刘韵婷, 于清淞, 李绅科, 等. 基于深度学习的多模型融合图像智能检测方法研究[J]. 电子测量技术, 2021, 44(20): 168-174.

[18]尹昊, 张承明, 李剑萍, 等. 融合语义特征与边缘特征的枸杞空间分布提取[J]. 测绘科学, 2022, 47(4): 111-121.

[19]赫晓慧, 邱芳冰, 程淅杰, 等. 基于边缘特征融合的高分影像建筑物目标检测[J]. 计算机科学, 2021, 48(9): 140-145.

[20]袁春兰, 熊宗龙, 周雪花, 等. 基于Sobel算子的图像边缘检测研究[J]. 激光与红外, 2009, 39(1): 85-87.

[21]林卉, 赵长胜, 舒宁. 基于Canny算子的边缘检测及评价[J]. 黑龙江工程学院学报, 2003, 17(2): 3-6.

[22]LIU Y, CHENG M M, HU X W, et al. Richer convolutional features for edge detection[C]// 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017: 5872-5881.

[23]张越, 程春泉, 杨书成, 等. 融合双注意力机制模型的遥感影像建筑物提取[J]. 测绘科学, 2022, 47(4): 129-136, 174.

[24]HU J, SHEN L, SUN G. Squeeze-and-Excitation Networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City: IEEE, 2018: 7132-7141.

[25]喬文凡, 慎利, 戴延帅, 等. 联合膨胀卷积残差网络和金字塔池化表达的高分影像建筑物自动识别[J]. 地理与地理信息科学, 2018, 34(5): 56-62.

[26]DEMIR I, KOPERSKI K, LINDENBAUM D, et al. DeepGlobe 2018: a challenge to parse the earth through satellite images[C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Salt Lake City: IEEE, 2018: 172-181.

(责任编辑:周晓南)

Road Extraction From High-Resolution Remote Sensing Images

Based on Cascade Fusion of Edge Features

LI Jiayou1,3, DONG Yan2, GUO Jun2, CHEN Yunzhi*1,3

(1.The Academy of Digital China (Fujian), Fuzhou University, Fuzhou 350108, China; 2. Sinopec Shengli Oilfield Branch,

Dongying 257000, China; 3.National and Local Joint Engineering Research Center for Comprehensive Application of Satellite Space Information Technology, Fuzhou 350108, China)

Abstract:

Aiming at the problems of recognition errors and broken extraction results that often occur in road extraction from high-resolution remote sensing images, this paper proposes a multi-task fusion model of ACEResUNet that cascades edge features and semantic features. The model automatically extracts road edge features through the edge detection task, and fuses it with the convolution unit corresponding to the improved ResUNet model for feature cascade fusion, which provides more decision-making basis for semantic segmentation training and helps to accurately segment the road boundary. By introducing a cross-compression attention module in each model feature extraction unit, the feature extraction capability of the model is improved, and a global multi-scale feature fusion module is added between the encoders and decoders of the improved ResUNet model to obtain the target features of different scales. Also full-text feature information is obtained to improve the integrity of the final road extraction results. The experimental results on the DeepGlobe road dataset show that the road extraction accuracy and intersection ratio of this model reach 0.798 and 0.661, respectively, which are greatly improved compared to classic models such as VNet and ResUNet.

Key words:

road extraction; model fusion; multi-task; high-resolution remote sensing images; edge detection