基于深度强化学习的干扰资源分配方法

2023-12-08李健涛王轲昕张天贤

李健涛,王轲昕,刘 凯,张天贤

(电子科技大学 信息与通信工程学院, 四川 成都 611731)

0 引 言

在突防场景中,组网雷达系统通过数据融合和信息融合等协同处理方法极大的提高了作战性能,对我方突防编队产生了巨大的威胁[1-2]。伴随干扰机群通常被用于对抗敌方组网雷达系统,使其无法准确地探测目标,从而掩护我方突防飞机完成既定任务[3-4]。在日益复杂的电磁环境中,如何合理地分配干扰资源,以达到对组网雷达最大的干扰效能,是近年来国内外学者研究的热点问题。

目前,突防场景下干扰资源分配问题被广泛研究。文献[5]综合考虑突防飞机在整个突防过程中位置变化时的干扰效益,利用概率加权法建立目标函数,并采用蚁群算法求解出干扰资源分配策略。文献[6]研究了不同干扰样式在不同恒虚警检测器中的干扰效果差异,提出了一种基于二维整数编码的改进布谷鸟(ICS)算法来提高收敛速度和寻优能力。文献[7]考虑到组网雷达系统工作参数不确定性带来的检测概率误差,建立了干扰资源稳健优化分配模型,并利用粒子群(PSO)算法对模型进行求解。然而,这些研究采用的算法仍基于传统群智能算法,都采用逐帧优化的方法,运行效率低且稳定性较差。

深度强化学习(DRL)是机器学习的一个分支,其利用智能体与环境交互过程中的经验来学习使回报最大化的策略,为复杂系统的感知决策问题提供了一种有效的解决方案。近年来,深度强化学习被广泛应用于各种热门领域中,如自动驾驶、游戏AI、机器人控制等。2014年起,谷歌DeepMind团队将深度强化学习技术应用于Atari游戏中,经过训练的游戏AI超越了人类玩家的最高水平[8]。深度强化学习也被应用于自然语言处理中,极大地提高了其语义关联、逻辑推理和句式生成等能力[9]。因此,将深度强化学习技术基于到干扰资源分配问题中是一个值得研究的方向。

本文提出了一个基于深度强化学习的干扰资源分配方法。首先,建立一个突防场景下的干扰资源分配模型;其次,将干扰资源分配模型描述为一个马尔可夫决策过程,设计相应的状态空间、动作空间和回报函数;最后,针对模型在多维约束情况下难以求解的问题,提出了基于动作密钥编码的双延迟深度确定性策略梯度网络训练算法,将混合整数优化问题转化为连续变量优化问题。仿真结果表明,本文所提的干扰资源分配方法能够对组网雷达实施有效的干扰,且具备出色的稳定性。

1 系统模型

1.1 突防场景模型

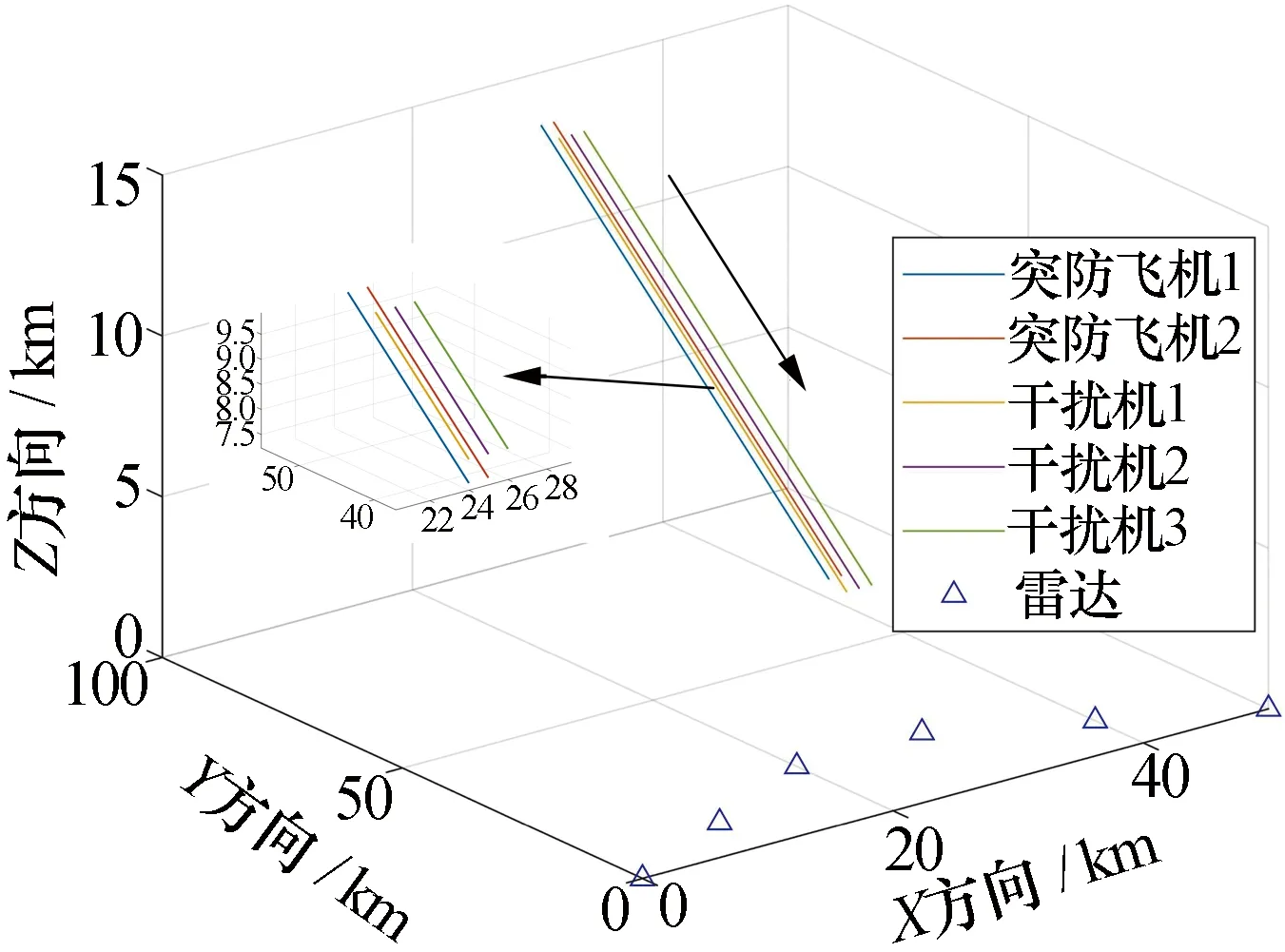

在突防组网雷达场景中,干扰机群在突防飞机周围伴随飞行并对组网雷达进行联合压制干扰,使组网雷达探测性能下降,进而掩护我方突防飞机完成突防打击任务,如图1所示。突防编队由W个突防飞机和M个干扰机组成,组网雷达系统由N个雷达组成。

图1 突防组网雷达场景示意图Fig.1 Schematic diagram of penetration netted radar

1.2 干扰资源分配模型

假设干扰机可以发射多个干扰波束,每个波束只能够干扰一部雷达,并且所有雷达都可以受到多个干扰波束的干扰。定义干扰机群在第k时刻的波束分配矩阵为

(1)

(2)

且每架干扰机最多产生L个波束,即

(3)

在本文的干扰模型中,每个干扰波束的发射功率是可控的,定义干扰机群在第k时刻的干扰功率分配矩阵为

(4)

(5)

1.3 雷达探测模型

雷达通过发射脉冲信号和接收目标回波信号来探测我方突防飞机,假设每个雷达的发射功率、天线增益、载频等工作参数相同,则雷达n接收到突防飞机w的回波信号功率为

(6)

在干扰机群发射压制干扰信号时,雷达n接收到干扰机m的干扰信号功率为

(7)

图2 突防飞机、干扰和雷达相对空间位置Fig.2 Relative geometry position of the surprise aircraft, jammer and radar

(8)

式中:θ3 dB为雷达的3 dB波束宽度;常数α为天线增益系数。

1.4 协同干扰组网雷达检测概率模型

本文采用组网雷达对多目标的联合检测概率作为协同干扰的效能指标,假设组网雷达的部分工作参数、工作模式被我方电子侦察系统提前获取。

首先考虑组网雷达n探测突防飞机w时受到压制干扰,其接收机的信干噪比为

(9)

(10)

根据Swerling Ⅰ检测模型[10-11],雷达单脉冲检测概率可以表示为

(11)

式中:y0为检测门限。

组网雷达一般通过数据融合和信息融合的方法对目标进行联合探测,本文考虑组网雷达检测概率采用秩K准则进行融合。假设雷达n的局部判决为dn∈{0,1},其中dn=1或dn=0表示是否发现目标。融合中心根据这些局部判决产生全局判决向量D=[d1,d2,…,dN],有2N个组合。定义全局判决规则R(D),组网雷达中有K部及以上雷达检测到目标,那么判定为发现目标,否则判定未发现目标,即

(12)

根据秩K准则得到的第k时刻组网雷达对突防飞机w的检测概率为[12]

(13)

式中:S0表示全局判决向量Di(i=1,2,…,2N)中判决为未发现目标的集合;S1表示Di中判决为发现目标的集合。

组网雷达对W个突防飞机的检测概率向量为

(14)

考虑到实际突防场景中,突防飞机对组网雷达的威胁程度可能不同,因此分配给突防飞机的检测概率的权重也会有差异。突防飞机的检测概率权重向量为

(15)

为了评估干扰机群对组网雷达的协同干扰性能,定义了一个全局代价函数为

J(Pdk,ωk)=ωk(Pdk)T

(16)

接下来基于深度强化学习的干扰资源分配方法中将参考式(16)设计回报函数。

2 基于深度强化学习的干扰资源分配方法

2.1 马尔可夫决策过程

马尔可夫决策过程(MDP)是一种用于描述深度强化学习中智能体贯序决策的数学模型,其具有马尔可夫性,即当前状态和回报只与上一时刻状态和动作有关,与之前的状态和动作无关。本文将突防场景下干扰资源分配建模为一个马尔可夫决策过程,并设计相应的状态空间、动作空间和回报函数。

2.1.1 状态空间

突防场景下的干扰资源分配是一个时间序列优化问题,我们假设敌方组网雷达的位置固定,且突防飞机对组网雷达的威胁程度不变。当突防飞机和干扰机相对于组网雷达的位置发生变化时,组网雷达接收突防飞机的回波信号功率和干扰机的干扰信号功率也发生变化。本文将突防编队的位置信息作为状态空间,即

(17)

2.1.2 动作空间

在不考虑突防编队动力学控制的情况下,我们假设其按照既定的飞行航迹执行突防任务。根据干扰资源分配模型,本文将干扰机群的波束分配策略和功率分配策略作为动作空间,即

A={uk,Pk}

(18)

2.1.3 回报函数

突防场景下,干扰机群的目标是降低组网雷达对突防飞机的检测性能,因此本文将突防过程中每一时刻的全局代价函数的相反数作为回报函数,即

R=-J(Pdk,ωk)

(19)

在突防过程中,突防编队的空间位置会发生变化,导致最优的回报值也随之变化。为了评估干扰机群在整个突防过程中的总体干扰效能,之后的仿真验证环节中我们把所有时刻的回报之和作为算法比较的指标依据之一。

2.2 基于动作密钥编码的双延迟深度确定性策略梯度算法

深度强化学习(DRL)是一种将深度学习的感知能力和强化学习的决策能力结合在一起的人工智能算法,常被用于解决复杂系统的贯序决策问题。深度强化学习的原理框架如图3所示,在每个时刻智能体与环境进行交互,得到当前环境下的状态信息和回报;之后基于预期的回报评估各个动作的价值,通过某种策略将当前状态映射为相应的动作并执行;环境对智能体的动作做出反应并更新环境参数。

图3 深度强化学习原理框图Fig.3 Deep reinforcement learning schematic

对突防场景下协同干扰组网雷达模型进行分析可以看出,干扰资源的分配本质上是一个多约束条件下的非线性混合整数规划问题,这类问题的求解难度大。为了提高智能体的寻优能力和收敛效率,本文提出了一种基于动作密钥编码的双延迟深度确定性策略梯度算法,将混合整数规划问题转换为连续规划问题,缓解了变量约束对的影响,有效地解决了双延迟深度确定性策略梯度算法可行性的问题。

借鉴文献[13]中的方法,将干扰波束分配矩阵和干扰功率分配矩阵进行密钥编码,该编码采用实数码的形式,由整数部分和小数部分组成如表1所示。

表1 动作密钥编码Tab.1 Action key encoding

表中编码的顺序值表示干扰波束的编号,编码的整数部分表示为干扰波束选择干扰的雷达,小数部分表示干扰波束的功率分配比例。其中,干扰波束1和2、3和4、5和6分别来自三个不同干扰机。如果多个干扰波束来自于同一架干扰机,则通过归一化的方式重新分配波束的功率比例。

双延迟深度确定性策略梯度是一种基于AC(Actor-Critic)框架的无模型、异策略深度强化学习算法[14],可用于解决连续动作问题。TD3算法相较于深度确定性策略梯度(DDPG)算法有三点改进:第一,同时学习两个价值网络,每次选取较小Q值进行网络参数的更新,有效地缓解高估偏差的问题;第二,给目标策略网络基于平滑机制,在动作中加入随机噪声,减小目标策略受函数近似误差引起的不准确影响;第三,降低策略网络和三个目标网络的更新频率,提高算法的稳定性。

本文提出的基于动作密钥编码的双延迟深度确定性策略梯度算法可以用任意的行为策略收集经验,再通过经验回放训练策略网络和价值网络。其中,智能体输出密钥编码动作与环境交互,环境将动作解码并返回下一时刻的状态和回报,其算法流程如下。

步骤1 设置环境参数,包括组网雷达和突防编队的位置信息、组网雷达的工作参数。

步骤3 对于每个轮,循环执行以下操作。

1)初始化状态s0。

2)根据当前状态s,策略网络πω输出带噪声的编码动作a:a←πω(s′)+ε,ε~N(0,σ)。其中,ε表示服从均值为0、方差为σ的高斯噪声。

3)智能体执行编码动作a与环境进行交互,环境对动作解码,得到回报r和下一时刻状态s′。

4)将智能体与环境交互的数据(s,a,r,s′)存储到经验池中。

5)若突防编队没有达到终点,则重复2)~4),否则开始执行以下步骤:

(1) 策略网络和价值网络及各自的目标网络从经验池B中随机抽取Nb个样本。

步骤4 保存网络模型,结束轮循环。

3 仿真结果与分析

本节将通过仿真实验来分析和验证基于深度强化学习的干扰资源分配算法的可行性、有效性和稳定性。

考虑在仿真实验中,突防场景下有W=2架突防飞机突防组网雷达,M=3架干扰机执行伴随干扰;组网雷达系统由N=6部雷达组成,并采用秩4准则进行数据融合。突防编队的飞机轨迹和组网雷达的空间位置如图4所示。

图4 突防场景仿真示意图Fig.4 The simulation scenario of penetration netted radar

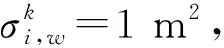

表2 干扰机工作参数Tab.2 The working parameters of the jammer

表3 雷达工作参数Tab.3 The working parameters of the radar

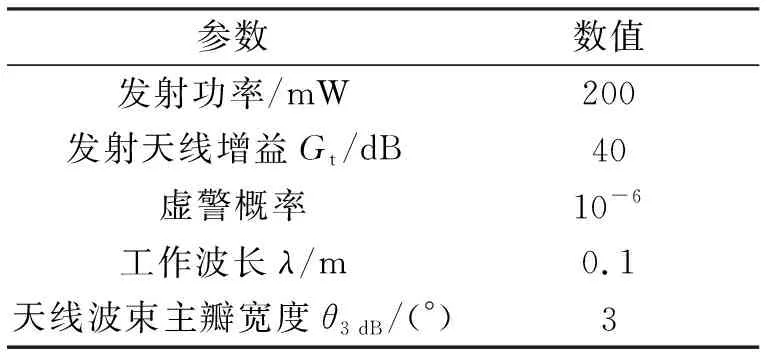

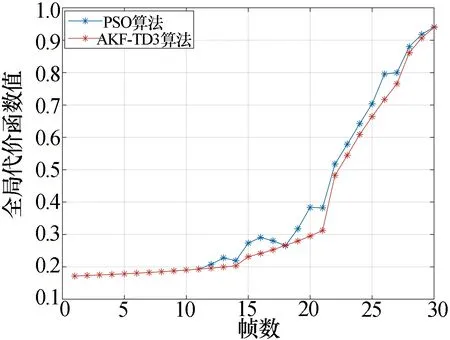

利用基于动作密钥编码的双延迟深度确定性策略梯度算法进行仿真训练时,相关参数设置:最大训练轮数400 000,记忆池大小4 000,软更新参数τ=0.1,奖励衰减因子γ=0.99,初始探索噪声方差1,探索噪声衰减因子0.999 9,单次训练batch-size采样数64,策略网络学习率0.001,价值网络学习率0.002,动作输出限制范围[0,7)。TD3中策略网络和价值网络的参数与各自对应的目标网络相同,价值网络和策略网络模型如图5所示。

图5 策略网络和价值网络模型Fig.5 Actor network and critic network models

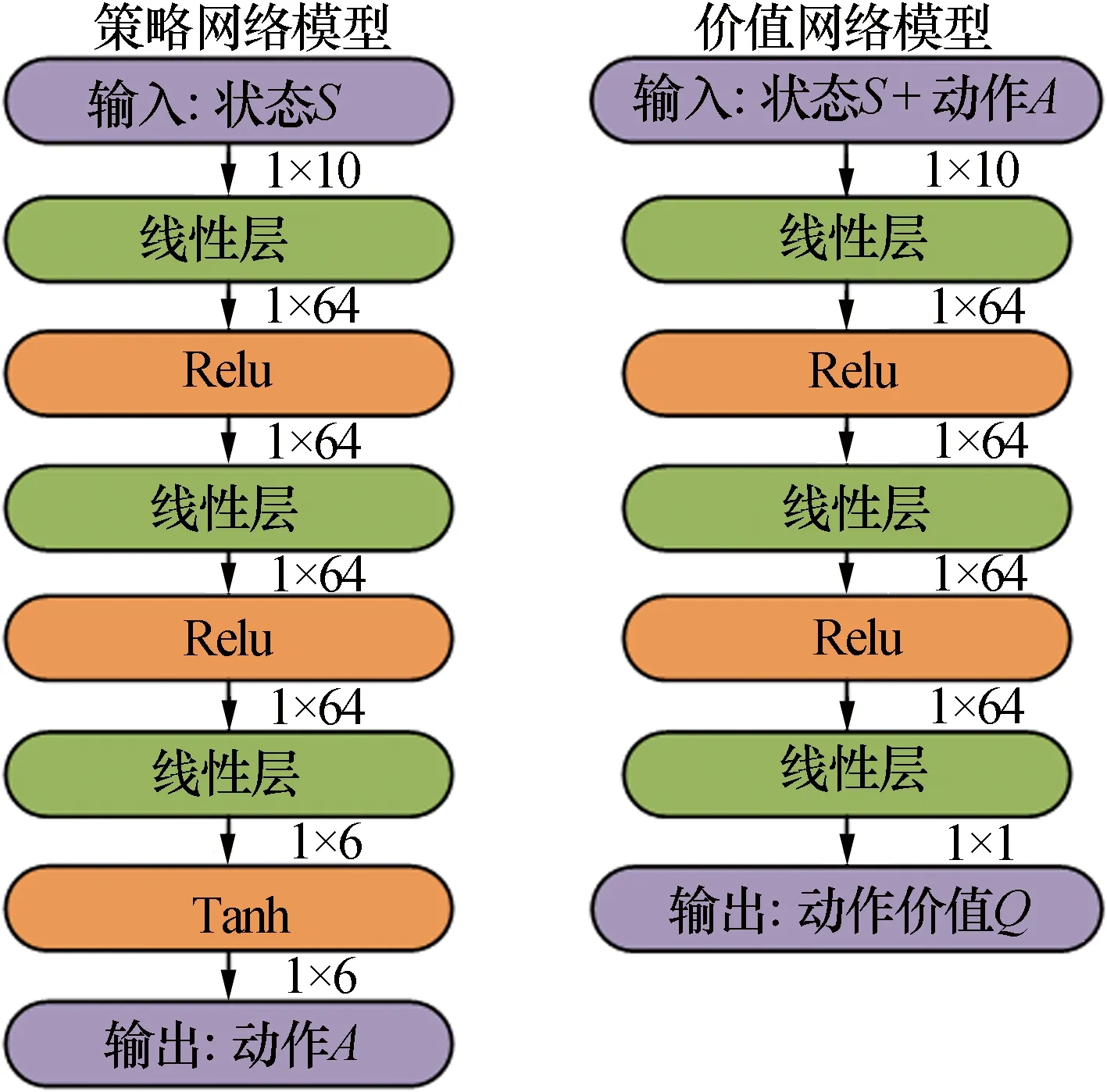

利用PSO算法和本文所提的AKE-TD3算法对上述场景问题进行仿真实验,得到不同算法在整个干扰过程中(每一帧)的全局代价函数性能曲线如图6所示。可以看出,相比于PSO算法,AKE-TD3算法的全局代价函数值在前几帧时基本相同,但在之后都表现出更出色的干扰性能。总体来说,AKE-TD3算法的干扰资源分配策略比PSO算法更好,初步验证了本文所提方法的有效性。

图6 单次仿真下不同算法全局代价函数对比Fig.6 Comparison of global cost functions of algorithms under single simulation

与图6中结果相对应的干扰资源分配结果分别如图7和图8所示。图中的颜色深浅表示干扰功率的大小,深蓝色的部分表示无干扰波束被分配。由于初始化的随机种群对PSO算法的性能有很大影响,因此每次收敛的结果具有波动性,且需要迭代多次才能得到较好的结果。因此可以明显地看出,在作战场景态势缓慢变化的情况下,基于PSO算法的干扰波束分配策略频繁变化,而基于AKE-TD3算法的干扰波束分配策略一直保持稳定,初步证明了本文所提方法的稳定性。

图7 基于PSO算法干扰资源分配结果Fig.7 The results of resource allocation achieved by PSO algorithm

图8 基于AKE-TD3算法干扰资源分配结果Fig.8 The results of resource allocation achieved by AKE-TD3 algorithm

为了进一步分析PSO算法和AKE-TD3算法的干扰性能和稳定性。本文使用PSO算法进行100次蒙特卡洛仿真实验,并使用AKE-TD3算法在10个随机种子下进行仿真实验。得到不同算法全局代价函数在单次仿真全过程中(每一帧)的最大值、最小值和平均值,如图9所示。对不同算法的总全局代价函数和分配策略平均变化次数进行数值统计分析,如表4所示。可以看出,本文所提算法的全局代价函数值和分配策略变化次数都比PSO算法小。因此其干扰能力更强,且在缓慢变化的战场态势中不会频繁的变换策略。进一步验证了本文所提算法的有效性和稳定性。

图9 不同算法全局代价函数对比Fig.9 Comparison of global cost functions for different algorithms

表4 算法的总体性能对比Tab.3 Comparison of overall performance of algorithms

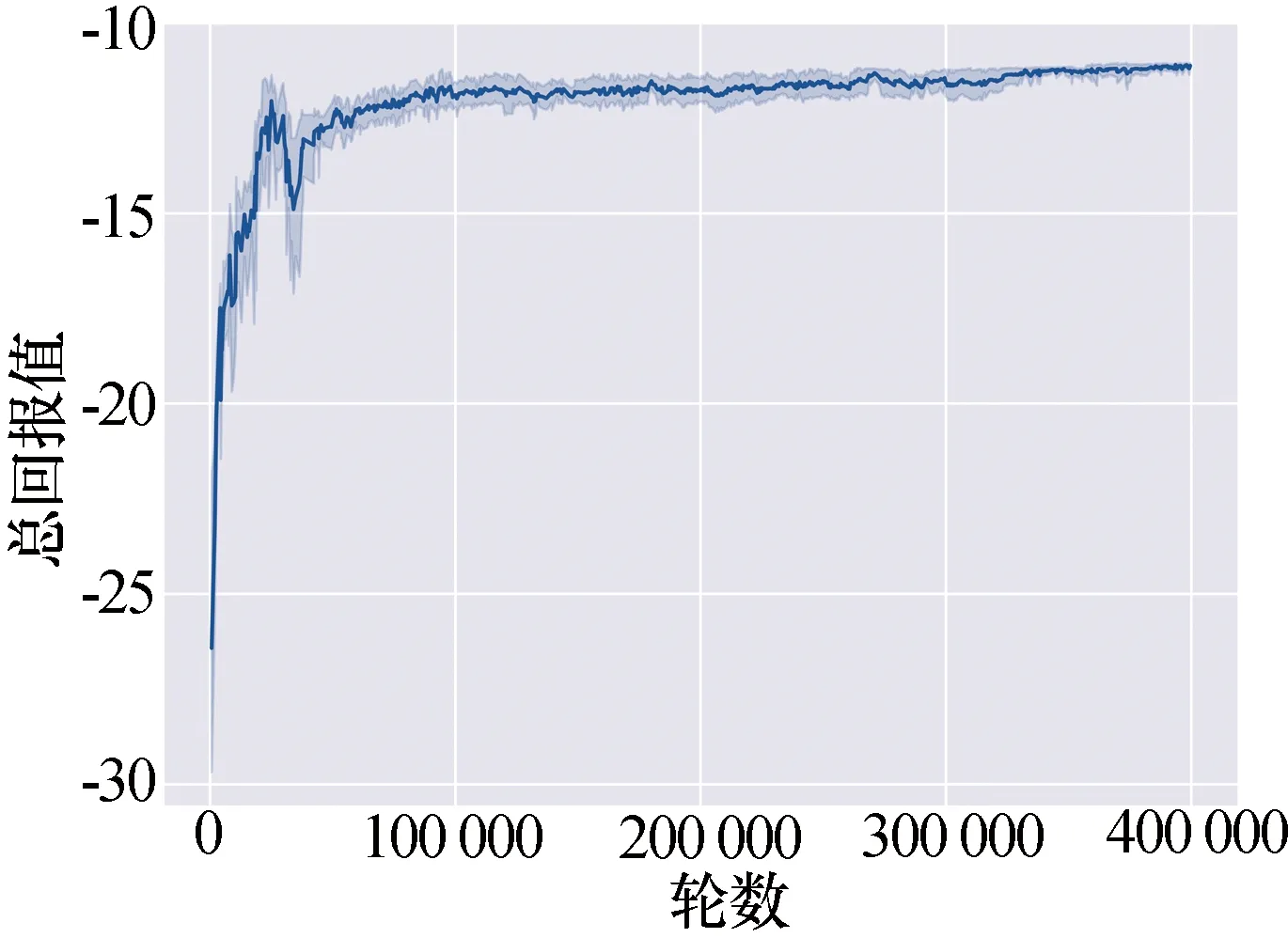

本文每隔100轮取消动作噪声,将整个突防过程中所有时刻的干扰效能之和作为总回报。设置10个随机种子,统计平均总回报的收敛曲线如图10所示。深色的线代表回报的平均值,浅色的部分代表不同随机种子下回报值的分布情况。可以看出,在训练前期,总回报值一直在波动;随着训练的进行,曲线逐渐上升直至收敛。收敛曲线结果证明了AKE-TD3算法的可行性。值得注意的是,深度强化学习需要大量的时间训练,AKE-TD3算法平均单次训练时间约为6 h。但可以通过在不同场景下进行训练将泛化性的策略保存到神经网络中,使其具备较高的实时性,这也是深度强化学习的特点和优势。

图10 TD3算法回报函数收敛曲线Fig.10 Convergence curve of the AKE-TD3 algorithm reward function

4 结束语

本文针对干扰机群掩护目标突防组网雷达的场景,提出了一种基于深度强化学习的干扰资源分配方法。将干扰资源分配建模为一个马尔可夫决策过程,提出基于动作密钥编码的双延迟深度确定性策略梯度算法对模型进行求解。仿真结果表明,本文所设计的算法在多约束复杂干扰问题中,可以通过模拟智能体与环境之间的交互来探索干扰策略。相较于传统智能优化方法,干扰效能得到提升,且能够满足稳定性的要求。值得注意的是,深度强化学习具有出色的泛化能力。通过随机模拟突防场景对智能体进行训练,可以使其具备在未知环境下的作战能力,这将是后续工作的重点。