基于多尺度的混合注意力机制图像超分辨率重建

2023-11-22黄慧玲

黄慧玲

引言

超分辨率重建是计算机视觉和图像处理领域一个经典的问题,旨在从低分辨率的图像中重建出具有清晰的纹理、边缘和高质量视觉感官的高分辨率图像。在计算机视觉领域中被认为是一个经典的病态逆问题[1]。高分辨的图片经过模糊、扭曲和下采样等多种操作后,可得到一张低分辨率图像。然而从低分辨率图像重建到高分辨率这个过程中,存在无限多种高分辨率图像对应,是不可逆的。目前基于深度学习超分辨重建方法研究热度最高,这类算法利用机器学习方法从大量训练数据中学习低分辨率和高分辨率图像之间的映射关系,通常能够更好地恢复图像细节,缺点是需要大量的训练数据和计算资源。深度学习本质上是利用大量训练数据和强大的模型学习能力,能够更好地重建图像细节,获得更高质量的超分辨率结果。

本文主要讨论的是基于深度学习的超分辨率重建,针对如何在提取更加丰富的特征时,关注提取特征与重建特征的相关性这一问题,提出了多尺度的混合注意力机制超分辨重建网络,主要贡献如下:

(1)多尺度提取特征:一个大的感受野可提供更多的上下文细节,并通过结合本地和全局信息帮助重建出更好的性能。因此,将局部信息和全局信息结合起来,在不同尺度上为图像提供上下文信息,设计了一个多分支网络。

(2)混合注意力机制:由通道注意力和空间注意力相结合,并融合到多分支模型中,实现在提取更加丰富特征情况下,关注提取特征与重建特征的相关性,从而提高重建质量。

一、网络结构整体设计

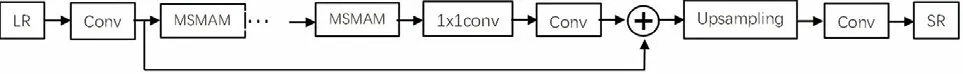

整个网络的结构如图1所示,分为特征提取、全局残差学习和上采样模块。特征提取的作用是提取超分辨重建需要的低中高分辨率信息,丰富的特征信息利于图像重建。设计网络结构的关键是采用多尺度融合注意力模块级联的方式,其中多尺度是指运用了两条信息流获取上下文的信息,混合注意力是指从通道和空间两个角度来优化选择的特征,使获取的特征更利于超分辨率重建。全局残差学习的作用就是不丢失刚进入网络的初始特征,即低频特征通过全局残差可以将低频信息流流向网络的最后阶段,参与重建,实现了全局跳跃连接,以增强模型的非线性映射能力。上采样(Upsampling)模块的作用是生成与SR图像相同的目标尺寸。

图1 网络整体结构

(一)多尺度混合注意力模块(Multi scale mixed attention module)

网络结构除了深度会带来更多的特征信息,网络的宽度也会。在GoogleLeNet中采用的inception模块中,由四条并行路径组成,旨在从不同的空间大小中提取信息[2]。这种多分支的结构在SR上也得到了应用[3-4],因此在本网络中借助了拓展宽度获取特征信息的思想,提出了多尺度模块,如图2所示:

图2 多尺度混合注意力模块图

多尺度混合注意力模块是构成网络的关键部分,以实现更强大的多尺度特征表达和特征相关性学习。为了改进信息丰富的多尺度特征表示能力,设计了一个带有注意机制的残差多尺度模块MSMAM,该模块由卷积核、注意力机制和残差连接组成,首先通过一个3×3的卷积核,接着分为一个并行网络,依次通过不同数量的3×3的卷积核,然后分别经过通道注意力和空间注意力接着两条网络求和,最后经过一个1×1的卷积核,并且运用残差连接用输入卷积核与从1×1输出的卷积进行融合。

(二)混合注意力机制

本网络提出的融合网络是通道注意力网络与空间注意力网络的结合,并把其放在多尺度特征提取中,有选择性地提取出更有利于超分辨率重建的特征。

通道注意力的计算过程如图3所示,首先模块输入一个H×W×C的一组特征图,其中H指特征图的高度,W指宽度,C指通道数。经过全局和平均池化计算得到每个通道的均值,即1×1×C。之后通过1×1卷积操作将通道数量缩小一定的倍数,接着经过Relu函数进行非线性化,然后再通过1×1卷积操作将通道数放大相同的倍数至原来的数量,接着再经过一个Sigmoid激活函数,即可得到每个通道的权重,即通道注意力。通过学习得到每个通道注意力参数,再与输入的特征图相乘,得到选择后化特征信息输出。

图3 通道注意力

空间注意力机制是一种在计算机视觉任务中应用的注意力机制。它允许模型集中注意力在图像的不同空间位置上,以便更好地处理图像中的相关信息。其基本思想是对输入图像的空间内容信息映射到另一个空间内容上并保留通过计算选定的关键信息,对每个区域根据权重计算并输出,从而确定图像中比较重要区域的位置信息。空间注意力机制形成的基本流程通常是通过降低输入张量的通道维数来挖掘位置信息,然后利用卷积计算空间注意力从而使得目标区域得以增强。

二、实验结果与分析

在服务器主机上搭建的实验环境,CPU为Intel(R)Xeon(R) Platinum 8375C CPU @ 2.90GHzPC,GPU为RTX 4090(24GB) * 1,配备了1.10.0版本的PyTorch,以及3.8版本的python,采用了ubuntu20.04操作系统。本实验采用数据集DIV2K[5]作为训练集,使用Set5作为验证集,基于验证集上的实验结果选取出最优的网络结构,并用最优的网络结构来测试Set14、BSD100和Urban100数据集。在训练过程中,本实验将每1000次迭代作为一个epoch。每个epoch后在Set5数据集上进行验证从而选出最好的模型。初始学习率被设置为1×10-4,并每隔300个epoch将其减半。为了优化提出的网络,采用了Adam优化器[6],相应的超参数为β1=0.9,β2=0.999,∈=10-8。

(一)定量分析

为了验证本网络的重建质量,将与一些经典的超分辨率重建领域的模型进行比较,模型有:Bicubic、SRCNN、VDSR、ESCPN、LapSRN等。将模型在数据集Set5、Set14、BSD100和Urban100进行测试,选取PSNR和SSIM为评价指标,在×3的放大因子下与设计的网络模型进行定量比较。

通过表1可以看出,通过在×3的放大因子以及4个不同的测试集测试实验下,相较于浅层网络SRCNN,网络较深的VDSR、LapSRN、DRRN都取得了更好的PSNR以及SSIM平均值,其中VDSR是单信息流的线性结构,Lap-SRN使用了金字塔结构逐渐重建连接,DRR是使用递归链接的卷积层,这是三类有代表的超分辨率重建模型。与设计的多尺度混合注意力机制相对比,都略低于它的PSNR以及SSIM平均值。

表1 不同模型在放大因子为3的PSNR和SSIM均值对比

(二)定性分析

为了体现重建图片在视觉上的效果,将Bicubic、SRCNN、VDSR、LapSRN与提出的模型在set5和urban100数据集上分别选一张图片来进行重建效果对比,如图4展示了×3放大尺度的视觉对比。对于Set5中的“baby”,提出的模型能以较少的模糊和噪声还原眼部轮廓。对于urban100中的“img_069”,提出的模型可以以更少的模糊恢复出可信的边缘。因此,提出的模型可以恢复出更精确的图像细节,图像整体的清晰度更高,视觉效果上更进一步。

图4 不同超分辨率方法在Set5和BSDS100上的重建结果对比(重建倍数为3)

结论

为了解决提取丰富特征的同时关注提取特征与重建特征的相关性问题,提出了多尺度的混合注意力机制超分辨重建网络。从多尺度特征提取、通道注意力机制、空间注意力等角度分析了模型的搭建,接着在一定的实验条件下进行实验。通过从定量和定性的角度做对比实验,把本模型与在超分辨率重建上经典的模型相对比,实验结果表明,该模型在定量比较上优于经典模型,在客观评价指标PSNR/SSIM上取得了较高的数值;在定性比较上也取得了接近HR图像的重建质量,在视觉效果上相比于其他模型也具有良好的感知质量。