深度强化学习优化物联网传感器数据分析

2023-10-25何伶俐

何伶俐

(湖北轻工职业技术学院,湖北 武汉 430070)

0 引言

物联网(Internet of Thing,IoT)是一个高速发展的领域,正在改变各个行业,例如:智能城市、工业自动化和医疗保健。随着IoT设备的增多和数据规模扩大,处理和分析IoT传感器数据变得至关重要[1]。但是,由于传感器和环境因素,数据质量问题(如噪声、冗余、空数据)成为挑战。这些问题可能影响数据分析的准确性和智能应用的性能。为了解决这个问题,本研究提出了一种基于深度强化学习的框架,利用深度Q网络代理清理传感器数据,分为空数据、垃圾数据和正常数据三类。实验结果显示,这种方法优于传统的基于时间序列的全连接神经网络方案,在提高数据质量和应用性能方面具有优势[2]。

1 深度强化学习优化物联网传感器数据问题分析

物联网传感器数据分析中存在3个主要问题:数据质量问题,如噪声、冗余和空数据;数据清理的挑战,涉及有效识别和处理空数据、垃圾数据和正常数据;数据处理效率问题,需要在大规模和复杂数据情况下保持高效。为了解决这些问题,本研究提出了一种基于深度强化学习的优化方案。本研究引入深度Q网络代理进行数据清理,目的是自动识别和处理各种数据,提高数据质量和应用程序性能[3]。

2 物联网数据分析中的数据清理需求

2.1 物联网数据分析

物联网数据分析是处理和挖掘从物联网设备和传感器收集的数据,以提取有价值的信息支持决策和应用程序。主要任务包括数据清理和预处理、数据可视化、数据挖掘与分析以及实时决策和响应。数据清理包括处理缺失值、异常值和噪声等,以优化数据质量。数据可视化帮助用户理解数据特征,而数据挖掘和分析则用于发现新的知识和洞察。实时决策和响应则用于支持智能实时应用。物联网数据分析在智能城市、智能制造、智能农业等多个领域有广泛应用,能有效提升资源利用效率,预测和解决问题,带来更多的便利和价值[4]。

2.2 传感器数据清理方法

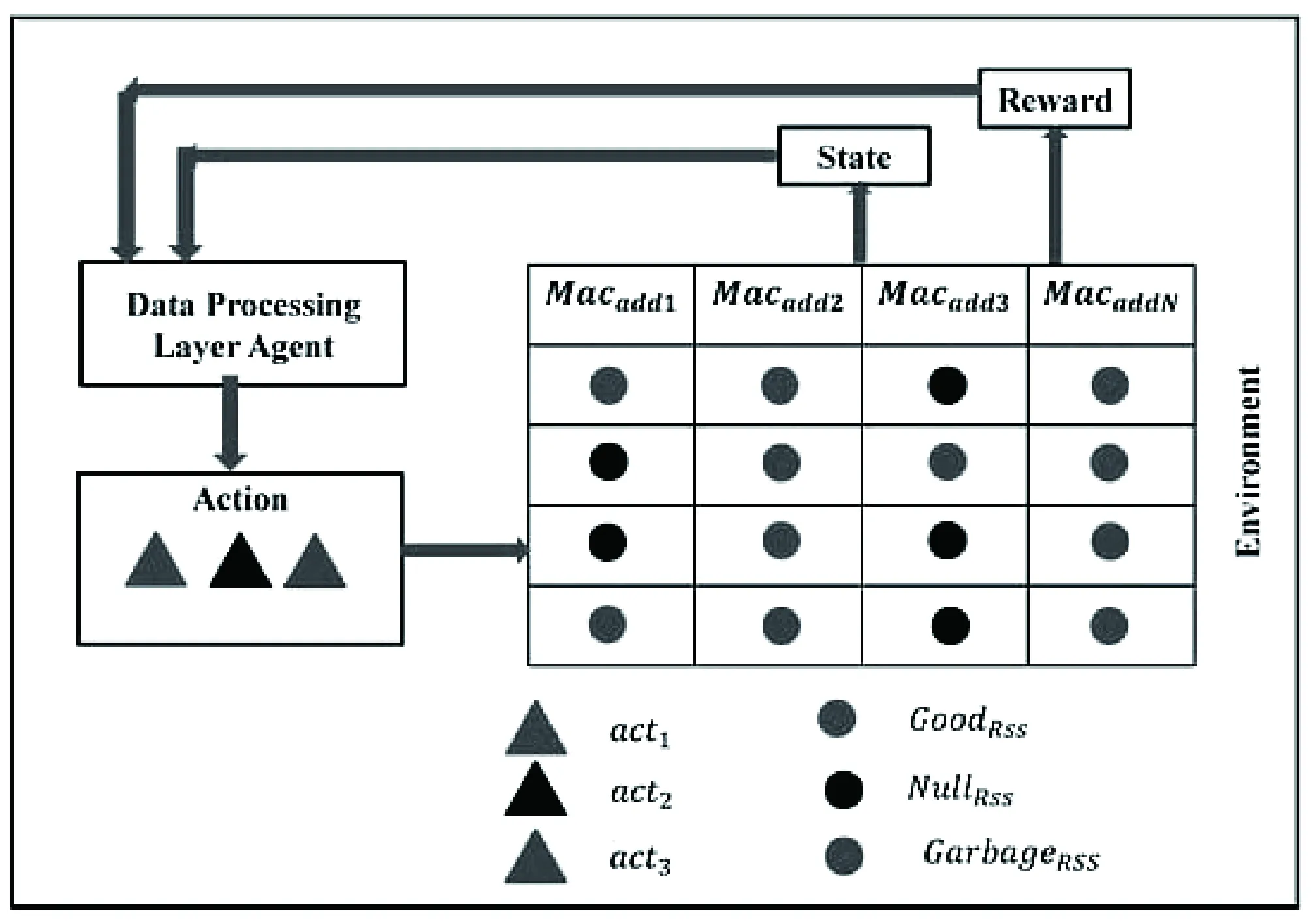

物联网数据清理是关键步骤,用于处理传感器数据的噪声、冗余和空数据。常用方法包括处理缺失值(删除或填补)、异常值检测(通过统计或机器学习)、冗余数据去除、数据平滑和滤波以及数据归一化和标准化。本研究提出了一种基于深度强化学习的数据清理方法(RLQN),它以实时环境状态为基础,根据当前状态决定最佳操作,以优化数据质量。该方法以RLQN代理在物联网架构的数据处理层中进行实时数据感知和处理[4]。图1展示了本研究提出的基于深度强化学习的数据清理方法(RLQN)的系统概述。该方法包括5个不同的概念,基于深度强化学习的原理进行设计。本研究将RLQN代理放置在物联网架构的数据处理层上,代理会根据当前的环境状态来决定适当的操作。需要注意的是,状态是由实时环境决定的,因此代理需要实时地感知和处理数据。

图1 用于跟踪丢失和垃圾数据的深度强化学习代理

2.3 物联网数据质量的挑战与需求

物联网数据质量面临众多挑战,包括多样的数据来源、大量的数据、噪声、不确定性和数据完整性问题。解决这些问题的关键在于数据清理和预处理、数据标准化和一致性、数据质量评估、数据安全保护和数据治理。数据清理是物联网数据分析中的关键任务,主要通过处理错误、噪声和缺陷以提高数据质量。常用的数据清理方法包括处理缺失值、异常值检测、噪声去除、去除重复数据、数据转换和标准化以及数据修复。这些方法可以相互结合,根据数据类型和处理目标的不同,提高数据质量和处理效果[5-7]。

3 基于RLQN的物联网数据分析系统的实验部署与方法原理

3.1 基于RLQN的物联网数据分析系统的实验环境和状态空间

本研究提出的模型与Keras库一起部署在Python 3.10下的TensorFlow 2.2.0 API上。本研究在一集中评估了本研究提议的DQN性能总奖励和不需要的数据检测准确性。环境是本研究提出系统中提高代理互动性能的基本因素之一。本研究提出的环境采用基于网格的架构,大小为20×20。在该架构中,每个网格索引表示从传感器收集的RSS值。因此,该系统总共收集了400个RSS值,其中每行有20个RSS值。本研究提出的系统能够从环境中实现对400个不同状态空间的评估。对于提出的状态空间,经验驱动的方法在训练后推断解决方案是有效的。图6显示了一些具有20个RSS值的行示例,其中包含所有可用的RSS数据(良好、空和垃圾)。

3.2 基于RLQN的物联网数据分析

在本研究提出的基于RLQN的系统中,与上述环境交互以获取经验是一项普遍而基本的任务,并以最佳方式实现[8]。最初,本研究设计的DQN代理对系统环境没有任何了解或经验。因此,代理使用epsilon参数随机选择特定操作。随后,代理开始根据基于贪心的exploitation策略提供最佳操作bestact。

bestacl=argmax( agent ( state )).

为了自动化地记住每个情境,本研究的系统将代理的经验存储在基于deque的内存中,称为“体验重播内存”,并针对每个时间步骤(t)进行存储。需要注意的是,本研究提出的代理的经验表明,在每个时间步骤中,当前状态、行动、奖励和下一个状态均被收集。这意味着系统将这4个值作为元组存储在单个基于deque的体验重播内存中,如图2所示。

图2 基于Deque的体验重播记忆

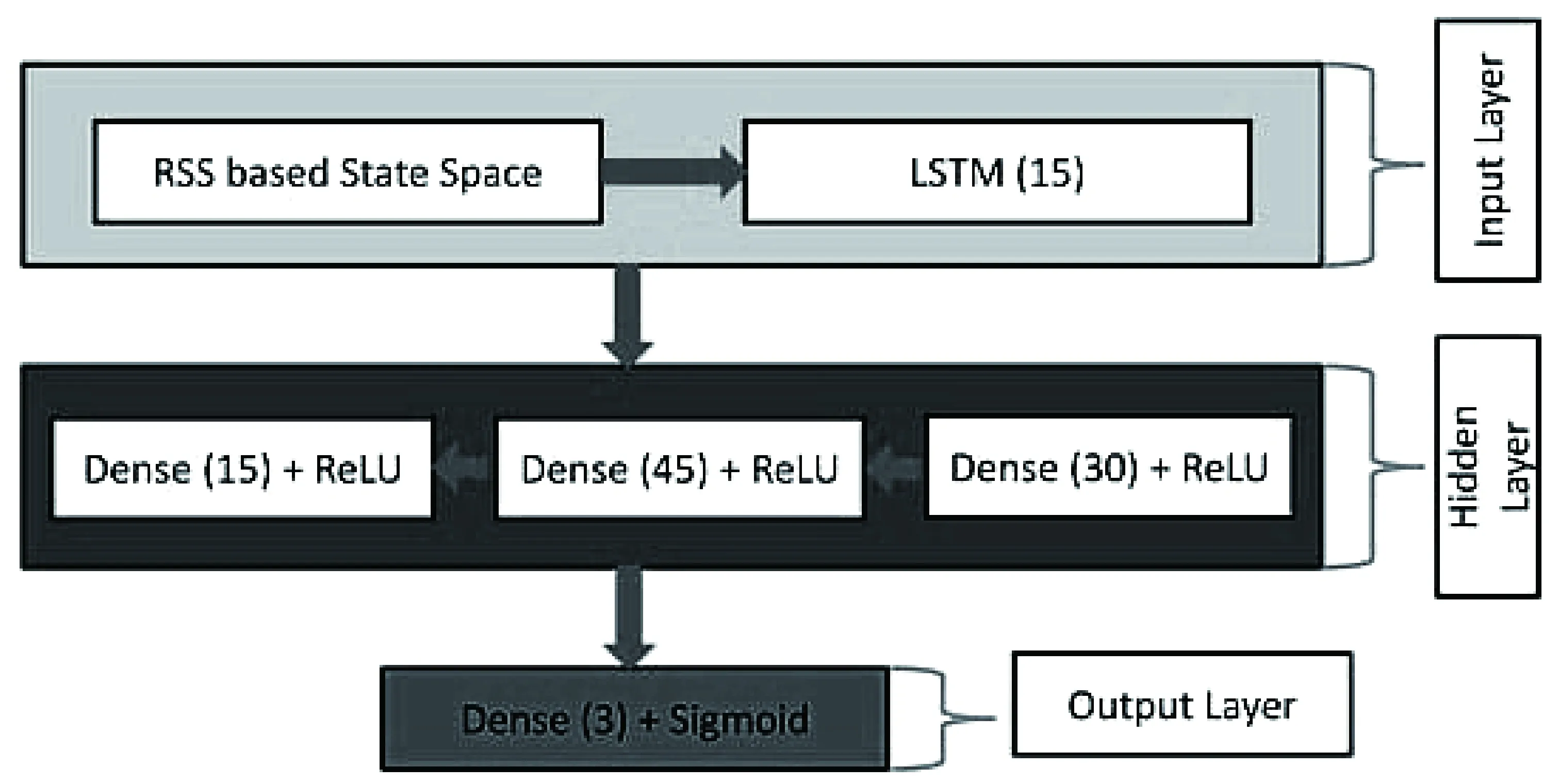

本研究的系统利用深度强化学习对体验进行存储和实时训练,采用随机采样策略减少体验间的相关性,降低训练复杂性。本研究的Q网络基于深度学习,以LSTM形式部署,适应了实时收集的RSS数据,优化了行动预测。本研究的系统实时从各部分收集RSS数据。因此,LSTM是Q网络的最佳选择之一。此外,本研究将完全连接的密集网络与本研究提议的RLQN相结合,以使整个网络稳健。图3代表了本研究设计系统的提出RLQN。同时,本研究将完全连接的密集网络与RLQN结合,以提升网络稳健性。为提高整体性能,本研究引入了另一个具有相同结构的RLQN,称为target-RLQN,一同优化预测和目标Q值之间的损失,提供最佳行动。

图3 提出的RLQN

Loss(θ)=(Q′-Q)2.

其中,Q和Q′分别在(4)和(5)中给出,其中γ代表折扣因素∈[0,1]。本研究提议的系统的整体算法在算法1中给出。

Q=Q(st,actt;θ)

3.3 基于RLQN的物联网数据实验设置

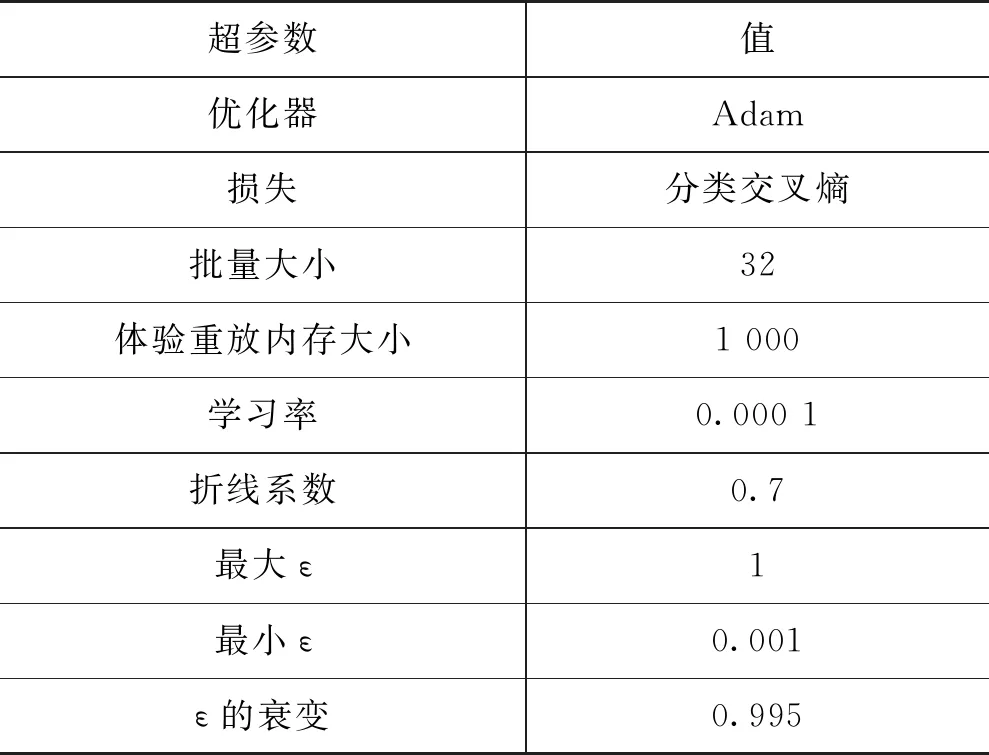

为了设计RLQN,本研究在训练期间通过试错策略初始化了一些超参数(例如:学习率、ε数量等)。这些超参数控制Q网络的特性,以提供最佳操作。表1详细描述了本研究提出的DQN的训练超参数。

表1 训练超参数

4 基于性能评估指标的物联网数据分析方法效果分析

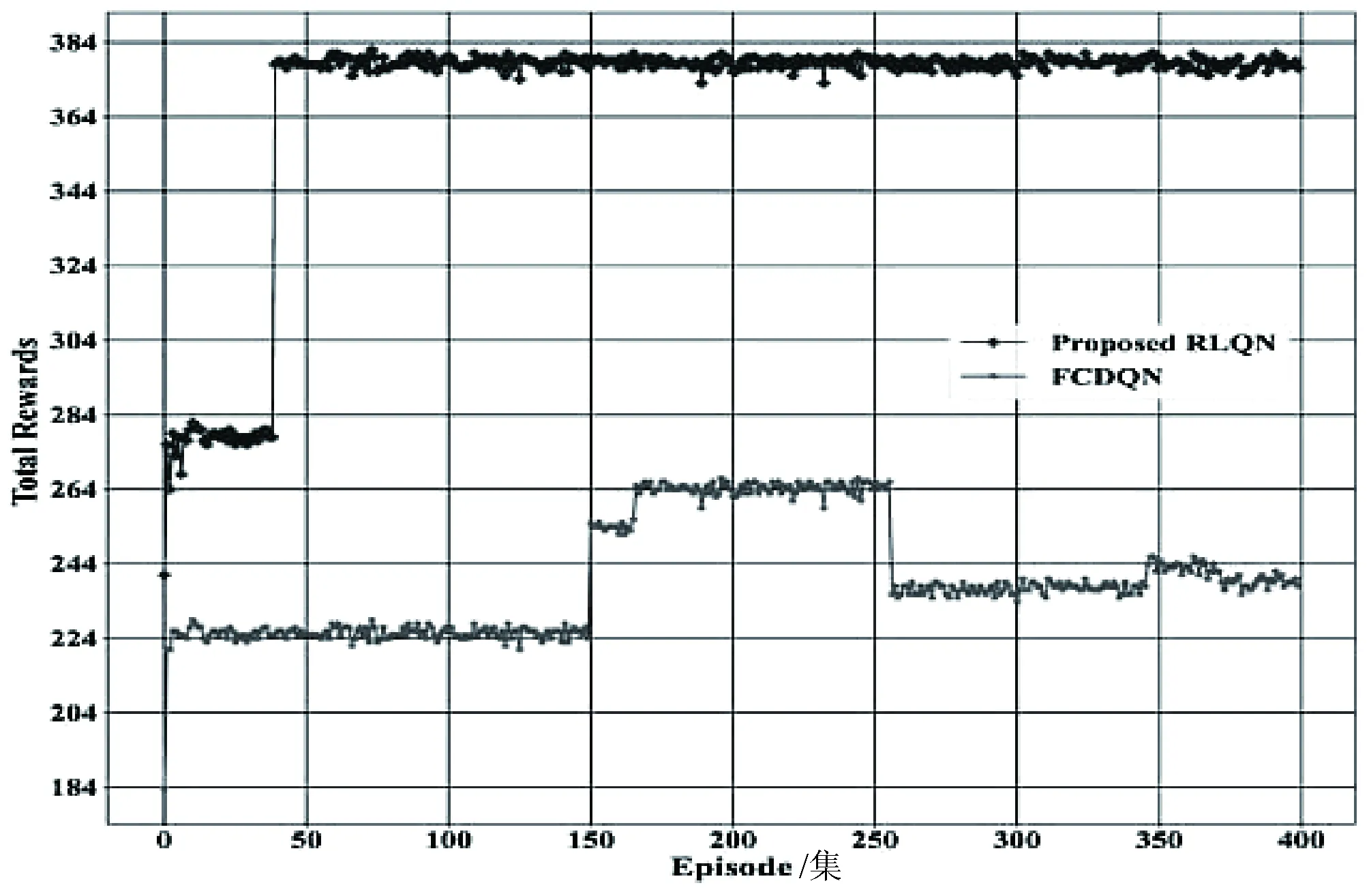

物联网数据分析的性能评估常用准确率、精确率、召回率、F1值、均方误差、均方根误差、相对误差和R平方等指标。本研究的研究运行了400集的模型,每集的总奖励图显示,本研究提出的RLQN方法在开始和整个实验过程中都能获得超过150的总奖励,而且在45集后总奖励大幅增加,其改进速度明显优于FCDQN。RLQN能够从总奖励增加开始,一直保持稳定的奖励水平到最后一集,而FCDQN的奖励水平只能在短时间内保持稳定,然后以不一致的方式下降,如图4所示。因此,本研究的RLQN系统相比于FCDQN表现更佳。

图4 每集的总奖励

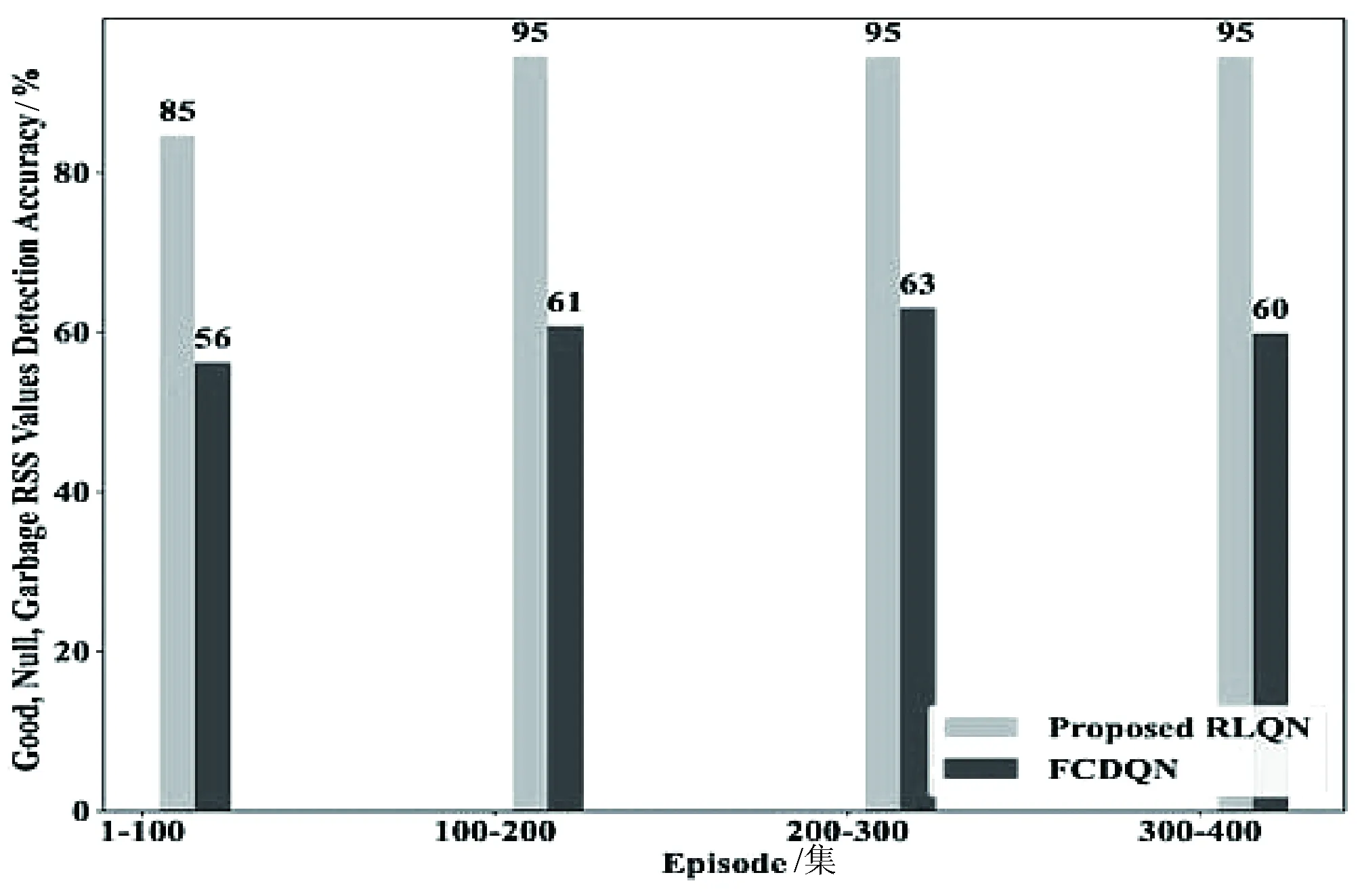

提出系统的主要目标是在数据收集阶段区分不同类型的数据,如“良好”“空”和“垃圾”,以减少不需要的数据量(即“空”和“垃圾”)。图5说明了识别“良好”“空”和“垃圾”RSS值的检测准确性,直到400集。

图5 每个情节间隔的检测准确性

从图5可以看出,提出的方法在每次发作间隔内始终保持更高的准确性。此外,可以看出,提出的系统在每次发作间隔时始终达到超过80%的准确性,而FCQN无法达到超过65%的准确性。值得注意的是,最初,由于代理在第一个间隔处于勘探模式,提出方法的准确性低于90%,但在勘探期后,随着代理开始贪婪地采取行动,这一准确性增加到近96%。相比之下,FCDQN在最终间隔时从未达到70%的准确率。因此,可以得出结论,提出的系统在有效识别和删除“空”和“垃圾”RSS数据方面非常强大。

5 结语

文章提出了一个深度强化学习的物联网数据清理框架,旨在改进数据分析并消除不必要的数据。使用深度Q网络识别并处理空数据、垃圾数据和正常数据,实时处理大量传感器数据,并在实时决策和高度适应性方面具有优势。实验结果表明,该框架的精度约为96%,可为各种物联网应用程序提供多功能解决方案。