具有方面项和上下文表示的方面情感分析

2023-10-21徐丹龚红仿罗容容

徐丹,龚红仿,罗容容

具有方面项和上下文表示的方面情感分析

徐丹,龚红仿*,罗容容

(长沙理工大学 数学与统计学院,长沙 410114)( ∗ 通信作者电子邮箱ghongfang@126.com)

针对预测特定方面情感极性时存在只依赖单一方面项而忽略了同一句子中方面项之间间情感依赖关系的问题,提出一种具有方面项和上下文表示的多层多跳记忆网络(AICR-M3net)。首先,通过双向门控循环单元(Bi-GRU)融合位置加权信息,并将隐藏层输出作为混合上下文编码层的输入以获取与上下文语义关联度更高的上下文表示;其次,引入多层多跳记忆网络(M3net)多次逐词匹配方面词和上下文,从而生成特定上下文的方面词向量;同时,建模特定方面项与句子中其他方面项的情感依赖性,从而引导特定方面项的上下文向量的生成。在Restaurant、Laptop和Twitter数据集上的实验结果表明,与AOA-MultiACIA (Attention-Over-Attention Multi-layer Aspect-Context Interactive Attention)相比,所提模型的分类准确率分别提高了1.34、3.05和2.02个百分点,F1值分别提高了3.90、3.78和2.94个百分点。以上验证了所提模型能更有效地处理上下文中多方面的混合信息,且在处理特定方面情感分类任务中具有一定的优势。

特定方面情感分析;情感依赖;记忆网络;多头注意力机制;门控循环单元

0 引言

情感分类是自然语言处理中一项重要的任务,主要分析用户对产品或者事件的评论的情感极性。与传统的对评论句子或者文段的情感分类不同,针对特定方面的情感分类是情感分类的分支,它捕获给定评论句子或者上下文中特定方面的情感极性,是一种更加细粒度的分析。例如句子“Everything is so easy to use, Mac software is just so much simpler than Microsoft software”,分别对目标词“use”和“Microsoft software”表达了积极和消极的情感。

特定方面情感分析的关键挑战是如何设计有效的算法建模方面与它相对应的意见词部分,在同一个句子中可能存在多个方面词,在判断每个方面词的情感极性时只需要上下文中的部分内容。例如句子“The restaurant is good but the service is terrible”,“good”能确定方面词“restaurant”的情感极性为积极,不影响判断方面项“service”的情感极性。因此,精准建模上下文和方面词之间的语义具有挑战性[1]。以往的研究集中通过注意力机制学习特定方面的上下文表示,相关模型也取得了较好的效果,但是仍然没有有效提取目标特定的情绪信息,模型在判断的过程中也可能定位到不正确的目标特征。

因此,作为一种替代方法,文献[2]中提出的AOA(Attention-over-Attention)模型让上下文和方面项分别参与对方的特征生成,相较于只使用注意力机制的模型,进一步提高了性能。文献[3]中提出了一种交互式注意网络(Interactive Attention Network, IAN)交互式学习上下文和目标的注意,并分别生成目标和上下文的表示。在该网络中,交互注意力机制在从给定方面词的上下文中选择性地提取目标相关的情感信息,起着至关重要的作用;然而该模型的信息交互方法是粗粒度的,分别使用上下文和方面词隐藏层输出的向量平均后作为查询向量,生成方面词和上下文的表示,这种方法会造成一定的信息损失。

受问答系统中记忆网络(Memory Network, MN)[4]的启发,文献[5]中将外部记忆网络引入神经系统。文献[6]中提出了一种深度记忆网络(deep Memory Network, MemNet)用于特定方面的情感分类,该模型通过多个计算层明确捕获每个上下文的重要性,取得了和支持向量机(Support Vector Machine, SVM)性能相当的结果。文献[7]中引入门控循环单元(Gated Recurrent Unit, GRU)作为深度记忆网络的门控机制,将注意力结果与递归神经网络非线性结合,提高了模型处理复杂语境的能力。文献[8]中针对传统MN仅依赖于注意力机制不能很好地检测给定目标的情绪特征的问题,提出了一种目标敏感记忆网络(Target-sensitive Memory Network, TMN),以捕获目标敏感情绪。为了利用相关句法约束和单词长距离依赖性,文献[9]中在依赖树上构建一个图卷积网络(Graph Convolutional Network, GCN),再结合注意力机制提取最终用于分类的特征。文献[10]中考虑了具有边缘约束的不同类型的邻域,更有效地学习方面和目标表示,用于具有交互注意力的方面情感分类。文献[11]中使用一系列卷积神经网络(Convolution Neural Network, CNN)从句子中捕获多尺度信息,通过GCN和注意力机制将方面信息合并用于情感分析。文献[12]中首先利用GCN提取句法依存树上的句法信息,其次通过交互式学习生成上下文和方面表示。文献[13]中考虑到了依赖项标签信息,集成类型化句法依赖信息提出了一种关系图注意网络(Relational Graph ATtention network, RGAT),实验结果证明有效利用标签信息能提高目标情感分类性能。

上述预测模型通过捕获上下文和方面项的相互作用提取对情感分析有效的特征,但是忽略了同一句话中特定方面项和其他方面项的情感依存关系。本文认为,方面项之间的情感依赖有助于生成更精确的特定方面项的句子特征表示,因此要建立一个有效的记忆网络用于方面情感分类需要考虑以下几点:

1)方面项之间的情感依赖信息有助于生成更精确的句子特征表示。例如在句子“The best thing about this laptop is the price along with some of the newer features”中,方面项“newer features”没有明显修饰的情感词,但是通过邻近方面项“price”积极的情感极性和“along with”表达的并列关系可以得知它的情感极性是积极的。

2)与上下文相同,部分目标词中也包含多个词语,每个词语在生成最终目标词的表示时贡献不同,因此需要计算各个词语的重要度以捕获相关信息。例如方面词“cooling system”中,“system”在方面词的角色更关键。

3)考虑到位置信息在方面项和上下文语境之间的作用,直觉上越接近方面项的词语对判断方面的情感贡献越大。

基于以往研究的不足,本文提出一种具有方面项和上下文表示的多层多跳记忆网络(Multi-layer Multi-hop Memory network with Aspect Item and Context Representation, AICR-M3net),用于方面情感分析。

本文的主要工作如下:

1)提出AICR-M3net用于方面情感分类。通过多次提取方面项之间的情感依赖信息用于合成特定方面项的情感分类特征向量,并通过GRU剔除冗余信息,保留对情感分类有用的特征用于下一个计算层的更新。

2)对方面项单独建模,逐词匹配方面词和上下文,生成特定的方面词向量。

3)考虑上下文关于特定方面项的位置信息的有效性,通过对双向门控循环单元(Bi-directional GRU, Bi-GRU)融合位置特征,获得上下文和方面项向量表示。

1 模型架构

AICR-M3net的模型架构如图1所示。模型包含4个部分:嵌入层、混合上下文编码层、多层多跳记忆层和输出层,其中:嵌入层生成位置感知的字向量表示;混合上下文编码层获得与句子语义更相关的特征表示,以涵盖单词之间的长距离依赖;多层多跳记忆层对给定方面和句子中其他方面依赖关系建模,分别生成更准确的上下文和方面词向量,用于情感分类。

图1 AICR-M3net模型框架

1.1 任务定义

1.2 位置感知的嵌入层

模型的嵌入层由位置加权和Bi-GRU两部分组成。获得句子和方面项对应的词向量表示后进行位置加权,再通过Bi-GRU融合位置特征,获得上下文和方面项向量表示。

为了融合位置信息,获得整个模型的输入词向量,本文模型使用Bi-GRU网络,GRU通过重置门和更新门控制输入和输出,利用门控机制让模型学习当前时刻的依赖关系,时刻重置门和更新门的计算公式为:

1.3 混合上下文编码层

混合上下文编码层的主要目的是捕获语义特征,生成新的单词向量用于方面间情感依赖关系建模。本文采用多头注意力(Multi-Head Attention, MHA)机制生成上下文的语义编码[15]。内部多头注意力(intra-MHA)机制是MHA中一种特殊情况,通过多通道机制可以在训练的过程中学习前文与自身、后文与自身的依赖关系和自身内部关系。

具体地,

1.4 多层多跳记忆网络

为了准确预测目标方面词的情感极性,需要获得更准确的上下文表示。受文献[16]启发,考虑到同一句话中不同的方面词的情感具有的依赖性,将多层多跳记忆网络(Multi-layer Multi-hop Memory Network, M3net)用于建模特定方面项与其他方面项间的依赖关系。本文所阐述的“多跳”指在单个计算层中包含两个计算步骤:一是生成问题向量表示,二是捕捉方面项之间的情感依赖生成上下文表示。

选取一个句子中的特定方面项输入MN,首先需要生成方面项单个词汇特定的特征表示。方面词与上下文相同,也可以由多个词语组成,每个词对它生成的最终表示贡献不同,将它们均值化后作为方面项的特征表示不合适;因此考虑逐词匹配方面词和上下文,生成特定的方面词向量,即问题向量,用于在上下文特征中计算特定方面项与句子中其他方面项情感依赖的相关信息,生成更准确的上下文特征表示。M3net是单层网络的叠加,每个计算层使用两个GRU作为门控机制分别重置更新上下文到方面的注意信息和方面项之间的注意信息。单层训练过程如下:

其中pooling为平均池化函数。

3)M3net更新。单层MN可能无法充分提取情感依赖信息,因此本文将多个计算层叠加,每一层得到比上一层更精确的上下文和方面词表示。MN的更新分为两个部分:

1.5 情感分类和模型训练

在模型训练的过程中,引入L2正则化机制,通过最小化交叉熵函数优化模型参数,目标函数的定义如下:

2 实验与结果分析

2.1 数据集

本文使用Twitter数据集[17],以及SemEval 2014任务4中提供的用于方面情感分析的评论公开数据集[18]:Laptop数据集和Restaurant数据集,3个数据集的统计结果如表1所示。

表1 数据集详情

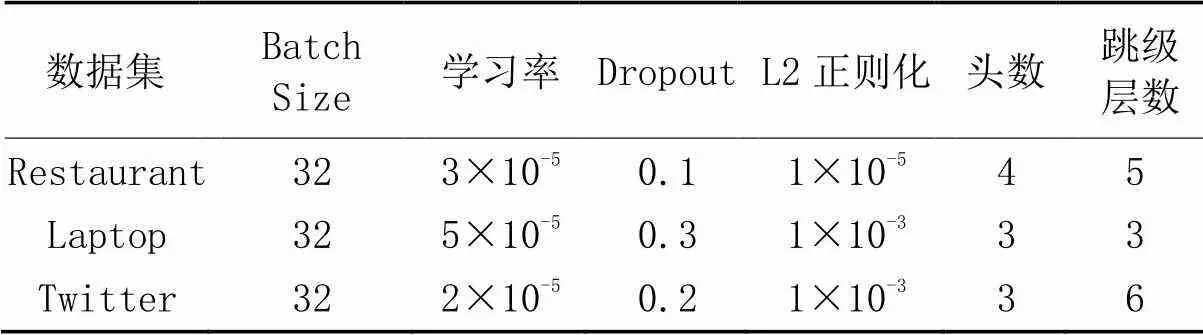

2.2 实验设置和参数指标

在本文实验中,使用预训练的BERT初始化词向量,维度为768,隐藏层的维度设置为300。模型的所有权重使用均匀分布初始化。注意力的头数、GCN层和深度交互层是本文实验的重要参数,采用网格搜索的方式调整这3个参数。模型的主要参数值见表2。此外设置早停机制,如果模型连续5轮训练性能没有提高,将自动停止训练并保留最佳模型。本文的句法依存树由开源工具Spacy的依存解析器生成。本文采用准确率(ACCuracy,ACC)和Macro-F1(F1)评估针对特定方面情感分类模型的性能。

表2 每个数据集的主要参数值

2.3 对比的基准模型

为了评估本文模型的性能,选择了以下前沿模型作为基准模型:

1)长短时记忆(Long Short-Term Memory, LSTM)网络[17]。使用单一模型LSTM的隐藏层的输出进行情感分类。

2)目标相关的长短时记忆(Target-Dependent LSTM, TD-LSTM)网络[1]。将句子以方面词为界分为左右两个部分,分别输入LSTM,将左上下文和右上下文的隐藏状态转移到目标以获得情感信息。

3)基于注意的方面嵌入的长短时记忆(ATtention-based LSTM with Aspect Embedding, ATAE-LSTM)网络[19]。为了更好地捕获方面信息,将方面词嵌入向量和上下文嵌入向量拼接后输入LSTM,得到的隐藏层输出结合注意力机制捕获方面词和上下文的依赖信息进行情感分类。

4)深度交互式记忆网络(Deep Interactive Memory Network, DIMN)[20]。基于注意力和特殊门控机制构建了一个深度交互记忆网络,以捕获目标和上下文的多个交互,为目标和上下文生成特定的记忆,有助于情感分类。

5)注意力编码网络(Attentional Encoder Network, AEN)[15]。针对循环神经网络(Recurrent Neural Network, RNN)难以并行化的问题,设计了一种基于多头注意力编码的网络在上下文和方面词之间建模。

6)IAN[3]。基于LSTM和注意力机制的交互式注意力网络。利用与目标相关联的注意力机制从上下文中提取重要信息,生成上下文表示;同理,利用上下文与目标的交互信息监督目标的生成,拼接向量后用于情感分类。

7)具有语义依赖和上下文矩的深度掩码记忆网络(Deep Mask Memory Network with Semantic Dependency and Context Moment, DMMN-SDCM)[21]。一种具有语义依赖和上下文时刻的深度掩码记忆网络。将方面的语义解析信息和方面间的相关信息集成在记忆网络中,引用语义解析信息代替传统的位置信息引导注意力机制,同时有效学习其他非目标方面提供的信息。

8)AOA-MultiACIA(Attention-Over-Attention Multi-layer Aspect-Context Interactive Attention)[22]。一种上下文和方面词的深层交互模型,仅依赖注意力机制在上下文中捕获特定方面相关特征,合成更精确的方面词表示。

9)具有位置感知的分层门控深度记忆网络(Hierarchical Gated Deep Memory network with Position-Aware, HGDM-PA)[23]。提出了细粒度信息交互机制,对方面词和上下文之间的词级交互建模,并且将位置信息作为特征嵌入句子的表示中,从而获得句子和方面词的特征表示。

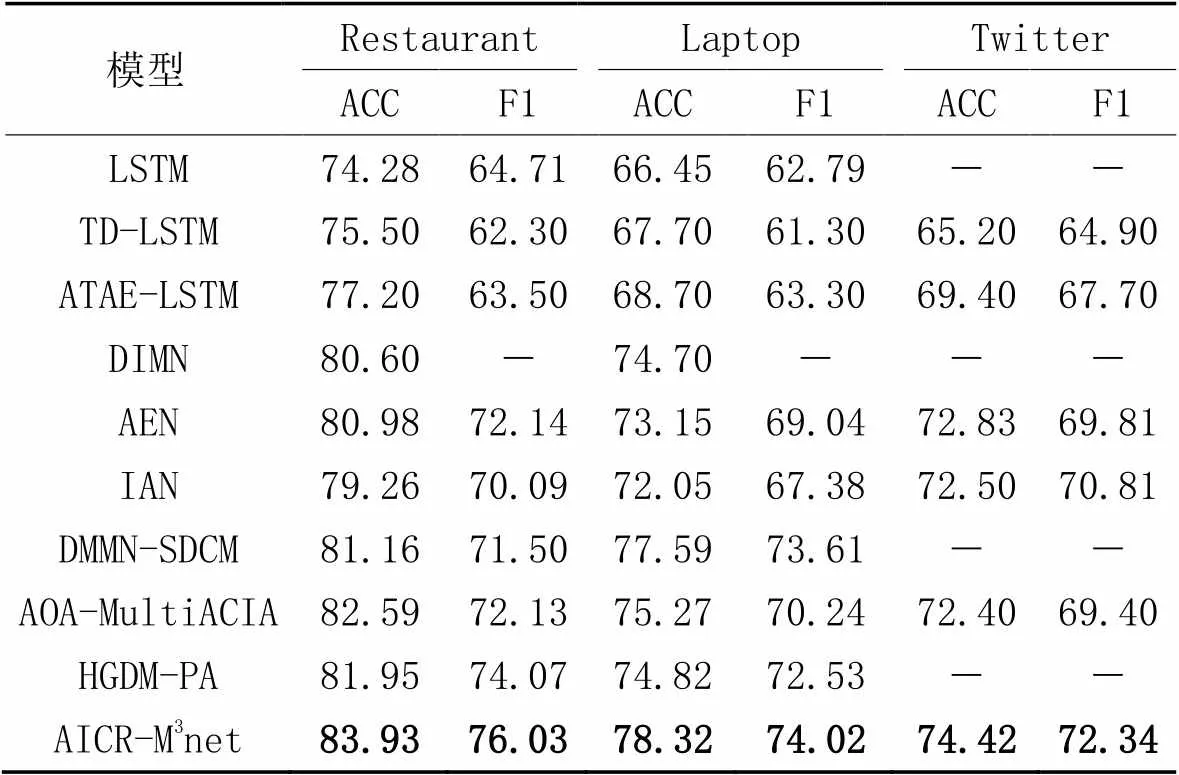

实验结果如表3所示。可以看出,本文模型在3个数据集上的方面情感分类结果均为最优,在Restaurant、Laptop和Twitter数据集上,比AOA-MultiACIA的分类准确率分别提升了1.34、3.05和2.02个百分点,F1分别提升了3.90、3.78和2.94个百分点。结果表明对方面短语单独建模并利用其他非目标方面的情感依赖信息,对特定方面的情感分类的准确率的提高有一定作用。

传统的LSTM、TD-LSTM模型仅粗粒度学习上下文的语义关系,对方面项前后的上下文赋予的权重一致,无法考虑到上下文中方面词的信息。一般地,基于注意力的模型优于基于LSTM的模型,ATAE-LSTM在方面词的监督下,使用单个注意力对句子和目标建模,在Restaurant和Laptop数据集上,相较于LSTM和TD-LSTM,分类准确率分别提升了1.70~2.92和1.00~2.25个百分点。由于数据集中可能出现多个方面项,因此考虑到方面项和上下文交互作用的AOA-MultiACIA、AEN、IAN模型在3个基准数据集上的表现均优于基于单个注意力机制的ATAE-LSTM模型。而本文模型基于M3net,实质是多重注意网络,相较于ATAE-LSTM,在3个数据集上的分类准确率分别提升了6.73、9.62和5.02个百分点。说明基于方面项引导注意力机制对捕获方面项相关的情感特征是有效的。

在Restaurant和Laptop数据集上,本文模型相较于性能较好的HGDM-PA的分类准确率分别提升了1.98和3.50个百分点。HGDM-PA和本文模型都使用记忆网络,区别是本文的记忆网络在残差连接的基础上对每一个计算层外部记忆和查询特征向量更新,经过多个计算层,每一层都利用特定方面项和句子中其他方面的情感信息合成更精确的特定方面的上下文表示。DMMN-SDCM在深度掩码记忆网络中有效学习其他非目标方面提供的信息,在Laptop数据集上分类准确率仅次于本文模型。本文模型同样使用一个句子中特定方面项和其他方面项的依赖关系对上下文建模,比其他基准模型的分类准确率高。

表3 不同数据集上的方面情感分类实验结果 单位:%

2.3.1模型消融分析

为了验证AICR-M3net各个子模块对模型性能的影响,本文对模型进行了消融,分别在Restaurant、Laptop和Twitter数据集上进行实验,结果见图2。

从图2可以看出,消融后的模型在3个数据集上的分类准确率和F1评估指标都不如原始模型,表明,被消融的子模块对提高模型性能至关重要。首先,混合上下文编码前取消对句子表示的位置编码(AICR-M3net w/o POS),在3个数据集上的准确率和F1均有一定的下降,表明接近特定方面项的词语对最终的情感分析预测有一定的作用。其次,用Bi-GRU代替方面项单独建模(AICR-M3net w/o A),在3个数据集上的分类准确率也有一定程度的下降。最后,取消使用方面间情感依赖引导特定方面项的上下文生成(AICR-M3net w/o IA),相较于前两次消融,模型的效果进一步下降,表明建模特定方面项与句子中其他方面项情感依赖性对最终的情感分类起着关键作用。

图2 移除关键模块对准确率和F1值的影响

2.3.2记忆网络的层数对性能的影响

为了验证多重多跳记忆网络的层数对模型性能的影响,在Restaurant、Laptop和Twitter数据集上设置层数从1到8进行实验,以准确率和F1为评价指标,得到在不同层数下,AICR-M3net在3个数据集上的方面情感分类的准确率和F1值,结果如表4所示。

表4 M3net层数对准确率和F1值的影响 单位:%

从表4可以看出,多个计算层对模型情感分类能力的提升是有效的。在Restaurant数据集上,设置多重多跳记忆网络的层数为5时,准确率和F1都最高;在Laptop数据集上设置层数为3时,模型达到最佳性能;在Twitter数据集上,当记忆网络计算层为6时,准确率和F1最高。因此,在设置模型的超参数时,在Restaurant、Laptop和Twitter数据集上分别设置层数为5、3、6。这说明具有不同层数记忆网络的模型的分类性能不同,表明AICR-M3net对特定目标和其他非特定目标项的情感依赖信息进行了有效的建模,生成了与特定目标更相关的上下文特征向量表示。当跳级数大于5时,模型在3个公开数据集上的性能开始下降,这是因为随着层数增多,模型参数也增多,出现过拟合现象,因此设置合适的参数有助于分类性能的提高。

2.4 模型泛化能力实验

利用本文模型和基准模型IAN[15]、ATBL-MHMN[15]模型进行分类性能的对比分析,以此研究本文模型的泛化能力。将样本数据集Restaurant和Laptop根据评论句子中含有单个方面或多个方面进行分类形成4个数据集,分别为Restaurant单方面、Restaurant多方面、Laptop单方面和Laptop多方面。分别在这4个数据集上展开实验,得到各个模型在单方面和多方面数据集上情感分类的结果,如表5所示。

表5 在单方面和多方面数据集上的情感分类准确率 单位:%

由表5可知,本文模型在2个单方面数据集上的情感分类准确率比IAN模型提高了7.20个百分点和4.90个百分点,由此可见本文模型对于只含有一个方面项的评论句子进行情感分类时性能有所提升。本文模型在2个多方面数据集上的分类准确率比IAN模型提高了5.80个百分点和6.50个百分点,比ATBL-MHMN模型提高了3.02个百分点和4.00个百分点。由于单个句子中方面项的个数增加,导致单个句子中情感信息增多,IAN模型在区分特定方面项对应的情感信息上优势减弱,故分类准确率降低。ATBL-MHMN模型在Bi-LSTM的基础上,使用了端到端记忆网络,一定程度上提高了模型的分类性能。本文模型除了引入方面项的位置信息外,将GRU融入记忆网络中剔除冗余信息,分别生成方面项和特定方面项句子的上下文表示,多次提取特定方面项的情感依赖信息,同时对方面项进行单独建模。根据以上分析,本文模型能很好地处理多方面评论句子的情感极性分类,泛化能力较强。

3 结语

本文通过Bi-GRU融合上下文中每个词的位置权重,用多头注意力机制得到句子的语义编码,使用改进的多层记忆网络捕获方面项之间的情感依赖关系,生成特定上下文的方面项表示和特定方面项的上下文表示,以确定特定方面项在句子中的情感极性。在3个公开数据集上的实验结果表明,本文模型能够有效处理上下文中的方面混合信息,可以构建与特定方面项更相关的情感特征向量。未来将进一步完善模型,提高模型的语义识别能力,以更好地分析一些不符合语法的句子,进一步扩大模型的应用范围。

[1] TANG D, QIN B, FENG X, et al. Effective LSTMs for target-dependent sentiment classification[C]// Proceedings of the 26th International Conference on Computational Linguistics: Technical Papers. [S.l.]: The COLING 2016 Organizing Committee, 2016: 3298-3307.

[2] HUANG B, OU Y, CARLEY K M. Aspect level sentiment classification with attention-over-attention neural networks[C]// Proceedings of the 2018 International Conference on Social Computing, Behavioral-Cultural Modeling and Prediction and Behavior Representation in Modeling and Simulation, LNCS 10899. Cham: Springer, 2018: 197-206.

[3] MA D, LI S, ZHANG X, et al. Interactive attention networks for aspect-level sentiment classification[C]// Proceedings of the 26th International Joint Conference on Artificial Intelligence. California: ijcai.org, 2017: 4068-4074.

[4] WESTON J, CHOPRA S, BORDES A. Memory networks[EB/OL]. (2015-11-29) [2022-04-13].https://arxiv.org/pdf/1410.3916.pdf.

[5] SUKHBAATAR S, SZLAM A, WESTON J, et al. End-to-end memory networks[C]// Proceedings of the 28th International Conference on Neural Information Processing Systems — Volume 2. Cambridge: MIT Press, 2015: 2440-2448.

[6] TANG D, QIN B, LIU T. Aspect level sentiment classification with deep memory network[C]// Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2016: 214-224.

[7] CHEN P, SUN Z, BING L, et al. Recurrent attention network on memory for aspect sentiment analysis[C]// Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2017: 452-461.

[8] WANG S, MAZUMDER S, LIU B, et al. Target-sensitive memory networks for aspect sentiment classification[C]// Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Stroudsburg, PA: ACL, 2018: 957-967.

[9] ZHANG C, LI Q, SONG D. Aspect-based sentiment classification with aspect-specific graph convolutional networks[C]// Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing. Stroudsburg, PA: ACL, 2019: 4568-4578.

[10] XIAO Y, ZHOU G. Syntactic edge-enhanced graph convolutional networks for aspect-level sentiment classification with interactive attention[J]. IEEE Access, 2020, 8: 157068-157080.

[11] ZHA Y, XIE Y, HUANG Q, et al. Aspect level sentiment classification with multi-scale information[C]// Proceedings of the 2nd International Conference on Electronics, Communications and Information Technology. Piscataway: IEEE, 2021: 279-285.

[12] HAN H, QIN X, ZHAO Q. Interactive attention graph convolution networks for aspect-level sentiment classification[C]// Proceedings of the 3rd International Conference on Artificial Intelligence and Advanced Manufacture. Piscataway: IEEE, 2021: 271-275.

[13] BAI X, LIU P, ZHANG Y. Investigating typed syntactic dependencies for targeted sentiment classification using graph attention neural network[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 503-514.

[14] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 770-778.

[15] SONG Y, WANG J, JIANG T, et al. Attentional encoder network for targeted sentiment classification[EB/OL]. (2019-04-01) [2022-07-05].https://arxiv.org/pdf/1902.09314.pdf.

[16] 卢天兰,陈荔. 面向方面级别情感分析的端到端多跳记忆网络[J]. 计算机应用研究, 2021, 38(5): 1409-1415, 1427.(LU T L, CHEN L. End-to-end multi-hop memory network for aspect-level sentiment analysis[J]. Application Research of Computers, 2021, 38(5): 1409-1415, 1427.)

[17] DONG L, WEI F, TAN C, et al. Adaptive recursive neural network for target-dependent Twitter sentiment classification[C]// Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics (Volume 2: Short Papers). Stroudsburg, PA: ACL, 2014: 49-54.

[18] PONTIKI M, GALANIS D, PAVLOPOULOS J, et al. SemEval-2014 Task 4: aspect based sentiment analysis[C]// Proceedings of the 8th International Workshop on Semantic Evaluation. Stroudsburg, PA: ACL, 2014:27-35.

[19] WANG Y, HUANG M, ZHU X, et al. Attention-based LSTM for aspect-level sentiment classification[C]// Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2016: 606-615.

[20] SUN C, LV L, TIAN G, et al. Deep interactive memory network for aspect-level sentiment analysis[J]. ACM Transactions on Asian and Low-Resource Language Information Processing, 2021, 20(1): No.3.

[21] LIN P, YANG M, LAI J. Deep mask memory network with semantic dependency and context moment for aspect level sentiment classification[C]// Proceedings of the 28th International Joint Conference on Artificial Intelligence. California: ijcai.org, 2019: 5088-5094.

[22] WU Z, LI Y, LIAO J, et al. Aspect-context interactive attention representation for aspect-level sentiment classification[J]. IEEE Access, 2020, 8: 29238-29248.

[23] JIA Z, BAI X, PANG S. Hierarchical gated deep memory network with position-aware for aspect-based sentiment analysis[J]. IEEE Access, 2020, 8: 136340-136347.

Aspect sentiment analysis with aspect item and context representation

XU Dan, GONG Hongfang*, LUO Rongrong

(,,410114,)

When predicting the emotional polarity of a specific aspect, there is a problem of only depending on a single aspect item and ignoring the emotional dependence between aspect items in the same sentence, a Multi-layer Multi-hop Memory network with Aspect Item and Context Representation (AICR-M3net) was proposed. Firstly, the position weighting information was fused by Bi-directional Gated Recurrent Unit (Bi-GRU), and the hidden layer output was used as the input of the mixed context coding layer to obtain a context representation with higher semantic relevance to the context. Then, Multi-layer Multi-hop Memory Networks (M3net) was introduced to match aspect words and context many times and word by word to generate aspect word vectors of specific context. At the same time, the emotional dependence between specific aspect item and other aspect items in the sentence was modeled to guide the generation of context vector of specific aspect item. Experimental results on Restaurant, Laptop and Twitter datasets show that the proposed model has the classification accuracy improved by 1.34, 3.05 and 2.02 percentage points respectively, and the F1 score increased by 3.90, 3.78 and 2.94 percentage points respectively, compared with AOA-MultiACIA (Attention-Over-Attention Multi-layer Aspect-Context Interactive Attention). The above verifies that the proposed model can deal with the mixed information with multiple aspects in context more effectively, and has certain advantages in dealing with the sentiment classification task in specific aspects.

aspect-specific sentiment analysis; emotional dependence; Memory Network (MN); Multi-Head Attention (MHA) mechanism; Gated Recurrent Unit (GRU)

This work is partially supported by National Natural Science Foundation of China (61972055), Natural Science Foundation of Hunan Province (2021JJ30734).

XU Dan, born in 1997, M. S. candidate. Her research interests include natural language processing, sentiment analysis.

GONG Hongfang, born in 1968, Ph. D., professor. His research interests include machine learning, intelligent information processing, queuing theory and its applications.

LUO Rongrong, born in 1997, M. S. candidate. Her research interests include natural language processing, sentiment analysis.

1001-9081(2023)10-3086-07

10.11772/j.issn.1001-9081.2022101482

2022⁃10⁃11;

2023⁃04⁃04;

国家自然科学基金资助项目(61972055);湖南省自然科学基金资助项目(2021JJ30734)。

徐丹(1997—),女,湖南娄底人,硕士研究生,主要研究方向:自然语言处理、情感分析; 龚红仿(1968—),男,湖北天门人,教授,博士生导师,博士,CCF会员,主要研究方向:机器学习、智能信息处理、排队论及应用; 罗容容(1997—),女,湖南邵阳人,硕士研究生,主要研究方向:自然语言处理、情感分析。

TP391.1

A

2023⁃04⁃10。