基于不可分提升小波的双U-Former图像去雨网络

2023-10-21刘斌方思严

刘斌,方思严

基于不可分提升小波的双U-Former图像去雨网络

刘斌,方思严*

(湖北大学 计算机与信息工程学院,武汉 430062)( ∗ 通信作者电子邮箱 fangsiyanfsy@163.com)

针对基于张量积小波的去雨方法无法捕获所有方向的高频雨纹的问题,提出基于不可分提升小波的双U-Former网络(DUFN)。首先,利用各向同性的不可分提升小波捕捉各个方向的高频雨纹,相较于哈尔小波等张量积小波只能捕捉3个方向的高频雨纹,DUFN能获得更全面的雨纹信息;其次,在各尺度上串联两个由Transformer Block(TB)构成的U-Net,将浅层解码器的语义特征传递到深层阶段,并更彻底地去除雨纹;同时,使用尺度引导编码器通过浅层各尺度信息引导编码阶段,并利用基于CBAM(Convolutional Block Attention Module)的门控融合模块(GFM)使融合过程更专注于有雨区域。实验结果表明,相较于先进方法SPDNet(Structure-Preserving Deraining Network),在Rain200H、Rain200L、Rain1200和Rain12这4个合成数据集上,DUFN的结构相似度(SSIM)平均提高了0.009 7,在Rain200H、Rain200L和Rain12这3个合成数据集上,DUFN的峰值信噪比(PSNR)平均提高了0.657 dB;在真实世界数据集SPA-Data上,相较于先进方法ECNetLL(Embedding Consistency Network+Layered Long short-term memory),DUFN的PSNR和SSIM分别提高了0.976 dB和0.003 1。验证了DUFN可以通过增强捕捉高频信息的能力提升去雨性能。

图像去雨;不可分提升小波;多尺度;Transformer;尺度引导

0 引言

雨天等恶劣天气会造成图像和视频质量退化,尤其是常见的雨纹会影响计算机视觉处理算法的性能,造成目标检测、语义分割等算法的可靠度和精确性下降。因此,研究图像去雨网络具有十分重要的意义。

现有的去雨方法主要分为基于视频的方法[1-2]和基于图像的方法。基于视频的方法[1-2]根据相邻帧图像之间的差异提取并去除雨纹,但是图像去雨任务缺乏时空信息,只包含某一时刻的雨纹分布情况,去雨难度很大。

传统的雨天模型由雨纹和背景组成,数学上可表示为:

其中:代表雨天图像;代表干净的背景图像;代表雨纹图像。

传统的去雨方法主要通过探索先验知识,利用雨纹的物理特征恢复无雨图像。Kang等[3]通过稀疏编码从高频层中分离雨纹;Li等[4]利用高斯混合模型将雨纹从背景层中分离;Chen等[5]提出基于低秩表示的方法,通过利用低秩模型去除雨纹。

近年,许多基于深度学习的方法通过从人工合成的大量数据中学习复杂的模型用于去雨。如Fu等[6]较早地将深度学习用于图像去雨,将雨天图像通过导向滤波分解为低频和高频,对高频部分使用卷积神经网络训练;Fu等[7]又提出基于深度残差结构的网络,通过减少从输入到输出的映射范围,使学习过程更容易;Li等[8]引入“雨嵌入一致性”思想,通过提高理想雨嵌入与编码器导出雨嵌入之间的一致性提高去雨性能;Chen等[9]使用在大型数据集lmageNet上预训练的Transformer恢复干净图像。

由于不同雨纹在形状、尺寸和密度上各不相同,一些方法通过多尺度策略利用不同层次特征的信息提取雨纹。Li等[10]通过循环利用具有扩张因子的卷积核和挤压激励模块消除密集雨纹。Jiang等[11]根据金字塔架构提出了一种多尺度渐进融合网络,并使用注意力机制指导不同尺度信息的融合。Wang等[12]探索跨尺度方式和内部尺度融合方法,实现去雨目标。Wang等[13]用尺度引导方式探索了不同尺度之间的相关性。然而,目前大部分多尺度方法采用具有不同内核大小和步幅的池化操作获取多尺度特征,这种方法虽然简单但容易丢失信息。

小波多尺度分析在图像处理领域被认为是较好的多尺度策略。SPDNet(Structure-Preserving Deraining Network)[14]等方法通过哈尔小波获取多尺度特征,有助于减少采样期间信息丢失并保留更多纹理细节;但是哈尔小波等由一维小波形成的张量积小波只强调水平、垂直和对角线方向上的高频,不具有各向同性。在真实场景中,雨纹在风或其他外力的作用下呈现的方向是随机的,张量积小波只能捕获3个方向上的高频雨纹,忽略了其他方向的雨纹。具有各项同性的不可分提升小波[15]能捕捉各个方向的高频雨纹。本文通过不可分提升小波实现多尺度策略,既有助于避免采样过程中信息丢失的问题,还能捕获各个方向的高频雨纹。

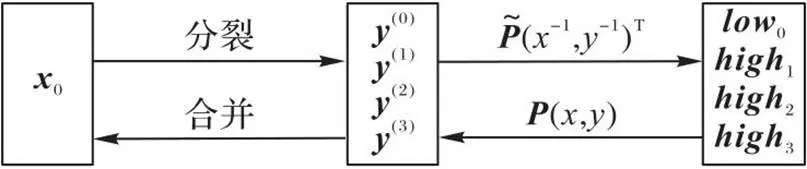

U-Net[16]是目前广泛使用的多尺度架构,已成功应用于语义分割等多个领域。较近的MCW-Net(Multi-level Connection and Wide regional non-local block Network)[17]、A2Net(Adjacent Aggregation Network)[18]等方法采用基于U-Net的主干架构去雨;但是传统单U-Net的编码‒解码模型和普通卷积模块在处理复杂雨天图像时容易遇到瓶颈,难以捕捉与背景相似的雨纹。DoubleU-Net[19]叠加组合两个U-Net,在分割任务中取得了不错效果。Uformer[20]将具有长距离依赖功能的Transformer嵌入U-Net,实现了高效图像复原。因此,本文结合DoubleU-Net和Uformer的优势提出双U-Former网络(Dual U-Former Network, DUFN),多尺度串联两个由Transformer Block(TB)[21]构成的U-Net,在捕获远距离雨纹的同时让浅层阶段各尺度特征传递到深层阶段,增强特征复用能力。DUFN利用基于CBAM(Convolutional Block Attention Module)[22]的门控融合模块(Gated Fusion Module, GFM),在引导和融合阶段根据特征的重要程度灵活调整来自不同特征图的贡献,使网络专注于有雨区域,提高雨纹捕捉能力。此外,由于浅层阶段含有丰富雨纹细节信息,受文献[13]启发,本文设计了尺度引导编码器,利用浅层编码阶段多尺度信息指导去雨,使浅层丰富的雨纹细节更容易被捕获。本文在合成数据集、真实雨天数据集和联合目标检测任务中进行了广泛实验,结果表明DUFN优于目前先进的方法。

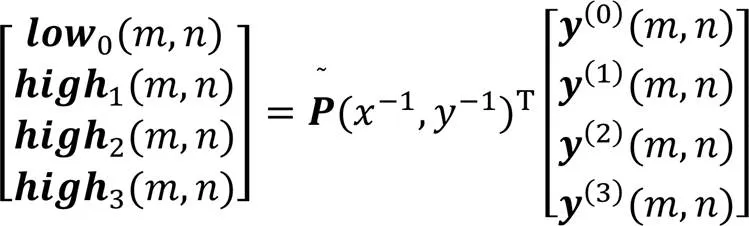

1 不可分提升小波

二维不可分小波通过按行列同时进行的方式处理图像,具有各向同性的特点,因此去雨时它能捕获各个方向的雨纹,但是基于傅里叶变换理论和卷积运算构造的二维不可分小波计算量大。为节省计算资源,本文使用它的提升方式,即二维不可分提升小波,实现多尺度策略。它既可以较好地保留各向同性的特点,又能提高运算速度。同时,二维不可分提升小波在处理图像时首先对像素点分类以实现分裂,其次把二维预测算子、更新算子或提升分解后的多相位矩阵作用于分裂后的子图像,而不对图像进行抽样和插值,因此可以避免信息的丢失。

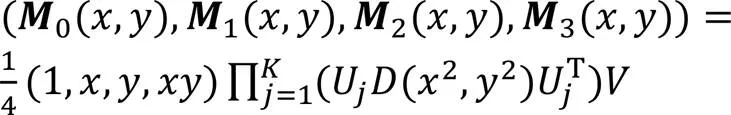

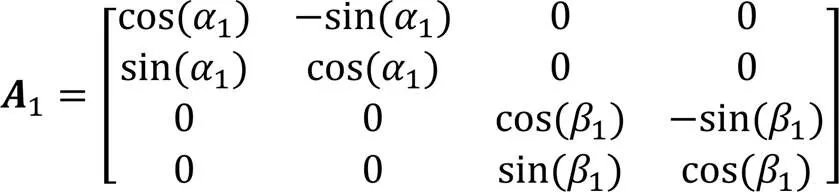

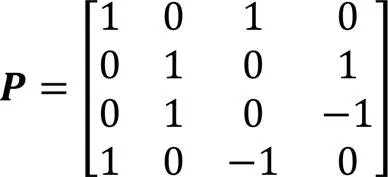

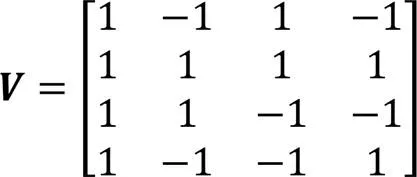

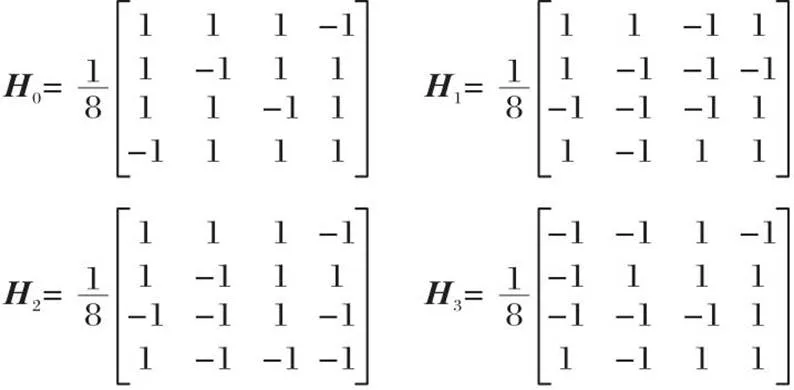

1.1 构造不可分小波滤波器

图1 有理数滤波器组

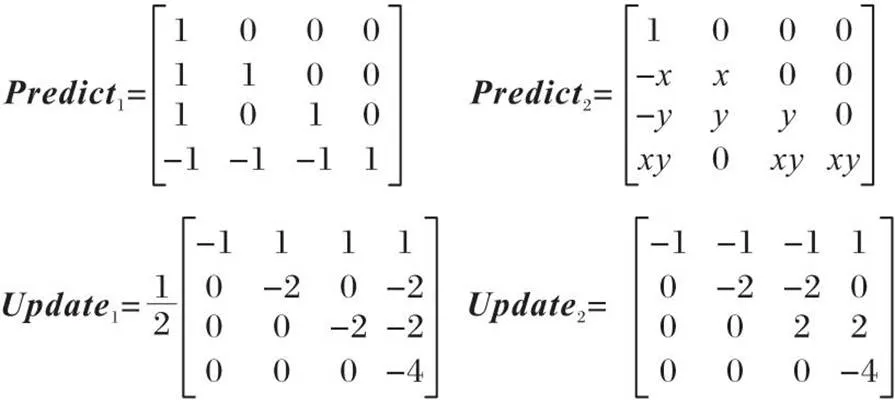

1.2 提升方案

图2 预测算子和更新算子

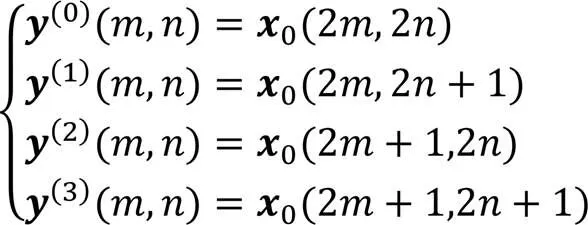

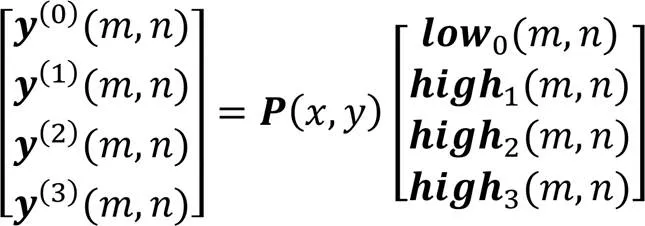

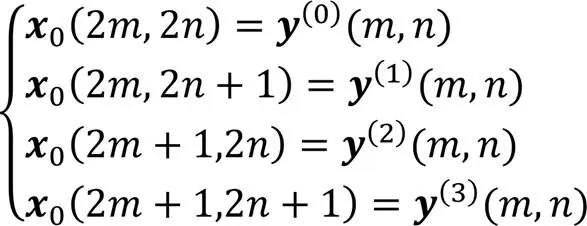

1.3 对图像分解与重构

传统的第一代小波先使用设计的低通滤波器和高通滤波器对图像卷积,再进行下2抽样得到分解子图;而重构算法是先对图像上2插值,再使用低通滤波器和高通滤波器卷积。基于多相位矩阵的提升方案,通过对分裂后的子集分别使用左下三角矩阵和右上三角矩阵进行连续作用,得到图像的低频和高频部分,实现分解。该提升方案提高了图像分解和重构的速度,节省了运算量。通过上述多相位矩阵对图像分解和重构的过程如图3所示,具体步骤如下。

其中和分别表示像素点的横、纵坐标。

图3 图像的不可分提升小波分解与重构过程

图4 不可分提升小波和哈尔小波的分解效果

2 双U⁃Former网络

2.1 整体架构

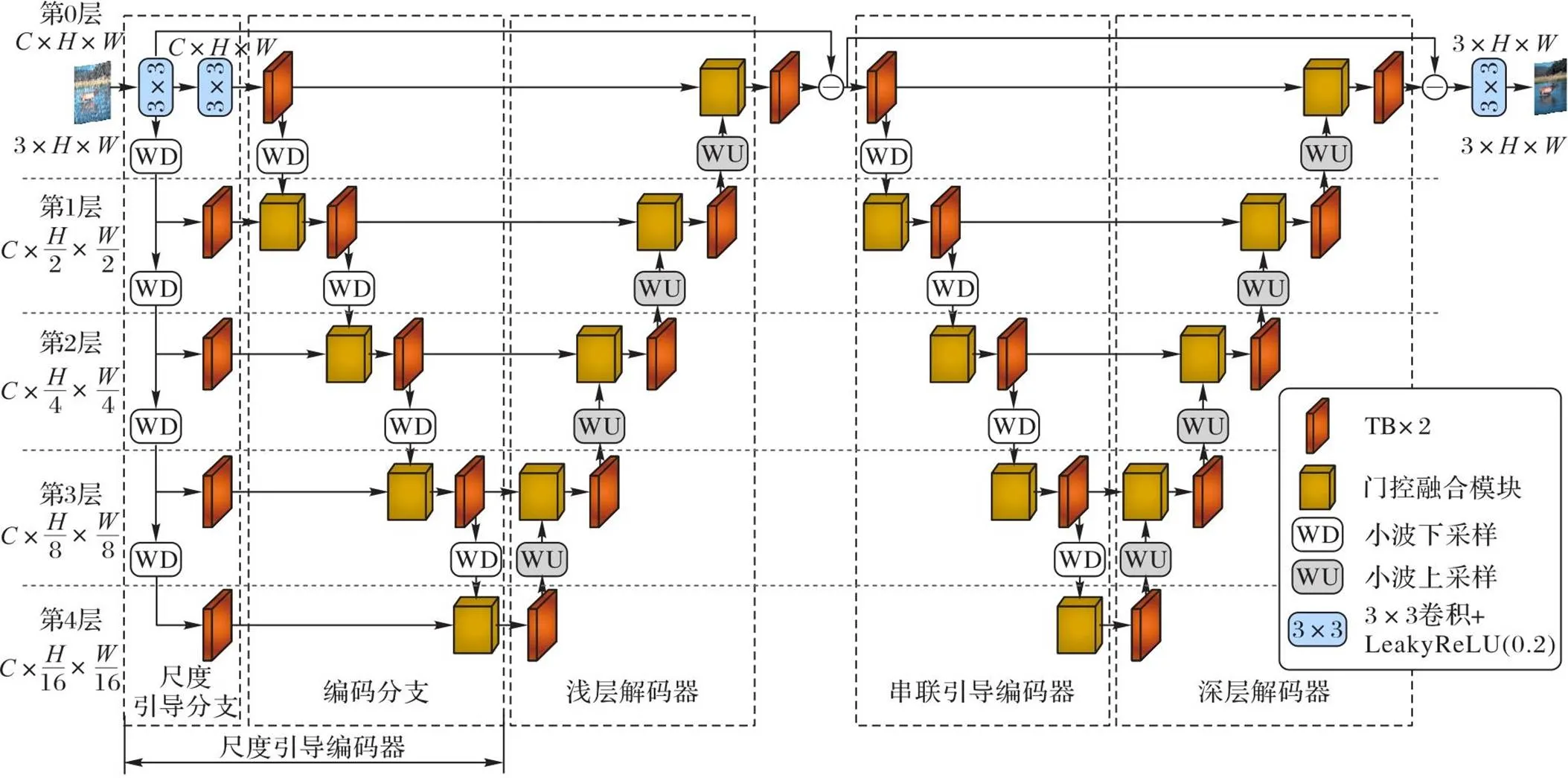

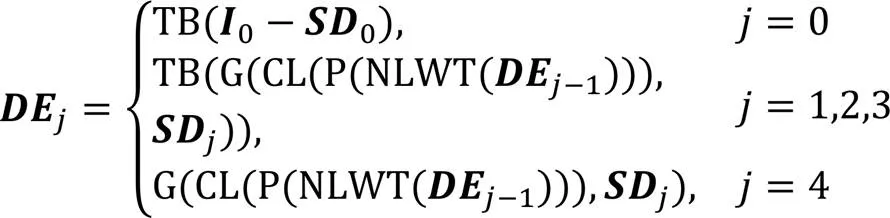

如图5所示,DUFN由两个基于TB构成的U-Net通过多尺度串联而成,主要分为浅层阶段和深层阶段。浅层阶段负责去除图像中简单的雨纹,由尺度引导编码器和浅层解码器组成,尺度引导编码器通过利用浅层多尺度信息引导编码过程,使雨纹更容易被捕获并保留细节特征;深层阶段由串联引导编码器和深层解码器组成,旨在利用浅层解码器中丰富的语义信息去除结构更复杂的残留雨纹。TB凭借远程像素交互能力,可以捕捉更全面的雨纹信息。网络中所有融合过程均使用门控融合模块,以保留更多重要信息。

图5 双U-Former网络

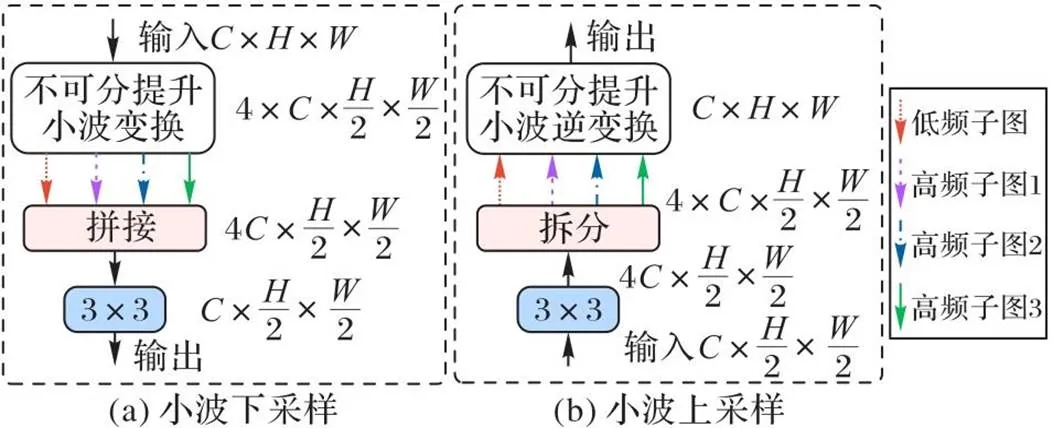

多尺度策略由如图6所示的小波上下采样实现,不可分提升小波作为尺度变换的核心工具,可在减少信息丢失的同时捕获各种方向的雨纹。

图6 小波上采样和小波下采样

2.2 尺度引导编码器

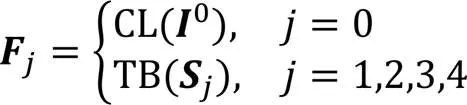

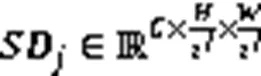

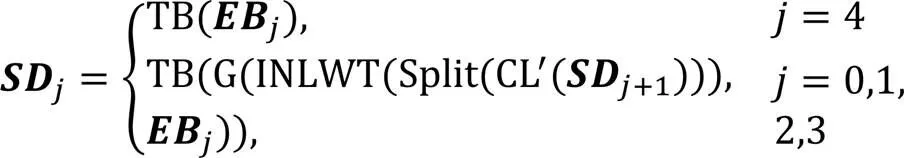

由于利用尺度的相关性引导去雨能取得更好的效果[13],且浅层网络含有丰富的细节信息,因此本文设计了尺度引导编码器,利用浅层多尺度信息以初步提取雨纹特征并保留更多细节信息。尺度引导编码器由尺度引导分支和编码分支组成。尺度引导分支先对图像进行不可分提升小波变换(Non-separable Lifting Wavelet Transform, NLWT),再将得到的子图拼接后通过卷积调整通道数,以实现紧凑表示。该过程可表示为如下形式:

2.3 串联引导编码器

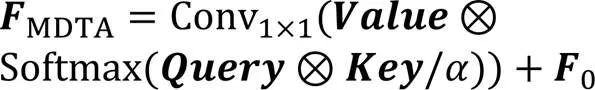

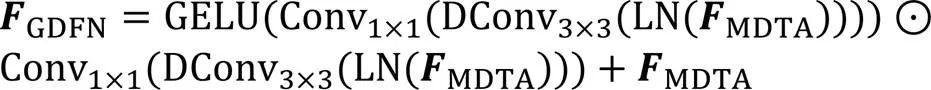

2.4 Transformer Block

Transformer凭借出色的性能在众多视觉任务中取得杰出表现。Zamir等[21]提出用于图像恢复的Transformer Block,能在高分辨率图像中捕获远程雨纹像素进行交互。如图7所示,Transformer Block由多深度卷积(Depth-wise Convolution, DConv)头部转置注意力(Multi-Dconv head Transposed Attention, MDTA)模块和门控Dconv前馈网络(Gated-Dconv Feed-forward Network, GDFN)组成。MDTA通过聚合局部和非局部像素交互,能够有效处理高分辨图像;GDFN通过抑制无用信息,允许有用信息通过,使网络更关注雨纹区域,产生高质量输出。

其中:表示3×3深度卷积;GELU表示高斯误差线性单元(Gaussian Error Linear Unit);LN表示层归一化;表示逐元素乘法。

2.5 门控融合模块

由于雨天图像的不同通道所含信息量不同,不同像素上的雨纹分布也并不均匀,受文献[24]启发,设计了基于CBAM[22]的门控融合模块(GFM)。GFM使用通道注意力给不同通道分配不同权重,利用空间注意力根据像素的重要程度灵活调整相应贡献,如图8所示。

图8 门控融合模块

2.6 损失函数

均方误差(Mean Square Error, MSE)是图像去雨任务中广泛使用的损失函数,但它没有考虑边缘、亮度等图像局部特征,通常导致高频细节模糊,而结构相似度(Structure SIMilarity, SSIM)损失[25]能很好地保留高频细节。为保持全局结构的完整性和每个像素的相似性,本文采用MSE和SSIM作为损失函数。两个损失函数用公式可以表示为:

通过结合均方误差损失函数和SSIM损失函数,本文总体损失函数可定义为:

3 实验与结果分析

3.1 数据集与评估指标

1)合成数据集。本文在Rain200H[26]、Rain200L[26]、Rain1200[27]和Rain12[4]这4种广泛使用的合成数据集上评估DUFN的性能。其中:Rain200H是合成大雨的数据集,Rain200L是合成小雨的数据集,Rain200H和Rain200L均包含1 800个用于训练的图像对和200个用于测试的图像对;Rain1200由不同密度的雨天图像组成,包含12 000张训练对和1 200张测试对;Rain12包含12个图像对,样本数少不适合单独训练,本文使用在Rain200H上训练的模型评估Rain12。消融实验均在Rain200H数据集上进行。

2)真实世界数据集。本文使用两个真实世界数据集评估DUFN的性能。SPA-Data[28]包含638 492张用于训练的图像对和1 000张用于测试的图像对;Internet-Data[29]包含147张雨天图像但缺乏干净背景图像。本文使用在Rain200H上训练的权重值定性评估。

3)评估标准。本文使用两个广泛使用的指标:峰值信噪比(Peak Signal-to-Noise Ratio, PSNR)[30]和结构相似度(SSIM)[25]作为合成数据集和真实世界SPA-Data的评估指标。由于Internet-Data的雨天图像没有相应的无雨背景图,本文仅比较视觉效果。

3.2 实验设置

3.3 与先进方法的比较

3.3.1在合成数据集上的结果

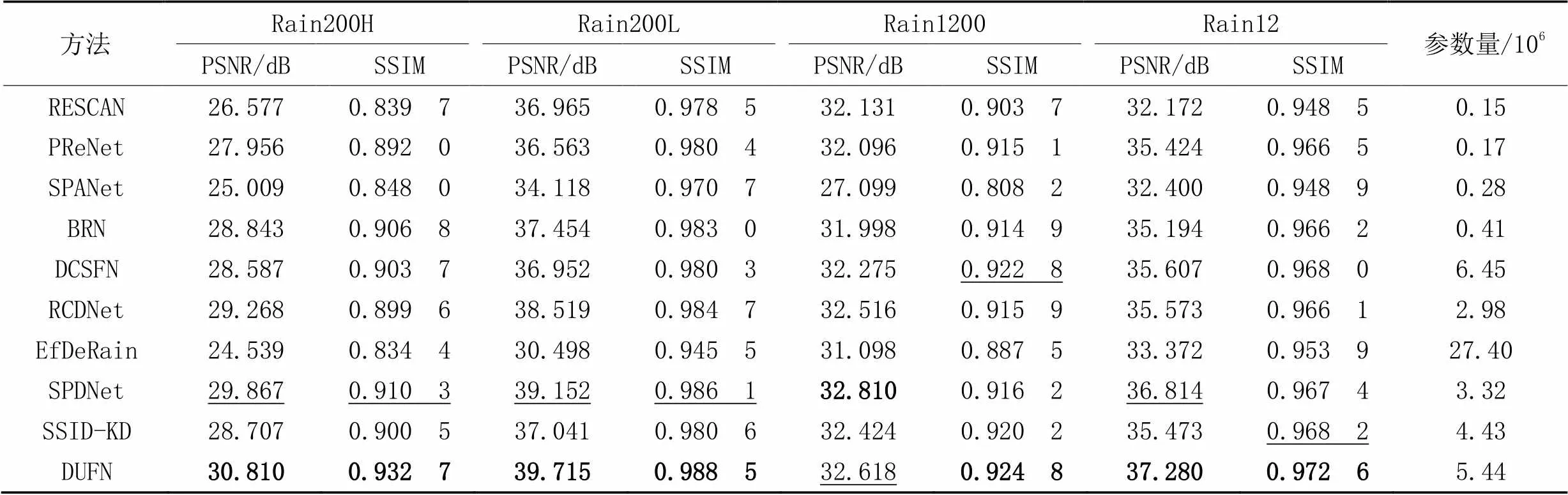

本文与9种先进方法在4个合成数据集上进行比较,对比方法分别为RESCAN(REcurrent Squeeze-and-excitation Context Aggregation Net)[10]、PReNet(Progressive Recurrent Networks)[32]、SPANet(Spatial Attentive Network)[28]、BRN(Bilateral Recurrent Network)[33]、DCSFN(Deep Cross-Scale Fusion Network)[12]、RCDNet(Rain Convolutional Dictionary Network)[34]、EfDeRain (Efficient-Derain)[35]、SPDNet[14]、SSID-KD(Semi-Supervised Image Deraining using Knowledge Distillation)[36]。

表1展示了定量比较结果。在Rain200H、Rain200L和Rain12数据集上,DUFN的PSNR均优于SPDNet,平均提升了0.657 dB;在Rain1200数据集上,略低于SPDNet,可能的原因是PSNR是基于像素点间误差的评价指标,SPDNet所使用的残差通道先验会影响网络的PSNR表现,它在不同场景中的效果不同,能在Rain1200数据集中发挥出较好效果,但未能有效提升网络的SSIM表现;在4个数据集上,DUFN的SSIM均高于SPDNet,平均提升了0.009 7。综合4个数据集上的结果,DUFN展现了最佳的去雨性能,表明DUFN能适应不同降雨条件,具有更好的鲁棒性和去雨效果。

表1 不同方法在合成数据集上的定量比较结果

注:粗体表示性能最好,下划线表示性能次优。

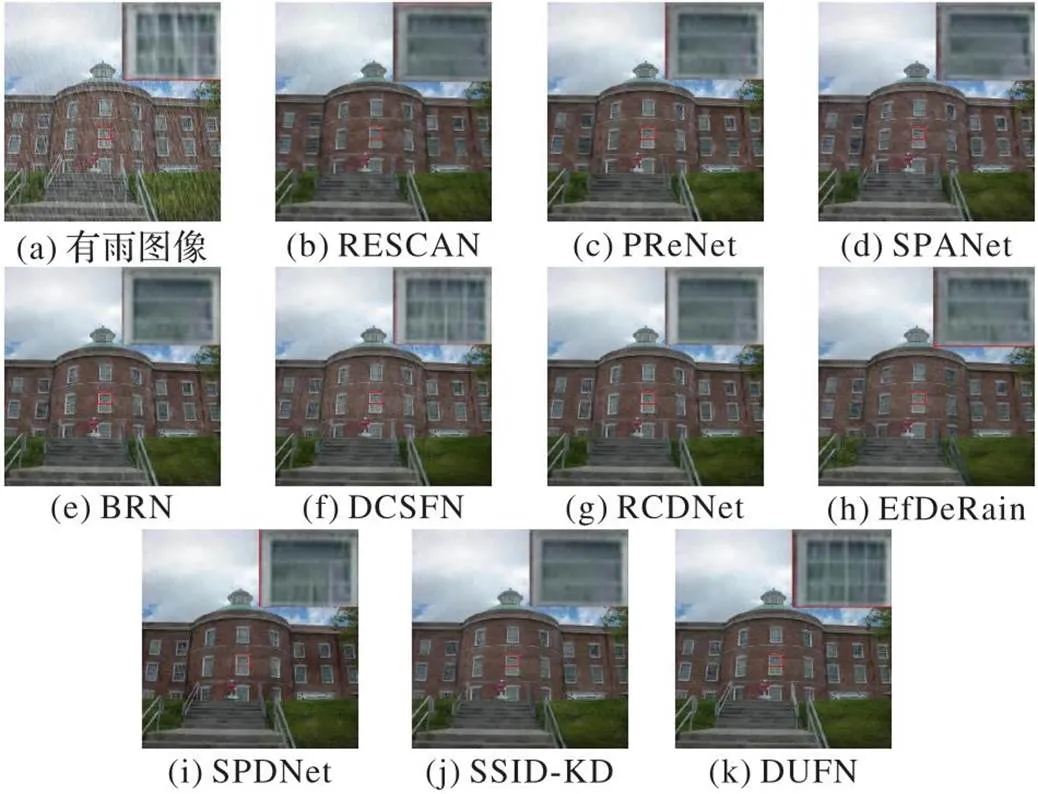

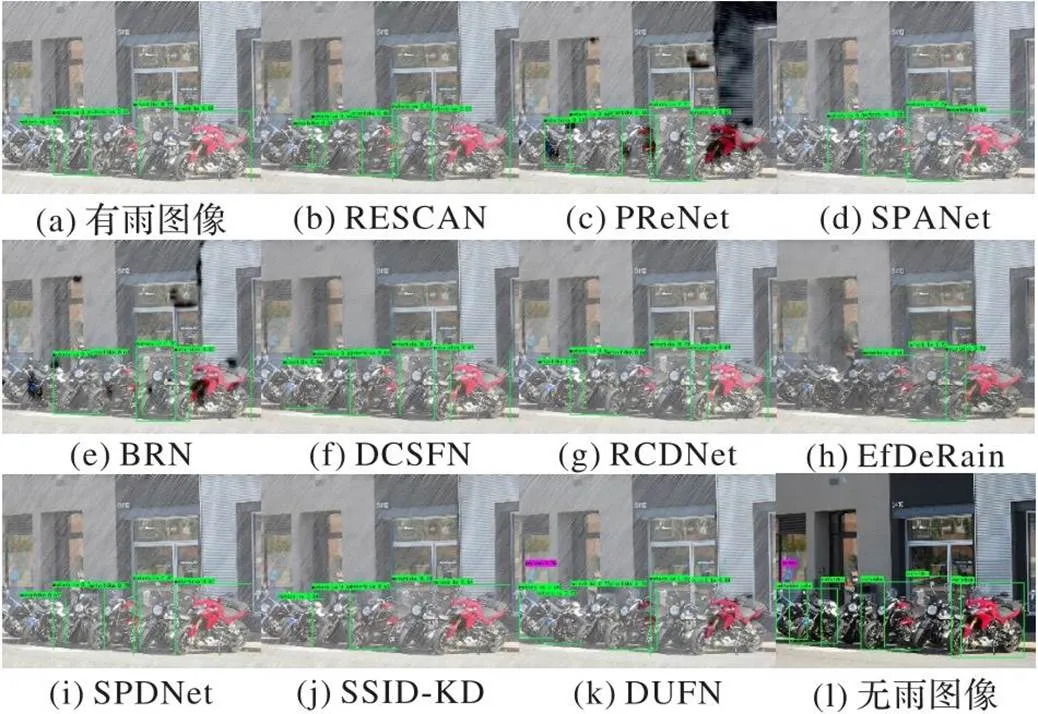

图9展示了在合成数据集上去雨的主观效果,可以看出,使用RESCAN、PReNet、SPANet去雨后的图像残留了过多雨纹;EfDeRain在恢复高频细节时容易导致过平滑现象;RCDNet、SPDNet、DCSFN容易残留与背景相似的雨纹;SSID-KD和BRN难以恢复高频边缘部分,而DUFN能更充分地去除雨纹并恢复出更清晰的细节信息。

3.3.2在真实雨天的结果

为了验证DUFN适用于真实雨天场景,与6种先进方法RESCAN、SPANet、RCDNet、EfDeRain、SPDNet和ECNetLL (Embedding Consistency Network+Layered Long short-term memory)[8]在SPA-Date上训练后进行了定量和定性比较。结果如表2所示,DUFN的PSNR和SSIM比ECNetLL分别提高了0.976 dB和0.003 1,两项指标仍然优于其他对比方法,在真实雨天数据集中维持了最佳性能。

图10展示了不同方法在SPA-Date上的视觉效果,可以观察到,相较于其他对比方法,DUFN能更充分地去除雨纹并保留更完整的背景信息。

由于Internet-Data中没有对应的干净图像,本文与9种先进方法使用在Rain200H上训练的模型进行定性分析。如图11所示,DCSFN和EfDeRain的去雨结果残留了较多雨雾,RESCAN、PReNet、SPANet、BRN、RCDNet、SPDNet和SSID-KD虽然能有效去除雨纹,但容易造成背景模糊和高频细节部分丢失,DUFN能在有效去除雨纹的同时恢复出更精细的高频细节。

图9 不同方法在合成数据集上的定性比较

表2 不同方法在真实雨天数据集SPA-Data上的定量比较

图10 不同方法在真实雨天数据集SPA-Data上的定性比较

图11 不同方法在真实雨天数据集Internet-Date上的定性比较

3.4 消融实验

3.4.1多尺度策略的消融实验

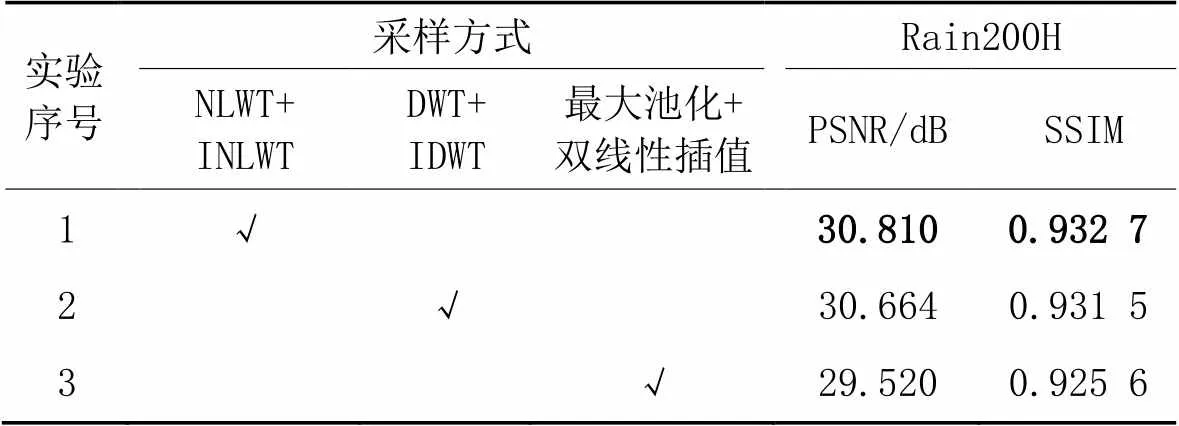

为验证不可分提升小波实现多尺度策略能减少信息丢失并保留更多细节,本文对比了其他两种不同的多尺度策略。实验1~3的设置和在Rain200H上的结果如表3所示。

视觉效果如图12所示:采用不可分提升小波实现多尺度的采样方式(实验1)取得了最佳性能;实验2恢复高频时使局部泛黄,实验3严重破坏了原有结构;而实验1通过不可分提升小波进行采样能减少信息丢失,保留更多细节。

表3 多尺度策略的消融实验结果

注:DWT和IDWT分别表示使用哈尔小波作为基函数的离散小波变换(Discrete Wavelet Transform)及其逆变换。

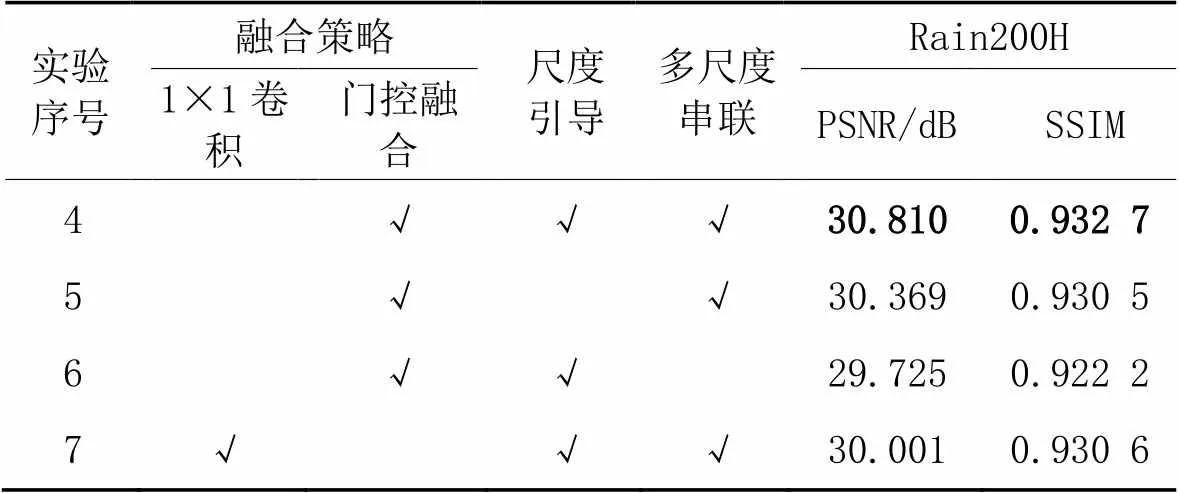

3.4.2各模块的消融实验

本文将不同模块进行多种组合,验证网络中所使用门控融合模块、尺度引导和多尺度串联的有效性。实验4~7的设置和在Rain200H上的实验结果如表4所示,其中,实验7中使用1×1卷积和LeakyReLU(0.2)激活函数代替门控融合模块。

表4 不同模块的消融实验结果

从表4可以看出,本文方法所用的每个子模块都有助于提升网络的性能,本文方法实现了最佳性能。视觉效果如图12所示,实验5恢复的图像在高频边缘部分变得模糊并丢失了纹理细节,实验6~7出现了色彩失真,而本文方法不仅能有效去除雨纹,还能恢复更详细的纹理细节。

图12 消融实验的视觉效果

3.5 目标检测应用

为了验证所提方法能增强高级视觉算法在雨天应用的性能,本文使用在Rain200H数据集上训练的模型对COCO350数据集[11]进行去雨处理,再使用YOLOv5s[37]进行目标检测。

表5展示了目标检测性能的定量结果,其中mAP50表示交并比(Intersection over Union, IoU)取值为0.5时的平均精度均值(mean Average Percision, mAP),值越高,效果越好。由表5可以看出,DUFN展现了最佳的去雨性能,大幅提升了检测准确度。视觉比较结果如图13所示,雨纹大幅降低了目标检测的准确度。本文方法生成的无雨图像能恢复更多清晰场景和细节内容,使目标检测算法识别出更多摩托车和行人目标,增强了目标检测的性能。

表5 不同方法在COCO350数据集上联合图像去雨和目标检测的比较结果 单位:%

图13 不同方法在COCO350数据集上联合图像去雨和目标检测的视觉效果

4 结语

本文提出的双U-Former网络(DUFN)使用不可分提升小波变换实现多尺度策略,在避免信息丢失的同时捕获各方向的雨纹。DUFN利用TB作为基本模块增强网络捕获远距离雨纹的能力。两个基于TB构造的U-Net在各尺度进行串联,使浅层解码器的语义信息充分传递到深层阶段,加强对不同尺度雨纹的提取能力。其中尺度引导编码器利用浅层各尺度特征对编码过程进行引导,使捕获到的雨纹位置更加准确。网络中所有特征融合过程均使用基于CBAM的门控融合模块进行,通过灵活调整不同特征的贡献程度对各像素和通道进行加权强化。定量和定性实验结果证明,本文方法在合成数据集和真实世界数据集以及应用于目标检测的结果都优于其他先进方法。本文方法的代码地址为https://github.com/fashyon/DUFN。

由于不同频域信息具有不同特点,即低频包含更多背景结构和颜色信息,高频包含更多细节信息,且雨纹更多存在于高频中,如果U-Net能在不同频域内学习,则能将图像去雨任务分解为在多个频域段进行的子任务,从而提高去雨效率。未来将结合频域知识设计自监督分频网络,在提高网络性能的同时节省收集数据集的人工成本。

[1] LIU J, YANG W, YANG S, et al. Erase or fill? deep joint recurrent rain removal and reconstruction in videos[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 3233-3242.

[2] YANG W, LIU J, FENG J. Frame-consistent recurrent video deraining with dual-level flow[C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 1661-1670.

[3] KANG L W, LIN C W, FU Y H. Automatic single-image-based rain streaks removal via image decomposition[J]. IEEE Transactions on Image Processing, 2012, 21(4): 1742-1755.

[4] LI Y, TAN R T, GUO X, et al. Rain streak removal using layer priors[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 2736-2744.

[5] CHEN Y L, HSU C T. A generalized low-rank appearance model for spatio-temporally correlated rain streaks[C]// Proceedings of the 2013 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2013: 1968-1975.

[6] FU X, HUANG J, DING X, et al. Clearing the skies: a deep network architecture for single-image rain removal[J]. IEEE Transactions on Image Processing, 2017, 26(6): 2944-2956.

[7] FU X, HUANG J, ZENG D, et al. Removing rain from single images via a deep detail network[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 1715-1723.

[8] LI Y, MONNO Y, OKUTOMI M. Single image deraining network with rain embedding consistency and layered LSTM[C]// Proceedings of the 2022 IEEE/CVF Winter Conference on Applications of Computer Vision. Piscataway: IEEE, 2022: 3957-3966.

[9] CHEN H, WANG Y, GUO T, et al. Pre-trained image processing transformer[C]// Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2021: 12294-12305.

[10] LI X, WU J, LIN Z, et al. Recurrent squeeze-and-excitation context aggregation net for single image deraining[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11211. Cham: Springer, 2018: 262-277.

[11] JIANG K, WANG Z, YI P, et al. Multi-scale progressive fusion network for single image deraining[C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2020: 8343-8352.

[12] WANG C, XING X, WU Y, et al. DCSFN: deep cross-scale fusion network for single image rain removal[C]// Proceedings of the 28th ACM International Conference on Multimedia. New York: ACM, 2020: 1643-1651.

[13] WANG C, ZHU H, FAN W, et al. Single image rain removal using recurrent scale-guide networks[J]. Neurocomputing, 2022, 467: 242-255.

[14] YI Q, LI J, DAI Q, et al. Structure-preserving deraining with residue channel prior guidance[C]// Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Piscataway: IEEE, 2021: 4218-4227.

[15] LIU B, LIU W. The lifting factorization of 2D 4-channel nonseparable wavelet transforms[J]. Information Sciences, 2018, 456: 113-130.

[16] RONNEBERGER O, FISCHER P, BROX T. U-net: convolutional networks for biomedical image segmentation[C]// Proceedings of the 2015 International Conference on Medical Image Computing and Computer-Assisted Intervention, LNCS 9351. Cham: Springer, 2015: 234-241.

[17] PARK Y, JEON M, LEE J, et al. MCW-Net: single image deraining with multi-level connections and wide regional non-local blocks[J]. Signal Processing: Image Communication, 2022, 105: No.116701.

[18] LIN H, JING C, HUANG Y, et al. A2Net: adjacent aggregation networks for image raindrop removal[J]. IEEE Access, 2020, 8: 60769-60779.

[19] JHA D, RIEGLER M A, JOHANSEN D, et al. DoubleU-Net: a deep convolutional neural network for medical image segmentation[C]// Proceedings of the IEEE 33rd International Symposium on Computer-Based Medical Systems. Piscataway: IEEE, 2020: 558-564.

[20] WANG Z, CUN X, BAO J, et al. Uformer: a general U-shaped Transformer for image restoration[C]// Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2022: 17662-17672.

[21] ZAMIR S W, ARORA A, KHAN S, et al. Restormer: efficient Transformer for high-resolution image restoration[C]// Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2022: 5718-5729.

[22] WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module[C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11211. Cham: Springer, 2018: 3-19.

[23] 刘斌,彭嘉雄. 基于四通道不可分加性小波的多光谱图像融合[J]. 计算机学报, 2009, 32(2): 350-356.(LIU B, PENG J X. Fusion method of multi-spectral image and panchromatic image based on four channels non-sperable additive wavelets[J]. Chinese Journal of Computers, 2009, 32(2): 350-356.)

[24] QIN X, WANG Z, BAI Y, et al. FFA-Net: feature fusion attention network for single image dehazing[C]// Proceedings of the 34th AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2020: 11908-11915.

[25] WANG Z, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612.

[26] YANG W, TAN R T, FENG J, et al. Deep joint rain detection and removal from a single image[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 1685-1694.

[27] ZHANG H, PATEL V M. Density-aware single image de-raining using a multi-stream dense network[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 695-704.

[28] WANG T, YANG X, XU K, et al. Spatial attentive single-image deraining with a high quality real rain dataset[C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 12262-12271.

[29] WEI W, MENG D, ZHAO Q, et al. Semi-supervised transfer learning for image rain removal[C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 3872-3881.

[30] HUYNH-THU Q, GHANBARI M. Scope of validity of PSNR in image/video quality assessment[J]. Electronics Letters, 2008, 44(13): 800-801.

[31] KINGMA D P, BA J L. Adam: a method for stochastic optimization[EB/OL]. (2017-01-30) [2022-05-15].https://arxiv.org/pdf/1412.6980.pdf.

[32] REN D, ZUO W, HU Q, et al. Progressive image deraining networks: a better and simpler baseline[C]// Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2019: 3932-3941.

[33] REN D, SHANG W, ZHU P, et al. Single image deraining using bilateral recurrent network[J]. IEEE Transactions on Image Processing, 2020, 29: 6852-6863.

[34] WANG H, XIE Q, ZHAO Q, et al. A model-driven deep neural network for single image rain removal[C]// Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2020: 3100-3109.

[35] GUO Q, SUN J, JUEFEI-XU F, et al. EfficientDeRain: learning pixel-wise dilation filtering for high-efficiency single-image deraining[C]// Proceedings of the 35th AAAI Conference on Artificial Intelligence. Palo Alto, CA: AAAI Press, 2021: 1487-1495.

[36] CUI X, WANG C, REN D, et al. Semi-supervised image deraining using knowledge distillation[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2022, 32(12): 8327-8341.

[37] Ultralytics. YOLOv5[EB/OL]. [2022-04-25].https://github.com/ultralytics/yolov5.

Dual U-Former image deraining network based on non-separable lifting wavelet

LIU Bin, FANG Siyan*

(,,430062,)

Aiming at the problem that the deraining methods based on tensor product wavelet cannot capture high-frequency rain streaks in all directions, a Dual U-Former Network (DUFN) based on non-separable lifting wavelet was proposed. Firstly, the isotropic non-separable lifting wavelet was used to capture high-frequency rain streaks in all directions. In this way, compared with tensor product wavelets such as Haar wavelet, which can only capture high-frequency rain streaks in three directions, DUFN was able to obtain more comprehensive rain streak information. Secondly, two U-Nets composed of Transformer Blocks (TBs) were connected in series at various scales, so that the semantic features of the shallow decoder were transferred to the deep stage, and the rain streaks were removed more thoroughly. At the same time, the scale-guide encoder was used to guide the coding stage by using the information of various scales in the shallow layer, and Gated Fusion Module (GFM) based on CBAM (Convolutional Block Attention Module) was used to make the fusion process put more focus on the rain area. Experimental results on Rain200H, Rain200L, Rain1200 and Rain12 synthetic datasets show that the Structure SIMilarity (SSIM) of DUFN is improved by 0.009 7 on average compared to that of the advanced method SPDNet (Structure-Preserving Deraining Network). And on Rain200H, Rain200L and Rain12 synthetic datasets, the Peak Signal-to-Noise Ratio (PSNR) of DUFN is improved by 0.657 dB averagely. On real-world dataset SPA-Data, PSNR and SSIM of DUFN are improved by 0.976 dB and 0.003 1 respectively compared with those of the advanced method ECNetLL (Embedding Consistency Network+Layered Long short-term memory). The above verifies that DUFN can improve the rain removal performance by enhancing the ability to capture high-frequency information.

image deraining; non-separable lifting wavelet; multi-scale; Transformer; scale-guide

This work is partially supported by National Natural Science Foundation of China (61471160).

LIU Bin, born in 1963, Ph. D., professor. His research interests include image processing, deep learning, wavelet analysis and application.

FANG Siyan, born in 1998, M. S. candidate. His research interests include image deraining, computer vision, wavelet analysis.

1001-9081(2023)10-3251-09

10.11772/j.issn.1001-9081.2022091422

2022⁃09⁃26;

2023⁃01⁃06;

国家自然科学基金资助项目(61471160)。

刘斌(1963—),男,湖北红安人,教授,博士,主要研究方向:图像处理、深度学习、小波分析与应用; 方思严(1998—),男,湖北潜江人,硕士研究生,CCF会员,主要研究方向:图像去雨、计算机视觉、小波分析。

TP391.4

A

2023⁃01⁃11。