基于结构纹理分解的红外与可见光图像融合算法

2023-10-13李青松杨莘吴谨黄泽丰

李青松, 杨莘, 吴谨, 黄泽丰

(武汉科技大学 信息科学与工程学院, 湖北 武汉 430081)

1 引言

图像融合是一种将多个传感器获得的信息综合到一幅图像中的图像增强技术,融合图像具有比单幅图像更丰富的信息且对噪声的鲁棒性更好,因此该技术广泛应用于军事、遥感、医学等领域[1]。本文主要研究红外与可见光图像融合。可见光图像通过反射光成像能提供丰富的细节,但易受成像环境的影响而丢失重要信息,且难以突出重要目标。红外图像通过热辐射成像能有效突出重要目标,且不受环境影响,但分辨率低、难以提供足够的细节。将同一场景的红外与可见光图像进行融合,可综合可见光图像中丰富的纹理细节和红外图像中显著的热目标信息,从而获得视觉效果更好、鲁棒性更高的融合图像。

目前红外与可见光图像融合方法可分为5类[2]:基于多尺度分解的方法、基于稀疏表示的方法、基于显著性的方法、基于深度学习的方法和混合方法。由于深度学习强大的特征提取能力,基于深度学习的图像融合方法逐渐成为红外与可见光图像融合领域的主流研究方向[3-4]。这类方法避免了传统图像融合方法需要人为设计复杂分解方法和融合规则的缺点,但是红外与可见光图像融合缺乏真值图像,所以这类方法都属于无监督学习。与传统方法相比,深度学习方法仅依靠网络结构的设计和损失函数的设置很难获得压倒性的融合结果[5]。除基于深度学习的方法外,基于多尺度分解的方法在红外与可见光图像融合中应用最广泛。基于多尺度分解方法的主要思想是将源图像分解为一个基础层和多个细节层,然后对各层设计不同的融合规则来实现有效的融合。在过去的30年中,研究者们提出了各种多尺度分解算法,例如拉普拉斯金字塔(LAP)[6]、小波变换[7]和非下采样轮廓波变换[8]等。

近10年来,由于边缘保持滤波器能保持边缘结构的空间一致性和减少边缘光晕伪影,研究者们将基于边缘保持滤波器的多尺度分解方法应用于红外与可见光图像融合领域,并取得了较好的效果。Li等人[9]提出了一种基于引导滤波的图像融合方法,该方法使用引导滤波分解图像,充分利用邻域像素间的强相关性,得到的融合结果的空间一致性好且计算效率高。Zhou等人[10]提出一种基于高斯和双边滤波的方法,使用高斯滤波器和双边滤波器将源图像分解为结构层和纹理细节层,并对边缘结构层和纹理细节层使用不同的融合规则,得到了符合人眼视觉的融合图像。Ren等人[5]提出一种边缘保持引导滤波器并用于红外与可见光图像融合,通过给梯度大的像素赋予更大的权重,使边缘结构保持效果更好。但上述方法中所使用的边缘保持滤波器都存在无法有效区分强纹理与结构的问题,导致融合结果中出现结构边缘模糊。Lee等人[11]提出了一种基于区间梯度的结构纹理分解算法,可以有效分离纹理和结构,本文将该算法引入红外与可见光图像融合,提出了一种基于多层分解的融合算法,解决了热目标信息丢失、边缘结构模糊、细节损失等问题。

本文主要工作如下:将结构纹理分解用于红外与可见光图像,有效分离结构纹理,避免边缘结构模糊;设计了一种结构均值法,能有效提取红外热目标与可见光背景信息,同时避免亮度层融合时的细节信息丢失;提出一种多指标的基础层融合规则,使对比度信息和结构信息得到保留,避免融合结果中产生伪影。

2 结构纹理滤波

纹理信息一般通过梯度算子提取,但梯度算子不能有效区分强纹理与边缘结构,导致边缘结构被误判为纹理,不利于后续的处理。为了准确地分离图像的纹理与结构信息,Lee等人[11]提出一种基于区间梯度的结构纹理分解算法,通过定义的区间梯度算子,能有效分离边缘结构与纹理信息。以一维离散信号I为例,在像素p处的前向差分梯度表示为:

像素p的区间梯度定义为:

其中:Ω表示像素p的邻域分别表示一维高斯函数的右半部分和左半部分,表达式如式(3)和式(4)所示:

式中:w表示半指数加权函数,σ表示尺度参数。wσ表达式如式(5)所示:

kr与kl都是归一化系数,表达式如式(6)和式(7)所示:

区间梯度与前向梯度不同,它度量的是像素点左右两侧的加权平均差,能有效地检测出结构信息。如果在局部窗Ωp内没有纹理信息,则|(∇I)p|≤|(∇ΩI)p|。对于处于结构上的像素p,由于加权核放大了梯度,(∇ΩI)p>(∇I)p;对于处于纹理区域的像素p,由于邻域内的梯度振荡相互抵消,(∇ΩI)p<(∇I)p。

为了从输入信号I中得到无纹理信号,使用区间梯度重建输入信号的梯度:

ε是一个小的常量,用于防止数值不稳定。本文中ε设为0.000 1。

在结构边缘和平滑区域,(∇ΩI)p>(∇I)p,ωp取1,重建后的梯度保持不变。在纹理区域,由于振荡,(∇ΩI)p<(∇I)p,ωp<1,梯度被抑制。

通过累加重建梯度可以获得临时信号R:

式中:I0是I中最左边的像素值,p为像素点,Np是I中的像素个数。然后使用一维引导滤波去除R中残留的纹理。

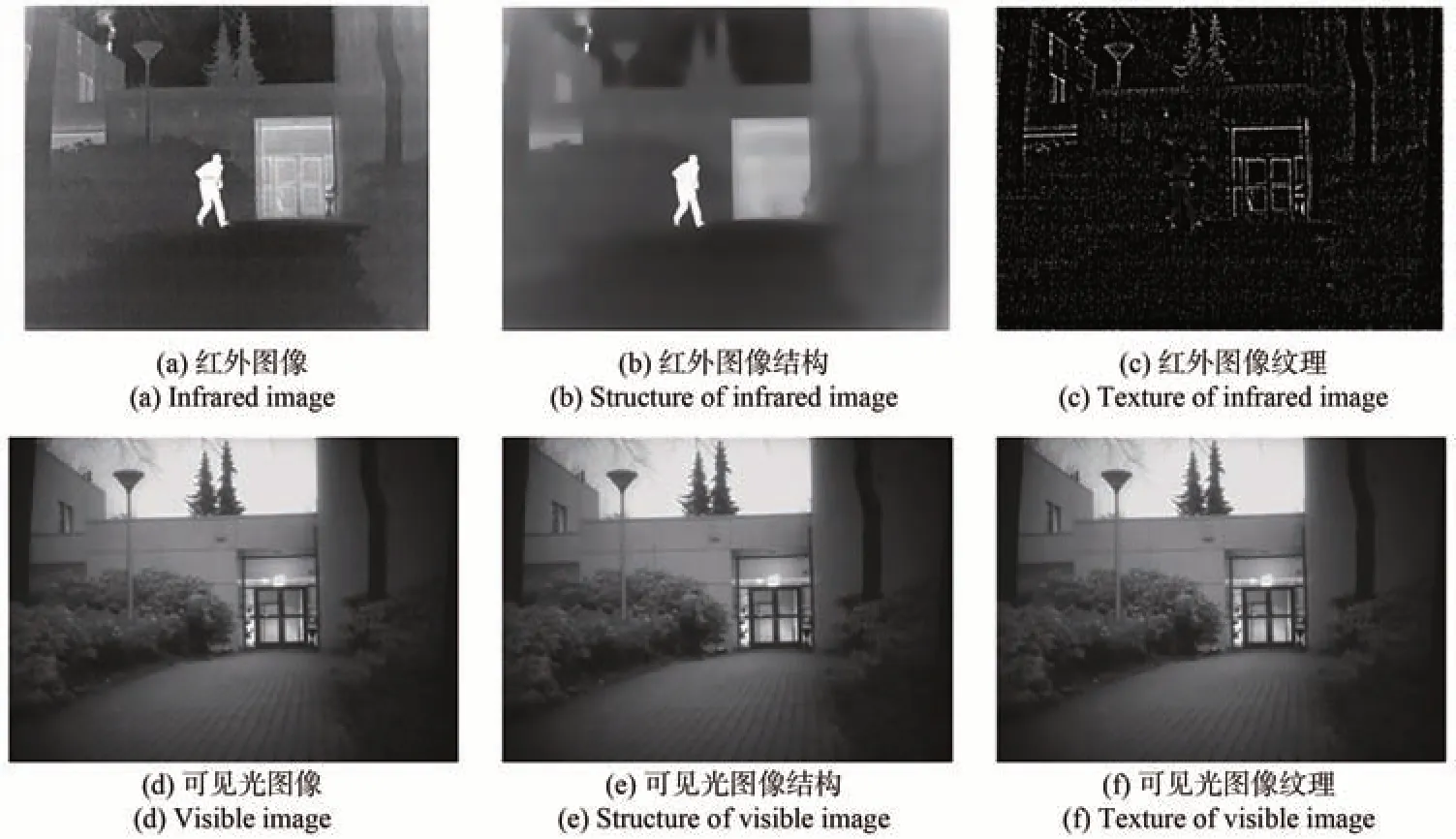

对于二维图像信号,分别在x和y方向上使用一维结构纹理滤波,并以迭代的方式达到收敛,实现二维结构纹理分解[11]。图1展示了对红外与可见光图像使用结构纹理分解的效果。为便于观察二者纹理细节差异,对得到的纹理细节图进行了增强处理。

图1 结构纹理滤波Fig.1 Structure-texture filtering

3 算法框架

本文提出的红外与可见光图像融合算法框架如图2所示。首先通过结构纹理分解和亮度层提取将源图像分解为细节层、亮度层和基础层。针对亮度层,为保证融合图像的整体亮度,使用像素值取大进行融合;针对基础层,为避免融合图像边缘结构模糊和产生伪影,设计一种多特征加权的融合规则;针对细节层,先使用基于奇异值分解的去噪算法[12](Singular value decomposition,SVD)对红外细节去噪,再使用基于SSIM和L2范数优化方法对细节层进行融合;最后将各层融合后的图像重构得到融合图像F。

图2 图像融合算法框图Fig.2 Framework of the image fusion algorithm

3.1 细节层提取与去噪

传统的基于边缘保持滤波的分解方法一般通过梯度值来区分纹理细节与边缘结构,存在不能区分强纹理与边缘结构的问题,易导致强纹理被误判为边缘结构,使得纹理细节信息丢失。本文进行结构纹理分解时,通过区间梯度分离边缘结构与纹理细节,可保留更多的纹理和结构信息。设红外图像为Iir,可见光图像为Ivis,对二者进行结构纹理滤波,可得到结构层Rir与Rvis,用源图像减去结构层即为细节层Dir与Dvis,表达式如式(11)和式(12)所示:

式中:STG表示第二部分中的二维结构纹理滤波器[11],r是区间梯度算子的窗半径。

由于红外图像中包含许多噪声,这些噪声与纹理信息很难通过梯度区分出来,所以被当作纹理信息分解到了Dir中。噪声的存在会严重影响最终融合图像的质量。本文采用SVD算法[12]对红外图像细节层进行降噪,该方法通过非局部冗余性和低秩矩阵抑制噪声,计算效率高且对边缘纹理有较强适应性:

3.2 亮度层与基础层分解

根据红外图像与可见光图像不同的成像原理可知,红外图像中的高亮区域多是重要热目标信息,而可见光图像的高亮区域多为背景和光源。提取亮度层的目的是将红外图像中的热目标信息与可见光图像的背景信息提取出来,使最终融合图像保留完整热目标的同时提高图像的整体亮度,从而更符合人眼视觉效果。

均值-高斯法(Mean-Gaussain,MG)[13]是红外与可见光图像融合中常见的亮度层提取方法,但高斯滤波器和均值滤波器都会使热目标模糊扩散,发生形变,导致提取出来的热目标不完整和亮度丢失。此外,由于纹理信息与亮度信息特征不同,亮度层的融合规则针对亮度信息设计,对纹理信息使用会导致纹理信息的丢失,因此应尽量去除亮度层中的纹理信息。基于此,本文结合结构纹理滤波的特点提出了一种结构均值法来提取亮度层(Structure-Mean,SM)。对源图进行结构纹理分解后,纹理信息被分离到细节层中,亮度信息和结构信息都保留在结构层中,有效避免了亮度层融合时导致纹理细节丢失;再对结构层求全局平均值,用结构层减去平均值并进行归一化,得到权重图,通过归一化增加图像对比度,使显著目标更突出;最后将权重图与结构层相乘得到亮度:

式中:Si是权重图,mean()为均值函数,ki为归一化系数,Vi表示亮度层。

最后,用结构层减去亮度层得到基础层Bir、Bvis:

图3展示了均值-高斯法和结构均值方法的亮度层提取效果。对比图3(b)和图3(c)两图,本文提取的红外目标亮度更亮且更完整。对比图3(e)和图3(f)两图,本文提取的可见光背景更亮且无纹理信息,有效避免了亮度层融合时的细节信息丢失。实验结果表明,本文方法对于红外与可见光图像的亮度层提取都取得了较好的效果。

图3 亮度层提取算法对比实验Fig.3 Comparison experiment of brightness layer extraction algorithm

3.3 亮度层与基础层融合规则

亮度层融合的目的是使红外图像中的热目标信息与可见光图像的背景信息都最大程度地保留下来,而二者都可通过像素值的大小来度量,因此本文采用像素值取大的融合规则实现亮度层融合:

基础层中包含源图像的结构信息和对比度信息,融合时需要最大程度地保留这些信息。针对此需求,本文提出一种基于结构显著度(Structure Saliency Measure)[14]、局部对比度(Local Contrast)和像素值的多指标融合方法(SCG)对基础层进行融合。

图像的局部结构与局部梯度协方差密切相关,因此可通过图像的局部梯度协方差计算结构显著度。红外基础层Bir在像素(x,y)处的局部协方差矩阵定义为:

其中:p=(x,y),Bx(p)与By(p)表示在像素p位置沿x和y方向的梯度;w表示局部窗口,本文中w为3×3大小的窗。对C做特征值分解:

将图像的局部结构与该矩阵的特征值关联,利用特征值可计算结构显著度(SS):

式中:α参数的作用是控制结构显著度对角结构的强调程度,本文中α=0.5。同理可计算可见光基础层的结构显著度SSvis。

图像的局部对比度可通过计算局部方差得到,基础层的局部对比度定义如式(21)所示:

结合结构显著度、局部对比度和基础层灰度值构建归一化权重图对基础层进行加权融合:

3.4 细节层融合规则

为了同时保留更多的红外与可见光细节,本文使用一种基于SSIM和L2范数优化方法对细节层进行融合[15]。

首先使用加权融合对细节层进行预融合,得到预融合细节层Dfpre:

利用Dfpre重建预融合图像Fpre:

分别计算预融合图像与红外和可见光图像的结构相似性,构建权重得分图:

其中SSIM计算如下:

其中:μi表示图像i的平均值,σij表示图像对(i,j)的协方差,σi表示图像i的标准差,b1、b2是防止分母为0的常量。权重图计算为:

通过权重图ω判定细节层中细节的重要程度,对细节层使用基于L2范数的优化:

式中:细节层增强系数αir、αvis通过计算细节层的局部均方误差和全局均方误差来确定:

式中:q1和q2分别是红外细节层与局部红外细节层的大小,(x0,y0)是像素位置,m1和m2分别表示红外细节层的全局均值和局部均值。同理可求得αvis。

3.5 融合图像重建

最终融合图像F由细节层融合图像DF、亮度层融合图像VF、基础层融合图像BF求和重建,并将大于1的像素点置1,小于0的像素点置0。

4 实验

本文实验在matlab2016a上进行。为了保证实验的客观性,本文选取了TNO数据集中的12组图像进行实验,与GFF[9]、FPDE[16]、GTF[17]、TIF[18]、MSID[19]、MLGCF[20]、BAYES[21]、DIDF[22]、MFEIF[23]共9种红外与可见光图像融合算法进行对比。9种算法包括经典算法和近期算法,也可分为传统算法与深度学习算法,代码均使用原文作者提供的源代码,且参数均按原文参数设置。为了使客观评价指标能更真实地反映融合图像质量,本文选取了7种客观评价指标,包括基于图像特征的空间频率(Spatial Frequency,SF)、平均梯度(Average Gradient,AG)、边缘强度(Edge Intensity,EI)、方差(Variance,Var),基于信息论的信息熵(Information Entropy,IE)和视觉保真度(Visual Information Fidelity,VIF),基于人类视觉感知的指标Qcv。7个指标中仅Qcv越小越好,其余6个指标皆越大越好。

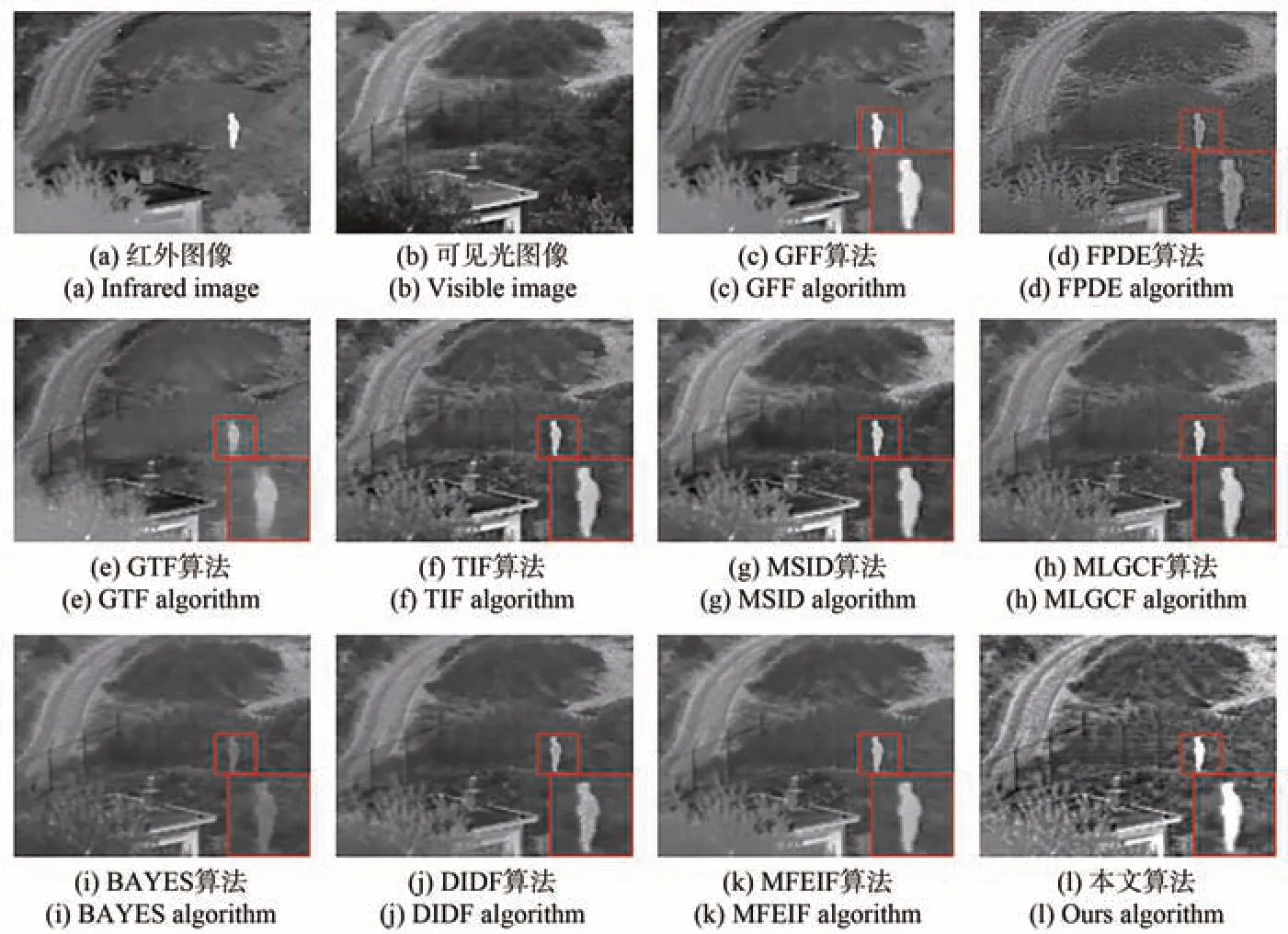

为了直观展示本文算法的融合性能,选取两组图像的融合结果进行定性分析。图4、图5给出了“Kaptein”、“Camp”图像在不同算法下的融合结果,图中前两幅图像分别是红外与可见光源图,剩余图像是各种算法的融合结果。

图4 “Kaptein”图像在各种算法下的融合结果Fig.4 Fusion results of “Kaptein”image using various algorithms

图5 “Camp”图像在各种算法下的融合结果Fig.5 Fusion results of “Camp” image using various algorithms

从图4中绿色框标注的红外热目标可以看到,GFF、FPDE、TIF、BAYES、DIDF和MFEIF方法的融合结果中红外热目标的亮度信息丢失比较严重;GTF算法亮度信息保留较完整,但红外目标发生了形变;MSID算法和本文算法比较完整,保留了亮度信息且未发生形变。观察图4中天空背景,所有对比算法的背景都偏暗,其中GTF算法严重丢失了可见光背景信息,本文算法得到的天空背景保留较好。因为本文算法提取了亮度层,能在有效保护红外热目标信息的同时保护可见光的背景信息,提高融合图像的整体亮度。对比图4中蓝框与红框标注处的纹理细节,在9种对比方法中,红框处的墙面纹理细节严重丢失,蓝框处的地板纹理仅MSID和MFEIF两种算法保留了部分而其余算法严重丢失,本文算法较好地保留了两处的纹理细节。图5中的红外热目标使用红框标注且在图像右下角放大显示,可观察到9种对比算法中仅GFF算法对红外热目标保留较好,其余8种算法的亮度信息均有丢失,本文的亮度保留完好且未发生形变。同时也可以看出,本文算法的融合结果纹理信息更丰富,房屋和路的边缘、栏杆的结构都更清晰。与图4对比,可以看出GFF算法对于红外热目标的保留效果不稳定,而本文算法在图4、图5的测试中对红外热目标都有很好的保留效果,对纹理细节保留较完整,且融合结果的整体亮度保持较好。

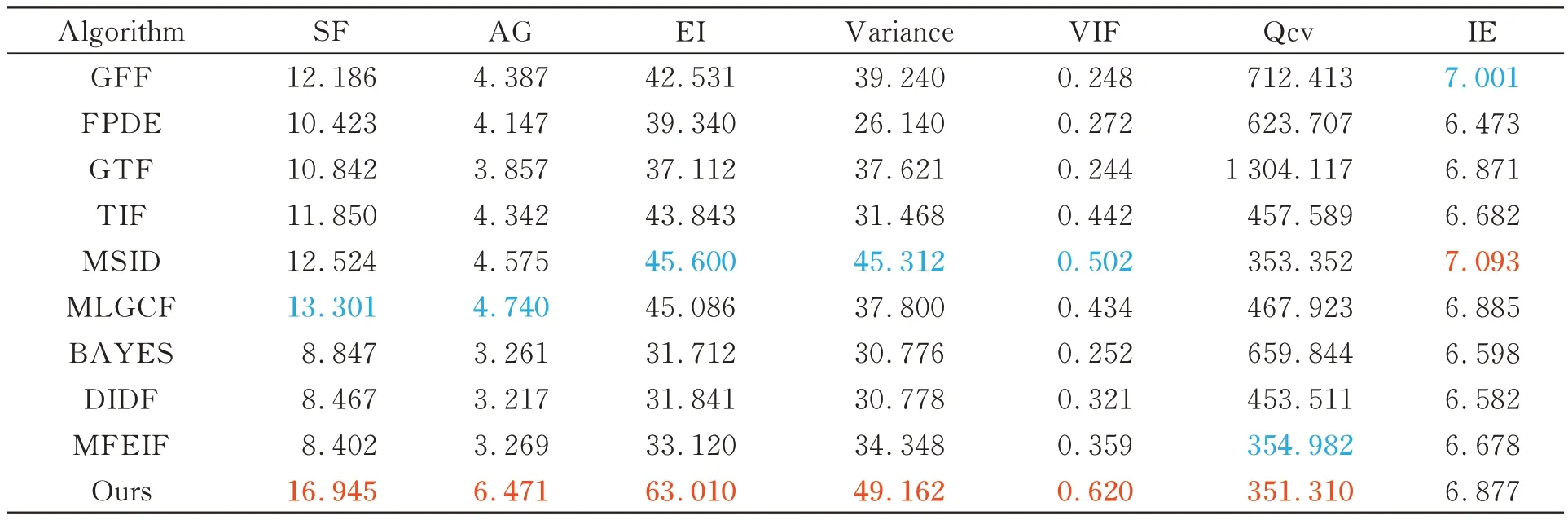

表1、表2分别是“Kaptein”、“Camp”在不同算法下的融合结果对应的客观评价指标,表中将最优值和次优值分别以红色和蓝色加粗标注。在表1中,本文方法仅Qcv为次优值,其余指标都为最优值。在表2中,本文方法在AG、EI、Variance、VIF、IE 5项指标上取得最优值,SF取得次优值。可能由于“Camp”图中纹理细节较多,本文算法又对纹理细节进行了增强,保留的细节更丰富,因此Qcv指标略差。

表1 “Kaptein”图像在各种算法下融合的客观指标Tab.1 Objective evaluating indicators of “Kaptein” image fusion under various algorithms

表2 “Camp”图像在各种算法下融合的客观指标Tab.2 Objective evaluating indicators of “Camp” image fusion under various algorithm

为了更全面地测试本文算法的有效性,本文对12组实验图像进行定量评估融合性能,计算各算法融合结果的客观指标平均值,实验结果如表3所示。在定量分析结果中,本文算法在除信息熵外的6项指标中都取得了最优结果。空间频率、平均梯度和方差3项指标提升较大,比次优值分别提升了27.4%、36.5%和8.5%,表明本文算法能保留更丰富的细节纹理信息且整体对比度更好;边缘强度指标比次优值提升了38.2%,表明融合结果中边缘结构的清晰度更好;视觉保真度提升了23.5%,同时Qcv值下降1%,表明融合图像更符合人眼感知的特点。可能因为对红外源图中的红外噪声进行了去噪,噪声也是属于源图中的信息,所以在计算信息熵时,本文算法的信息熵指标略低。可看出本文算法指标与任一算法单独比较都能取得明显优势,客观反映了本文算法的有效性。

表3 12组图像的平均指标Tab.3 Average indicators for twelve pairs of images

5 结论

本文提出了一种基于结构纹理分解的红外与可见光融合算法。通过结构纹理分解将纹理细节与结构分离,使结构保留在基础层中,解决了融合结果中边缘结构模糊的问题;使用结构均值法提取亮度层,使红外热目标与可见光背景完整保留,同时提高融合结果的整体亮度。根据本文基础层特征设计的融合规则,使融合图像的边缘结构保持清晰且图形整体对比度好。针对细节层中存在红外噪声的问题,使用基于SVD的算法对红外细节层去噪,并使用基于SSIM和L2范数的融合规则对细节层进行融合,解决了细节损失的问题。实验结果表明,本文算法在空间频率、平均梯度、边缘强度、方差和视觉保真度5个指标上分别取得了27.4%、36.5%、38.2%、8.5%和23.5%的提升,主观和客观两方面都能取得比其余9种红外与可见光算法更优的结果。但为了保证融合质量,本文增加了算法的复杂度,导致时间成本略高,12组图像平均用时达到了63 s。如何在保证融合质量的同时降低时间成本,是未来需要解决的问题。