抗视差的宽基线弱纹理影像自动拼接算法

2023-10-13姚国标黄鹏飞龚健雅

姚国标,黄鹏飞,龚健雅,孟 飞,张 进

1. 山东建筑大学测绘地理信息学院,山东 济南 250100; 2. 武汉大学遥感信息工程学院,湖北 武汉 430079

近年来,随着卫星多角度遥感、无人机倾斜航摄及贴近摄影测量等新型测绘技术的兴起,与之对应的影像拼接技术在算法的自动化和稳定性方面亟须突破[1-4]。影像拼接是将两幅或多幅具有一定重叠度的影像序列融合成一幅全景图的技术[5]。现阶段,已有的影像拼接算法难以对大视角变化的弱纹理影像实现全自动高精度拼接,主要原因是:①对大视角变化的弱纹理区域难以提取稳定和可靠的连接点;②对存在地形起伏或视差突变的影像难以创建顾及全局和局部优化的配准模型。

特征点匹配是影像拼接的基础[6],目前代表性匹配算法主要分为基于手动设计(handcrafted)的方法和基于深度学习的方法。在基于手动设计的匹配算法中,自尺度不变特征变换(scale-invariant feature transform,SIFT)算法[7]发布以来,相继涌现出许多经典特征匹配算法。如通过集成加速分段检测策略[8]与二进制独立基元算法[9],文献[10]提出了ORB(oriented fast and rotated brief)算法,该方法运行效率较高,但不具备尺度不变性。文献[11]是在尺度不变SIFT算法的基础上,研究了ASIFT(Affine-SIFT)算法对影像的仿射变形的适应性,但该方法在面向弱纹理区域时容易出现误匹配。文献[12]针对多源遥感影像的亮度畸变,提出集成角度和边缘方向分布的直方图描述符。另一类,基于深度学习的影像匹配方法[13],如L2-Net[14]通过训练孪生全卷积网络模型来拉近匹配描述符间的距离,从而获得描述符模型。在此基础上,HardNet[15]将非匹配描述符纳入模型训练,即通过增加非匹配描述符间的距离,来提升描述符的区分度。文献[16]在HardNet基础上,提出AffNet仿射不变特征检测模型,可在视角变化的立体像对间匹配出较多的同名特征,但其难以适用于纹理匮乏的视角变化区域。文献[17]在AffNet的基础上,通过自监督学习来获取特征的仿射形状和方向,并扩展了多层次匹配项查找网络,提升了对不同纹理畸变的适应性。为此,ContextDesc[18]在常规卷积神经网络(convolutional neural network,CNN)基础上,提出引入几何和视觉上下文编码结构。文献[19]提出一种可自动标注训练数据的自监督特征检测网络模型,提升了模型的泛化能力。SuperGlue[20]引入注意力机制和图神经网络,显著提升了模型的匹配性能。受SuperGlue启发,文献[21]集成Transformer和CNN结构,构建了局部特征变换LoFTR[22]模型,该模型能够显著增强对弱纹理区域的特征识别及匹配。上述的手动设计方法和深度学习算法均难以兼顾影像的弱纹理和大视角变化情况,但为解决宽基线弱纹理立体影像匹配问题提供了参考。

影像配准作为影像拼接的核心技术,其配准精度将直接决定影像的拼接质量[23]。文献[24]提出的AutoStitch算法,为后续研究影像自动化拼接奠定算法基础。在此基础上,文献[25]提出双单应性变换(dual-homography warping,DHW)算法,利用影像前景与背景间各自的映射关系实现影像配准。文献[26]在DHW算法基础上,利用直接线性变换(direct linear transform,DLT)算法计算各网格点的局部单应矩阵,以此实现影像的精确配准。文献[27]为保留待拼接影像的边缘信息,提出在变换过程中施加场景形状约束。文献[28]在对重叠区域进行单应变换的同时,考虑到非重叠区的特征影响,提出了自适应自然图像拼接算法(adaptive as-natural-as-possible,AANAP),但该方法不适用于大视差变化影像。文献[29]利用薄板样条(thin plate spline,TPS)[30-31]函数模拟影像间的视差变化,可适用于带有一定程度视差突变的高分影像的配准。文献[32]基于三角平面理论提出了三角面转换(triangular facet transformation,TFT)算法,该方法引入球面和平面的三角剖分策略实现自适应的局部配准。文献[33]利用共面子区域融合点线特征来进行局部和全局配准,尽可能地保留了影像的原有细节。文献[34]提出一种阈值自适应的融合拼接策略,改善了拼接缝和亮度不均等问题。文献[35]提出一种基于纹理和梯度结构自适应的配准方法,为高质量影像拼接提供了较好的参考。

综上,本文首先通过集成视角变化纠正和局部特征变换策略,实现宽基线弱纹理立体像对的准密集匹配提取;其次,在此基础上,顾及宽基线影像大视差变化情况,基于改进的深度神经网络实现影像全局配准视差的泛化学习,并通过TPS函数模拟局部视差变化,以此来改善由于视差突变导致的不同地形区域的扭曲配准或重影问题;然后,利用深度学习对拼接结果边界进行自适应矩形化处理;最后,选取4组代表性宽基线弱纹理影像数据,验证方法的有效性。

1 方 法

本文算法流程如图1所示,主要包括3个步骤:①宽基线弱纹理影像同名特征提取,该步融合大视角纠正策略和局部特征变换纹理增强技术,能够由粗到精地实现大视角弱纹理的准密集对应;②抗视差的影像配准,该步基于准密集匹配和深度神经网络,泛化学习立体影像的全局视差,并利用TPS函数模拟配准区域的局部视差突变,以改善扭曲配准或重影问题;③拼接影像的矩形化处理,该步利用全卷积网络模型预测拼接影像矩形化的形变函数,在剔除空白区域的同时,最大限度地保留了原有拼接内容。最终,本文算法在无须相机位姿等先验信息的情况下,面向视差变化较大的宽基线弱纹理影像,实现自动化和高质量拼接。

1.1 宽基线弱纹理同名特征提取

宽基线影像的弱纹理区域往往难以被提取出同名特征,主要原因是:一方面弱纹理区域的灰度变化不明显,导致仅依靠灰度梯度计算的传统特征检测算法失效;另一方面显著的视角变化则会大大降低同名特征的检测重复度和匹配相似性,继而增加误匹配率。因此,本节首先通过大视角纠正策略来提升影像特征的几何不变性,并引入局部特征变换的纹理增强策略,来耦合纹理匮乏区域的细节特征,然后完成宽基线弱纹理同名特征提取,具体方法如下。

(1) 大视角纠正。利用ASIFT算法[11]获取待拼接的影像IA和IB之间的连接点,并通过随机采样一致性算法[31]剔除离群点。IA和IB间的透视投影矩阵H根据式(1)计算

(1)

式中,h11,h12,…,h33为矩阵H中的待求参数;(x,y)和(x′,y′)分别表示为IA和IB上的匹配点坐标。将右影像IB上的各像素按式(2)进行几何变换,生成畸变改正影像IC

(2)

式中,(x″,y″)表示IC上的像素点坐标。通过大视角纠正策略对宽基线影像进行透视变换改正,可使影像之间具备较好的几何一致性,有利于提升同名特征的检测重复度。

PE(pos,i)=sin(pos/10000i/dmodel)

(3)

PC(a,b)=Softmax(S(a,·))b·

Softmax(S(·,b))a

(4)

(5)

因此,粗等级的匹配预测结果MC用式(6)表示

(6)

(7)

(8)

1.2 抗视差影像配准

本节采用“两步法”来渐进式拟合宽基线影像配准视差。首先,利用改进的深度神经网络来学习影像间的透视投影变换,以获取全局配准视差;然后,采用TPS函数[29-31]来拟合剩余的局部配准视差,进一步改善大倾角场景影像配准可能出现的扭曲或重影现象。

(9)

式中,hi和vi分别代表水平和竖直方向视差的误差,其中hi和vi对应的函数形式分别用h(x,y)和v(x,y)表示。对水平方向的视差变换函数h(x,y)定义损失函数ε,如式(10)所示

ε=εD+λεS

(10)

式中,λ为权值系数用来控制整幅影像的变换程度;εD为拟合项表示经过视差换后两点间的距离差异;εS为扭曲项表示整幅影像的视差变换。εD和εS分别由式(11)和式(12)计算

(11)

(12)

根据文献[29]方法推导可得式(11)的最优解h(x,y),相应表达式为

(13)

式中,ωi为各任意点的对应权重;φi(x)为径向基函数,可根据式(14)计算

(14)

(15)

经测试,将得到的视差变换偏移p(x,y)直接应用于左影像IA的像素变换时,会使部分非重叠区域内的特征出现轻微扭曲或失真等现象。为此,需要以各像素点与重叠区域的空间距离为条件,对p(x,y)施加相等的距离约束,同时引入频域加权亮度融合机制,从而确保影像的几何与辐射变换的最优性。

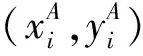

为验证抗视差配准的有效性和优越性,选取经典的全局单应性配准方法AutoStitch[24]及文献[29]的REW(robust elastic warping)算法,对模型应用阶段选出的构成矩形的4组匹配角点分别进行均方根误差(root mean square error,RMSE)统计[40]及精度对比,测试结果见表1。表1的试验1数据取自前文图1中的IA和IB,试验2数据为本文试验部分的数据A。对比结果可见,本节方法能够取得较高的配准精度,这得益于本文提出的“两步法”渐进式抗视差配准策略,其中改进的深度神经网络,能够泛化学习到宽基线影像的全局视差变换,而剩余的局部配准视差可由TPS函数来精确拟合。

表1 3种方法配准精度对比结果

1.3 拼接影像的矩形化

由上文方法生成的拼接影像IAC边界往往呈现不规则的形状,为此本节引入文献[41]的深度学习策略,具体如下。

2 试验与讨论

2.1 试验环境及数据

本文在RTX2080tiGPU,I9-9900K处理器及64 GB内存的计算机上,基于Python3.7的Pycharm试验平台,进行算法程序的编写与测试。在模型训练阶段,通过随机梯度下降(stochastic gradient descent,SGD)算法[42]进行透视变换模型的学习迭代,以10-5为初始学习率;MegaDepth[43]被作为特征检测训练数据集,训练过程中Transformer循环次数N设置为4,LoFTR模块特征变换次数Nf取1,特征窗口边长w取5;在拼接影像的矩形化学习中,初始学习率被设置为10-4,网格分辨率U和V分别设置为8和6,利用SGD实现算法的迭代训练与快速收敛。为验证算法的有效性,4组(A—D)不同场景不同地表类型的宽基线立体像对被选为测试数据,用于算法的特征匹配、影像配准和边界矩形化的试验。4组像对均存在较大的视角变化、景深突变及弱纹理区域,详细的数据描述请见表2。

表2 测试数据描述

2.2 特征匹配

为检验本文算法的特征匹配性能及优势,分别选用经典的ASIFT[11]、AffNet[16]和ContextDesc[18]与本文算法进行对比测试:ASIFT在SIFT的基础上增加了尺度特征的仿射不变性,对视角变化的影像能够获得较好的匹配效果;AffNet通过CNN预测Hessian特征的仿射变换,从而增强在影像视角变化区域的匹配能力;ContextDesc则是在CNN的基础上利用几何和视觉的上下文信息来获取特征间的匹配关系,能够适用于较为复杂场景下的匹配工作。为客观和详实地测评各算法性能,正确匹配数目[44]和RMSE[40]分别被用来评价各算法的匹配可靠性和匹配精度,其中正确匹配数目的确定方法为首先通过随机采样一致性策略估计基本矩阵F,继而基于F剔除匹配结果中误差超过2.0像素的离群点,以此统计各算法的正确匹配数目,而RMSE(单位:像素)由式(16)计算

(16)

表3 各算法的匹配精度RMSE对比

图2 基于A组数据的各方法匹配结果对比Fig.2 The comparison of matching results with each algorithm based on group A data

图6 各匹配算法的正确匹配数目对比Fig.6 The contrast of number of correct matches based on each matching algorithm

影像间的连接点提取是影像拼接过程中的至关重要的环节,匹配点数量、匹配空间分布及精度决定着全局和局部单应映射的准确性与可靠性[45]。面向纹理匮乏的宽基线影像数据,各像对均存在较大的视角变化、景深突变及弱纹理区域,图6和表3的定量试验结果揭示本文算法能够取得较多的正确匹配数目和较高的匹配精度;观察图2—图5的匹配结果,可见本文算法可获得准密集且空间分布均匀的同名特征,上述试验结果综合验证了本文算法匹配结果,具有较高的可靠性和准确性。原因在于,本文算法在影像视角变换改正基础上,引入局部纹理增强LoFTR模块,既提高了影像同名区域的仿射不变性,又增强了影像全局与局部纹理的区分度,因而本文算法在宽基线的弱纹理影像中具有较好的适应性。仿射不变ASIFT算法对视角变换的宽基线影像具有良好的适应性,但对纹理单一或匮乏的宽基线影像仅能获得少量的正确匹配。分析原因,一方面该算法在模拟影像的视角变化过程中,弱化了纹理特征的区分度;另一方面ASIFT本质上属于局部尺度不变特征,缺少对各局部特征上下文信息的关联,因此在弱纹理影像中容易出现大量的误匹配。ContextDesc算法虽具备对局部特征上下文信息的学习能力,但对较大的视角变化及视差突变影像适应性一般。AffNet算法通过大量匹配样本的学习,提高了对弱纹理影像的适应性,但仍难以取得均匀分布的准密集对应。总之,本文算法能够较为准确地从宽基线弱纹理的影像中获取充足的连接点,为下一步的高质量影像配准奠定基础。

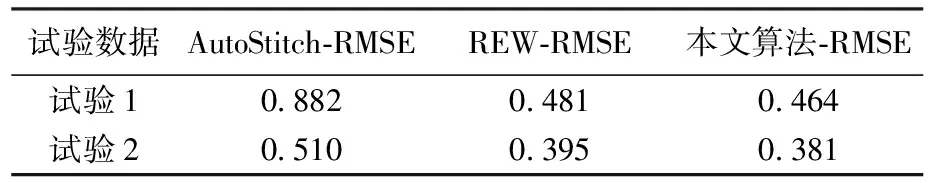

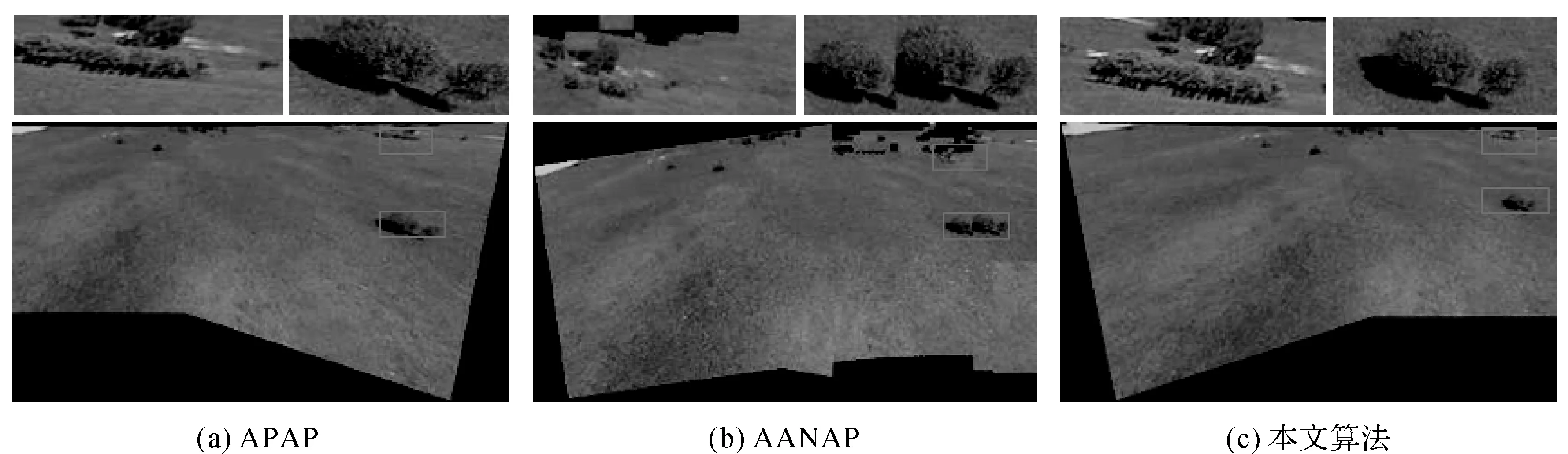

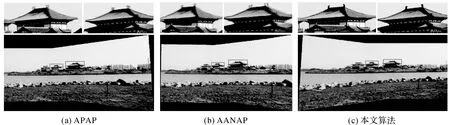

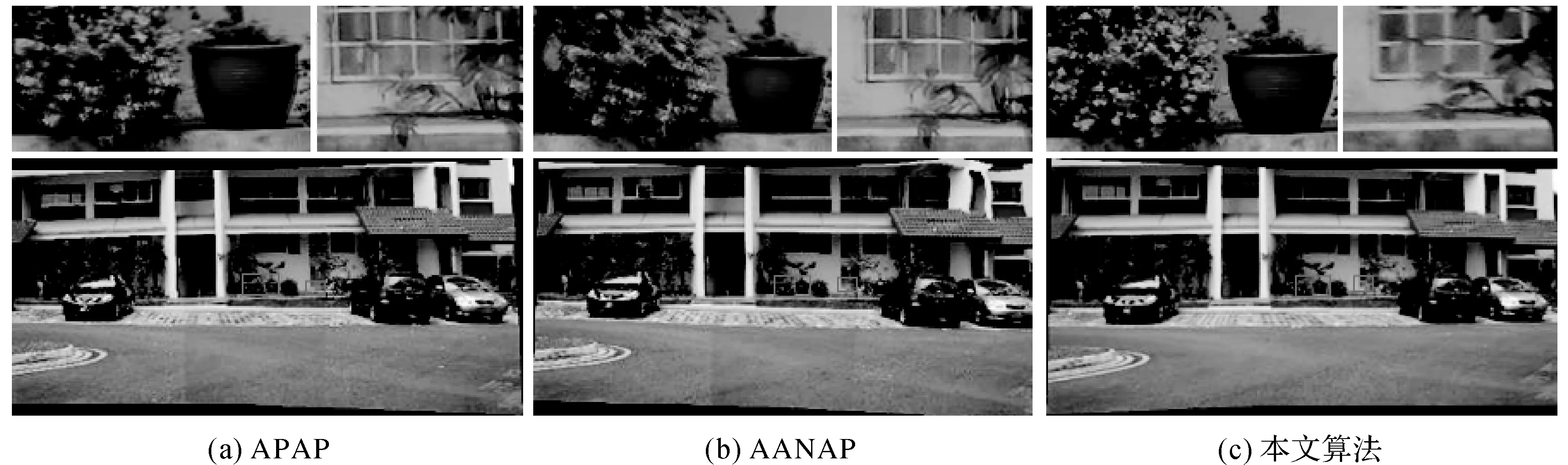

2.3 影像拼接

为验证本文算法在影像配准阶段的优越性,统一沿用2.2节本文算法得到的宽基线弱纹理特征,并选取APAP(as-projective-as-possible)算法[26]和AANAP(adaptiveas-natural-as-possible)算法[28]与本文的配准算法在拼接融合结果上进行对比:APAP算法通过(direct linear transform,DLT)策略分别计算影像各部分的局部透视投影矩阵来完成影像的配准工作;AANAP算法则通过自适应DLT算法求取局部单应模型,并线性化影像的非重叠区域,最终通过全局相似性变换来完成影像的拼接工作。图7—图10展示了基于A—D组数据的各算法配准结果,其中的局部细节对比由矩形框选中后放大。

图7 A组影像宽基线弱纹理特征的影像拼接结果Fig.7 The stitching results of wide baseline weak texture features based on group A images

图8 B组影像宽基线弱纹理特征的影像拼接结果Fig.8 The stitching results of wide baseline weak texture features based on group B images

图9 C组影像宽基线弱纹理特征的影像拼接结果Fig.9 The stitching results of wide baseline weak texture features based on group C images

图10 D组影像宽基线弱纹理特征的影像拼接结果Fig.10 The stitching results of wide baseline weak texture features based on group D images

综合图7—图10的总体配准结果及局部放大细节来看,APAP和AANAP在4组影像的拼接结果由于受到视差突变的影响,均存在不同程度的重影和模糊等问题,影像重叠区域之间的部分标志特征难以实现契合配准,明显干扰了逐像素的特征融合。究其原因,是因为测试影像中大都存在视差不连续情况,仅靠初始单应变换难以有效模拟复杂视差的变化情况;而本文则采用“两步”渐进式求解策略,逐级逼近配准视差,即通过改进的深度神经网络精准获取全局配准视差,再由TPS函数拟合残余的局部视差。APAP算法在计算局部透视投影矩阵的过程中未考虑视差突变的影响,因而难以适用于地面近景或低空地形起伏的高分辨率影像。而AANAP算法同样忽略了视差因素的影响,且全局的相似单应变换难以重构立体影像的多平面场景,导致局部配准结果中容易出现重影模糊甚至是信息丢失问题。总之,本文算法具有较好的抗视差性能,拼接结果明显优于APAP和AANAP方法,且目视拼接效果更接近于实际的影像场景。

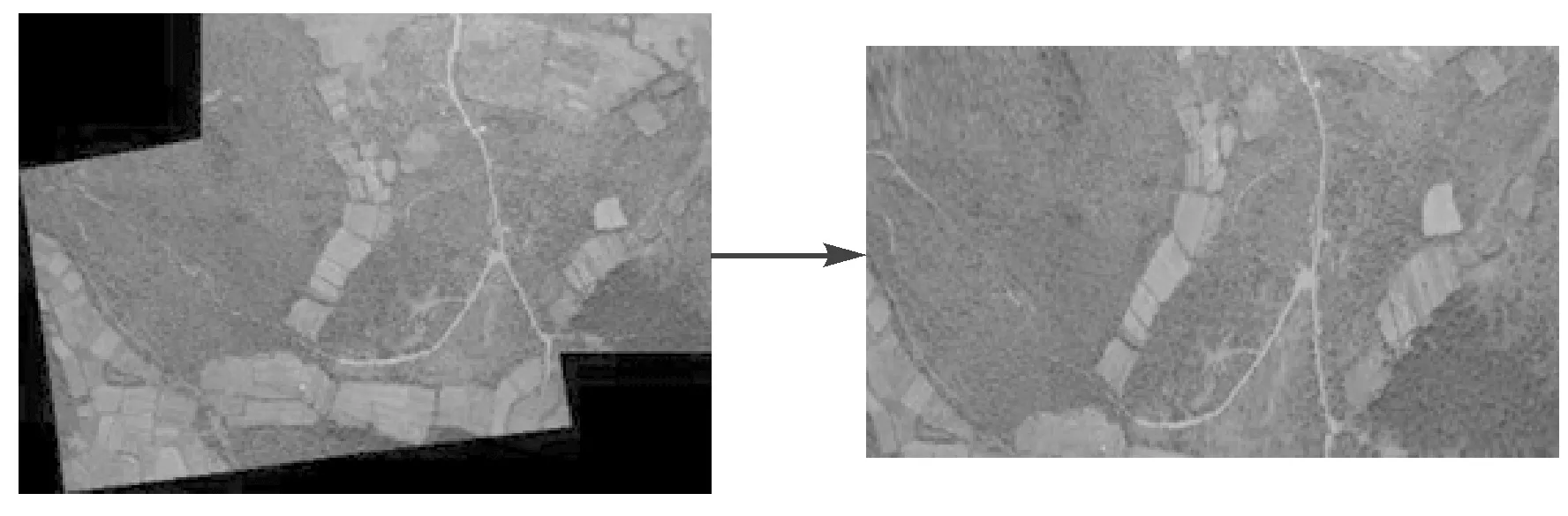

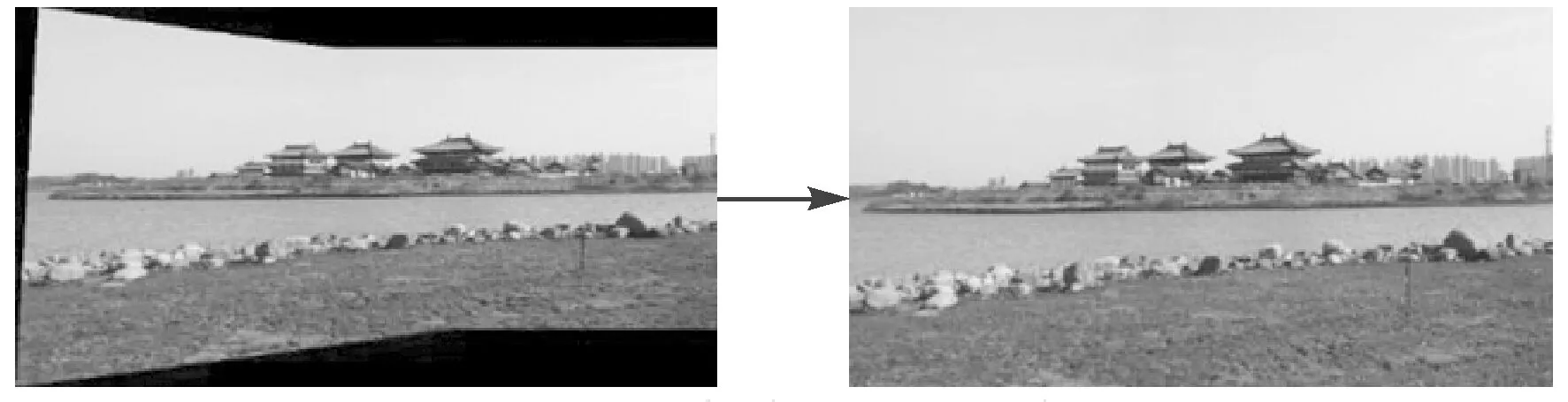

2.4 拼接影像矩形化

图11—图14给出本文算法的各组数据配准结果的矩形化效果。观察试验结果,本文算法在进行边界矩形化过程中通过CNN推算影像中网格点向规则矩形的变换轨迹,若拼接影像边界存在的缺失较大,则训练迭代过程中会产生过多的权重参数,导致无法拟合,因此会不可避免地丢失掉部分信息;而当两幅影像之间存在足够的重叠区域时,则可以在最大限度保留影像拼接内容的同时剔除空白区域,将影像拼接区域有效训练为规则化矩形。

图11 A组拼接结果的矩形化效果Fig.11 The rectangularization of group A images stitching results

图12 B组拼接结果的矩形化效果Fig.12 The rectangularization of group B images stitching results

图13 C组拼接结果的矩形化效果Fig.13 The rectangularization of group C images stitching results

图14 D组拼接结果的矩形化效果Fig.14 The rectangularization of group D images stitching results

除了从视觉上分析评比配准及矩形化的结果外,还引入了自然影像质量评估指标(natural image quality evaluator,NIQE)[46]来客观评价各组影像的拼接结果,该指标是受生物视觉启发,通过影像特征拟合的多元高斯模型来统计待测影像中的特征分布差异,其值越小则表示影像质量越高。表4给出了对各组拼接影像结果的质量评价NIQE。

表4 各组拼接影像结果质量评价

综合图11—图14和表4分析,AANAP在各组影像中的拼接结果总体上优于APAP,因此其对应的NIQE值相对较低;而本文算法的影像拼接结果优于APAP和AANAP,因此其NIQE值较APAP和AANAP最低,表明拼接结果的目视效果与定量评价结果一致。由表4可知,本文算法的拼接结果矩形化前后,影像NIQE值变化很小,表明本文的矩形化处理在提高影像的目视效果外,并未影响原有拼接质量。

3 结 论

本文从宽基线弱纹理区域特征匹配和视差估计两方面入手,构建了从特征匹配到影像配准再到边界矩形化的全自动拼接流程。首先,在影像特征匹配阶段引入基于局部特征变换的LoFTR模块来训练提升对弱纹理特征的区分度,并融合了影像视角的几何纠正来增强特征的仿射不变性,能够在宽基线弱纹理的立体影像中提取可靠准密集匹配;其次,在影像配准阶段,通过改进的深度神经网络模型获取待拼接影像的可靠全局视差,再由TPS函数对局部剩余视差进行拟合;然后,通过CNN来推算拼接影像内各网格点的矩形化变换轨迹,在最大限度地保护影像内容的同时,剔除拼接影像周围的空白区域;最后,选取4组代表性宽基线弱纹理影像数据进行测试,基于大量的定量和定性的试验结果,表明本文算法能够适用于地面近景及低空航拍影像的高质量配准任务。

本文的主要贡献有:①融合了视角纠正和弱纹理特征增强策略,构建适用于宽基线弱纹理的特征匹配模型,能够从大倾角变化的宽基线弱纹理影像中获取准密集同名特征;②建立“两步法”渐进式配准途径,即通过改进的深度神经网络和TPS函数获得影像的全局与局部高精度配准模型,较好地克服了大倾角影像视差突变导致的扭曲配准或重影问题。然而,考虑到手动设计ASIFT算法对大倾角变化的弱纹理影像适应的局限性,下一步将构建透视投影不变的轻量级CNN模型,取代ASIFT来实现对影像视角畸变的纠正,从而提升本文算法整体的可靠性与普适性。