优化梯度增强黑盒对抗攻击算法

2023-09-25刘梦庭

刘梦庭,凌 捷

广东工业大学计算机学院,广州510006

深度神经网络由于其强大的表达能力在许多任务上都有很好的表现,是许多人工智能应用的基础,包括图像分类[1]、人脸识别[2]、无人驾驶[3]等。与此同时有大量的工作表明深度神经网络容易受到对抗样本的影响,通过将精心设计的细微扰动添加到输入样本中生成人眼察觉不出变化的对抗样本,大幅降低神经网络模型的准确率。对抗样本的存在给深度神经网络的应用带来了安全隐患,例如在无人驾驶中通过对抗样本技术将停车标志识别为前进或者其他行为,从而造成不可估量的后果。对抗样本在深度神经网络中表现出了模型间的可迁移性,针对某一个模型生成的对抗样本也能对其他结构不同的模型产生同样的影响。对抗样本的可迁移性为不法分子对未知目标模型的攻击提供了可能。近年来出现了很多对抗样本的研究,这方面的研究可以识别深度模型潜在的缺陷,也能够帮助提高深度模型的鲁棒性,且能够在一定程度上促进更先进的对抗防御算法的研究。

对抗样本攻击可以分为白盒攻击[4-6]和黑盒攻击[7-8]两大类。白盒攻击指目标模型的信息是可完全获取的,攻击的成功率也较高。但在现实世界中是很难获取到目标模型的具体信息,因此白盒攻击更偏向于理论分析。黑盒攻击则只能获取模型的输出甚至对模型的信息完全未知,这种设定提高了对抗样本攻击的难度,也更具有现实意义。现有的一些方法借助于对抗样本的可迁移性进行黑盒攻击,包括基于梯度计算的方法[9]和基于输入转换的方法[10-11]。在最近的工作中,Wang等人[12]提出使用梯度方差来调整当前的梯度,稳定更新方向并显著提高了对抗样本的可迁移性。Admix[13]认为混合操作是一种新的对抗性学习的数据论证范式,并在多个防御模型下使用基于混合转换操作生成的对抗样本显著提高了攻击性能。现有算法生成的对抗样本表现出较弱的可迁移性,导致了较差的黑盒攻击性,与白盒攻击的性能相比仍然有较大的差距。

本文提出了一种优化梯度增强黑盒对抗攻击算法,着重于提高对抗样本在黑盒攻击下的性能。深度神经网络进行正常的训练能够收敛到优化空间中的局部最小值区域,而基于梯度的迭代攻击方法则是从该局部区域出发,根据梯度信息搜索并生成最终的对抗样本。但由于在局部最小值区域内求得的梯度会导致振荡的更新过程,容易落入较差的局部最优中。基于此,所提的算法首先用其他类别的图像样本混合输入样本从而获得混合图像的梯度信息。同时为了保证迭代更新的稳定,结合前一次迭代的梯度方差来调整当前的梯度以获得本文所提的优化梯度。将得出的优化梯度与Adam优化算法[14]结合进行迭代优化生成对抗样本。在标准ImageNet数据集[15]上的实验结果表明,本文所提出的算法能够显著提升对抗样本的黑盒攻击性能,同时也保持了较高的白盒攻击性能。在单模型攻击设置下用Inc-v3[16]、Inc-v4、IncRes-v2[17]和Res-101[18]这四个模型生成的对抗样本的平均攻击率相对于方差调整法[12]分别提高了6、5.3、9.2和6.9个百分点。与现有的输入转换模型结合起来能进一步提高对抗样本的鲁棒性。此外,所提的方法对现有先进的防御模型能够达到92.7%的平均攻击率,分别高于Admix[13]和方差调整法[12]4.5和2.5个百分点。

1 相关工作

对抗攻击的任务是对输入样本添加尽可能小的扰动去生成对抗样本,并使得图片分类器给出错误的分类结果,如公式(1)所示:

其中,x是初始图片,xadv是对抗样本,f(x;θ)是参数为θ的图片分类器,ε是控制扰动大小的超参数表示Lp范数距离,p的取值为∞(与之前的工作保持一致)。

下文将介绍与本文相关的两类黑盒攻击算法,包括基于梯度的对抗攻击算法和基于输入转换的对抗攻击算法。最后还介绍了近几年的对抗防御方法,并用这些方法对所提黑盒攻击算法的有效性进行验证。

1.1 基于梯度的对抗攻击算法

FGSM[4]是第一个基于梯度的攻击方法,其认为对抗样本产生的原因在于深度神经网络的线性特性,并提出使用单步最大化损失函数的方式生成对抗样本。I-FGSM[5]提出使用迭代攻击的方式逐步生成扰动,进一步提高了白盒攻击成功率,但降低了在黑盒模型上的攻击性能。MI-FGSM[6]将动量项整合进迭代过程中得到更加稳定的更新方向。计算如公式(2)所示:

后续Wang等人[12]基于MI-FGSM,结合前一次迭代的梯度方差来调整当前的梯度来避免较差的局部最优值。除了引入梯度方差外,还可以在迭代过程中引入一些额外的梯度信息去更好地指导对抗样本的生成。本文在梯度方差的基础上,引入了其他类别图片的梯度信息,从而提高了黑盒攻击的性能。

1.2 基于输入转换的对抗攻击算法

基于输入转换的对抗攻击算法采用不同的输入转换方法来增强模型的可迁移性,从而提高算法的黑盒攻击性。DIM[10]用固定的概率进行随机缩放和裁剪处理输入图片,然后作为模型分类器的输入并进行后续梯度的计算,提高了对抗样本的可迁移性。TIM[11]提出将迭代攻击方法过程中间得到的梯度与预定义的高斯卷积核进行卷积操作并将得到的结果用于迭代更新。SIM[9]首先将输入图片在数值上进行不同尺度的缩放,然后输入分类器中计算不同尺度缩放下图像的平均梯度。上述方法由于需要进行对输入进行多次转换,在提高黑盒攻击性的同时计算量也会成倍的增加。Admix[13]提出使用其他类别的信息使得样本点更靠近决策边界,以便获取更好的梯度信息来实现对抗攻击。组合多种基于输入转换的对抗攻击算法能进一步提高对抗样本的可迁移性,即可以进一步增强对抗样本的黑盒攻击性。

基于梯度的对抗攻击算法重点在于通过精心设计的梯度以生成攻击性更强的样本,而基于输入转换的对抗攻击算法则侧重于对输入进行多种方式进行转换,对多个转换后的输入图片进行计算以提高生成对抗样本的泛化性。两类黑盒攻击方法各有优势,同时两者之间并不是对立的,可以结合两类方法去生成可迁移性更强的对抗样本,在本文的集成模型攻击实验中得到验证。

1.3 对抗防御方法

为了减轻对抗样本对深度神经网络的影响,近年来出现了许多对抗防御算法。HGD[19]基于高层输出的损失提出高级表征去噪器,推理速度非常快。R&P[20]通过对输入图像进行随机缩放和填充的操作减轻了对抗样本的影响。Bit-Red[21]提出两种特征压缩方法,能够很好地检测出对抗样本。JPEG[22]在图像输入到模型分类器前进行转换来防御对抗样本的攻击。FD[23]是在JPEG的基础上进行改进的防御对抗样本的框架。

2 本文方法

2.1 方法概述

基于深度神经网络去生成对抗样本的方法,包括I-FGSM、MI-FGSM 等经典方法,都是朝着正常模型训练梯度的相反方向进行优化。这种方式在一般情况下均可以降低原物体类别的置信度,但是由于对抗样本的另一目标是扰动尽可能小,这会影响到对抗样本的攻击性能。精细的调整梯度指导对抗样本的生成,是提高对抗样本攻击性的关键。本文方法结合混合图像的方式和使用梯度方差的方式调整当前梯度以得到优化梯度,生成的对抗样本的可迁移性更强。此外,所提出的优化梯度缓解了ADAM优化算法由于窗口累计导致的学习率震荡问题,进一步提高了对抗样本的攻击性。下面将详细介绍本文方法。

2.2 基于优化梯度的迭代攻击

本节提出了一种优化梯度,重点在尽可能小的扰动约束下给定当前迭代的最优梯度方向。深度神经网络在多次训练迭代中更新参数,最终会收敛到优化空间中的一个局部最小值区域中。而基于梯度的对抗攻击则是从该区域出发搜索更新方向并迭代生成最终的对抗样本。直接使用该区域的梯度作为攻击的迭代更新方向会导致比较振荡的更新过程并产生较差的局部最优结果。基于如上分析,本文结合Admix[13]和方差调整法[12]得到适用于对抗攻击的优化梯度,并将其用于迭代攻击过程去生成可迁移性强的对抗样本。

首先针对梯度在迭代攻击过程中存在的更新振荡问题,本文采用混合梯度的方式使攻击的迭代更新过程更加稳定。所提算法使用其他类别的图像样本去混合输入样本,但不改变输入样本的真实分类标签,然后对混合图像进行求导获得的混合图像的混合梯度。由于受到其他类别梯度信息的共同作用,混合梯度能够进行较稳定的迭代更新指导,并快速越过决策边界。

其中,x是输入样本,x′是其他类别的图像样本和vt分别是第t次迭代过程中的对抗样本、动量的累加、平均混合梯度和梯度方差,Jθ(x,y)表示预测输出与真实标签的交叉熵损失函数,∇表示求导操作,η∈[0,1] 混合图像权重,μ是动量衰减因子,m表示其他类别图片样本的数量,n表示用于方差调整的采样数,ri表示用均匀分布中采样的随机样本,α是每一步迭代的最大扰动量。

2.3 结合ADAM优化算法的迭代攻击

ADAM 算法适用于解决高稀疏和高噪声的模型优化问题,这种特性对于生成可迁移性强的对抗样本是有益的。而本节关注于如何将ADAM优化算法应用于生成对抗样本中。ADAM优化算法[14]计算每个参数的自适应学习率,在深度学习模型优化中被广泛使用。ADAM用到的是二阶动量,二阶动量是固定时间窗口内的累计,当窗口内的数据发生较大的变化时,会引起学习率的震荡从而影响最终的收敛。作者认为一般的梯度不能充分发挥ADAM 优化算法在对抗样本中的作用。表1 是基于梯度的迭代攻击算法在单模型攻击设置下对Inc-v3进行攻击的成功率(%)表。从表1的实验结果也验证了这一观点,直接使用ADAM 优化算法降低了对抗样本的黑盒攻击性。而上一节得到的优化梯度指导每次迭代的攻击朝着更优的方向前进,同时在一定程度上缓解了ADAM 学习率的震荡问题,使得ADAM 迭代优化过程较为稳定并能够应用于对抗样本的生成。基于此,所提方法能发挥ADAM 的特性从而可以提高对抗样本的可迁移性。

表1 梯度算法在单模型攻击下的攻击成功率Table 1 Success rate of gradient algorithm under single model attack单位:%

2.4 算法描述

本文优化梯度增强黑盒对抗攻击算法的完整描述如算法1。算法选用ADAM算法用于多轮迭代优化,在每次迭代中则使用所提出的优化梯度进行计算,在规定迭代次数下生成最终的对抗样本。

算法1 优化梯度增强黑盒对抗攻击算法

输入:参数为θ的图片分类器f(x;θ),输入样本x及其真实分类标签y,最大扰动量ε,迭代次数T,混合图像权重η,表示其他类别图片样本数的m,用于方差调整的随机样本数量n,均匀分布的因子β。

输出:对抗样本xadv。

步骤1 每一步迭代的最大扰动量:α=ε/T。

步骤2 计算初始值:v0←0;adam_m0←0;adam_v0←0;

步骤3 fort=0 →T-1 do

步骤4 计算平均梯度

步骤5 计算当前梯度g及其平方

步骤6 更新adam_mt+1:

步骤7 更新adam_vt+1:

步骤8 计算当前扰动方向:

步骤9 更新vt+1:

步骤10 更新

步骤11 End for

步骤12 得到最终生成的对抗样本并返回:

3 实验与结果分析

本文进行了单模型攻击实验、集成模型攻击实验、防御模型下的攻击实验和消融实验。其中单模型攻击实验分别使用四个正常训练的网络模型中去生成对抗样本,以此验证所提算法生成的对抗样本在不降低白盒攻击性能的基础上有效提高了黑盒攻击性。集成模型攻击实验则用于验证使用集成了多个正常训练的网络模型生成的对抗样本更具攻击性,此外也验证了结合基于输入转换的攻击方法后能够生成可迁移性更强的对抗样本。防御模型下的攻击实验用于验证所提算法能够有效攻破近几年的一些对抗防御方法。最后,消融实验用于验证所提算法中的优化梯度及其与ADAM优化算法结合的有效性。

3.1 实验环境

本文在标准的ImageNet 数据集[15]上进行实验。为了保证实验的可对比性,所提方法使用Lin 等人[9]提供的1 000 张图片样本进行评估,对应ImageNet 数据集中的1 000 个类别且几乎能够被所有使用到的测试模型正确分类。实验使用7 个网络模型进行测试,其中包括Inception-v3[16](Inc-v3)、Inception-v4(Inc-v4)、Inception-Resnet-v2[17](IncRes-v2)和Resnet-v2-101[18](Res-101)模型这4个正常训练得到的模型,此外还有三个集成对抗训练模型,包括ens3-adv-Inception-v3(Inc-v3ens3)、ens4-adv-Inception-v3(Inc-v4ens4)和ens-adv-Inception-ResNet-v2(IncRes-v2ens)[24]。

本文实验设置最大扰动量ε为16,迭代次数T为10,η为0.2。其他类别图片样本数m为3,用于方差调整的随机样本数n为3,β为1.5。

3.2 单模型攻击实验

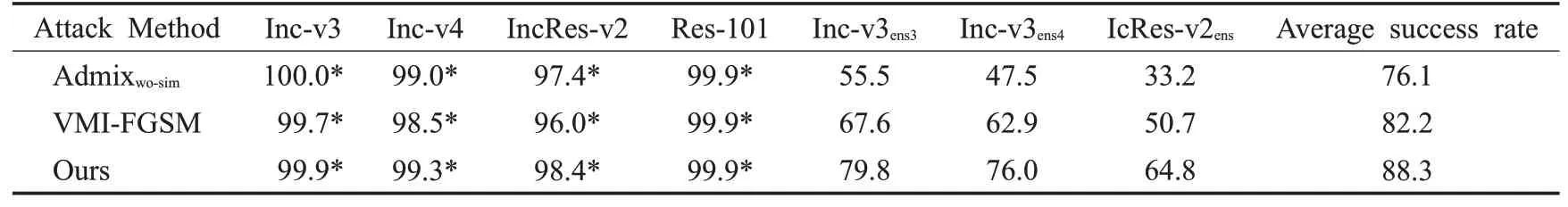

本文分别使用各个正常训练的网络模型去生成对抗样本,然后在7个测试模型验证其攻击成功率。攻击成功率表示对抗样本在测试模型上的误分类率。所提算法对比了SIM[9]、Admix[13]和方差调整法[12](VMI-FGSM),实验结果如表2 所示,攻击的模型在行上,测试的模型在列上。其中,Admixwo-sim表示去掉SIM模块的Admix方法。

表2 单模型攻击设置下的攻击成功率Table 2 Attack success rate under single model attack setting 单位:%

如表2所示,用Inc-v3、Inc-v4、IncRes-v2 和Res-101这四个正常训练的模型生成对抗样本,本文方法相对于VMI-FGSM[12]算法在平均攻击率上分别提高了6、5.3、9.2 和6.9 个百分点。本文方法在白盒攻击和黑盒攻击设置下的平均攻击率优于现有算法,表明了所提算法的有效性。从表2 中也可以看出,基于输入转换的方法SIM 在一些场景下是优于本文算法的。SIM 通过在原图上进行转换,本质上也是通过调整优化的梯度方向去生成对抗样本。由于生成对抗样本的任务需要保证对图片的扰动不能太大,优化的方向上存在的差异会直接影响攻击的成功与否。以I-FGSM的方法为例,它是朝着梯度下降相反的方向进行优化,这在一定程度上可以理解为最优方向,但是这个方向仅仅是使得预测成原类别的概率降低,并不能确保在约束的扰动条件下使得预测错误。SIM 方法这类基于输入转换的方法和本文所提方法从不同角度进行优化,可以考虑两类方法的结合去提高对抗样本的攻击成功率,下一节给出实验结果。

3.3 集成模型攻击实验

集成模型攻击是指在攻击过程中融合多个模型的分类概率输出,在多个模型的共同作用下生成对抗样本。本实验集成了Inc-v3[16]、Inc-v4、IncRes-v2[17]和Res-101[18]这四个模型去生成对抗样本,这四个模型都被分配了相同的权重。在三个集成对抗训练模型上进行对抗样本的黑盒攻击性能的测试。

实验结果如表3 所示。所提算法的平均攻击成功率达到了88.3%,相比Admix[13]和方差调整法[12](VMIFGSM)的平均攻击成功率高了12.2 和6.1 个百分点。在ImageNet数据集上用上述三种方法生成的对抗样本对IncRes-v2ens进行黑盒攻击,成功率分别为33.2%、50.7%和64.8%。其中所提方法相对Admix 和方差调整法分别提升了31.6和14.1个百分点,可看出使用本文方法能够生成可迁移性更强的对抗样本。

表3 集成模型攻击设置下的攻击成功率Table 3 Attack success rate under ensemble-model attack setting 单位:%

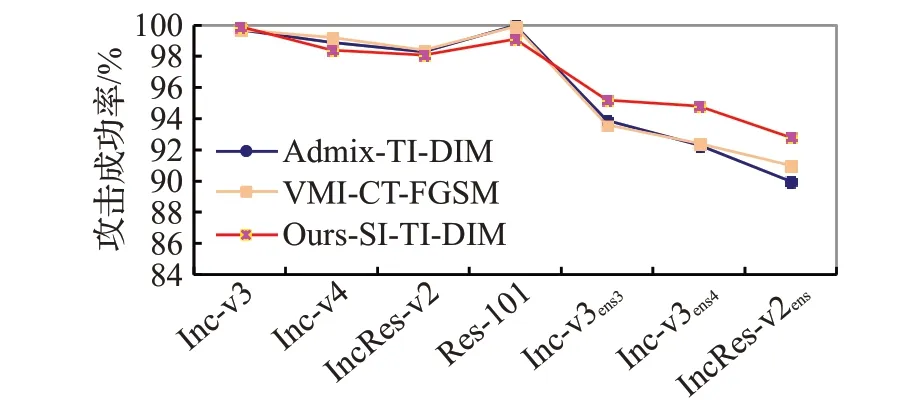

图1给出了融合DIM[10]、TIM[11]和SIM[9]三个方法后的实验结果图。从图1可以看出,融合基于输入转换的攻击算法能进一步提高对抗样本的攻击成功率。现有的Admix[13](Admix-TI-DIM)和方差调整法[12](VMI-CTFGSM)在融合了三种基于输入转换的攻击算法后平均攻击成功率已经有了很大的提升。本文方法相对于Admix-TI-DIM 和VMI-CT-FGSM 分别提升了0.6 和0.5个百分点的攻击率,达到了96.8%。其中,本文方法在白盒攻击上略微差于Admix和方差调整法,但是在黑盒攻击上显著优于这两个方法。作者认为出现这种情况的原因是Admix 和方差调整法出现了一些过拟合的情况,而本文方法在黑盒攻击上的表现更能体现算法的泛化性。

图1 融合输入转换模型设置下的攻击成功率Fig.1 Attack success rate under setting of fusion input conversion model

3.4 防御模型下的攻击实验

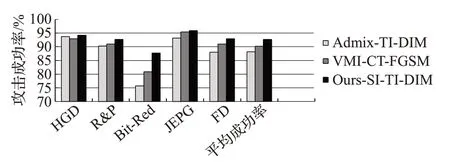

融合三种基于输入转换方法生成的对抗样本表现出了更强的攻击性,因此本文在此设置下对防御模型进行攻击。实验考虑了当前五种防御模型,包括HGD[19]、R&P[20]、Bit-Red[21]、JPEG[22]和FD[23]。图2 给出了在集成模型攻击配置下融合三种输入转换的算法后生成的对抗样本在多种防御模型下的攻击结果。所提算法在防御模型下的攻击平均成功率为92.7%,相比于Admix-TI-DIM[13]和VMI-CT-FGSM[12]分别提高了4.5和2.5个百分点,表明所提方法生成的对抗样本攻击性更强。在Bit-Red 防御模型下,本文方法的攻击成功率达到了87.7%,表明仍然存在不少攻击失效的场景,存在一定的性能提升空间。此外,所提方法生成的对抗样本能用于后续对抗防御模型的验证。

图2 在五个防御模型下的攻击成功率Fig.2 Attack success rate graph under 5 defense models

3.5 消融实验

本文进行了消融实验来验证所提算法中的优化梯度及其与ADAM优化算法结合的有效。选择ImageNet数据集,在Inception v3上生成对抗样其中ADAM-VMIFGSM[12]和ADAM-Admixwo-sim[13]分别表示使用ADAM优化算法替换原算法中的动量优化法算法,Oursm表示使用优化梯度与动量优化法进行迭代优化的算法。

验证优化梯度:使用VMI-FGSM、Admixwo-sim和Oursm攻击方法进行比较,采用动量优化法同等条件下,白盒攻击成功率均达到了100%。Oursm生成的对抗样本具有57.2%的平均攻击成功率,相比VMI-FGSM、Admixwo-sim分别提高了2.7 和13.5 个百分点。可以看出,本文设计的优化梯度算法能够增强对抗样本的可迁移性。在对IncRes-v2ens进行黑盒攻击实验中,Oursm的攻击成功率比Admixwo-sim高了10.5 个百分点,可以看出本文设计的优化梯度算法生成的对抗样本更具有攻击性。

验证优化梯度与Adam 优化算法的结合:使用ADAM-VMI-FGSM,ADAM-Admixwo-sim和所提方法生成对抗样本。如表4 所示,发现在Adam 优化法同等条件下,Ours生成的对抗样本进行黑盒攻击获得了60.5%的平均迁移攻击成功率,相比ADAM-VMI-FGSM,ADAMAdmixwo-sim分别提高了4.4 和17.7 个百分点说明了两者结合的有效。同时可以看出,Admixwo-sim所提出的改进梯度加剧了ADAM 优化算法优化过程中的震荡问题,仅仅通过加入其他类别的图像梯度会影响优化过程中的学习率震荡,从而影响对抗样本的生成,进而使得攻击成功率不升反降。

表4 不同消融模型在Inc-v3上的攻击成功率Table 4 Attack success rate of different ablation models on Inc-v3单位:%

4 对抗样本的可视化

使用本文方法生成的对抗样本如图3 所示。本文方法能够生成视觉上与其他攻击算法相似的对抗样本,但可迁移性更强并且在黑盒攻击上的表现更好。其中,I-FGSM的结构相似性得分SSIM最高,但其攻击成功率是最低的。本文生成的对抗样本在保证较高相似性得分的基础上达到了较高的攻击成功率。

图3 I-FGSM、MI-FGSM及本文方法生成的对抗样本Fig.3 Adversarial samples generated by I-FGSM,MI-FGSM and proposed algorithm

5 结束语

本文提出了一种优化梯度增强黑盒对抗攻击算法,其目的是通过提高对抗样本的迁移性从而增强对抗样本在黑盒模型上的攻击性能。本文方法结合优化梯度与ADAM 优化算法进行迭代优化,从而生成迁移性更强的对抗样本。在单模型攻击实验中,本文方法在Inc-v3、Inc-v4、IncRes-v2 和Res-101 这四个模型下生成的对抗样本相对于VMI-FGSM算法在平均攻击率上分别提高了6、5.3、9.2 和6.9 个百分点。而集成模型攻击实验中所提方法集成了四个模型后的平均成功率达到了88.3%,分别高于Admix 和方差调整法12.2 和6.1 个百分点,说明本文方法能有效提高对抗样本的黑盒攻击性能。在五个防御模型下本文方法展现出了较强的攻击性,攻击平均成功率达到了92.7%。本文算法生成的对抗样本能够用于后续对抗防御模型防御性的验证。

本文方法通过迭代优化的方式生成对抗样本,相较于单步优化方法在速度上仍然有较大的差距,提高算法的速度是进一步的研究方向。其次,在本文实验中仅将该方法应用于基础的图像分类任务中,而将该方法应用于其他视觉任务包括目标检测、目标跟踪等任务也是未来的一个研究方向。