基于轻量级变形卷积的超分辨率网络研究*

2023-08-22卢晨晖

倪 铭,卢晨晖

(上海工程技术大学机械与汽车工程学院,上海 201620)

0 引言

图像超分辨率(ImageSuper-Resolution,ISR)是一个非常活跃的研究领域,它完成经典的计算机视觉任务,即从低分辨率(Low-Resolution,LR)图像中重建高分辨率(High-Resolution,HR)图像。目前,ISR 广泛应用于遥感图像处理、红色影像修复等多种领域[1],科研人员已经提出了多种方法来获得重构SR 图像[2-4]。近几年深度学习的发展给图像SR领域打开了新视角,几种基于卷积神经网络(Convolutional Neural Network,CNN)的深度模型在SR 中实现了极佳的性能。Dong等人[2]提出了一个包含三个卷积层的SRCNN,可以直接对映射进行从LR 到HR 的建模,SRCNN 是深度学习方法在SR 领域工作的先驱。随后,Kim 等人[3]在此工作基础上将SR 网络的深度提升到20 层,与SRCNN相比,该算法的性能明显提高。EDSR 网络[4]则进一步加深了网络的深度,实验结果证明更深的网络能够显著地提高SR图像的质量。

尽管深度网络能够挖掘SR图像的空间特征,但是深度的增加也导致了巨大的计算力资源消耗,因此并不适合现实场景。从这个角度来看,设计一种轻量级的深度学习模型对于图像超分辨率算法的移动端部署来说尤为重要。本文提出了一种更加轻量级、精确化的超分辨率网络——轻量级变形卷积网络(Lightweight deformable convolutional network,LDCN),以普通卷积和变形卷积为网络的基础组成组件,引入特征蒸馏的概念,降低模型训练所需参数。同时提出了一种增强的特征注意力融合模块,能够自适应地为特征分配权重,提高特征融合效率。

1 相关工作

1.1 知识蒸馏机制

知识蒸馏机制的具体步骤是:将提取的特征从通道维度划分成两个部分:一部分直接保留,而另外一部分作为后续网络层的输入,并用于特征细化。Hui等人[5]首先将知识蒸馏机制用于图像超分辨率重建,提出了IDN 网络,用较少的参数量获得了较高的超分辨性能。随后,IMDN[6]在IDN 的工作基础上进一步改进,设计了一个信息多蒸馏块(IMDB),获得更精细化的特征,IMDN 在PSNR 和推理时间方面都有很好的表现。但是IDN 和IMDN 还是不够轻量化,Liu 等人[7]提出了残差特征蒸馏网络(RFDN),该网络以残差特征蒸馏块为网络的主要模块,并使用多特征蒸馏连接方式,获得更准确的特征,进一步降低了模型参数。IDN、IMDN和RFDN模型的关键组成部分是知识蒸馏机制,三种模型在SR任务上的优秀性能也充分证明了该机制的在减少模型参数和提高模型性能方面的有效性。

1.2 注意力机制

注意力机制是指模拟人类视觉注意力的特点,将注意力聚焦在更为有用的特征信息上,目前已被广泛地应用于各种计算机视觉任务[8-9]。Hu 等人[8]引入了由注意力机制构成的SE 块,来计算通道注意力权重,增强了网络的特征表达能力,在图像分类中效果极佳。Zhang 等人[9]对SE 块进行改进,提出了一种增强的残差通道注意力机制来衡量不同通道之间的相关性,并将其用于超分辨率重建任务,取得了当时领先的重建效果。

2 LDCN的网络结构

本文设计的网络结构如图1 所示,主要由三部分组成,包括卷积层、特征提取和融合块(Feature Extraction and Fusion Module,FEFB)、增强的特征注意力融合模块(EFAB)以及重建模块。其中,重建模块由一个3×3的卷积层和一个Pixel Shuffle构成。

图1 LDCN网络结构图

2.1 特征提取和融合模块(FEFB)

如图2(a)所示,FEFB 模块首先将输入从通道的维度划分为两个部分,其中一个部分用1×1的卷积操作获得图像的规则特征并进行保留,另一部分利用残差变形卷积块(Residual Deformable Convolutional Block,RDCB)。获得不规则的特征信息并进行下一步细化。这样就完成了一次蒸馏操作。以此类推,直到第三次蒸馏操作后,将细化特征进行1×1 的卷积操作获得保留特征。最后,将获得的保留特征进行串联组合,采用EFAB模块进行融合。

图2 FEFB整体结构图

给定输入Fin,整个FEFB模块可以表示为:

其中,Fdi和Fci分别表示第i次蒸馏操作后的保留特征和细化特征。fRDCB(⋅)和fEFAB(⋅)分别表示RDCB 和EFAB 模块的操作函数。Conv1×1(⋅)为卷积核大小为1×1的卷积操作,Fout为FEFB模块的最终输出。

RDCB 的结构如图2(b)所示,包括DC 层、残差连接和Leaky ReLU 激活函数,DC 为变形卷积(Deformable Convolution)层[10]。假定输入为,RDCB过程可以表示为:

fDC表示变形卷积操作,fLR(⋅)为Leaky ReLU函数。

通过交替的普通卷积层和DC 层,能够分别获得规则和不规则的特征信息,进而充分挖掘输入的特征信息,提高特征表达能力。通过知识蒸馏的连接方式,从通道维度上减少需要细化的特征,从而减少了网络训练参数。

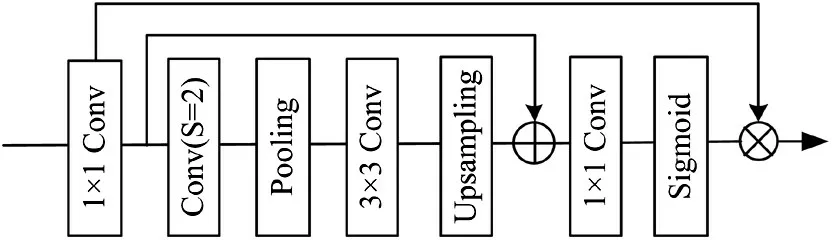

2.2 增强的特征注意力融合模块(EFAB)

为了提高模型的特征融合能力,本文设计了EFAB来考虑卷积层和变形卷积层特征之间的相关性,从而灵活地为每层分配不同的权重。EFAB 的网络结构如图3所示。

图3 EFAB结构图

给定输入为Fin,首先通过1×1的卷积层Conv1×1(⋅)来减少输入的通道数目:

其次采用步长为2 的卷积层和池化层Hpool减小特征图尺寸,采用3×3卷积层Conv3×3(⋅)进一步提取特征,利用上采样操作来恢复特征尺寸:

EFAB 模块用在每个FEFB 模块的末端以及四个FEFB 模块特征的融合阶段,使注意力更加集中于感兴趣的特征区域。当这些突出显示的特性被聚合时一起,可以得到更有代表性的特征,更有利于图像SR重建。

3 实验与结果分析

3.1 数据集

本文使用目前流行的基准数据集DIV2K 数据集训练SR 模型。DIV2K 包括800 张训练图像,100 张验证图像和100 张测试图像。使用Set5、Set14、BSD100(B100)和Urban100 (U100)[3]四个基准数据集作为测试数据集。为了和现有得超分辨率方法进行比较,我们参考了文献[2]的操作,将缩放因子选择为4,并将从SR模型中获得的RGB值转换到Y通道用于验证SR效应。

3.2 网络参数设置

本文采用MSE 损失函数和Adam 优化器。迭代次数为800,批大小为16,初始学习率为10−4,每迭代200 次减少一半。网络训练平台为Ubuntu 22.04,CPU Intel Core i9-11900,RAM 16G,GPU GTX 3070Ti的电脑。

3.3 实验结果及分析

为了验证和评价所提出的LDCN 的性能,将其与目前主流的一些轻量级SR 方法进行对比,主要包括:Bicubic、SRCNN[2]、VDSR[3]、IDN[5]、CARN[11]和IMDN[6]。

3.3.1 客观评价

表1 为LDCN 在缩放因子取值为4 时四个基准数据集上的定量结果,包括参数量、平均PSNR 和SSIM值。最佳结果已加粗表示,次佳结果用下划线表示。可以发现,相比于对比的SR 方法,所提出的LDCN 在多个数据集上都取得了最佳或次佳的PSNR 和SSIM。尽管在Set14 数据集上LDCN 的SSIM 低于IMDN,但是LDCN 的参数量相比于IMDN 减少了50%以上(如表2 所示)。因此,相比于其余轻量级超分辨率算法,本文提出的LDCN基本上能够以较少的参数代价获得最好的图像复原效果。

表1 不同SR方法的PSNR和SSIM对比

表2 不同SR方法的参数量和运行时间对比

3.3.2 主观视觉评价

为了进行主观视觉评价,本文采用不同的SR方法获得测试集中个别图像的超分辨率图像。对比方法包括:Bicubic、FSRCNN[12]、VDSR[3]、IDN[5]、CARN[11]和IMDN[6],代码均来源于对应算法作者提供的官方网址。对比图片来自于B100 数据集的“8023”图像。图4显示了不同SR 方法的复原图像。我们可以发现,通过Bicubic 方法获得的SR 图像非常模糊,复原效果相对而言比较差。而基于深度学习的方法虽然有了一定的提升,但仍然存在边缘模糊和响铃现象,图像部分区域的纹理信息还不够准确。相比于其他对比方法,本文所提LDCN 能较为准确的复原图像中的纹理信息,LDCN 所复原的图像中纹理更加清晰,也更接近真实图像。主观视觉对比结果可以进一步说明所提出的LDCN 能够更加有效地利用LR 图像的特征,从而复原出更加清晰的边缘和纹理信息。

图4 不同SR方法对“8023”图像的复原效果

3.3.3 模型复杂度分析

参数数量和网络运行时间可作为模型复杂度的评价指标。本文选择VDSR、CARN 和IMDN 来进行对比,结果见表2。相比于其他算法,LDCN 的参数量更少,其在不同的SR方法中是非常有竞争力的。

模型的运行时间对于实际应用非常重要,以Set5数据集为例进行四倍超分辨率重建。由表2对比结果可知,LDCN 的运行时间最少,说明LDCN 的模型复杂度更低,更容易在移动端进行部署。

4 结束语

本文提出了一种轻量级的超分辨率网络LDCN,该网络以普通卷积和变形卷积为基础组件,能够充分利用规则和不规则的空间特征,获得表示能力更强的特征。同时,LDCN 额外引入了一种增强的特征注意力机制,能够考虑到卷积层和变形卷积层特征之间的相关性,从而为每层分配不同的权重,提高特征融合效率。在不同基准数据集上的实验结果证明了LDCN能够在较少参数的情况下获得较高的超分性能。