基于双目视觉与ToF结合的海洋吊装定位研究

2023-07-25闻修俊肖昊菁王殿龙曹旭阳

闻修俊,肖昊菁,王殿龙,曹旭阳

(大连理工大学机械工程学院,辽宁大连 116085)

0 引言

船舶起重机在工作的过程中,由于货船经常受到海浪、海风等外部环境影响,导致货船与被吊物在吊装过程中发生不可预知的相对位置变化,严重影响吊装作业效率,需要波浪补偿系统来补偿船舶产生的六自由度运动,然而传统的惯性测量元件无法检测出船舶间的相对运动姿态。因此,开发一套能对被吊物进行捕捉并追踪实时相对舰船的位置的海洋定位装置具有重要的工程应用价值。

随着传感器技术的发展和计算机算力的提高,基于视觉的物体定位方法受到了国内外学者的广泛关注。目前常用的视觉定位技术手段主要包括双目、结构光和ToF 3个技术方向。文献[1]设计了一种高超声速风洞的双目视觉测量方案,通过模型标志点技术来计算实验模型的位移和姿态。文献[2]提出了一种基于双目结构光立体视觉的高反射焊接表面3D重建技术。文献[3]使用人工神经网络 (ANN) 技术提高了ToF测量的精度。并使用深度学习算法实现ANN。证明了人工神经网络方法在光学测距方面的优越性。

本文基于双目相机与ToF(time-of-flight)相机互补的特质,将2种技术进行结合定位,对于结合后的系统图像进行处理及求取结合视差,计算待测物体的空间位置,以便于指导海洋吊装作业。

1 双目视觉与ToF结合的空间定位方法

目前,在视觉测量技术中尤为突出的是双目视觉与ToF技术。其中双目视觉能够获得致密、髙分辨率、高精度的视差图[4]。然而其算法十分复杂,导致系统的反应时间较长,同时对环境光较敏感。而ToF深度相机技术可以直接获取深度信息,并获得稠密的三维点云,且实时性能好,对物体表面纹理没有依赖性,其缺点主要是在视场边缘会产生不可靠的结果,分辨率相对较低,较近距离深度缺失。因此,基于双目相机与ToF深度相机之间的互补特性,将双目相机与ToF深度相机相结合可以扩大其使用范围,改良性能。

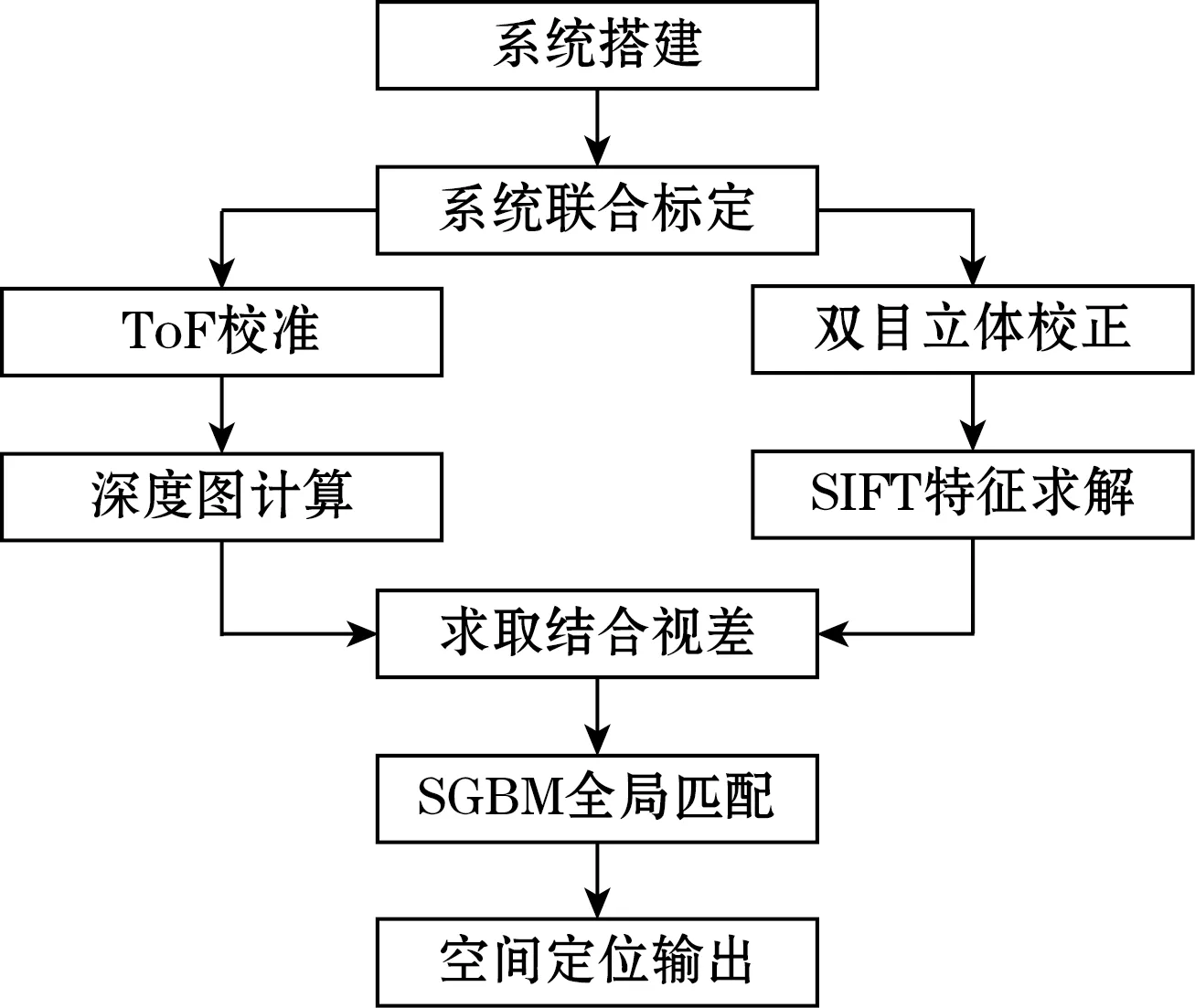

双目视觉与ToF技术的结合方法如图1所示。通过相机标定,获取ToF深度相机与双目相机之间的位姿关系,并建立2个相机系统的转换矩阵,从而建立2个系统的三维数据交换通道。接着对ToF深度相机和双目相机进行校准和立体校正工作,并计算出深度图和双目相机的特征点。在完成双目相机与ToF深度相机的数据预处理工作后,将ToF相机的高精度深度图像转换为视差图,以ToF深度信息指导双目相机中的匹配结果,确定最佳的匹配点,从而输出更准确的空间信息,实现2种技术的融合。

图1 双目视觉与ToF结合方法示意图

2 视觉检测系统的构建

在双目视觉与ToF技术算法结合之前,需要构建2个相机的异构立体系统,并对双目相机与ToF深度相机进行联合标定。

2.1 双目视觉系统

双目视觉系统通过在不同视角的2个相机拍摄同一个点,获得该点在2个平面中的投影,将2个平面中互相对应的点联立起来,利用相似三角形原理确定其唯一的深度值,进一步计算出物体的三维点信息。如图2所示,P点和Q点虽然在左相机平面πR上都投影到了同一个点,但由于其在右相机平面πT上的投影和P′位于不同的位置,那么通过在左相机平面πR与右相机平面πT上的投影的结果就可以将2个点区分开,从而确定物体的真实尺寸。

图2 双目视觉投影

由于制造工艺、装配误差等因素的影响,使得相机成像出现畸变。为了减少畸变带来的影响,需要对双目相机的图像进行校正。将相机成像过程进一步细化,将其分为4个坐标系:世界坐标系(Xw,Yw,Zw)、图像坐标系(x,y)、像素坐标系(u,v)、相机坐标系(Xc,Yc,Zc),如图3所示。

图3 相机四大坐标系

通过坐标系的转换可以得到双目相机的成像模型为式(1):

(1)

式中:R和T分别为世界坐标系和相机坐标系之间的旋转矩阵和平移矩阵,两者组成了相机的外参矩阵。

相机的外参矩阵和内参矩阵构成了相机的投影矩阵:

P=[R|T]·K

(2)

2.2 ToF深度相机系统

ToF技术是基于激光测距原理的主动视觉测距技术,响应快速、操作简单、测量距离远、场景应用丰富,近年来迅速发展为视觉测量领域的研究热点。

ToF深度测算的基本原理是通过传感器发射近红外光,光线在遇到目标物体后会反射并再次被传感器接收,检测光线从传感器发射到被接收后的时间差来计算传感器与目标对象之间的距离[5]。

ToF深度测算的基本公式为

(3)

式中:d为测算出的深度信息;c为光在介质中的传播速度;Δt为光波信号的飞行时间,即传感器发射与接收信号的时间差。

iToF(indirect ToF)采用连续正弦波进行调制,假设发射信号s(t)的振幅为Ae,调制的正弦波频率为f,经过物体表面发射后接收到的光波信号为r(t),则有:

s(t)=Ae[1+sin(2πft)]

(4)

r(t)=Ar[1+sin(2πft-Δφ)]+Br

(5)

式中:Ar为光波信号能量衰减后的振幅;Br为由外部环境光、系统内部偏差引起的偏移;Δφ为相位延迟。

则测算距离d可表示为

(6)

3 双目相机与TOF深度相机结合

3.1 获取数据集与联合标定

使用双目相机获取RGB图像数据集,由于ToF深度相机分辨率为640×480,而双目相机的分辨率为2 560×720,为了保证数据的有效性,应选择分辨率较大的系统,因此对双目相机所获得的图像进行处理。

将双目相机的图像左右分割为2个1 280×720的图像。计算双目相机左右摄像头、ToF相机和双目相机左摄像头的旋转和偏移矩阵,并对左摄像头的数据图像进行处理。完成图像分割后,锁定图像纵横比,进行图像压缩。压缩后得到853×480分辨率的左摄像头图像,截取左摄像头靠双目相机中心侧的图像,对图像进行剪切,获得分辨率为640×480的左摄像头图像。

完成双目图像处理后,采集ToF图像数据集,利用张正友标定法[6]对双目相机和TOF相机进行联合标定。得到的双目相机和ToF相机内外参数如表1和表2所示。

表1 相机联合标定结果

表2 ToF相机及联合标定结果

3.2 深度补全

由于ToF相机本身硬件上的限制,导致输出的深度图有大片的深度值缺失,在图像表现上较为空洞,需要对输出的深度图进行深度补全。可以利用ToF相机搭载的彩色相机提供的彩色图像信息来补全深度缺失。

利用31届 IEEE/CVF 计算机视觉和模式识别会议(CVPR)中提出的算法可以很好地解决这个问题[7]。其训练网络只预测深度的局部微分性质,然后用原始深度图作正则化处理,求解一个全局线性优化问题,最终得到补全的深度图。预测表面法线图像N和遮挡边界图像B后,需要求解一组方程来完成深度图像[8]。以4项误差平方的加权和作为目标函数:

E=λDED+λSES+λNENB

(7)

(8)

(9)

(10)

式中:ED为像素p处预测深度D(p)与观察到的原始深度D0(p)之间的距离;EN为预测深度D(p)与预测表面法线N(p)的一致性(切线点乘法线);ES为促使相邻像素有相似的深度值;B∈[0,1],基于像素在遮挡边界B(p)上的预测概率对正常项进行加权。

该方法经过多个不同视角的重建和优化,可以填补深度图中的空洞和噪点。

3.3 深度稠密重建

由于双目相机得到的视差图比深度相机的深度图致密,需要对补全后的深度图进行基于稀疏式采样不变性的深度稠密重建[9]。假设f表示从输入端到输出端的映射。掩膜o={ou,v}表示二进制变量,用于判断是否观察到变量。

则CNN中标准卷积层的输出可表示为

(11)

式中:内核大小为2k+1;w为权重,b为偏差。

如果输入包含多个特征,则xu、v和wi、j为权重向量。

定义一个提供输入点位置信息的观测掩膜o。对于输入的数据,只对于有效点进行处理,这就使得输出的结果具有不变性。

CNN中稀疏卷积的输出可表示为

(12)

式中∈是为了防止在没有观察到任何输入像素xu+i,v+j时滤波器的位置为零导致表达式无意义。

最大池操作的输出可表示为

(13)

其中,通过最大池化方法为之后的卷积层提供新的观测值。如果至少有一个观察到的变量对过滤器可见,则其值为1,否则为0。结合卷积的输出,观测值将作为下一个稀疏卷积层的输入。

有了额外的观测指标后,每个通道c和位置(u,v)的输入层总和可以重新定义为观测输入xl的归一化总和[12]:

(14)

式中n为输入层的数量。

特征和掩膜同时输入稀疏卷积操作,特征和掩膜先进行点乘,保留观测到的值,而后与权重进行第一次卷积;掩膜与全1矩阵进行归一化卷积,而后与权重作用后的特征进行点乘,最后加上偏置得到最终的特征结果;而掩膜分支则利用上文中提到的改进最大池化方法来得到新的掩膜。通过掩膜与特征的共同作用,使模型专注于对于观测数据的特征提取和学习,使得最后恢复的稠密深度图更为精确,得到的表示特征具有稀疏不变性。

3.4 获取结合视差

完成对ToF深度图像的深度补全及稠密重建后,将ToF深度相机得到的深度图转换成视差图,并将其深度方向的信息作为指导,用于双目相机求取三维坐标的匹配。双目相机获得的视差图用于计算空间坐标,其处理时间更快。然而,在没有纹理和重复纹理的区域,它的错误率较高,因此使用ToF相机深度图来指导双目立体匹配过程[13]。

将从特征点获得的视差值用作种子,以调整双目左视图,通过种子在双目视图中形成中心区域,并设置阈值以查找与阈值匹配的中心区域周围的视差像素。例如,设置特征点坐标m(x,y,d),其中,x、y是特征点位置坐标,d是当前特征点视差值,设置阈值F,然后在区域视差(d+F,d-F)的范围内进行校正匹配融合形成视图,如果在区域视差值中搜索不匹配,则视图使用该点的原始视差值。根据该原理调整左右图像后,使用Census匹配算法来实现图像的立体匹配,从而产生融合视差图像。

3.5 结合效果与分析

为了凸显ToF深度相机与双目相机的互补特性,选择与背景相近的低纹理被测物体。对双目相机进行校正,可以发现即使检测出了较准确的特征点,但由于自身的局限性,对于低纹理的被测物体效果不佳,难以检测出被测物体的位置和轮廓,如图4所示。

图4 双目定位计算结果图

双目视觉与ToF结合定位计算结果如图5所示,图中从左至右分别为对双目摄像头截取预处理后的图像、ToF红外光波相机的红外图像、ToF深度图;从图5可以看出,与双目视觉单独定位计算相比,结合ToF深度信息后,针对没有纹理和相同纹理的被测物体仍然能获得较好的信息结果。

图5 双目视觉与ToF结合定位计算结果图

4 实验结果及分析

4.1 模拟实验平台

本文研究的应用场景为复杂多变的海洋吊装环境,为了验证所述方法在海上环境的实用性,构建海洋吊装模拟环境。如图6所示,通过正弦造浪泵进行海况的模拟,采用350:1的舰船模型,将双目相机和ToF深度相机固定在船上。吊装模拟模块用来模拟起重机的吊装过程,包括模拟起重机和被吊物。

图6 实验平台设计

4.2 实验结果分析

在复杂的海洋环境下进行吊装作业时,舰船可能遭遇多种类型的浪向角,通过将造浪泵安装在不同位置,可以分别在遭遇浪向角为180°(迎浪)、120°(斜浪)、90°(横浪)、0°(顺浪)的条件下进行实验验证。基于Stellar SDK(c++)工具包,将原深度相机提供的上位机Furnace_Stellar400进行改进,以同时显示双目相机RGB图、ToF相机IR红外灰度图以及深度图。

迎浪、斜浪、顺浪以及横浪条件下采集到的图像信息如图7~图10所示。

图7 迎浪周期图像

图8 斜浪周期图像

图9 顺浪周期图像

图10 横浪周期图像

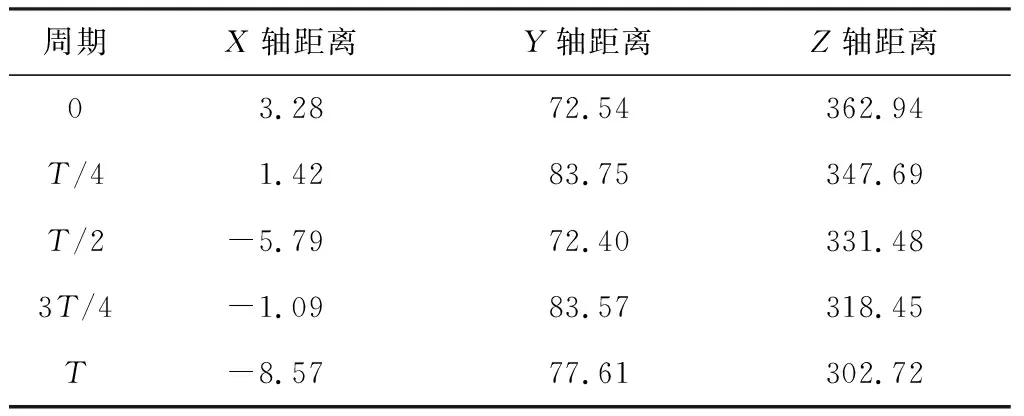

迎浪周期被吊物定位结果如表3所示。

表3 迎浪周期定位结果 mm

斜浪周期被吊物定位结果如表4所示。

表4 斜浪周期定位结果 mm

顺浪周期被吊物定位结果如表5所示。

表5 顺浪周期定位结果 mm

横浪周期被吊物定位结果如表6所示。

表6 横浪周期定位结果 mm

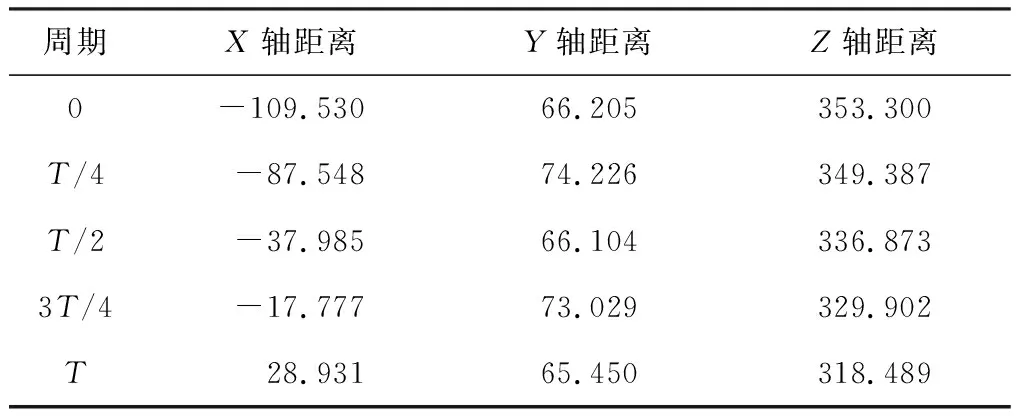

为了对比实验所定位结果的准确性,在横浪周期下对被吊物的位姿进行了同步传感器的测量。测量结果如表7所示。

表7 横浪周期测量结果 mm

相机定位结果与测量结果之间的差值如表8所示。

表8 横浪周期定位结果差值 mm

由表8可知,船在波浪的横向作用下X方向位移不断增大,同时Y向随着波浪周期存在±10 mm左右的升沉运动,Z向由于横流波浪的作用导致了40 mm的偏移。对比表5和表6中计算结果,可以发现最大误差为2.729 mm,误差不超过3 mm,同时随着距离的增加,误差没有变大的趋势,解决了双目相机随着距离增加,定位精度下降的问题,同时对于低纹理的物体也有较好的定位效果,满足定位要求。

5 结论

本文针对海上吊装过程被吊物的定位问题提出了一种基于双目视觉与ToF结合的定位方法。根据双目相机和ToF相机的互补特性,对深度图进行深度补全和深度稠密重建以获取结合视差,同双目视觉的计算结果对比,证明该方法具有更好的效果。为了验证本文方法在海上吊装过程的有效性,模拟复杂的海洋环境,在迎浪、斜浪、顺浪、横浪4种浪向角下进行实验,得到的结果与惯性传感器数据进行对比。实验结果表明:在4种浪向角下该方法均能实现精确定位,得到的深度图物体边缘清晰,深度对比明显,定位结果误差不超过3 mm,证明该方法的有效性,为下一步的实际应用奠定了基础。