复杂环境下雷达-视觉目标融合技术

2023-07-13李小柳苏皎阳尹洁珺席光荣

李小柳,姜 敏,苏皎阳,尹洁珺,席光荣

(1.上海无线电设备研究所,上海 201109;2.上海目标识别与环境感知工程技术研究中心,上海 201109;3.中国航天科技集团有限公司交通感知雷达技术研发中心,上海 201109)

0 引言

作为现代军民用技术发展的重要部分,目标探测感知系统可对场景态势作出实时评估,提升系统决策应对效能,对于交通监控、周界防护等场景应用具有重要意义。但由于应用环境复杂且不可预测,如何有效利用各类传感器来实现环境感知和目标跟踪成为目标探测领域的难点[1-2]。

作为目标探测感知系统中十分重要的两类传感器,毫米波雷达和视觉传感器各有优劣势,而雷达-视觉融合技术可以充分发挥各传感器的优势,实现信息互补,突破单个传感器的性能限制,获取更有效可靠的环境兼容信息。雷达-视觉融合技术已有大量研究成果。CHADWICK 等[3]提出一种毫米波雷达与视觉融合方法,采用不同焦距的相机进行联合标定。该方法可以在一定程度上提升系统的远距目标检测能力。靳延伟[4]分别进行了基于图像和雷达的障碍物检测,通过坐标变换和决策判别对二者的检测结果进行融合,实现对前方环境的连续实时监测。JIANG等[5]根据反射强度对雷达目标的类型进行估计,并映射到图像上生成感兴趣区域(ROI),采用图像去雾算法处理后,通过YOLOv2 网络进行目标识别。该方法对雾天目标的识别准确率有显著提升作用。

但现有雷达-视觉融合技术研究仍存在一些不足。雷达与视觉融合多采用单帧加权方法,融合信息利用率低,雷达多散射点问题无法解决。另外,单传感器的工作状态将直接影响监测效果。而采取以视觉为主、雷达为辅的策略,则会导致环境条件恶劣时系统无法正常工作,且无法充分发挥雷达传感器的优势。

针对目前目标探测感知系统对传感器检测跟踪能力的迫切需求,以及现有传感器融合技术的不足,本文提出基于目标运动特征的雷达-视觉融合技术。利用视觉边界框进行雷达多散射点聚类,并以数据交叠时间、平均欧氏距离、关联唯一性等指标为判据,筛选得到目标关联匹配关系。面向复杂多变环境进行适应性目标检测跟踪,充分发挥雷达和视觉两类传感器的优势,以提高单传感器信息利用率,并在复杂交通场景下验证融合系统的有效性和可行性。

1 雷达-视觉融合系统

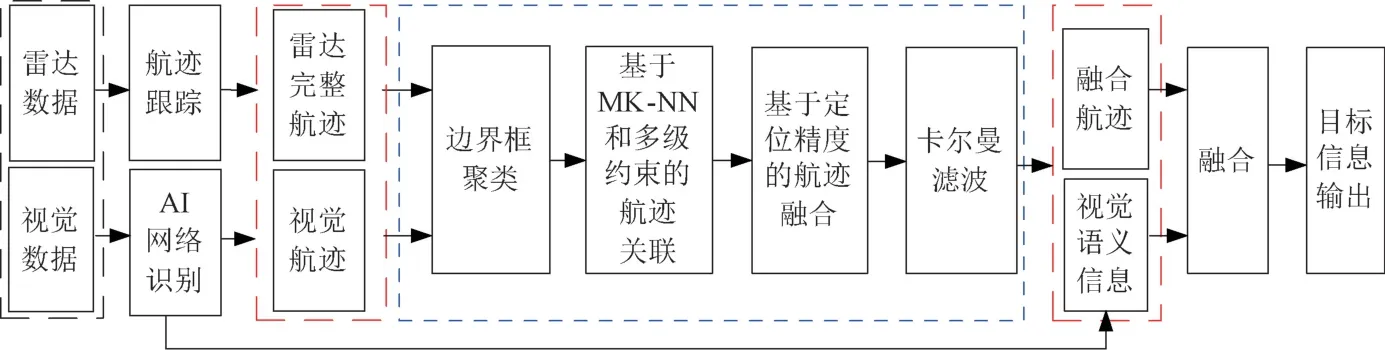

雷达-视觉融合系统如图1所示。雷达数据处理模块采用目标聚类等航迹跟踪算法处理输出目标航迹数据,包括目标编号(ID)和位置等。视觉数据处理模块利用人工智能(AI)网络识别技术生成目标连续帧航迹及丰富的目标语义化描述。对雷达和视觉目标数据在航迹级别上进行边界框聚类、基于修正k-最近邻(modifiedknearest neighbor,MK-NN)法和多级约束的航迹关联、基于定位精度的航迹融合及卡尔曼滤波等处理,最后输出完整平滑的融合航迹。对融合航迹与AI图像识别网络输出的视觉语义信息进行融合,即可实现对目标的稳定准确跟踪。

图1 雷达-视觉融合系统

2 雷达-视觉目标融合处理算法

2.1 目标数据预处理

(1) 传感器航迹生成

针对视觉传感器,系统采用卷积神经网络(CNN)图像深度学习识别技术[6],通过深度学习和视频结构化技术,综合利用YOLOv5 网络与DeepSORT 跟踪算法,有效提取目标的颜色、类型、边界框等多维微特征信息,实现目标识别,并为目标赋予指定ID,进而生成视觉目标航迹。

针对雷达传感器,目标回波信号经过雷达信号处理后生成目标点迹,并基于联合概率数据关联算法(JPDA)和卡尔曼滤波算法实现雷达目标跟踪与预测,得到雷达目标航迹。

(2) 边界框聚类

在时空同步[7]的基础上,针对雷达视场下大目标或横向运动目标易出现的多散射点问题,利用视觉传感器输出的目标边界框进行聚类。根据空间同步关系解算出雷达目标散射点的像素坐标(pr,x,pr,y),该坐标与视觉目标边界框坐标比较,应满足条件

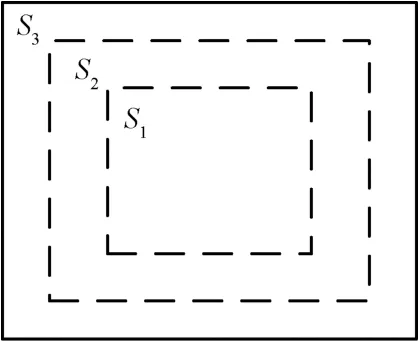

式中:pc,x,pc,y为目标边界框左上角点像素坐标;Δρ为边界框向外放大常量;w,h分别为目标边界框像素宽度和像素高度。对满足条件的雷达目标散射点信息进行加权,避免分布在目标主体附近的多散射点无法聚类。按1∶1∶1面积比例将边界框区域划分为3部分,如图2所示。雷达目标散射点所属区域S1,S2,S3对应不同权重进行加权,以此实现雷达目标多散射点滤除。

图2 边界框内雷达目标散射点加权区域划分

对边界框聚类后的雷达目标散射点作点迹到航迹的关联性判断,以保证雷达航迹的跟踪准确性和稳定性。

2.2 目标航迹关联融合算法

针对应用场景存在的遮挡、拥堵等复杂情况,考虑到传统航迹关联算法[8-9]计算复杂、不利于工程实现的问题,本文基于MK-NN 算法,将航迹关联状态分为关联期、检查期两个阶段。提出三级关联约束,以数据交叠时间、平均欧氏距离、关联唯一性等指标为判据,筛选关联质量矩阵,得到最优关联关系,同时显著降低运算量。

(1) 航迹关联算法

设雷达-视觉融合系统在当前时刻接收到的雷达A 航迹i和视觉传感器B 航迹j的航迹状态为

式中:tA,i(k)表示雷达A 航迹i第k个数据点对应的系统时间;xA,i(k),(k)表示雷达A 航迹i第k个数据点目标横向位置及横向位置估计值;yA,i(k),(k)表示雷达A 航迹i第k个数据点目标纵向位置及纵向位置估计值;tB,j(k)表示视觉传感器B航迹j第k个数据点对应的系统时间;xB,j(k)(k)表示视觉传感器B航迹j第k个数据点目标横向位置及横向位置估计值;yB,j(k),(k)表示视觉传感器B 航迹j第k个数据点目标纵向位置及纵向位置估计值。

若时间窗[t-nΔt,t]内航迹i与航迹j的交叠时间小于MΔt,则排除该组关联关系,其中t为当前时刻,Δt为时间同步后最小时间单元,n为时间窗间隔单元数,M为交叠时间单元数阈值。

计算雷达A 的航迹i和视觉传感器B 的航迹j在当前时间窗内对应的平均欧氏距离

式中:Ncro为航迹交叠时间单元数;k0为交叠序列起始点序号。

记航迹i,j的关联质量Lij=1/φij(i=1,2,…,N1;j=1,2,…,N2),N1,N2分别为传感器A、B当前时刻的检测目标个数,则航迹关联矩阵ψ可表示为

若目标粗关联门限为ηL,当Lij≤ηL时,航迹集合中航迹i与航迹j预判为不关联。利用剩余关联航迹进行最优关联筛选,对于雷达航迹i,可能存在多个满足粗关联条件的视觉航迹j。尤其当目标密集或处于远距离区域时,需根据关联角度和关联时长联合取最优,确认关联的航迹不参与其他航迹的关联筛选,以此保证关联关系的唯一性。最终得到全局最优关联矩阵

系统设定持续时间ΔT内,t时刻的航迹关联矩阵ψt将保持关联关系。新出现的雷达航迹l将与视觉传感器B 的全部航迹进行关联匹配,并将初筛后t时刻的关联矩阵ψ't与ψt比较,筛选全局最优的关联对集合。

当持续时间达到ΔT时,对雷达A 和视觉传感器B的航迹遍历生成全关联矩阵,筛选寻优得到最佳关联对集合,并将其输入航迹融合模块,即可维持系统感知稳定性并极大降低融合系统运算量。

(2) 航迹关联算法仿真对比

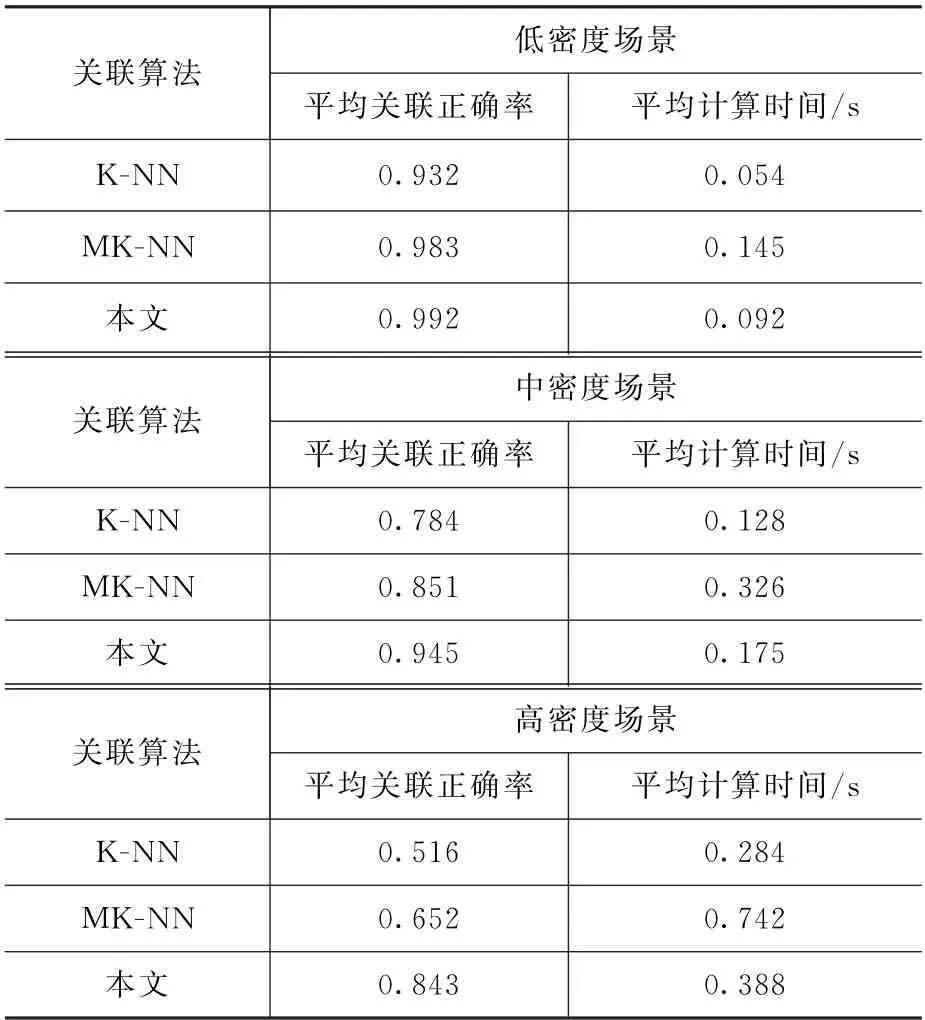

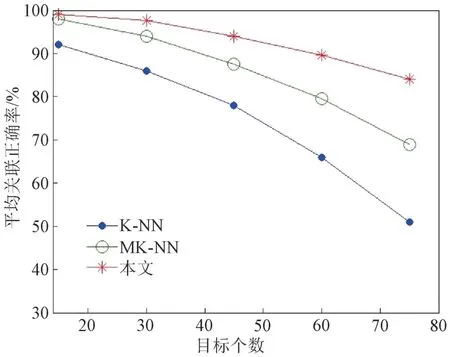

利用k-最近邻(k-nearest neighbor,K-NN)关联、MK-NN 关联及本文关联算法分别对场景数据进行关联处理,以平均关联正确率和平均计算时间综合评估算法性能。各关联算法平均关联正确率如图3所示。不同目标密集场景下,各关联算法的性能如表1所示。可以看出,本文关联算法关联结果更加准确,在目标密集场景下表现更加稳定,计算时间相对更短,可用性更强。

表1 航迹关联算法性能

图3 各关联算法平均关联正确率

(3) 航迹融合

在判定航迹关联对后,航迹融合处理的重要步骤是加权融合[10]。本文算法以各传感器的定位能力为依据,引入定位几何精度衰减因子(geometric dilution of precision,GDOP)作为融合系数。融合前首先对传感器进行误差配准,设第m个传感器测量得到的目标位置坐标为(xm,ym),测量精度分别为σm,x,σm,y。

GDOP为传感器在工作区域内各点处的定位精度。则第m个传感器的定位几何精度衰减因子

以测量值X为例,计算单传感器GDOP 值后,可计算M个传感器加权融合后X的估计值

式中:Xm为第m个传感器的测量值。

加权融合后,对航迹对应的单传感器信息进行目标级融合,最终得到完备准确的目标信息。目标级融合内容包括:a)视觉结构化输出的目标语义化描述,如类型、颜色、型号、款式等信息;b)雷达检测输出的精确速度、雷达散射截面积(RCS)等信息。

2.3 航迹连接

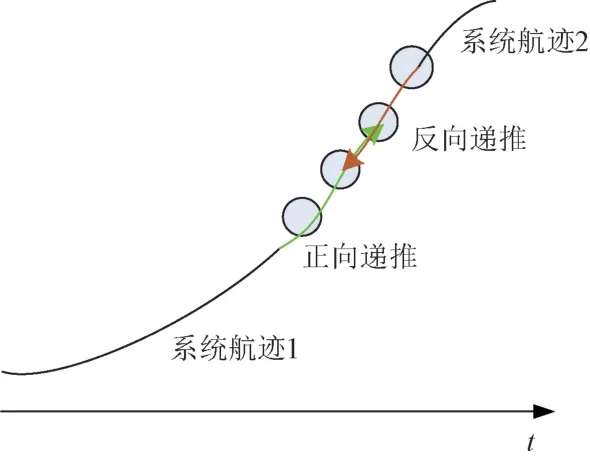

由于单传感器工作状态不稳定、目标跟踪性能不高等因素,系统航迹易出现中断、目标ID跳变情况,因此需进行航迹连接处理,保证航迹连续性和唯一性。航迹存在中断时的融合过程如图4所示。

图4 航迹存在中断时的融合过程示意图

通过卡尔曼滤波将系统航迹1、2进行正向/反向递推,在设定的时间段内通过航迹关联方法判断两系统航迹是否存在关联关系,对两航迹中间段进行加权平均并继承航迹编号,得到目标完整航迹,保证目标跟踪的稳定性。最后利用卡尔曼跟踪滤波对输出航迹进行处理,使系统航迹更加平滑。

3 试验结果与分析

各类目标探测环境与交通环境下,目标行为特性具备一定的共通性,如目标运动状态复杂、系统实时性和准确性要求高等。为了验证算法的有效性与可行性,本文借助复杂交通多目标场景进行测试试验,为算法在各类目标探测环境下的应用提供参考。

试验验证的雷达-视觉融合系统组成如图5所示。毫米波雷达及雷达信号处理模块用于生成雷达目标航迹;网络摄像机生成的视觉图像经深度学习视频处理模块处理后,实现图像目标检测与重识别,并生成视觉目标航迹;嵌入式处理平台用于多源异构数据融合处理;通信模块包括5G模块和路由模块,用于实现各模块间数据通信;可视化平台用于实时展示融合系统目标感知信息,观测融合情况。

图5 雷达-视觉融合系统组成

得到雷达和视觉传感器的目标航迹后,参照视觉真实情况,对边界框聚类处理情况进行分析。测试场景为:10 min内,出现大目标(卡车、客车等)60个,对应雷达多散射点航迹166个。边界框聚类后得到航迹60个,大量多散射点被滤除,但仍存在少量时刻多散射点未能满足聚类条件,可在后续关联阶段做进一步滤除。影响聚类效果的主要因素有:a)聚类后雷达航迹无法与历史航迹连接而无法重新获得航迹编号;b)雷达多散射点分布不满足聚类条件,距离目标主散射点太远,导致多散射点无法滤除。

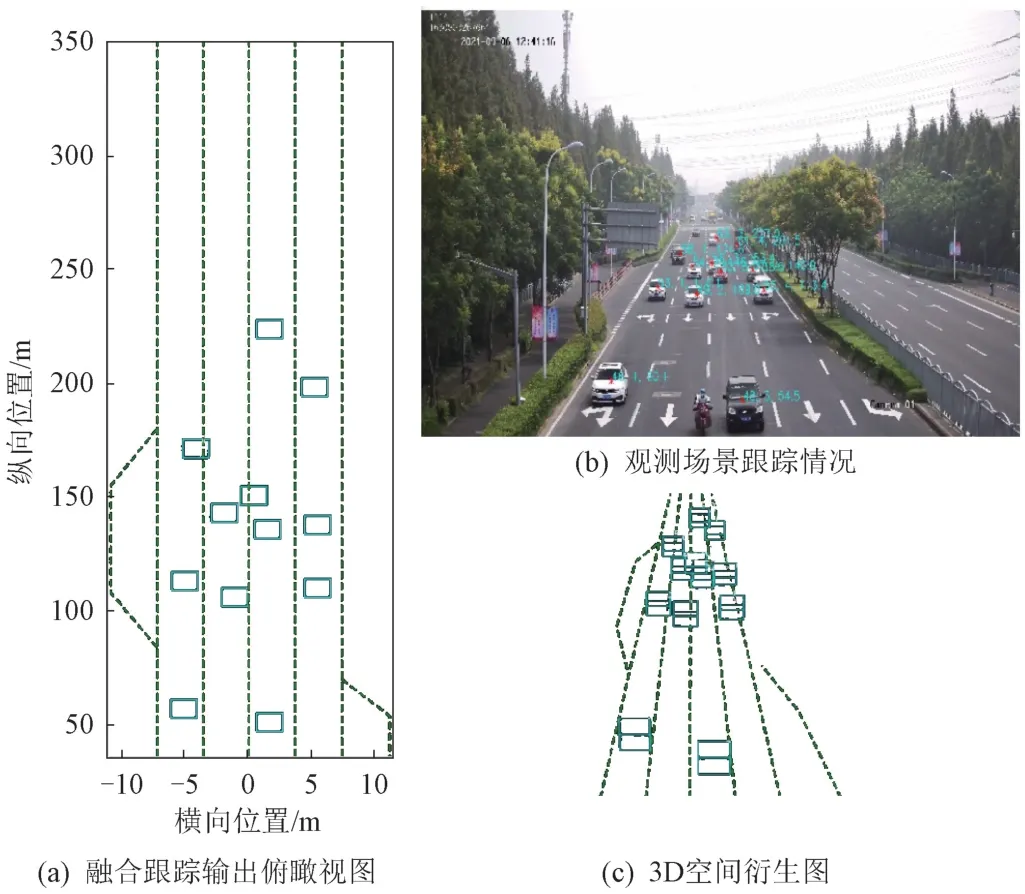

选取典型场景作为示意,航迹关联处理和融合结果如图6所示。可以看出,雷达、视觉航迹能够及时有效关联,并根据关联对进行融合,与单个传感器航迹相比,融合航迹更加稳定,获取的目标信息更加完整丰富。

图6 航迹关联及融合结果

平均关联正确率βcorr和平均关联错误率βerr的计算公式为

式中:Ntr为真实目标数;NP为正确关联目标数;Nre为真实关联目标数;Nlos为关联漏检目标数;Ne为关联错误目标数。

在测试时段内以500 ms为间隔进行采样,统计航迹关联情况,如表2所示。可知,平均关联正确率为98.3%,平均关联错误率为1.7%。在目标密集场景下存在的关联匹配瞬时错误的情况,将在检查期被修正。

表2 航迹关联情况

针对特殊场景下系统航迹中断并重新起批的问题,进行航迹连接处理,获取最优系统航迹连接对,再通过卡尔曼滤波算法进行滤波平滑处理,即可得到最终系统航迹。

利用目标ID 跳变率SID和航迹符合率Ptr表征目标跟踪的准确性和稳定性,其表达式分别为

式中:MS为目标ID 跳变次数;Tobj为单个目标航迹符合时间;Ttr为单个航迹总时间。当真实位置与融合位置角度欧氏距离小于1°时,认为目标航迹符合。

利用雷达-视觉融合系统进行路段实时测试。设测试时长为10 min,纵向距离350 m 内为传感器感兴趣区域。统计目标跟踪情况,路段实时测试结果如表3所示,车辆检测效果如图7所示。

表3 路段实时测试结果

图7 车辆检测效果

由表3可知,相较于雷达、视觉传感器独立工作的情况,本文所提融合系统目标跟踪ID 跳变率为3.45%,分别降低了7.24%、3.46%;航迹符合率达97.6%,分别提升了1.9%、4.4%。测试结果表明,相比于以往的雷达-视觉单帧融合系统,本文所提融合系统在视觉交通场景下工作状态良好,目标跟踪的准确率和稳定性均得到极大提升,同时目标语义信息更加丰富,充分发挥了雷达、视觉传感器的工作优势,互相弥补劣势,大幅提升了传感系统对环境的感知能力。

4 结论

本文在以往雷达-视觉单帧融合算法的基础上进行融合技术优化,基于深度学习、视频结构化技术,采用航迹跟踪算法分别生成视觉、雷达目标航迹,并结合两类传感器的工作特性制定航迹关联融合策略,提高传感器信息的利用率,实现复杂场景下目标的有效感知和稳定跟踪。利用交通场景对该融合系统进行测试验证,结果表明,该融合系统能够实时稳定输出,目标跟踪ID 跳变率和融合系统航迹符合率均得到大幅提升,目标语义信息丰富稳定,目标探测系统的环境感知能力得到有效提升。该系统可应用于交通监控、周界防护等场景,有效支撑多目标环境感知的相关应用。研究成果也可为反无人机群等军事场景应用提供参考。