基于YOLOv5目标识别无线抓拍追踪声音报警系统

2023-06-21黄恒一付三丽

黄恒一 付三丽

摘 要:文章基于YOLOv5目标检测环境的计算机终端,通过配备无线路由器的无线摄像头实现对行人的实时检测,通过deepsort算法对目标行人的方向进行计数,并对其进行跟踪。当目标计算机终端绘制的特定区域出现识别目标时,实现机器视觉语音自动报警,此外,该系统可以抓拍所识别的目标行人的照片。文章内容对研究人员入门机器视觉以及开发视觉相关应用产品具有一定的指导价值。

关键词:抓拍;语音报警;计数;无线路由;deepsort算法

中图分类号:TP391.4;TP18 文献标识码:A 文章编号:2096-4706(2023)09-0018-04

Abstract: In the computer terminal based on YOLOV5 target detection environment, this paper realizes the real-time detection of pedestrians through the wireless camera equipped with a wireless router, and the direction of the target pedestrians is counted and tracked through the deepsort algorithm. When the identified target appears in a specific region drawn by the target computer terminal, the machine vision voice automatic alarm is realized. In addition, the system can capture the photos of the identified target pedestrians. The content of this paper has a certain guiding value for researchers to learn machine vision and develop vision related application products.

Keywords: capture; voice alarm; counting; wireless routing; deepsort algorithm

0 引 言

當下随着嵌入式技术、机器学习、AI等人工智能新兴技术的飞速发展,目标检测应用非常广泛,例如生活中常见的人脸识别、车牌识别等;在自动驾驶领域,有行人识别、车道线识别;还有智能视频监控、机器人导航、飞机航拍等多个领域的应用。目标监测最经典也是最常用的应用之一就是人脸识别。现在的智能手机、人脸支付、安检等功能,都用到人脸检测算法,而且速度快、准确率高。通过智能视觉识别,一群人站在一起,仍然可以清晰地检测出每个人的脸部特征,实现人脸识别。

由于目前的一些嵌入式应用产品中融合了大量人工智能技术、当下人们生活中的嵌入式产品离不开机器视觉、人工智能等技术。机器视觉系统的特点是提高生产的柔性和自动化程度。在一些不适合人工作业的危险工作环境或人工视觉难以满足要求的场合,常用机器视觉来替代人工视觉;同时在大批量工业生产过程中,用人工视觉检查产品质量效率低且精度不高,用机器视觉检测方法可以大大提高生产效率和生产的自动化程度。而且机器视觉易于实现信息集成,是实现计算机集成制造的基础技术。人工智能是计算机科学的一个分支,它通过了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器,该领域的研究包括机器人、语言识别、图像识别、自然语言处理和专家系统等。人工智能可以对人的意识、思维的信息过程进行模拟,能像人那样思考、也可能超过人的智能。论文在机器视觉、人工智能背景下设计了基于YOLOv5目标识别无线抓拍追踪声音报警系统[1]。

论文机器视觉系统在树莓派YOLOv5环境下通过无线路由器配置的摄像头实现对行人数量信息的视觉检测并在显现界面实时统计出监测的行人数量,此外论文视觉目标检测系统可对视觉目标检测区域进行设定,当目标检测区域出现识别目标的时候,监控画面会进行实时识别提示并且电脑端会实现语音报警,此外论文系统可根据目标特征训练的模型,对目标行人进行图片的抓拍,用于进一步跟踪分析行人特征信息。

1 目标识别原理

传统的计算机目标识别原理是通过图像识别器对特定目标进行识别,但是对于一副画面中出现多种目标物体及对机器视觉图像识别处理速度实时性要求较高的一些领域,如自动驾驶等领域,一些新的图像目标识别技术就出现了。论文目标识别系统用到的YOLOv5目标检测算法,该算法是一种将图像划分为网格系统的对象检测算法,网格中的每个单元格负责检测自身内部的对象[2]。

1.1 机器视觉

机器视觉就是利用机器系统代替人的眼睛以及大脑来作出各种测量和判断。采用成像技术(通常使用相机)获取被测目标的图像,再经过快速图像处理,与图形识别算法,从摄取图像中获得目标的尺寸、方位、光谱、结构、缺陷等信息,从而可以执行产品检验,分类与分组,装配线上的机械手运动引导,零部件的识别与定位,生产过程中质量监控与过程控制反馈等任务[3]。

1.2 行人监测

论文中的行人监测主要是通过行人模型识别器,通过搭建Python环境下行人识别环境,当有行人信息通过目标区域的时候,就会将目标行人框选出来,通过deepsort算法对目标行人进行跟踪,并将通过摄像头监测的行人数量信息实时统计出来[4]。

1.3 目标识别语音报警

传统的目标识别系统对目标信息进行检测,论文机器视觉系统在目标检测识别的基础上增加了语音报警、区域检测语音报警等功能。当运行目标检测脚本文件,当目标区域目标物体识别检测到后会联动判断触发后台语音文件,进行后台语音文件的播报[5]。

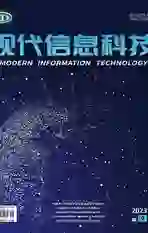

2 系统方案

论文目标识别监控计数报警系统涉及硬件主要有树莓派监控平台,PC电脑端,用于配置树莓派无线摄像头的路由器及监控摄像头。系统运行时,PC、树莓派均要加入系统无线路由器搭建的局域网热点。电脑端通过树莓派远程登录软件VNC进入树莓派桌面端,运行行人目标计数检测报警程序,即可弹出路由器上搭载的USB摄像头即可在PC端接收无线路由器上摄像头视频流监控画面[6]。此外论文目标模型可对摄像头内的目标行人信息进行抓拍、语音报警。论文系统原理结构图如图1所示。

2.1 系统硬件环境

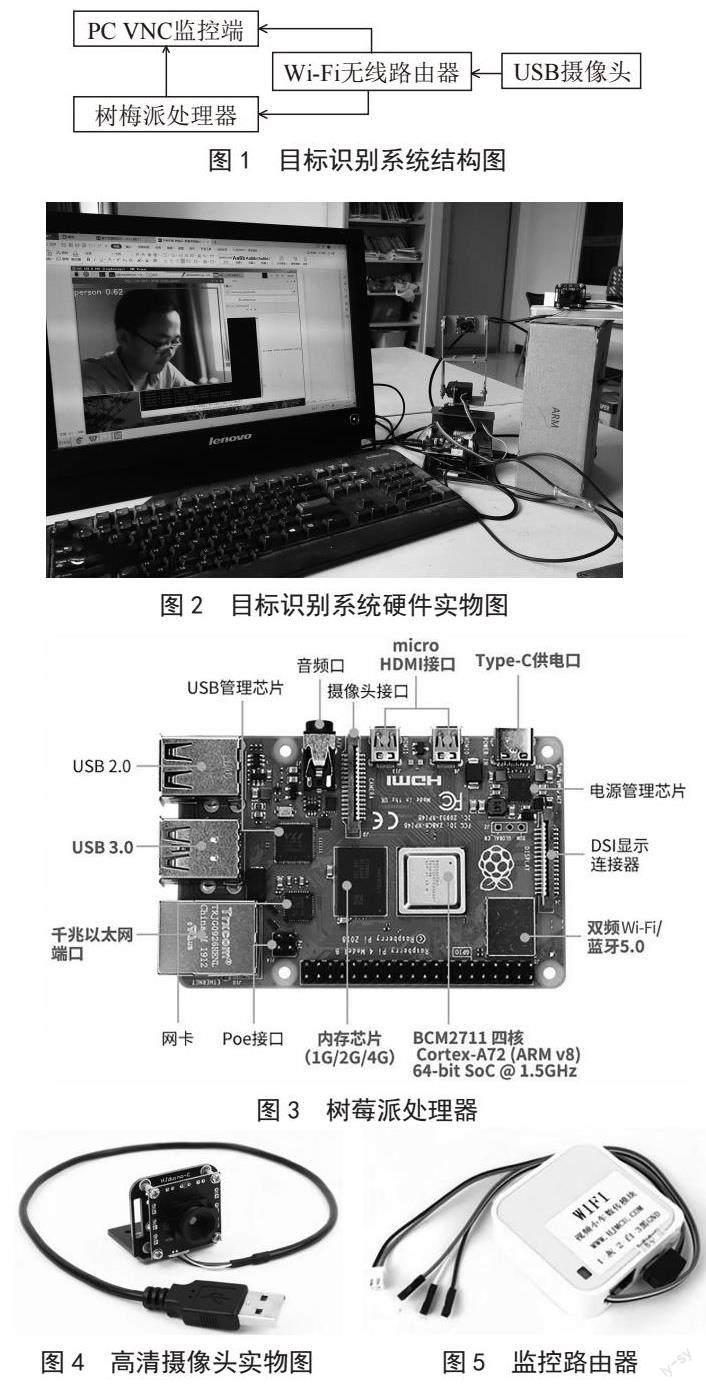

系统目标识别硬件涉及电脑端、树莓派平台、Wi-Fi无线路由器。论文用于训练目标识别模型电脑配置信息如下。系统制造商:LENOVO,系统型号:QiTianA7100-N000,BIOS:LENOVO BIOS,版本:F0KT39A 0.0,处理器:Intel(R)Pentium(R)CPU G2030@3.00 GHz(2个CPU)~3.0 GHz,内存:4 096 MB RAM,可用操作系统内存:3 918 MB RAM,页面文件:使用3 406 MB,可用4 426 MB。电脑端用于训练目标识别的模型文件及通过VNC软件登录树莓派处理器进行目标行人的监控显示,可移动监控平台用于對目标区域行人数量信息进行实时检测、统计人数并可实现对目标行人进行抓拍运算,Wi-Fi路由器用于搭建目标识别系统的局域网热点。系统硬件搭配实物图如图2所示。

2.1.1 树莓派硬件

论文行人数量统计应用案例用到的树莓派处理器如图3所示,它是一款基于ARM的微型电脑主板,以SD/MicroSD卡为内存硬盘,卡片主板周围有1/2/4个USB接口和一个10/100以太网接口(A型没有网口),可连接键盘、鼠标和网线,同时拥有视频模拟信号的电视输出接口和HDMI高清视频输出接口,以上部件全部整合在一张仅比信用卡稍大的主板上,具备所有PC的基本功能只需接通电视机和键盘,就能执行如电子表格、文字处理、玩游戏、播放高清视频等诸多功能[7]。

2.1.2 无线监控模块

监控模块由Wi-Fi数传模块和高清摄像头组成。具体工作过程如下,高清摄像头拍摄实时监控画面传给数传模块,Wi-Fi数传模块再通过Wi-Fi将画面传输手机或者平板中。Wi-Fi数传模块供电电压为5 V,驱动电流为1 A,搭载64 M RAM储存,配备一个USB接口,天线上搭载大功率板载天线,通过TTL串口进行通信。高清摄像头模块通过USB接口与数传模块相连,其供电电压为5 V,像素为30万,输出帧率为30 FPS,支持手动调焦[8]。如图4和图5所示,分别为高清摄像头和Wi-Fi数传模块实物图。

2.2 系统软件环境

论文目标识别系统软件通过PC端进行环境搭建。PC端环境搭建需要acona、Python、PyCharm进行实验测试环境的搭建。通过PyCharm加载目标源文件、通过acona搭建目标测试的虚拟环境。行人模型的生成是通过Lambel软件,进行行人图片信息的标注,生成行人数据集,通过PyCharm进行行人数据集的训练,生成best.pt行人模型文件,后续导入到树莓派中,分别进行行人图片、行人视频、摄像头行人信息的实时识别,实现抓拍、跟踪、语音报警功能。

2.2.1 声音监控区域代码

限定区域监控语音报警代码如下,让目标区域检测出识别目标即实现机器端的语音声音文件报警。

<bndbox>

<xmin>1034</xmin>

<ymin>167</ymin>

<xmax>1366</xmax>

<ymax>565</ymax>

</bndbox>

上述代码中的数值就是声音监控区域框面积的代码,通过在程序中进行数值的调整,即可实现目标监控区域位置、大小的变化。

2.2.2 目标识别代码

目标识别系统硬件环境Wi-Fi热点搭配完毕后,PC端通过VNC软件登录树莓派处理器桌面端,通过运行监控计数代码,即可实现对目标图像的监控识别。树莓派命令终端目标识别代码如下:

python3 detect.py --source http://@192.168.8.1:8083/?action=stream

上述代码中的http://@192.168.8.1:8083/?action=stream就是Wi-Fi路由器搭配的摄像头视频流[9],树莓派终端Python程序运行完毕后,即可通过Wi-Fi路由器上的摄像头实现目标行人的识别,目标识别画面如图6所示。

2.2.3 追踪目标检测线代码

目标识别追踪系统中黄色横线用来检测摄像头视野中有多少目标通过特定的检测线,目标横线检测代码如下。

mask_image_temp = np.zeros((1080, 1920), dtype=np.uint8)

list_pts_yellow = [[50, 50], [50, 150], [1850, 150], [1850, 50]]

ndarray_pts_yellow = np.array(list_pts_yellow, np.int32)

polygon_yellow_value_2 = cv2.fillPoly(mask_image_temp, [ndarray_pts_yellow], color=2)

polygon_yellow_value_2 = polygon_yellow_value_2[:, :, np.newaxis]

通过上述代码分析,坐标点位置的判断:

图片格式为1 080×1 920,即图片长宽分别为1 920和1 080,在此范围内取值即为坐标点。

例:取任意四点,[[500,500],[500,600],[1 000,600],[1 000,500]]

目标追踪检测结果画面如图7所示。

改变3和4的坐标,使其增大800即[1 800,600],[1 800,500]结果如图8所示。

由上述图7和图8可以得知,横坐标增大向右偏移;反之向左偏移,纵坐标增大向下偏移;反之向上偏移。黄线的位置为坐标点之间依次连线围成的封闭图形。

2.3 行人区域声音报警

论文系统可以进行目标区域的绘制,目标对象进入目标区域方框界限的时候,电脑端监控区域画面会进行识别报警提示,此外电脑端会播放警报声音,当目标区域没有目标对象的时候,电脑端不会发出报警声音提示[10]。摄像头监控画面端目标区域行人识别正常画面和报警画面如图9和图10所示。

2.4 行人抓拍

论文系统根据训练的模型标注情况可以对目标行人进行自动抓拍,当路由器搭载的无线监控摄像头中出现目标行人信息的时候,会对目标信息进行自动抓拍。摄像头监控画面和树莓派端目标行人抓拍画面如图11和图12所示。

2.5 行人追踪

论文目标识别系统除了前文叙述对目标图像进行计数、抓拍,还可以对摄像头目标图像进行轨迹跟踪,通过运行目标跟踪,可以实现对目标图像的精确分析。目标图像视觉跟踪画面如图13和图14所示。

由图13和图14可以得知,调整图中目标检测线的位置即可实现对经过目标检测线的人数的确切统计并实时显示在画面的上端。

3 创新点

论文目标检测系统增加无线监控模块,通过配置无线路由器使得树莓派可以通过Wi-Fi的方式连接无线摄像头,增加了监控设备的可移动性。论文视觉目标检测模型增加了检测目标对象进行语音报警功能及特定区域目标对象语音报警模块,目标对象语音报警功能提高了系统对特定对象检测反馈的效率,此外论文目标识别系统可对目标行人进行自动抓拍并保存本地端。

4 结 论

当下机器视觉逐渐渗入社会生活的方方面面,在人脸识别、图片识别、视频监控、3C应用等各领域几乎都能看到机器视觉的身影,对于工业领域而言,机器视觉的应用更是大大降低了高危作业的危险系数,保障了工业生产的安全性和高效性。论文基于树莓派处理器实现的机器视觉目标行人机器视觉环境下区域声音报警、抓拍、跟踪功能测试效果符合预期要求,论文研究的基于YOLOv5技术的声音报警系统可拓展至相关特定目标的识别及安防监控领域。随着嵌入式技术、人工智能、大数据技术的發展,论文研究的内容与相关技术的融合结合应用范围会越来越广泛。

参考文献:

[1] 王曼菲,李志明.基于深度学习的港口移动目标识别技术研究 [J].中国水运,2022(10):59-60.

[2] 宋波.水下目标识别技术的发展分析 [J].舰船电子工程,2014,34(4):168-173.

[3] 王亮,陈建华,李烨.一种基于深度学习的无人艇海上目标识别技术 [J].兵工学报,2022,43(S2):13-19.

[4] 曹健,王武军,韩飞,等.基于局部特征的目标识别技术研究 [J].计算机工程,2010,36(10):203-205.

[5] 崔磊.针对多种声特征的声目标识别技术研究 [J].价值工程,2011,30(14):198-199.

[6] 李峰,詹邦成,辛蕾,等.基于新型联合感知矩阵的压缩学习目标识别技术 [J].电子学报,2021,49(11):2108-2116.

[7] 脸部描述和目标识别技术 [J].电脑与电信,2011(2):32.

[8] 唐自力,马彩文.基于航迹和特征的目标识别技术在多目标跟踪中的应用 [J].光子学报,2010,39(2):375-379.

[9] 薛武,赵玲,王鹏.星地协同光学遥感影像目标识别技术验证研究 [J].航天返回与遥感,2021,42(3):128-137.

[10] 唐绍富,段兰兰.基于遥感图像的船舶目标识别技术 [J].舰船科学技术,2020,42(14):85-87.

作者简介:黄恒一(1988.03—),男,汉族,河南信阳人,讲师,硕士研究生,研究方向:机器视觉、路径规划;付三丽(1985.10—),女,汉族,河南开封人,讲师,硕士研究生,研究方向:网络安全。