基于mBERT的东南亚小语种推特文本情感分析

2023-05-30贺友程

贺友程

摘要:小语种由于其训练语料资源稀缺,在自然语言处理领域一直是一大难题,使用传统的机器学习方法与神经网络方法,具有很大的瓶颈。而跨语言预训练语言模型的出现,对于低资源语种的包括文本分类在内的多项任务,都起到了很大的提升效果。在基于海量语料训练得到的跨语言预训练语言模型mBERT的基础上进行微调,相较于传统的机器学习方法,在情感分析任务的效率和准确度都可得到不错的提升。

关键词: 小语种;预训练语言模型;文本分类;情感分析;BERT

中图分类号:TP391 文献标识码:A

文章编号:1009-3044(2023)01-0074-03

1 引言

对小语种文本的情感分析的方法,经历了从构建其情感词典并采用基于规则的无监督方法、挖掘其文本特征并采用有监督的分类方法,再到基于跨语种的方法。然而,传统基于机器翻译的方法,或直接将源语种情感词典翻译为目标语种,或直接將目标语种翻译为源语种后进行训练,模型效果不够理想。

对于低资源语种的情感分析,文献[1]通过将目标小语种机器翻译为源语种,通过英语情感分类器对目标小语种实现分类;文献[2]提出CoNBiLSTM词嵌入模型在多语言和多领域环境中进行文本分类;文献[3]比较了4种机器学习方法对少量的印尼语推特文本进行情感分析的效果;文献[4]提出LAAE网络模型,通过LSTM+AAE获得跨语言情感向量后利用双向GRU进行情感分类任务;文献[5]提出基于时间卷积注意力胶囊网络的维吾尔语情感分类模型;文献[6]研究了通过多任务学习训练小语种文本的情感分析模型。

BERT[7]通过词嵌入、句子类别、位置信息3个维度的特征,通过MLM与NSP进行微调,在包括文本分类在内的多项任务中均取得良好效果。而mBERT跨语言模型则是BERT的一个分支,支持100多种语言的多项NLP任务。本文将mBERT运用到东南亚小语种推特文本的情感分析中,构建目标语种数据集,对mBERT的输出层进行调整后,通过微调训练实现目标东南亚小语种推特文本的情感分析器。

2 数据预处理与数据集构建

Sentiment140[8]是由Go等构建的包含了1,600,000条从推特爬取的推文的数据集,可用于情感分析相关的训练。本文基于其首先构建了源语言的微调训练数据集,并借助谷歌翻译构建了目标语言的微调训练数据集。

2.1 源语言微调数据集构建

Sentiment140数据集可用于研究推特中关于品牌、产品、话题的情感极性,它移除了推文中的表情符号,以csv文件格式存储。它标注了推文的情感极性(积极情感用4表示,消极情感用0表示)、ID、发布时间、发布用户与内容等信息,其格式如表1所示。

对于微调训练数据集,仅需要关注其推文内容与情感极性,因此本文从中分别截取了仅包含推文情感标注与推文内容的10000条正向情感推文与负向情感推文,共20000条数据作为源语言微调数据集。

2.2 构建目标语言微调训练数据集

本文利用了GitHub上的开源工具googletrans调用谷歌翻译任务,它具备快速、可靠的特点,支持源语言自动识别、批量翻译、自定义服务地址以及HTTP/2。它的原理是通过构造AJAX请求完成谷歌翻译的请求过程,再对HTTP GET请求的返回结果进行解析,得到最终的翻译结果。通过设置多个翻译服务地址,可以使其在每次翻译时随机选择一个服务地址进行请求,避免短时间内对同一个地址进行多次请求。

3 mBERT模型与微调

BERT模型的输入表示由字向量(Token Embedding) 、文本向量(Segment Embedding) 和位置向量(Position Embedding) 三部分求和而成,模型输出为各字对应的融合全文语义信息后的向量表示,内部则是由Transformer编码器堆叠而成。

BERT的多语言版本mBERT直接使用多语言的单语语料,采用MLM作为训练目标进行训练,过程中没有加入任何信息来指示每句话的语种,也没有促使不同语言同义句具有相似表达的显性机制。它有cased与uncased两个模型,均具备12层Transformer块、768维的字向量与12个注意力机制头。而前者会考虑字符的大小写并支持非拉丁字符,因此本文选择前者进行微调训练。

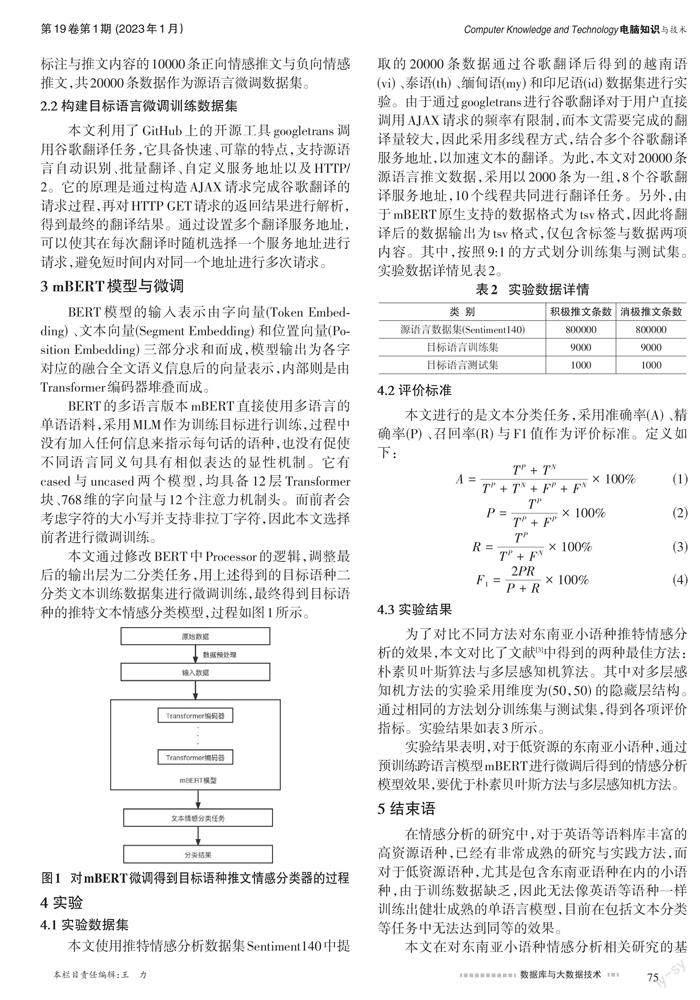

本文通过修改BERT中Processor的逻辑,调整最后的输出层为二分类任务,用上述得到的目标语种二分类文本训练数据集进行微调训练,最终得到目标语种的推特文本情感分类模型,过程如图1所示。

4 实验

4.1 实验数据集

本文使用推特情感分析数据集Sentiment140中提取的20000条数据通过谷歌翻译后得到的越南语(vi) 、泰语(th) 、缅甸语(my) 和印尼语(id) 数据集进行实验。由于通过googletrans进行谷歌翻译对于用户直接调用AJAX请求的频率有限制,而本文需要完成的翻译量较大,因此采用多线程方式,结合多个谷歌翻译服务地址,以加速文本的翻译。为此,本文对20000条源语言推文数据,采用以2000条为一组,8个谷歌翻译服务地址,10个线程共同进行翻译任务。另外,由于mBERT原生支持的数据格式为tsv格式,因此将翻译后的数据输出为tsv格式,仅包含标签与数据两项内容。其中,按照9:1的方式划分训练集与测试集。实验数据详情见表2。

4.2 评价标准

本文进行的是文本分类任务,采用准确率(A) 、精确率(P) 、召回率(R) 与F1值作为评价标准。定义如下:

4.3 实验结果

为了对比不同方法对东南亚小语种推特情感分析的效果,本文对比了文献[3]中得到的两种最佳方法:朴素贝叶斯算法与多层感知机算法。其中对多层感知机方法的实验采用维度为(50,50) 的隐藏层结构。通过相同的方法划分训练集与测试集,得到各项评价指标。实验结果如表3所示。

实验结果表明,对于低资源的东南亚小语种,通过预训练跨语言模型mBERT进行微调后得到的情感分析模型效果,要优于朴素贝叶斯方法与多层感知机方法。

5 结束语

在情感分析的研究中,对于英语等语料库丰富的高资源语种,已经有非常成熟的研究与实践方法,而对于低资源语种,尤其是包含东南亚语种在内的小语种,由于训练数据缺乏,因此无法像英语等语种一样训练出健壮成熟的单语言模型,目前在包括文本分类等任务中无法达到同等的效果。

本文在对东南亚小语种情感分析相关研究的基础上,探索了采用预训练跨语言模型mBERT进行微调的方法对目标语种推特文本的情感分析,实验结果表明该方法可以获得比传统的朴素贝叶斯方法与多层感知机方法更好的效果。然而,由于本文微调数据集基于机器翻译得出,因此最终模型可能受机器翻译模型效果的影响。未来可通过对微调训练数据进行降噪处理、改善微调模型等,提升情感分类效果。

参考文献:

[1] Can E F,Ezen-Can A,Can F.Multilingual sentiment analysis:an RNN-based framework for limited data[EB/OL].[2021-09-20].2018:arXiv:1806.04511.https://arxiv.org/abs/1806.04511.

[2] Nguyen H T,Le Nguyen M.Multilingual opinion mining on YouTube - A convolutional N-gram BiLSTM word embedding[J].Information Processing & Management,2018,54(3):451-462.

[3] Indriani D,Nasution A H,Monika W,et al.Towards a sentiment analyser for low-resource languages[M]//Proceedings of International Conference on Smart Computing and Cyber Security.Singapore:Springer Singapore,2020:109-118.

[4] 沈江紅,廖晓东.基于LAAE网络的跨语言短文本情感分析方法[J].计算机系统应用,2021,30(6):203-208.

[5] Luo H, Yang Y, Dong R, et al. 基于时间注意力胶囊网络的维吾尔语情感分类模型 (Uyghur Sentiment Classification Model Based on Temporal Attention Capsule Networks)[C]//Proceedings of the 20th Chinese National Conference on Computational Linguistics, 2021: 248-257.

[6] Hande A,Hegde S U,Priyadharshini R,et al.Benchmarking multi-task learning for sentiment analysis and offensive language identification in under-resourced Dravidian languages[EB/OL]. [2022-03-20].2021:arXiv:2108.03867.https://arxiv.org/abs/2108.03867.

[7] Devlin J,Chang M W,Lee K,et al.BERT:pre-training of deep bidirectional transformers for language nderstanding[EB/OL].[2021-09-20].2018:arXiv:1810.04805.https://arxiv.org/abs/1810.04805.

[8] Go A,Bhayani R,Huang L.Twitter sentiment classification using distant supervision[J].CS224N project report, Stanford,2009,1(12):2009.

【通联编辑:光文玲】