基于分区编码坐标的目标物体6D位姿检测网络

2023-03-16张云瞻张剑江天乐

张云瞻 张剑 江天乐

1.同济大学机械与能源工程学院;2.浙江巨化联州制冷科技有限公司

基于建立2D-3D坐标密集对应的两阶段方法是对目标物体进行6D位姿检测的一类解决方案。本文在前人的基础上改进,提出了ZC-Pose,一种基于分区编码坐标的目标物体6D位姿检测网络框架,其仅使用RGB数据和模型信息对目标位姿进行预测。本文在Linemod数据集上测试其表现,相较于该领域的一项经典工作——CDPN中的旋转分支部分有了可观的提升,并且与其他相关工作进行比较,也表现出了具有竞争力的结果。

1 研究背景介绍

如何检测目标物体的6D位姿是计算机视觉领域广受关注的热点问题之一,在机器人抓取[1]、增强现实[2,3]和自动驾驶[4-6]等方面都有着重要意义。此问题的传统解决方案包含基于特征描述子[7-9]和模板匹配[10,11]的一些方法。有赖于深度学习技术的深入发展,近年来关于目标物体位姿估计的很多研究使用相机拍摄得到的RGB或RGB-D数据,在普通环境和带遮挡的环境下都表现出了令人印象深刻的准确性和效率。

一般来说,基于深度学习的目标位姿估计可以分为间接法和直接法。间接法主要通过各种特征图——例如,建立图像像素坐标系上2D点与已知的目标模型上3D点坐标之间的对应关系,然后通过透视n点投影(PnP)算法或其衍生算法[12]得出目标物体坐标系与相机坐标系之间的转换矩阵,而直接法则直接回归出旋转和平移参数等信息来进行预测[13]。

基于坐标的分离位姿网络[14](CDPN)的结构分为旋转和平移两个分支,将旋转分支输出的坐标特征图用PnP/RANSAC算法计算得出旋转矩阵,而平移分支直接回归得出平移向量,充分利用了两种姿态估计方式的优势,在多个常用数据集上得出了优异的结果。其主要缺陷是网络结构较为臃肿;训练方法也分为仅旋转、仅平移和旋转平移融合的三步方式来进行训练,导致训练消耗的时间过多。

我们旨在开发一个具有堪比CDPN的准确性,且具有更简练结构和训练过程的、仅使用RGB数据的网络。我们在本文中提出了ZC-Pose,一种在CDPN之上改进的基于2D-3D密集对应和PnP/RANSAC算法的两阶段的目标位姿检测算法。

2 研究方法

在下文中,我们首先在第一节中回顾CDPN方法中如何通过网络预测与像素二维坐标对应的目标物体三维坐标,讨论掩膜图(Mask)预测相较于目标的坐标特征图对于网络误差的鲁棒性高低;随之在第二节中引出我们提出的分区编码坐标的概念;在第三节中讨论如何设计基于这一概念的网络框架。

2.1 回顾基于模型坐标建立2D-3D对应关系的方法

CDPN中网络的输出层包括64×64×3的目标物体坐标值特征图与64×64×1的掩膜图像。CDPN采用了大多数网络偏好零对称输出的观点,将网络所需要预测的特征图中的目标物体坐标值转化到[-1,1]的区间,如式(1)所示:

其中i∈{1,2,3},分别表示x,y和z三个维度,C代表目标物体的坐标值,max为单个维度上的最大值,默认目标物体坐标系的原点位于三维包围盒的中心,所以有Ci∈[-maxi, maxi]。而用于训练的掩膜图像的取值为{0,1},以1标示目标物体所在的像素点,其余为背景。

图3 ZC-Pose网络框架示意图Fig.3 ZC-Pose network framework diagram

其中M*和分别表示训练用的真实数据与网络预测的特征图,°表示哈达玛积,Mcoor表示编码坐标特征图,Mconf表示辨别物体与背景的掩膜图像,Mzone表示用于区分物体区块的掩膜图像。

3 实验

3.1 实验设置

(1)应用细节:我们的网络使用Ranger优化器,在一块RTX 3060显卡上进行训练,CPU配置为i5 8400H。我们使用的训练批量大小为16,基础学习率为1e-4,损失LZC的参数的α为1,β,γ均为0.6。

(2)数据集:我们在一个用于目标6D位姿检测的标准数据集中进行实验:Linemod(LM)[15]。LM数据集包含13个目标物体,每个目标物体都有大约1.2k张包含光线变化、无纹理特征和遮挡等各类复杂情况的RGB图像及其准确姿态。我们选择其中占总数大约15%的图像,加上每个目标1k张用OpenGL合成出的图像作为训练数据,再把剩余85%的图像用于测试[16]。

(3)评估指标:我们采用最常用的一些指标将我们的方法与CDPN和其他方法的表现进行比较。ADD(-S)[15]测量与真实值之间偏差低于物体外接球的直径10%的变换模型点的百分比。对于对称对象,ADD(-S)测量到最接近的模型点的偏差。此外,n°n cm用于表达旋转误差小于n度且平移误差小于n cm的预测6D姿态占总数的百分比。2D投影误差(Proj-2D)所用的是将模型点投影到图像坐标系形成的像素度量上的误差,以相差5个像素以内的比例作为指标。

3.2 LM数据集上的实验

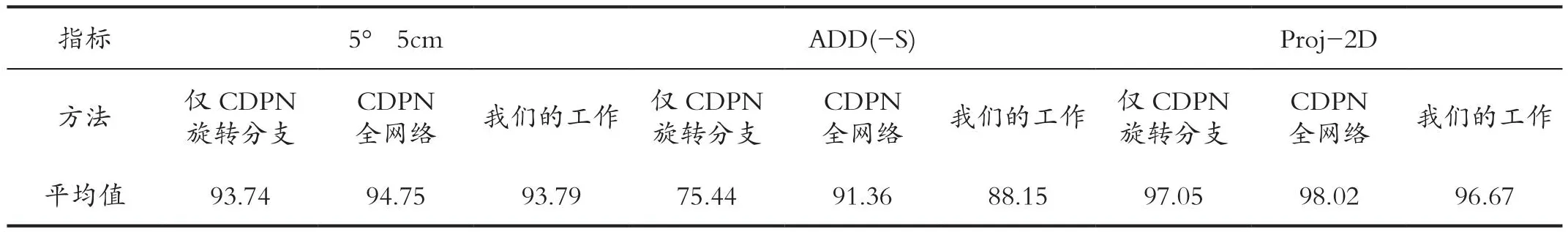

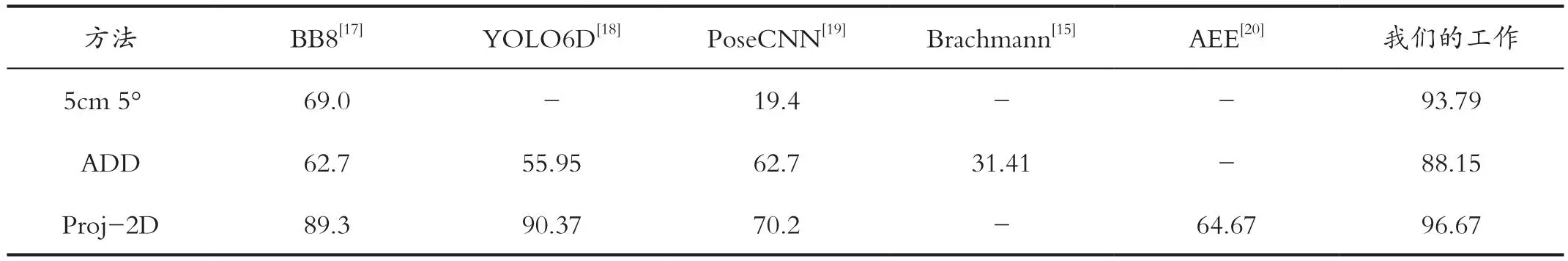

如表1所示,我们的工作对比仅用CDPN旋转分支的结果,在5°5cm上提升了0.05%,在ADD上提升12.71%,在Proj-2D上稍降0.38%;对比CDPN的全网络结构,虽然性能稍有下降,但训练时间大约减少了一半,储存参数所需大小由432.8MB下降到了103.72MB。如表2所示,与一些经典工作相比,ZC-Pose的预测性能很有竞争力。

表1 ZC-Pose与CDPN性能的比较Tab.1 Performance comparison between ZC-Pose and CDPN

表2 ZC-Pose与其他工作的对比Tab.2 Comparison between ZC-Pose and other works

4 结论

本文在CDPN网络框架的基础上设计出仅使用RGB图像数据的、基于分区编码坐标的目标物体6D位姿估计网络,经过测试得知其相对于CDPN有切实的改进,并且相对于其他相关工作也拥有较高的性能。

引用

[1]Alvaro Collet,Manuel Martinez,Siddhartha S Srinivasa.The MOPED Framework:Object Recognition and Pose Estimation for Manipulation[J].The International Journal of Robotics Research,2011,30(10):1284-1306.

[2]AZAD P,ASFOUR T,DILLMANN R.Stereo-based 6D Object Localization for Grasping with Humanoid Robot Systems[C]//Intelligent Robots and Systems.IEEE,2007.

[3]Eric Marchand,Hideaki Uchiyama,Fabien Spindler.Pose Estimation for Augmented Reality:a Hands-on Survey[J].IEEE Transactions on Visualization and Computer Graphics(TVCG),2015,22(12):2633-2651.

[4]Tan David Joseph,Tombari Federico,Navab Nassir.Real-Time Accurate 3D Head Tracking and Pose Estimation with Consumer RGB-D Cameras[J].International Journal of Computer Vision,2018,126(2-4):158-183.

[5]Fabian Manhardt,Wadim Kehl,Adrien Gaidon.ROI10D:Monocular lifting of 2d detection to 6d pose and metric shape[C]//IEEE Conference on Computer Vision and Pattern Recognition,2019:2069-2078.

[6]CHABOT F,CHAOUCH M,RABARISOA J C.Teuliere and T.Chateau, Accurate 3D car pose estimation[C]//IEEE International Conference on Computer Vision(ICCV),2016:3807-3811.

[7]LOWE D G.Distinctive Image Features from Scale-Invariant Keypoints[J].International Journal of Computer Vision,2004,60(2):91-110.

[8]BAY H,TUYTELAARS T,GOOL L V.SURF:Speeded Up Robust Features[C]//European Conference on Computer Vision.Springer-Verlag,2006:404-417.

[9]RUBLEE E,RABAUD V,KONOLIGE K,et al.ORB:An efficient alternative to SIFT or SURF[C]//International Conference on Computer Vision.IEEE,2012:2564-2571.

[10]HUTTENLOCHER D P,KLANDERMAN G A,RUCKLIDGE W J.Compaing images using the Hausdorff distance[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1993,15(9);850-863.

[11]HINTERSTOISSER S,LEPETIT V,ILIC S,et al.Dominant orientation templates for Real-Time detection of Texture-Less objects[C]//Computer Vision and Pattern Recognition,2010:2257-2264.

[12]Lepetit Vincent,Moreno-Noguer Francesc,Fua Pascal.EPnP:An Accurate O(n) Solution to the PnP Problem[J].International Journal of Computer Vision,2009,81(2):155-166.

[13]Gu Wang,Fabian Manhardt,Federico Tombari,et al.GDR-Net:Geometry-Guided Direct Regression Network for Monocular 6D Object Pose Estimation[C]//IEEE Conference on Computer Vision and Pattern Recognition,2021.

[14]LI Z G,WANG G,JI X Y.CDPN:Coordinates-Based Disentangled Pose Network for RealTime RGB-Based 6-DoF Object Pose Estimation[C]//IEEE International Conference on Computer Vision,2019:7677-7686.

[15]Tomas Hodan,Martin Sundermeyer,Bertram Drost,et al.BOP Challenge 2020 on 6D Object Localization[C]//European Conference on Computer Vision Workshops(ECCVW),2020:577-594.

[16]Eric Brachmann,Frank Michel,Alexander Krull,et al.Uncertaintydriven 6D Pose Estimation of Objects and Scenes from a Single RGB Image[C]//IEEE Conference on Computer Vision and Pattern Recognition(CVPR),2016:3364-3372.

[17]RAD M,LEPETIT V.BB8:A Scalable,Accurate,Robust to Partial Occlusion Method for Predicting the 3D Poses of Challenging Objects without Using Depth[C]//IEEE International Conference on Computer Vision,2017:3706-4442.

[18]Bugra Tekin,Sudipta N Sinha,Pascal Fua.Real-Time Seamless Single Shot 6D Object Pose Prediction[C]//IEEE Conference on Computer Vision and Pattern Recognition(CVPR),2018:292-301.

[19]Yu Xiang,Tanner Schmidt,Venkatraman Narayanan,et al.PoseCNN:A Convolutional Neural Network for 6D Object Pose Estimation in Cluttered Scenes[C]//14th Conference on Robotics-Science and Systems,2018.

[20]SUNDERMEYER M,MARTON Z C,DURNER M,et al.Implicit 3D Orientation Learning for 6D Object Detection from RGB Images[C]//European conference on computer vision,2018:712-729.