基于先验机制的级联目标跟踪算法研究

2023-03-07钟小勇黄林辉

杨 浩,钟小勇,黄林辉

(江西理工大学 理学院,江西 赣州 341000)

0 引言

目标跟踪是计算机视觉中一个重要的研究方向,在动作识别[1]、视频监控[2]和无人机[3]领域已经具有了广泛应用。然而跟踪情况复杂多变,目标跟踪容易受光照、遮挡和背景干扰等因素干扰,在实际应用中,长时间稳定跟踪目标依旧是待解决的问题。目标跟踪根据观测模型可分为生成式模型和判别式模型[4]。如今主流跟踪模型为判别式模型,基于相关滤波的目标跟踪算法是典型的判别式模型,由于其优越的精确性和鲁棒性而广受关注。

早在2010年,Bolme等[5]将相关滤波引入目标跟踪算法,提出了最小平方误差输出和(MOOSE)跟踪算法,该算法通过计算目标与样本的最小平方差的方式训练滤波器,同时计算从时域转入傅里叶域,减小计算量,具有较快的跟踪速度。2012年,Henriques等[6]在MOOSE基础上加入循环结构,提出了了循环结构检测(CSK)跟踪算法,该算法通过循环矩阵扩充目标样本,提高了分类能力,由于CSK算法使用单通道的灰度特征,目标特性表现不足。2014年,Henriques等[7]针对此问题提出了核相关滤波(KCF)算法,该算法扩充单通道,使用多通道的梯度直方图(HOG)特征,提升目标的表征能力,使跟踪精度有了较大提高。

近年来,深度卷积神经网络在目标检测和目标分类方向具有较好的表现[8]。很多学者也将深度卷积神经网络引入目标跟踪领域,有效地提高了跟踪的准确性。基于深度卷积神经网络的目标跟踪算法主要分为2类:一类为端到端离线训练的目标跟踪算法,主要有基于孪生网络的目标跟踪算法[9],该类算法具有较高的精度,但丢弃实时更新模型,当目标形状发生变化,同时周围出现过多与目标相似物体时,容易丢失目标;另一类则是深度特征和相关滤波结合的目标跟踪算法[10],采用预训练的神经网络作为特征提取工具。使用深度特征有效提高了目标表征能力,但只适用单一特征和固定学习率,当跟踪过程中出现遮挡情况容易丢失目标。

针对以上问题,本文提出一种基于先验机制的级联目标跟踪方法。利用先验机制计算出当前帧出现的挑战情况,在不同情景选择适当特征,同时加入级联结构预测目标位置,提高跟踪精确度。当背景出现干扰时,学习率进行阶段性衰减,减少模型的污染,解决固定学习率引起的鲁棒性差的问题。

1 判别式相关滤波模型

相关滤波模型使用岭回归方式训练分类器,在下一帧计算出最大响应值作为目标位置。设一帧图像为X,对当前图像进行提取目标多通道特征xi。损失函数如下所示:

(1)

式中,y为期望目标;hi(i=1,2,…,D)表示每个通道所获取的滤波器;*表示循环卷积;λ为正则化参数。滤波器hi通过式(1)转入频域求解可得:

(2)

在后续帧利用训练好的滤波器进行预测目标位置。对下一帧图像,设其搜索区域为z,对此区域进行检测,通过式(3)获得响应图r:

(3)

最后采用插值的方式更新外观模型和滤波器模型,更新方式为:

(4)

式中,t为当前帧的序号;η为学习率;x为目标样本模型;h为滤波器模型。

2 基于先验机制的级联目标跟踪算法

2.1 目标跟踪算法整体流程

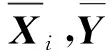

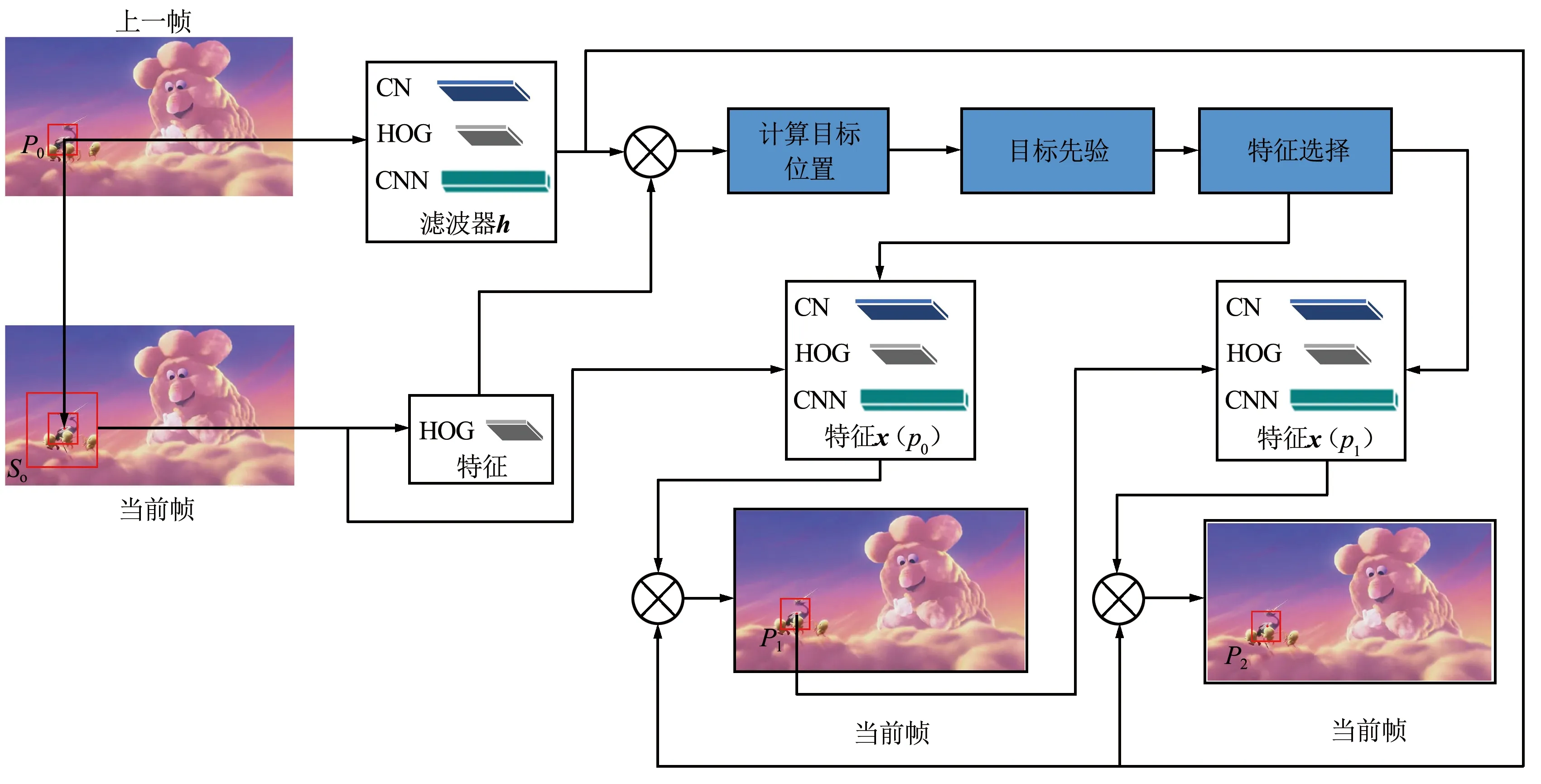

本文提出目标跟踪算法主要由目标先验、级联预测和模型更新3部分组成,整体流程如图1所示。目标先验部分主要利用上一帧训练好的滤波器预测目标位置,然后对目标区域进行先验,判别出当前帧出现的挑战情况,进而选取适当特征进行级联。级联预测采用2级预测方式;第1级预测目标位置并传递给第2级;第2级以上一级预测的目标位置为中心提取特征,再次计算出目标位置,以此来减少目标定位误差。当目标区域受到干扰,在模型更新阶段,使学习率衰减,减轻模型污染。

图1 目标跟踪算法整体流程Fig.1 Overall flowchart of target tracking algorithm

2.2 目标定位漂移问题

级联结构在很多领域都有涉及,如语音处理[11]和深度特征提取[12],通过对目标逐渐剖析,获取更精确的信息。文献[13]发现前一帧预测位置与目标真实位置越接近,后续帧计算目标位置越准确,所以在检测阶段加入级联结构来提高跟踪精确度。

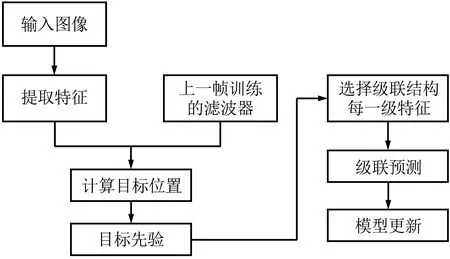

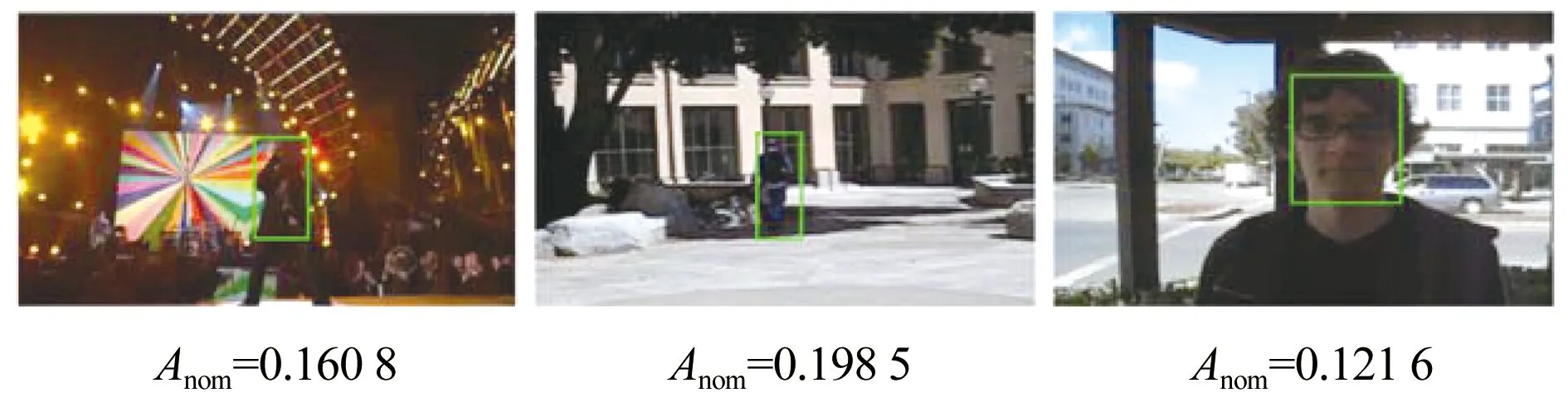

虽然使用级联结构在无干扰场景下能够减少定位误差,但是当目标区域受到干扰时,如运动模糊和光照等原因,在级联结构的第1级目标定位会发生飘移,而且这样的情况还会延续到下一级。具体以OTB数据集中图像序列分析,如图2(a)75帧、图2(b)171帧和图2(c)12帧所示。因运动模糊、目标旋转和快速运动等原因,使用单特征预测目标位置,其定位误差继续增加,而采用相同特征级联预测目标位置,出现连续漂移现象,其定位误差相比单特征更高。

图2 不同特征目标位置与真实值位置误差Fig.2 Error diagram of target position and true value for different features

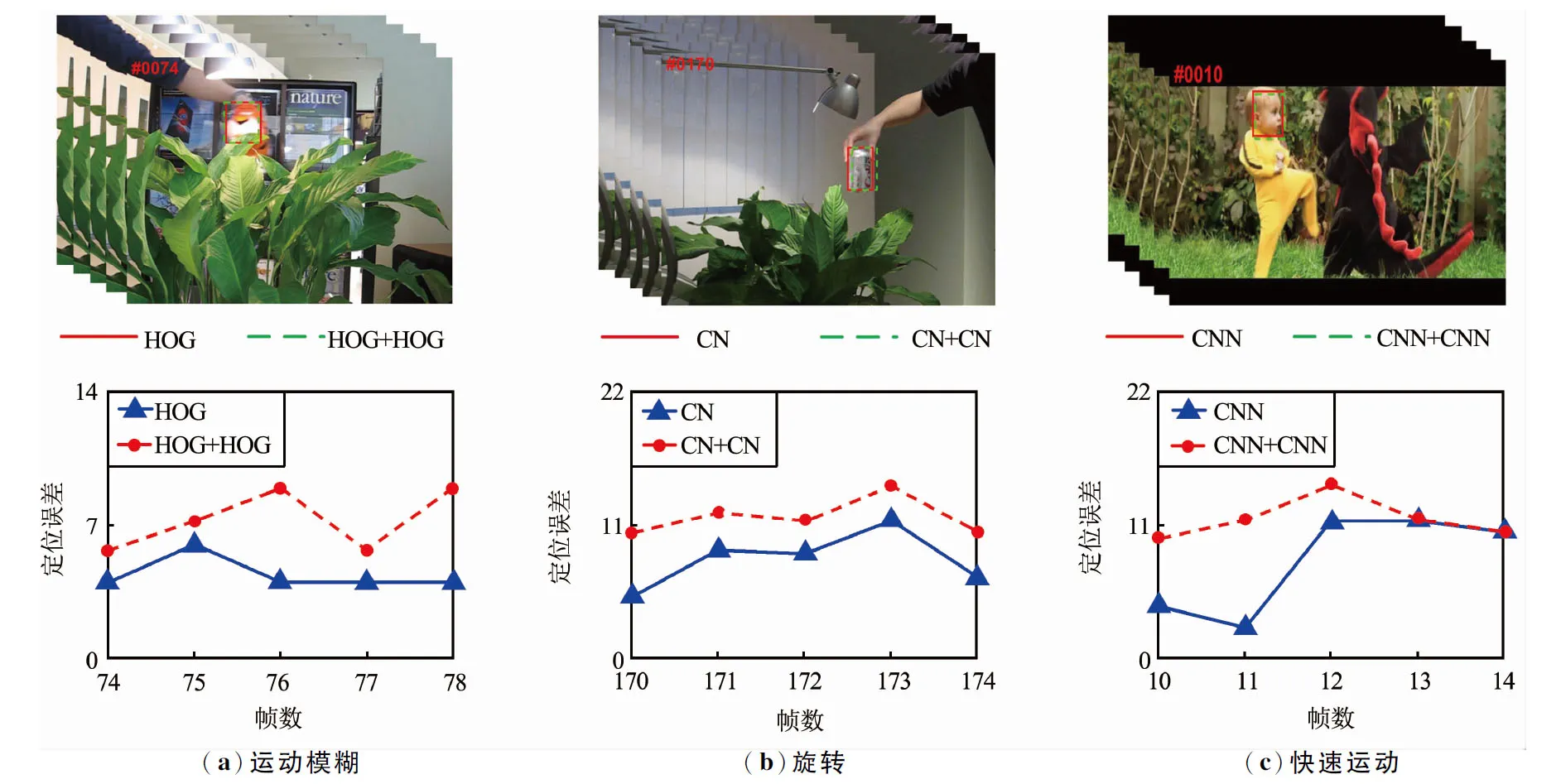

使用不同的特征进行级联能够消除连续漂移问题,图3为视频序列集singer2每帧定位误差,箭头指示为使用颜色名称(CN)特征跟踪目标发生严重漂移位置。如图3(a)所示,在目标未丢失前,并未出现因第1级漂移而引起的第2级继续漂移的现象。虽然预测阶段使用不同特征级联使得连续漂移问题得以解决,但是由于光照影响,使用单特征和HOG+CN特征级联进行跟踪都发生失败,计算的位置与真实值位置的偏差持续增加。如图3(b)所示,采用CN特征为第1级,HOG特征为第2级的方式进行跟踪。由于HOG特征对光照具有鲁棒性,使用此方式进行级联,并未发生丢失情况,位置误差保持在一定范围内。第1级跟踪结果即便因光照轻微漂移,第2级使用的特征只要能够应此帧出现的光照问题,依旧能够解决因挑战情况而引起的目标丢失问题。

图3 singer2视频序列每帧位置误差Fig.3 Position error diagram of each frame of the singer2 video sequences

围绕如何获取每帧最适当的特征,本文提出目标先验的方式。在预测目标位置前了解当前帧出现的光照变化和快速运动情况,针对性地选择特征级联,达到减少目标定位误差的目的。

2.3 基于先验机制的手工特征选择方案

先验机制在图像处理领域有了广泛应用,通过先验图像信息来有效处理图像。近些年也有学者将目标先验的方式引入目标跟踪,文献[14]通过暗通道先验的方式,通过图像去模糊的方式来提高跟踪性能。文献[15]通过去除目标背景信息,先验出更详细目标初始特征,当跟踪发生丢失时,使用先验的特征进行目标搜索。与上述先验方式不同,本文采用的先验机制主要检测目标每一帧面临的挑战,灵活地选择适合的特征并搭配级联结构,以此来提高跟踪精确度。

在不同的场景特征表现能力不同,CN特征对目标形变鲁棒性较好,但容易受光照影响,而HOG特征却恰好相反。虽然二者具有互补作用,但表现方式不同,直接融合有时表现不佳。而在预测阶段采用级联方式,不同特征相互独立,能够充分利用不同特征优势。先验机制可以判别当前帧出现的光照情况,针对性选择手工特征进行跟踪。图像的均值表示一幅图像平均亮度。图像在低亮度情况下,通过摄像头获取的图像颜色信息缺失较大[16],导致目标特征学习不足,从而引起目标丢失。而在图像亮度适当的情况下,图像颜色特性能够准确表现,便于区分目标与背景。如图4(a)所示,目标区域亮度较低,目标颜色特征表现不足,图像归一化均值较低,此时使用CN特征进行跟踪容易丢失目标。如图4(b)所示,目标区域颜色明亮,目标颜色特性表现较好,图像归一化均值较高,此时使用CN特征能够较好表征目标。

(a)目标区域亮度较低

(b)目标区域亮度正常图4 目标区域图像归一化均值Fig.4 Normalized mean of target area image

本文通过预测的目标位置,再计算目标区域图像归一化均值,以此选择每一级特征。图像均值计算公式为:

(5)

式中,A表示图像均值;F(i,j)为像素值大小;M,N分别为图像的行和列数。为了更直观地表现图像亮度情况,对图像均值进行归一化处理:

(6)

式中,Anom,A,Fmax,Fmin分别为均值数据的归一化值、图像像素均值、图像像素最大值和最小值。

设置阈值,当归一化均值大于0.7或者小于0.4时,目标颜色特性表现不足,使用CN特征跟踪容易丢失目标,由于第2级具有修正第1级误差的作用,此时第1级使用CN特征,第2级使用HOG特征能够较好地解决因光照引起目标特征表现不足而导致目标丢失问题。当图像归一化均值在区间(0.4,0.7)时,能够较好地表现目标颜色特征,此时第1级使用HOG特征,第2级使用CN特征的方式级联能够较好应地对目标形变问题。具体特征选择方式为:

(7)

2.4 深度特征拓展

深度特征对目标形变、光照具有较好的鲁棒性,能够准确定位目标位置,可是深层的语义特征难以区分过暗的目标和明亮的背景[17]。虽然手工特征在精确度上较深度特征不足,但是特定跟踪情况下具有更好效果,依旧具有较高使用价值。针对这些考虑,先对目标区域特性进行检测,再选择不同特征进行级联操作。

级联结构第2级计算出目标位置为最终位置,相比于第1级更为重要。在一般情况下,第1级选择手工特征,第2级选择鲁棒性更高的深度特征。目标区域检测主要从目标亮度、目标快速运动、背景与目标亮度3个方面进行处理,根据不同情况来选择特征。

目标亮度检测:通过计算预测目标区域归一化均值来选取第1级特征,当均值判别图像亮度适当,使用CN特征,反之使用HOG特征,这样在第1级别能够达到更精确的目标定位。

目标快速运动检测:手工特征在预测目标阶段使用的搜索框相比深度特征的搜索框更小,当目标发生快速运动时使用手工特征容易丢失目标,第2级难以修正,此时只使用深度特征进行跟踪效果最好。目标快速运动通过计算前后帧目标距离进行判别,即:

(8)

式中,Pt为先验阶段预测的目标位置;Pt-1为上一帧目标位置;d为前后帧目标位置距离。当d>10时,认为目标发生快速运动。

背景与目标亮度检测:当目标区域亮度过暗而背景区域亮度偏亮时,使用深度特征容易丢失目标。针对这个情况,计算目标区域与目标背景区域归一化均值,当判别目标昏暗并且背景明亮时,此帧只使用具有光照鲁棒性的HOG特征进行目标位置预测,保证精度同时减少计算量。

除上述3种情况外,由于手工特征的局限性,在一些情况下目标定位发生漂移严重甚至丢失目标,以至于第2级修正不足导致最终结果不理想。在进行第2级目标定位操作前,先使用置信值判断,当置信值满足要求时才将第1级预测的目标位置传输给第2级。

本文置信值使用平均峰值相关能量(APCE)为判别标准,APCE表示响应图的震荡程度。当稳定跟踪目标时,响应图峰值较大,整体波动较小。而当目标发生遮挡,运动模糊时,目标较容易丢失,同时响应图峰值较小,整体波动严重。

本文利用0.7倍的APCE平均值作为阈值,以20帧为一组,计算每20组内的平均APCE值。当每一帧APCE值大于0.7倍的平均APCE值时,表明稳定跟踪目标,此时将第1级计算的结果传输给下一级,反之舍弃第1级结果。APCE计算如下:

(9)

式中,Fmax,Fmin表示响应图上峰值的最大值和最小值;F(W,H)表示响应图上(W,H)位置的响应值。

特征选择具体步骤如下:

步骤①:计算前后帧目标距离,当判别为快速运动时,使用深度特征计算目标位置作为最终结果,不再进行后续步骤,反之继续下一步操作。

步骤②:背景与目标亮度检测,当目标昏暗而背景明亮时,使用HOG特征计算目标位置作为最终结果,不再进行下一步操作。当判别目标归一化均值满足要求时,级联结构使用CN特征作为第1级,不满足则第1级使用HOG特征。选择好第1级特征后,预测目标位置,然后进行下一步操作。

步骤③:计算第1级响应图的APCE值,不满足要求时,丢弃第1级的预测结果,只使用深度特征计算目标位置。当满足要求时,根据第1级计算的目标位置,再次提取目标的深度特征,最后计算出目标位置作为结果。

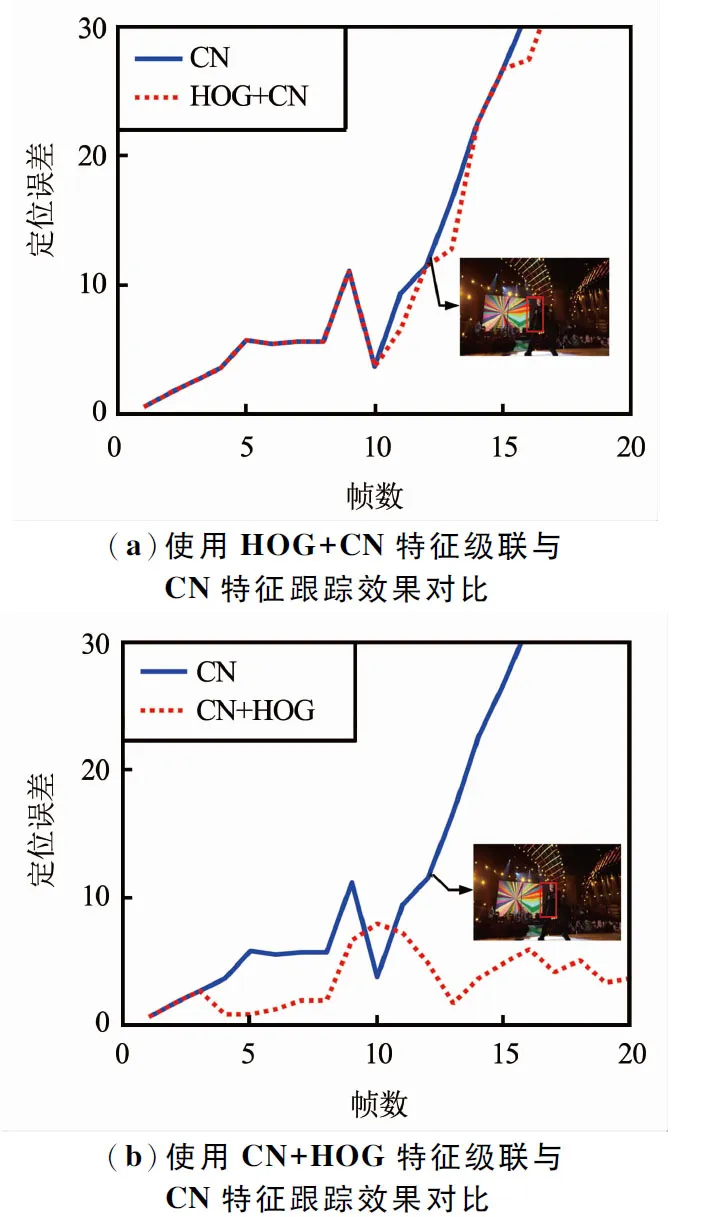

2.5 基于目标先验机制的级联结构

选择级联结构如图5所示,整体结构以当前帧图像和前一帧目标位置p0作为输入,输出为经过2级级联得到的目标位置P2。每一级与上一帧训练好的滤波器hk(k=1,2,3)进行相乘预测目标位置。hk(k=1,2,3)为HOG特征、CN特征、卷积神经网络(CNN)提取的特征训练的滤波器,各滤波器相互独立。本文使用的CNN特征为经过预训练的VGG19网络提取的特征。

图5 选择级联结构Fig.5 Cascade structure selection

目标先验首先将上一帧的预测目标位置p0输入当前帧,然后以p0为中心,提取目标大小为Sò的HOG特征x(p0)={x(l)(Sò),p0}l,l表示通道数。将提取的特征带入式(3)计算出r,再将r代入式(10)计算出最大响应对应目标位置Pr:

Pr=max(r)。

(10)

根据预测的位置进行目标先验,然后根据不同场景选择第1级和第2级使用的特征。级联结构由2级组成,第1级主要为粗定位,第2级主要解决目标漂移、丢失问题和修正目标定位误差的问题。第1级接收上一帧预测的目标位置P0,根据先验机制选择特征,提取以P0为中心目标特征x(p0),然后将上一帧训练的滤波器hi与提取特征x(p0)带入式(11),计算出第1级预测的目标位置P1:

(11)

第2级接收第1级传输的目标位置P1,根据目标先验的要求,在当前帧提取相应的特征x(p1),最后通过式(12)计算出最终目标位置P2。

(12)

2.6 模型更新机制

传统的相关滤波目标跟踪算法采用固定学习率更新模型,当跟踪过程中出现快速运动、光照和遮挡等情况,目标区域产生过多干扰,固定学习率更新模型将造成模型污染,容易导致跟踪丢失。

为处理此问题,本文采用一种阶段性衰减学习率的方式进行模型更新。首先利用先验机制和APCE值判别当前帧的情况,当出现快速运动、光照变化和遮挡情况,对学习率进行衰减,直至度过挑战情况。其次,防止学习率长时间减小而导致学习不足,周期性初始化学习率。以20帧为一周期,在周期内进行衰减,超过20帧则初始化学习率,并重新累计帧数。衰减方式为:

ηt={kηt-1},

(13)

式中,η为更新学习率;t为当前帧数;k为衰减系数。

3 实验结果及分析

3.1 实验环境和参数设计

计算机硬件配置:I5-6700@2.3 GHz处理器,8 GB内存,Windows 10操作系统,实验运行环境为Matlab2017B。参数设置:正则化参数λ为1×10-4,初始学习率为0.01。使用OTB_2013,OTB_2015和TC-128数据集来测试本文算法。

实验使用精确度和成功率来评估跟踪结果,精确度是通过计算跟踪过程中目标中心位置和标准中心位置的欧氏距离。计算公式为:

(14)

式中,xt和yt表示通过目标跟踪算法计算出的目标位置;xt0和yt0则表示准确的目标坐标。

成功率通过计算目标框和预设框之间的重合率来进行表现,即:

(15)

式中,St表示跟踪过程中计算出的目标尺度框面积;Sb表示目标准确的尺度框面积;∩,∪分别表示交集、并集。

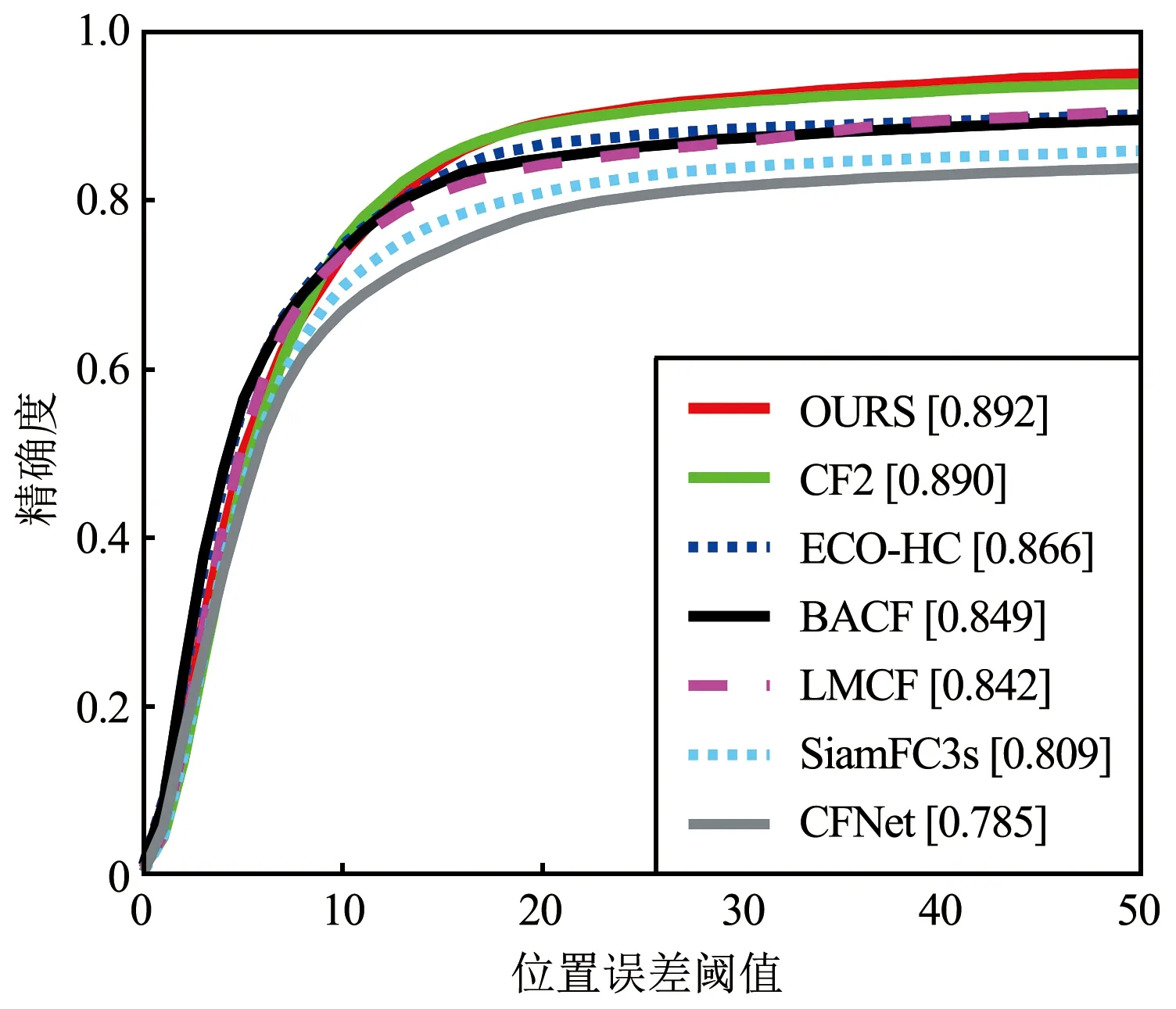

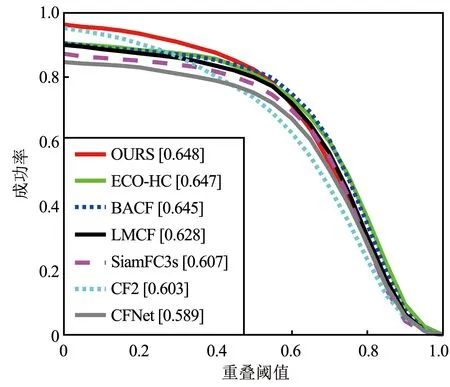

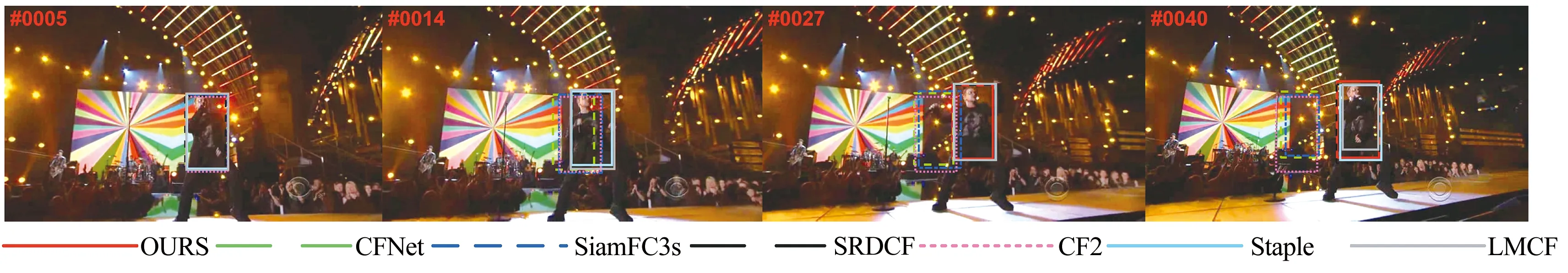

3.2 本文算法与主流算法对比实验

OTB_2013数据集在目标跟踪领域应用广泛,其中包含51个具有挑战性的视频。在OTB_2013数据集上,使用本文算法与6种主流算法进行比较,6种算法分别为ECO-HC[18],LMCF[19],SiamFC3s[20],CF2,BACF和CFNet[21]。图6为本文算法与其他算法的对比结果,本文算法的精确度和准确度分别为0.892,0.648。相比ECO-HC算法,本文算法精度提高了2.9%,成功率提高了0.1%,与基于深度学习的SiamFC3s算法相比,精度提高了9%,成功率提高了6.3%,精度和准确度都排名第一。

(a)距离精度

(b)重叠成功率图6 在OTB_2013数据集测试结果Fig.6 Test results in OTB_2013 dataset

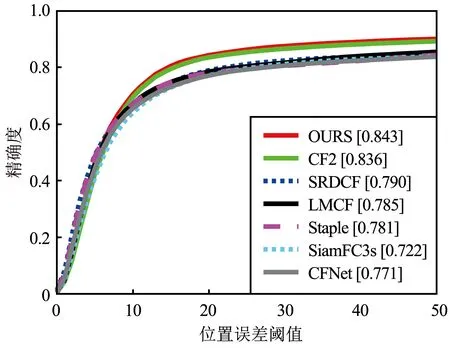

OTB_2015数据集由100个视频序列集组成,相比OTB_2013数据集,视频数量更多,更具挑战性。在OTB_2015数据集上使用6种算法与比本文算法进行对比,6种算法分别为CF2,LMCF,Staple[22],SRDCF,SiamFC3s和CFNet。对比结果如图7所示,本文算法在数据集测试的精确度达到0.843,成功率达到0.614,相比其他算法具有更好的表现。

(a)距离精度

(b)重叠成功率图7 在OTB_2015数据集测试结果Fig.7 Test results in OTB_2015 dataset

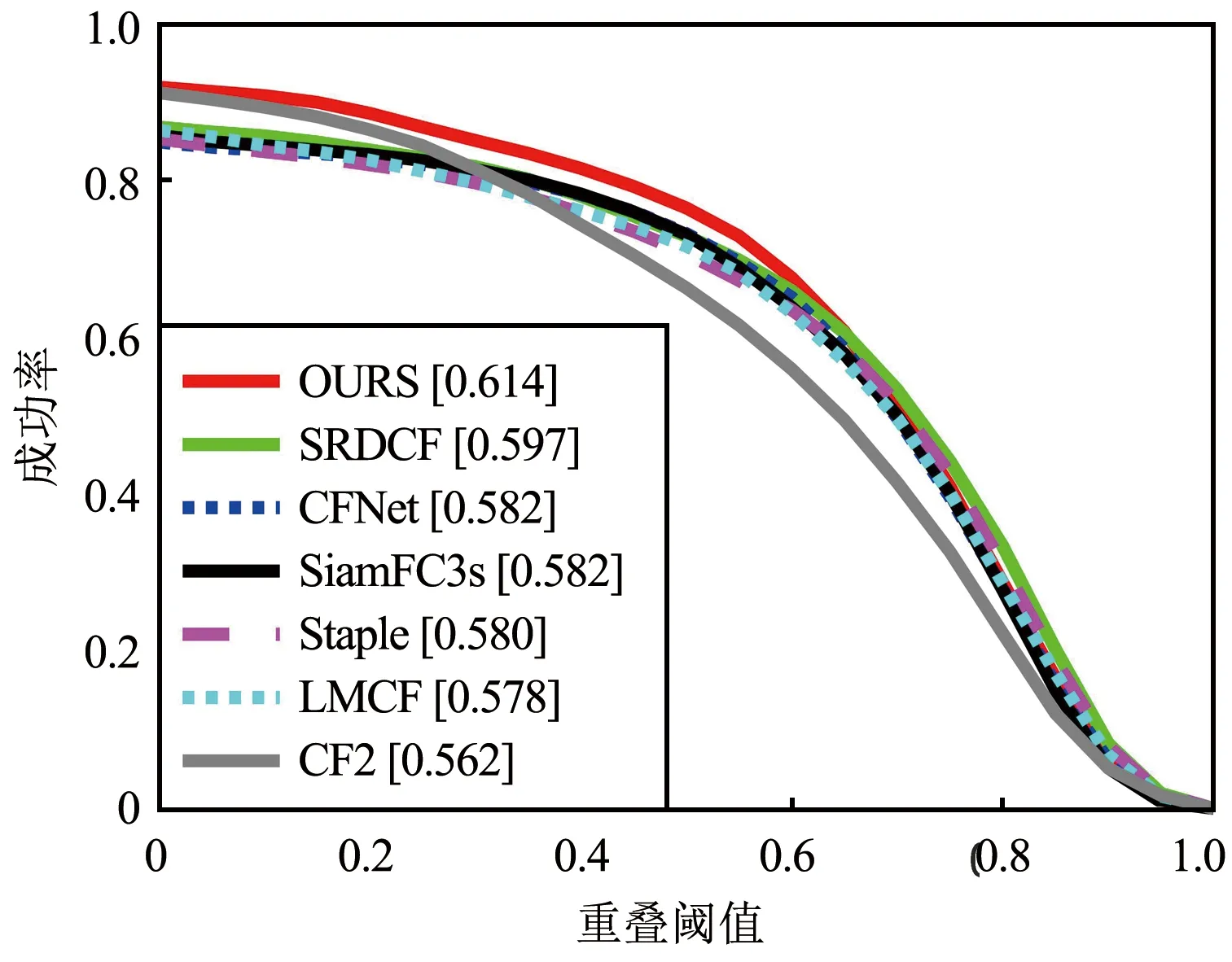

为了进一步检测本文算法的有效性,使用6种算法在TC-128数据集上与本文算法进行对比,6种算法分别为BACF[23],Staple,SRDCF,SiamFC,HDT[24]和CF2。与OTB数据集不同,TC-128数据集由128个具有颜色的视频序列组成,包含更多颜色信息。表1展示了对比结果,其中加粗表示此类数据得分最高,下划线表示得分第二。本文算法的精度和准确度分别为0.514,0.709,相比其他算法准确度更高,结果表明使用合适的手工特征和深度特征级联能够有效提高跟踪性能。

表1 7种算法在TC-128数据集测试结果对比Tab.1 Comparison of the test results of seven algorithms on TC-128 dataset

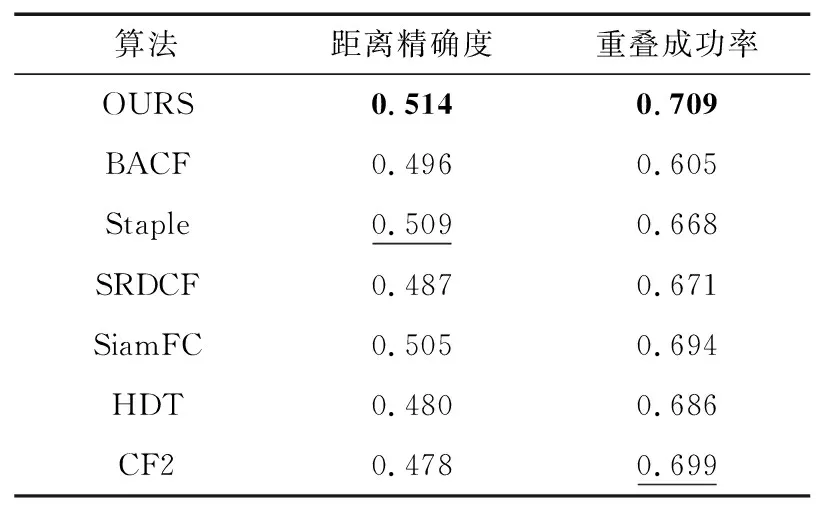

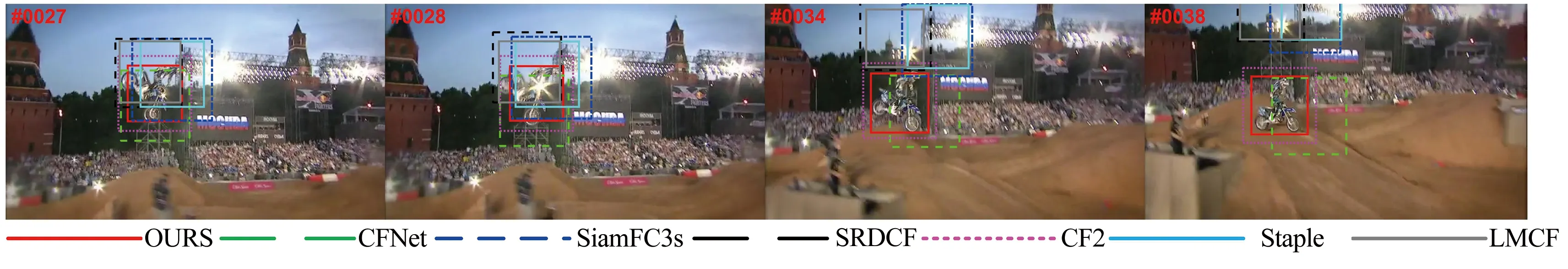

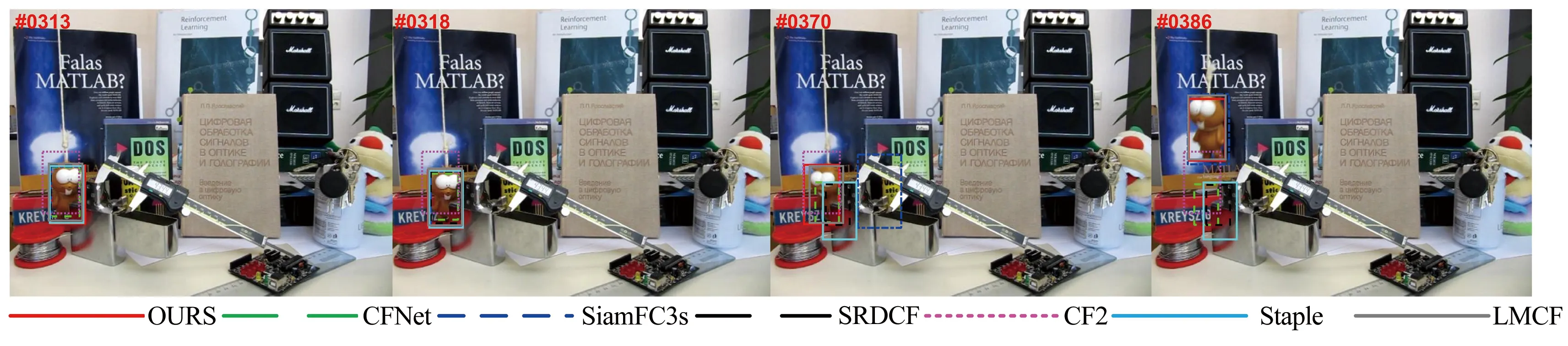

定性分析:图8为7种算法在OTB数据集中3个视频序列跟踪结果对比。图8(a)面对光照问题,由于目标过于昏暗而背景明亮,使用深度特征的CF2,SiamFC3s和CFNet算法对目标特征学习不足,不易于区分背景,在27帧丢失目标。其他算法利用HOG特征对光照具有鲁棒性的特性,能够准确地跟踪目标。本文算法计算目标归一化均值,选择适当的特征,也能够稳定跟踪目标。

(a)Singer2序列跟踪结果

(b)Motor Rolling序列跟踪结果

(c)Lemming序列跟踪结果图8 7种算法在不同视频序列结果对比Fig.8 Comparison of the results of seven algorithms in different video sequences

图8(b)面对快速运动问题,在27~28帧,目标快速运动,LMCF,SRDCF算法出现严重漂移,34帧开始完全丢失目标,而本文通过目标先验机制判别出目标快速运动的状态,只采用深度特征,能够准确地跟踪目标。

图8(c)面对遮挡问题,在313帧目标出现轻微遮挡,318帧CF2算法开始发生漂移,370帧目标发生遮挡后,重新出现在未遮挡区域,CF2,SRDCF,Staple和CFNet算法丢失目标,本文采取学习率阶段性衰减的方式,减少跟踪过程中的外观模型受到的污染,依旧能够跟踪目标。

3.3 消融实验

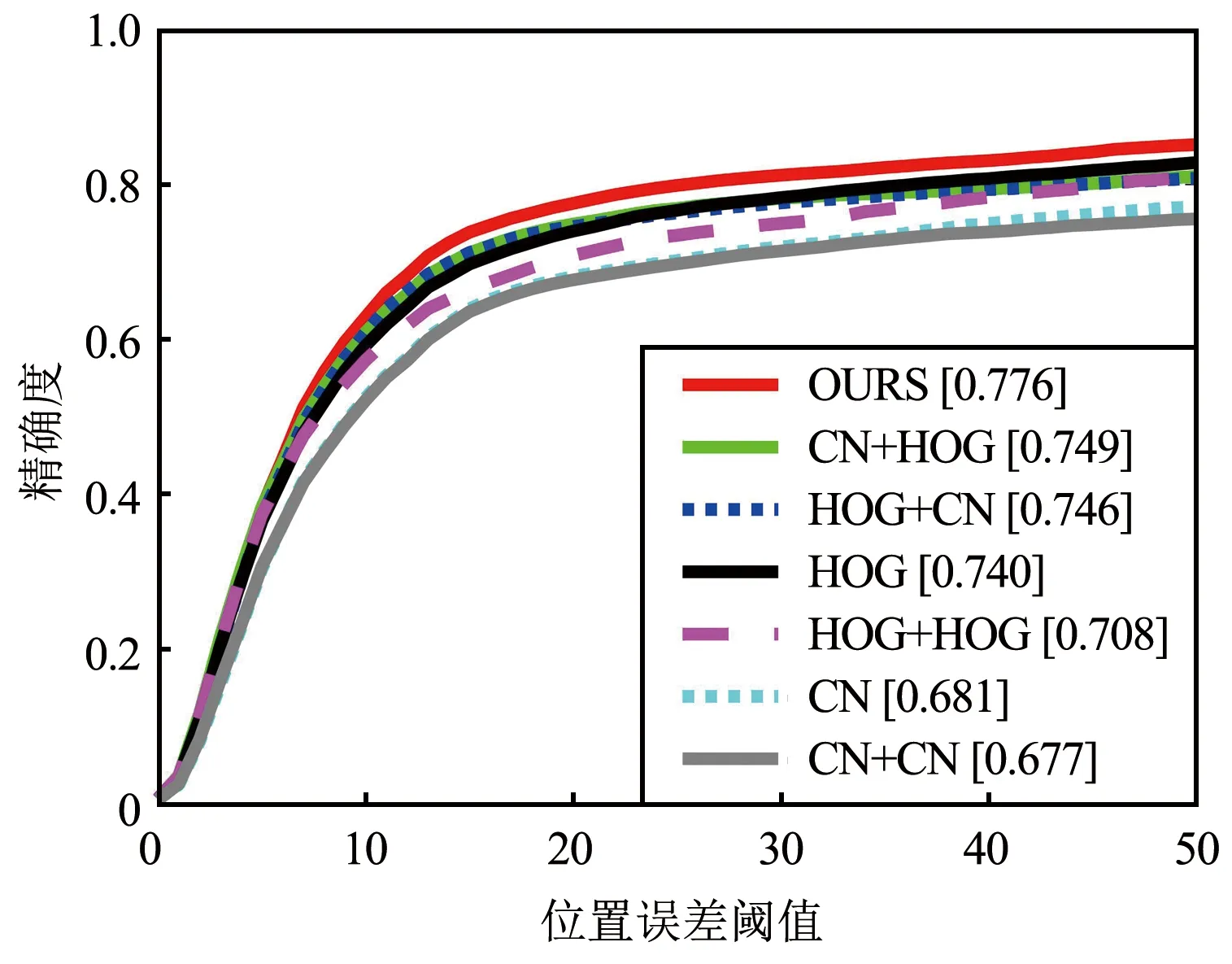

为了客观表现选择级联结构的有效性,在相关滤波目标跟踪算法框架中加入级联结构,并通过OTB_2013数据集进行验证。图9给出了使用单特征和使用不同方式的手工特征级联在OTB_2013数据集上的对比结果,其中OURS为选择级联,‘+’前为第1级使用的特征,‘+’后为第2级使用的特征,‘+’前后相同为相同特征级联,反之为不同特征级联。

(a)距离精度

(b)重叠成功率图9 基于各类特征选择的跟踪算法在OTB_2013数据集中的测试结果Fig.9 Test results of tracking algorithms based on various feature selections on OTB_2013 dataset

从图9可以看出,使用相同特征级联的算法相比单级的算法精确度和准确度更低,表明了使用相同特征级联的跟踪算法存在漂移的问题。采用不同特征进行级联相比使用单特征跟踪算法精确度和准确度更高,能够修正目标定位误差。选择级联能够较好地应对每帧图像问题,相比使用不同特征级联,能进一步提升准确度。

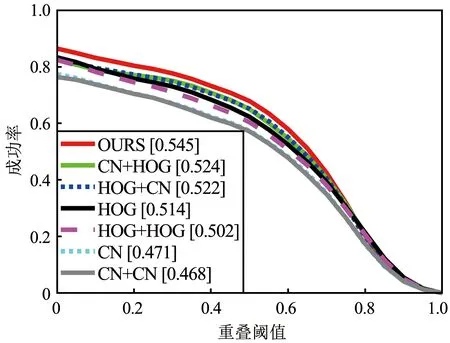

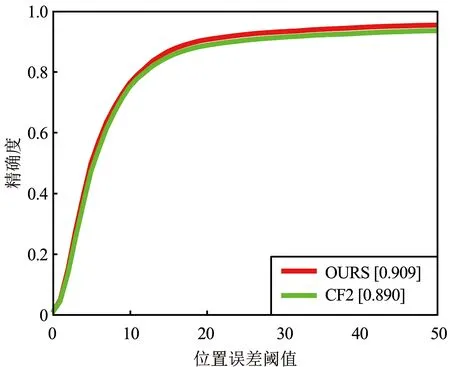

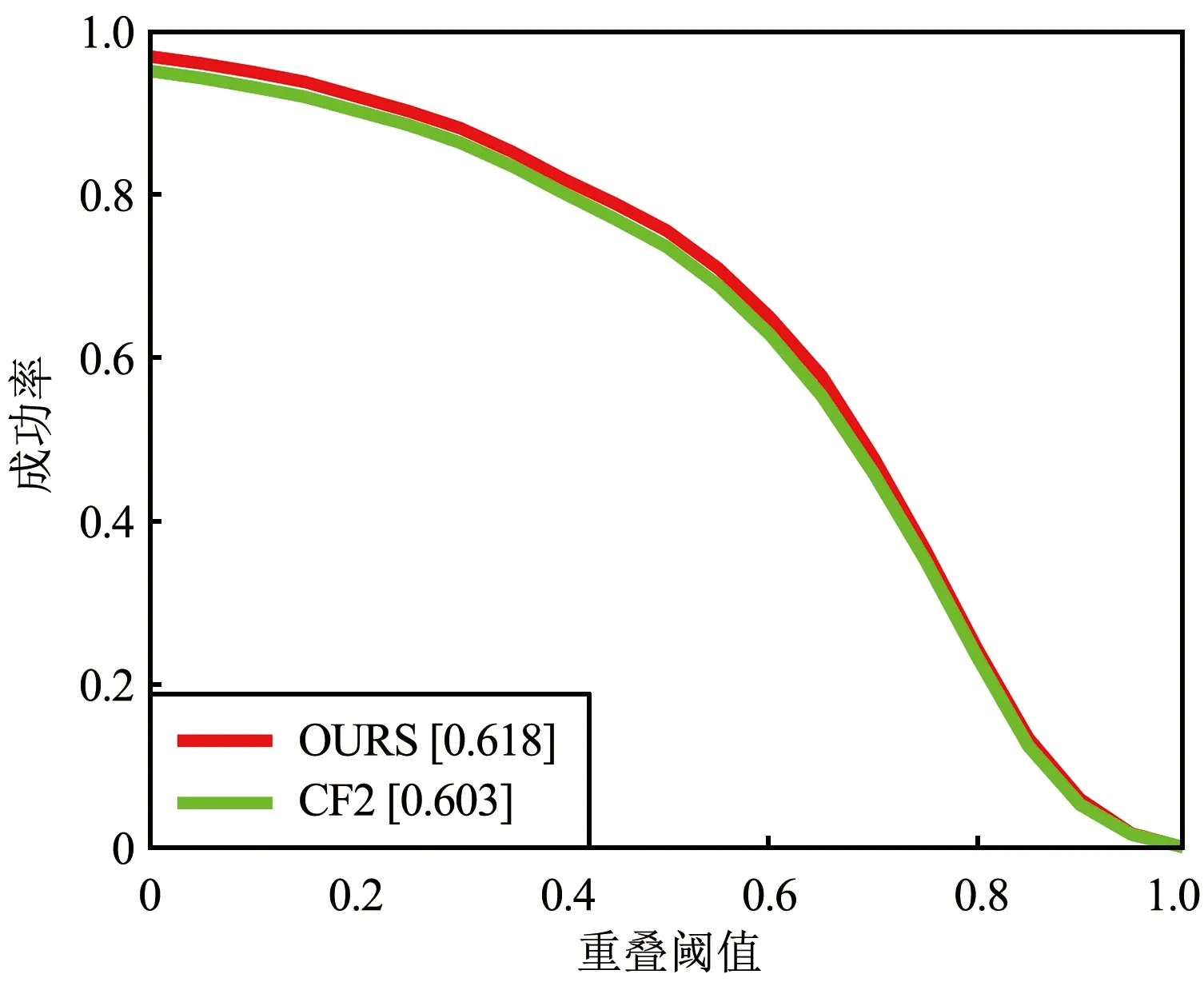

使用同样方式,在CF2算法的基础上加上手工特征进行级联,在OTB_2013数据集上进行验证,如图10所示。

(a)距离精度

(b)重叠成功率图10 在CF2算法中运用本文方法的前后对比Fig.10 Comparison of the results in the CF2 algorithm before and after using the proposed method

从图10可以看出,使用手工特征和深度特征级联能够提高目标跟踪的精确性和鲁棒性。通过先验机制能够在第1级选择适当特征定位目标位置,第2级能够较好地修正目标的漂移,减小定位误差。

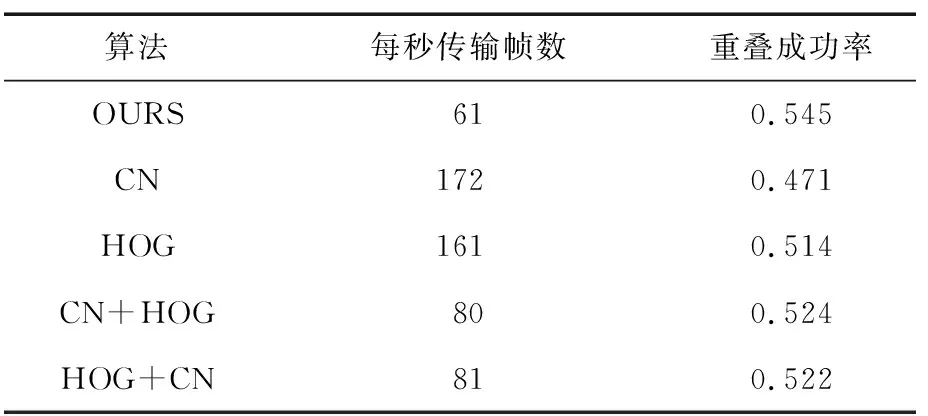

时间效率分析:使用单特征和不同方式的手工特征级联在OTB_2013数据集上运行速度和成功率对比如表2所示。先验方式和级联结构无可避免地增加了计算量,在牺牲速度的情况下,成功率有了明显的提升,相比使用CN特征,HOG特征成功率分别提升了13.5%,5.63%,并且跟踪速度依旧能够达到61帧/秒,依旧具有较快运行速度。

表2 基于各类特征选择的跟踪算法运行速度和成功率对比Tab.2 Comparison of running speed and success rate of different features tracking algorithm

4 结束语

为提高目标精确度和处理光照、快速运动和遮挡问题,提出了一种具有选择级联结构和学习率阶段性衰减结构的目标跟踪算法。对于跟踪过程中的复杂情景,使用先验机制计算目标在当前帧出现的挑战情况,有效根据不同情景选取适当特征预测目标位置,并且使用级联结构修正目标定位误差。同时,利用学习率阶段性衰减的方式,减缓目标外观模型固化,在遮挡情况下实现稳定跟踪目标。