基于无锚框YOLO检测网络的麦穗检测方法

2023-01-12路乔宽张惊雷

路乔宽,张惊雷

基于无锚框YOLO检测网络的麦穗检测方法

路乔宽,张惊雷*

天津理工大学电气工程与自动化学院, 天津 300384

小麦产量可由单位面积的小麦麦穗总数估算得出。基于采集小麦图像序列特征并进行检测的方法受光照等因素影响大,检测精度不高。为准确定位麦穗位置,估计麦穗数量,引入深度卷积神经网络进行麦穗检测工作。针对麦穗比例多样,先验锚框设定无法完美契合的弊端,舍弃了目标检测网络中常用的矩形先验锚定框(anchor),提出了一种基于YOLO框架的无锚框(anchor-free)麦穗目标检测方法。采用CSPDarkNet53作为特征提取网络,中间层采用特征图金字塔网络结构FPN(Feature Pyramid Networks)设计特征处理模块,增大感受野并提取图像的多尺度信息,获得融合高低层语义信息的特征图,后端采用FoveaBox式无锚框检测器完成目标检测。在WEDD与GWHD两个不同分辨率的公开麦穗数据集上测试表明,该网络的检测平均精度AP值相较于YOLOv4网络分别提升了8.81%和1.69%,并在GWHD数据集上帧率达到36FPS。本算法能够实时有效地进行麦穗精确检测,为后续小麦估产、育种等创造了条件。

无锚框; 麦穗检测方法; 图像识别

小麦是世界上种植最多的谷物之一,也是我国主要的粮食作物。小麦产量对粮食安全、社会稳定至关重要,同时其产量的预估对育种、植物表型分析等农业科学研究有重要意义。单位面积麦穗总数是估计小麦产量的重要参数[1],如何高效准确地检测出大田环境下的麦穗就成为了重中之重。目前对麦穗图像信息的提取多依赖于人工方法,费时费力、成本高等缺点尤为突出[2]。根据Madec S等[3]的研究结果,人工检测的误差约为10%。因此,近年来基于图像处理技术的小麦麦穗自动检测方法得到了广泛的研究。

传统的图像处理算法已在农业研究领域广泛使用。如Dammer KH等[4]通过设置二值化阈值对麦穗和图像背景进行分类,Cointault F等[5]使用颜色特征和纹理特征分析图像并检测麦穗。这类算法多依赖于大量人工特征描述,且在光照、土壤、小麦品种等因素的变化下,使得以传统统计模式识别方法得到特征的难度增加。近年来,随着硬件技术的提升和深度学习算法的发展,基于可以自动提取图像特征的卷积神经网络(Convolutional Neural Network, CNN)算法得到了广泛应用。

Pound PP等[6]应用卷积神经网络模型检测温室条件下的小麦穗,Lu等提出了一种名为TasselNet[7]的深度卷积神经网络来建立麦穗计数回归模型,之后又陆续提出了TasslNetv2[8]与TasselNetv3[9]模型用于高粱、玉米穗等目标的计数回归。为了研究不同生长阶段的小麦对检测结果的影响,Hasan MM等[10]训练Faster R-CNN结构在4个不同生长阶段捕获的不同数据集上生成4个不同的模型,从而实现小麦籽粒检测。张领先等[11]基于图像处理和深度学习技术,设计并实现了基于卷积神经网络的冬小麦麦穗检测计数系统。陈佳玮等[12]构建了MobileNetv2-YOLOv4深度学习模型用于灌浆期小麦麦穗检测。鲍烈等[13]建立了WheatNet模型用于麦穗检测并进行产量评估。然而,上述算法大多都只能在同种类或相似种类麦穗目标中才能取得较好的检测结果,因此如何在不同类麦穗目标及麦穗相互遮挡的情况下提高网络的检测性能成为关键性问题。

1 本文算法

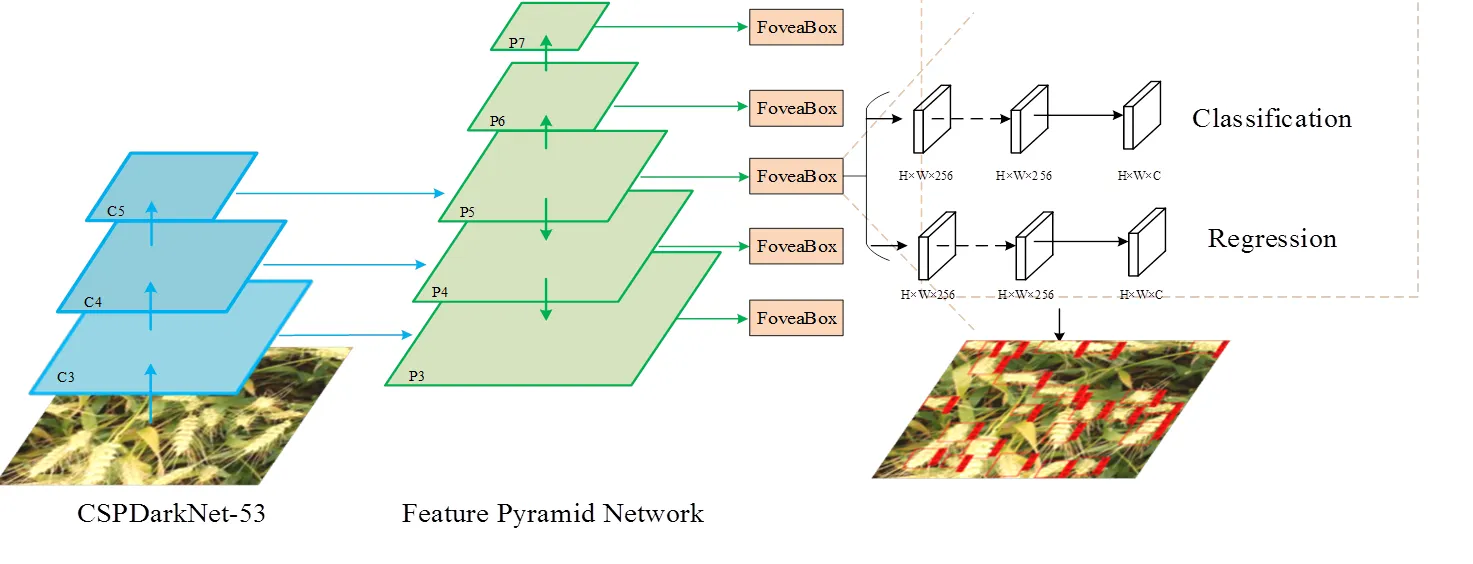

为研究适合高低分辨率大田小麦图像的麦穗检测网络,针对经典目标检测网络小目标漏检及遮挡误检测等问题,本文设计了基于YOLO框架的无锚框麦穗检测网络,网络整体框架如图1所示。

图1 麦穗目标检测网络模型结构

算法分为三个阶段:前端网络由CSPDarkNet-53[14]组成,提取麦穗的多尺度特征,本文保留了CSPDarknet-53中的Resblock_3,Resblock_4,Resblock_5的最后一层特征;将提取到的特征输入特征图金字塔网络结构FPN(Feature Pyramid Networks)[15]中,利用1×1卷积跨通道整合浅层的尺度特征和深层的深度特征,充分融合高低层语义信息,增强特征的鲁棒性,获得多尺度信息融合的麦穗特征图,同时保留了捕捉较小麦穗目标的尺度特征与较大目标的深度语义特征,本文将获取到的三层特征图在多尺度特征融合模块中进行高低层语义信息融合,获得P3、P4、P5、P6四个融合层,再将高层语义特征上采样后与低层尺度特征进行二次融合,获得最终的融合特征层P7;检测头部分网络结构舍弃了传统深度目标检测网络常用的锚框设计,采用FoveaBox[16]网络结构,标定目标框中的相应像素点,并在特征图上确定目标位置,输出分类、中心点及回归分支,产生高质量的检测框。避免了因先验锚框设计不足导致的麦穗漏检误检问题,更好地适应麦穗目标的大小及尺度变化,同时减少了模型运行时间,为麦穗实时检测创造条件。

1.1 骨干网络

CSPDarkNet-53是由DarkNet-53[17]改进而来,YOLOv4将之作为骨干网络用于目标特征提取。DarkNet-53引入直连(shortcut)思想改进ResNet-50[18],直接将浅层的信息传递到深层,解决模型特征退化问题并同时做到特征重用。

CSPDarkNet-53则在原始网络结构的基础上增加了跨阶段局部(CSP)结构[19],将原始输入分成两个分支,从而分别进行不同的卷积操作使得通道数减半,对其中一个分支进行多次BottleNeck操作,然后将两个分支级联,保持CSP结构的输出与输入是同样大小,使模型学习到更多特征。

CSPDarkNet-53保留了部分CSP结构,删除了BottleNeck操作,从而在保证模型精确度的同时降低计算量,减轻模型的重量。

本文将网络中的Mish激活函数更换回LeakyReLU激活函数,在牺牲很小的性能代价的同时大大加快模型训练。

1.2 多尺度特征融合模块

深度卷积网络常常被用于图像的特征提取阶段,其低层特征保留了图像的空间信息、尺度信息、细节纹理信息,却无法获得图像的语义信息,因此会造成目标漏检现象;而高层特征获得图像的语义信息,但随着下采样的进行,低层特征所包含的信息大量丢失,导致小目标丢失现象。因此FPN基于特征融合思想,将高低层语义信息融合,从而最大限度地保留各种信息,提高检测精度。

有鉴于特征图金字塔网络结构(FPN),本文设计了多尺度特征融合模块,选用五层不同尺度的特征图进行特征融合,采用从低层到高层的方式,从已融合完成的P3层开始,对相应各层采用最大值池化(Max Pooling)进行降采样,使得各个融合层降采样后产生的新特征图通道数保持一致,最后进行级联操作获得包含了多层特征的P7层,将之输入检测部分用以指导检测框的分类与回归。

1.3 无锚框目标检测器

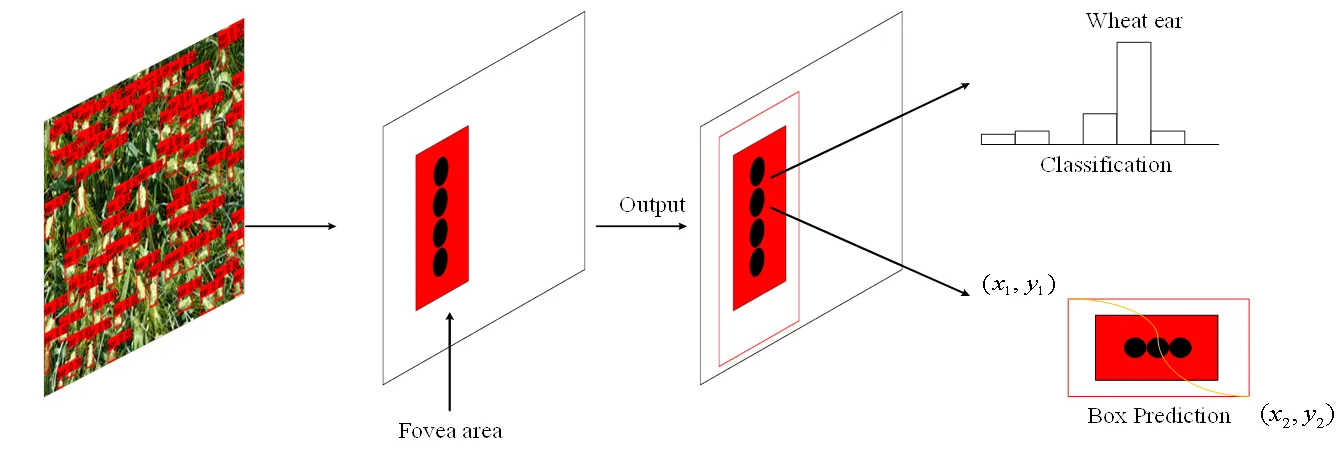

检测器部分采用了2019年清华大学发布的FoveaBox结构(图2),其动机来源于人眼对视觉域的中心拥有最强烈的敏感度。

图2 FoveaBox目标检测器结构

Fig.2Structure of FoveaBox object detector

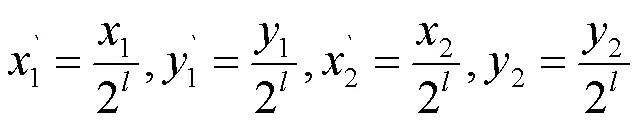

FoveaBox通过逐像素直接预测的方式计算目标可能出现的位置及其相应的边界,从而将真实的边界框(1,1,2,2)映射到不同尺度的特征金字塔上。

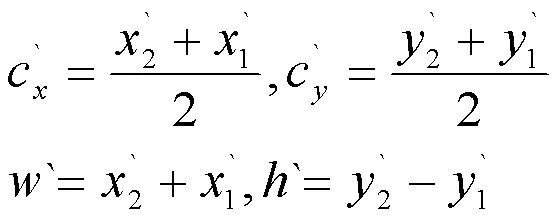

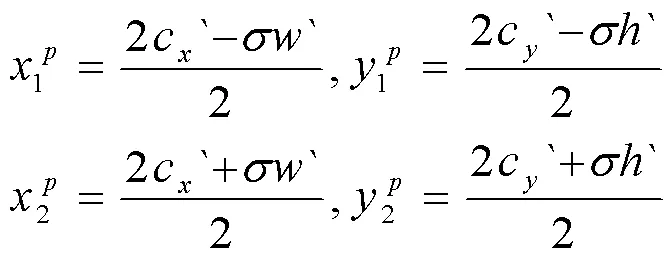

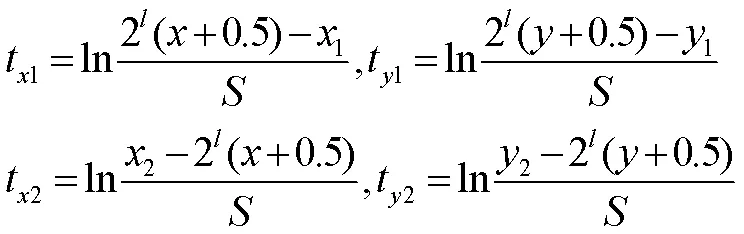

其中,2为第层特征金字塔的步长。即中心点的位置和映射的真实边界的宽、高为:

为了划分正负样本,引入收缩因子,使得正样本小于当前映射出的边界框:

本文FPN网络结构输出P3、P4、P5、P6、P7五层特征图,因此本文针对各层特征图大小,分别令=32、64、128、256、512作为每层的基本尺度,在检测时充分利用融合信息,利用多层金字塔检测同一目标,从而生成高质量检测框。

1.4 损失函数

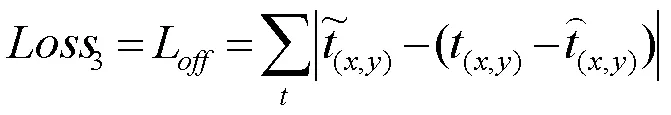

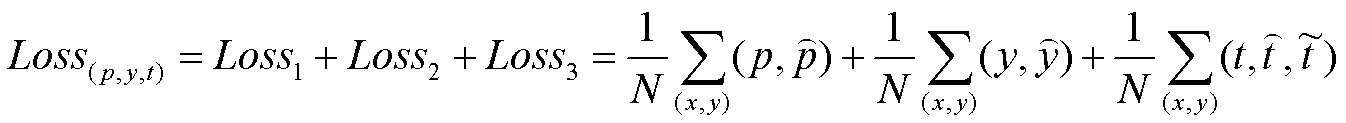

由于本文为单类型目标检测任务,因此对目标检测网络中常用的多类型检测任务损失模型中的分类损失进行简化,采用Focal Loss作为分类损失函数,其公式为:

中心点损失函数采用交叉熵损失函数进行,通过计算检测框与真值框之间的IoU数值,来判断检测框与真值框的差异,保留高质量检测框,其公式为:

回归损失函数使用L1损失,该函数能够让损失对于离群点、异常值等不敏感、梯度变化更小、鲁棒性更强,其公式为:

因此,本文算法在训练阶段使用的损失函数为上述三者之和,即定义为:

其中,表示数据集中正样本的数量。

2 实验准备

2.1 数据集

本文选用的数据集来自于David E等[20]发布的全球小麦穗检测数据集GWHD(Global_Wheat_Head_Detection Dataset)与全球小麦公共数据库WEDD(Wheat_Ear_Detection Dataset)。图3为从两个数据集中随机挑选的图片,其中GWHD数据集为7个不同国家的研究机构从全球十个不同地点拍摄获得,共3422张,由于生长环境和相机设置的不同,图像间的特征差别明显;而WEDD数据集提供了236张高分辨率麦穗图像,图像清晰,麦穗种类相同,但存在大量遮挡与颜色信息不明确等问题,影响检测精度。

图3 GWHD数据集(左列与中列)和WEDD数据集(右列)示意图

2.2 硬件与环境搭建

3 结果分析

3.1 WEDD数据集中的检测结果对比及分析

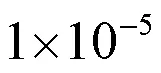

为验证算法的有效性,将本算法与经典目标检测网络及其改进网络进行对比实验。对比的方法分为两类:以YOLO算法为代表的的单阶段目标检测算法和以R-CNN算法为代表的两阶段目标检测算法。单阶段算法基于整张图片信息进行推理,因此速度较快;两阶段算法使用滑窗进行目标检测,基于局部图片信息进行检测,速度较单阶段检测算法慢,但定位准确率高。由于二者都采用了锚框anchor的设计思想,其设置好的先验锚框会由于长宽比筛选过滤掉大小和长宽比与先验锚框差异较大的真实目标框,就长宽比完全不确定的麦穗目标来说,会造成大量的未成功检测,影响检测性能。不同方法在WEDD数据集上的对比检测结果如表1所示。

表1 本文方法与5种经典目标检测算法在WEDD数据集中的实验结果对比

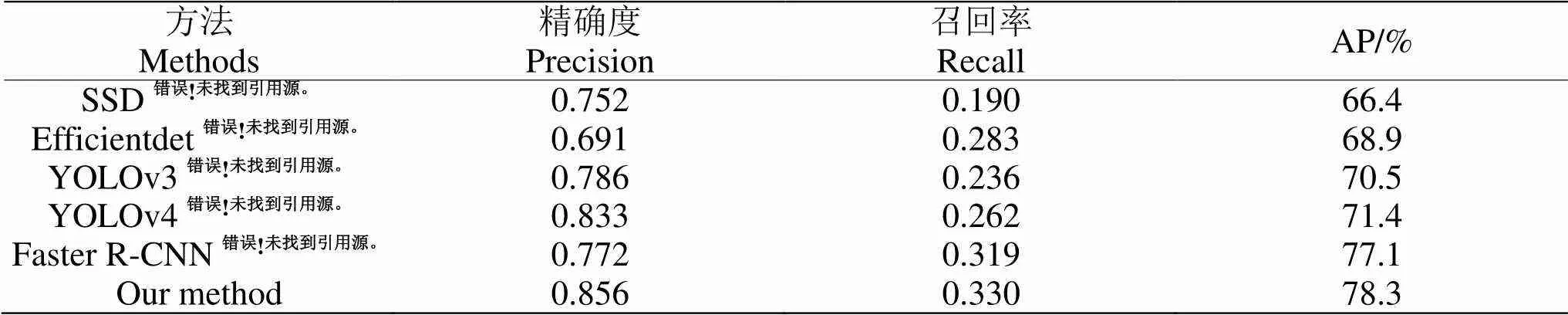

WEDD数据集为高精度、高复杂度的麦穗检测数据集,每张图片中都含有大量待检测目标,而且图像整体以绿色为主,麦穗与周围茎叶、杂草区分度低,难以形成准确的边界检测效果。从表中数据可以看出,本文算法在对于麦穗检测的结果有所提高。相较于几种单阶段目标检测算法效果提升明显,与YOLOv3、YOLOv4相比,AP值分别提升了9.96%和8.81%;相较于两阶段目标检测算法,本算法在无需提前设计anchor先验信息的前提下,在检测AP值上也取得了1.53%的效果提升。为了直观展示目标检测结果,本文将4种方法的检测结果进行了可视化处理,每个检测框上方的数字代表该预测框的置信度。本文将各算法检测出置信度大于0.5的预测框可视化并呈现出来(图4)。

a、b、c为在WEDD数据集中随机挑选的三张麦穗图像。(1)原图;(2)YOLOv3;(3)YOLOv4;(4)Faster R-CNN;(5)本文方法

在图像a中,本文算法检测出了94个目标,略超过Faster R-CNN的91个,远超过YOLOv3、YOLOv4检测出的63个和67个,查全率有着明显的优势。在图像b中,左上角有一簇集聚的麦穗目标,因其相互遮挡导致纹理特征减弱,YOLOv3/v4算法均未能检测出该部分麦穗目标,Faster R-CNN虽然检测出其中的部分目标,但是漏检现象依旧严重,本文算法成功检测到了目标。图像3中存在大量竖直麦穗目标,特征极不明显的同时带来了小目标检测的挑战,相较于前述几种算法,本文算法成功的检测出了几乎所有麦穗目标,避免了漏检的现象。

3.2 GWHD数据集中的检测结果对比及分析

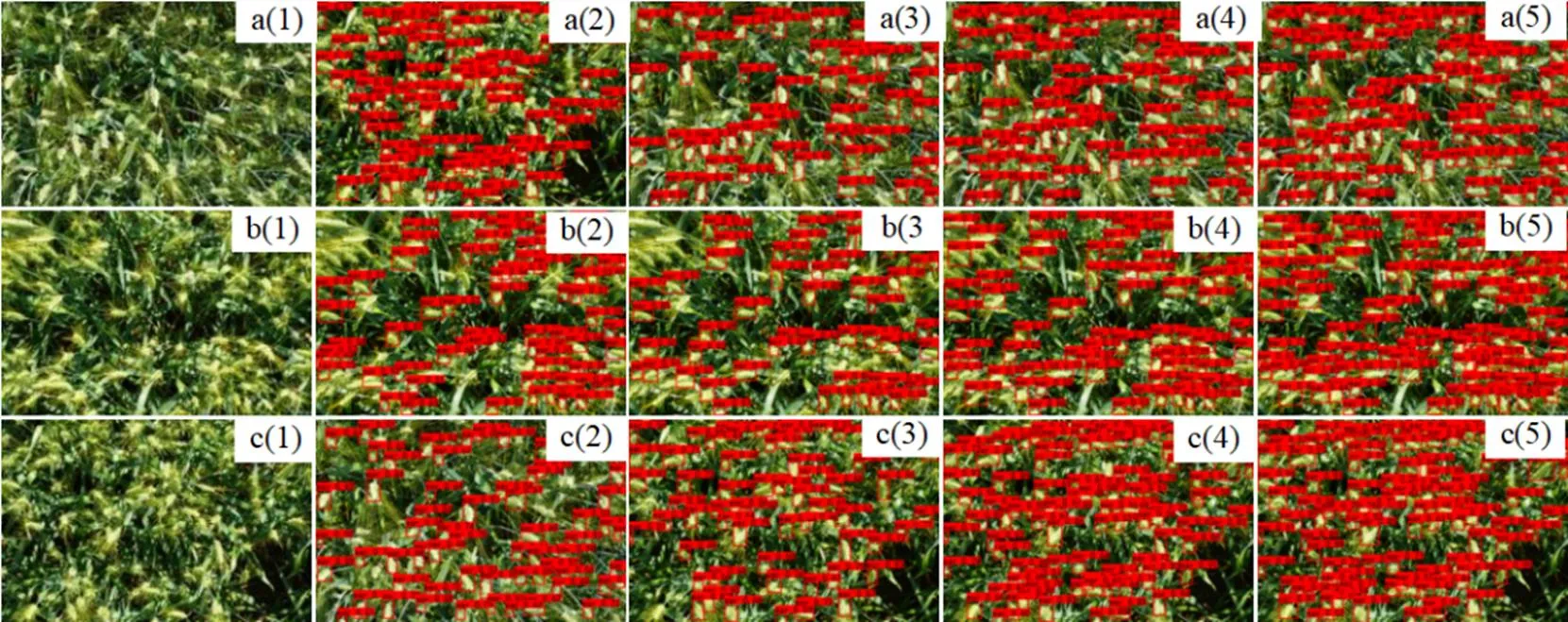

相较于WEDD数据集,GWHD数据集单张图片复杂度较低,且单张图片包含的麦穗数量也较少。但因其为从全球十个不同地点获取,麦穗种类、种植方式以及麦穗成熟度均不尽相同,且拍摄角度和相机高度也有所差异,因此其数据集包含的特征信息更为繁杂,对目标检测算法的泛化性提出了更高的要求。不同方法在GWHD数据集上的对比检测结果如表2所示。从表中数据可以看出,本文算法在对于麦穗检测的效果有所提高,同时本文算法在检测速度上也取得了最优的结果,达到了36FPS,满足麦穗实时检测的需求。

表2 本文方法与5种经典目标检测算法在GWHD数据集中的检测实验结果对比

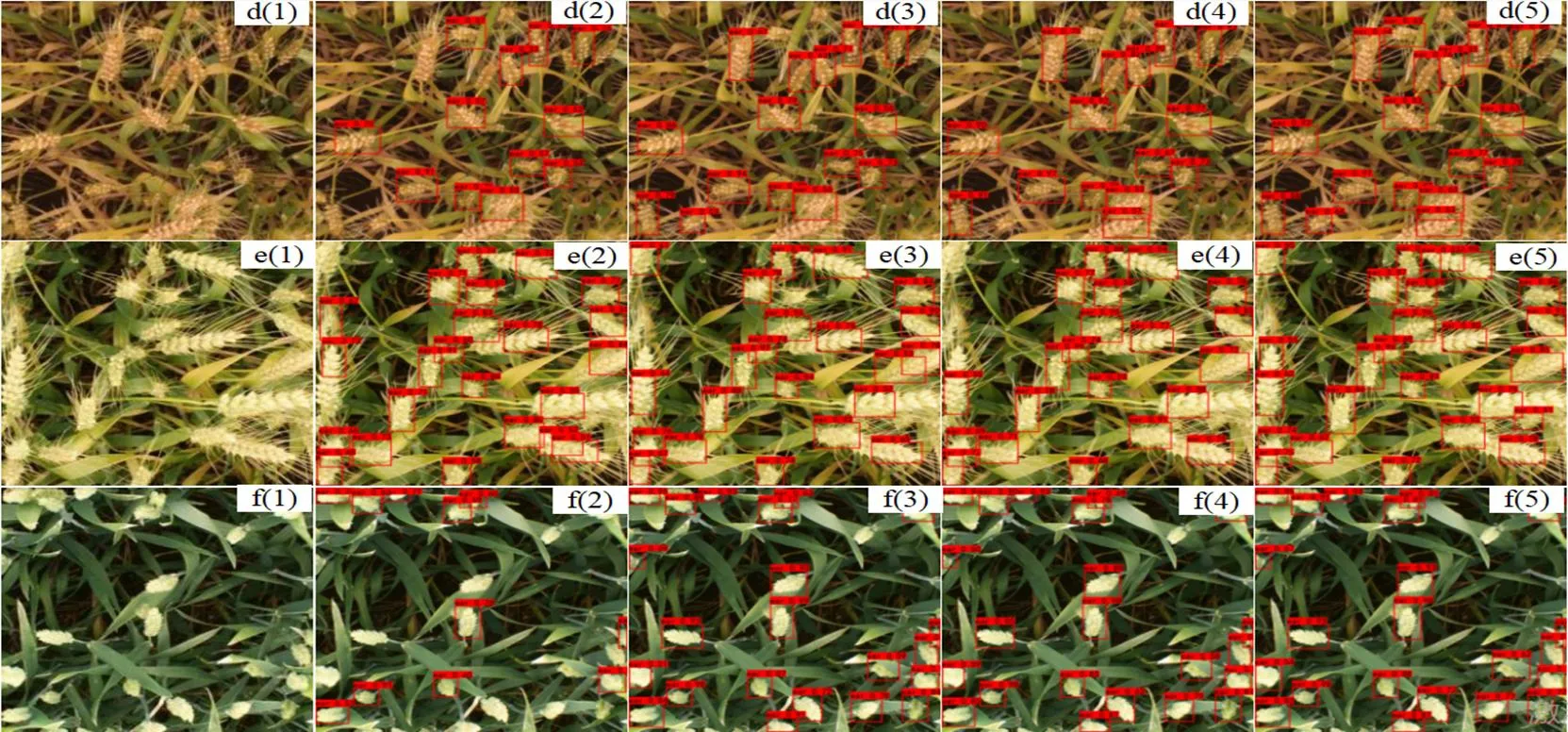

由于WEDD数据集单张图片包含目标多,其主要面临的挑战为遮挡问题和能否查全的问题,因此对其进行的实验结果评估分析中主要在查全方面进行考量。而GWHD数据集单张图片包含目标少,其主要挑战为因地质地貌、小麦种类及其成熟度、种植习惯等不同导致的麦穗特征的大幅改变,以及由于光照、视角、拍摄角度等因素导致的图像质量高低不一,进而增大了准确检测麦穗目标的难度,因此本部分主要在不同种类的麦穗图像中对其检测结果进行分析。检测结果如图5所示,从检测结果中可以看出,本算法能够在麦穗种类和成熟度各不相同的情况下准确检测出所有麦穗目标;对于茎叶干扰度较大,麦穗目标出现重叠的情况下,前述几种算法都出现了不同程度的漏检和误检情况,识别准确率出现下降,而Faster R-CNN网络虽能够准确识别目标,但识别速度下降明显,本文算法能够高速准确地检测到麦穗目标。

d、e、f为在GWHD数据集中随机挑选的三张麦穗图像。(1)原图;(2)YOLOv3;(3)YOLOv4;(4)Faster R-CNN;(5)本文方法

4 结论

针对麦穗长宽比例多样,无法设置合适的锚框的问题,提出了一种基于YOLO框架的无锚框麦穗检测网络。舍弃了复杂的锚框设置步骤,提高了麦穗目标检测的平均精度和召回率。本文算法在多种类、多精度、复杂场景麦穗检测数据集上均取得良好的检测效果,证明其有较强的泛化性,低精度图像中检测帧率达到了36FPS,检测速度符合实时检测的需求。

[1] Ferrante A, Cartelle J, Savin R,. Yield determination, interplay between major components and yield stability in a traditional and a contemporary wheat across a wide range of environments [J]. Field Crops Research, 2017,203:114-127

[2] Fernandez-gallego JA, Kefauver SC, Gutierrez N,. Wheat ear counting in-field conditions: high throughput and low-cost approach using RGB images [J]. Plant Methods, 2018,14(1):1-22

[3] Madec S, Jin X, Lu H,. Ear density estimation from high resolution RGB imagery using deep learning technique [J]. Agricultural and Forest Meteorology, 2019,264:225-234

[4] Dammer KH, Mller B, Rodemann B,. Detection of head blight (Fusarium ssp.) in winter wheat by color and multispectral image analyses [J]. Crop Protection, 2011,30(4):420-428

[5] Cointault F, Guerin D, Guillemin JP,. In-field Triticum aestivum ear counting using colour-texture image analysis [J]. New Zealand Journal of Crop & Horticultural Science, 2008,36(2):117-130

[6] Micheal PP, Jonathan AA, Darren MW,Deep learning for multi-task plant phenotyping [C]//IEEE International Conference on Computer Vision. IEEE Computer Society. Seattle, WA, USA: IEEE, 2017:2055-2063

[7] Lu H , Cao ZG , Xiao Y,. TasselNet: counting maize tassels in the wild via local counts regression network [J]. Plant Methods, 2017,13(1):1-17

[8] Xiong H, Cao ZG, Lu H,. TasselNetv2: in-field counting of wheat spikes with context-augmented local regression networks [J]. Plant Methods, 2019,15:150

[9] Lu H, Liu L, Li YN,. Tasselnetv3: Explainable plant counting with guided upsampling and background suppression [J]. IEEE Transactions on Geoscience and Remote Sensing, 2021,60:1-15

[10] Hasan MM, Chopin JP, Laga H,. Detection and analysis of wheat spikes using Convolutional Neural Networks [J]. Plant Methods, 2018,14:1-13

[11] 张领先,陈运强,李云霞,等.基于卷积神经网络的冬小麦麦穗检测计数系统[J].农业机械学报,2019,50(3):144-150

[12] 陈佳玮,李庆,谭巧行,等.结合轻量级麦穗检测模型和离线Android软件开发的田间小麦测产[J].农业工程学 报,2021,37(19):156-164

[13] 鲍烈,王曼韬,刘江川,等.基于卷积神经网络的小麦产量预估方法[J].浙江农业学报,2020,32(12):2244-2252

[14] Bochkovskiy A, Wang CY, Liao HYM. Yolov4: Optimal speed and accuracy of object detection [J]. arXiv preprint arXiv. 2004, 2020:10934

[15] Lin TY, Dollar P, Girshrck R,. Feature pyramid networks for object detection [C]//IEEE Conference on Computer Vision and Pattern Recognition. Seattle, WA, USA: IEEE, 2017:2117-2125

[16] Kong T, Sun F, Liu H,. Foveabox: Beyound anchor-based object detection [J]. IEEE Transactions on Image Processing, 2020,29:7389-7398

[17] Redmon J, Farhadi A. Yolov3: An incremental improvement [J]. arXiv preprint arXiv:1804, 2018:02767

[18] He K, Zhang X, Ren S,. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Seattle, WA, USA: IEEE, 2016:770-778

[19] Wang CY, Liao HYM, Wu YH,. CSPNet: A new backbone that can enhance learning capability of CNN[C].//IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Seattle, WA, USA: IEEE, 2020:390-391

[20] David E, Madec S, Sadeghi-tehran P,. Global Wheat Head Detection (GWHD) dataset: a large and diverse dataset of high resolution RGB labelled images to develop and benchmark wheat head detection methods [J]. Plant Phenomics, 2020:1-12

[21] Liu W, Anguelov D, Erhan D,. Ssd: Single shot multibox detector [C]//European Conference on Computer Vision. Springer, 2016:21-37

[22] Tan M, Pang R, Le QV. Efficientdet: Scalable and efficient object detection [C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, WA, USA: IEEE, 2020:10781-10790

[23] Ren S, He K, Ross G,. Faster r-cnn: Towards real-time object detection with region proposal networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017,39(6):1137-1149

The Wheat Ear Detection Method Based on Anchor Free YOLO Detection Network

LU Qiao-kuan, ZHANG Jing-lei*

300384,

Wheat yield can be estimated from the total number of wheat ears per unit area. The detection method based on the sequence characteristics of wheat image is highly effected by factors such as light, resulting in inaccuracy. In order to accurately locate wheat ears and estimate the number the deep convolution neural network was introduced. In order to overcame the disadvantages of inappropriate anchors with various proportions of wheat ears, this paper used an anchor-free wheat ear target detection method based on YOLO framework instead of the common rectangular priori anchor frame in target detection network. CSPDarknet53 network was applied as feature extraction network. And a feature processing module was designed according to the FPN (Feature Pyramid Networks) structure in middle layer, which could increase the receptive field, extract the multi-scale information of the image, and obtain feature maps that include the semantic information from both high and low levels. In back-end network, an anchor-free FoveaBox detector was applied to achieve object detection. The test results from two public wheat ear data sets with different resolutions WEDD and GWHD showed that compared with Yolov4 network, the average detection precision values increased by 8.81% and 1.69%, respectively. The proposed method could reach 36FPS of frame rate on GWHD dataset. This algorithm could accurately and effectively detect wheat ears in real time, and is of help with subsequent work such as wheat yield estimation and breeding.

Anchor free; wheat ear detection method; image identification

TP751

A

1000-2324(2022)05-0796-07

2022-05-25

2022-05-30

路乔宽(1997-),男,硕士,研究方向:深度学习,农业信息工程. E-mail:1065219917@qq.com

通讯作者:Author for correspondence. E-mail:zhangjinglei@tjut.edu.cn