基于深度强化学习的分布式电源就地自适应电压控制方法

2022-11-28蔡田田魏明江

习 伟,李 鹏,李 鹏,蔡田田,魏明江,于 浩

(1. 智能电网教育部重点实验室(天津大学),天津市 300072;2. 南方电网数字电网研究院有限公司,广东省 广州市 510670)

0 引言

分布式电源(distributed generator,DG)的大量接入使得配电网的运行情况进一步复杂。其中,过电压和电压波动问题得到了广泛关注[1]。传统的有载调压变压器[2](on load tap changer,OLTC)及电容器组[3](capacitor bank,CB)作为主要电压调节设备,调节速度较慢,难以适应DG 的快速波动[4];储能系统可以实现削峰填谷的效果,但建设成本较高,应用场景仍然受限[5];而基于换流器的DG 能够利用剩余容量为系统提供实时无功电压支撑[6],具有较好的经济性以及高度灵活可控的就地无功支撑能力,成为配电网实时电压控制的有效手段[7]。

国内外对DG 无功控制方法已经开展了广泛研究。例如,传统的基于二阶锥松弛的集中式优化算法[8]、为应对不确定性的随机优化方法[9]、考虑分区的分布式优化方法[10]等。然而,在实际运行中,由于难以获取配电网的精确参数,以上基于物理模型的DG 无功优化方法无法保证模型的准确性。强化学习作为一种数据驱动的无模型方法,在电力系统电压控制中得到了广泛应用[11]。通过强化学习方法构建的智能体,能够基于历史数据或在线交互进行训练,智能体根据获取的观测状态迅速给出运行策略,并基于历史经验不断优化调整,从而进一步改善系统的运行状态。

依据动作空间的不同,强化学习问题可以分为离散控制问题和连续控制问题[12]。经典的深度Q学习(deep Q-learning,DQN)算法[13]适用于OLTC与CB 等离散调节设备控制[14]。文献[15]提出了深度确定性策略梯度(deep deterministic policy gradient,DDPG)方法,DDPG 方法适用于大规模连续控制问题,可应用于电力系统微电网运行控制[16]、电力系统发电频率控制[17]等。文献[18]基于DDPG 方法实现了基于DG 逆变器的集中短期电压控制。

随着DG、电动汽车的广泛接入,海量的信息流使得系统通信负担加大,集中式控制方法由于通信能力限制,难以做到实时响应[19],并且隐私问题难以得到保障。在此背景下,边缘计算技术与分布式就地控制成为解决海量通信负担与控制时延问题的有效方案[20]。基于网络分区与边缘计算装置,可以对区域内设备进行就地管理,实现对系统变化的快速响应,减轻通信负担与云服务器的计算压力[21]。同时,边缘计算装置也具备与云端的通信能力,可以实现云-边协同调控[22]。

为解决多区域协同问题,多智能体深度强化学习 (multi-agent deep reinforcement learning,MADRL)将单个强化学习问题拓展为多智能体控制问题,广泛应用于电力系统需求侧响应[23]、微电网能源管理[24]、频率控制[25]等领域。其分布式和就地响应特性与边缘计算架构高度匹配,利用深度强化学习的无模型控制能力,边缘计算装置可实现对本区域内设备的实时控制。同时,边缘计算装置本地交互控制数据可按周期上传至云端,云端对深度强化学习模型进行更新并重新下发至边缘侧以实现自适应的云-边协同控制。

针对高比例DG 接入下的电压波动问题,本文提出了基于MADRL 的DG 云-边协作就地电压自适应控制技术框架。然后,构建基于DG 的电压控制马尔可夫决策过程,设计了DG 出力动态边界掩模机制,解决了分布式电源有功和无功出力耦合下的深度强化学习控制问题。最后,在改进的IEEE 33 节点算例及中国南方电网53 节点算例上验证了所提方法的可行性与有效性。

1 DG 就地智能控制框架

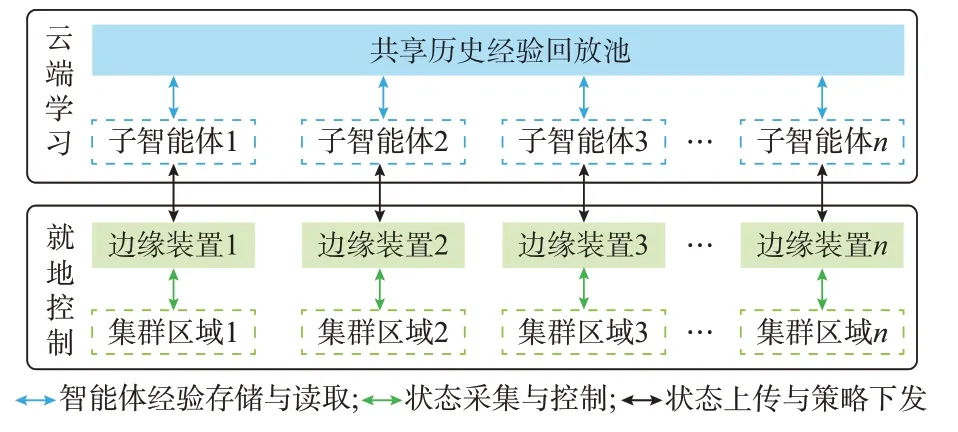

基于深度强化学习的DG 集群就地电压控制框架如图1 所示。基于配电网络分区的深度强化学习,智能体对控制区域内的DG 及无功调节设备可以实现就地控制,改善电压质量,提高系统运行状态。

图1 DG 集群控制框架Fig.1 Control framework for DG clusters

如图1 所示,在就地控制层,配电网各分区内边缘计算装置搭载智能体控制模型,智能体模型感知本区域内观测节点的量测信息,迅速调节区域内的DG 无功出力,从而优化控制,交互记录将上传至云端学习层以更新策略。

在云端学习层,智能体接受来自对应区域的交互记录并储存至共享经验池。同时,智能体定时从共享经验池采样进行策略更新,并将更新后的控制模型下发至边缘控制装置,以保证模型对环境变化的适应性。

为解决DG 有功和无功出力耦合约束,在智能体动作出口引入动态边界掩模方法,对智能体给出的原始动作进行再处理,避免动作不符合约束。

1.1 DG 集群就地电压控制方法

边缘计算装置作为本文所提电压控制框架的物理依托,通常安装在馈线的分支节点或DG 集群处。本文以边缘计算装置安装位置作为区域中心,确定控制区域。同时,在实际运行中,分区可根据配电运营商的要求进行调整。基于边缘计算装置的配电网分区控制在一定程度上解耦控制过程。同时,通过各区共享运行控制数据,实现信息交互增强智能体协作能力。

静止无功补偿器(static var compensator,SVC)、静止无功发生器(static var generator,SVG)、磁 控 电 抗 器(magnetically controlled reactor,MCR)[26]等设备广泛应用于电力系统无功控制,具备快速、平滑的调节能力[27]。相对于DG 逆变装置而言,以上装置的无功出力不受有功出力的限制,本文为进一步考虑有功和无功出力耦合下的逆变器出力调节,充分利用剩余容量,同时因分布式光伏具备就地控制特性,使用分布式光伏换流器作为主要调节设备。因SVG 等设备的控制特性较为相似,将SVG 调节作为DG 调节后的补充调节设备。

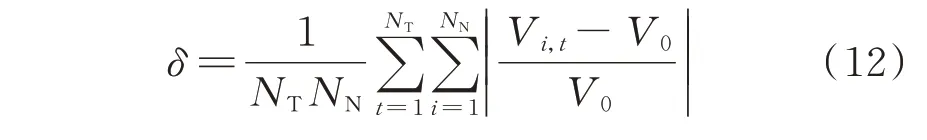

本文所提方法的控制目标为通过调节无功出力设备以最小化系统各节点电压偏差之和,表达式为:

式中:f为目标函数;Vi为节点i(i=1,2,…,NN)的电压幅值;V0为网络额定电压;NN为网络节点数量。

被控对象DG 及SVG 需要满足以下约束。

1)DG 有功出力约束

式 中:Pj,DG为 第j个DG 的 有 功 出 力,其 中,j=1,2,…,NDG,NDG为DG 的 数 量;Pj,DG,max、Pj,DG,min分别为第j个DG 的有功出力上、下限。

2)DG 无功出力约束

式 中:Qj,DG为 第j个DG 的 无 功 出 力;Qj,DG,max、Qj,DG,min分 别为第j个DG 的无功 出力上、下限。

3)DG 容量约束

式中:Sj,DG为第j个DG 的容 量。

4)SVG 容量约束

式 中:Qk,SVG为 第k个SVG 的 无 功 出 力,k=1,2,…,NSVG,NSVG为SVG 的 数 量;Qk,SVG,max和Qk,SVG,min分别为第k个SVG 的无功出力上、下限。

1.2 深度强化学习电压控制原理

DDPG 采用双Actor-Critic 网络架构,适用于大规模控制问题,可输出确定、连续的动作[15]。

各区域智能体观测给定关键节点的状态s,根据状态s给出动作a,区内被控设备执行动作a后配电网转入下一状态s',同时配电网根据奖励函数,返回奖励r,用于评价给定动作的优劣。按照以上过程循环,形成强化学习序列决策问题。其中,一个交互周期数据定义为(s,a,r,s')。

Actor-Critic 网络架构中的Actor 网络通过拟合策略π(s),根据区内量测信息来指导DG 的运行。而Critic 网 络 通 过 拟 合 动 作 价 值 函 数qπ(s,a),由 量测信息和基于量测信息给出的出力方案评估动作的价值。基于动作价值持续更新策略π(s),以达到策略最优。

1.3 考虑云-边协同的多智能体电压控制

多 智 能 体 DDPG (multi-agent DDPG,MADDPG)基于DDPG 将单智能体决策过程演变为多智能体协作模式。考虑云-边协同的多智能体电压控制如下:

1)智能交互与经验上传。在多区域DG 集群电压控制过程中,考虑边缘计算装置算力限制,各区域交互数据将按交互周期上传至云端经验回放池。通过建立经验回放池可以实现云端智能体的自主学习与策略更新。

2)经验共享与策略更新。通过共享经验回放池数据,各分区智能体能够获得其余智能体的历史状态及对应动作信息。具备学习能力的云主站智能体将从经验回放池中采样本区域及其他区域交互数据进行策略更新。在多区域协作模式下,本区域智能体依据协作目标进行策略更新,从而实现多区域多主体协调控制。

3)策略下发与实时控制。更新后的策略网络将下发至边缘计算装置,边缘计算装置可通过策略网络根据就地信息做出实时响应。同时,交互数据将再次上传至云端经验回放池,并进行下一周期智能体学习与策略更新,保证智能体对环境变化的适应性以及区间协作能力。

值得注意的是,由于云端训练时考虑区间协作为目标,下发至边缘侧的策略具备一定的协作能力,边缘侧控制过程可不进行区间信息交互,在保证控制器对系统环境变化的快速响应的同时,实现了区间协作控制。

2 DG 集群就地控制问题建模

2.1 就地电压控制马尔可夫决策过程建模

1)基于分区的状态空间构建

各区域的节点观测数据集中传输至边缘计算装置,定义智能体状态空间为:

式 中:Sn为 智 能 体n的 状 态 空 间,n=1,2,…,NA,NA为 智 能 体 的 数 量;Pi、Qi分 别 为 节 点i的 有 功 功率、无 功 功 率;Ωn,O为 智 能 体n区 域 内 的 观 测 节 点集合。

2)就地控制动作空间建模

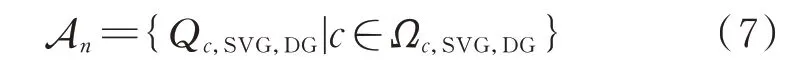

基于DG 集群,通过DG 换流器及其余无功调节设备实现电压的灵活控制,定义智能体动作空间为:

式 中:An为 智 能 体n的 动 作 空 间;Qc,SVG,DG为 被 控 设备c的 无 功 出 力,c=1,2,…,NDG+NSVG;Ωc,SVG,DG为智能体n区域内被控设备集合。

3)电压控制奖励函数设计

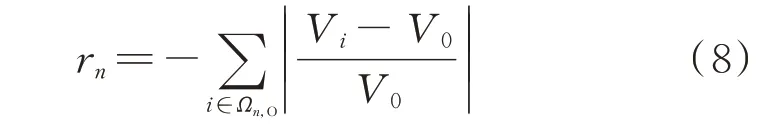

为减少系统电压偏差,拟以分区电压偏差绝对值的相反数为奖励函数,即电压偏差越小,智能体收获奖励越大,以达到驱动智能体使策略向减少电压偏差方向更新的目的,表达式为:

其中:rn为智能体n的奖励。

2.2 考虑容量耦合的动态边界动作掩模机制

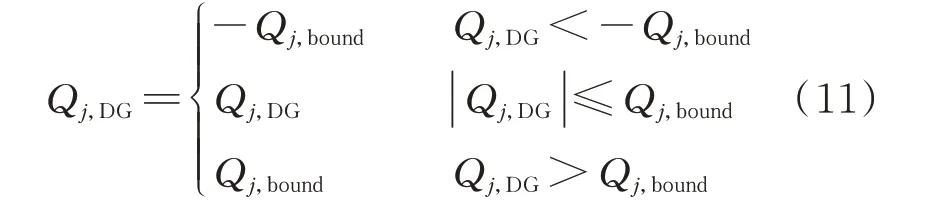

如式(4)所示,DG 的有功与无功出力互相耦合。因此,DG 的无功出力动作范围处于动态变化中。在给定第j个DG 的有功出力情况下,其无功容量边界绝对值为:

式 中:Qj,bound为 第j个DG 的 无 功 容 量 边 界 绝 对 值。

为简化动作空间,将无功容量的上下限作为换流器容量的上下限。则式(3)的表达式变为:

故对于智能体给定原始无功出力,按照如式(11)所示处理。

通过以上处理步骤,根据有功出力动态设定无功出力边界,保证智能体动作的合理性,避免实际运行过程中动作失效。

基于MADDPG 的就地电压控制流程如附录A图A1 所示。

3 算例分析

3.1 改进的IEEE 33 节点系统

本文使用改进IEEE 33 节点系统算例,其拓扑及分区如附录A 图A2 所示。额定负荷为(3.715+j2.3)MV·A。其 中,节点9、10、11、18、21、23、24、25、31、32 和33 接入光伏,有功容量为120 kW,视在容量为144 kV·A;节点16、17、22 和29 接入光伏,有功容量为240 kW,视在容量为288 kV·A;节点15、20 和30 接入SVG,容量为240 kvar。接入的光伏总容量为2.736 MV·A,容量渗透率为62.62%。

使用 TensorFlow 深度学习框架,搭建MADDPG 智能体模型,选取1 年的数据对智能体进行训练。软件环境为Python 3.8.10,TensorFlow 2.8.0,硬件为腾讯云2 核2 GB 轻量应用服务器,搭载Ubuntu 20.04 LTS 系统。模型训练情况如附录A 图A3 所 示。

3.2 电压控制效果分析

训练完毕后,选取测试日对智能体控制效果进行测试,测试日DG 及负荷日变化曲线如附录A 图A4 所示,优化步长为5 min。对比以下3 个场景的运行优化效果:

场景1:无功出力为0,DG 仅有功出力,得到电压初始状态;

场景2:利用所提MADDPG 集群控制方法优化被控设备出力;

场景3:利用集中式优化方法对被控设备出力进行优化。

选取1 d 中各时刻电压幅值(标幺值)的最大值与最小值,绘制电压极值曲线如图2 所示。

图2 不同场景下的电压极值变化Fig.2 Variation of maximum and minimum voltages in different scenarios

选取SVG 接入节点15 和DG 接入节点31,绘制其电压分布如附录A 图A5 和图A6 所示。由图可知,场景1 中无功出力为0,电压最小值低于安全运行下限,且节点电压波动较大。场景2 与场景3 中的电压极值曲线与节点电压分布曲线基本接近,极值电压均位于安全运行范围内,且节点电压相对波动平缓,电压质量有较大提升。

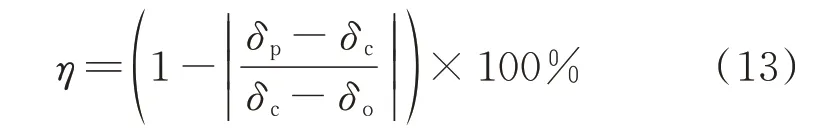

进一步对1 d 中的电压分布进行数值分析,得到电压质量的各项指标如表1 所示。

表1 测试日各场景电压控制结果Table 1 Voltage control results in different scenarios on test days

平均电压偏差指标δ定义为:

式 中:Vi,t为 节 点i在t时 刻 的 电 压 幅 值;NT为 测 试 日测量时刻的数量。

最优率η定义为:

式中:δp、δc和δo分别为所提MADDPG 方法、集中式优化方法和不控制3 种场景下的平均电压偏差指标。

最优偏移指标衡量了所提方法接近集中式优化方法的程度。由表1 可知,相比于场景1,场景2 所提方法和场景3 集中式优化方法的平均电压偏差分别降低了76.47%和77.94%,对电压质量有明显改善;场景1 的电压最小值为0.930 9,远低于安全运行约束下限,而场景2 和场景3 的电压均位于安全运行约束范围以内。

3.3 最优动作对比

选取接入节点15 处的SVG 和节点31 处的DG,绘制场景2 和场景3 中无功出力如附录A 图A7 和图A8 所示。由图可知,所提无模型的自适应控制方法的出力方案与基于最优化方法所得的出力方案基本接近。由表1 可知,所提方法的电压控制效果基本接近最优化方法,最优率达98.05%。即所提方法能够自适应控制DG 及SVG 出力,其控制效果接近于最优化方法。

3.4 不确定性应对效果分析

为验证所提方法对DG 出力及负荷波动的适应性,对DG 及负荷曲线施加±20%随机波动,考虑不确定性的DG 及负荷曲线如附录A 图A9 所示。各个场景电压控制效果如表2 所示。节点15 的电压分布如图A10 所示。

表2 不确定性场景测试日控制结果对比Table 2 Comparison of control results in uncertainty scenarios on test days

由表2 及附录A 图A10 可知,考虑DG 有功出力及负荷的不确定性后,基于日前预测曲线的集中式优化方法电压控制效果有明显波动,电压控制效果下降,而所提方法能够跟踪负荷及DG 的变化,从而实时制定出力策略,电压波动相对平缓。

3.5 中国南方电网53 节点算例测试

为验证方法的可行性,选取中国南方电网某53节点系统进行测试,算例拓扑及分区如附录A 图A11 所示,额定负荷(7.032 5+j1.429 2)MV·A。其中,节点9、10、15、17、20、21、31 和50 接入光伏的有功容量为240 kW,视在容量为264 kV·A;节点27、28、29、51、52 和53 接入光伏的有功容量为400 kW,视在容量为440 kV·A。接入的光伏总容量为4.752 MV·A,容量渗透率为66.22%。

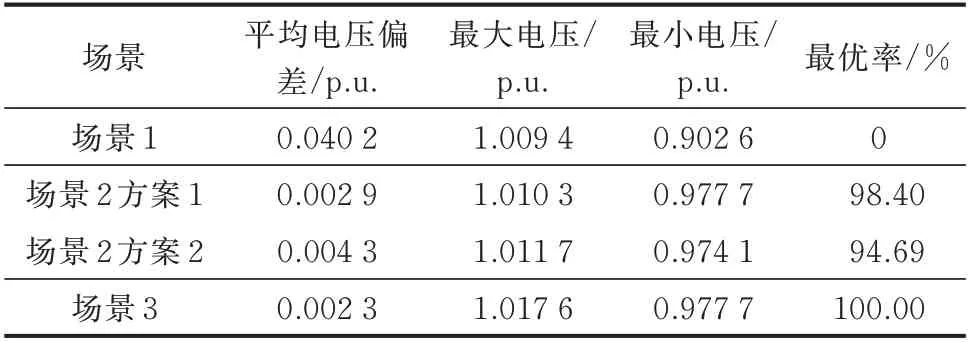

测试日负荷及DG 运行曲线如附录A 图A4 所示。为研究不同分区下智能体的学习效果与控制效果,分别将网络分为3 个和4 个区域,如图A11 所示。仍选取3 种场景进行对比。模型训练情况如图A12 所示。表3 为各场景优化结果对比。

表3 测试日各场景电压控制结果Table 3 Voltage control results in different scenarios on test days

由表3 可知,在方案1 中,所提方法的平均电压偏差相比于原始场景下降了92.78%,且由于该算例节点较多、负荷较重,原始电压下限为0.902 6,远低于安全运行水平,所提方法将电压下限由0.902 6 提高至0.977 7,大幅提高了电压运行质量。

由方案1 和方案2 的对比可知,分区对所提方法控制效果无明显影响。值得注意的是,随着分区数量的增多,将对智能体的协作要求更高,控制效果略有下降;相应的,若分区数目减少,智能体之间协作要求下降,但将趋近于全局控制,大幅增加通信成本。

采用集中式方法进行优化时,存在优化时间长、收敛性受网络拓扑及负荷水平影响等问题,所提方法在智能体训练完成后仅依靠就地信息进行实时决策,策略生成周期低至毫秒级,且决策时不存在优化算法的收敛性问题。同时,依托于云-边协同框架下的经验共享,所提方法最优率达98.04%,在实时决策模式下保证了较高的决策水平。

4 结语

本文面向高渗透率DG 接入的配电网电压波动问题,充分利用DG 的调节潜力,提出了基于MADDPG 的DG 集群控制框架。考虑DG 的容量耦合,使用动态边界掩模方法,保证动作的合理性,基于分区实现DG 就地控制。最后,在改进IEEE 33节点系统及中国南方电网53 节点系统算例上验证了所提方法的可行性,基于MADDPG 的DG 就地电压控制方法能够自适应地控制DG 无功出力,从而缓解电压波动问题。

后续工作将进一步考虑OLTC 等慢时间尺度调节设备控制方法,实现快慢时间尺度上的多设备协调电压控制。

附录见本刊网络版(http://www.aeps-info.com/aeps/ch/index.aspx),扫英文摘要后二维码可以阅读网络全文。