基于深度学习的目标跟踪技术及其多波段应用研究*

2022-11-19李文涛李世玉郇金晓张振华乔海东牟进超

李文涛,李世玉,郇金晓,李 磊,张振华,康 忱,刘 娣,乔海东,牟进超

基于深度学习的目标跟踪技术及其多波段应用研究*

李文涛1,李世玉1,郇金晓1,李 磊1,张振华2,康 忱2,刘 娣2,乔海东2,牟进超2

(1 西安电子科技大学天线微波技术国家重点实验室 西安 710071 2 北京遥测技术研究所 北京 100076)

目标跟踪是计算机视觉领域中最具挑战性的领域之一。首先,回顾了目标跟踪技术发展现状并总结出目标跟踪的一般流程;其次,分析了卡尔曼滤波、粒子滤波等传统目标跟踪方法的优缺点;再次,依次重点介绍了固定窗跟踪等相关滤波目标跟踪方法,以及全网络自适应目标跟踪等高性能目标跟踪方法;最后,总结了目标跟踪在红外、毫米波、太赫兹等波段的应用,并对多波段融合目标跟踪进行了展望。

目标跟踪;深度学习;太赫兹;红外;毫米波

引 言

视觉目标跟踪是指已知目标在初始图像中位置和跟踪窗大小信息的情况下,通过特定方法获取目标在后续帧中位置以及跟踪窗大小信息的技术。该技术在低小慢飞行器监控[1]、空间轨道目标跟踪[2]、高通量场所重点目标监视[3]等方面具有广泛应用前景。目标跟踪可以分别从目标数量、时间跨度、工作波段等不同角度进行分类。从跟踪目标数量角度来看,目标跟踪可以分为单目标跟踪[4]和多目标跟踪[5];从跟踪时间跨度角度来看,目标跟踪可以分为短期跟踪和长期跟踪[6];从工作波段角度来看,目标跟踪可以分为可见光、红外、毫米波以及太赫兹跟踪[7]等;从目标对应量测和占据分辨单元个数角度来看,目标跟踪可以分为点目标跟踪[8]以及扩展目标跟踪[9]。随着各波段成像技术的不断发展,目标跟踪算法在各波段中不断被应用并取得了大量的研究成果。近十年来,随着深度学习技术的不断进步[10],基于深度学习的目标跟踪及其多波段应用研究成为国内外学术界研究重点。

本文根据当前目标跟踪技术的发展现状,给出了目标跟踪的一般性流程,并重点研究了传统目标跟踪算法,相关滤波目标跟踪算法和基于深度学习的高性能目标跟踪算法。在此基础上,分别介绍目标跟踪技术面向不同波段的应用研究,分析其技术难点以及未来发展趋势,并为多波段融合目标跟踪提供研究思路以及参考方向。

1 目标跟踪的一般性过程

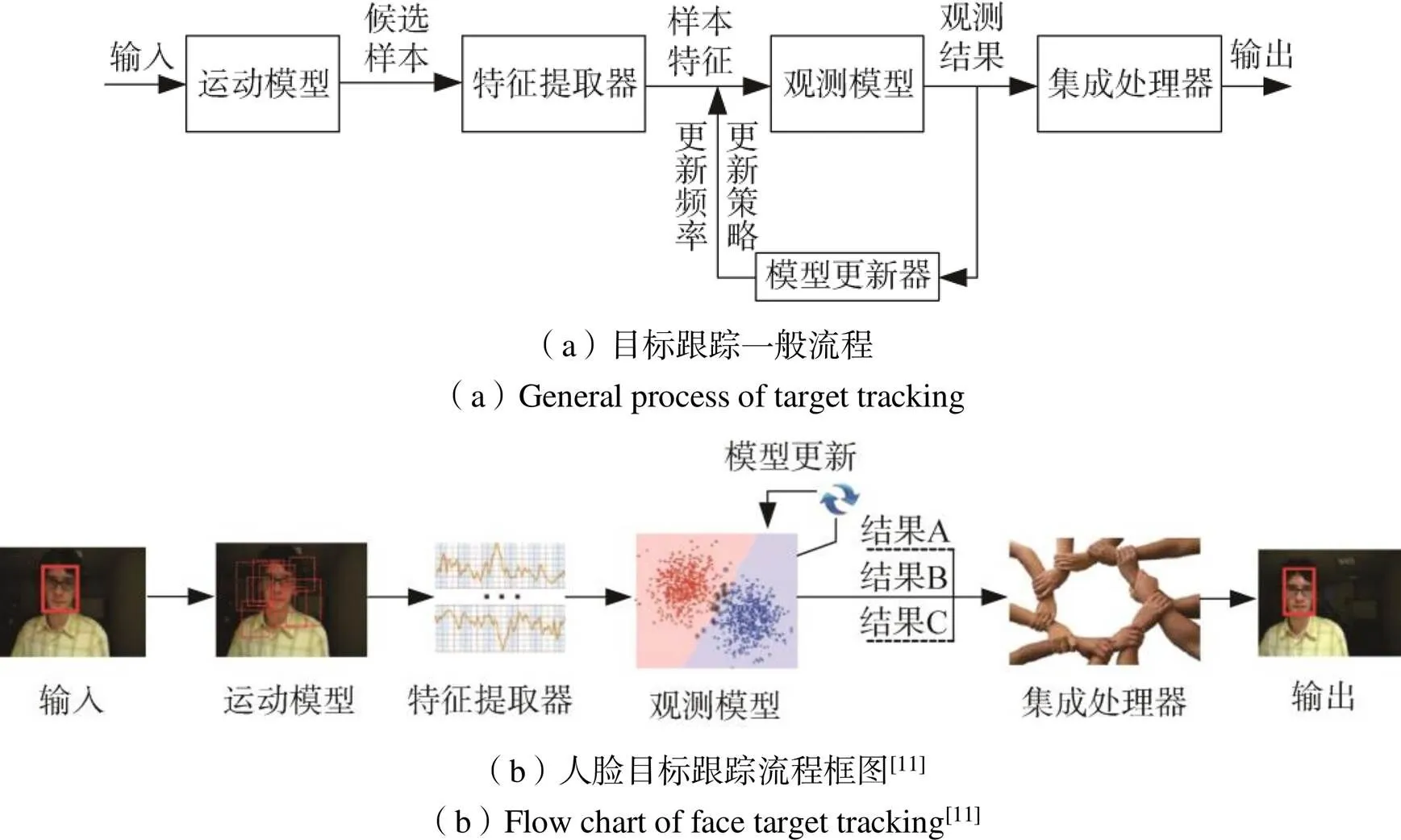

图1(a)给出了目标跟踪的一般性过程,包括运动模型、特征提取器、观测模型、集成处理器以及模型更新器,共五个模块[11]。不同的目标跟踪技术与上述流程略有差异,但都是对上述流程的某一个或几个模块进行改进。其中运动模型模块在前一帧估计的基础上,生成一组候选样本,并将此候选样本输入特征提取器;特征提取器模块使用特征表示每个候选样本,并将每个特征输入观测模型;观测模型模块基于特征模板判断候选样本中是否存在目标,计算候选样本为目标的概率,然后选择概率最高的候选样本作为观测结果,并将此结果输入模型更新器以及集成处理器;模型更新器模块根据观测模型的输出控制观测模型的更新频率以及更新策略;当多个跟踪器集成一个跟踪系统时,最终结果由集成处理器使用集成策略将多个跟踪器结果组合并输出。图1(b)以人脸跟踪为例,给出了目标跟踪一般流程的可视化解读。

图1 目标跟踪及实例

2 传统目标跟踪

传统目标跟踪技术重点研究生成式目标跟踪算法。该算法的特点是不太关注背景信息,通过最大化联合概率对目标进行建模[12],然后找出数据如何生成。其通用思路是通过学习一个表示目标的生成模型,然后搜索图像区域;在生成模型的基础上,找到与模型描述相似的目标进行匹配,最匹配的区域即当前帧中的目标。生成式目标跟踪算法典型例子是卡尔曼滤波和粒子滤波,它们是非常经典的传统目标跟踪算法。

2.1 卡尔曼滤波跟踪

卡尔曼滤波[13]最早由美国马里兰州高级研究所的Kalman于1960年提出,其基本流程如图2所示。其中为目标状态向量,为转移矩阵即目标运动模型,为系统输入,为将系统输入映射到状态向量维度的控制矩阵,为均值为零、协方差矩阵为的高斯噪声,为目标状态之间的协方差矩阵,为卡尔曼增益,为将状态向量映射到测量值维度的转换矩阵,为测量噪声协方差矩阵,为系统测量值。首先,根据输入系统观测数据和上一状态的信息,通过线性系统运动模型预测当前时刻状态以及协方差矩阵,然后通过协方差矩阵、转换矩阵以及测量噪声协方差矩阵计算卡尔曼增益,最后使用观测模型得到的测量值以及卡尔曼增益对系统预测状态以及协方差进行修正。

卡尔曼滤波可以有效解决目标跟踪过程中目标暂时消失的问题,但不适用于非线性系统。针对卡尔曼滤波这一缺陷,日本京都工业大学Y. Sunabara和美国南加州大学Bucy先后于1970年、1971年提出一种适用于非线性随机离散系统的卡尔曼滤波[14,15];1999年,德国宝马汽车公司K. Reif等人正式提出扩展卡尔曼滤波(Extended Kalman Filter)[16],先将非线性系统通过泰勒级数展开进行线性化处理,然后对信号使用传统卡尔曼滤波框架进行滤波。1997年,英国牛津大学S. J. Julier等人利用不敏变换(Unscented Transform)[17],通过互相关矩阵以及加权样本点来近似描述目标当前时刻状态的概率密度分布,从而实现了无迹卡尔曼滤波(Unscented Kalman Filter)[18],克服了扩展卡尔曼滤波计算复杂度高和精确度低的缺陷,且在非线性系统中表现更好。2009年,加拿大麦克马斯特大学I. Arasaratnam提出容积卡尔曼滤波(Cubature Kalman Filter)[19],基于三阶球面容积准则[19],通过容积点来逼近非线性系统的高斯噪声状态均值和协方差,能够有效解决非线性系统状态估计问题。卡尔曼滤波体系算法演化逻辑如图3所示。

2.2 粒子滤波跟踪

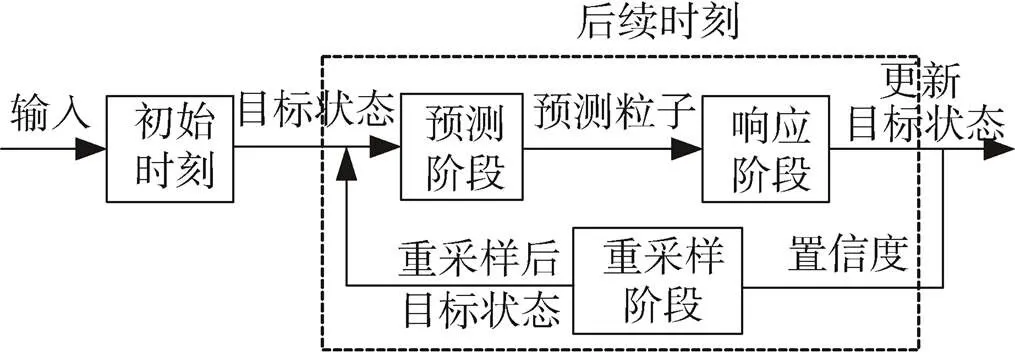

粒子滤波跟踪方法是比利时天主教鲁汶大学Nummiaro等人于2003年,针对卡尔曼滤波存在不适用非线性系统缺陷提出的[20],其基本流程如图4所示。首先,在初始时刻通过粒子模拟目标状态;其次,在预测阶段根据目标运动方程,得出每个粒子对应的预测粒子;然后,在响应阶段计算预测粒子的置信度(权重),并根据权重更新目标当前时刻状态;最后,在重采样阶段根据粒子权重对粒子进行重采样;在后续时刻重复上述预测、响应以及重采样阶段。粒子滤波算法流程中目标状态的概率密度函数通过状态空间中随机样本来近似,系统的后验概率密度根据系统状态的先验概率密度进行修正,进而将跟踪看作一个状态估计问题,评估目标的状态;与卡尔曼滤波算法假设噪声服从高斯分布不同,粒子滤波无需对噪声分布做出假设。

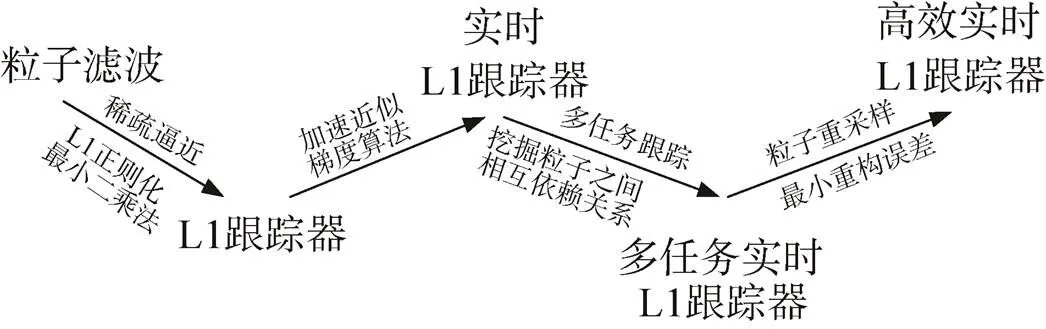

2009年,美国马里兰大学Mei Xue等人提出基于粒子滤波的L1跟踪器[21]。之所以被称为L1跟踪器,是因为该算法将跟踪等效成粒子滤波框架中的稀疏逼近问题,通过求解L1正则化最小二乘问题完成,但是其计算复杂度高导致算法的实时性差。针对上述方法存在的不足,新加坡国立大学Bao等人于2012年提出加速近似梯度求解方法[22],解决了L1跟踪器计算复杂度高的问题。2012年,伊利诺斯州高级数字科学中心Zhang等人提出一种多任务跟踪算法[23],该算法通过挖掘粒子之间的相互依赖性产生一系列封闭形式的解,可以有效加速近似梯度算法。2013年,美国丰田研究所Mei等人在目标跟踪领域中引入稀疏表示方法,利用L1跟踪器,从目标模板子空间中找到使重构误差最小的目标作为跟踪器输出结果[24]。虽然这类跟踪器的跟踪性能良好,但是在实时性方面存在不足。粒子滤波算法体系演化逻辑如图5所示。

图4 粒子滤波跟踪算法流程图

图5 粒子滤波算法体系演化逻辑图

2.3 其他跟踪方法

除了上述卡尔曼滤波以及粒子滤波外,传统目标跟踪方法还包括均值漂移、自适应背景混合模型等生成式跟踪算法。

美国西门子公司Comaniciu[25]等人于2000年在目标跟踪领域中首次提出均值漂移算法,通过图像特征构造概率密度函数,目标的最终位置根据梯度方向搜索的局部最大值获得,该算法计算量小,能够实现对目标的实时跟踪。2002年,英国萨里大学R. Bowden[26]等人提出了一种自适应背景混合模型,该模型每个像素点使用多个高斯分布函数来表示,组成高斯混合模型的概率密度函数,在后续跟踪过程中使用模型与当前图像中的像素点进行匹配,进而判断该点属于背景还是前景。2004年,加拿大多伦多大学Ross等人针对增量子空间无法自适应目标变化问题,提出一种基于R列奇异值分解的增量子空间方法[27],通过增量更新样本集,自适应跟踪过程中目标的变化。2005年,美国罗格斯大学Oncel. Tuzel等人提出了一种动态贝叶斯模型背景建模方法[28],该算法每个像素使用高斯分布表示,每个高斯分布均值和协方差的概率分布由递归贝叶斯学习获得,通过保留背景多模态性并估计每个像素所需层数,相比于自适应背景混合模型,提升了参数估计以及多模态场景表示性能。

生成式传统目标跟踪算法携带了更多信息,当数据不完整或目标被部分遮挡时,能较好地处理这些问题,但是由于没有充分利用目标背景信息,算法鲁棒性较差。表1给出了传统目标跟踪算法的特点及应用场景。

表1 传统目标跟踪算法特点及应用场景

3 相关滤波目标跟踪

相关滤波目标跟踪方法以判别式目标跟踪算法为基础,利用数据直接学习决策函数或最大化条件概率分布,不考虑样本生成方法,而是直接研究预测模型[29]。

由于相关滤波目标跟踪方法在训练中加入了背景信息,因此,能够有效区分图像中的目标和背景,算法鲁棒性更优越。相关滤波目标跟踪将图像转换到频域进行计算,根据滤波器只对感兴趣目标产生高响应;通过目标信号的卷积响应大于背景信号的卷积响应这一原理,得到目标在下一帧中的位置。

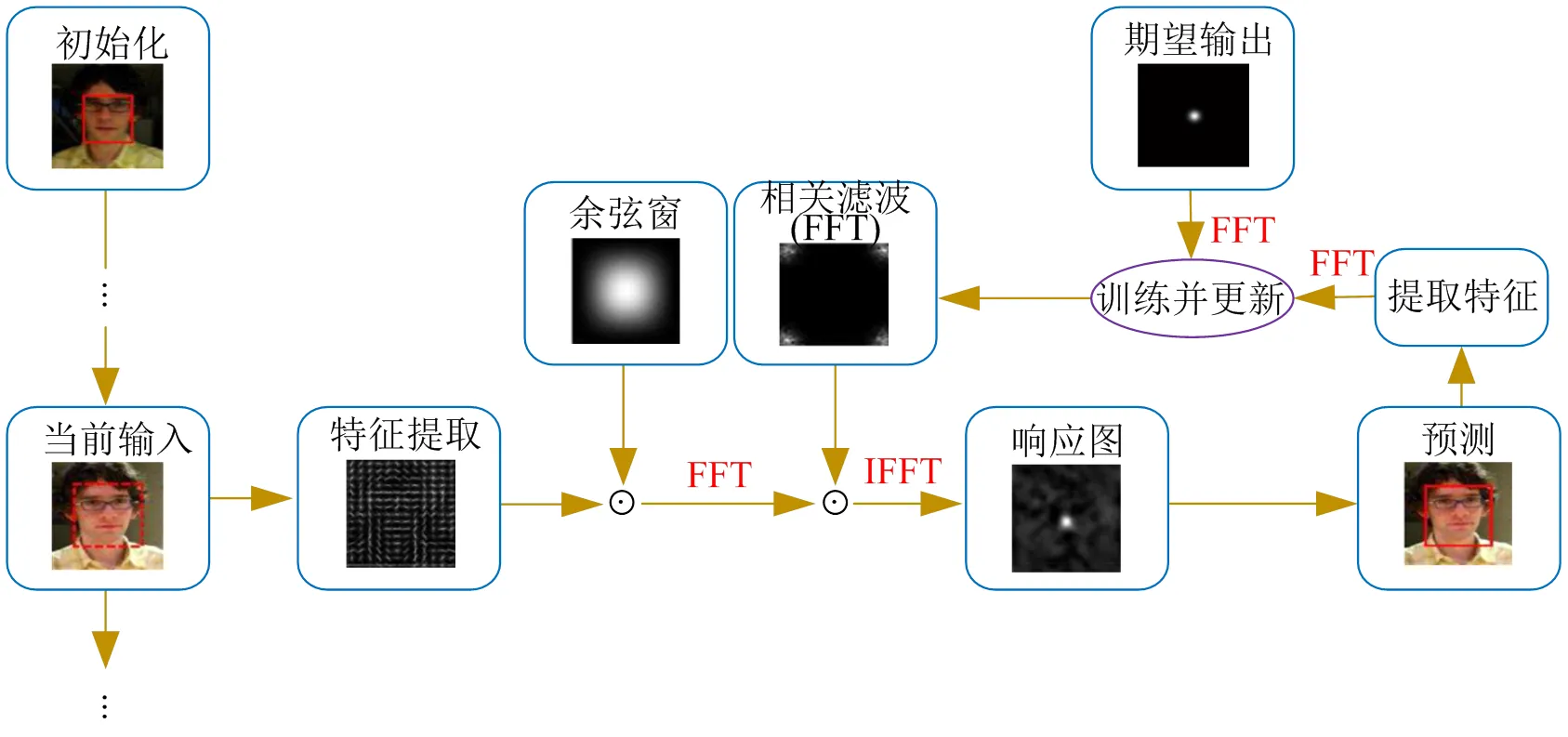

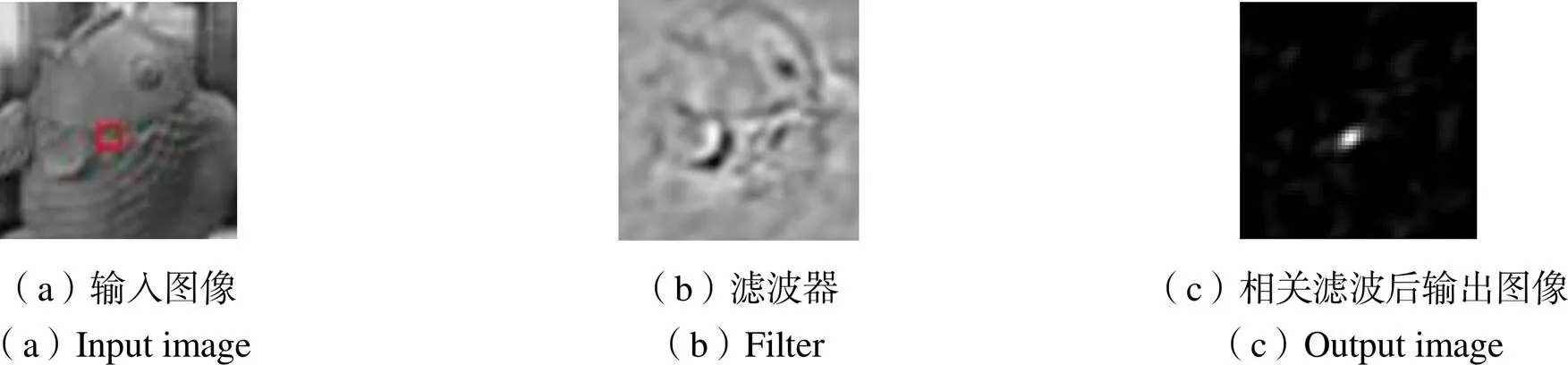

2015年,美国明尼苏达大学Chen等人提出相关滤波目标跟踪流程框架,如图6所示[30],包括初始化模块、特征提取模块、相关滤波模块、响应图模块以及模型更新模块。首先,训练相关滤波器,在初始帧中从目标给定位置裁剪图像块;其次,在后续每一帧中,从上一步预测位置裁剪出候选样本,并提取特征,例如LBP特征[31]、Haar-like特征[32]以及HOG特征[33]等,使用余弦窗口平滑边界效果;再次,通过逆快速傅里叶变换得到响应图,将响应图中最大值的位置作为滤波器输出,即目标的新状态;最后提取估计位置的特征,对相关滤波器进行更新。

图6 相关滤波跟踪框架[30]

3.1 固定窗相关滤波目标跟踪

2010年,Bolme提出最小均方误差输出和算法MOSSE(Minimum Output Sum of Squared Error)[34],该算法的滤波器通过最小化均方误差和进行训练,使用单通道灰度特征并在后续帧中更新滤波器以适应目标不断变化,跟踪速率提升至669帧/秒,算法效果如图7所示。2012年,葡萄牙科英布拉大学J. F. Henriques等人提出基于核函数的循环检测跟踪器CSK(Circulant Structure of Tracking-by-detection with Kernels)算法[35],在MOSSE算法的基础上扩展岭回归、基于循环移位的密集采样方法以及核方法,跟踪精确度相比于MOSSE有显著的提升,同时保持了320帧/秒的跟踪速率。2014年,葡萄牙科英布拉大学J. F. Henriques等人提出核相关滤波KCF(Kernel Correlation Filter)算法[36],KCF在CSK的基础上采用高斯核、线性核和多项式核三种核函数并且扩展多通道方向梯度直方图特征,在精度显著提高的同时实现172帧/秒的跟踪速率,满足实时性要求。2014年,瑞典林雪平大学M. Danelljan等人提出自适应颜色属性算法[37],实现了CSK算法颜色特征扩展。自适应颜色属性算法的跟踪速率随特征通道数量的增加逐渐下降,但跟踪效果越来越好,始终能保持高速跟踪水平。

图7 MOSSE算法效果图

3.2 自适应窗相关滤波目标跟踪

由于固定窗相关滤波目标跟踪方法采用固定窗口大小的跟踪窗,因此在跟踪尺度变化目标等动态目标过程中容易出现跟踪漂移甚至跟踪失败的情况。为了更好地满足目标尺度变化跟踪需求,2014年,瑞典林雪平大学M. Danelljan等人于2014年提出尺度估计算法[38],利用平移滤波器和尺度滤波器两个滤波器来检测目标位置和尺度变化。由于上述两个滤波器单独求解运算,因而实时性不好,只能达到25帧/秒。为了解决实时性问题,2017年,该团队提出了一种使用PCA降维的加速判别式尺度空间跟踪算法[39],通过将33个图像尺度特征减少到17个,运行速率提高到54帧/秒,其框图如图8所示,围绕目标中心提取平移滤波器样本(a),并通过平移滤波器估计目标位置,然后采用一组不同尺度的尺度滤波器样本(b),并将每个这样的样本映射为一个特征向量,尺度滤波器通过这些特征向量更新并计算出目标尺度。2014年,国内浙江大学Yang Li等人提出基于KCF的多特征尺度自适应算法[40],与使用PCA降维的加速判别式尺度空间跟踪算法[39]相似。该算法使用方向梯度直方图HOG(Histogram of Oriented Gradient)和颜色名称CN(Color Name)特征对图像进行多尺度缩放,然后通过平移滤波器检测目标,多尺度自适应算法将尺度估计与位置估计相结合,通过迭代优化实现了全局优化,提高了跟踪精确度但是实时性有所下降,只能达到7帧/秒。2016年,英国牛津大学Bertinetto等人结合HOG特征对光照变化的鲁棒性以及CN特征对形变不敏感的特点提出了实时跟踪的互补算法[41],在平移检测中加入光流法估计响应,提高了跟踪精确度以及跟踪速率,跟踪速率超过80帧/秒。2017年,美国阿卜杜拉国王科技大学Mueller等人结合上下文感知策略,提出了一种新的相关滤波CACF(Context-Aware Correlation Filter)算法[42],可用于传统相关滤波的学习阶段,也可广泛应用于多种不同类型的相关滤波跟踪算法,该感知策略能够显著提高跟踪器的精确度同时对速率产生很小的影响。

为了解决目标跟踪过程中边界效应问题,学者们尝试在自适应窗相关滤波跟踪算法的基础上,提出优化边界效应的算法。2015年,瑞典林雪平大学M. Danelljan等人提出空间正则化滤波器算法[43],该算法针对跟踪过程中的边界效应问题,引入空间正则化惩罚边界区域,即离目标中心越近,约束越小,离目标中心越远,约束越大。但是基于高斯-赛德尔迭代求解方法会导致跟踪器无法实时跟踪,跟踪速率仅能达到5帧/秒。2016年,土耳其Aselsan研究中心Gundogdu等人分析了余弦窗口的缺点,提出了一种空间窗函数相关滤波SWCF(Spatial Windowing for Correlation Filter)算法[44],可以抑制目标的无关区域并突出目标相关区域。由于新窗口的复杂性,跟踪器无法实现实时跟踪,跟踪速率同样仅能达到5帧/秒。

图8 判别式尺度空间跟踪算法原理框图

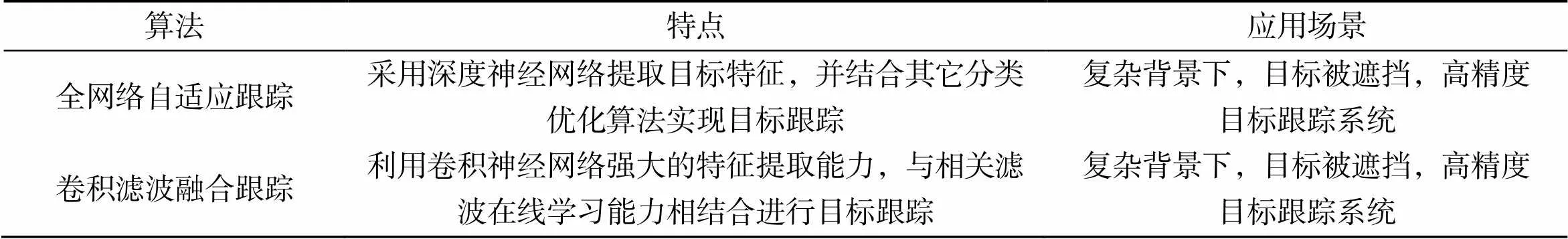

相关滤波算法通过快速傅里叶变换以及频域点乘运算,大大提高了算法的运行速率,并且能够自适应改变目标跟踪窗口的大小,优化目标跟踪过程中的边界效应。表2总结了相关滤波目标跟踪算法特点及应用场景。由于采用LBP、Haar-like、HOG等人工制作特征,对目标特征表达不够充分,相关滤波目标跟踪算法对目标形变、背景扰动等干扰的鲁棒性不高。

表2 相关滤波目标跟踪算法特点及应用场景

4 高性能目标跟踪

近年来,深度学习方法快速发展,尤其在目标识别、分割领域,卷积神经网络应用十分广泛,因此深度学习在计算机视觉领域各类任务中越来越发挥着举足轻重的作用。自2015年以来,顶级国际会议(CVPR、ICCV、ECCV)中,越来越多基于深度学习的跟踪器实现了惊人的性能。高性能目标跟踪算法即通过深度学习进行目标跟踪,根据跟踪网络主要可以分为两大类:一类是完全使用神经网络作为框架的全网络自适应目标跟踪[45];另一类是深度学习与相关滤波结合的卷积滤波融合目标跟踪[46]。下文将分别从这两方面开展论述。

4.1 全网络自适应目标跟踪

全网络自适应目标跟踪算法专注目标观测模型,该模型由一个具有多个分支的神经网络训练得到,目标状态由所有的分支通过集成处理器(分类器)进行估计,模型在线更新通过神经网络的反向传播算法完成,全网络自适应目标跟踪一般性流程如图9所示。

图9 全网络自适应目标跟踪一般流程

最早使用深度学习网络进行目标跟踪的是CNN-SVM算法[45],2015年由韩国浦项工业大学Seunghoon Hong等人提出。该算法将卷积神经网络以及支持向量机分类器进行结合,由网络的隐含层输出表示目标的特征描述因子,这些特征通过在线支持向量机学习一个可区分性的目标观测模型进行目标跟踪。2016年,韩国浦项工业大学Hyeonseob Nam等人将深度学习目标跟踪算法进行改进,提出了一种新的目标跟踪算法[47]。该算法使用卷积神经网络,预先使用视频集训练该网络用来表示目标,该网络包括领域特定层的多个分支以及共享层,通用目标表示通过迭代训练网络中的每个领域获得,然后使用预先训练的卷积神经网络中的共享层与一个新的二分类层相结合来构造网络,最后通过评估候选窗口随机采样周围目标状态进行目标跟踪。2017年,韩国浦项工业大学Bohyung Han等人提出了一种简单有效的正则化技术[48]用于卷积神经网络来表示目标,通过随机选择卷积神经网络中的一个子集在线学习完成正则化,其系统跟踪框网络框架如图10所示。

图10 卷积神经网络正则化跟踪网络框架

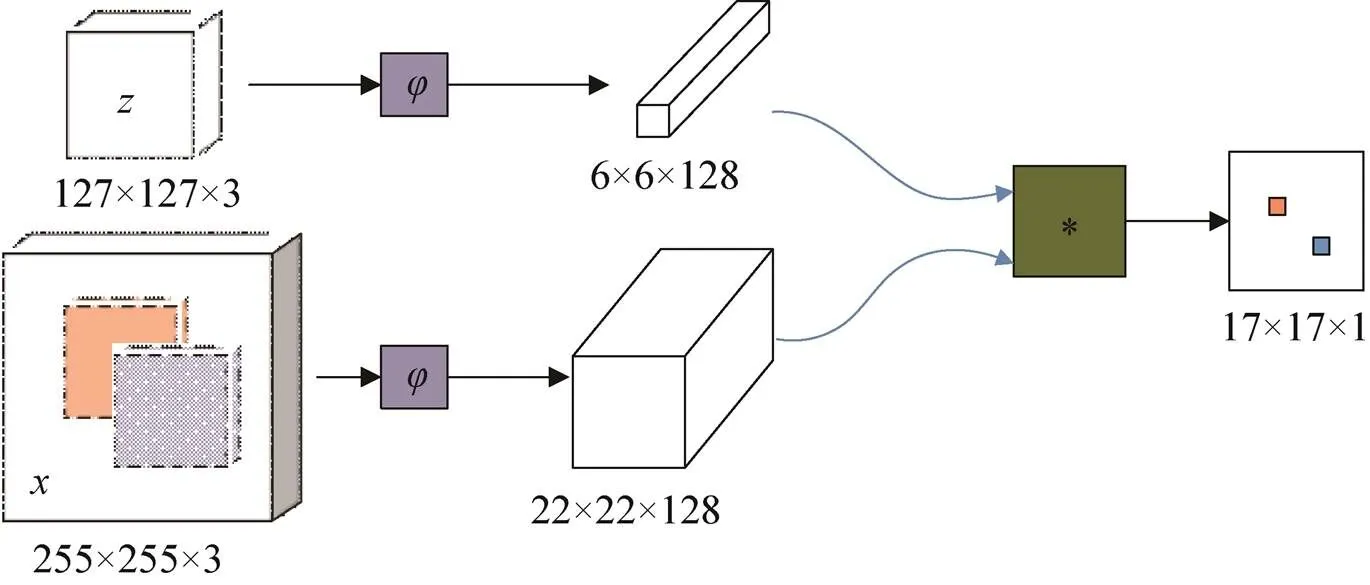

孪生网络即“连体神经网络”,最早由LeCun提出用于支票上的签名验证,并于2016年由英国牛津大学Bertinetto等人应用到目标跟踪领域,提出了全卷积孪生网络SiameseFC(Fully-Convolutional Siamese Networks)算法[49]。该算法采用全卷积的孪生网络,其网络框架如图11所示。首先使用卷积神经网络对输入的搜索图像以及模板图像进行卷积运算,然后使用一种相似度量函数将两个矩阵合并成一个矩阵。2018年,商汤集团有限公司B. Li等人提出了孪生区域回归网络SiamRPN(Siamese Region Proposal Network)算法[50],SiamRPN和SiameseFC使用了相同的数据读入方案,但是SiamRPN在网络后面加入了一个区域回归网络用来回归目标的类别以及跟踪窗,从而对SiameseFC进行改进。虽然基于孪生网络的跟踪算法性能较强,但是所有孪生网络算法都使用较简单的网络结构,较深的网络结构反而让算法的性能下降。针对上述问题,商汤集团有限公司B. Li等人在2019年提出了SiamRPN++算法[51],该算法针对由于网络严格平移不变性破坏而导致的影响,让目标在中心点附近通过均匀分布的采样方式进行偏移,对位置偏见进行了有效的消除,从而使得目标跟踪算法可以使用深层网络。目标跟踪算法大多采用尺度搜索或预先定义锚的方式来精确估计目标的尺度,通常需要复杂的配置。为了解决这个问题,2020年,国内华侨大学Zedu Chen等人利用全卷积网络,提出了一种新的目标跟踪框架[52],将目标跟踪问题看作是一个并行的分类和回归问题,在统一的全卷积中直接对目标进行分类并回归跟踪窗。同年,国内浙江工业大学Dongyan Guo等人[53]将目标跟踪任务分解为像素分类和跟踪窗回归两个问题,提出了一种新的全卷积网络框架。该框架由一个用于特征提取的孪生子网络以及一个用于跟踪窗预测的分类回归子网络组成。不同于SiamRPN和SiamRPN++等方法,该算法框架是无锚的,因此它能够避免锚的超参数调节并且减少人为的干预。

图11 孪生网络跟踪框架

目标跟踪网络的训练样本数据一直都是影响其性能的关键因素之一,即使通过大规模的训练数据集,也无法覆盖所有情况,正样本仍然单一。针对这一问题,2018年,国内安徽大学X. Wang等人提出了一种基于对抗学习的视觉跟踪正样本生成方法[54]。该算法引入正样本生成网络,通过遍历所构造的目标对象来抽取大量不同的训练数据生成多种目标物体图像,丰富了训练集,从而增强了跟踪算法的鲁棒性。同年,国内腾讯人工智能实验室Y. Song等人利用对抗性学习,通过生成网络来随机生成掩膜,这些掩膜应用于自适应随机特征输入,以捕获各种外观变化,再通过对抗性学习,使网络识别出在一个较长时间跨度内保持目标对象最健壮特征的掩码,并使用高阶代价敏感损失算法处理类别不平衡的问题,以减少负样本的影响,方便分类网络训练[55],其对抗生成网络如图12所示。

图12 对抗生成网络框架

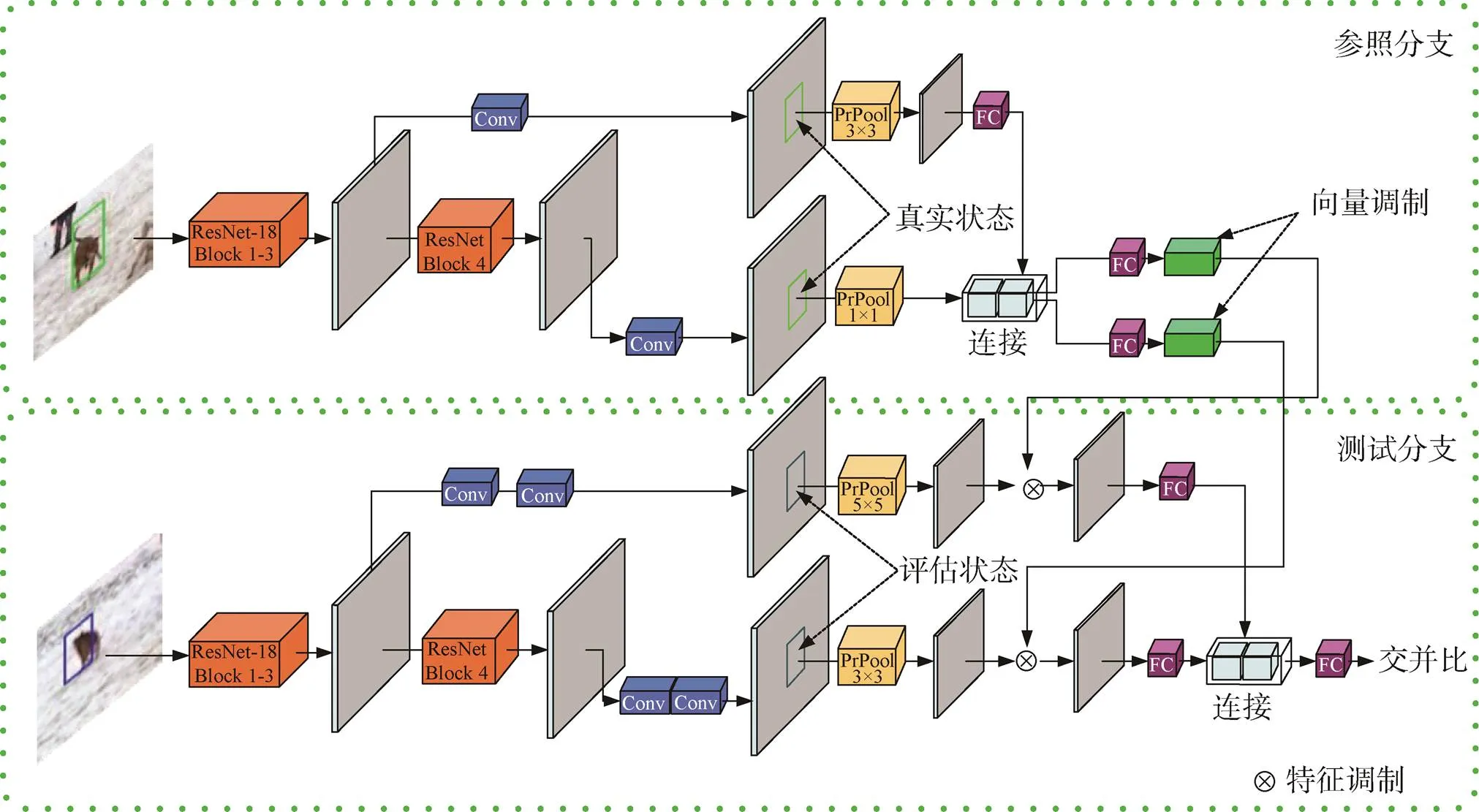

现有跟踪网络大多采用简单的多尺度搜索(对目标可能出现的有限种不同尺度进行搜索)来估计目标跟踪窗的宽高,该方法不能精准预测目标的状态。针对该问题,2019年,瑞典林雪平大学M. Danelljan等人提出了一种新的跟踪体系结构[56],该结构包括目标估计和分类组件,目标估计部分预测目标与估计跟踪窗之间的重叠,通过整合特定目标信息,实现了较好的跟踪窗精度。该算法针对存在干扰物体的情况,引入在线训练分类组件,能够保证较高的分类能力,算法跟踪框图如图13所示。2020年,瑞士苏黎世联邦理工学院M. Danelljan等人在ATOM算法的基础上,提出了一个概率回归公式[57],并将其应用于目标跟踪,用于预测输入图像目标状态的条件概率密度,能够对任务中不准确的注释产生的噪音建模,采用最小化Kullback-Leibler散度训练回归网络,将概率回归公式应用于跟踪,大大提升了算法的性能。

图13 文献[56]提出的新跟踪体系框架

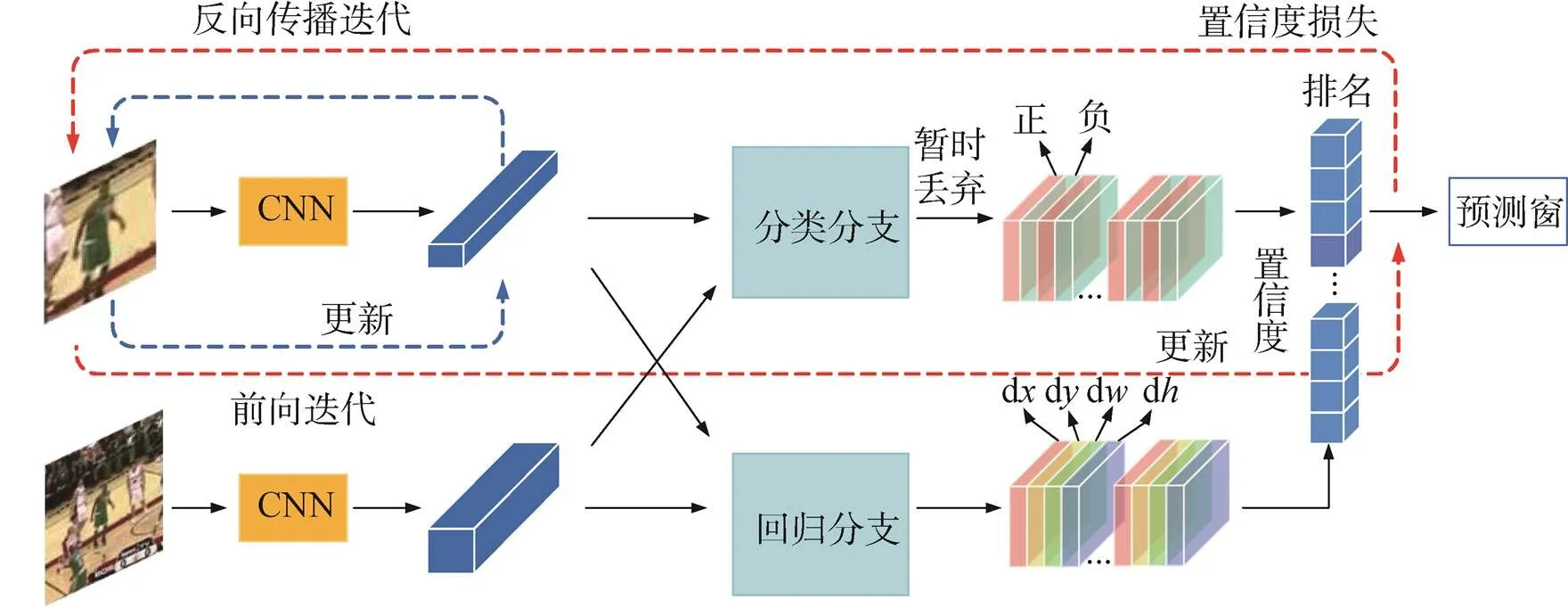

对于目标跟踪,通常跟踪目标类别的先验信息无法得知,跟踪算法也有被攻击的潜在风险。为了引起人们对跟踪风险的更多关注,2020年,北京大学X. Chen等人研究了对抗性攻击的跟踪算法,提出了一次性对抗攻击算法[58]。该方法只需在初始帧中的目标补丁上加入微小的扰动,就可以使跟踪器在后续帧中丢失目标。该攻击方法由两部分组成,并利用了双重注意机制:第一部分采用有针对性的攻击策略,优化处理置信度损失;第二部分采用一般的扰动策略,优化特征损失,跟踪框架如图14所示。

图14 面向对抗性攻击跟踪网络框架

全网络自适应目标跟踪算法在目标跟踪方面呈现出较高的精确性及鲁棒性,并随着计算机硬件技术的发展,算法的效率也在不断提高,因此吸引了研究人员广泛关注。

4.2 卷积滤波融合目标跟踪

与全网络自适应目标跟踪算法相类似,卷积滤波融合目标跟踪算法主要专注目标观测模型。两者之间的主要区别在于:卷积滤波融合目标跟踪算法在卷积神经网络之后引入相关滤波器,将滤波器作为网络的一层,然后再进行目标状态估计与模型更新。

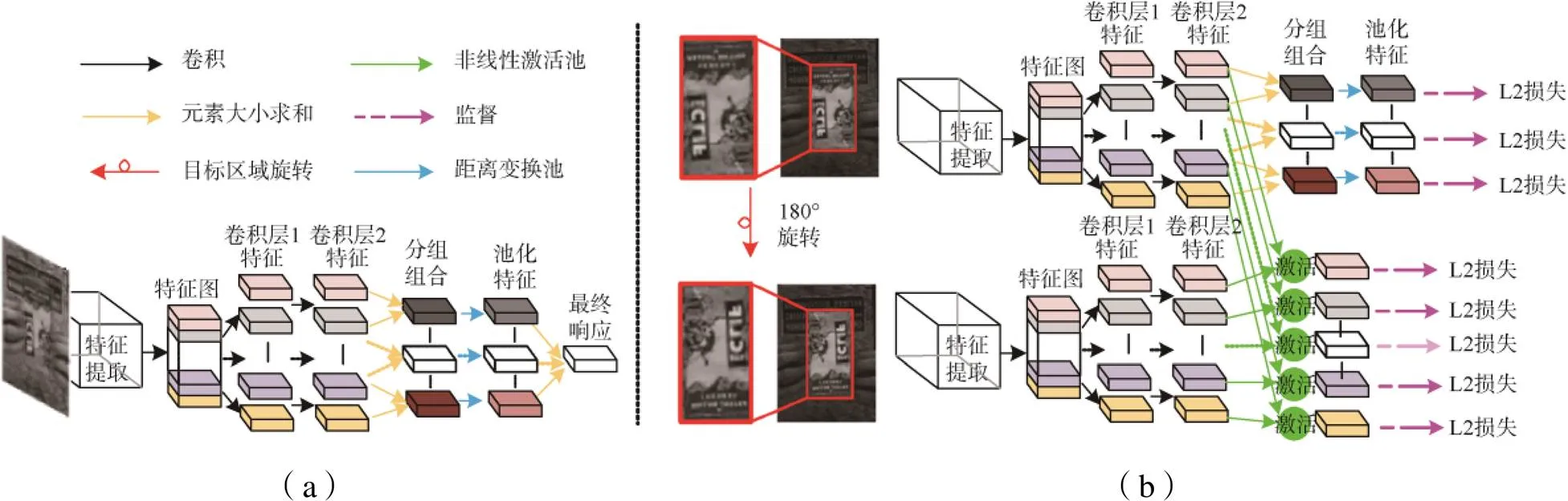

卷积滤波融合目标跟踪指的是:通过卷积神经网络提取特征并结合相关滤波在线学习能力的目标跟踪方法。2016年,瑞典林雪平大学M. Danelljan等人在提取目标特征时使用深度卷积神经网络,将不同分辨率的特征图使用立方插值方法插值到连续空间域,最终的目标位置通过Hessian矩阵求得,提出了连续卷积跟踪算法[46]。2017年,该作者提出有效卷积算法[59]作为连续卷积跟踪算法的进一步改进,它通过分解卷积算子显著减少了模型参数,并通过生成样本空间模型保持样本的多样性并减少其数量,提高了时间和空间效率。2018年,大连理工大学Chong Sun等人提出了基于互补回归的目标跟踪算法[60],该算法采用核化岭回归模型以及具有空间规则的全卷积神经网络模型,通过距离变换池来确定每个输出通道的有效性,最后结合核化岭回归模型和全卷积神经网络模型,获得最终响应。该算法的网络结构如图15所示[60],其中(a)为测试网络,(b)为训练网络。

图15 互补回归的目标跟踪算法网络结构

早期孪生网络滤波跟踪算法只将初始帧与后续帧进行匹配,并未考虑跟踪过程中目标的变化。针对该问题,英国牛津大学J. Valmadre等人于2017年将相关滤波器引入孪生网络跟踪框架中,提出了基于相关滤波跟踪器的端到端学习算法[61],其网络体系结构如图16所示。通过将相关滤波作为网络的一个可微训练层,实现了相关滤波在线学习能力与卷积神经网络的特征提取能力相结合完成端到端的训练。该方法采用了非对称的孪生网络结构,对两个输入图像采用相同的卷积特征变换,然后利用线性模板和交叉关系搜索测试图像。2018年,中国科学院Z. Zhu等人针对卷积相关滤波器大多只考虑当前帧的外观特征,很难从运动和帧间信息中获得有效信息这一问题,提出了一种高跟踪精度的流跟踪算法[62]。该算法在孪生网络框架中联合训练过程以及跟踪任务,将历史特征图与当前特征图按照设置时间间隔进行聚合。2019年,中国科学院Ning Wang等人使用孪生网络相关滤波网络框架,提出了一种无监督目标跟踪方法[63],其卷积神经网络模型在无监督学习的方式下使用未标记的原始视频进行训练,并使用多帧验证方法以及成本敏感损失来促进无监督学习。

图16 基于相关滤波跟踪器端到端学习算法网络结构

在卷积滤波融合目标跟踪算法中,大多数算法都没有充分挖掘多种特征之间的联系以及这些特征的强度。针对该问题,中国科学院N. Wang等人于2018年提出了一种有效的多线索分析框架跟踪算法[64]。该算法通过组合不同类型的特征,利用相关滤波器构造多个独立跟踪目标的专家,通过相关的评估策略,选择合适的专家进行各帧跟踪。2019年,大连理工大学Y. Sun等人利用目标感兴趣区域组合方法,提出了一种目标跟踪相关滤波算法[65],该算法通过学习滤波器加权约束,可以等价地实现感兴趣区域的权重分配,从而使感兴趣区域的权重分配在虚拟循环样本上成为可能。

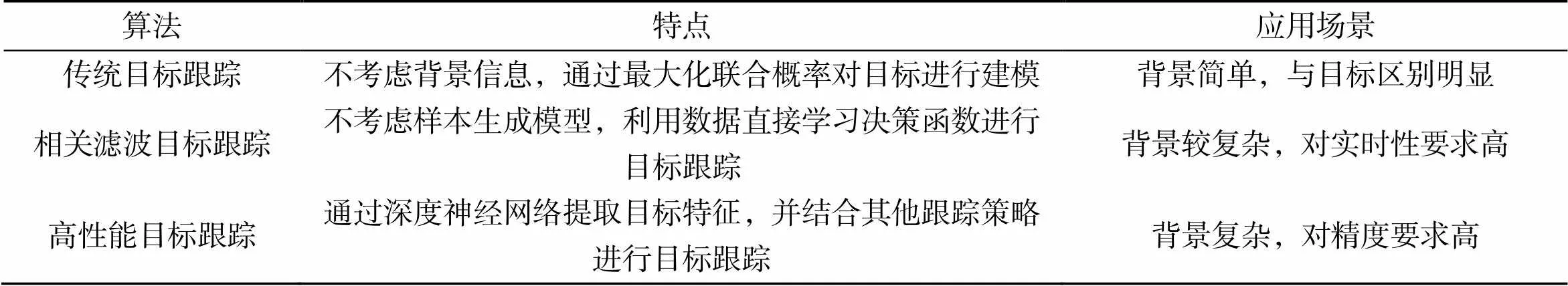

高性能目标跟踪算法将深度学习与相关滤波相互结合,继承了两种方法的优点,能够实现良好的跟踪性能,表3给出了高性能目标跟踪算法特点及应用场景总结。

表3 高性能目标跟踪算法特点及应用场景

5 面向不同波段目标跟踪技术应用

目标跟踪技术在不同领域的应用前景十分广泛,例如在军事领域,目标跟踪可用于战时的空中远程预警、隐形飞机跟踪和反导防御等系统。而在民用领域,目标跟踪技术在无人驾驶和安防等领域得到了广泛应用,尤其是在基于可见光图像的目标跟踪技术方面,如行人和车辆跟踪技术等,相对较为成熟且投入应用。针对各波段特点,国内外研究人员将目标跟踪算法应用到不同波段,并结合各波段成像特点进行优化,提出了适用于本波段的目标跟踪算法。其中,面向红外和毫米波等不同波段的目标跟踪技术成为研究热点。

5.1 红外目标跟踪

5.1.1 红外点目标

当目标距离较远时,红外成像系统中目标辐射能量大幅度减弱,目标在红外图像中通常占较少的像素形成点目标。点目标几乎没有形状以及纹理信息,只包含灰度信息,因此需要采用合适的目标跟踪算法对红外点目标进行跟踪。2009年,海军工程大学闵祥龙等人[66]利用两级流水管道实现对红外图像的二值分割,然后对目标点利用第三级目标检测管道进行搜索并实现准确定位,从而实现了可靠红外点目标跟踪。2011年,92941部队李晓冰等人[67]通过分析测量图像的特点,利用Hough变换对噪声的不敏感性,提出了基于Hough变换的红外点目标跟踪算法。2015年,西北工业大学李少毅等人[68]针对干扰环境下点目标跟踪问题,将背景和前景通过自适应压缩背景差分法进行分离,使用Hadamard矩阵对红外压缩成像系统进行重建,目标位置通过压缩前景信息中解码得出,最后结合卡尔曼滤波算法以及数据关联实现点目标跟踪。2019年,新疆大学武文成等人[69]对红外点目标的特征进行研究,在跟踪过程中通过调整目标分类器,提出了一种具有较强鲁棒性的在线集成学习红外点目标跟踪算法。

5.1.2 红外图像目标跟踪

与光学图像相比,红外图像虽然无法提供足够的细节和纹理信息,但其不受光照影响,能够在光照条件很差的环境下对目标进行跟踪。2007年,华中科技大学高璐等人[70]将运动模型估计视为函数估计,使用支持向量机对当前运动模型进行估计,采用卡尔曼滤波算法,实现了对红外图像动态目标自适应跟踪。同年,哈尔滨工程大学王卓等人[71]针对灰度图像特征贫乏、噪声不易抑制等问题,通过降低红外图像的分辨率,实现了对红外图像目标的有效跟踪。2009年,北京理工大学付梦印等人[72]采用多模式跟踪,针对具体的目标,使用自适应波门确定不同模式的跟踪,并结合互信息测度方法,实现了红外图像相关匹配跟踪。2010年,北京理工大学李玉珏等人[73]利用点特征的空间不变性以及灰度特征的易用性,解决了单一特征易受噪声干扰以及实时性较差等方面的不足,提出了红外目标图像的复合特征跟踪算法。2017年,海军航空工程学院王杰等人[74]根据红外图像的特点,提出了在均值漂移跟踪框架下,将颜色特征和梯度特征相结合的基于多特征直方图红外图像目标跟踪算法。2019年,南京理工大学刘辉等人[75]通过对后续帧图像自适应分割,利用决策筛选出真实目标,更新动态决策准则,采用多特征融合以及感兴趣区域预测实现对红外目标的跟踪。

红外目标跟踪具有抗干扰能力强、支持全天候工作等特点[76],能够在复杂环境下提供比可见光图像更稳定的跟踪性能,但红外图像信噪比以及分辨率低[77],太深的网络层结构会使深度特征最终映射成一个像素点。因此,如何更有效地进行特征提取并对不同的特征采用不同融合策略实现目标跟踪,是红外图像目标跟踪亟待解决的一大问题。

5.2 毫米波图像目标跟踪

与光学、红外图像不同,毫米波电磁波频段的特殊性使其成像边缘通常携带较多的热噪声,造成图像边缘模糊。目前,面向毫米波图像目标跟踪的研究主要聚焦于无源毫米波图像目标跟踪。2012年,电子科技大学毛林军[78]采用卡尔曼滤波法进行目标跟踪,使用方向加权目标关联与延迟判定的轨迹管理策略,减少了关联错误的发生,并且在遮挡造成目标暂时丢失的情况下,还能够对目标实现跟踪。2014年,电子科技大学张越[79]提出了基于卡尔曼滤波估计目标位置、尺度的目标跟踪算法。2015年,电子科技大学孙永贺[80]使用最近邻数据关联算法对观测数据进行关联,然后利用卡尔曼滤波法对隐匿目标进行跟踪。2016年,电子科技大学江攀[81]使用多特征压缩跟踪算法,通过多个决策树弱分类器组成随机森林强分类器,引入随机采样来减少模型对噪声的敏感性,提出了基于在线随机森林的压缩跟踪算法。2017年,电子科技大学毛靖琦[82]利用判别式跟踪算法框架,提出了基于循环矩阵的快速跟踪算法,采用HOG特征描述目标,使用优化后的线性分类器快速训练及更新,再经过循环测试样本采集、样本特征提取、样本分类器快速响应计算,最后根据响应预测结果。

5.3 太赫兹目标跟踪

太赫兹频段位于微波频段向光学频段的过渡区域,与毫米波高频段、红外低频段相重合[83]。与可见光频段相比,太赫兹频段良好的穿透特性特别适合目标成像,这一特性为目标跟踪提供潜在的优势。而与微波频段相比较,太赫兹波段高频率、窄波束和大时宽特别适合目标检测和跟踪。太赫兹目标跟踪具有高频毫米波和低频红外的双重优点,其成像能够提供比毫米波成像更高的分辨率,并保持安全、高效、高穿透的优势,高效太赫兹图像目标跟踪技术能够为航天国防事业提供更先进的航空监控技术,是新一代航天技术发展的重要战略方向,然而目前关于太赫兹图像跟踪技术少有报道。

与可见光学图像、红外及毫米波图像目标跟踪所不同,太赫兹目标跟踪存在以下几个难点:背景环境噪声复杂、目标状态变化以及运动过程中的遮挡等问题。除此之外,在太赫兹图像中,由于成像系统的限制,图像的分辨率相比于光学图像较低,图像比较模糊,因此目标在图像中的信息较少,这就使得太赫兹图像目标更容易受到背景噪声的干扰。除了上述难点外,设计鲁棒性高且实时性好的跟踪技术仍然是目前太赫兹目标跟踪的共性难题。目前,太赫兹目标跟踪相关研究还处在初步发展阶段。2018年,电子科技大学齐竟熊等人[84]在半监督框架下,提出了基于半监督框架的太赫兹图像目标跟踪算法,根据目标的初始位置信息,对无标签数据进行标定以增加学习样本量,从空间和形态两方面对目标位置进行有效预测。2021年,中国科学院Li Hongwei等人提出了太赫兹目标跟踪算法[85],该算法首先对目标的几何中心进行跟踪,然后利用角闪烁与归一化幅度方差之间存在的统计相关性,识别和排除不稳定散射体,建立了雷达异常测角的非线性鉴角函数,在此基础上,提出了一种结合不稳定点剔除和非线性角度辨别的改进型跟踪方法,能够抑制角闪烁和减小测量扰动。

相比红外、毫米波图像目标跟踪研究成果,目前太赫兹图像目标跟踪算法极少。针对太赫兹目标跟踪存在的难点,可以预计,当目标距离成像系统较远,在太赫兹成像系统中呈现点目标时,目标只有灰度信息,此时,红外点目标跟踪算法提供了有效的跟踪思路,其中目标的运动状态以及前后帧之间的联系是一大关键,而如何结合特征提取网络实现对太赫兹点目标的跟踪是未来研究的重点。此外,当目标具有多个测量值时,扩展目标跟踪提供了有效的跟踪思路,如何对多个量测进行有效的数据关联匹配并建模是亟待解决的问题;另一方面,面对太赫兹图像目标所具有的灰度信息以及纹理、形状等信息,可以借助于光学以及毫米波目标跟踪算法,其中有效的特征提取器并对特征进行相应的融合成为一大关键。

5.4 多波段融合目标跟踪

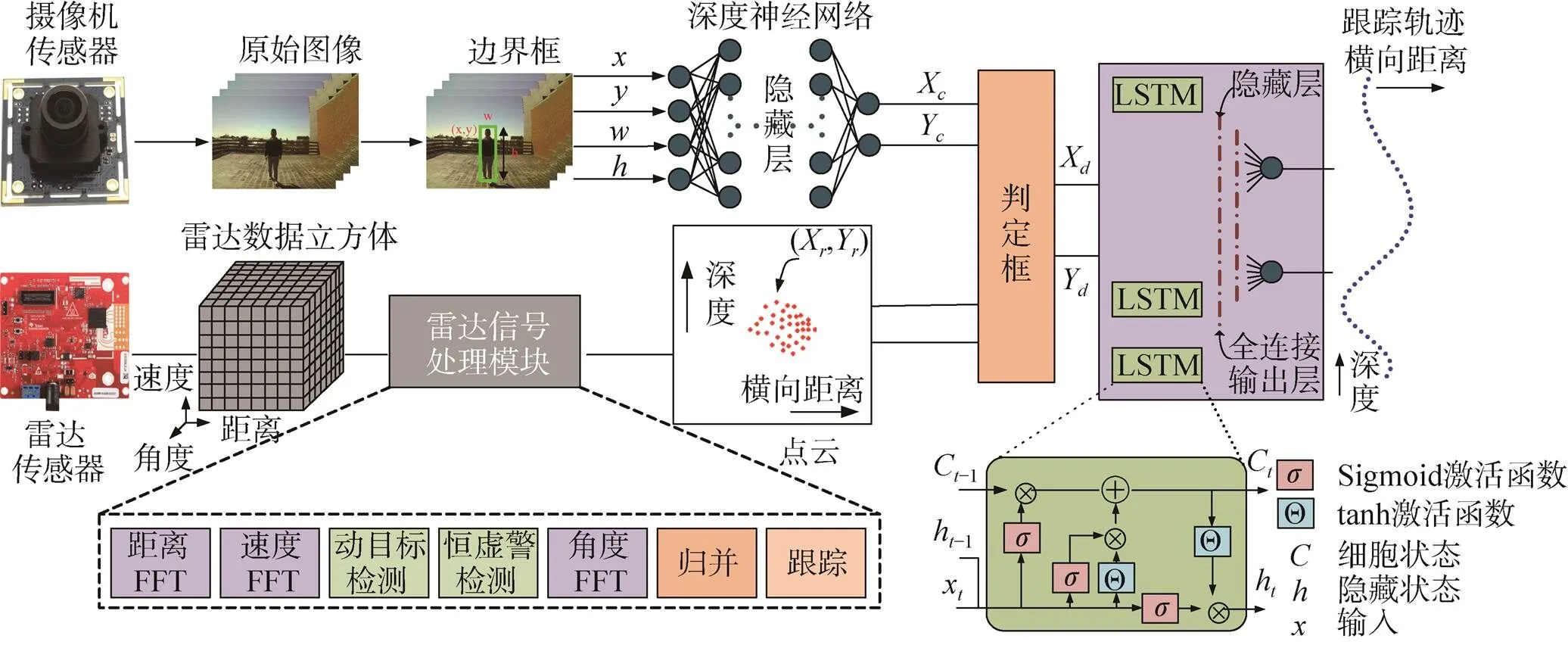

多波段融合目标跟踪技术通过对不同波段跟踪结果相融合,有效增加跟踪的准确性和鲁棒性。2006年,空军工程大学王飞等人基于传统复合跟踪框架,首先对目标在空间上进行配准,再对目标进行跟踪,然后计算每一帧跟踪窗中心与目标中心之间的偏移量,最终通过偏移量得出跟踪结果[86]。2007年,西安电子科技大学张婷等人采用粒子滤波算法,根据毫米波以及红外雷达不同数据的特征,并针对在数据融合中时间和空间不匹配问题进行配准校正,对毫米波方位以及距离信息和红外角度信息进行数据融合[87]。2010年,海军航空工程学院李相平等人在简单加权以及互协方差航迹融合的基础上,针对两种不同传感器的情况,根据系统反馈,提出了一种能够提高系统抗干扰能力的融合跟踪算法[88]。2013年,电子科技大学李琢[89]提出了基于贝叶斯准则的目标重合概率分析融合算法,通过计算目标区域重合部分的概率,将目标进行归类判决,以判决结果为依据得到融合结果,使目标跟踪的结果更加精确。2019年,美国亚利桑那州大学A. Sengupta等人提出了一种基于深层神经网络和长短期内存网络的摄像机与毫米波雷达传感器融合算法[90],该算法使用决策框架,能够在任何一个传感器失败时产生可靠的输出,算法融合框架如图17所示。同年,美国亚利桑那州大学R. Zhang等人提出了一种能够将毫米波雷达目标信息与相机图像目标信息融合的新系统[91],该系统考虑了来自不同传感器坐标系的误差界限,利用扩展卡尔曼滤波器来适应不同的传感器。重庆大学姜雨含等人于2019年提出了基于图像视觉信息和毫米波雷达信息的融合算法[92],建立图像视觉信息和毫米波雷达信息融合算法框架,通过统一传感器采样时刻、坐标系之间的变换以及对相机进行标定,实现图像视觉信息和毫米波雷达信息在时空上的信息融合。2020年,重庆大学提出了基于毫米波雷达和视觉融合的夜间目标检测和跟踪方法[93],通过毫米波雷达和相机获取和处理原始数据和图像,获得目标航迹并进行匹配。同年,重庆大学张翔等人通过内外参数标定实现毫米波雷达与像素之间的坐标转换,完成不同传感器的时间配准,再利用毫米波雷达测得目标运动学参数,修正视觉跟踪窗尺寸,实现了毫米波雷达与图像的信息融合目标跟踪[94]。2021年,合肥工业大学胡延平等人提出核相关滤波结合卡尔曼滤波目标跟踪算法,通过利用对称检测算法以及雷达干扰剔除算法,对目标运动过程中出现的遮挡、快速运动、方向改变等情况进行处理,有效提高了目标跟踪的精度[95]。

图17 融合长短期内存网络的深层神经网络结构

6 结束语

本文首先回顾了目标跟踪算法的发展历程,给出了目标跟踪的一般流程,并重点研究了传统目标跟踪算法,相关滤波目标跟踪算法和高性能目标跟踪算法,表4给出了不同目标跟踪算法的特点及应用场景。在此基础上,分别对红外、毫米波和太赫兹波段以及多波段融合目标跟踪技术进行综述,通过对不同波段图像目标跟踪技术分析,并结合多波段融合目标跟踪技术,无疑对多波段成像系统稳定鲁棒目标跟踪具有重要的研究意义和参考价值。

表4 目标跟踪算法特点及应用场景

[1] 赵春梅, 陈忠碧, 张建林. 基于深度学习的飞机目标跟踪应用研究[J]. 光电工程, 2019, 46(9): 1–10.

ZHAO Chunmei, CHEN Zhongbi, ZHANG Jianlin. Application of aircraft target tracking based on deep learning[J]. Opto-Electronic Engineering, 2019, 46(9): 1–10.

[2] 张远, 吴昊. 临近空间目标运动建模与跟踪方法研究[J]. 火控雷达技术, 2013, 42(4): 22–27.

ZHANG Yuan, WU Hao. Study on modeling of near-space moving targets and its tracking algorithm[J]. Fire Control Radar Technology, 2013, 42(4): 22–27.

[3] 盛卫东. 天基光学监视系统目标跟踪技术研究[D].长沙: 国防科学技术大学, 2011.

[4] 汪鸿翔, 柳培忠, 骆炎民, 等. 单目标跟踪算法综述[J]. 海峡科学, 2016 (7): 28–32.

WANG Hongxiang, LIU Peizhong, LUO Yanmin, et al. A survey of single object tracking[J]. Straits Science, 2016 (7): 28–32.

[5] 刘钢, 刘明, 匡海鹏, 等. 多目标跟踪方法综述[J]. 电光与控制, 2004, 11(3): 26–29, 39.

LIU Gang, LIU Ming, KUANG Haipeng, et al. Survey on multi-target tracking method[J]. Electronics Optics & Control, 2004, 11(3): 26–29, 39.

[6] 李磊. 视觉目标长期跟踪算法研究[D]. 西安: 西安电子科技大学, 2018.

[7] 丁正彤, 徐磊, 张研, 等. RGB-T目标跟踪综述[J]. 南京信息工程大学学报, 2019, 11(6): 690–697.

DING Zhengtong, XU Lei, ZHANG Yan, et al. A survey of RGB-T object tracking[J]. Journal of Nanjing University of Information Science & Technology, 2019, 11(6): 690–697.

[8] 王硕, 张奕群, 孙冰岩. 红外点目标跟踪方法综述[J]. 现代防御技术, 2016, 44(2): 124–134.

WANG Shuo, ZHANG Yiqun, SUN Bingyan. Review of point target tracking methods based on infrared sensor[J]. Modern Defense Technology, 2016, 44(2): 124–134.

[9] 武江涛. 雷达扩展目标跟踪算法研究[D]. 西安: 西安电子科技大学, 2014.

[10] YAN L C, YOSHUA B, GEOFFREY H. Deep learning[J]. Nature, 2015 , 521: 436–444.

[11] Wang N, Shi J, Yeung D, et al. Understanding and diagnosing visual tracking systems[C]//2015 IEEE International Conference on Computer Vision (ICCV), 2015, 3101–3109.

[12] 朱文青, 刘艳, 卞乐,等. 基于生成式模型的目标跟踪方法综述[J]. 微处理机, 2017, 38(1): 41–47.

ZHU Wenqing, LIU Yan, BIAN Le, et al. Survey on object tracking method base on generative model[J]. Microprocessors, 2017, 38(1): 41–47.

[13] Kalman R E. A new approach to linear filtering and prediction problems[J]. Transactions of the ASME-Journal of Basic Engineering, 1960, 82(Series D): 35–45.

[14] Sunahara Y, OhsumiA. An approximate method of stochastic terminal control for nonlinear dynamical systems[J]. Journal of the Franklin Institute, 1970, 289(3): 205–222.

[15] Bucy R S,Senne K D. Digital synthesis of non-linear filters[J]. Automatica, 1971, 7(3): 287–298.

[16] Reif K, Gunther S, Yaz E, et al. Stochastic stability of the discrete-time extended Kalman filter[J]. IEEE Transactions on Automatic Control, 1999, 44(4): 714–728.

[17] Uhlmann J K. Simultaneous map building and localization for real time applications[R]. University of Oxford, 1994.

[18] Julier S J, Uhlmann J K.New extension of the Kalman filter to nonlinear systems[C]//Signal Processing, Sensor Fusion, and Target Recognition VI: International Society for Optics and Photonics, 1997, 3068: 182–193.

[19] Arasaratnam I, Haykin S. Cubature Kalman filters[J]. IEEE Transactions on Automatic Control, 2009, 54(6): 1254–1269.

[20] Nummiaro K, Koller-Meier E, VAN Gool L. An adaptive color-based particle filter[J]. Image and Vision Computing, 2003, 21(1): 99–110.

[21] Mei X, Ling H. Robust visual tracking using L1 minimization[C]//2009 IEEE 12th International Conference on Computer Vision, 2009: 1436–1443.

[22] Bao C, Wu Y, Ling H, et al. Real time robust L1 tracker using accelerated proximal gradient approach[C]//2012 IEEE Conference on Computer Vision and Pattern Recognition, 2012: 1830–1837.

[23] Zhang T, Ghanem B, LiuS, et al. Robust visual tracking via multi-task sparse learning[C]//2012 IEEE Conference on Computer Vision and Pattern Recognition. 2012: 2042–2049.

[24] Mei X, Ling H, WU Y, et al. Efficient minimum error bounded particle resampling L1 tracker with occlusion detection[J]. IEEE Transactions on Image Processing, 2013, 22(7): 2661–2675.

[25] Comaniciu D, Ramesh V, Meer P. Real-time tracking of non-rigid objects using mean shift[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR 2000, Cat. No. PR00662), 2000, 2: 142–149.

[26] KaewTraKulPong P, Bowden R. An improved adaptive background mixture model for real-time tracking with shadow detection[M]//Video-based surveillance systems. Boston: Springer, 2002: 135–144.

[27] Ross D, Lim J, Yang M H. Adaptive probabilistic visual tracking with incremental subspace update[C]//European Conference on Computer Vision. Berlin, Heidelberg: Springer, 2004: 470–482.

[28] Tuzel O, Porikli F, Meer P. A bayesian approach to background modeling[C]//2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'05)-Workshops. IEEE, 2005: 58–58.

[29] Prince S J. Computer vision: models, learning, and inference[M].: Cambridge University Press, 2012.

[30] CHEN Z, Hong Z, Tao D.An experimental survey on correlation filter-based tracking[J]. arXiv preprint arXiv: 2015, 1509.05520.

[31] Ojala T, Pietikainen M, Harwood D. Performance evaluation of texture measures with classification based on Kullback discrimination of distributions[C]//Proceedings of 12th International Conference on Pattern Recognition, IEEE, 1994, 1: 582–585.

[32] Papageorgiou C P, Oren M, Poggio T. A general framework for object detection[C]//Sixth International Conference on Computer Vision (IEEE Cat. No. 98CH36271), IEEE, 1998: 555–562.

[33] Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]//2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'05), IEEE, 2005, 1: 886–893.

[34] Bolme D S, Beveridge J R, Draper B A, et al. Visual object tracking using adaptive correlation filters[C]//2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, IEEE, 2010: 2544–2550.

[35] Martins P, Henriques J, Caseiro R, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//European Conference on Computer Vision. Berlin, Heidelberg: Springer, 2012: 702–715.

[36] Henriques J F, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 37(3): 583–596.

[37] Danelljan M, Khan F S, Felsberg M, et al. Adaptive color attributes for real-time visual tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1090–1097.

[38] Danelljan M, Hager G, Khan F S, et al. Accurate scale estimation for robust visual tracking[C]//British Machine Vision Conference, Nottingham, September 1-5, 2014. Bmva Press, 2014.

[39] Danelljan M, Häger G, Khan F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 39(8): 1561–1575.

[40] LI Y,Zhu J. A scale adaptive kernel correlation filter tracker with feature integration[C]//European Conference on Computer Vision. Cham: Springer, 2014: 254–265.

[41] Bertinetto L, Valmadre J, Golodetz S, et al. Staple: Complementary learners for real-time tracking[C]// Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016: 1401–1409.

[42] Mueller M, Smith N, Ghanem B. Context-aware correlation filter tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 1396–1404.

[43] Danelljan M, Häger G, Shahbaz Khan F, et al.Learning spatially regularized correlation filters for visual tracking[C]//Proceedings of the IEEE International Conference on Computer Vision. 2015: 4310–4318.

[44] Gundogdu E, Alatan AA. Spatial windowing for correlation filter based visual tracking[C]//2016 IEEE International Conference on Image Processing (ICIP), IEEE, 2016: 1684–1688.

[45] Hong S, You T, Kwak S, et al. Online tracking by learning discriminative saliency map with convolutional neural network[C]//International Conference on Machine Learning. PMLR, 2015: 597–606.

[46] Danelljan M, et al. Beyond correlation filters: Learning continuous convolution operators for visual tracking[C]// European Conference on Computer Vision. Cham: Springer, 2016: 472–488.

[47] Nam H, Han B. Learning multi-domain convolutional neural networks for visual tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4293–4302.

[48] Han B, Sim J, Adam H. Branchout: Regularization for online ensemble tracking with convolutional neural networks[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 3356–3365.

[49] Bertinetto L, Valmadre J, Henriques J F, et al. Fully-convolutional siamese networks for object tracking[C]// European Conference on Computer Vision. Cham: Springer, 2016: 850–865.

[50] LI B, YAN J, WU W, et al. High performance visual tracking with Siamese region proposal network [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2018: 8971–8980.

[51] LI B, YAN J, WU W, et al. Siamrpn++: Evolution of siamese visual tracking with very deep networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 4282–4291.

[52] Chen Z, Zhong B, Li G, et al. Siamese box adaptive network for visual tracking[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 6668–6677.

[53] Guo D, Wang J, Cui Y, et al. SiamCAR: Siamese fully convolutional classification and regression for visual tracking[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 6269–6277.

[54] Wang X, Li C, Luo B, et al. Robust visual tracking via adversarial positive instance generation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 4864–4873.

[55] Song Y et al. Vital: Visual tracking via adversarial learning[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 8990–8999.

[56] Danelljan M, Bhat G, Shahbaz Khan F, et al. Atom: Accurate tracking by overlap maximization[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 4660–4669.

[57] Danelljan M, Gool L V, Timofte R. Probabilistic regression for visual tracking[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 7183–7192.

[58] CHEN X, YAN X, ZHENG F, et al. One-shot adversarial attacks on visual tracking with dual attention[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2020: 10176–10185.

[59] Danelljan M, Bhat G, Shahbaz Khan F, et al. Eco: Efficient convolution operators for tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 6638–6646.

[60] Sun C, Wang D, Lu H, et al. Learning spatial-aware regressions for visual tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 8962–8970.

[61] Valmadre J, Bertinetto L,Henriques J, et al. End-to-end representation learning for correlation filter based tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 2805–2813.

[62] Zhu Z, Wu W, Zou W,et al. End-to-end flow correlation tracking with spatial-temporal attention[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 548–557.

[63] Wang N, Song Y, Ma C, et al. Unsupervised deep tracking[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 1308–1317.

[64] Wang N, Zhou W, Tian Q, et al. Multi-cue correlation filters for robust visual tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018: 4844–4853.

[65] Sun Y, Sun C, Wang D, et al. Roi pooled correlation filters for visual tracking[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 5783–5791.

[66] 闵祥龙, 王江安, 高翔. 三级管道流水线算法实现红外点目标跟踪[J]. 光电工程, 2009, 36(2): 23–28.

MIN Xianglong, WANG Jiangan, GAO Xiang. Algorithm of the triple pipeline for actualizing IR point target tracking[J]. Opto-Electronic Engineering, 2009, 36(2): 23–28.

[67] 李晓冰, 赵满庆, 张宏艺. 基于Hough变换的红外序列图像点目标跟踪方法[J]. 红外, 2011, 32(10): 27–29,34.

LI Xiaobing, ZHAO Manqing, ZHANG Hongyi. Hough transform-based method for tracking point target in infrared sequence images[J]. Infrared, 2011, 32(10): 27–29,34.

[68] 李少毅, 梁爽, 张凯,等. 基于红外压缩成像的点目标跟踪方法研究[J]. 电子与信息学报, 2015(7): 1739–1745.

LI Shaoyi, LIANG Shuang, ZHANG Kai, et al. Research of infrared compressive imaging based point target tracking method[J]. Journal of Electronics & Information Technology, 2015(7): 1739–1745.

[69] 武文成, 艾斯卡尔·艾木都拉. 基于在线集成学习的红外点目标跟踪研究[J]. 山西大学学报(自然科学版), 2019, 42(4): 755–761.

WU Wencheng, AIMUDULA Aisikaer. Infrared small target tracking algorithm based on online ensemble learning[J]. Journal of Shanxi University(Natural Science Edition), 2019, 42(4): 755–761.

[70] 高璐, 张大志, 田金文. 红外序列图像目标跟踪的自适应Kalman滤波方法[J]. 红外与激光工程, 2007, 36(5): 729–732, 757.

GAO Lu, ZHANG Dazhi, TIAN Jinwen. Moving object tracking based on adaptive Kalman filter[J]. Infrared and Laser Engineering, 2007, 36(5): 729–732, 757.

[71] 王卓, 焦淑红, 邓磊. 基于降低图像分辨率的红外目标跟踪方法[J]. 应用科技, 2007, 34(3): 54–56.

WANG Zhuo, JIAO Shuhong, DENG Lei. Infrared target tracking algorithm based on reduced resolution[J]. Applied Science and Technology, 2007, 34(3): 54–56.

[72] 付梦印, 刘羿彤. 基于互信息测度红外目标图像相关匹配跟踪算法[J]. 兵工学报, 2009, 30(3): 371–374.

FU Mengyin, LIU Yitong. Infrared image object tracking based on multi-pattern algorithm[J]. Acta Armamentarii, 2009, 30(3): 371–374.

[73] 李玉珏, 王军力, 颜景龙. 红外目标图像的复合特征跟踪算法[J]. 弹箭与制导学报, 2010, 30(6): 17–18, 22.

LI Yujue, WANG Junli, YAN Jinglong. Infrared target image tracking algorithm based on composite features[J]. Journal of Projectiles, Rockets, Missiles and Guidance, 2010, 30(6): 17–18, 22.

[74] 王杰, 孙艳丽, 周伟. 基于多特征直方图的红外图像目标跟踪[J]. 四川兵工学报, 2017, 38(8): 103–106.

WANG Jie, SUN Yanli, ZHOU Wei. Target tracking in infrared image based on multi-feature histogram algorithm[J]. Journal of Ordnance Equipment Engineering, 2017, 38(8): 103–106.

[75] Hui L, Yong H, HE B, et al. Infrared target tracking algorithm based on multiple feature fusion and region of interest prediction[J]. Acta Photonica Sinica, 2019, 48(7): 0710004.

[76] 胡阳光, 肖明清, 张凯, 等. 传统特征和深度特征融合的红外空中目标跟踪[J]. 系统工程与电子技术, 2019, 41(12): 2675–2683.

HU Yangguang, XIAO Mingqing, ZHANG Kai, et al. Infrared aerial target tracking based on fusion of traditional feature and deep feature[J]. Systems Engineering and Electronics, 2019, 41(12): 2675–2683.

[77] 孙明杰, 周林, 顾金玲, 等. 基于多域网络的红外目标跟踪算法[J]. 系统工程与电子技术, 2021, 43(5): 1176–1183.

SUN Mingjie, ZHOU Lin, GU Jinling, et al. Infrared target tracking algorithm based on multi-domain network[J]. Systems Engineering and Electronics, 2021, 43(5): 1176–1183.

[78] 毛林军. 基于无源毫米波图像序列的目标检测与跟踪算法研究[D]. 成都: 电子科技大学, 2012.

[79] 张越. 无源毫米波图像变尺度目标检测跟踪算法研究与实现[D]. 成都: 电子科技大学, 2014.

[80] 孙永贺. 毫米波无源探测目标多模式检测与跟踪算法研究[D]. 成都: 电子科技大学, 2015.

[81] 江攀. 毫米波无源成像目标跟踪算法研究及实现[D]. 成都: 电子科技大学, 2016.

[82] 毛靖琦. 毫米波无源成像运动目标检测与跟踪算法研究[D]. 成都: 电子科技大学, 2017.

[83] Siegel P H. Terahertz technology[J]. IEEE Transactions on Microwave Theory and Techniques, 2002, 50(3): 910–928.

[84] 齐竟雄. 毫米波及太赫兹无源探测动目标检测跟踪算法研究[D]. 成都: 电子科技大学, 2018.

[85] Li H, Li C, Gao H, et al. Study of moving targets tracking methods for a multi-beam tracking system in terahertz band[J]. IEEE Sensors Journal, 2020, 21(5): 6520–6529.

[86] 王飞, 万少松, 袁华. 红外/毫米波雷达双模导引末状态的目标跟踪算法[J]. 兵工自动化, 2006, 25(10): 5–6, 18.

WANG Fei, WAN Shaosong, YUAN Hua. Target track algorithm based on double-module guided end appearance of infrared/millimeter wave radar[J]. Ordnance Industry Automation, 2006, 25(10): 5–6, 18.

[87] 张婷. 红外/毫米波复合制导数据融合技术研究[D]. 西安: 西安电子科技大学, 2007.

[88] 李相平, 王光复, 谢志敏. 毫米波/红外复合制导目标融合跟踪算法[J]. 制导与引信, 2010, 31(1): 9–13.

LI Xiangping, WANG Guangfu, XIE Zhimin. Target fusion tracking algorithm for millimeter wave and infrared compound guidance[J]. Guidance & Fuze, 2010, 31(1): 9–13.

[89] 李琢. 无源毫米波和视频序列图像目标跟踪算法研究[D]. 成都: 电子科技大学, 2013.

[90] Sengupta A, Jin F, Cao S. A DNN-LSTM based target tracking approach using mmWave radar and camera sensor fusion[C]//2019 IEEE National Aerospace and Electronics Conference (NAECON). IEEE, 2019: 688–693.

[91] Zhang R, Cao S.Extending reliability of mmWave radar tracking and detection via fusion with camera[J]. IEEE Access, 2019, 7: 137065–137079.

[92] 姜雨含. 毫米波雷达和机器视觉融合的前方车辆检测与跟踪算法研究[D]. 重庆: 重庆大学, 2019.

[93] 重庆大学. 基于毫米波雷达和视觉融合的夜间目标检测和跟踪方法: CN202010699523.5[P]. 2020-11-20.

[94] 张翔. 基于毫米波雷达与机器视觉信息融合的道路车辆检测与跟踪算法研究[D]. 重庆: 重庆大学, 2020.

[95] 胡延平, 刘菲, 魏振亚, 等. 毫米波雷达与视觉传感器信息融合的车辆跟踪[J]. 中国机械工程, 2021, 32(18): 2181–2188.

HU Yanping, LIU Fei, WEI Zhenya, et al. Vehicle tracking of information fusion for millimeter-wave radar and vision sensor[J]. China Mechanical Engineering, 2021, 32(18): 2181–2188.

Research on target tracking technology based on deep learning and its multi-band application

LI Wentao1, LI Shiyu1, HUAN Jinxiao1, LI Lei1, ZHANG Zhenhua2, KANG Chen2, LIU Di2, QIAO Haidong2, MOU Jinchao2

(1. State Key Laboratory of Antenna and Microwaves, Xidian University, Xi'an 710071, China; 2. Beijing Research Institute of Telemetry, Beijing, 100076, China)

Target tracking is one of the most challenging topics in computer vision field. Firstly, the development of target tracking technology is reviewed and the general process of target tracking is summarized. Secondly, the advantages and disadvantages of traditional target tracking methods based on Kalman filter and particle filter are analyzed. Thirdly, the fixed window correlation filter target tracking methods and high-performance adaptive full network target tracking methods are successively highlighted. Finally, the applications of target tracking in infrared, millimeter wave and terahertz radiation band are summarized, and multi-band fusion target tracking is forecasted.

Target tracking; Deep learning; Terahertz; Infrared; Millimeter wave

Website: ycyk.brit.com.cn Email: ycyk704@163.com

V556

A

CN11-1780(2022)06-0021-18

10.12347/j.ycyk.20220106001

李文涛, 李世玉, 郇金晓, 等.基于深度学习的目标跟踪技术及其多波段应用研究[J]. 遥测遥控, 2022, 43(6): 21–38.

10.12347/j.ycyk.20220106001

: LI Wentao, LI Shiyu, HUAN Jinxiao, et al. Research on target tracking technology based on deep learning and its multi-band application[J]. Journal of Telemetry, Tracking and Command, 2022, 43(6): 21–38.

中央军委173计划重点项目;北京市科技新星计划(Z201100006820130)

李文涛(wtli@mail.xidian.edu.cn)

2022-01-06

2022-03-16

李文涛 1983年生,博士,副教授,主要研究方向为机器学习、目标跟踪和天线设计。

李世玉 1998年生,硕士研究生,主要研究方向为新体制太赫兹雷达探测跟踪。

郇金晓 1998年生,硕士研究生,主要研究方向为机器学习、目标识别、目标跟踪。

李 磊 1999年生,硕士研究生,主要研究方向为机器学习、目标识别、目标跟踪。

张振华 1977年生,博士,研究员,主要研究方向为雷达与卫星有效载荷技术。

康 忱 1995年生,硕士,助理工程师,主要研究方向为太赫兹成像算法技术。

刘 娣 1994年生,硕士,助理工程师,主要研究方向为太赫兹天伺馈与源技术。

乔海东 1990年生,博士,工程师,主要研究方向为太赫兹探测芯片与微系统技术。

牟进超 1985年生,博士,高级工程师,主要研究方向为太赫兹科学与技术。

(本文编辑:潘三英)