基于混合现实的虚拟指挥协同空间构建与应用

2022-11-16袁泉

袁泉

(中国电子科技集团公司第十五研究所 北京市 100083)

1 引言

元宇宙起源于1992 年发表的科幻小说《雪崩》,书中对其描写为,“戴上耳机和眼镜,连接终端,将能够利用虚拟分身,进入由计算机模拟的,与真实世界平行的赛博空间”[1]。

民用领域,元宇宙发展已从第一阶段仅存在于文学、艺术和宗教的古典形态,经历第二阶段以电子游戏和科幻为载体的新古典形态后,随着区块链[2‐3]、交互技术、电子游戏、人工智能、网络及运算、物联网等领域技术积累,迈入由“非中心化”游戏承载的,具备高度智能化形态的第三阶段[4]。

元宇宙的技术发展目前仍处于完善阶段,埃森哲发布的《技术展望2022》中指出,虚实共生、编码世界、未来网络、无限算力四个方向将共同构成元宇宙基石[5]。元宇宙应用场景要从概念到真实落地,仍需要实现两个突破:XR、数字孪生、区块链等单项技术突破,多项数据技术的综合应用突破[6]。

国内外互联网公司正积极布局,扎伯格将Facebook 更名为Meta,收购6 家VR 公司和游戏工作室,打造基于VR的虚拟居家场景Horizon Home 和虚拟远程办公的Horizon Workrooms 等[7]。腾讯则以社交为核心切入点,如其代理发行《罗布思乐》,就是定位为集体验、开发于一体的多人在线3D 创意社区。

在军事领域,元宇宙的应用发展虽不及民用领域迅速,但其基础技术已被广泛使用。2021 年,美军与微软签订4.8亿美元合同,打造基于混合现实的战略决策、战役规划、战术实施三层协同作战决策与训练系统[8]。2022 年3 月美空军宣布“数字孪生全息实验室”在佛罗里达州廷德尔空军基地建成并启用,该实验室能够以数字模型的形式展示空军基地,使飞行员在虚拟环境中测试各种技术,并将成果转化为可实战的技术[9]。

我军正积极探索利用元宇宙来解决现存问题。传统指挥协同模式受时空、距离限制,存在协同方无法直观交流、协同过程难以实时开展、指挥员感知战场态势依赖鼠标键盘交互性差等问题;战场环境展示形式仍以二三维地图平面显示为主,战场环境全貌与细节展示不直观、战场变化表达方式单一。利用元宇宙概念和技术,恰能很好解决上述问题,提升指挥协同效率。

虚拟指挥协同空间的构建,就是基于元宇宙“平行于现实世界的虚拟空间”的概念,利用图像目标识别、目标动态感知、三维实景建模、全息场景搭建和混合现实等技术手段,打通虚拟战场构建、战场目标识别、战场综合环境虚拟展示和混合现实指挥协同各个环节,构建虚拟指挥协同空间[10]。

身处不同地理位置的指挥员们,能够在同一虚拟空间内获得更为直观的立体虚拟三维战场环境。在语言、动作捕捉、表情捕捉、眼动识别等自然交互技术支撑下,进一步打破空间壁垒,实现“面对面”沟通交流,协同开展战场情报分析、战场态势研判、作战文书下发等指挥环节,大幅提升人与人间协同、人与系统间交互的效率。

2 系统设计

2.1 整体设计

2.1.1 现实战场环境

现实战场环境通常可以细分为自然环境、人造环境[11]和作战环境等。其中,自然环境主要指山峦地势、河川湖泊、土壤植被、气候水文等[12];人造环境主要指城镇乡村、交通水利、工业农业、水电、供给系统、文化设施等;作战环境主要指敌我体系作战、行军部署、后勤保障、情报、通信等。现实战场环境的数据将通过卫星、有/无人机、单兵终端、传感器以及历史积累数据等方式采集和获取。

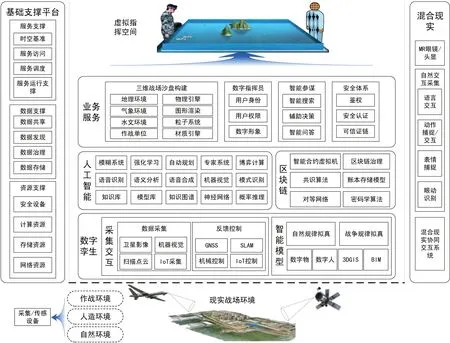

2.1.2 基础支撑平台

基础支撑平台作为整个系统的基座,将为虚拟指挥协同空间的构建提供资源、数据、服务等方面支撑。资源支撑主要包括网络、存储、计算、安全等;数据支撑主要包括数据的存储、治理、发现、共享等;服务支撑主要包括服务的运行支撑、调度、访问以及时空基准等。

基础支撑环境负责将各类硬件资源虚拟化,形成资源池,再通过虚拟机云、容器云等不同方式,支撑各类服务运行。区别于民用,战场暴力特性决定该空间内充满来自各个方向和维度剧烈、破坏性的对抗,因此还要求军用基础支撑环境必须具备去中心/分布式、轻量化、抗毁伤、高柔性等特性。

2.1.3 混合现实

图1:虚拟指挥协同空间技术架构

接入访问终端将采用MR 设备,相较于AR 和VR 设备,MR 设备能够为用户提供视觉、听觉等更多方位的感官沉浸体验。同时,利用语言交互、动作捕捉/交互、表情捕捉、眼动捕捉等自然交互技术,用户还能够摆脱传统键盘、鼠标的桎梏,消弭交流的空间隔阂,让“面对面”沟通更加自然顺畅。

2.1.4 虚拟指挥空间

虚拟指挥空间基于基础支撑平台,由数字孪生、人工智能、区块链和业务服务组成,将采集到的现实战场环境数据平行映射至赛博空间,完成虚拟指挥协同空间构建。

智能模型将卫星影像、IoT 采集、扫描点云、机器视觉等方式获取到的数据,形成地形地貌、建筑等基础图层,作战目标、可移动物、敌我部队活动等主题要素图层。

人工智能在大数据基础上,构建模型库和知识库,通过模糊系统、自动规划、博弈计算等AI 技术手段,搭建智能参谋专家系统,为辅助指挥决策提供智能化支撑。

区块链为整个技术架构提供去中心化技术,不依赖中心管理的机制,各节点信息的自我验证、传递和管理,能够将原有限制部队移动的庞大信息中心、指挥中心化整为零,提升部队在战场上的生存能力。

业务服务包括三维战场沙盘构建、数字指挥员、安全体系、智能参谋等。三维战场沙盘构建负责引入基础图层和主题要素图层,渲染地理环境、气象环境、水文环境、作战单位,形成3D 虚拟指挥协同空间战场展示场景;数字指挥员完成参与协同指挥的指挥人员的数字化,形成数字形象,并分配相应的身份与权限;安全体系为虚拟协同空间提供鉴权、安全认证和可信证链;智能参谋基于人工智能的知识库、AI算法等,为虚拟协同空间内的指挥人员提供辅助指挥决策支撑。

2.2 系统流程

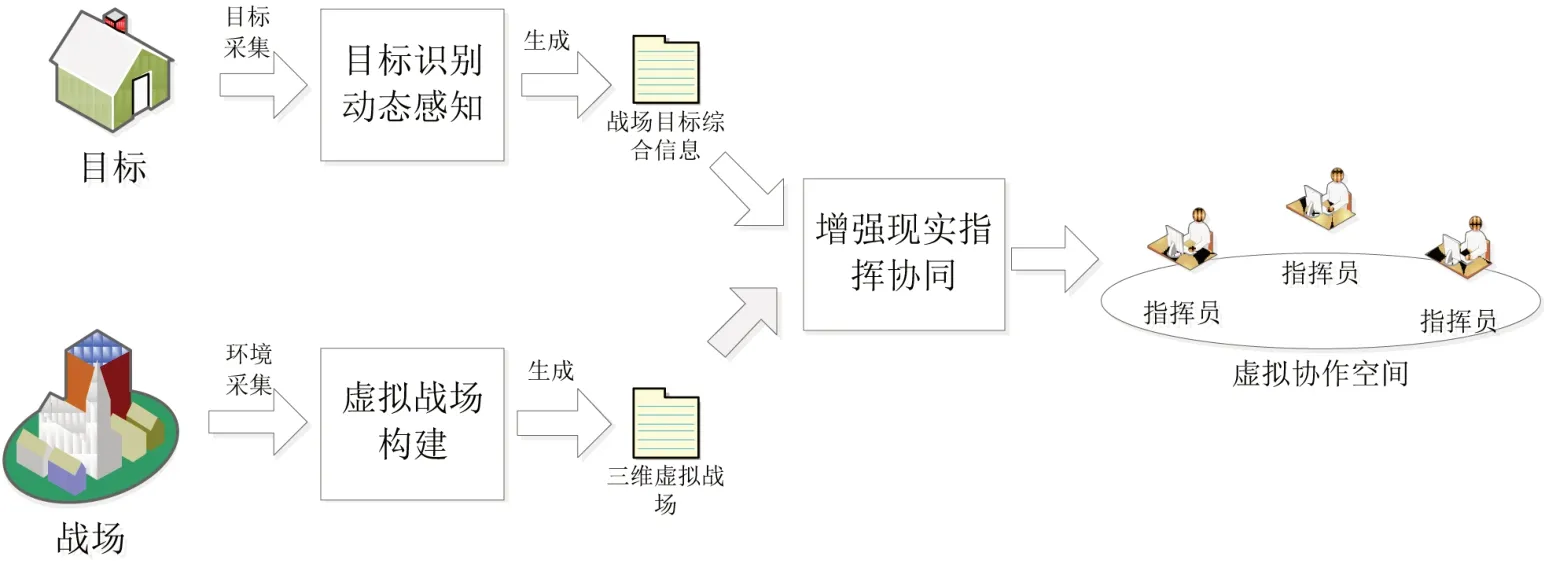

基于实景三维、全景地图和激光点云等技术,通过卫星照片、航空照片、航空激光雷达、地面照片和地面激光雷达相结合方式,星、空、地协同采集,快速获取战场全景信息。利用智能处理和算法分析,完成数据清洗、匹配和定位,将时空信息、集合信息、属性信息和拓扑信息进一步融合、组织,形成物理实体库,完成战场的三维全息空间构建。如图2 所示。

图2:系统流程

目标识别动态感知环节,通过对实时动态图像源的云计算与边缘计算相结合的方式,利用计算机图形学、制图和建模、场景生成、计算机视觉图像和视频处理、计算数学摄影测量和自动分析等技术,动态感知和识别敌我部队、作战目标、可移动物等价值目标。

混合现实指挥协同环节,完成虚拟协同空间构建的同时,在基于人体影像的多人协同交互方面,利用精准定位、手势识别、语音识别和多人协同等技术,对身处异地的多位用户进行人像、声音采集,经空间坐标转换与定位、音像同步、虚实场景融合等一系列处理后投射到眼镜设备中,实现虚拟场景中的用户相互之间可看、可听、可协作。

2.3 系统特点

在战场展现方面,系统采用3D 实景建模与动态目标检测结合方式,既能构建大场景虚拟三维战场沙盘,也满足以较小的数据计算、传输代价保证价值目标的精准定位与实时更新的要求。

在人‐物交互综合应用方面,系统以手势、动作、语言等复合方式,替代鼠标键盘交互方式,实现对虚拟空间中各目标的精准定位、指令分发和交互反馈,用户能够更为自由、便捷的操作和使用虚拟空间内的模型、按钮、菜单,加载的外部文档、视频、系统界面等。

在多人协同交互方面,支持将身处异地的多位用户的全息三维影像,系统对用户进行人像、声音采集,根据人体影像中附带的测距参数、同步采集到的音频,经空间坐标转换与定位、音像同步、虚实场景融合等处理,投射到MR 眼镜设备中,实现虚拟场景中的用户相互之间可看、可听效果,比传统的音视频更为生动,表现的效果和协作的效率也更高。

3 关键技术

3.1 三维战场沙盘构建技术

数字孪生(Digital Twin)是以数字化方式创建物理实体的虚拟模型,借助数据模拟物理实体在现实环境中的行为,通过虚实交互反馈、数据融合分析、决策迭代优化等手段,为物理实体增加或扩展新的能力[13,14]。三维战场沙盘构建技术用于搭建虚拟指挥空间内的战场环境,现实战场在赛博空间的数字孪生。

三维战场沙盘建模与超大城市空间的三维模型颇为相似,都能够利用卫星遥感获取大范围地理信息。利用倾斜摄影、三维激光扫描等技术完成三维模型的构建,由数字正射影像图等技术进行三维地理信息更新[15]。

三维战场沙盘也有其特有的要求,主要表现在全息和动态。全息要求三维战场沙盘能够显示更为全面的信息,除了传统的战场地理、气象、交通等环境信息,还应该包括指令、态势、社交、舆论等标识和信息;动态表现在三维战场沙盘需要动态分析已采集的各类地理、时间、人员等数据,实时进行战场环境和战场态势信息的处理,形成标绘并综合展示[16]。

3.2 混合现实技术

混合现实(Mixed Reality, MR)是继虚拟现实(AR)、增强现实(VR)之后,技术的进一步发展。通过在虚拟环境中引入现实场景信息的方式,混合现实能够打破真实与数字世界的固有界限,再借助沉浸技术将两者融合并形成一个全新的环境,在现实世界、虚拟世界、用户三者之间搭建起一个完整的交互反馈回路,以此来加强用户体验的真实感。

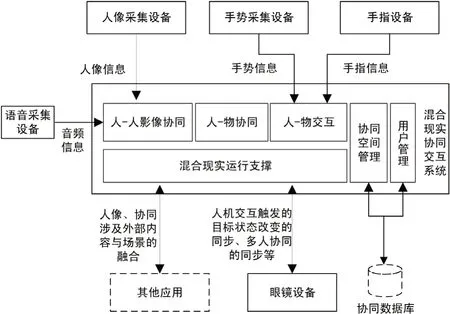

混合现实在虚拟指挥系统中主要提供现实人到数字人的映射和更为先进的人机交互,其主要包括各类采集设备、MR 眼镜和混合现实协同交互系统等。如图3 所示。

图3:混合现实技术架构

混合现实系统交互系统作为实现混合现实的支撑软件,主要包括混合现实运行支撑模块、人‐人影像协同模块、人‐物协同模块、人‐物交互模块、协同空间管理模块和用户管理模块。

(1)混合现实运行支撑模块,由整个技术架构所需的共性模块组成,主要包括时钟同步、坐标计算、指令和状态协同等。这些功能模块能够为用户间协同、用户与内容协同提供必须的时统服务,为全息三维人像在虚拟空间中的坐标定位提供基础算法,并能够向各眼镜设备分发用户手势操作指令信息和虚拟空间内目标状态变化信息。

(2)人‐人影像协同模块,由人物特征提取、多路人像融合、语音降噪、音像同步等功能模块构成。功能模块间相互协作,能够实现利用一组深度摄像头从多个角度采集人像并提取特征值、颜色、姿态、体型等相关影像参数,通过拼接组合形成完整的人像参数,对语音进行降噪处理,对同一时刻采集的人像和语音进行同步处理,在统一时间基准的前提下分发到所有眼镜设备,确保每个人看到其他人同时也能听到对方的语音。

(3)人‐物协同模块,负责物的状态采集和物的状态同步。当获取目标状态改变时,该模块将提取出具体变化的参数值,并以发起人为参照,将目标状态的改变同步到所有人的眼镜设备,与本地目标状态的改变进行比对和校验。

(4)人‐物交互模块,提供语音分析、语义匹配、手势获取、位置解析、姿态解析、深度分析、指令集、指令交互等功能。该模块能够提取用户发出语音的特征,识别建模并将解析后形成的语音模型与指令关联映射;利用眼镜设备的摄像头和手环等手势感知设备,获取用户当前手势,定位和计算手指、手势在场景中的相对坐标位置,对姿态解析建模并完成对手势边缘、轮廓、图像特征向量、图像矩、区域直方图等特征解析,形成手势与指令的映射;统一管理用户手势与语音对应指令的映射对,将指令发送到用户手势指定的目标,改变目标的状态。

(5)协同空间管理模块,提供虚拟空间管理和协同邀请管理。可由发起者创建一个虚拟协同空间,并通过协同邀请选择人员加入。

(6)用户管理模块,负责人员管理和权限管理,维护用户信息,并完成授权与鉴权。

4 结束语

目前,元宇宙在我国虽有政府政策扶持、各大企业争相进场,但受限于技术、产业、经济、法律、监管、伦理、人才等多维因素影响,其仍将存在一个长期的实践探索阶段。不过,元宇宙中虚拟空间的概念及相应技术在军事领域,如日常训练、兵棋推演、指挥协同等方向,有着广阔的应用空间和挖掘潜力。