基于近端策略优化算法的灾后配电网韧性提升方法

2022-11-14王子昊蒋传文白冰青

王子昊,王 旭,蒋传文,龚 开,白冰青,邓 晖

(1. 电力传输与功率变换控制教育部重点实验室(上海交通大学),上海市 200240;2. 国网浙江省电力有限公司电力科学研究院,浙江省杭州市 310014;3. 国网浙江省电力有限公司电力市场仿真实验室,浙江省杭州市 310014)

0 引言

台风灾害是影响中国沿海及部分内陆地区的主要灾害性天气系统之一,台风灾害会导致配电网负荷损失[1]。为了评估应对极端自然灾害的能力,配电网引入了韧性(resilience)的概念[2]。配电网韧性用于评价配电网承受小概率-高损失事件的能力。文献[3]提出了考虑多阶段配电网拓扑重构的配电网韧性评估指标。文献[4]将灾害过程中所有负荷的正常运行时间与灾害持续影响时间的比值作为韧性量化指标。目前,在配电网韧性提升问题的研究中,文献[5]采用线路加固方式实现了配电网韧性的提升;文献[6]采用核密度估计法计算韧性概率分布并反映分布式发电(distributed generation,DG)对韧性的提升程度;文献[7]构建了3 层优化模型以提升配电网-城市交通网耦合系统韧性;文献[8-9]利用可控开关实现网络重构来满足灾后负荷需求。

强化学习是机器学习领域迅速发展的分支。目前,强化学习在配电网韧性的应用尚处于初步阶段,如何利用强化学习实现灾后配电网快速恢复仍面临诸多技术难题。近年来,研究人员在电力系统中尝试应用各种强化学习方法,例如:基于深度强化学习的负荷频率控制策略[10]、基于竞争深度Q 网络的主动配电网运行优化[11]、利用深度确定策略梯度(deep deterministic policy gradient,DDPG)算法实现配电网节点电压总偏差与线损最小[12]、基于深度强化学习的配电网高恢复力决策方法[13]、基于行动者-评论家(actor-critic,AC)框架的配电网多时间尺度无功优化[14]、基于多智能体深度强化学习的配电网无功调度方案[15]等。这些方法都基于马尔可夫决策过程(Markov decision process,MDP)进行建模,MDP 也可应用在配电网韧性领域[16]。常用的强化学习方法包括基于值函数的方法、基于策略梯度(policy gradient,PG)的方法以及两者相结合的AC方法。目前的研究[10-15,17-21]涉及3 类强化学习方法,但尚未见文献将属于AC 方法的近端策略优化(proximal policy optimization,PPO)算法应用于灾后配电网韧性提升。

PPO 算法是OpenAI 提出的一种强化学习算法,可在复杂的场景中快速学习到正确的策略。目前,PPO 算法已应用在无人机集群攻防对抗[22]、物联网环境温度预测[23]、综合能源系统的多目标能源优化调度[24]等领域。基于以上研究[22-24],在极端灾害发生后配电网的网络重构、DG 调度及负荷恢复问题中运用PPO 算法具备可行性,使用高效的PPO算法对于解决灾后配电网韧性提升问题有着重要意义。

本文构建了配电网韧性恢复力评价指标,将灾后配电网网络重构问题转化为一个MDP,用深度神经网络拟合配电网已知状态到联络线开关投切动作的函数映射,以最大化累计奖励为优化目标以减少负荷损失,在每个动作周期进行内层优化。最后,通过算例分析验证了所提方法在提升灾后配电网韧性上的有效性以及PPO 算法的收敛性。

1 PPO 算法

PPO 算法是一种基于AC 框架的深度强化学习算法,该算法基于PG 获得最优策略。PPO 算法由评论家网络(critic network,CN)和行动者网络(actor network,AN)构成。CN 学习环境和奖励之间的关系并获得当前的动作优势函数,AN 根据动作优势函数不断调整策略的参数,以增加获得高奖励值的概率。

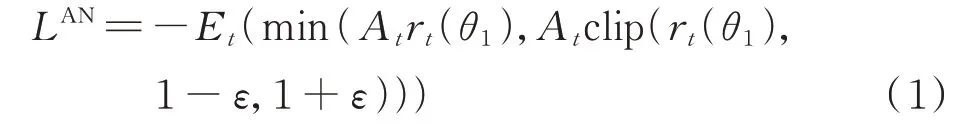

PPO 算法中,AN 的损失函数LAN表达式[25]为:

式 中:Et(·)为t时 刻 的 期 望 函 数;θ1为AN 的 参 数;rt(·)为t时 刻 的 新 旧 策 略 概 率 函 数;At为t时 刻 的 动作 优 势 函 数;clip(·)为 修 剪 函 数;ε为 小 于1 的 正常数。

PPO 算法尝试通过最小化取得更大劣势动作概率的同时,最大化At的数值,使AN 向高奖励值的方向更新。传统PG 算法对新策略的更新幅度十分敏感,步长较小时,难以在限定的时间内生成更好的策略,步长较大时,生成的策略收敛困难。PPO算法使用式(1)限制了新策略的更新幅度,当步长较大时也可保证策略的稳定收敛,从而兼顾了算法的策略优化以及收敛性。

CN 的作用是拟合状态价值函数,θ2为CN 的参数,CN 的损失函数LCN表达式为:

式中:s和a分别为强化学习中的状态和动作;r(s,a)为状态s下采取动作a的即时奖励;γ为折扣因子;s′为状态s下采取动作a的后继状态;V(·)为状态价值函数。

2 灾后配电网韧性提升内层优化模型

配电网韧性提升分为3 个阶段,即灾前提升配电网抵御各类型极端事件的能力、灾中提升配电网应对、适应、吸收极端事件影响的能力、灾后配电网从极端事件影响中迅速恢复的能力。配电网韧性恢复力指标衡量配电网逐步恢复负荷供电,使其尽快接近或者达到灾前正常状态的调控能力[2]。

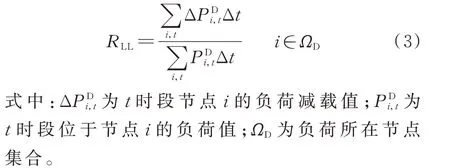

本文用负荷失电率以及负荷停电率衡量配电网韧性恢复力。负荷失电率RLL为极端事件发生后,负荷减载总量占负荷总量的比值,表达式为:

负荷停电率RLC为极端事件发生后,配电网负荷停电总次数占总仿真数的比值,表达式为:

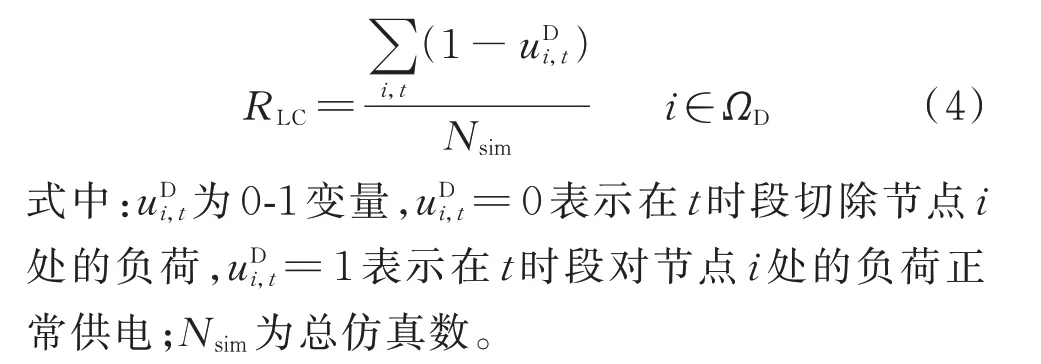

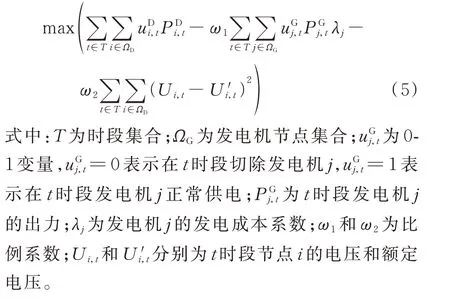

在遭受极端台风事件后,配电网部分线路断线,以灾后配电网的负荷损失、发电成本和节点电压偏差最小为目标,此时的优化目标函数为:

具体约束条件如下:

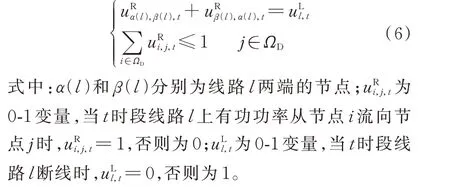

1)配电网辐射状网络约束[26]

式(6)表示辐射状网络中的子节点最多有1 个父节点。

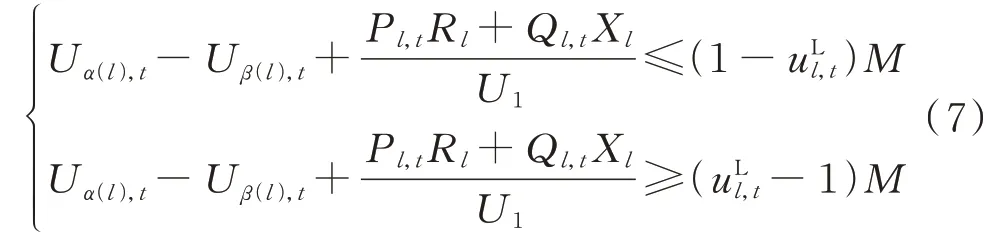

2)线路电压降约束[26]

式 中:Pl,t和Ql,t分 别 为t时 段 流 经 线 路l的 有 功 功 率和无功功率;Rl和Xl分别为线路l上的电阻和电抗;U1为电压基值;M为一个取值很大的正数。

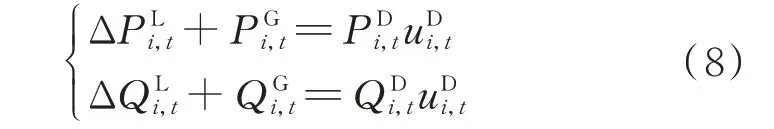

3)功率平衡约束

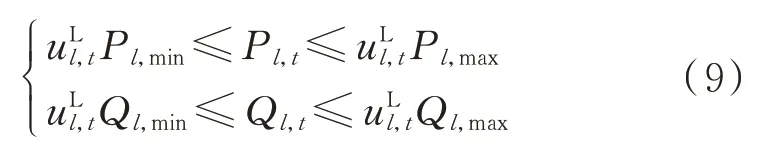

4)线路传输功率约束

式 中:Pl,max和Pl,min分 别 为 流 经 线 路l的 有 功 功 率 上、下 限;Ql,max和Ql,min分 别 为 流 经 线 路l的 无 功 功 率上、下限。

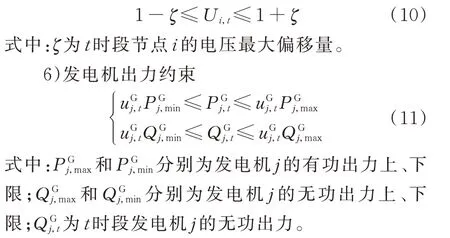

5)节点电压约束

3 灾后配电网韧性提升方法

本文构建基于PPO 算法的双层优化模型实现灾后配电网韧性提升,通过分析配电网负荷、DG 和联络线通断数据,获得配电网韧性恢复力最优的网络重构策略。

3.1 基于强化学习的灾后配电网韧性提升模型

3.1.1 配电网网络模型及参数设置

本文采用改进的IEEE 33 节点配电网为研究对象,含联络线的配电网系统拓扑如附录A 图A1所示。

假设该配电网区域发生极端台风灾害,配电网内易损线路设置情况如附录A 图A1 所示,该配电网与主网断开连接,配电网其余线路均为电缆,在极端天气下不会出现断线事故。配电网被故障线路分隔形成多个原始孤岛,此时,该配电网系统能量支撑来源于用户侧DG。极端灾害下,DG 难以适应随机性的故障位置。在原始孤岛划分下,可能存在部分孤岛电源功率支撑不足的情况,造成配电网的负荷损失。设置5 条联络线,每条线上都有联络开关。各DG 技术参数见表A1,在本模型中不进行弃风、弃光操作,即当风机和光伏接入配电网时,其出力全部消纳。

3.1.2 灾后配电网韧性提升外层优化模型

若将灾后配电网系统作为环境,进行动作决策的联络线调度中心作为智能体,则灾后配电网韧性提升问题可以转化为典型的MDP 问题,其决策过程的状态空间S、动作空间A、奖励空间R定义如下。

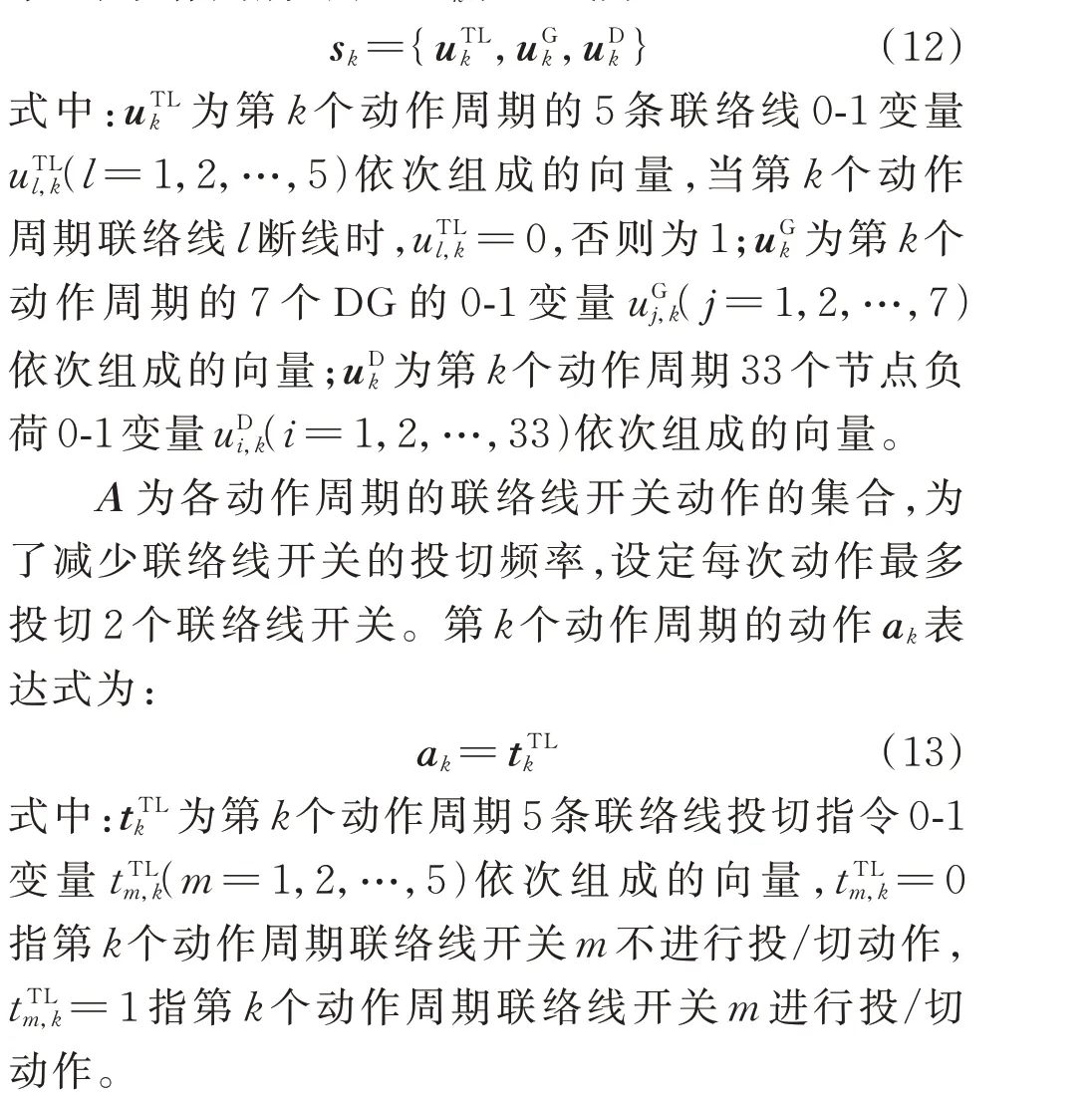

S为联络线调度中心获取到的配电网信息,具体包括配电网中联络线、DG 与负荷的通断信息。第k个动作周期的状态sk表达式为:

向 量sk有45 个 元 素;ak共 有16 种 取 值 情 况,即联络线调度中心每次有16 种动作选择。

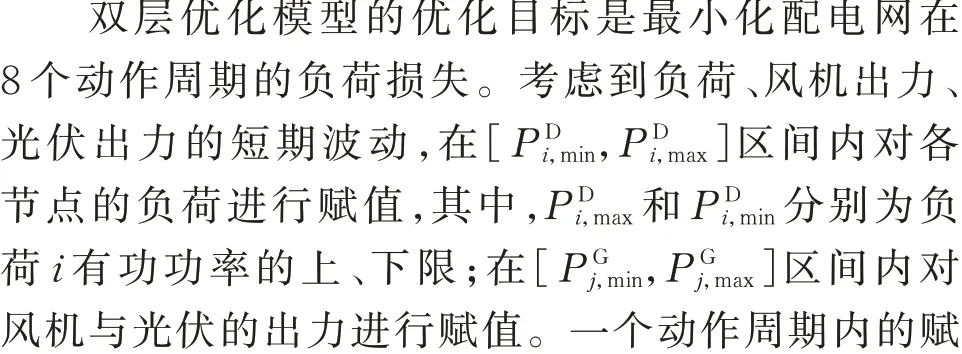

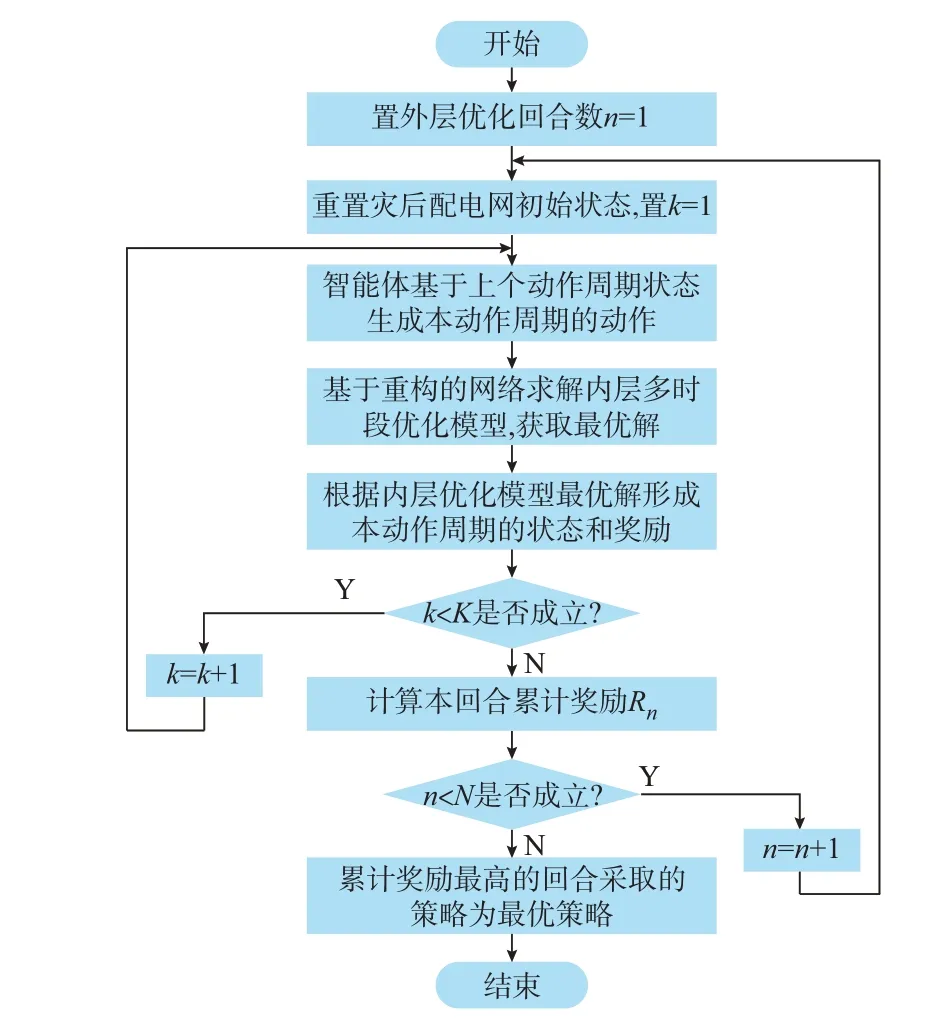

本文构建包含外层强化学习优化与内层传统优化的双层优化模型,即在每个动作周期完成内层优化模型的多时段优化,并完成由全部动作周期构成的外层强化学习优化。假设配电网故障线路的断线持续时间为40 min,每5 min 作为一个动作周期,共有8 个动作周期。每个动作周期包含5 个时段,即每分钟进行一次优化调度。线路故障期间智能体首先根据上一个动作周期的状态生成该动作周期的动作指令,重构后的网络应最大限度地实现孤岛间的功率联络并尽可能地恢复负荷。然后,根据新的系统拓扑图,在约束条件下使内层优化模型的目标函数值最大,基于内层优化模型的最优解生成该动作周期的状态与奖励,此后,循环这一过程。

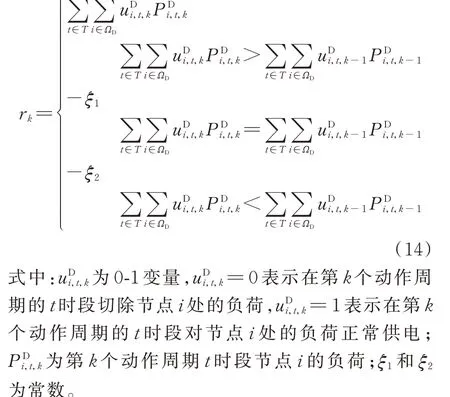

R与负荷损失值有关,其第k个动作周期rk的表达式为:

若本动作周期的负荷损失值小于上个动作周期的负荷损失值,即当本动作周期的动作能促进配电网灾后负荷进一步恢复时,rk取值为本动作周期的负荷恢复值,奖励取为正数以促进强化学习向配电网韧性提升方向优化;两者相等时,rk取一个绝对值较小的负值,ξ1=20;否则,rk取一个绝对值较大的负值,ξ2=80。

显然,外层强化学习优化模型的优化目标为最大化累计奖励值,模型的最优解相当于求解MDP的最优策略,表达式为:

式中:K为动作周期总数。

强化学习流程如图1 所示。值情况见附录A 表A2。

图1 强化学习流程图Fig.1 Flow chart of reinforcement learning

3.2 PPO 算法训练过程

3.2.1 PPO 算法训练过程原理

基于灾后配电网韧性提升的PPO 算法学习框架如图2 所示。样本单元由上个动作周期的状态信息、本动作周期的动作信息和动作价值函数信息构成。CN 根据本动作周期的奖励和状态生成动作价值函数信息。在每个回合中,每隔指定的动作周期数后提取该区间的样本单元集。CN 利用样本单元集中的状态信息和动作价值函数信息计算其损失函数值LCN并 更 新CN 的 参 数θ2。AN 中 包 含 新、旧2 个 策略,此时,结合CN 输出的动作优势函数与样本单元集中的动作信息、状态信息计算AN 的损失函数值LAN,并更新AN 的参数θ1。在经过足够多的训练后,PPO 算法中的参数会收敛于稳定值。AN 根据新策略和给定的状态s生成动作a,根据动作a求解内层优化模型后形成奖励r和新状态s′并输入CN以实现完整的PPO 算法优化学习循环。

图2 PPO 算法优化学习过程Fig.2 Optimal learning process of PPO algorithm

对于AN 和CN,梯度下降优化均选择Adam 优化器,其隐藏层个数均为1,隐藏层均采用Relu 函数作为输出函数,AN 的输出层采用Softmax 函数来激活。AN 的输入为含45 个元素的状态向量s,输出为基于s的16 个联络线开关动作组合概率。CN 的输入也是状态向量s,输出为状态价值函数。AN 和CN 的学习率分别是0.000 1 和0.000 2。clip 函数中的参数ε=0.2,折扣因子γ=0.9。在每个回合中依次选取前5 个动作周期和后3 个动作周期这2 个区间的样本单元集对AN 和CN 进行训练。设置节点23、24 处的负荷值远大于配电网其他节点的负荷值,因此,将节点23、24 处的负荷视为重要负荷。在内层优化模型中增加5 个时段内配电网线路和联络线通断情况不变的约束条件,内层优化问题的参数ω1=0.1、ω2=0.5,发 电 机 的 发 电 成 本 系 数 均为0.5。

3.2.2 PPO 算法训练过程测试

实验基于Python 3.6 及Keras 库实现,采用Tensorflow 作为后端,采用Cplex 求解器求解内层优化问题。计算机CPU 为2.60 GHz 的Intel Core i7-9750H,内存容量为16 GB。

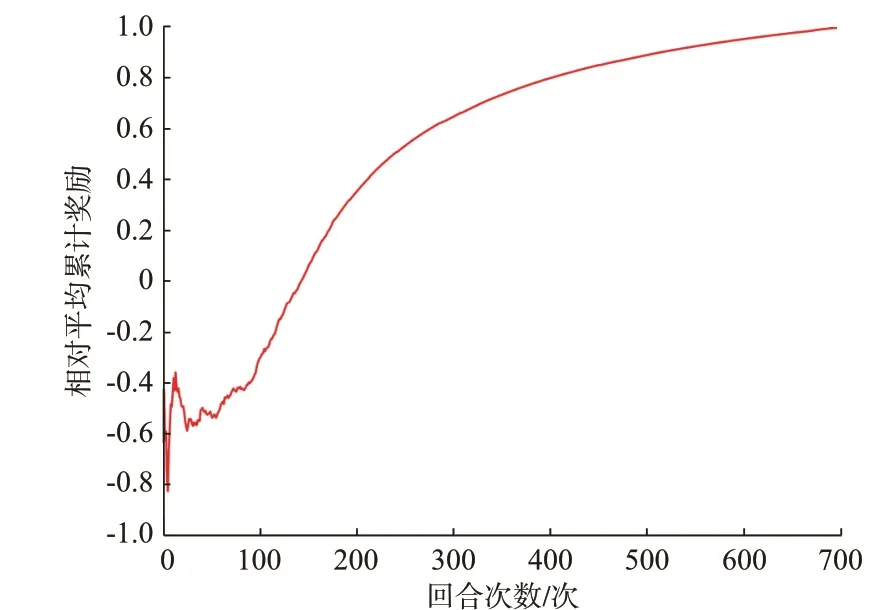

采用相对平均累计奖励值及AN、CN 的损失函数的变化来评估PPO 算法的训练情况。相对平均累计奖励值是指当获取第n个回合的累计奖励值时,计算前n个回合累计奖励值的平均值。在完成指定的回合数N后,计算每个回合对应的平均累计奖励值与最大平均累计奖励值的比值,从而获取PPO 算法的整体训练效果。

设定总回合数N=700,PPO 算法训练过程中的相对平均累计奖励值如图3 所示。随着回合次数的增加,相对平均累计奖励值趋于稳定。AN、CN损失函数值的变化情况分别如附录A 图A2 和图A3所示。

图3 PPO 算法训练过程中的相对平均累计奖励值Fig.3 Value of relative average cumulative reward in training process of PPO algorithm

当训练次数大于400 次后,AN、CN 的损失函数值振荡衰减。随着训练次数的增加,AN、CN 的损失函数值逐渐趋近于0,训练的神经网络稳定较快。当连续10 个回合累计奖励值维持不变时,认为算法生成稳定策略。PPO 算法在第190 个回合生成了稳定策略,可见PPO 算法的收敛性较好。

PPO 算法训练过程中一个回合包括8 次动作值输出、8 次内层优化模型的最优解输出以及AN、CN的参数更新,每一个回合均可在6 s 内完成,求解过程较快。

4 仿真结果分析

4.1 改进的IEEE 33 节点系统算例分析

4.1.1 优化结果分析

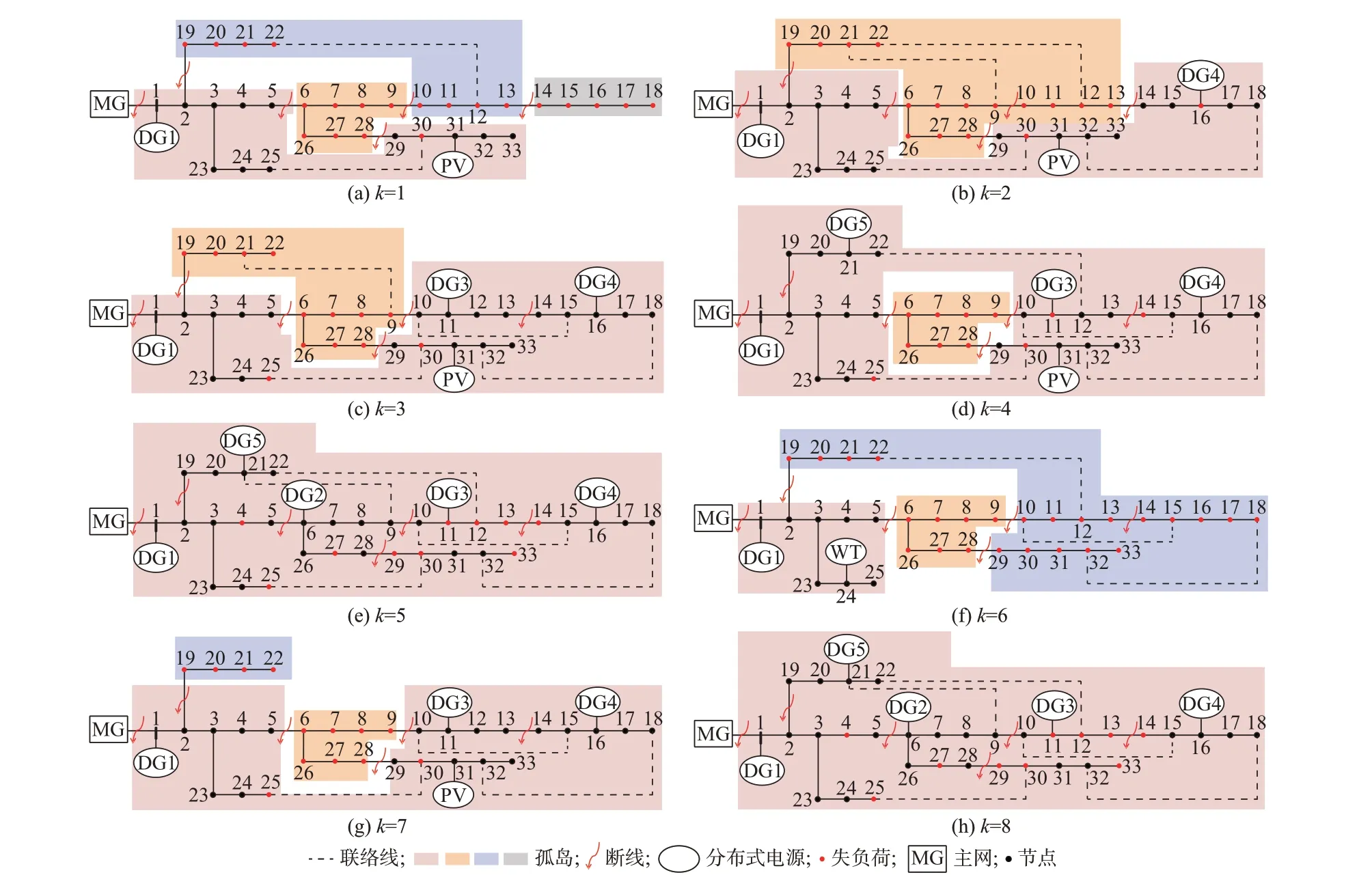

动作周期第5 个时段的联络线、负荷、DG 的通断数据是下一个动作周期的初始状态数据,也是下一个动作周期智能体发出动作指令的依据,在最优策略下的灾后配电网各动作周期第5 个时段的联络线通断情况、切负荷组合、DG 调度情况以及孤岛范围如图4 所示。

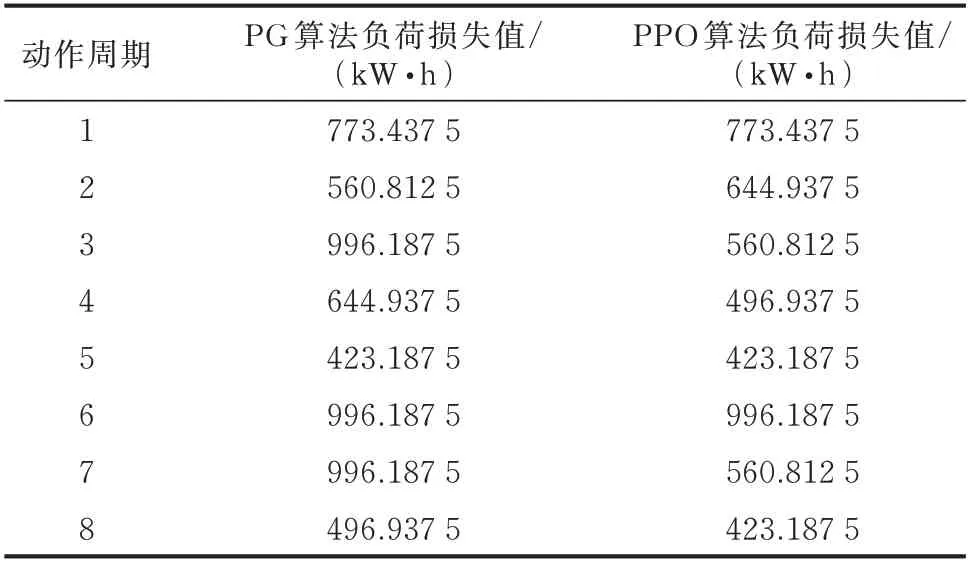

PPO 算法与PG 算法在一个回合的用时基本相等,2 种算法最优策略下各动作周期的负荷损失值见表1。结合表1 与图4(a)至图4(e)可知,在智能体完成网络重构动作后,孤岛之间彼此联络,前5 个动作周期失电孤岛的数量依次为3、1、1、1、0,失电孤岛的范围不断减小,前5 个动作周期第5 个时段DG 投入数量依次为2、3、4、5、5,配电网的供电能力呈现明显的上升趋势,前5 个动作周期第5 个时段配电网中断负荷数量分别为21、17、13、11、10,负荷恢复能力持续提升。结合表1 与图4(f)至图4(h)可知,在配电网经历第6 个动作周期短暂的负荷损失增加后,配电网负荷损失值在第8 个动作周期再次降低到图4(e)的水平,且负荷恢复速度大于前5 个动作周期的恢复速度。在8 个动作周期内,最优策略始终保证对节点23、24 处的重要负荷供电。

表1 不同算法最优策略下各动作周期的负荷损失值Table 1 Load loss value of each operation cycle with the best strategies of different algorithms

图4 灾后配电网韧性提升策略及调度情况Fig.4 Resilience improvement strategy and dispatching situation of post-disaster distribution network

灾后配电网各动作周期第5 个时段的DG 出力水平如附录A 图A4 所示。可见,采取光伏、风机出力全部消纳的策略可较大程度地缓解配电网节点1处DG1 的发电压力。

4.1.2 PPO 算法性能分析

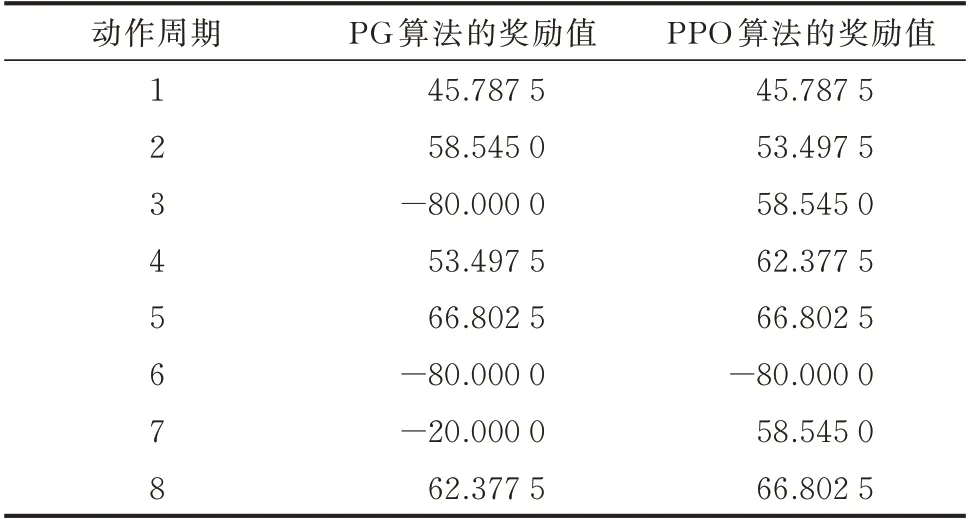

PPO 算法、PG 算法最优策略下各动作周期的奖励值如表2 所示。求得PG 算法、PPO 算法最优策略的累计奖励值分别为107.010 0、332.357 5,PPO 算法在限定的总回合数内生成了累计奖励值更大的策略。

表2 不同算法最优策略下各动作周期的奖励值Table 2 Reward value of each operation cycle with the best strategies of different algorithms

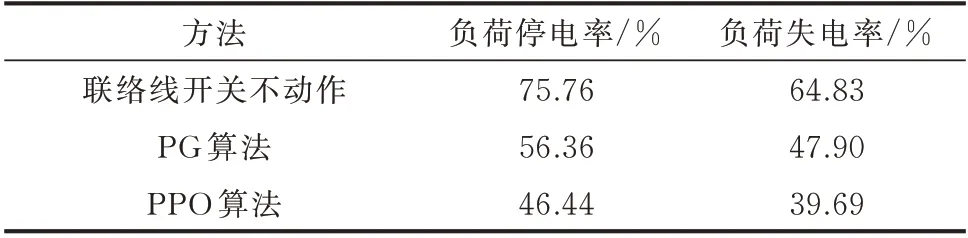

PPO 算法与PG 算法最优策略的负荷停电率和负荷失电率如表3 所示。由表3 可知,基于PPO 算法的灾后配电网韧性提升方法可以有效促进灾后配电网的负荷恢复。

表3 IEEE 33 节点配电网算例的不同算法对比Table 3 Comparison of different algorithms in the case of IEEE 33-bus distribution network

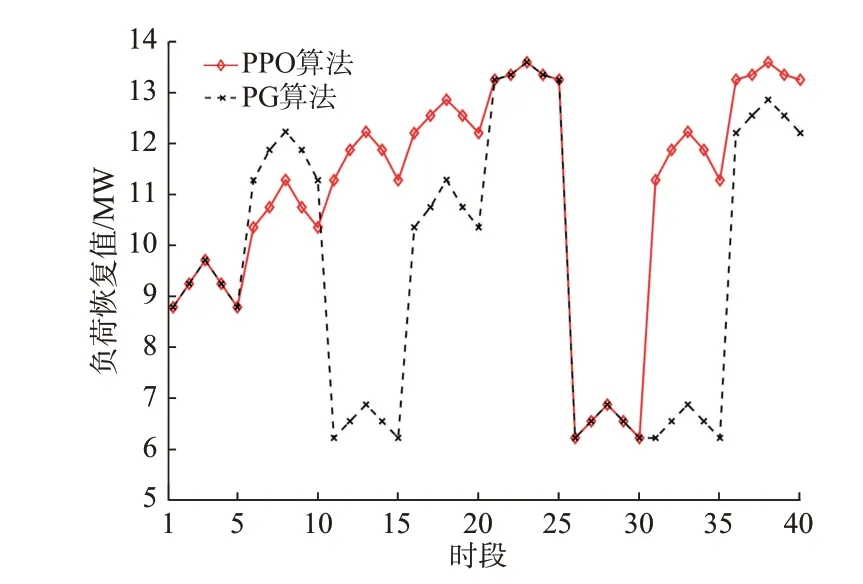

PPO 算法和PG 算法生成的最优策略对比如图5 所示。可见,除第6 个时段至第10 个时段PPO 算法的负荷恢复值短暂小于PG 算法外,其余35 个时段PPO 算法的负荷恢复值均大于或等于PG 算法的负荷恢复值,可见PPO 算法比PG 算法更有效地提升了灾后配电网韧性。

图5 PPO 算法与PG 算法生成的最优策略对比Fig.5 Comparison of optimal strategies from PPO algorithm and PG algorithm

4.2 改进的IEEE 118 节点系统算例分析

本算例的参数设置见附录B。PG 算法在限定的总回合数内没有生成稳定策略,而PPO 算法在第110 个回合生成了稳定策略。PPO 算法、PG 算法最优策略下各动作周期的奖励值与负荷损失值分别如附录B 表B3 和表B4 所示。由表B3 可求得PG 算法、PPO 算法最优策略的累计奖励值分别为-23.728、73.116,可见PPO 算法生成了累计奖励值更大的策略。

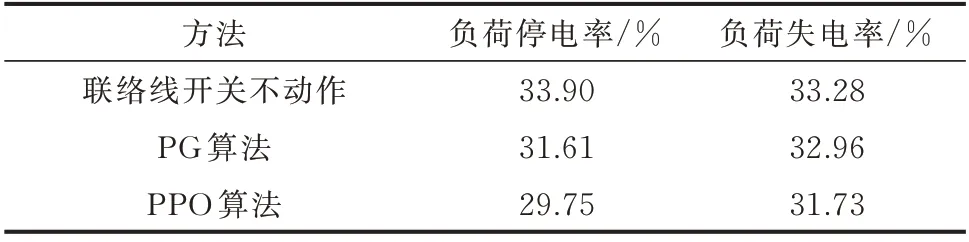

PPO 算法与PG 算法最优策略的负荷停电率和负荷失电率如表4 所示。由表4 可知,相比PG 算法,PPO 算法最优策略的负荷失电率和负荷停电率更小。

表4 IEEE 118 节点配电网算例的不同算法对比Table 4 Comparison of different algorithms in the case of IEEE 118-bus distribution network

5 结语

本文将灾后配电网韧性提升问题转化为MDP问题,以配电网的联络线、DG 与负荷的通断状态集作为状态空间,以联络线开关动作集作为动作空间,以动作周期负荷恢复值作为即时奖励,构建了双层优化模型并采用深度强化学习中的PPO 算法求解灾后配电网韧性提升问题。主要结论如下:

1)PPO 算法收敛性好。PPO 算法达到稳定的韧性提升策略所需回合数少,且训练的AN、CN 稳定较快。

2)在本文算例中,相比于联络线开关不动作与采用PG 算法两种情况,采用PPO 算法优化后的负荷失电率与负荷停电率更低,生成的联络线、DG 与负荷最优调度策略可以有效提升灾后配电网韧性恢复力。

本文考虑了配电网线路故障情况不变的韧性提升方案,未对极端灾害发生期间线路故障动态变化、灾后配电网无功调度优化等情况下PPO 算法的应用进行深入分析,如何进一步降低灾后配电网负荷损失仍有待研究。

附录见本刊网络版(http://www.aeps-info.com/aeps/ch/index.aspx),扫英文摘要后二维码可以阅读网络全文。