AI引领元宇宙时代的生产力革命

2022-11-10张俊波

■文/张俊波

人工智能的引入可以从根本上改变虚拟人、虚拟场景、虚拟物品等数字资产的生产方式,让打造数字资产的生产流水线成为可能,从而实现规模化、批量化生产。这是实现未来元宇宙世界的必经之路。

近年来,互联网及软件行业的各种技术发展迅速,这也构成了我们畅想未来元宇宙时代的基础。但是,从科技领域的生产流程而言,我们还处于工业革命之前的状态,生产效率低下,距离实现大批量、规模化生产还有很长的路要走。数字资产的生产成本高昂、对技术人才的要求苛刻,已然成为阻碍其发展的重要原因。

以近几年非常火爆的数字人为例,灵动表现的背后是动画师在一帧帧地精修渲染,不仅成本高昂,而且制作流程耗时费力。在生产流程中引入人工智能(AI)技术,将工具训练成开发者大脑的延伸势在必行。只有在数字资产制作的流程中引入AI技术,才能够大规模生产高质量的虚拟内容,从而引领元宇宙时代的生产力革命。

AIGC:用AI加速数字资产的规模化生产

元宇宙有3个不可或缺的基础要素:人、场、物,这些数字资产共同构成了元宇宙世界,影响着人们在元宇宙世界中的体验。作为全球领先的实时3D互动内容创作和运营平台,Unity已经在有意识地探索如何通过AI加速数字资产的生产流程。

●AI与虚拟人资产生成

元宇宙最早落地的应用场景是虚拟数字人。当前,很多公司采用的流程是让模特在光场设备中做出极限表情并拍摄下来,然后让艺术家用K帧(关键帧)的方式进行模型清理,这个步骤耗时耗力,却是避免“恐怖谷”效应的必经之路。

人的表情是由面部肌肉牵动的,只要掌握了面部肌肉间的相互作用关系,就可以借助AI技术模拟出人类的所有表情,而不需要找真人来一一扫描。例如,Unity收购的全球领先的数字角色创作公司Ziva,就十分擅长利用机器学习来帮助实时角色创作,精通复杂模拟与模型变形。Ziva打造的虚拟人Emma,可以在Unity平台中实时运行(见图1)。

图1 Ziva打造的虚拟人Emma,可以在Unity平台中实时运行

通过Ziva Faces、Ziva Face Trainer(见图2)等AI赋能的工具,结合人工智能的计算,原本要耗费数周甚至数月的角色脸部创作,可以浓缩成云端的一次按钮点击。这种新颖的方式不仅能加快创作流程,还能让更多的创作者参与其中,发挥他们的创意。

图2 Ziva Face Trainer

如今,Ziva和Unity正在合作规划开发路线,着重普及可负担、可扩展的实时3D人脸技术,让数字角色的表演无须昂贵的头戴摄像机(HMC)或体积捕捉设备即可完成。

Ziva与Unity还合作开发了工具Ziva RT,其主要功能是将复杂的显式表达变成一个AI模型的隐式表达,从而大大提升性能与效率,减少算力代价和运行期内存消耗,让原来需要艺术家十几天时间才能完成的创作,现在只需要短短2小时就能完成。

Ziva RT的使用非常简单,只需要用户提供一个复杂的程序化动画绑定系统10 000帧的动画结果,即每一帧网格体的顶点数据,Ziva RT就能学到这个复杂系统的隐式表达,然后在运行时取代它。Ziva RT带来的变形效果可以直接用于最终成品,它还可以加快用工具评估动画装配的速度,加快数字内容创作(DCC)迭代流程(见图3)。

图3 Ziva RT带来的变形效果

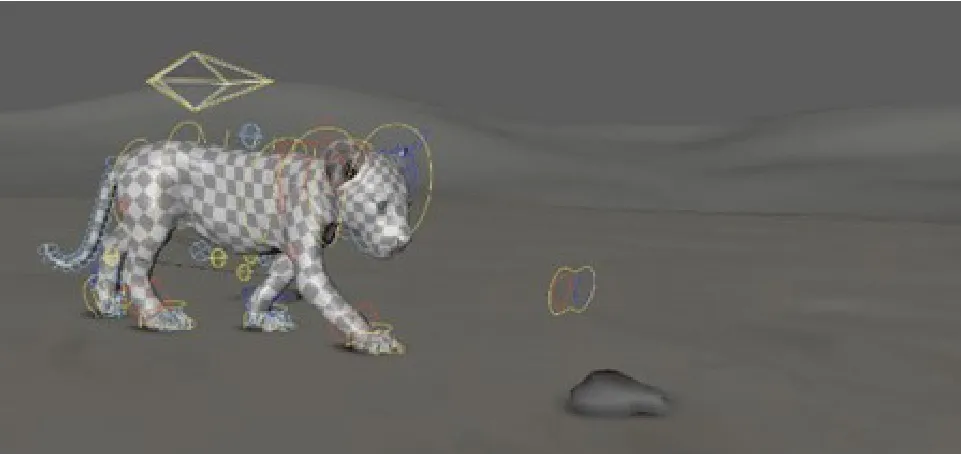

Ziva的能力远远不止于完善3D面部模型与面部表情制作,也能用于动作模拟。例如,使用Ziva VFX 2.0中的新准静态积分器与生物力学弹性体求解器模拟真实世界中躯体柔软的狮子,从而提供准确的结果,确保肢体动作最高保真度的变形。

正如面部表情一样,人类的肢体动作是靠关节控制的,所以只要理解了关节间实时互动的逻辑,就能够用AI来加速肢体动作的制作。例如,利用Unity Deep Pose功能,就可以通过控制某个关节,自动模拟出在该动作的作用下身体其余关节的正确反应(见图4)。

图4 Unity Deep Pose功能

同样用于动作制作的AI驱动功能还有动画系统Kinematica。在传统做法下,开发者需要在混合树(Blend Tree)或状态机安排两个动作之间的切换,才能够模拟出逼真的人物动作。基于Kinematica,开发者只要给予一个骨骼姿势和所需要的轨迹运动,系统就会演算出惯性的动作位移。

●AI与虚拟场景生成

在元宇宙中,除了虚拟人之外,场景也是重要的组成部分,而且其体量比数字人要大得多。现在创作数千甚至数万平方千米的虚拟世界,已经无法用纯人工的方式摆放和设计每一寸土地了,程序化和规则化生成世界成为开放大世界的一个关键技术,人工智能生成内容(AIGC)在这个方面发挥着至关重要的作用。

Unity在场景创作中也已经引入AI功能。例如,Unity World Generation是由AI技术驱动的美术辅助工具,开发者只需要简单地“扫”几下,就有一座高山凭空而起,并且实时模拟出真实的光影效果(见图5)。

图5 由AI技术驱动的美术辅助工具World Generation

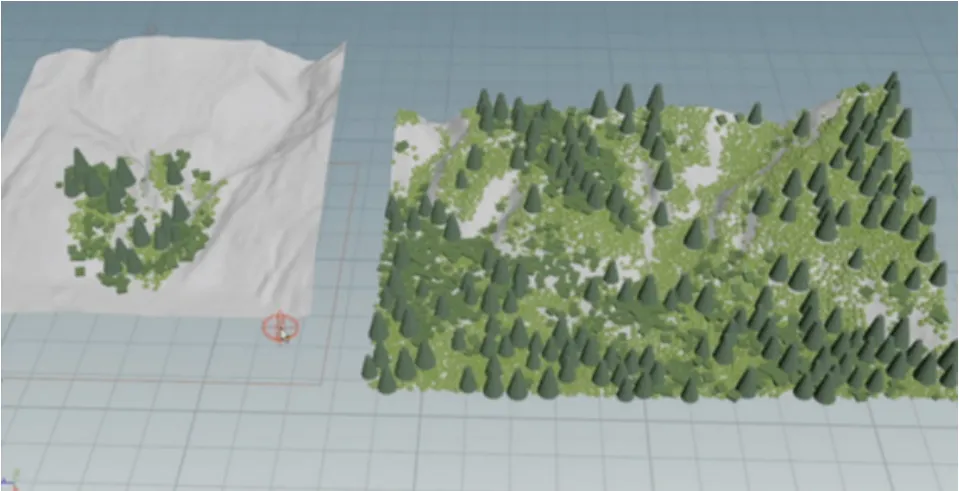

如果想要更多的细节,也可以借助机器学习快速生成。例如图6中,用户通过可视化的方式在左侧的小区域内“放置”树木、地皮等资产,机器学习模型就会根据山体的坡度、水流侵蚀等表面特征实时模拟出植被的正确状态。

图6 通过机器学习可快速生成植被

此外,Unity还推出了智能资产(Smart Assets)。在这种资产里的每一个元素都由AI驱动,用户通过可视化的方式控制每一个元素在场景中所占的比重,系统就会自动生成符合物理真实的场景。所有的计算都通过AI自动完成,不需要再去手动调整参数。

●AI与虚拟物品生成

在人与场景之外,物体也是元宇宙世界必不可少的构成要素。逐一地建模复刻设计无疑是一个效率低下的方式,而通过3D扫描技术和AI则可以大幅提高效率。目前,Unity已经推出了一些AI驱动的功能,通过可视化的方式与3D扫描对现实世界的对象进行三维重建。

例如,Unity ArtEngine利用AI改进了表面摄影制图工作流程,可以通过AI来根据照片自动生成模型资产中的材质数据,并快速去光照、去接缝,消除不需要的伪影,从而快速将照片转换为基于物理渲染(PBR)的素材。形象地说,通过Unity ArtEngine,用户可以轻松地将猫毛提取为PBR材质,然后应用于任何物品,如做成一张独一无二的地毯。

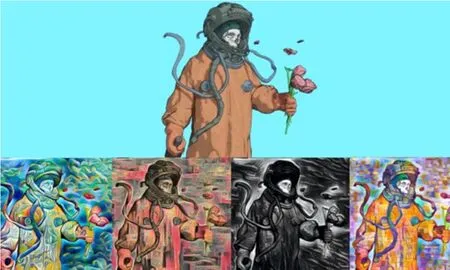

近期,Unity ArtEngine推出了全新的Style Transfer功能,可进一步释放设计师、独立制作者的创作潜力。Style Transfer可以帮助用户以图像为基础,生成不同气氛与色调的图像,将一张参考图像的艺术风格转移到另一张图像上,效果如图7所示。

图7 Unity ArtEngine可以快速生成不同风格的图片

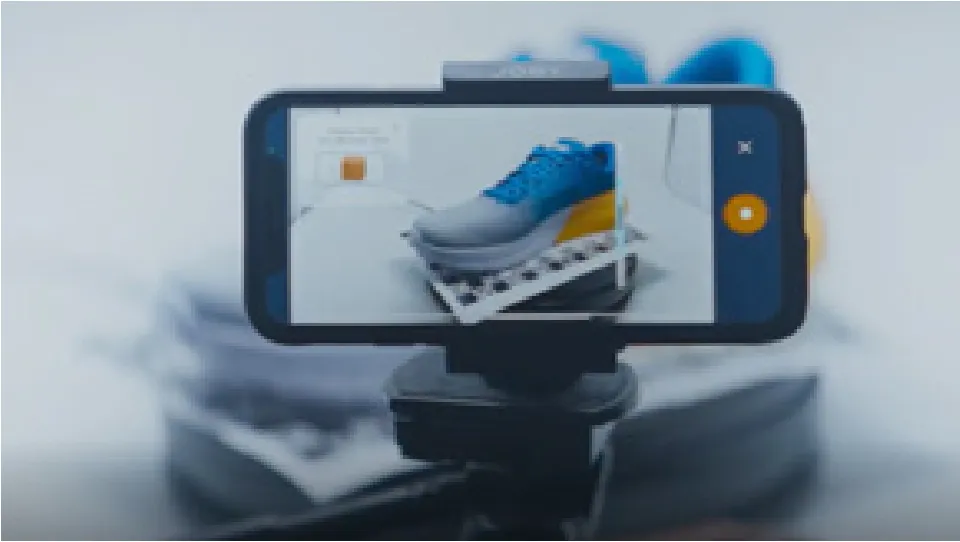

Unity ArtEngine可以生成PBR材质,而Unity的RestAR能够为任何产品或实体创建3D模型。RestAR借助计算机视觉和深度学习,让没有技术背景的用户通过使用移动设备即可对产品进行高质量的3D扫描和渲染。用户只需要用手机拍摄1分钟的视频,然后将其上传至云端,视频就会在AI技术的辅助下进行处理和压缩,从而成为高质量的3D模型。

UGG、Off-White等时尚品牌和电商平台都已经率先使用了RestAR,应用场景包括3D预览、AR试穿等。未来,这项技术可以成为用户在元宇宙世界的好帮手,如把生活中的摆件、书籍等物品扫描成3D模型(见图8)。

图8 RestAR可以快速生成3D模型

AI行为模拟与AI交互:让元宇宙“活”起来

通过Unity的技术,开发者可以高效创作出元宇宙里的人、场、物。但是,元宇宙并不仅仅是一个静态的画面,“交互性”“社交属性”同样是元宇宙不可忽视的基本特征。

元宇宙世界中的数字人,就如同游戏中的非玩家角色(NPC),需要能够与用户对话、给出实时反应与反馈,不仅要有精美灵动的外表,还需要有近乎人的智能,甚至是“灵魂”。这涉及两个部分:交互设计与行为模拟。

交互设计包括语音驱动、动作捕捉、面部捕捉以及物体追踪,这更多涉及的是现实世界向虚拟世界转换与移植的问题。例如,在召开虚拟会议的时候,可以实现变脸,通过Unity的AR Foundation就可以在Unity中以多平台方式进行面部捕捉。在不久的将来,用户用一个普通的摄像头就可以实现非常精细、准确的面部捕捉,而不再需要非常专业的设备。

对元宇宙世界而言,更重要的是AI在行为模拟方面的作用,也就是如何让元宇宙中的NPC能够与用户交互,如何让它们看起来如同拥有自主意识和“灵魂”(见图9)。

图9 元宇宙是生机勃勃的世界,NPC能够自然地与人“交谈”

针对这个问题,Unity已经拥有了成熟的工具,如ML-Agent。ML-Agent为开发者提供了强化学习和模仿学习框架,以及游戏虚拟仿真环境,能够大大降低游戏AI领域各种行为模拟算法的训练和测试成本。

训练与测试是一个方面,推理则是另一条根本捷径。只有将二者结合,才可以让这些原住民不仅能够在预设的条件中灵活应对,还可以自己推理演算,满足与真人接触时不可预测的种种情况。

Unity为基于计算机图形(Computer Graphics)结构开发的AI算法模型,提供了一个跨平台的推理引擎Unity Influence Engine。任何AI开发框架,如Tensorflow、PyTorch、Keras等,只要将训练结果导出成开放神经网络交换(ONNX)格式都可以导入Unity的推理引擎中,直接使用该AI模型的功能。

基于ML Agent与Influence Engine这两项技术,Unity让元宇宙中的NPC可以像真正的人一样与用户的数字分身进行交互,给他们更好的生活体验。

AI技术:拉近我们与元宇宙的距离

虽然我们已经可以在技术层面构建出虚拟的人、场、物,并且让元宇宙中的原住民NPC看上去仿佛拥有了“灵魂”。但是,元宇宙离我们依然很遥远。

首先,元宇宙其实就是一个广泛的实时3D版本的互联网,其特征为始终实时、3D为主、高度交互、高度社交和持续稳定。从这个定义来看,现在很多所谓的元宇宙概念的产品,要么是纯静态展示无法互动,要么互动是由设定好的程序按部就班执行,无法对设定程序以外的行为做出反应。这其实还不能被称为真正意义上的元宇宙,因为它们无法满足“实时性”与“交互性”的要求。真正的“实时”状态,应该就像我们的日常生活一样——没有人知道接下来会发生什么,完全取决于你现在做了什么以及你周围的环境,而这只能由可以像人一样思考,甚至超过人的人工智能来实现。

其次,只有通过AI实现流水线式批量生产,才能确保有足够多的数字资产打造一个丰富的元宇宙。元宇宙并不是一个空间概念,而是一个时间概念。也就是说,当人们在虚拟世界里花的时间越来越多,直到超过现实世界时,才可以说我们进入了元宇宙时代。这就需要元宇宙世界有足够多的、丰富有趣的内容,能够给人以比现实世界更多元的体验,才能让人更愿意在虚拟空间而非物质世界里花费时间。

但是,要实现这一点,就需要海量的虚拟人、场景、资产等素材。如果再想要追求3A级内容(一般指高成本、高体量、高质量的游戏),就需要大量的时间成本、金钱成本、人力成本,按照现在这种相对传统的生产模式,必然无法满足海量的内容需求。因此,能够指数级降低数字资产制作成本的AI技术就成为实现元宇宙必不可少的先决条件。

AI的引入可以从根本上改变虚拟人、虚拟场景、虚拟物品等数字资产的生产方式,让打造数字资产的生产流水线成为可能,从而实现规模化、批量化生产。我认为,这恰恰也是实现未来元宇宙世界的必经之路。

AI未来的发展趋势:NeRF

近期,Unity非常关注的一个关键技术方向是神经辐射场(NeRF)。

美国加利福尼亚大学伯克利分校、谷歌研究(Google Research)和加利福尼亚大学圣迭戈分校的研究团队在2020年欧洲计算机视觉会议(ECCV 2020)上发表的一篇里程碑式的论文中提到,NeRF实现了神经场(Neural Field)与图形学体渲染(Volume Rendering)的有效结合,首次利用神经网络隐式场景表示实现了照片级的渲染效果。

NeRF是一种有可能完全改变虚拟世界表达方式的技术,无论是画面的产生,还是数字资产的表达方式,都可以参数化到一个隐式空间。

NeRF技术具有很强的使用价值。例如,通过神经网络渲染等技术,NeRF不仅可以生成较好的视觉效果,还能控制生成结果的风格和语义结构。通过NeRF,我们可以让用户自主输入颜色、纹理等细节信息,制定并修改内容,进而将用户指定的语义图映射为逼真的图像。

这其中涉及的神经网络渲染,在很多方面改进了传统的渲染方式。神经网络渲染可以预设在特定环境下的所有渲染效果,但这对算力与存储有很高的要求。如果采用神经元网络渲染技术,就可以通过AI解决算力与存储压力,以一种类似于查表的机制去获得描述性表达。以员工走进办公室的场景为例,在这个场景中,随着员工的位移,光影也会随之变动。传统模式是预设一些根据光影变化而呈现的画面,但通过神经网络渲染,就可以提前渲染出更多种甚至无数种情况。在实际运行过程中,系统会根据员工所在的位置实时调取正确的光影配置,而且这个过程也更加准确、可控。

NeRF与神经元网络渲染如果能够实现,将取代当前GPU光、声、画的影视化表达,就能够完全颠覆呈现虚拟3D世界的方式。

当然,目前的NeRF如果要完全替代传统GPU渲染和数字资产的表达还存在效率问题。对工具厂商来说,Unity一直在为开发者用最小的算力存储代价获得最好的虚拟交互体验而努力。虽然目前NeRF的数字表达无论是生产阶段还是使用阶段,算力效率以及与传统方式的协同都存在一些问题,但这无疑是一个很值得关注的技术方向。

接下来,Unity会将NeRF等AI相关技术集成、纳入更多的创作流程中,让工具真正成为创作者的大脑,让在现实世界中的所见成为元宇宙世界中的所得。